Материалы по тегу: облако

|

30.09.2025 [23:25], Владимир Мироненко

С 1 ноября клиентов гиперскейлеров вынудят покупать лицензии на VMware напрямую у Broadcom

aws

broadcom

google cloud platform

microsoft azure

software

vmware

виртуализация

гиперскейлер

лицензия

облако

В связи с отменой Broadcom бессрочных лицензий VMware и переходом на модель подписки BYOS (Bring Your Own Subscription, «принеси свою собственную подписку»), обеспечивающую переносимость лицензии на проверенные VMware решения на базе VMware Cloud Foundation (VCF), клиенты крупнейших облачных провайдеров должны с 1 ноября покупать подписки на VCF напрямую у неё, без посредников. Об изменениях отношений с гиперскейлерами Broadcom объявила в самом конце августа. Google Cloud Platform анонсировала изменения в работе сервиса Google Cloud VMware Engine (GCVE) от Google Cloud Platform (GCP), который позволяет запускать рабочие нагрузки на основе VMware в инфраструктуре Google Cloud, однако через несколько часов удалила запись. Тем не менее, копия сообщения прямо говорит, что теперь клиентам придётся обращаться за лицензиями и разрешением на их использование в GCP к Broadcom. Google первой среди гиперскейлеров предложила клиентам опцию Bring Your Own License (BYOL) для сред VMware в начале 2024 года. Согласно договорённости Google и Broadcom, пользователи GCP получат следующие возможности:

Для всех остальных заказчиков с 1 ноября 2025 года для развёртывания GCVE потребуется лицензия, купленная у Broadcom. Основные возможности VMware Engine для клиентов GCP останутся прежними. GCVE останется управляемой службой Google, которая предоставляет выделенную среду VMware Cloud Foundation, работающую непосредственно на инфраструктуре Google Cloud. Microsoft сообщила, что решение Azure VMware Solution (AVS) готово к изменениям в политике Broadcom. Вариант Azure VMware Solution VCF BYOL доступен во всех 35 регионах по всему миру. Цена варианта BYOL будет меньше, чем AVS с пакетной подпиской VCF. Microsoft прекратит продажу Azure VMware Solution с комплектной подпиской на VCF после 15 октября 2025 года. После этой даты для покупки новых узлов Azure VMware Solution потребуется подписка на VCF, приобретенная непосредственно у Broadcom. Узлы Azure VMware Solution с опцией PayGo смогут работать без дополнительных лицензий и изменений в продукте до 31 октября 2026 года. Клиенты могут перейти с AVS PayGo, приобретя до 15 октября 2025 года зарезервированные инстансы Azure VMware Solution с уже включённой подпиской VCF. AWS же в начала августа 2025 года, т.е. до публичного объявления Broadcom о смене политики лицензирования для клиентов гиперскейлеров, сообщила об общедоступности сервиса Amazon Elastic VMware Service (Amazon EVS), который позволяет запускать среды VCF в виртуальном частном облаке Amazon VPC и интегрировать их с другими сервисами AWS. При этом лицензии так же придётся покупать у Broadcom, причём минимум на 256 ядер. Нюанс в том, что EVS пока поддерживает только VCF версии 5.2.1 и только на узлах i4i.metal на базе Intel Xeon Ice Lake-SP.

27.09.2025 [15:32], Сергей Карасёв

Майнинговая компания Iren увеличила мощность ИИ-облака, закупив тысячи ускорителей NVIDIA и AMD за $674 млнКриптомайнинговая компания Iren (ранее известная как Iris Energy), по сообщению Datacenter Dynamics, увеличила количество ИИ-ускорителей в своём облаке примерно в два раза. Стоимость приобретённого оборудования оценивается в $674 млн. Компании прочат статус серьёзного игрока на рынке неооблаков. Компания находится в процессе перехода от майнинга криптовалют к облачному бизнесу на базе ИИ. В частности, закуплены 7100 ускорителей NVIDIA B300 и 4200 изделий NVIDIA B200, а также 1100 AMD Instinct MI350X. В результате, общее количество ускорителей в составе платформы Iren достигло приблизительно 23 тыс. Новое оборудование в ближайшие месяцы будет развёрнуто в кампусе Iren в городе Принс-Джордже (Prince George) в северной части провинции Британская Колумбия в Канаде. В настоящее время на этой площадке ведётся строительство вычислительного комплекса с жидкостным охлаждением мощностью 10 МВт (ИТ-нагрузка), который сможет поддерживать более 4500 суперускорителей NVIDIA GB300. В конце августа нынешнего года Iren сообщила о приобретении 1200 ускорителей NVIDIA B300 для серверов с воздушным охлаждением и 1200 изделий NVIDIA GB300 для систем с жидкостным охлаждением: стоимость данной партии составила примерно $168 млн. Эти чипы также предназначены для ЦОД в Принс-Джордже. Тогда говорилось, что Iren привлекла финансирование в размере около $96 млн для покупки GB300: средства получены по схеме лизинга сроком на два года. В настоящее время Iren управляет пятью кампусами ЦОД общей мощностью 810 МВт, расположенными в Северной Америке: два в Техасе (США) и три в Британской Колумбии (Канада). Ещё 2,1 ГВт находятся в стадии строительства, причём 2 ГВт из них приходится на новый кампус в Техасе. Как отмечает Дэниел Робертс (Daniel Roberts), соучредитель и содиректор Iren, удвоение парка GPU позволит удовлетворить растущие потребности клиентов в масштабируемых вычислительных мощностях.

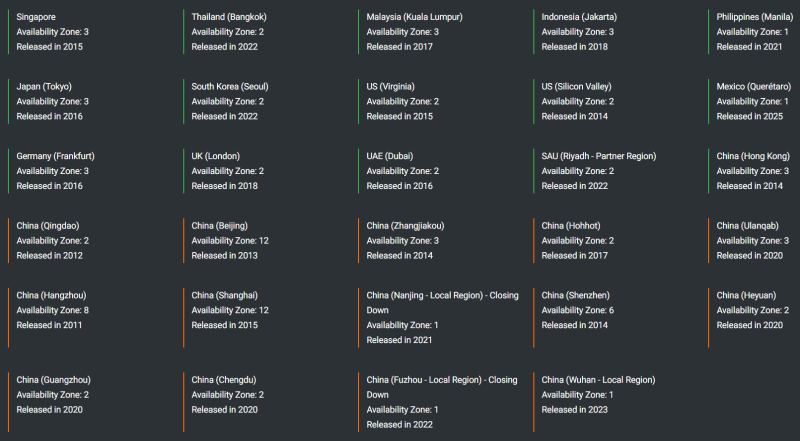

26.09.2025 [13:28], Руслан Авдеев

Alibaba Cloud запустит восемь новых ЦОД в Европе, Азии и Северной АмерикеКитайский облачный провайдер Alibaba Cloud (Aliyun) готовится открыть восемь новых ЦОД в разных странах. Анонсирован запуск первых объектов в Бразилии, Франции и Нидерландах, а также расширение присутствия в Мексике, Японии, Южной Корее, Малайзии и ОАЭ. По словам компании, ИИ меняет не только технологии, но и сами методы «создания ценности» и стимулирования роста. Стратегическое расширение глобальной инфраструктуры призвано удовлетворить растущий спрос со стороны «дальновидных» клиентов. В Alibaba Cloud считают, что компания находится в авангарде инноваций в сфере ИИ, развиваясь вместе с клиентами, предлагая комплексные решения на базе искусственного интеллекта и облачных технологий, поддерживающих бизнес в любое время, в любом месте. Компания готова вложить ¥380 млрд ($52,7 млрд) в развитие собственной инфраструктуры, чтобы сохранить лидерские позиции. На сегодня Alibaba Cloud управляет 91 зоной доступности в 29 облачных регионах, включая материковый Китай, Азию, США, Южную Америку, Европу и Ближний Восток. Так, Alibaba вышла на японский рынок в 2016 году, в Токио действуют три зоны доступности. В Сеуле (Южная Корея) имеются две зоны доступности, в Мексике в 2025 году была открыта зона. В Дубае (ОАЭ) Alibaba присутствует с 2016 года, там компания управляет двумя зонами. Также три зоны имеются в Куала-Лумпуре (Малайзия). Ранее в сентябре компания опубликовала финансовый отчёт за I квартал 2026 финансового года, согласно которому совокупная выручка подразделения Alibaba Cloud Intelligence Group составила $4,662 млрд, на 26 % выше год к году. При этом, как сообщают в Alibaba, год к году выручка от ИИ сохранила «трёхзначный» рост — подобный рост сохраняется уже восемь кварталов подряд. Кварталом ранее выручка облачного подразделения составила $4,152 млрд, увеличившись в годовом исчислении на 18 %.

26.09.2025 [13:01], Руслан Авдеев

OpenAI заказала у CoreWeave ИИ-мощности ещё на $6,5 млрд — общая сумма контрактов выросла до $22,4 млрдCoreWeave расширила партнёрские отношения с OpenAI, заключив новое соглашение на сумму $6,5 млрд. Таким образом, общая сумма контрактов с OpenAI достигла $22,4 млрд, сообщает Reuters. Речь идёт уже о третьей крупном заказе OpenAI мощностей у CoreWeave в этом году. Первоначальный договор на $11,9 млрд заключили в марте 2025 года, в мае последовало новое соглашение на $4 млрд. Партнёры продолжают углублять сотрудничество, поскольку OpenAI ищет всё новые вычислительные мощности. Объявление последовало за анонсом, обещающим крупные обновления инфраструктурного проекта Stargate, курируемого OpenAI. На днях компания объявила, что намерена открыть в США пять новых ЦОД совместно с Oracle и SoftBank. В компании утверждают, что совокупная мощность пяти новых площадок, флагманского объекта в техасском Абилине (Abilene и проектов с CoreWeave составит до 7 ГВт, а инвестиции — более $400 млрд в следующие три года. В CoreWeave заявляют, что предложение на рынке очень отстаёт от спроса. В компании стремятся диверсифицировать свои партнёрские отношения, сократив зависимость от Microsoft, которая некогда была эксклюзивным поставщиком инфраструктуры для создателей ChatGPT. В 2024 году на инфраструктуру для Microsoft (в интересах OpenAI) приходилось 62 % выручки CoreWeave. Однако разлад между OpenAI и Microsoft усиливается, так что последняя теперь намерена самостоятельно наращивать ИИ-мощности. CoreWeave же обещает «квартал диверсификации» с привлечением «действительно замечательных, известных и кредитоспособных клиентов». Ранее на этой неделе NVIDIA заявила, что намерена инвестировать до $100 млрд в OpenAI и поставит ей ИИ-ускорители для дата-центров, это знаменует собой объединение крупнейших отраслевых бизнесов в гонке ИИ. Сделка NVIDIA и OpenAI обеспечит первой долю в капитале одного из крупнейших клиентов и уже вызвала опасения у антимонопольных органов. Более того, NVIDIA также инвестировала и в CoreWeave, она владеет более 5 % компании и является вторым по величине её клиентом (15 %). CoreWeave, в свою очередь, приобрела немало оборудования NVIDIA и подписала с компанией соглашение на $6,3 млрд, согласно которому производитель чипов гарантированно выкупит все облачные мощности, не проданные клиентам до апреля 2032 года.

25.09.2025 [16:54], Руслан Авдеев

«Европе нужен гиперскейлер»: Nscale привлекла $1,1 млрд инвестиций от Dell, Nokia и NVIDIAКомпания Nscale, начинающий застройщик ЦОД, привлекла $1,1 млрд на развитие бизнеса в Великобритании и за её пределами. В раунде финансирования серии B, возглавляемом Aker ASA, приняли участие Blue Owl, Dell, Fidelity Management & Research Company, G Squared, Nokia, NVIDIA, Point72 и T.Capital, сообщает Datacenter Dynamics. Обязались вложить больше cредств и действующие акционеры, включая Sandton Capital. Ранее сообщалось, что стартап намерен привлечь $2,7 млрд. «Европе нужен гиперскейлер, и Nscale принимает этот вызов», — заявила компания. В последние месяцы лондонская Nscale оказалась в центре внимания благодаря сделкам, связанным с созданием цифровой инфраструктуры с участием OpenAI, NVIDIA и Microsoft. В компании заявляют, что ИИ меняет отрасли, экономику и национальные стратегии, но без ЦОД, ускорителей и ПО всё это невозможно. В Nscale говорят о создании вертикально интегрированной основы для ИИ, призванной стать движущей силой технологических изменений нового поколения. Полученные средства Nscale направят на развитие ИИ-инфраструктуры в Европе, Северной Америке и на Ближнем Востоке, повторив путь CoreWeave. Nscale претендует на создание одной из крупнейших в своём роде глобальных платформ, специально разработанных для удовлетворения растущего спроса на ИИ и реализации революционных решений в беспрецедентных масштабах. Фактически Nscale была основана в 2024 году, когда основатели отказались от криптомайнинг и приобрели ЦОД в Норвегии у своей предыдущей компании Akkon Energy. Сейчас дата-центр, работающий от энергии ГЭС и использующий естественное охлаждение — единственный из имеющихся в распоряжении этого бизнеса. Тем не менее, у компании амбициозные планы по строительству объектов в Великобритании и других странах. В январе Nscale объявила о намерении потратить £2,5 млрд ($3 млрд) в Соединённом Королевстве, построив первый ЦОД в Лоутоне (Loughton, Эссекс). Ввод в эксплуатацию запланирован на 2026 год. Позже стало известно, что в ЦОД разместят суперкомпьютер Microsoft на ускорителях NVIDIA, который станет крупнейшим проектом такого рода в Великобритании. Также Nscale работает с OpenAI для обеспечения работы ЦОД в рамках проекта Stargate UK. Ожидается, что американский партнёр получит доступ к 8 тыс. ускорителей NVIDIA. Компании уже совместно работают над проектом Stargate Norway (Норвегия) — OpenAI в перспективе получит до 100 тыс. ИИ-ускорителей в Квандале (Kvanndal) близ Нарвика (Narvik) на севере Норвегии, строительством которого занимается Aker. Клиентом Nscale и Aker в Норвегии собирается стать и компания Microsoft, заключив контракт на закупку вычислительных мощностей на $6,2 млрд сроком на пять лет. Кроме того, соглашение с Nscale заключила и Nokia. По словам главы последней Джастина Хотарда (Justin Hotard), спрос на создание безопасной масштабируемой инфраструктуры в Европе и мире растёт, а интеллектуальная собственность Nokia и её опыт в области оптических сетей позволит компаниям внедрять инновации, необходимые для будущего ИИ-инфраструктуры.

25.09.2025 [13:31], Руслан Авдеев

Суверенный ChatGPT для Германии: SAP, OpenAI и Microsoft анонсировали проект OpenAI for Germany

microsoft

microsoft azure

openai

sap

software

германия

информационная безопасность

конфиденциальность

облако

сделка

Немецкая SAP SE и OpenAI сообщили о запуске проекта OpenAI for Germany. Партнёры намерены внедрить в государственный сектор Германии технологии SAP для корпоративных приложений и передовые решения OpenAI в сфере искусственного интеллекта, сообщает пресс-служба OpenAI. Для выполнения требований к суверенитету данных проект OpenAI for Germany будет реализован на платформе дочерней структуры SAP — SAP Delos Cloud, работающей на платформе Microsoft Azure. Это позволит миллионам госслужащих безопасно использовать ИИ, соблюдая строгие стандарты для обеспечения суверенитета, безопасности и законности использования информации. В SAP заявляют, что с её опытом внедрения ИИ-функций для бизнеса и десятками лет взаимодействия с государственными организациями, компания рассматривает OpenAI for Germany как огромный шаг вперёд. Экспертиза SAP Sovereign Cloud объединится с передовыми ИИ-технологиями OpenAI для эффективного использования ИИ-решений, разработанных «в Германии и для Германии». По словам главы OpenAI Сэма Альтмана (Sam Altman), Германия давно является пионером в области инженерных решений и технологий, поэтому неудивительно, что миллионы немцев пользуются ChatGPT, чтобы упростить себе жизнь, вывести на новый уровень научные достижения и организовать новые бизнесы. С помощью нового проекта OpenAI рассчитывает работать с местными партнёрами, чтобы распространить потенциал ИИ-технологий на госсектор, способствуя улучшению сервисов и обеспечивая распространение ИИ по всей стране в соответствии с немецкими ценностями, касающимися доверия и безопасности.

Источник изображения: Adeolu Eletu/unspalsh.com Наконец, глава Microsoft Сатья Наделла (Satya Nadella) заявил, что новое партнёрство позволит его компании предоставить государственному сектору Германии больше возможностей в сфере ИИ. Основой этого станет облако Azure (как платформа для Delos Cloud), что поможет обеспечить внедрение ИИ с соблюдением высочайших стандартов, касающихся суверенитета и конфиденциальности данных, с соответствием работы местным нормативным требованиям и другим параметрам. Это позволит госучреждениям уверенно и ответственно внедрять ИИ. В рамках нового партнёрства, старт которого запланирован на 2026 год, OpenAI, SAP и Microsoft намерены упростить повседневную работу местным чиновникам, сотрудникам научно-исследовательских структур и др. — для того, чтобы появилась возможность уделять больше времени людям, а не бумажной работе, заявляют компании. Кроме того, OpenAI for Germany послужит основой для разработки специализированных приложений для госструктур и интеграции ИИ-агентов в действующие рабочие процессы вроде управления документооборотом или анализа административных данных. Для этого SAP намерена расширить имеющуюся инфраструктуру Delos Cloud в Германии до 4 тыс. ИИ-ускорителей. В зависимости от спроса в будущем, SAP, возможно, продолжит инвестировать в развитие прикладной ИИ-функциональности в Германии, масштабируя проекты как за счёт имеющейся инфраструктуры SAP, так и за счёт сотрудничества с партнёрами. Не исключается расширение предложения суверенных решений на другие отрасли и рынки по всей Европе. OpenAI for Germany поддерживает местные амбиции, касающиеся внедрения ИИ. Местная повестка, касающаяся высоких технологий, направлена на «создание дополнительной стоимости» с помощью ИИ на уровне до 10 % ВВП к 2030 году. Более того, в рамках инициативы Made for Germany, поддерживаемой 61 крупной компанией, планируется привлечь €631 млрд на ускорение роста и IT-модернизацию страны. Сама SAP недавно заявляла о намерении инвестировать более €20 млрд в укрепление цифрового суверенитета Германии, в том числе в облако Delos.

23.09.2025 [17:40], Владимир Мироненко

Oracle назначила сразу двух гендиректоровВ понедельник Oracle объявила о назначении Клэя Магоуйрка (Clay Magouyrk) и Майка Сицилии (Mike Sicilia) новыми гендиректорами, поскольку Сафра Кац (Safra Catz) покидает эту должность после более чем десяти лет руководства, чтобы занять пост исполнительного вице-председателя совета директоров. «Сейчас, когда компания находится на пике своей формы, самое время передать пост генерального директора следующему поколению способных руководителей», — заявила Кац CNBC. По данным источников The Wall Street Journal, 63-летняя Кац не рассчитывала, что останется генеральным директором надолго, так что всё к этому шло. Высшее руководство Oracle начало обсуждать кадровые перестановки несколько месяцев назад, а Кац заявила о своей готовности к ним после успешного квартала Oracle, сообщил источник WSJ. Что примечательно, Oracle называет её преемников генеральными директорами, а не соруководителями. Внутри компании Магоуйрк и Сицилия считаются более сильными специалистами, чем Кац, известная своей финансовой прозорливостью. По словам источника WSJ, их повседневная работа существенно не изменится. Магоуйрк будет курировать облачный бизнес компании, а Сицилия займётся продажей продуктов Oracle. Председатель совета директоров и технический директор Oracle Ларри Эллисон (Larry Ellison) заявил, что оба генеральных директора были выбраны благодаря их лидерским качествам и опыту в области ИИ, пишет CRN. «Многолетний опыт Клэя в руководстве крупным и быстрорастущим подразделением OCI продемонстрировал его готовность к роли генерального директора», — отметил он. Эллисон также сообщил, что Сицилия последние несколько лет занимался модернизацией бизнеса Oracle по разработке отраслевых приложений, включая Oracle Health, с использованием новейших ИИ-технологий. «Несколько лет назад Клэй и Майк начали внедрение ИИ в инфраструктуру и приложения Oracle — и это даёт плоды. Они оба — проверенные лидеры, — сказал Эллисон. — У Oracle блестящее будущее». Клэй Магоуйрк (39 лет) перешёл в компанию в 2014 году из AWS. В качестве одного из основателей команды разработчиков облачных решений Oracle, он руководил разработкой и внедрением в OCI высокопроизводительной облачной платформы второго поколения, которая обеспечивает работу как публичных облачных ЦОД, так и гигаваттных ИИ ЦОД. Как сообщает Oracle, под руководством Магоуйрка OCI добилась роста и стала ведущей платформой для обучения и инференса ИИ. Майк Сицилия (54 года) присоединился к Oracle после приобретения Primavera Systems в 2008 году. Он являлся президентом Oracle Industries, курируя разработку ПО для таких секторов как здравоохранение, банковское дело и розничная торговля, а также продвигая использование генерации приложений на основе намерений и встроенных ИИ-агентов для замены традиционного программирования при разработке приложений Oracle. Эксперты отмечают, что наличие двух человек у руля компании может привести к конфликтам из-за возможного несовпадения характеров. Но положение Oracle уникально, поскольку Ларри Эллисон в значительной степени рассматривается как главный руководитель, принимающий многие стратегические решения и делегирующий полномочия. «Сафра руководила Oracle, когда мы стали гигантом в сфере облачных технологий, что наглядно продемонстрировали наши недавние результаты, — сказал Эллисон. — Мы с Сафрой на посту заместителя председателя сможем продолжить наше 26-летнее партнёрство, помогая Oracle определять направление развития, рост и успех». Oracle также объявила в понедельник, что Марк Хура (Mark Hura), нынешний исполнительный вице-президент по продажам Oracle в Северной Америке, назначен президентом по глобальным операциям. А Даг Керинг (Doug Kehring), нынешний исполнительный вице-президент по операциям, получил повышение в виде назначения на должность главного финансового директора. Ресурс The Register сообщил, что эти решения были приняты спустя несколько недель после того, как в документах WARN была раскрыта информация об очередном раунде сокращений в Oracle, включающем увольнение более 350 сотрудников в Калифорнии и Вашингтоне. По данным источников, сокращение персонала по всему миру может исчисляться тысячами человек и, по некоторым оценкам, составляет до 12 тыс. специалистов. Компания предпочитает не афишировать масштабы увольнения, но они вызвали беспокойство внутри Oracle, особенно в командах разработчиков, отметил The Register. В частности, в подразделении MySQL было уволено около 70 человек, включая опытных специалистов.

22.09.2025 [09:16], Руслан Авдеев

JLL: среднегодовой темп роста выручки неооблаков за пять лет составил 82 %По данным экспертов компании JLL, среднегодовой темп роста выручки (GAGR) неооблаков (neocloud) с 2021 года составил 82 %. В недавнем отчёте The rise of neocloud infrastructure подчёркивается, что соответствующий рынок демонстрирует значительный рост, поскольку конкуренция за ИИ-мощности и доступ к ускорителям возросли, сообщает DataCenter Knowledge. В JLL отмечают, что помимо уже хорошо известных на рынке и хорошо зарекомендовавших себя «неооблачных» операторов вроде CoreWeave, Nebius и Crusoe, имеется ещё около 190 независимых компаний того же профиля. Недавно S&P Global сообщила, что в прошлом году на этот сектор было потрачено более $10 млрд. В JLL считают, что это свидетельствует о «значительном инвестиционном импульсе». Так, акции CoreWeave с момента IPO в марте 2025 года выросли в цене почти втрое. JLL отмечает, что неооблачные провайдеры могут выбирать локации с оптимальной доступностью энергоресурсов и экономической выгодой, без привязки к традиционным хабам, необходимым гиперскейлерам. В итоге их модель развития более экономична и допускает ускоренное развёртывание мощностей. По данным Uptime Institute, неооблака обеспечивают снижение затрат примерно на 66 % в сравнении с гиперскейлерами.

Источник изображения: venki cenation/unsplash.com По мнению экспертов, спрос на ИИ-инфраструктуру сегодня растёт исключительными темпами, а глобальный рынок ЦОД столкнулся с проблемой дефицита мощностей. Неооблачные бизнесы получили преимущество перед традиционными поставщиками облачных услуг благодаря более низким ценам, гибким условиям и некоторым другим факторам. Поскольку рынок ИИ, похоже, не намерен замедляться, инфраструктура новых облачных провайдеров в ближайшее время будет чрезвычайно востребована. Что касается возможных рисков, в JLL подчёркивают, что контракты неооблаков обычно короче, чем у традиционных облачных операторов, и составляют от двух до пяти лет — но в теории это не соответствует периодам окупаемости активов ЦОД в семь-девять лет. Кроме того, ставки у неооблаков растут из-за потребности в дефицитных ЦОД с возможностью размещения высокоплотных систем, передовыми сетевыми стеками и полами повышенной прочности, неооблачные провайдеры конкурируют за них друг с другом. JLL заявила, что более высокие требования к капиталу и более короткие сроки аренды значительно увеличивают инвестиционные риски в сравнении с традиционными ЦОД. В компании подчёркивают, что важнейшим фактором при реализации потенциала неооблаков для высоких ИИ-нагрузок станут вопросы финансирования. Для создания инфраструктуры ИИ-ускорителей требуются значительные капиталовложения — инвесторам необходимо чётко представлять, как создать жизнеспособную бизнес-модель и заручиться поддержкой клиентов прежде, чем выходить на рынок «новых облаков».

21.09.2025 [01:05], Владимир Мироненко

Meta✴ готова потратить $20 млрд на аренду ИИ-мощностей у OracleАгентству Bloomberg стало известно о переговорах между Oracle и Meta✴ Platforms о многолетнем соглашении на сумму $20 млрд, в рамках которого Oracle будет предоставлять гиганту социальных сетей вычислительные мощности для обучения и развертывания ИИ-моделей. Сумма сделки не окончательная, как и её условия, которые могут измениться до достижения сторонами окончательного соглашения, предупредили источники Bloomberg, знакомые с обстоятельствами ведения переговоров. Как полагает SiliconANGLE, сделка Meta✴ с Oracle в сфере облачных технологий, вероятно, является частью масштабной инициативы по созданию ЦОД, о которой компания сообщила в июле. В рамках проекта она инвестирует сотни миллиардов долларов в новую ИИ-инфраструктуру. Первые два кластера ЦОД этого проекта, Prometheus и Hyperion, потребуют по нескольку ГВт электроэнергии каждый. На прошлой неделе Oracle заключила соглашение с OpenAI на $300 млрд сроком на пять лет на предоставление вычислительный мощностей для обработки ИИ-нагрузок. Компания ранее сообщила, что в I квартале 2026 финансового года заключила многомиллиардные соглашения с тремя клиентами, в результате чего объём оставшихся обязательств по контрактам (RPO) вырос год к году на 359 % до $455 млрд. По словам гендиректора Oracle Сафры Кац (Safra Catz, на фото выше), в ближайшие несколько месяцев у компании должно появиться еще несколько крупных клиентов с многомиллиардными контрактами, благодаря чему RPO, вероятно, превысит полтриллиона долларов. Дэйв Велланте (Dave Vellante), главный аналитик CUBE Research (SiliconANGLE Media), отметил, что эти достижения свидетельствуют о том, что Oracle вошла в число гиперскейлеров. Oracle становится ключевым поставщиком вычислительных мощностей для ИИ-нагрузок, конкурируя с лидерами рынка облачных технологий Amazon.com, Microsoft и Google. На фоне успешной работы акции техасской компании выросли в этом году на 84 %.

20.09.2025 [13:06], Сергей Карасёв

OpenAI потратит $100 млрд на аренду резервных ИИ-серверов у облачных провайдеровКомпания OpenAI, по сообщению The Information, намерена в течение пяти лет потратить до $100 млрд на аренду резервных серверов у облачных провайдеров. Эти ресурсы будут использоваться для удовлетворения спроса на вычислительные мощности в периоды пиковых нагрузок. OpenAI полагает, что быстрое развитие ИИ и внедрение новых возможностей в данной области в перспективе могут привести к более резким скачкам нагрузки на серверные платформы. Компания опасается, что нехватка мощностей в подобных ситуациях может привести к тому, что клиенты начнут обращаться к Google, Meta✴ и другим конкурирующим игрокам. Ожидается, что арендованные резервные ресурсы во время простоя будут использоваться для выполнения тех или иных научных и исследовательских задач. Кроме того, в зависимости от условий соглашения с облачным провайдером излишки вычислительных мощностей могут перепродаваться сторонним заказчикам. В целом, OpenAI намерена выделять на облачные сервисы около $85 млрд ежегодно. Недавно компания заключила пятилетнее соглашение о приобретении вычислительных мощностей у Oracle для задач ИИ: на эти цели будет выделено $300 млрд. OpenAI продолжает использовать облачную инфраструктуру Microsoft Azure, а также арендует ресурсы у CoreWeave. Ранее генеральный директор OpenAI Сэм Альтман (Sam Altman) заявлял, что со временем компания потратит на создание ИИ-инфраструктуры триллионы долларов. По словам Альтмана, доступ к передовым вычислительным мощностям является ключом к сохранению преимущества в гонке за ИИ. При этом OpenAI терпит убытки, рассчитывая выйти на прибыль в 2030 году. Компания прогнозирует, что её выручка вырастет до $200 млрд к концу текущего десятилетия против примерно $13 млрд, ожидаемых по итогам нынешнего года. |

|