Лента новостей

|

20.10.2025 [12:13], Сергей Карасёв

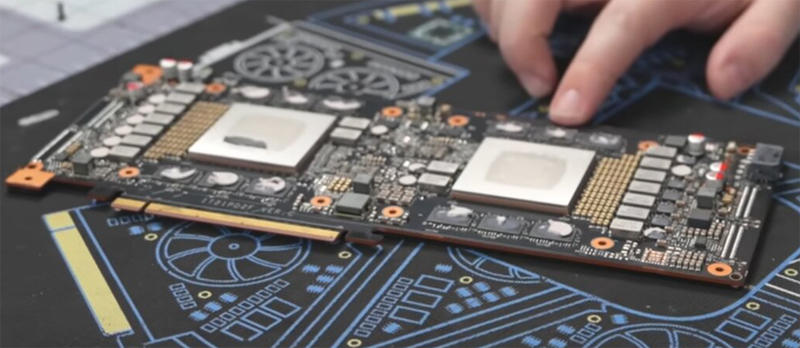

ИИ-ускоритель Huawei Atlas 300I Duo получил однослотовое исполнениеВ распоряжении сетевых источников оказалась информация о необычном ускорителе Atlas 300I Duo, разработанном компанией Huawei для решения задач в области ИИ: это двухпроцессорное изделие, оснащенное пассивной системой охлаждения. Карта получила однослотовое исполнение. В оснащение входят два GPU серии Ascend 310 и 96 Гбайт памяти LPDDR4X, пропускная способность которой достигает 408 Гбайт/с. Используется интерфейс PCIe 4.0 х16. Утверждается, что Atlas 300I Duo может декодировать до 256 потоков видео в формате Full HD со скоростью 30 к/с или 32 потока 4K со скоростью 60 к/с. Возможно кодирование 48 видеопотоков Full HD со скоростью 30 к/с. ИИ-производительность на операциях INT8 достигает 280 TOPS. При этом показатель TDP находится на отметке 150 Вт.

Источник изображений: Gamers Nexus via YouTube Применённая пассивная система охлаждения предусматривает использование радиаторов в области каждого GPU, соединённых тепловыми трубками. Кроме того, имеется металлическая пластина для рассеяния тепла. Для подачи дополнительного питания используется специальный 8-контактный разъём, не совместимый со стандартными гнёздами. Стоимость Huawei Atlas 300I Duo составляет около $1600.  Между тем Huawei продолжает развивать семейство ИИ-ускорителей Ascend. В I квартале 2026 года компания намерена представить ускоритель Ascend 950PR, который обеспечит производительность до 1 Пфлопс на операциях FP8. После этого последуют устройства Ascend 950DT, Ascend 960 и Ascend 970.

20.10.2025 [09:52], Руслан Авдеев

VoltaGrid обеспечит Oracle 2,3 ГВт электроэнергии газовых генераторов для ИИ ЦОДТехасская VoltaGrid, специалист в области энергетических решений, поставит Oracle энергетическую платформу Qpac мощностью 2,3 ГВт на базе газовых генераторов, разработанную совместно с INNIO Jenbacher и ABB, для питания ИИ ЦОД, сообщает Datacenter Dynamics. Поставки природного газа будут осуществляться через сеть трубопроводов компании Energy Transfer. По словам OCI, ИИ потребляет очень много энергии, а рабочие нагрузки часто меняются, что может вести к заметным колебаниям спроса на электричество. Платформа VoltaGrid Qpac способная сглаживать колебания, благодаря чему энергопотребление ЦОД становится более стабильным, предсказуемым и безопасным для электросетей. При этом платформа VoltaGrid обеспечивает не только энергоснабжение объектов, но и легко поддаётся масштабированию. VoltaGrid Qpac представляет собой модульную энергосистему, работающую на газе. Каждый её узел генерирует до 20 МВт. Узлы можно легко объединить для обеспечения до 200 МВт основной мощности — если регуляторы допустят заранее оговоренные выбросы в атмосферу. Как считают в VoltaGrid, речь идёт больше, чем просто о сделке в сфере электроснабжения. Это совместная с Oracle работа по разработке масштабируемых решений, компенсирующих колебания спроса на электричество ИИ-системами. Вместе обеспечивается сверхбыстрый отклик на спрос, нулевая зависимость от аккумуляторов и практически нулевые выбросы. В VoltaGrid отмечают, что сделка расширит мощности в районах Далласа и Хьюстона (Техас).

Источник изображения: VoltaGrid Компания уже подписала ряд важных соглашений о поставках электричества с компаниями, занятыми строительством дата-центров. Так, в феврале она заключила соглашение с Vantage Data Centers для развёртывания автономных от общих энергосетей газовых генераторов мощностью 1 ГВт на североамериканском рынке. В августе 2024 года она обязалась поставить для ЦОД xAI в Мемфисе 14 мобильных газовых генераторов, которые обеспечили 35 МВт дополнительной мощности в кратчайшие сроки. Местные жители были этому не слишком рады. Oracle уже подписала ряд соглашений с поставщиками электричества для снабжения американских дата-центров. В июле она заключила договор с производителем топливных элементов Bloom Energy о развёртывании соответствующих решений в нескольких ЦОД на территории США.

20.10.2025 [09:11], Сергей Карасёв

Pegatron представила ИИ-систему RA4802-72N2 на базе NVIDIA GB300 NVL72Компания Pegatron представила систему RA4802-72N2, предназначенную для наиболее ресурсоёмких ИИ-нагрузок, включая обучение больших языковых моделей (LLM) в масштабе и инференс. В основу положена платформа NVIDIA GB300 NVL72. Изделие GB300 содержит Arm-процессор Grace с 72 ядрами Neoverse V2 (Demeter) и два чипа Blackwell Ultra. В составе RA4802-72N2 объединены 18 вычислительных лотков, каждый из которых несёт на борту два Grace и четыре Blackwell Ultra. В сумме это даёт 36 процессоров Grace и 72 чипа Blackwell Ultra. Каждый из вычислительных узлов располагает 960 Гбайт памяти LPDDR5X и 1152 Гбайт памяти HBM3e. Таким образом, в общей сложности система оперирует примерно 17 Тбайт LPDDR5X и 20 Тбайт HBM3e. ИИ-производительность достигает 720 Пфлопс на операциях FP8/FP6. В состав RA4802-72N2 также входят девять коммутационных лотков. Общая пропускная способность интерконнекта NVLink составляет 130 Тбайт/с. В расчёте на вычислительный узел используются два адаптера NVIDIA ConnectX-8 и один DPU NVIDIA BlueField-3. Прочие характеристики включают контроллер Aspeed AST2600, модуль TPM 2.0, восемь отсеков для накопителей E1.S NVMe, коннектор M.2 2280/22110 NVMe. Система выполнена в форм-факторе 48U MGX с габаритами 600 × 2296 × 1200 мм. Применяется полностью жидкостное охлаждение. Полка питания оснащена шестью 1U-модулями мощностью 33 кВт. Поставки машины RA4802-72N2 уже начались.

20.10.2025 [01:23], Владимир Мироненко

Ускорителей хватит на всех — Alibaba Aegaeon оптимизировал обработку ИИ-нагрузок, снизив использование дефицитных NVIDIA H20 на 82 %Alibaba Cloud представила Aegaeon, систему пулинга вычислений, позволяющую сократить количество ускорителей NVIDIA, необходимых для обслуживания ИИ-моделей, на 82 %, пишет ресурс SCMP. По словам разработчиков, благодаря Aegaeon количество ускорителей NVIDIA H20, необходимых для обслуживания десятков моделей с 72 млрд параметров, удалось сократить с 1192 до 213 единиц. «Aegaeon — это первое решение на рынке, которое выявило чрезмерные затраты, связанные с обслуживанием параллельных рабочих нагрузок LLM», — сообщили исследователи из Пекинского университета и Alibaba Cloud. Провайдеры облачных сервисов, такие как Alibaba Cloud и ByteDance Volcano Engine, предоставляют пользователям одновременно тысячи ИИ-моделей — множество вызовов API обрабатывается одновременно. Однако на практике для инференса чаще всего используются лишь несколько моделей, таких как Qwen и DeepSeek, а большинство других моделей применяются лишь эпизодически. Это приводит к неэффективному использованию вычислительных ресурсов: исследователи обнаружили, что 17,7 % ускорителей выделяется на обслуживание лишь 1,35 % запросов в Alibaba Cloud. Aegaeon выполняет «автоматическое масштабирование» на уровне токенов, обеспечивая переключение ускорителей между обслуживанием различных моделей в процессе генерации. В рамках системы один ускоритель поддерживает обработку до семи моделей по сравнению с двумя-тремя моделями в альтернативных системах. При этом задержка, связанная с переключением между моделями, снижена на 97 %, заявили исследователи. Alibaba Cloud сообщила, что решение уже используется на её торговой площадке моделей Bailian. Глава NVIDIA Дженсен Хуанг (Jensen Huang) объявил, что из-за экспортных ограничений доля компании на рынке передовых чипов в Китае сократилась с 95 % до нуля. Этому также способствовала стратегия Пекина, направленная на самообеспечение местного рынка. В связи с этим планы NVIDIA возобновить отгрузки ИИ-ускорителей H20, на которые ранее были установлены ограничения правительством США, встретили в Китае довольно прохладно. Более того, в Китае вынесли запрет местным компаниям на покупку разработанного специально для местного рынка ускорителя NVIDIA RTX Pro 6000D, поскольку пришли к выводу, что китайские ИИ-чипы не уступают продукции NVIDIA, разрешённой к экспорту в Китай.

19.10.2025 [13:51], Руслан Авдеев

Alibaba Cloud запустила свой второй ЦОД в ДубаеКитайская Alibaba Cloud ввела в эксплуатацию свой второй дата-центр в Дубае (ОАЭ). Новый ЦОД появился через девять лет после открытия первого объекта компании в городе, сообщает Datacenter Dynamics. Новый дата-центр — часть планов по глобальному масштабированию бизнеса. В его рамках Alibaba обязалась потратить $52,7 млрд на облачную и ИИ-инфраструктуру. Как сообщает Alibaba, новый объект позволит компании расширить предложение новых облачных технологий и систем искусственного интеллекта в Дубае. По словам Alibaba, запуск нового дата-центра и объявление об инновационных проектах на GITEX Global 2025 — важные вехи на пути расширения бизнеса компании в регионе. Готовность Ближнего Востока к быстрому внедрения ИИ и готовая к сотрудничеству экосистема — важнейшие факторы, способствующие процветанию структур в частном и государственном секторах, говорит Alibaba Cloud.

Источник изображения: Alibaba Cloud Дополнительно Alibaba Cloud объявила о подписании меморандума о взаимопонимании c ближневосточной цифровой финансовой платформой Wio Bank. Соглашение позволит использовать облачные технологии и ИИ Alibaba в рамках мультиоблачной стратегии платформы. В частности, Wio Bank будет использовать дубайские ЦОД комапнии. В Wio Bank подчёркивают, что масштабируя возможности с помощью передовых технологий Alibaba Cloud, компания создаёт ИИ-агентов, упрощающих операции и позволяющих клиентам безопасно расти, процветать и достигать большего. Среди прочих организаций, подписавших соглашение о переходе на Alibaba Cloud — облачная игровая платформа The Game Company и оказывающая услуги по переработке отходов компания Accumed. Alibaba Cloud стремительно развивается за пределами КНР. В сентябре она подтверждала, что намерена запустить до конца года восемь новых дата-центров, в том числе в Дубае. Среди прочих регионов — Мексика, Япония, Малайзия и очередная локация в Южной Корее, где в текущем году компания открыла две новые. В конце августа сообщалось, что Alibaba разработала собственный ИИ-ускоритель для инфреренса, который поможет компании избавиться от зависимости от ИИ-чипов NVIDIA и других зарубежных продуктов.

19.10.2025 [13:09], Сергей Карасёв

Meta✴ привлекла почти $30 млрд на строительство гигантского ИИ ЦОД Hyperion в ЛуизианеКомпания Meta✴ Platforms, по информации Bloomberg, получит от частной инвестиционной фирмы Blue Owl Capital финансирование в размере почти $30 млрд для строительства гигантского кампуса дата-центров в округе Ричленд в Луизиане (США) для масштабных нагрузок ИИ. Речь идёт о проекте Hyperion, который был анонсирован в конце 2024 года. Комплекс расположится на 910 га бывших сельскохозяйственных угодий. Общая площадь сооружений в составе кампуса превысит 371 тыс. м2. Завершить строительные работы планируется к 2030 году. Как сообщает Bloomberg, ссылаясь на данные, полученные от осведомлённых источников, финансирование строительства будет осуществляться через компанию специального назначения (SPV), созданную Morgan Stanley для этого проекта. Партнёрами в рамках соглашения выступают Meta✴, Blue Owl Capital и ещё один инвестиционный фонд — Pimco. Вложения составят $2,5 млрд в виде акционерного капитала и $27 млрд в виде заёмных средств. Привлечение структуры SPV означает, что сама Meta✴ формально не заимствует средства, а следовательно, не должна отражать большую задолженность на своём балансе. Кроме того, благодаря формированию SPV повысится эффективность управления финансовыми потоками и операциями, связанными с инициативой Hyperion.

Источник изображения: Meta✴ Соглашение предполагает, что Meta✴ будет владеть только 20 % долей в новом кампусе ИИ ЦОД. Долг должен быть полностью погашен к 2049 году. Meta✴ будет отвечать за создание и эксплуатацию объекта после его ввода в строй в конце текущего десятилетия. При этом сама компания будет арендовать вычислительные ресурсы площадки. Изначально предполагалось, что мощность Hyperion составит до 2 ГВт. Однако впоследствии Meta✴ повысила планку до 5 ГВт. Для удовлетворения таких потребностей понадобится существенное расширение энергетической инфраструктуры в регионе размещения кампуса. С этой целью Meta✴ заказала строительство новой газогенераторной установки у местного оператора коммунальных услуг Entergy. На начальном этапе на этой станции будут смонтированы три парогазовых турбины общей генерирующей мощностью более 2,2 ГВт, а также ЛЭП. Суммарная стоимость строительства Hyperion с учётом оборудования может достигнуть $50 млрд. В целом, Meta✴ намерена инвестировать «сотни миллиардов долларов» в мультигигаваттные дата-центры для задач ИИ. В частности, помимо кампуса Hyperion в Луизиане, будет создан ЦОД мощностью 1 ГВт в Эль-Пасо (El Paso) в Техасе (США). На этот объект компания планирует потратить более $1,5 млрд.

19.10.2025 [09:36], Владимир Мироненко

Micron покидает серверный рынок Китая после санкций правительстваКомпания Micron прекратит поставки серверных чипов памяти китайским провайдерам ЦОД, сообщило агентство Reuters со ссылкой на информированные источники. После введения в 2023 году правительством КНР запрета на использование чипов Micron в ключевых инфраструктурных проектах ей так и не удалось восстановить свой бизнес в стране в этом сегменте. Вместе с тем Micron продолжит поставки продукции двум компаниям, имеющим крупные ЦОД за пределами Китая. По словам источников, одна из них — Lenovo. Micron стал первым американским производителем чипов, попавшим под ограничения Пекина, которые были восприняты как ответ на серию ограничений, введённых Вашингтоном с целью сдерживания технологического прогресса китайской полупроводниковой промышленности. За последний финансовый год Micron получила $3,4 млрд — 12 % от общего объёма выручки — от операций на материковом Китае. По данным Reuters, в настоящее время в команде Micron, занимающейся поставками для ЦОД в Китае, работает более 300 человек. И насколько значительным будет её сокращение, пока неизвестно. «Micron будет искать клиентов за пределами Китая в других частях Азии, в Европе и Латинской Америке», — сообщил Reuters Джейкоб Борн (Jacob Bourne), аналитик Emarketer. Он отметил, что Китай является критически важным рынком, однако сейчас наблюдается расширение ЦОД по всему миру, обусловленное спросом на ИИ, и Micron рассчитывает на то, что сможет компенсировать на других рынках потерю бизнеса в Поднебесной. Запрет на использование продукции Micron в критически важной инфраструктуре Китая принёс выгоду её конкурентам — Samsung и SK hynix, а также китайским компаниям YMTC и CXMT, которые активно расширяют деятельность при поддержке китайского правительства. Согласно обзору государственных закупок, проведенному агентством Reuters, в прошлом году инвестиции в ЦОД в Китае выросли в девять раз и достигли ¥24,7 млрд ($3,4 млрд). Тем не менее Micron удалось компенсировать сокращение выручки в Китае поставками в другие страны благодаря огромному спросу на ЦОД и сопутствующие инструменты и добиться рекордной квартальной выручки. Вместе с тем Micron продолжит поставлять чипы китайским компаниям, занятым в автомобильной отрасли и секторе производства мобильных телефонов. Также производитель микросхем памяти продолжил расширять некоторые другие направления в стране, включая завод по упаковке микросхем памяти в Сиане. «У нас сильное производственное и клиентское присутствие в Китае, и Китай остаётся важным рынком для Micron и полупроводниковой промышленности в целом», — сообщила Micron агентству Reuters. Как пишет Data Center Dynamics, в июне Micron заявила о планах инвестировать $200 млрд в расширение производства микросхем памяти в США. Средства будут направлены на строительство второй фабрики по производству чипов памяти в Бойсе (Айдахо), двух дополнительных фабрик в Нью-Йорке и расширение производства в Манассасе (Вирджиния).

18.10.2025 [22:25], Владимир Мироненко

К полувековому юбилею суперкомпьютера Cray-1 выпущена памятная однодолларовая монетаМонетный двор США представил дизайн памятных однодолларовых монет для программы 2026 American Innovation $1 Coin Program. На одной из них изображён Cray-1 — один из самых известных суперкомпьютеров всех времён, отличавшийся инновационной для своего времени конструкцией и уникальным дизайном. В рамках этой программы, действующей с 2018 года, ежегодно выпускаются четыре монеты, представляющие «американские инновации, а также значительные инновационные и новаторские достижения отдельных лиц или групп». В этом году дизайн монет для программы был предложен штатами Айова, Висконсин, Калифорния и Миннесота. Дизайн монеты с изображением Cray-1 был предложен штатом Висконсин, где находится исследовательский центр Cray Research, в котором был создан Cray-1 под руководством ныне покойного Сеймура Крея (Seymour Cray) и соучредителя, главного инженера Лестера Дэвиса (Lester Davis). На лицевой стороне монеты размещено изображение вида сверху суперкомпьютера Cray-1 с круговым расположением вычислительных блоков. На С-образном корпусе машины видна надпись Cray-1 Supercomputer, а также подписи художника и скульптора Пола Романо (Paul Romano) и Джона П. Макгроу (John P. McGraw). Также есть надписи «Соединённые штаты Америки» и «Висконсин». Памятные монеты вряд ли поступят в регулярное обращение, и их вряд ли можно будет купить в банке за доллар. Они являются законным платёжным средством, но в первую очередь — предметом коллекционирования. Предыдущие памятные долларовые монеты продавались монетным двором по цене от $13,25. Cray-1 стал первым суперкомпьютером, в котором была успешно реализована концепция векторного процессора, позволяющего повысить скорость математических операций путём оптимальной организации памяти и регистров для быстрого выполнения одной операции с большим набором данных. В предыдущих системах эта концепция была реализована с ограниченной производительностью. Cray-1 работал в несколько раз быстрее любой аналогичной конструкции и лидировал среди суперкомпьютеров с 1976 по 1982 год, достигая впечатляющих 160 Мфлопс благодаря инновационному использованию интегральных схем. За всё время существования системы на рынке было продано более 80 машин, что сделало Cray-1 одним из самых успешных в этой категории за всю историю вычислительных систем. Он известен своей уникальной формой: относительно небольшим С-образным корпусом, окружённым кольцом «тумбочек», закрывающих блоки питания и систему охлаждения. Согласно «Википедии», после анонса Cray-1 с частотой 80 МГц в 1975 году ажиотаж вокруг него был настолько велик, что между Ливерморской национальной лабораторией имени Лоуренса (LLNL) и Лос-Аламосской национальной лабораторией (LANL) разгорелась настоящая война за право покупки первой машины. В итоге последняя выиграла тендер и получила в 1976 году первый экземпляр Cray-1 с серийным номером 001. Национальный центр атмосферных исследований США (NCAR) стал первым официальным клиентом Cray Research в 1977 году, заплатив $8,86 млн (сейчас это более $47 млн с учётом инфляции) за суперкомпьютер с серийным номером 003. Этот суперкомпьютер был выведен из эксплуатации в 1989 году.

18.10.2025 [21:42], Сергей Карасёв

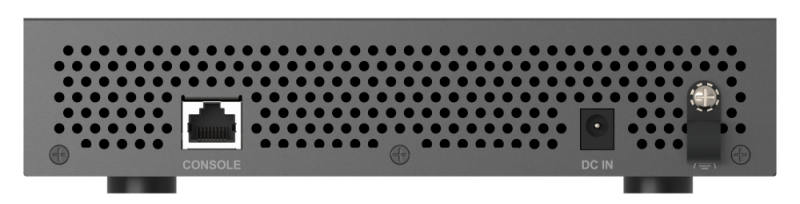

QNAP представила 10GbE-коммутатор QSW-L3205-1C4T с пятью портами для малого бизнесаКомпания QNAP Systems анонсировала коммутатор QSW-L3205-1C4T в «настольном» форм-факторе, ориентированный на сферу малого бизнеса, небольшие студии, профессиональных создателей контента и пр. Устройство также может использоваться для организации потоковой передачи видео с камер наблюдения. Новинка относится к так называемым решениям Lite Managed, то есть, занимает промежуточное положение между неуправляемыми и полностью управляемыми коммутаторами L2. Реализована поддержка VLAN, QoS (Quality of Service), IGMP Snooping и функция зеркалирования портов. Коммутатор располагает четырьмя портами 10GbE (на основе разъёмов RJ45), которые могут функционировать в режимах 5GbE, 2.5GbE, 1GbE и 100MbE. Кроме того, имеется один комбинированный порт 10GbE SFP+ / RJ45. Есть поддержка LACP (до 20 Гбит/с). Общая коммутационная способность достигает 100 Гбит/с. Говорится о совместимости со стандартами IEEE 802.3az, 802.3x и др. Предусмотрен консольный порт (RJ45). Устройство заключено в металлический корпус с габаритами 44 × 210 × 160 мм и весит 1,17 кг. Применяется пассивное охлаждение; диапазон рабочих температур — от 0 до +40 °C. Питание подаётся от внешнего адаптера; максимальное энергопотребление составляет 36 Вт. На новинку предоставляется двухлетняя гарантия, но за отдельную плату можно продлить гарантийный срок до 5 лет.

18.10.2025 [15:39], Сергей Карасёв

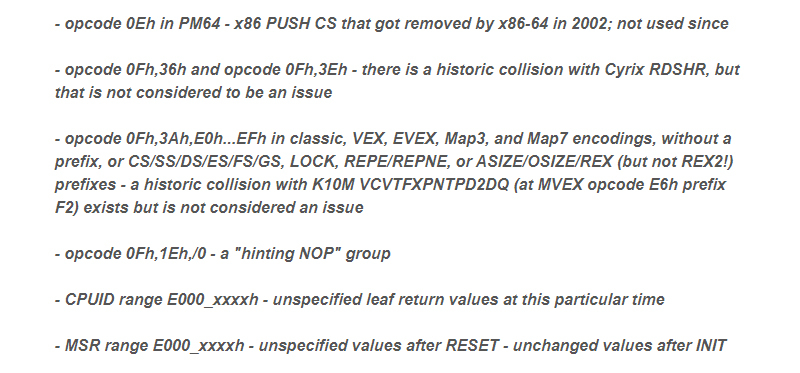

В Linux появилось упоминание загадочного x86-процессора от неизвестного ранее производителяВ списках рассылок Linux Kernel и GNU Binutils, по сообщению ресурса Phoronix, появилась информация о кодах операций (opcode), которые используются в процессорах с архитектурой х86, не имеющих отношения к изделиям AMD и Intel. О каком именно производителе чипов идёт речь, пока не ясно. О загадочных инструкциях сообщил Кристиан Ладлофф (Christian Ludloff), опытный эксперт по архитектуре x86. Он в течение многих лет работал в компаниях Google, AMD и Texas Instruments. Кроме того, Ладлофф является создателем сайта sandpile.org, на котором собрана различная техническая информация о чипах x86. Известно, что новые инструкции используются в продуктах некоего производителя изделий. То есть речь не идёт об исследовательской организации или каком-либо экспериментальном проекте.

Источник изображения: Phoronix Высказываются предположения, что за новым x86-процессором может стоять китайская компания Zhaoxin. Минувшим летом она представила чип KH-50000 для серверов и ИИ-систем. Изделие выполнено на x86-совместимой архитектуре Zhaoxin Century Avenue, лицензия на которую ей досталась по наследству от Cyrix и VIA. В целом, китайские компании на фоне американских санкций активно развивают направление собственных серверных чипов. Так, компания Loongson недавно представила 64-ядерные процессоры 3C6000 на архитектуре LoongArch. Однако для Zhaoxin нет смысла секретничать, поскольку компания давно открыто и активно занимается разработкой, развивая открытые проекты, в том числе ядро Linux, библиотеки, компиляторы и т.д. В Китае также есть Hygon, которая, как ранее сообщалось, готовит 128-ядерного конкурента AMD EPYC с SMT4 и AVX-512. Ранее AMD и Hygon выпустили процессор Dhyana, который представлял собой чуть доработанный под местные требования первые EPYC Naples. Чем-то похожим занимается Montage Technology, выпускающая под брендом Jintide перелицованные Intel Xeon. Также известна тайваньская DM&P Electronics, которая выпускает 32-бит x86-процессоры Vortex86, которые корнями уходят к Rise Technology и SiS. Лицензии на современный набор инструкций у неё нет. Среди других предположений, высказанных в Сети, есть упоминание сделки Intel с NVIDIA по разработке кастомных CPU. Наконец, упоминаются эмуляторы, программные или с аппаратной поддержкой, т.е. не x86-процессоры. Это может быть интересно, например, Qualcomm. Кроме того, в российских процессорах «Эльбрус» есть двоичная трансляция x86-кода. |

|