Лента новостей

|

17.10.2025 [17:18], Руслан Авдеев

Poolside и CoreWeave построят в Техасе 2-ГВт кампус ИИ ЦОД, работающий на газе из Пермского бассейнаИИ-стартап Poolside объединился с CoreWeave для строительства кампуса ЦОД Project Horizon мощностью 2 ГВт на площади 230 га на территории ранчо Longfellow в Западном Техасе. Для электроснабжения планируется использовать природный газ, добываемый в местном Пермском бассейне, сообщает Datacenter Dynamics. ЦОД построят с использованием «гибридного модульного подхода», предполагающего «параллельное, а не последовательное строительство», которое будет завершено в I квартале 2027 года. CoreWeave станет ключевым арендатором первой фазы проекта, которая должна обеспечить мощность 250 МВт в соответствии с договором аренды на 15 лет. В будущем допускается увеличение арендуемых мощностей до 500 МВт. Также соглашение компаний предусматривает, что с декабря CoreWeave предоставит Poolside кластер NVIDIA GB300 NVL72 с более чем 40 тыс. чипов. По словам Poolside, партнёрство с CoreWeave обеспечит немедленный доступ к ускорителям новейшего поколения, что позволит обучать модели с триллионами параметров. Poolside основана в 2023 году. Стартап разрабатывает ПО для автоматизации написания программного кода с высокими корректностью и безопасностью, достаточных для того, чтобы его можно было использовать в государственных учреждениях. По данным Bloomberg, в 2024 году компания выпустила ИИ-агента для разработчиков государственного и оборонного секторов. Также ведутся работы и в области создания «общего искусственного интеллекта» (AGI).

Источник изображения: Bailey Alexander/unsplash.com Пока Poolside проводит раунд привлечения $2 млрд инвестиций, оценка стоимости компании по его итогам должна составить $14 млрд. Большую часть средств направят на приобретение 40 тыс. ускорителей NVIDIA. В 2024 года стартап уже привлёк $500 млн, получив оценку в $3 млрд. Компания является известным клиентом Fluidstack, а также арендовала некоторое количество NVIDIA H100 у Iris Energy. Благодаря большим запасам природного газа и относительно доступной электроэнергии в целом Техас стал весьма привлекательным местом для строителей дата-центров. По информации CBRE, сегодня это второй по величине рынок ЦОД в США. В штате реализуется первый проект в рамках инициативы Stargate, Meta✴ инициировала строительство ЦОД на 1 ГВт в Эль-Пасо, а Fermi America, будучи новичком на рынке дата-центров, заранее договорилась о подключение к газопроводу своего будущего 11-ГВт кампуса в Амарилло (Amarillo).

17.10.2025 [16:00], Руслан Авдеев

Meta✴ построит ещё один гигаваттный ИИ ЦОД, на этот раз в ТехасеMeta✴ Platforms строит в Техасе новый дата-центр гигаваттной мощности для ИИ-проектов. Это последняя в серии значимых инвестиций компании, намеренной добиться паритета с конкурентами-гиперскейлерами в сфере ИИ, сообщает Bloomberg. Компания потратит более $1,5 млрд на новый ЦОД в Эль-Пасо (El Paso, Техас). Мощность дата-центра составит 1 ГВт. Ожидается, что центр введут в эксплуатацию в 2028 году. Как сообщается в блоге компании, в районе Эль-Пасо будут поддерживаться малые бизнесы в рамках программы Community Accelerator, которая помогает в обучении навыкам работы с ИИ, в том числе Meta✴ AI для роста деловой активности. В следующем году в городе заработает грантовая программа Community Action Grants. Meta✴ активно тратит средства на ИИ-инфраструктуру и кадры наряду с конкурентами вроде OpenAI и Google, разрабатывающими передовые ИИ-модели. Ранее в текущем году Meta✴ уже анонсировала строительство ЦОД Hyperion в Луизиане, стоимость которого, по словам президента США, может составить $50 млрд. На этот проект Meta✴ уже привлекла от Pacific Investment Management и Blue Owl Capital $29 млрд. Строятся и другие гигаваттные ЦОД, в том числе Prometheus в Огайо.

Источник изображения: Meta✴ ИИ становится одним из ключевых направлений деятельности компании, использующей технологию для собственного чат-бота, показа релевантных интересам пользователей видеороликов и рекламы в Instagram✴ и Facebook✴. Важность ИИ-помощников подчёркивал и глава компании Марк Цукерберг (Mark Zuckerberg). В текущем году капитальные расходы Meta✴ должны составить до $72 млрд, в том числе речь идёт об инфраструктурных проектах, связанных с ИИ. По словам Цукерберга, на искусственный интеллект «лучше потратить больше, чем меньше». В 2024 году глава Meta✴ заявил, что есть ненулевая вероятность того, что многие бизнесы сейчас избыточно наращивают мощности в сфере ИИ. Тем не менее Цукерберг считает, что решение о крупных инвестициях рациональное, поскольку в случае отставания придется оставаться в хвосте на рынке технологий в ближайшие 10–15 лет. ЦОД в Эль-Пасо получит стойки AMD Helios. Arm недавно заявила о расширении партнёрства с Meta✴. Стороны заключили долгосрочное соглашение, в рамках которого будут совместно наращивать усилия по разработке ПО и аппаратного обеспечения. Meta✴ намерена использовать платформу Arm Neoverse для разработки чипов для ЦОД, которые смогут обеспечить повышенную производительность и меньшее энергопотребление в сравнении с решениями конкурентов на базе технологий Intel.

17.10.2025 [14:44], Сергей Карасёв

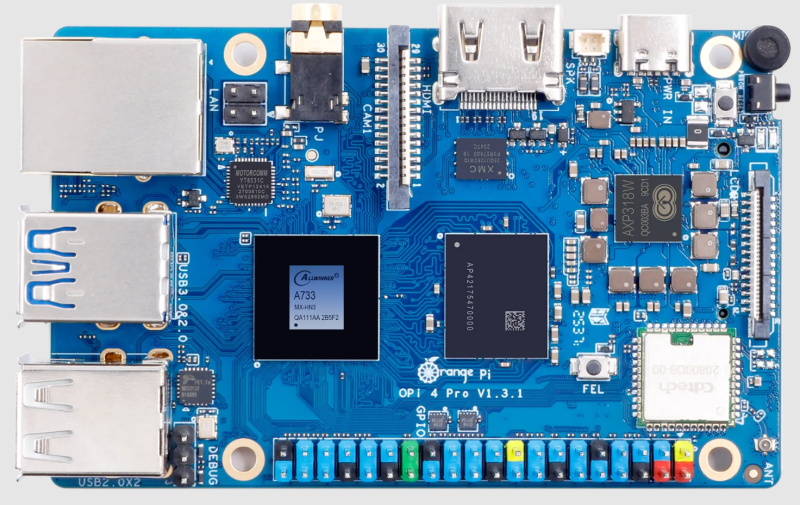

Одноплатный компьютер Orange Pi 4 Pro объединил ядра Arm и RISC-VДебютировал одноплатный компьютер Orange Pi 4 Pro, предназначенный для построения периферийных устройств с ИИ-функциями, систем промышленной автоматизации, сетевых хранилищ данных, шлюзов и пр. В основу новинки положена аппаратная платформа Allwinner. Применён процессор A733, объединяющий два ядра Arm Cortex-A76 с частотой до 2 ГГц, шесть ядер Arm Cortex-A55 с частотой до 1,8 ГГц, а также ядро реального времени XuanTie E902 RISC-V с частотой 200 МГц. Чип содержит графический блок Imagination BXM-4-64 и нейропроцессорный модуль (NPU) с производительностью до 3 TOPS на операциях INT8 (говорится также о поддержке INT16/FP16/BF16). Объём оперативной памяти LPDDR5 может составлять 4, 6, 8, 12 и 16 Гбайт. Изделие располагает коннектором M.2 M-Key для SSD с интерфейсом PCIe 3.0 (NVMe) и слотом microSD с поддержкой карт ёмкостью до 128 Гбайт, а опционально может быть добавлен накопитель eMMC вместимостью 16, 32, 64 или 128 Гбайт. Предусмотрены адаптеры Wi-Fi 6 и Bluetooth 5.4 (BLE), сетевой контроллер 1GbE (YT8531CA) с поддержкой PoE. В набор разъёмов входят три порта USB 2.0 Type-A, по одному порту USB 3.0 Type-A и USB Type-C (служит для подачи питания 5 В / 3 А), гнездо RJ45 для сетевого кабеля, коннектор HDMI 2.0 и аудиогнездо на 3,5 мм. Есть интерфейс MIPI-DSI (4 линии), два интерфейса MIPI-CSI (4 и 2 линии) и 40-контактная колодка GPIO, совместимая с Raspberry Pi. Габариты составляют 89 × 56 мм, масса — 58 г. Стоимость Orange Pi 4 Pro начинается примерно с $30 в варианте с 4 Гбайт ОЗУ.

17.10.2025 [10:47], Сергей Карасёв

SK hynix показала 245-Тбайт SSD серии PS1101 для дата-центровКомпания SK hynix в ходе мероприятия Dell Technologies Forum 2025 в Сеуле (Южная Корея) продемонстрировала свои новейшие SSD, оптимизированные для высокопроизводительных серверов и дата-центров для ИИ. В частности, показаны устройства PEB110, PS1010, PS1012 и PS1101.

Источник изображения: SK hynix Особого внимания заслуживает накопитель PS1101. Это решение, выполненное в форм-факторе E3.L, вмещает 245 Тбайт информации. Новинка ориентирована на крупномасштабные ИИ ЦОД и облачные среды, где критически важны высокая плотность хранения данных и энергоэффективность. В основу SSD положены чипы флеш-памяти QLC NAND, а для подключения служит интерфейс PCIe 5.0 х4. Скоростные показатели и величина IOPS пока не раскрываются. Устройству PS1101 предстоит конкурировать с другими SSD аналогичной ёмкости, о подготовке которых уже сообщили некоторые игроки рынка. В частности, Kioxia в июле нынешнего года анонсировала накопитель серии LC9 типоразмера EDSFF E3.L, рассчитанный на хранение 245,76 Тбайт данных. Кроме того, Sandisk представила NVMe SSD UltraQLC SN670 объёмом 256 Тбайт, предназначенный для ИИ-систем и НРС-платформ. А компания Samsung проектирует SSD с интерфейсом PCIe 6.0, вместимость которых будет достигать 512 Тбайт. Возвращаясь к новинкам SK hynix, можно выделить изделие PS1012 в форм-факторе U.2, которое вмещает до 61,44 Тбайт данных. Устройство выполнено на чипах флеш-памяти QLC NAND и оснащено интерфейсом PCIe 5.0 х4. В свою очередь, модель PEB110 типоразмера E1.S имеет вместимость до 8 Тбайт: этот продукт базируется на чипах TLC NAND с подключением посредством PCIe 5.0 х4. Наконец, изделие PS1010 получило исполнение E3.S, чипы TLC NAND, интерфейс PCIe 5.0 х4 и ёмкость до 15 Тбайт.

17.10.2025 [08:46], Руслан Авдеев

Поддерживаемый Equinix разработчик малых ядерных реакторов Radiant начнёт строительство своего первого завода уже в 2026 годуАмериканская Radiant, занимающаяся разработкой малых модульных реакторов (SMR) и поддерживаемая Equinix, объявила о создании своего первого производства SMR на площадке Манхэттенского проекта в Ок-Ридже (Oak Ridge, шт. Теннеси), сообщает Datacenter Dynamics. Строительство завода R-50 стартует в начале 2026 года. Компания намерена поставить первый серийный реактор Kaleidos к 2028 году и в течение нескольких лет нарастить производство до 50 реакторов ежегодно. Сейчас Radiant работает над моделью Kaleidos, высокотемпературным реактором с газовым охлаждением, использующим топливо TRISO, гелиевый теплоноситель и призматические графические сборки. Radiant утверждает, что модульная контейнеризированная SMR-платформа может быть развёрнута всего за несколько дней. Пока компания ведёт переговоры с Комиссией по ядерному регулированию США (NRC). Не так давно она вошла в число 11 проектов программы Министерства энергетики США (DoE) по пилотному внедрению новых ядерных технологий. Компания завершила работы по основному проектированию и подготовке эксперимента для прототипа Kaleidos с целью начать лабораторные испытания уже в середине 2026 года.

Источник изображения: Radiant В августе 2025 года подписано соглашение с Equinix о поставке оператору ЦОД 20 SMR. Тогда же компания подписала контракт на сумму £4 млн ($5,1 млн) с компанией Urenco, занимающейся обогащением урана. Предполагается поставка в США высококачественного уранового топлива HALEU. Индустрия ЦОД стала одним из крупнейших инвесторов в передовые ядерные технологии. Участники полагают, что они могут стать ключевым источником энергии для обеспечения базовой мощности. За последний год с разработчиками SMR подписали соглашения Amazon, Google, Data4, Oracle, Switch и Endeavour.

17.10.2025 [01:23], Владимир Мироненко

Британцы раздумывали над уничтожением дата-центра с секретными данными, который по недосмотру достался компании, связанной с КитаемПо словам двух бывших высокопоставленных сотрудников службы безопасности Великобритании, а также других информированных источников агентства Bloomberg, на протяжении более десяти лет китайские государственные структуры систематически взламывали секретные компьютерные системы правительства страны. Источники утверждают, что Китай регулярно получал доступ к информации низкого и среднего уровня секретности в защищённых ИТ-сетях правительства Великобритании, включая информацию с грифом «служебная тайна» и «секретно». Вместе с тем доступа к совершенно секретной информации у Китая не было. По словам одного из источников, одним из каналов утечек стал ЦОД в Лондоне, который использовался для хранения некоторой конфиденциальной правительственной информации. Он был продан организации, связанной с Китаем, в связи с чем в правительстве обсуждался план уничтожения ЦОД до того, как он сможет быть защищён иным способом. Название ЦОД, о котором идёт речь, не разглашается. Также не уточняется, что подразумевалось под уничтожением, поскольку был и другой выход — попросту убрать свои серверы с объекта. Так, например, поступила CloudFlare после компрометации своих систем, полностью заменив оборудование в одном из ЦОД. Комментируя сообщения прессы об утечках, представитель правительства Великобритании заявил, что «наиболее чувствительная» правительственная информация и системы, в которых она хранится, не были взломаны. Однако в среду бывший глава администрации премьер-министра Великобритании в 2019–2022 гг. сообщил газете The Times, что Китай взломал засекреченную компьютерную систему британского правительства и получил доступ к секретной информации: «Огромные объёмы данных, классифицированных как совершенно секретные и крайне опасные для получения любой иностранной организацией, были скомпрометированы». Его слова подтвердил в интервью радио LBC бывший министр безопасности страны в 2022–2024 гг., отказавшись вдаваться в подробности.

16.10.2025 [16:44], Сергей Карасёв

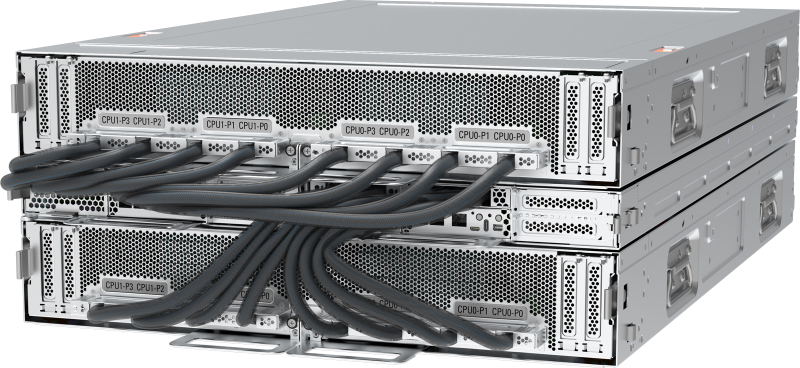

Pegatron представила ИИ-сервер AS501-4A1-16I1 с СЖО и 16 ускорителями AMD Instinct MI355XPegatron анонсировала высокопроизводительный сервер AS501-4A1-16I1 с СЖО для задач НРС, а также ресурсоёмких приложений ИИ, включая инференс и обучение больших языковых моделей. Устройство выполнено в форм-факторе 5OU на аппаратной платформе AMD. До восьми серверов AS501-4A1-16I1 могут быть установлены в стойку RA5100-128I1. Это позволяет сформировать ИИ-систему высокой плотности, насчитывающую до 32 процессоров EPYC 9005 и до 128 ускорителей Instinct MI355X. Конструкция системы включает два CPU-узла и два лотка GPU. Каждая из CPU-секций допускает установку двух процессоров AMD EPYC 9005 Turin с показателем TDP до 500 Вт и 24 модулей оперативной памяти DDR5-6400 RDIMM. Таким образом, в общей сложности могут быть задействованы четыре чипа EPYC и 48 модулей ОЗУ. В свою очередь, каждый из GPU-лотков оснащается восемью ускорителями AMD Instinct MI355X, которые несут на борту 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. В общей сложности реализованы 12 слотов PCIe 5.0 x16 FHHL, в которые установлены десять однопортовых сетевых адаптеров 400GbE и два двухпортовых адаптера 10GbE В оснащение входят контроллер Aspeed AST2600, два сетевых порта 1GbE (RJ45), выделенный сетевой порт управления (RJ45), последовательный порт (разъём Micro-USB), интерфейсы USB 2.0 Type-C и Mini-DP. В дополнение к СЖО имеются десять вентиляторов охлаждения. Применяется шина питания ORv3 на 48 В DC.

16.10.2025 [15:53], Руслан Авдеев

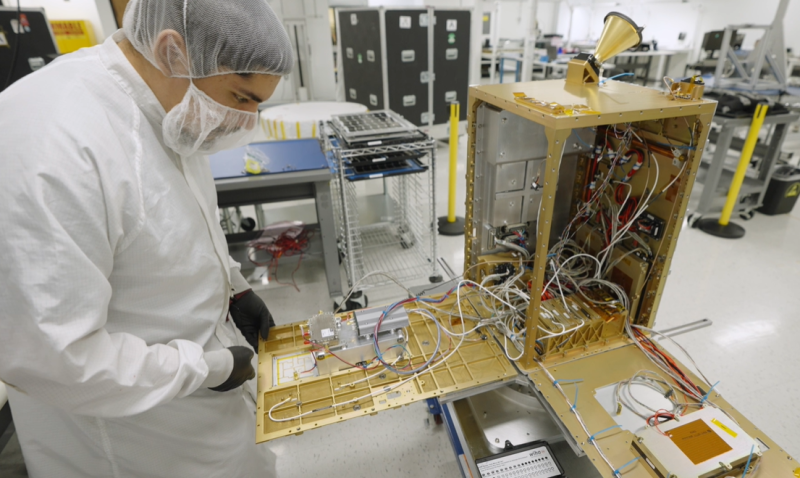

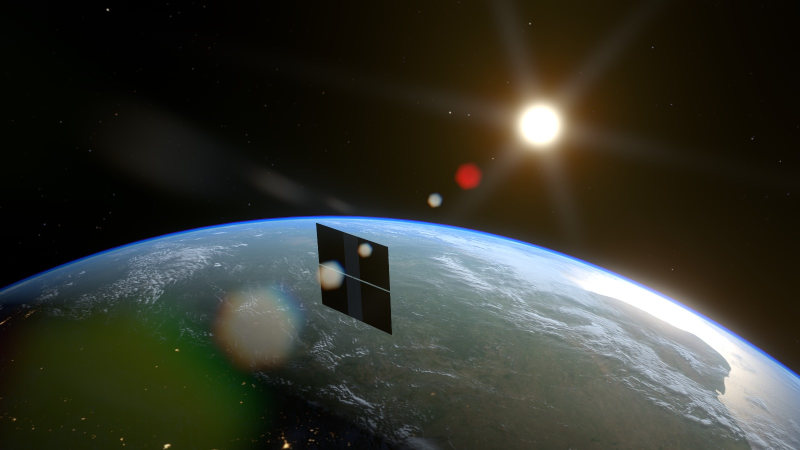

NVIDIA поможет Starcloud отправить в космос первый ИИ-спутник с H100Появление массовых космических дата-центров уже не за горами. В скором времени вывести на орбиту ИИ-спутник намерен стартап Starcloud (ранее Lumen Orbit), участвующий в грантовой программе NVIDIA Inception. В Starcloud заявляют, что в космосе доступна практически неограниченная возобновляемая энергия, которая даже с учётом расходов на запуск на порядок дешевле, чем на Земле. При этом постоянное нахождение Солнца в «пределах прямой видимости» позволяет отказаться от мощных резервных источников питания. Затраты ожидаются в основном до вывода в космос, а после предполагается десятикратная «экономия» углеродных выбросов в течение всего жизненного цикла в сравнении с ЦОД на Земле. Охлаждение в космосе тоже практически «бесплатное» и «безлимитное». Запуск спутника запланирован на ноябрь 2025 года. Речь идёт о дебютном использовании ИИ-ускорителей NVIDIA H100 в космосе. 60-килограммовый спутник Starcloud-1 размером с небольшой холодильник должен обеспечить в 100 раз более эффективные вычисления, чем любой предыдущий космический проект аналогичного назначения.

Источник изображения: Starcloud На начальном этапе космические дата-центры будут применяться для анализа данных наблюдений за земной поверхностью. Обработка данных в режиме реального времени в космосе обеспечивает огромные преимущества в критических ситуациях — при распознавании лесных пожаров, получении сигналов о бедствии и др. Инференс в космосе, т.е. там же, где будут собираться данные, позволяет выдавать результаты практически немедленно, снижая задержки с часов до минут. Методы наблюдения за Землёй включают съёмки камерами в нескольких диапазонах и радарами с синтезированной апертурой (SAR) для создания трёхмерных карт с высоким разрешением. SAR, в частности, генерируют около 10 Гбайт данных в секунду, поэтому обрабатывать информацию на месте намного выгоднее, чем отправлять её на Землю.

Источник изображения: Starcloud В Starcloud подчёркивают необходимость быть конкурентоспособными на фоне наземных ЦОД, поэтому компания выбрала ИИ-ускорители NVIDIA. Вместе с тем Starcloud — недавний «выпускник» программы Google for Startups Cloud AI Accelerator, поэтому для тестов будет использоваться LLM Gemma. Что касается будущих запусков, в перспективе Starcloud рассчитывает перейти на платформу NVIDIA Blackwell. Ещё осенью 2024 года сообщалось, что Lumen Orbit проектирует на орбите гигантские гигаваттные дата центры. Идея популярна — основатель Amazon Джефф Безос (Jeff Bezos) в начале октября заявлял, что в космосе скоро появится множество ЦОД гигаваттного масштаба.

16.10.2025 [13:39], Руслан Авдеев

Унификация, стандартизация, совместимость: Google призвала создавать взаимозаменяемые компоненты для ИИ ЦОДВ ходе мероприятия OCP Summit компания Google выступила с общеотраслевой инициативой «переосмысления» архитектуры ЦОД, оптимизированных для эпохи ИИ. В рамках сообщества Open Compute Project (OCP) предлагается создать рабочее направление по разработке «гибких, взаимозаменяемых ЦОД», сообщает пресс-служба компании. Google подчеркнула, что скорость внедрения и неоднородность ИИ-технологий растёт, что затрудняет создание общей системы, проектирования, развёртывания и обслуживания ЦОД. Представленный Google проект предусматривает создание модульных, совместимых друг с другом решений для ЦОД, позволяющих легко адаптироваться к стремительному развитию ИИ и изменению рабочих нагрузок. Говорится о «начале революции» в сфере ИИ — мир радикально изменился и необходимо создавать дата-центры, способные меняться не менее быстро. По данным компании, за последние 24 месяца использование ИИ-ускорителей внутри Google увеличилось в 15 раз, объём хранилищ для машинного обучения Hyperdisk ML — в 37 раз, а количество обработанных токенов — до двух квадрлн/мес. В Google сравнивают исследователей ИИ с исследователями космоса, а участников OCP, строителей инфраструктуры — со строителями ракет. Сама инфраструктура компании, как утверждается, поддерживает ИИ-трансформацию на всех уровнях экосистемы, от пользовательских приложений (на основе Gemini) до корпоративных сервисов и научных изысканий в самых разных областях. Особое внимание уделяется обеспечению взаимозаменяемости и гибкости: модульные компоненты, спроектированные различными участниками отрасли, должны быть совместимы с компонентами и системами других поколений и вендоров, причём принципы унификации должны применяться ко всем компонентам ЦОД, включая электропитание, охлаждение, вычислительное оборудование, сетевые технологии и др. Стратегия самой Google строится вокруг т.н. ИИ-гиперкомпьютера — комплексной архитектуры, в которой все компоненты от чипов до электросетей разработаны с учётом общих особенностей системы для обеспечения максимальной эффективности. Благодаря использованию собственных TPU, оптических коммутаторов и СЖО, компания добилась роста энергоэффективности и снижения затрат в 10–100 раз за последние 10 лет. Google уже развернула мегаваттами инфраструктуры с жидкостным охлаждением. Компания вместе с партнёрами организовала в рамках OCP рабочую группу, целью которой является создание единых стандартов обеспечения модульности и совместимости компонентов, а также общих интерфейсов в области вычислений, сетей, хранилищ, безопасности и устойчивости. В частности, участники OCP договорились о разработке гибких систем электропитания для современных ЦОД. Речь идёт о стандартизации 400-В архитектур и модульных системах Mt. Diablo с использованием твердотельных преобразователей. Также ведутся работы в сфере микросетей и аккумуляторных хранилищ. Всё вместе это позволит сглаживать пики потребления энергии, характерные для обучения ИИ, а в перспективе и возвращать излишки энергии обратно в энергосети. Охлаждение также переосмысливается в эпоху ИИ. В начале 2025 года OCP представлено современное решение для жидкостного охлаждения Project Deschutes. Теперь оно получит широкое распространение среди вендоров, включая поставщиков жидкостного охлаждения вроде Boyd, CoolerMaster, Delta, Envicool, Nidec, nVent и Vertiv. Сообщество работает над унификацией интерфейсов охлаждения, новых теплообменников. Важную роль играет стандартизация компонентов и интерфейсов в колокейшн- и сторонних ЦОД. Наконец, Google подчёркивает необходимость унификации физических стандартов: высоты, ширины, глубины и даже грузоподъёмности стоек; ширины и планировки проходов, интерфейсов стоечного и сетевого оборудования. Также требуются единые стандарты для телеметрии и мехатроники, которые лягут в основу строительства и эксплуатации дата-центров следующего поколения. Совместно с партнёрами по OCP ведутся работы над стандартизацией интеграции телеметрии для сторонних дата-центров. Помимо физической инфраструктуры, по словам Google, необходимо внедрение открытых стандартов для обеспечения масштабируемости и безопасности систем:

Для измерения воздействия на окружающую среду предложена методология измерения потребления энергии, воды и подсчёта выбросов в ходе ИИ-нагрузок. В частности, с их помощью выяснилось, что медианный промпт Gemini тратит менее 5 капель воды и электричество в объёме, достаточном для просмотра телевизора в течение менее девяти секунд. Эти методы подсчёта касаются и других, совместных с OCP проектов, включая выпуск экобезопасного бетона, чистой резервной энергии и др. Google приглашает принять участие в инициативе OCP Open Data Center for AI Strategic для разработки общих стандартов. Наконец, сообщество OCP призвали работать над проектами «ИИ для ИИ» — использованием искусственного интеллекта для разработки ИИ-систем следующего поколения. Так, проект AlphaChip предусматривает использование ИИ для размещения компонентов чипов, что уже позволило улучшить показатели мощности, производительности и др., одновременно сократив время проектирования. Предполагается, что создание ИИ систем с помощью ИИ, от полупроводников до программного обеспечения, позволит достигнуть нового уровня эффективности технологий.

16.10.2025 [12:12], Руслан Авдеев

Группа инвесторов, включающая NVIDIA, под руководством Macquarie Asset Management купит Aligned Data Centers за $40 млрд — это одна из крупнейших сделок на рынке ЦОДГруппа AI Infrastructure Partnership (AIP), фонд MGX из ОАЭ и Global Infrastructure Partners (GIP) под руководством Macquarie Asset Management намерены приобрести техасского оператора ЦОД Aligned Data Centers за $40 млрд. Сделка заключена в рамках более широкого проекта по развитию ИИ-инфраструктуры, сообщает пресс-служба Macquaire, и станет одной из крупнейших на рынке ЦОД. Ожидается, что сделка будет закрыта в I полугодии 2026 года. AIP включает NVIDIA, BlackRock, Microsoft, xAI, Global Infrastructure Partners (GIP, принадлежит BlackRock) и государственную инвесткомпанию (создана при участии Mubadala и G42) из ОАЭ. AI Infrastructure Partnership была сформирована в 2024 году с целью ускорения инвестиций в ИИ-инфраструктуру нового поколения. По словам BlackRock, благодаря инвестициям в Aligned будет обеспечено создание инфраструктуры, необходимой для будущих ИИ-проектов. Aligned располагает 50 дата-центрами и 5 ГВт доступной мощности. Помимо США Aligned имеет серьёзный бизнес в Латинской Америке — компания приобрела OData, владеющей объектами в Бразилии, Чили, Колумбии и Мексике в мае 2023 года. Также она является инвестором канадского оператора ЦОД QScale SEC.

Источник изображения: Aligned Data Centers Как сообщает Datacenter Knowledge, в последние месяцы IT-гиганты тратили миллиарды долларов на создание достаточной для удовлетворения спроса инфраструктуры ЦОД на фоне нарастающего интереса бизнеса к ИИ. В UBS утверждают, что мировые инвестиции в искусственный интеллект могут составить в 2025 году $375 млрд, а к 2026 году — $500 млрд. Руководство Aligned Data Centers заявило, что новое партнёрство будет способствовать ускоренному выполнению миссии по созданию инфраструктуры, обеспечивающей будущее цифровой экономики. Компания утверждает, что готова к более активному масштабированию, дальнейшим инновациям и переосмыслению возможностей устойчивой инфраструктуры ЦОД. Руководителем Aligned останется Эндрю Шаап (Andrew Schaap), а компания сохранит штаб-квартиру в Далласе (Техас). |

|