Лента новостей

|

10.08.2025 [15:21], Сергей Карасёв

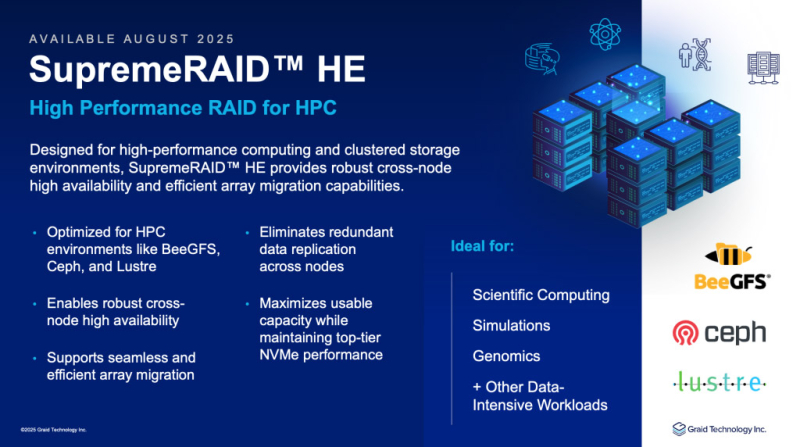

Graid представила платформу SupremeRAID HE: массивы NVMe RAID для НРС-средКомпания Graid Technology объявила о глобальной доступности платформы SupremeRAID HE (HPC Edition), предназначенной для создания программно-определяемых массивов NVMe RAID с ускорением на базе GPU. SupremeRAID HE переносит операции RAID с CPU на GPU, что, как утверждается, позволяет полностью раскрыть потенциал производительности NVMe SSD. Заявлена совместимость с такими параллельными файловыми системами, как Ceph, Lustre, MinIO и IBM SpectrumScale. Возможно развёртывание JBOF в системах с коммутаторами Broadcom. Благодаря GPU-ускорению заявленная пропускная способность достигает 132 Гбайт/с при чтении данных и 83 Гбайт/с при записи (после выполнения RAID-операций). Заявлена поддержка RAID 0/1/5/6/10, NVMe-oF, конфигураций с двумя контроллерами и функции миграции массива. Допускается использование до 32 накопителей. SupremeRAID HE предлагается в виде комплекта из GPU-ускорителя и лицензии на ПО. В качестве аппаратной составляющей могут использоваться карты NVIDIA RTX A1000 (8 Гбайт GDDR6) или NVIDIA RTX 2000 Ada (16 Гбайт GDDR6). «Перенося операции RAID на GPU, мы предоставляем клиентам возможность масштабировать производительность накопителей NVMe, сохраняя при этом высокую доступность узлов — без сложностей репликации и компромиссов», — говорит Леандер Ю (Leander Yu), президент и генеральный директор Graid Technology. Отмечается, что SupremeRAID HE допускает развёртывание в широком спектре инфраструктур, включая платформу Supermicro High Availability Dual Node All-Flash петафлопсного класса. Новое RAID-решение ориентировано на среды с высокими нагрузками, включая НРС. Говорится о совместимости с Ubuntu 20.04–24.04 и RHEL 8.x–9.x.

10.08.2025 [00:10], Владимир Мироненко

Samsung решила возродить сверхбыстрые SSD с памятью Z-NANDКомпания Samsung Electronics возрождает технологию памяти Z-NAND после семилетнего перерыва, позиционируя её как высокопроизводительное решение для ИИ-нагрузок. По данным DigiTimes, следующее поколение памяти Z-NAND получит 15-кратное увеличение производительности по сравнению с современными NVMe SSD и даст ускорителю возможность напрямую обращаться к накопителю Z-NAND с минимальными задержками. Как пишет Tom's Hardware, исполнительный вице-президент Samsung по производству памяти сообщил, что при значительном росте производительности с помощью технологии Z-NAND энергопотребление накопителей будет на 80 % ниже по сравнению с традиционной флеш-памятью NAND. Кроме того, в новом поколении упор сделан на минимизацию задержек. Для этого Samsung внедряет новую технологию GPU-Initiated Direct Storage Access (GIDS), которая позволит ускорителям напрямую обращаться к устройствам хранения Z-NAND, минуя CPU и RAM, тем самым значительно сокращая время доступа. Samsung представила технологию Z-NAND в 2016 году в качестве альтернативы памяти Intel 3D XPoint (Optane). Вышедший в 2018 году твердотельный накопитель Samsung 983 ZET на базе 64-слойной SLC 3D V-NAND предлагал значительно более низкую задержку и высокие скорости в сравнении с обычными NVMe SSD. По производительности он вплотную приблизился к Intel Optane SSD 900P. Обе технологии фактически относятся к SCM (Storage Class Memory), хотя только Intel предлагала PMem-модули в виде DIMM. Однако в итоге разработку 3D XPoint последняя (вместе с Micron) забросила, да и Samsung, ответив выпуском Z-SSD на появление Optane, решила свою технологию не развивать. Примерно в то же время Kioxia (тогда ещё Toshiba) представила свой вариант сверхбыстрой SLC NAND — XL-Flash. Её она тоже довольно долго особенно не развивала, но планирует уже в следующем году представить XL-Flash SSD с переработанным контроллером, который обеспечит более 10 млн IOPS, особенно на небольших транзакциях. Для точной настройки SSD с целью повышения производительности при запуске ресурсоёмких ИИ-приложений компания сотрудничает с ведущими производителями ускорителей. Phison также предлагает eSLC-накопители PASCARI с технологией aiDAPTIV+. SLC-накопители также есть у Solidigm и Micron. Впрочем, широкая востребованность Z-SSD может оказаться под вопросом. Уже анонсированы быстрые SSD с интерфейсом PCIe 6.0. CXL же позволяет относительно недорого наращивать объём памяти, хотя и в ущерб задержкам. Так что Samsung придётся сделать новые Z-SSD не только быстрыми, но и экономически эффективными.

09.08.2025 [13:22], Сергей Карасёв

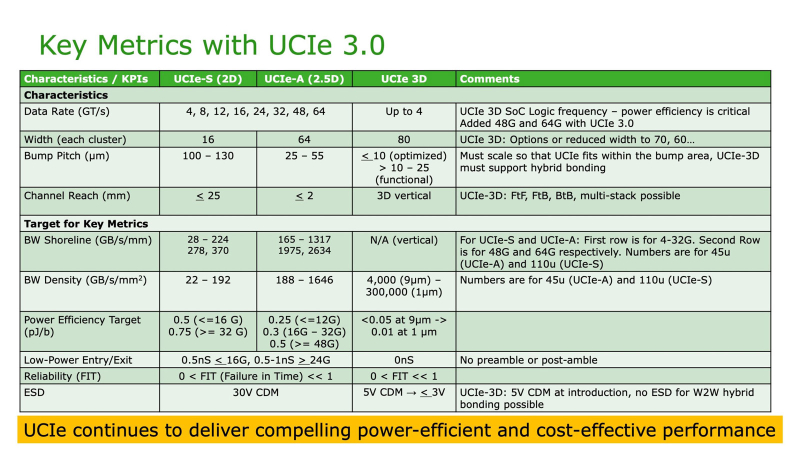

До 64 ГТ/с: обнародована спецификация UCIe 3.0 для объединения чиплетовКонсорциум Universal Chiplet Interconnect Express (UCIe) объявил о выпуске спецификации UCIe 3.0 для соединения чиплетов в составе высокопроизводительных систем, таких как платформы аналитики данных, HPC и ИИ. Напомним, консорциум UCIe был сформирован в 2022 году с целью создания стандартного интерконнекта, позволяющего объединять в одном корпусе чиплеты разных производителей, обладающие различными функциями и изготовленные на разных предприятиях. В состав консорциума вошли Intel, AMD, Qualcomm и TSMC, а также ведущие гиперскейлеры, включая Google Cloud, Meta✴ и Microsoft. Обнародованная спецификация UCIe 3.0 предусматривает удвоение скорости по сравнению со стандартом предыдущего поколения — до 48 и 64 ГТ/с для вариантов UCIe-S (стандартная упаковка 2D) и UCIe-A (передовая упаковка 2.5D). Таким образом, достигается более высокая пропускная способность в расчёте на соединение, что имеет большое значение, когда для обмена данными между кристаллами может быть задействовано строго ограниченное количество соединений. В случае UCIe 3D скорость ограничивается 4 ГТ/с.

Для UCIe 3.0 заявлена обратная совместимость со спецификациями предыдущих поколений. Упомянута улучшенная перекалибровка во время выполнения, обеспечивающая снижение энергопотребления каналов передачи данных и чиплетов. Предусмотрены и другие усовершенствования, ориентированные на повышение плотности полосы пропускания, энергоэффективности и управляемости на системном уровне. В целом, спецификация UCIe 3.0 обеспечивает более высокую масштабируемость, гибкость и совместимость, что, как считают участники консорциума, поможет ускорить инновации в области модульной полупроводниковой архитектуры. Вместе с тем некоммерческая организация Open Compute Project Foundation (OCP) выпустила новую спецификацию Universal D2D Transaction и Link-Layer, которая охватывает в том числе UCIe.

09.08.2025 [13:19], Сергей Карасёв

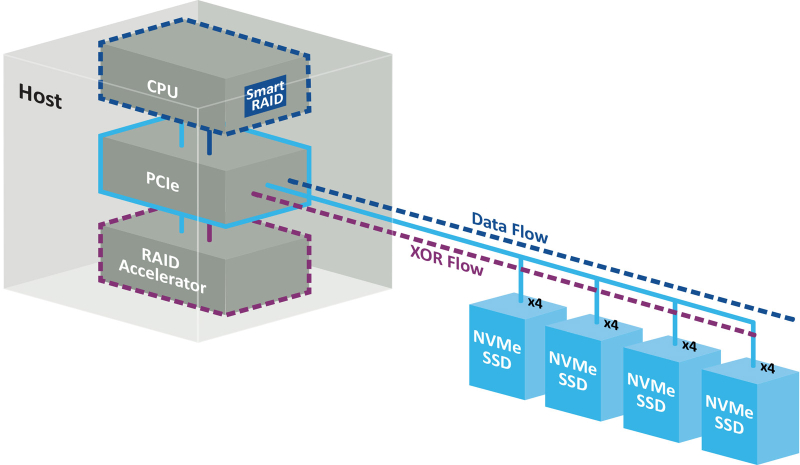

Беспортовый контроллер: Microchip представила RAID-ускорители Adaptec SmartRAID 4300 для NVMe-хранилищКомпания Microchip Technology анонсировала ускорители Adaptec SmartRAID 4300 для дата-центров, поддерживающих ресурсоёмкие нагрузки, в том числе связанные с ИИ. Решения предназначены для работы с массивами NVMe RAID в составе программно-определяемых хранилищ (SDS). Концепция Adaptec SmartRAID 4300 предполагает разделение платформы Microchip Smart Storage на программные и аппаратные компоненты. В данном случае CPU отвечает за непосредственную запись данных на твердотельные накопители, полноценно используя скоростные возможности интерфейса PCIe. Вместе с тем дополнительные расчёты (в том числе XOR-операции) переносятся с хост-процессора на RAID-ускоритель. Такой подход, как утверждается, устраняет узкие места, присущие традиционным решениям с последовательным подключением. В результате, достигается высокий уровень гибкости и масштабируемости. Возможно подключение до 32 устройств NVMe SSD с интерфейсом PCIe 4.0 х4 или PCIe 5.0 х4. По оценкам Microchip, изделия Adaptec SmartRAID 4300 обеспечивают семикратное увеличение производительности ввода-вывода (I/O) по сравнению с решениями предыдущего поколения. В частности, в средах Windows показатель IOPS в режимах RAID 0 и RAID 5 достигает 5 млн при произвольном чтении данных блоками по 4 Кбайт и соответственно 4,8 млн и 2,3 млн при произвольной записи. Скорость последовательного чтения составляет до 317 Гбайт/с (RAID 0) и 291 Гбайт/с (RAID 5), скорость последовательной записи — до 120 Гбайт/с (RAID 0) и 26 Гбайт/с (RAID 5). При работе с Linux скорости значительно выше. Так, величина IOPS в режимах RAID 0 и RAID 5 при произвольном чтении достигает 27,2 млн и 27,3 млн соответственно, при произвольной записи — 22,4 млн и 5,1 млн. Скорость последовательного чтения — до 300 и 291 Гбайт/с, последовательной записи — до 196 и 155 Гбайт/с. Ускорители выполнены в виде низкопрофильной (HHHL) карты расширения с интерфейсом PCIe 4.0 х16. Поддерживаются массивы RAID 0/1/5/10/50. Габариты составляют 68,9 × 167,65 мм. Значение MTBF (средняя наработка на отказ) — до 3 млн часов при температуре до +40 °C. Гарантирована совместимость с Windows Server, Red Hat Enterprise Linux, SuSE Linux Enterprise Server, Oracle Linux.

08.08.2025 [18:41], Руслан Авдеев

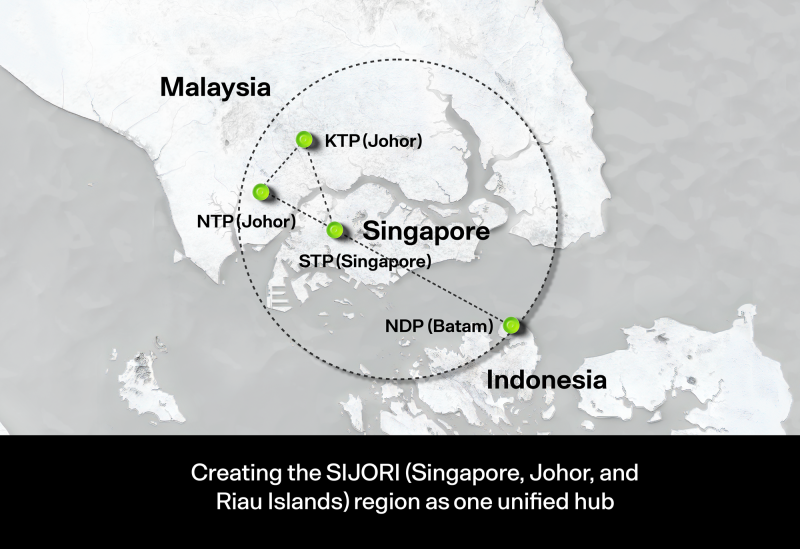

Во II квартале 2025 года штат Джохор (Малайзия) одобрил 42 проекта строительства ЦОДМалайзия взяла курс на ускоренную цифровизацию. Только штат Джохор (Johor) во II квартале 2025 года одобрил 42 проекта строительства дата-центров. Местные власти считают, что это позиционирует штат как лидера в области инвестиций в цифровую инфраструктуру страны, сообщает The Edge Malaysia. По словам представителя местного Комитета по жилищному строительству и самоуправлению, дата-центры служат ключевым драйвером развития особой экономической зоны Johor-Singapore Special Economic Zone (JS-SEZ), а также других проектов в регионе, в том числе призванных преобразовать экономику приграничных районов штата.

Источник изображения: Ven Jiun (Greg) Chee/unsplash.com Сообщается, что на заседании целевой группы по развитию ЦОД Джохора с участием высших руководителей страны, были рассмотрены и семь новых заявок на строительство дата-центров в районе Большого Джохор-Бару (Greater Johor Bahru). Правительство отдаёт приоритет строительству ЦОД в промышленных зонах вроде Ibrahim Technopolis (IBTEC) в Кулаи (Kulai), Sedenak и Pasir Gudang — эти места предлагают стратегические преимущества, в том числе прямой доступ к основным автомагистралям, энергоёмким электросетям, стабильному водоснабжению и близость к портам и международным аэропортам. Сообщается, что всего для строительства было выделено более 3 тыс. га территорий под разными юрисдикциями, в т.ч. зоны ASM Green, Rising Gateway, Iskandar Halal Hub, Kosmo и Keck Seng, а также IBTEC. В частности, в технополисе IBTEC более 240 га выделено специально для строительства дата-центров. Правительство штата намерено ограничить выдачу разрешений на строительство ЦОД на некоторых территориях вблизи жилых районов. Власти подчёркивают, что процесс утверждения проектов строительства ЦОД отличается высокой прозрачностью и основан на «реальных технических требованиях». Каждая заявка должна соответствовать требованиям по уровню шума и контроля тепловыделения, архитектурным стандартам, требованиям к энергетической ёмкости, безопасности для окружающей среды и др. Отмечается, что Джохор стал первым штатом в Малайзии, получившим ЦОД уровня Tier IV, а также технологии переработки сточных вод, разработанные совместно с Indah Water Konsortium и Johor Special Water. Ещё в 2023 году сообщалось, что Малайзия может захотеть стать новым IT-хабом Юго-Восточной Азии и постепенно теснит Сингапур, страдающий от нехватки свободных площадей и дефицита энергии. Конкуренцию ей пытается составить Индонезия.

08.08.2025 [14:57], Владимир Мироненко

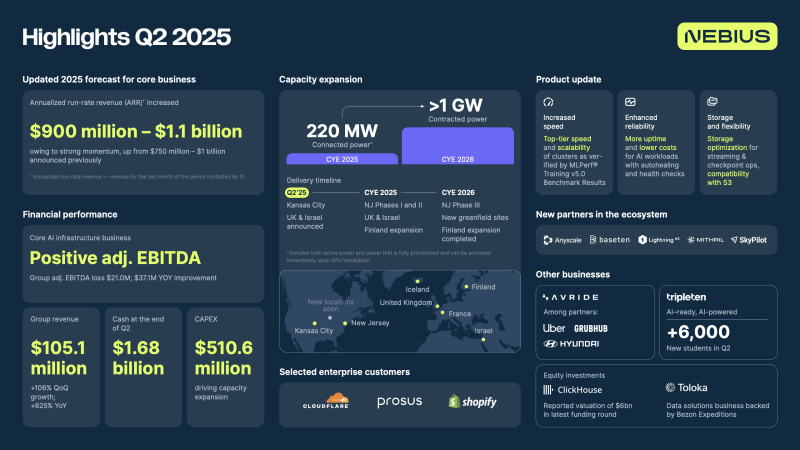

Nebius увеличила выручку на 625 % и повысила прогноз ARR до $0,9–$1,1 млрдПровайдер облачных ИИ-сервисов Nebius (ранее Yandex N.V.) объявил неаудированные финансовые результаты за II квартал, закончившийся 30 июня 2025 года. На фоне позитивных новостей акции компании подскочили на 18 %, в результате рост их стоимости с начала года составил 145 %. Выручка компании составила за отчётный квартал $105,1 млн, что на 625 % больше, чем годом ранее и выше консенсус-прогноза Уолл-стрит в размере около $101 млн, сообщил ресурс investors.com, отметив, что пока интерес к компании слабый. По данным FactSet, в настоящее время акции компании освещают всего лишь пять аналитиков. На сегодняшний день компания привлекла более $4 млрд капитала. В декабре Nebius объявила о привлечении $700 млн в ходе частного размещения от группы инвесторов, включая NVIDIA. В июне компания также привлекла $1 млрд в виде заёмных средств. Nebius завершила квартал со скорректированными чистыми убытками около $91,5 млн, что больше убытков годом ранее в размере $61,6 млн. Компания отразила в отчёте чистую прибыль в размере $502,5 млн, тогда как год назад у неё были убытки в $116,9 млн. Как сообщают «Ведомости», положительный финансовый результат был получен благодаря переоценке финансовых вложений, в том числе доли в платформе Toloka. Доход от этих активов составил $597,4 млн. Скорректированная EBITDA составила −$21 млн против −$58,1 млн годом ранее. В обращении к инвесторам генеральный директор Nebius Аркадий Волож заявил, что компания добилась значительного ускорения по сравнению с I первым кварталом благодаря высокому спросу клиентов и почти пиковой загрузке платформы. В связи с этим компания повышает прогноз годовой доходности (Annualized Run Rate, ARR) с $0,75–$1,0 млрд до $0,9–$1,1 млрд. «Спрос на инфраструктуру ИИ — вычислительные мощности, программное обеспечение и услуги — будет только расти по мере увеличения числа вариантов использования. Мы активно наращиваем мощности, чтобы воспользоваться этой существенной возможностью, и к концу 2026 года планируем получить более 1 ГВт», — сообщил Волож. Он рассказал, что к концу 2025 года подключённая мощность компании достигнет 220 МВт. В Финляндии она вырастет до 75 МВт. «В Нью-Джерси мы недавно увеличили наши обязательства по обеспечению 100 МВт мощности в этом году и 100 МВт мощности в 2026 году», — сообщил Волож, добавив, что сейчас идут переговоры ещё по двум крупным новым площадкам в США. По словам Воложа, компания усовершенствовала инфраструктуру, сделав её более доступной для разработчиков и исследователей ИИ, включая AnyScale, BaseTen, Mithril (Foundry), LightningAI, а также углубила сотрудничество со SkyPoint и NVIDIA. Он отметил, что компания осталась одним из ведущих поставщиков т.н. неооблака для стартапов, работающих с ИИ, привлекая таких клиентов, как HeyGen, Lightning.AI, Photoroom и многих других.

08.08.2025 [12:44], Руслан Авдеев

OpenAI похвасталась, что на GPT-5 «ушло» 200 тыс. ИИ-ускорителей, а с 2024 года её вычислительные мощности выросли в 15 разОдновременно с премьерой новейшей ИИ-модели GPT-5 компания OpenAI рассказала некоторые подробности о своей инфраструктуре. В частности, появилась информация о том, что с 2024 года компания нарастила вычислительные мощности в 15 раз, сообщает Datacenter Dynamics. По словам представителя компании, только за последние 60 дней было развёрнуто более 60 кластеров, сформирована цифровая магистраль, пропускающая больше трафика, «чем целые континенты», а также задействовано более 200 тыс. ИИ-ускорителей для запуска LLM GPT-5 для 700 млн человек. Дополнительно ведётся подготовка ещё 4,5 ГВт мощностей для «сверхразума». Стало известно и о вакансиях для проекта Stargate, курируемого OpenAI. Было заявлено, что сегодня небольшая команда строит ИИ-инфраструктуру планетарного масштаба беспрецедентными темпами. Она нанимает специалистов в сфере обработки данных, энергетики, ЦОД, планирования новых мощностей, развития бизнеса, финансов и др.

Источник изображения: Felix Mittermeier/unsplash.com При этом компания «агрессивно» нанимает людей в команду Stargate, при этом преимущественно полагаясь на Oracle. Так, в июле компании подтвердили сделку по аренде 4,5 ГВт для проекта Stargate в США. Как ожидается, сделка будет обходиться в $30 млрд ежегодно. Впрочем, не так давно сообщалось, что OpenAI по-прежнему планирует самостоятельно строить собственные дата-центры. Также компания намерена построить кампус ЦОД Stargete в Объединённых Арабских Эмиратах (ОАЭ) при участии других IT-гигантов, включая Oracle, NVIDIA, Cisco, SoftBank и G42. В Европе компания уже работает над дата-центром в Норвегии совместно с Nscale. Кроме того, она ищет площадки для новых инициатив по всему миру. При этом развитием инфраструктуры занимается в основном сама OpenAI, а сам проект Stargate развивается не так быстро, как планировалось.

08.08.2025 [11:50], Руслан Авдеев

Tesla отказалась от развития ИИ-суперкомпьютеров DojoTesla распускает команду, стоявшую за суперкомпьютером Dojo, сообщает TechCrunch со ссылкой на Bloomberg. Как сообщают анонимные источники, глава проекта Питер Бэннон (Peter Bannon) покидает компанию, а оставшихся участников команды переведут на работу с другими вычислительными проектами Tesla. О закрытии Dojo стало известно после ухода из Tesla порядка 20 сотрудников, основавших собственный ИИ-стартап DensityAI, который займётся разработкой чипов, аппаратного и программного обеспечения для ИИ ЦОД, связанных с робототехникой, ИИ-агентами и автомобильными приложениями. DensityAI основана бывшим руководителем Dojo Ганешем Венкатарамананом (Ganesh Venkataramanan), причём в не самый удачный для Tesla момент, поскольку глава компании Илон Маск (Elon Musk) ранее настоял на том, чтобы акционеры рассматривали компанию как бизнес, занимающийся ИИ и робототехникой. Решение о закрытии Dojo стало значительным изменением стратегии. Ранее Маск утверждал, что суперкомпьютер станет краеугольным камнем для удовлетворения амбиций компании в сфере ИИ и основная цель — добиться полной автономии машин благодаря способности Dojo обрабатывать огромные массивы видеоданных. В 2023 году Morgan Stanley посчитал, что Dojo может поднять капитализацию Tesla на $500 млрд за счёт новых источников дохода — проектов роботакси и программных сервисов. В 2024 году Маск сообщил, что команда Tesla, занятая искусственным интеллектом, «удвоит ставку» на Dojo перед презентацией роботакси. Тем не менее разговоры о Dojo уже в августе того же года постепенно сошли на нет, когда Маск начал продвигать ИИ-кластер Cortex (на базе ускорителей NVIDIA) при штаб-квартире Tesla в Остине (Техас). Проект Dojo включал в себя как суперкомпьютер, так и предполагал собственное производство ИИ-ускорителей. Ещё в 2021 году Tesla во время официального анонса Dojo представила чип D1, который должен был бы использоваться совместно с ускорителями NVIDIA для обеспечения работы Dojo. Также сообщалось, что ведутся работы над чипом D2, в котором будут устранены недостатки предшественника. По данным источников Bloomberg, теперь Tesla намерена сделать ставку преимущественно на NVIDIA, а также других сторонних партнёров вроде AMD, а Samsung будет выпускать чипы на заказ. В прошлом месяце с Samsung подписан контракт на выпуск инференс-чипов AI6, которые будут работать как с автопилотами Tesla, так и использоваться в роботах Optimus и дата-центрах. Ранее Маск намекнул, что в случае с Dojo 3 (D3) и инференс-чипом AI6, речь, возможно, будет идти о едином чипе. Недавно совет директоров Tesla предложил Маску пакет акций на $29 млрд, чтобы тот оставался в Tesla и продвигал ИИ-разработки компании, вместо того чтобы отвлекаться на другие бизнесы.

08.08.2025 [10:44], Сергей Карасёв

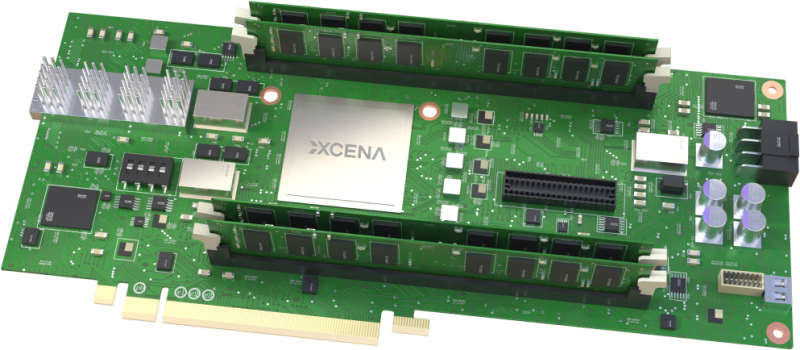

Стартап Xcena представил вычислительную память MX1 с поддержкой PCIe 6.0 и CXL 3.2Южнокорейский стартап Xcena анонсировал свой первый продукт — вычислительную память MX1. Избранные партнёры начнут получать образцы изделий с октября, тогда как массовое производство запланировано на 2026 год. Решение MX1 обладает поддержкой PCIe 6.0 и CXL 3.2. Новинка позволяет расширить основную память системы, добавив до 1 Тбайт в виде четырёх модулей DDR5 DIMM ёмкостью 256 Гбайт каждый. Реализована технология NDP (Near Data Processing), которая сводит к минимуму задержку при перемещении данных между интерфейсами и значительно снижает совокупную стоимость владения для приложений, требующих обработки больших объемов информации. Для выполнения вычислений в оперативной памяти используются «тысячи ядер» на открытой архитектуре RISC-V. Изделия MX1 позволяют существенно ускорить выполнение таких задач, как операции с векторными и графовыми базами данных, анализ информации и пр. При этом снижается нагрузка на CPU. Прототип на базе FPGA продемонстрировал сокращение времени обработки запросов при работе с базами данных на 46 % по сравнению с серверными CPU. Теоретически выигрыш может достигать 95 % при реализации в виде ASIC. Чип задействует 4-нм техпроцесс Samsung Foundry. Упомянута поддержка ECC. Компания Xcena предоставляет полностью интегрированный комплект для разработчиков (SDK), состоящий из низкоуровневых драйверов, библиотек среды выполнения и вспомогательных инструментов, которые помогают создавать прототипы и развертывать MX1 с минимальными усилиями по интеграции.

08.08.2025 [10:05], Руслан Авдеев

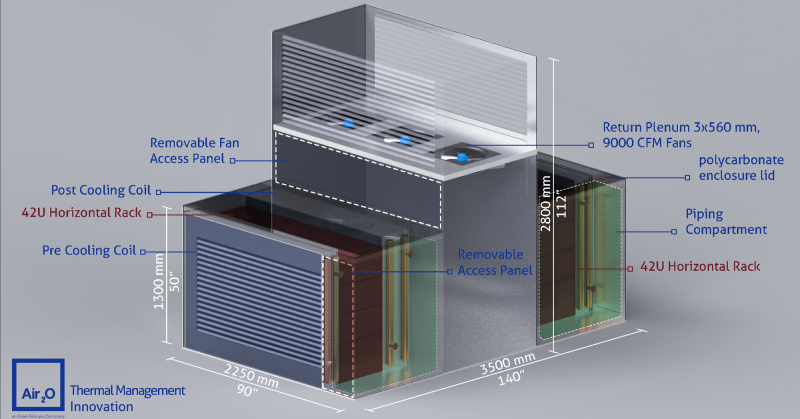

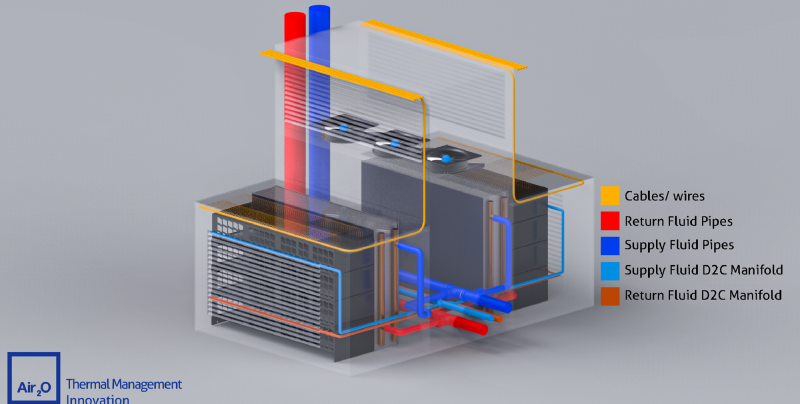

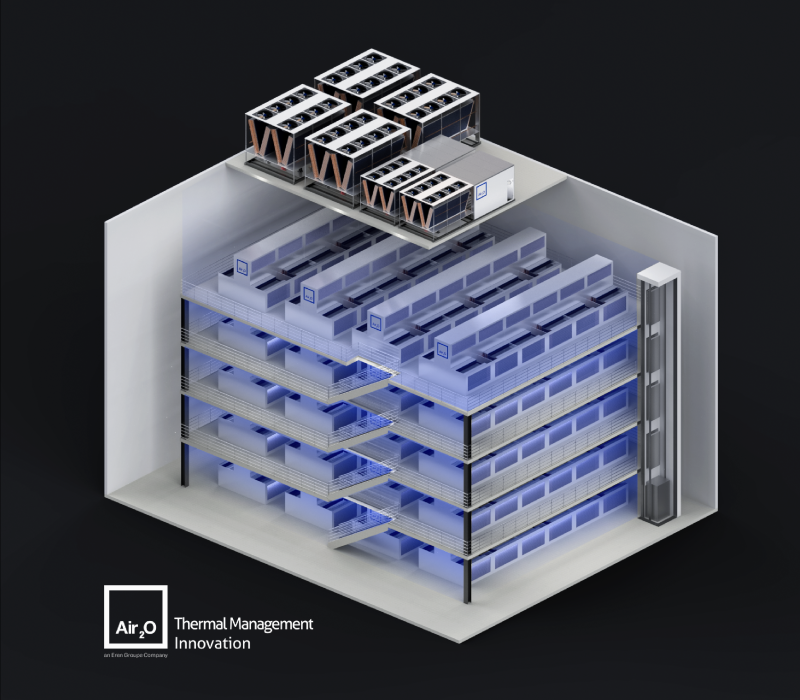

Масштабирование штабелированием: Air2O предложила высокоплотные модули с горизонтальными 42U-стойкамиРазработчик систем охлаждения Air2O предложил необычные модули High Thermal Density Air-Cooled Rack Assembly с двумя горизонтально расположенными 42U-стойками, которые, по словам компании, позволят заметно увеличить плотность размещения вычислительных мощностей, сообщает Datacenter Dynamics. К стойкам с двух сторон прилегают теплообменники, а между стойками находится воздушный коридор с собственными вытяжными вентиляторами высотой 2,8 м. Таким образом, воздух охлаждается до попадания в стойку и после выхода из него, что, по словам, Air2O, упрощает его повторное использование. По данным компании, новые модули обеспечивают энергетическую плотность до 320 кВт при фрикулинге и до 600 кВт при прямом жидкостном охлаждении. В версии с СЖО место одного из теплообменников занимает CDU. Масштабировать модули предполагается путём штабелирования. Air2O заявляет, что способна разместить до 120 соответствующих модулей общей мощностью до 40 МВт в помещении 16 × 25 × 20 м (400 м2), тогда как традиционный ЦОД такой же мощности может занимать более 25 тыс. м2. Каким образом предполагается обслуживать оборудование в таких стойках, компания, к сожалению, не уточняет. Также нет данных, построила ли компания хоть один такой модуль. По словам компании, стандартные 19″ стойки, разработанные AT&T более ста лет назад и используемые в большинстве дата-центров, устарели и никогда не предназначались для оборудования с высокой плотностью тепловой энергии. Подчёркивается, что оборудование современных ЦОД не должно выглядеть, как оснащение телефонной станции столетней давности. Со стойками экспериментируют не только специализированные компании, но и гиперскейлеры. Например, в конце 2024 года Microsoft и Meta✴ представили дизайн ИИ-стойки с раздельными шкафами для питания и IT-оборудования, а в мае 2025 года Google показала мегаваттные стойки с питанием 400 В и СЖО для ИИ-платформ будущего. А NVIDIA предлагает перейти уже к 800 В. |

|