Материалы по тегу: open source

|

13.10.2025 [00:30], Владимир Мироненко

Вложи $5 млн — получи $75 млн: NVIDIA похвасталась новыми рекордами в комплексном бенчмарке InferenceMAX v1

b200

gb200

hardware

nvidia

open source

semianalysis

бенчмарк

ии

инференс

рекорд

финансы

энергоэффективность

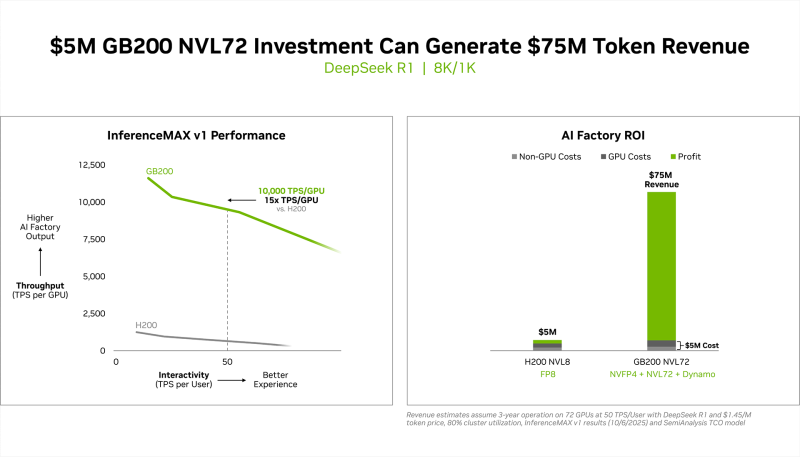

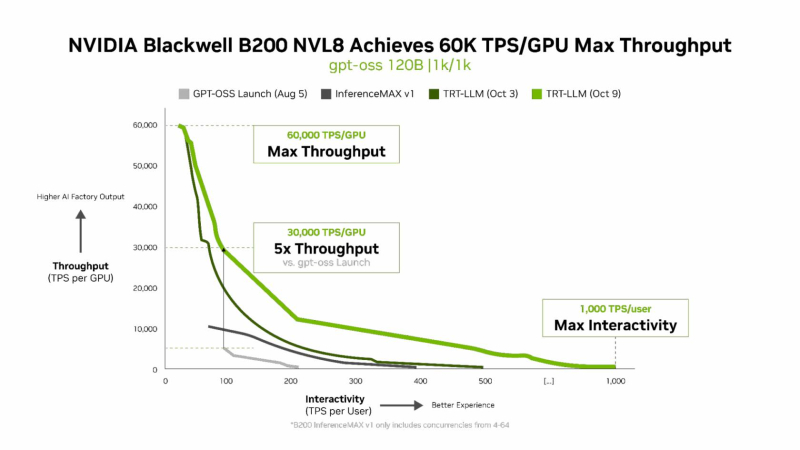

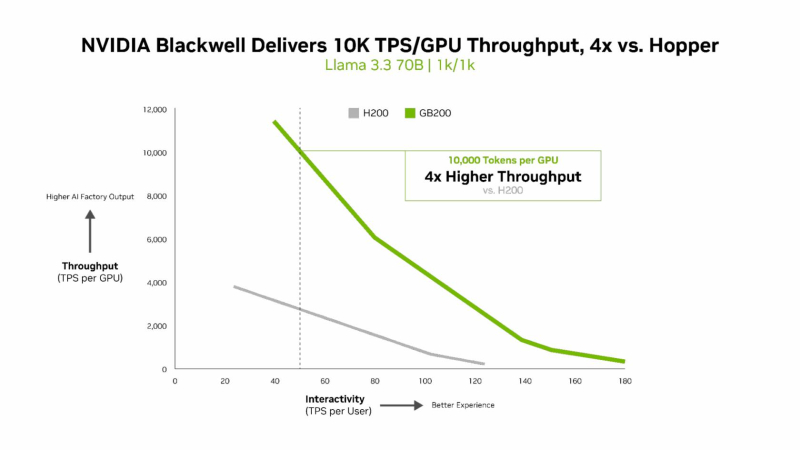

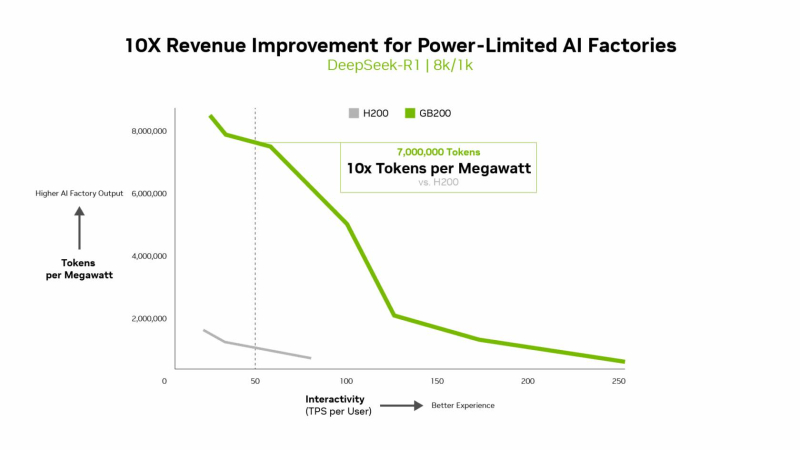

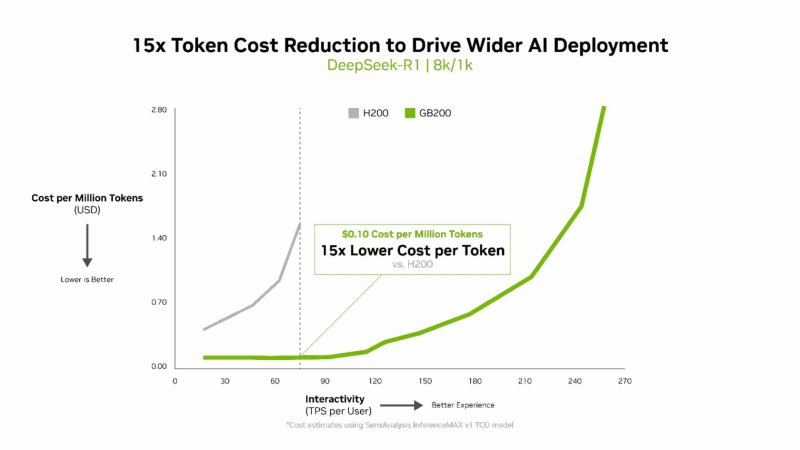

NVIDIA сообщила о результатах, показанных суперускорителем GB200 NVL72, в новом независимом ИИ-бенчмарке InferenceMAX v1 от SemiAnalysis. InferenceMAX оценивает реальные затраты на ИИ-вычисления, определяя совокупную стоимость владения (TCO) в долларах на миллион токенов для различных сценариев, включая покупку и владение GPU в сравнении с их арендой. InferenceMAX опирается на инференс популярных моделей на ведущих платформах, измеряя его производительность для широкого спектра вариантов использования, а результаты может перепроверить любой желающий, говорят авторы бенчмарка. Суперускоритель GB200 NVL72 победил во всех категориях бенчмарка InferenceMAX v1. Чипы NVIDIA Blackwell показали наилучшую окупаемость инвестиций — вложение в размере $5 млн приносят $75 млн дохода от токенов DeepSeek R1, обеспечивая 15-кратную окупаемость (год назад NVIDIA обещала ROI на уровне 700 %). Также ускорители поколения Blackwell отличаются самой низкой совокупной стоимостью владения. например, оптимизация ПО NVIDIA B200 позволила добиться стоимости всего в два цента на миллион токенов на OpenAI gpt-oss-120b, обеспечив пятикратное снижение стоимости одного токена всего за два месяца. NVIDIA B200 первенствовал и по пропускной способности и интерактивности, обеспечив 60 тыс. токенов в секунду на ускоритель и 1 тыс. токенов в секунду на пользователя в gpt-oss с новейшим стеком NVIDIA TensorRT-LLM. NVIDIA сообщила, что постоянно повышает производительность путём оптимизации аппаратного и программного стека. Первоначальная производительность gpt-oss-120b на системе NVIDIA DGX Blackwell B200 с библиотекой NVIDIA TensorRT LLM уже была лидирующей на рынке, но команды NVIDIA и сообщество разработчиков значительно оптимизировали TensorRT LLM для ускорения исполнения открытых больших языковых моделей (LLM). Компания отметила, что выпуск TensorRT LLM v1.0 стал значительным прорывом в повышении скорости инференса LLM благодаря распараллеливанию и оптимизации IO-операций. А у недавно вышедшей модели gpt-oss-120b-Eagle3-v2 используется спекулятивное декодирование — интеллектуальный метод, позволяющий предсказывать несколько токенов одновременно. Это уменьшает задержку и обеспечивает получение ещё более быстрых результатов — пропускная способность выросла втрое, до 100 токенов в секунду на пользователя (TPS/пользователь), а общая производительность на ускоритель выросла с 6 до 30 тыс. токенов. Для моделей с «плотной» архитектурой (Dense AI), таких как Llama 3.3 70b, которые требуют значительных вычислительных ресурсов из-за большого количества параметров и одновременного использования всех параметров в процессе инференса, NVIDIA Blackwell B200 достиг нового рубежа производительности в бенчмарке InferenceMAX v1, отметила NVIDIA. Суперускоритель показал более 10 тыс. токенов/с (TPS) на GPU при 50 TPS на пользователя, т.е. вчетверо более высокую пропускную способность на GPU по сравнению с NVIDIA H200. NVIDIA подчеркнула, что такие показатели, как количество токенов на Вт, стоимость на миллион токенов и TPS/пользователь не уступают по важности пропускной способности. Фактически, для ИИ-фабрик с ограниченной мощностью ускорители с архитектурой Blackwell обеспечивают до 10 раз лучшую производительность на МВт по сравнению с предыдущим поколением и позволяют получать более высокий доход от токенов. Компания отметила, что стоимость обработки одного токена (Cost per Token) имеет решающее значение для оценки эффективности ИИ-модели и напрямую влияет на эксплуатационные расходы. NVIDIA утверждает, что в целом архитектура NVIDIA Blackwell позволила снизить стоимость обработки миллиона токенов в 15 раз по сравнению с предыдущим поколением. В InferenceMAX используется метод оценки эффективности Pareto front, определяющий наилучшее (компромиссное) сочетание различных факторов для оценки производительности ускорителя. Это показывает, насколько Blackwell лучше конкурентов справляется с балансом стоимости, энергоэффективности, пропускной способности и скорости отклика. Системы, оптимизированные только для одной метрики, могут демонстрировать пиковую производительность «в вакууме», но такая «экономика» не масштабируется в производственных средах. Компания отметила, что ИИ переходит от экспериментальных пилотных проектов к ИИ-фабрикам — инфраструктуре, которая производит интеллектуальные решения, преобразуя данные в токены и решения в режиме реального времени. Фреймворк NVIDIA Think SMART помогает предприятиям ориентироваться в этом переходе, демонстрируя, как полнофункциональная платформа инференса обеспечивает измеримую окупаемость инвестиций. Обещая 15-кратную окупаемость инвестиций и непрерывный рост производительности за счёт ПО, NVIDIA не просто лидирует в текущей гонке ИИ-технологий, но и задаёт правила для следующего этапа, где экономика будет определять победителей рынка, пишет The Tech Buzz. Для предприятий, делающих ставку на конкурирующие платформы в своих стратегиях по развёртыванию ИИ, результаты таких бенчмарков должны побудить к пересмотру выбора ИИ-инфраструктуры.

07.10.2025 [23:17], Владимир Мироненко

Qualcomm купила Arduino: бренд и экосистему обещают сохранитьQualcomm объявила о приобретении Arduino, итальянской компании-разработчика, известной своей open source экосистемой решений на базе микроконтроллеров и ПО. Qualcomm отметила, что сделка позволит ускорить реализацию стратегии по расширению возможностей разработчиков за счёт упрощения доступа к её портфелю передовых технологий и продуктов, а также укрепить свои позиции в области периферийных и ИИ-вычислений. О сделке объявили через несколько дней после победы Qualcomm над Arm в суде. «Объединяя принципы open source с портфолио Qualcomm Technologies, мы помогаем миллионам разработчиков создавать интеллектуальные решения быстрее и эффективнее», — заявил Накул Дуггал (Nakul Duggal), генеральный менеджер подразделения автомобильных, промышленных и встраиваемых решений для Интернета вещей Qualcomm Technologies, передаёт TechRadar. Arduino с сообществом из более чем 33 млн активных пользователей сохранит свой бренд и продолжит поддерживать широкий спектр микроконтроллеров, а также разрабатывать решения для различных направлений: от любительских роботов и простых проектов домашней автоматизации до корпоративных платформ Интернета вещей. Финансовые подробности сделки не разглашаются. Её завершение зависит от получения одобрения регулирующих органов и других стандартных условий оформления сделки. В марте 2024 года Qualcomm приобрела компанию Foundries.io, занимающуюся периферийными вычислениями, а в марте 2025 года объявила о приобретении Edge Impulse, разработчика платформы для создания периферийных ИИ-решений. Как отметил ресурс CNBC, Qualcomm стремится диверсифицировать бизнес, поскольку рынок смартфонов стагнирует, а Apple начала переход на собственные модемы. В последнем квартале на долю бизнеса Qualcomm в сфере IoT, включающем в себя многие из её текущих чипов, которые могут использоваться в промышленных или робототехнических продуктах, и автомобильного бизнеса пришлось в общей сложности 30 % от общей выручки от продажи чипов. Несмотря на то, что Qualcomm неоднократно подчёркивала, что Arduino продолжит существовать как самостоятельная экосистема, всегда существует опасение, что крупная компания, покупая любой небольшой открытый проект, в конечном итоге начнёт ограничивать экосистему, пишет Ars Technica. Это может привести к сокращению или прекращению выпуска аппаратных и программных проектов для сообщества разработчиков или снижение поддержки чипов сторонних производителей. Также это может означать перенос фокуса на крупных корпоративных клиентов Qualcomm в ущерб преподавателям и разработчикам из сообщества Arduino. Впрочем, приверженность Arduino принципам open source может стать страховкой от таких попыток Qualcomm в будущем.

26.07.2025 [14:55], Сергей Карасёв

В Европе запущена первая метаоблачная ИИ-платформа Fact8raКомпания OpenNebula Systems объявила о запуске Fact8ra — это, как утверждается, первая в Европе платформа «ИИ как услуга» (AI-as-a-Service) на основе мультиоблачной архитектуры. Инициатива является важным этапом на пути формирования европейской суверенной инфраструктуры ИИ. Любопытно, что в Китае создаётся похожая платформа, но по совсем иным причинам — в результате не слишком удачного планирования значительная часть вычислительных мощностей простаивает без дела. Система Fact8ra предлагает многопользовательскую среду для развёртывания частных экземпляров больших языковых моделей (LLM) с открытым исходным кодом. Платформа объединяет НРС-мощности, публичное облако и периферийные ресурсы по всему ЕС. Fact8ra основана на суверенном облачном стеке ИИ, включающем решения OpenNebula, а также другие европейские технологии open source, такие как openSUSE и MariaDB. Поначалу Fact8ra объединит GPU-серверы в восьми странах ЕС: Франции, Германии, Италии, Латвии, Нидерландах, Польше, Испании и Швеции. Отмечается, что Fact8ra способна агрегировать ресурсы поставщиков публичных облачных сервисов, периферийных площадок, суперкомпьютерных центров и финансируемых ЕС фабрик ИИ. В частности, будут объединены мощности Arsys, CloudFerro, IONOS, Leaseweb, OVHcloud, Scaleway, StackScale и Tiscali. Говорится о расширенной поддержке ИИ-ускорителей NVIDIA. Fact8ra поддерживает работу с различными LLM, включая Mistral Nemo 12B, EuroLLM 9B, Salamandra 7B и Italia 9B. Кроме того, реализована интеграция с внешними каталогами ИИ-моделей, в том числе Hugging Face. Поначалу пользователям будут доступны возможности инференса, а затем появятся функции тонкой настройки и обучения моделей ИИ. Fact8ra реализуется как часть программы IPCEI-CIS (Important Project of Common European Interest on Next Generation Cloud Infrastructure and Services) — это европейский проект развития облачной инфраструктуры и услуг следующего поколения. Инициатива стоимостью €3 млрд была одобрена Европейской комиссией в декабре 2023 года. Проект поддерживается 12 государствами-членами ЕС и более чем 120 индустриальными партнёрами. Целями являются стимулирование исследований и увеличение инвестиций в технологии периферийных и облачных вычислений в ЕС, а также создание децентрализованной периферийной инфраструктуры. Ранее в рамках IPCEI-CIS была анонсирована суверенная облачная платформа Virt8ra.

23.07.2025 [09:37], Владимир Мироненко

SSD не нужны: OFP обещает на порядок повысить плотность All-Flash СХД и наполовину снизить расходы на инфраструктуруИнициатива Open Flash Platform (OFP) призвана полностью пересмотреть работу с флеш-памятью в ИИ ЦОД. Участники OFP — Hammerspace, Linux Foundation, Лос-Аламосская национальная лаборатория (LANL), ScaleFlux, SK hynix и Xsight Systems — намерены отказаться от традиционных All-Flash хранилищ и контроллеров. Вместо них предложено использовать флеш-картриджи с минимумом аппаратной начинки, а доступ к таким массивам предоставлять посредством DPU и pNFS. Как отмечено в пресс-релизе, OFP отвечает многим фундаментальным требованиям, возникающим в связи со следующим этапом развития СХД для ИИ. Для ИИ требуются поистине огромные массивы данных, но вместе с тем ЦОД сталкиваются с дефицитом энергии, повышением температуры и недостатком свободного места. Именно поэтому в OFP решили, что инфраструктуры хранения для ИИ лучше разработать с чистого листа. Если 10 лет назад технология NVMe вывела флеш-память на новый уровень производительности благодаря отказу от устаревших шин данных и контроллеров, то теперь OFP обещает раскрыть возможности флеш-памяти, исключив посредников в виде серверов хранения и проприетарных программных стеков. OFP же опирается на открытые стандарты и open source решения, в частности, Parallel NFS (pNFS) и стандартный Linux, для размещения флеш-памяти непосредственно в SAN. А отказ от традиционных СХД обеспечит на порядок большую плотность размещения данных, существенную экономию энергии и значительно более низкую совокупную стоимость владения. OFP отметила, что существующие решения изначально привязаны к модели сервера хранения, которая требует чрезмерных ресурсов для повышения производительности и возможностей. Конструкции всех современных поставщиков AFA не оптимизированы для достижения максимальной плотности размещения флеш-памяти и привязаны к сроку службы CPU (обычно пять лет), тогда как срок службы флеш-памяти в среднем составляет восемь лет. Эти серверы хранения также предлагают проприетарные структуры и уровни хранения данных, что приводит к увеличению количества копий данных и добавлению расходов на лицензирование для каждого узла. Комментируя инициативу, ресурс Blocks & Files отметил, что Pure Storage и другие поставщики AFA уже предлагают оптимизированные схемы лицензирования и подписки, в том числе с обновлением контроллеров и дисковых полок. Та же Pure Storage предлагает более высокую плотность хранения, чем многие другие поставщики, хотя и использует проприетарные решения. Поддержкой DPU тоже удивить нельзя. Например, VAST Data уже поддерживает работу своего ПО на NVIDIA BlueField-3. А большинство поставщиков флеш-массивов и так поддерживают RDMA и GPUDirect. OFP выступает за открытый, основанный на стандартах подход, включающий несколько основных элементов:

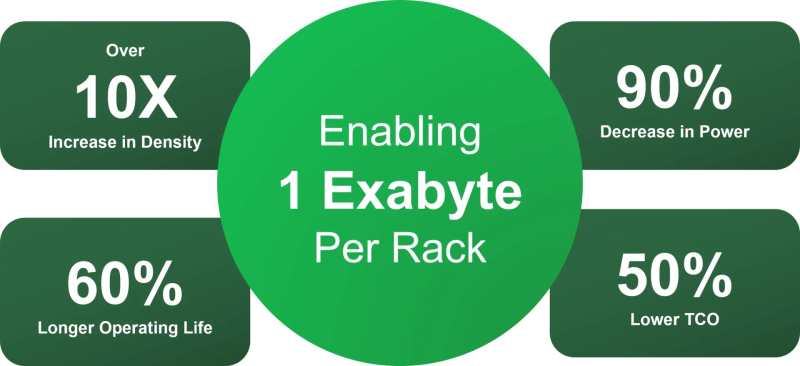

Благодаря использованию открытых архитектур и компонентов, соответствующих отраслевым стандартам, реализация OFP приведёт к значительному повышению эффективности хранения данных, утверждают основатели инициативы. Так, обещано десятикратное увеличение плотности размещения данных, что позволит «упаковать» в одну стойку 1 Эбайт, попутно снизив энергопотребление на 90 %, увеличив срок службы флеш-памяти на 60 % и уменьшив совокупную стоимость владения (TCO) на 60 % по сравнению со стандартными массивами хранения. По мнению Blocks & Files, в текущем виде OFP выглядит скорее как маркетинговая инициатива, от которой в первую очеред выиграют её участники. Концепция же «сетевых» SSD сама по себе не нова. Весной Kioxia показала SSD с «оптикой». Да, тут речь идёт скорее о блочном доступе и NVMe-oF, но, например, Nimbus Data в прошлом году представила ExaDrive EN с поддержкой NFS.

21.07.2025 [16:08], Руслан Авдеев

Samsung начал поиск альтернатив VMwareОсновные компании, входящие в Samsung Group, начали искать альтернативы VMware в связи со значительным ростом цен на продукты последней, причём ПО, похоже, будут дорожать и дальше, передаёт ETNews. Как сообщают источники издания, Samsung Electronics, Samsung Display и другие подразделения Samsung Group уже реализуют либо готовятся к реализации проектов по постепенному отказу от VMware. Так, Samsung Electronics рассматривает альтернативные варианты с прошлого года. При этом компания не намерена немедленно отказываться от продуктов, пока заключён контракт на закупку ПО на сумму ₩40 млрд (около $29 млн). Параллельно компания участвует в проектах по разработке open source ПО. Цель состоит в том, чтобы разработать облачную среду, избегая коммерческих инструментов вроде продуктов VMware. Привлечены специалисты по виртуализации и облачным технологиям. В 2026 году будут определены направление и масштаб внедрения новых продуктов. Samsung Electronics намерена самостоятельно создать частное облако. Для работы над ним привлекут как сотрудников самой Samsung, так и специализированные компании. Проект планируется завершить в течение года. Samsung Display также готовит проект снижения зависимости от VMware. Компании Samsung Group являются одними из крупнейших заказчиков VMware в Южной Корее. Однако смена политики VMware привела к росту цен, так что дочерние структуры Samsung Group посчитали затраты слишком высокими в сравнении с выгодами от использования VMware. В 2023 году VMware была куплена Broadcom, а в 2024-м компания повысила цены на свою продукцию. По мнению экспертов, в ближайшие два-три года цена может значительно увеличиться в сравнении с текущей. Уже есть примеры пятикратного роста стоимости лицензий и обслуживания. Утверждается, что цены будут формироваться в индивидуальном порядке. Кроме того, постоянно меняются условия сделок. Есть претензии и к политике продаж. Флагманский продукт VMware Cloud Foundation (VCF) включает ПО для виртуализации, сетевые решения и решения для хранения данных единым пакетом. При этом многим корейским компаниям нужны только продукты для виртуализации, а переплачивать за ненужные продукты они не хотят. По словам одного из источников, большинство крупных компаний, включая производственные и финансовые, ускорят движение к отказу от VMware.

19.07.2025 [15:58], Владимир Мироненко

Intel прекратила поддержку фирменного дистрибутива Clear Linux OSIntel объявила о прекращении поддержки оптимизированного для производительности дистрибутива Clear Linux OS. «Начиная с этого момента, Intel больше не будет предоставлять исправления безопасности, обновления или техническое обслуживание Clear Linux OS, а репозиторий Clear Linux OS на GitHub будет заархивирован и доступен в режиме только для чтения», — указано в заявлении компании на странице Clear Linux Project. Всем, кто в настоящее время использует Clear Linux OS, компания рекомендовала запланировать переход на другой активно поддерживаемый дистрибутив. Intel также отметила, что по-прежнему инвестирует в экосистему Linux, активно поддерживая различные проекты и дистрибутивы Linux с открытым исходным кодом и внося свой вклад в их оптимизацию для аппаратного обеспечения. Clear Linux был известен глубокой оптимизацией для x86-64, причём в производительности от этого выигрывали не только платформы Intel, но и AMD. Тем не менее, дистрибутив оставался достаточно нишевым. Как сообщил ранее ресурс Phoronix, в этом месяце Intel покинул Кирилл Шутемов (Kirill Shutemov) после 14 лет работы в компании, который внёс значительный вклад в развитие основных компонентов Intel для ядра Linux. Сообщается, что в последнее время Шутемов работал над аспектами управления памятью в ядре, а также принимал участие в реализации TDX в Intel. Согласно данным Phoronix, последний раунд увольнений Intel сильнее повлиял на разработку ПО, чем некоторые из предыдущих. В этот раз компанию покинули сразу несколько разработчиков Linux.

04.07.2025 [19:50], Владимир Мироненко

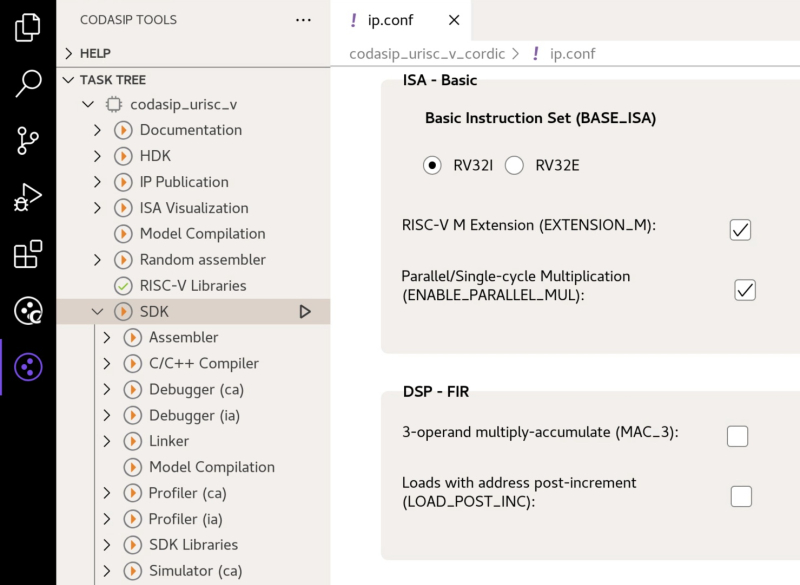

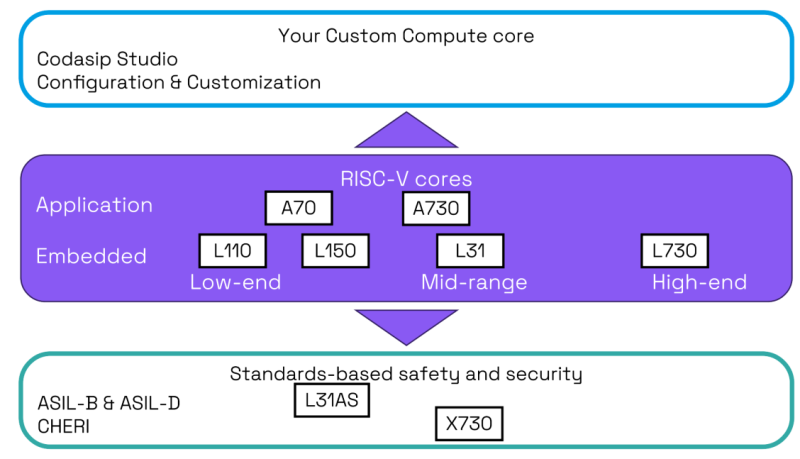

Разработчик RISC-V-чипов Codasip готов продаться — целиком или по частямРазработчик чипов с архитектурой RISC-V и инструментов проектирования из Мюнхена Codasip объявил о готовности продать свои активы, сославшись на проявление к ним интереса со стороны компаний во время недавнего раунда финансирования. Компания сообщила, что процесс приёма заявок на покупку, начавшийся 1 июля, продлится три месяца, что, по мнению ресурса The Register, может указывать на уже поступившие предложения. Ландшафт открытой архитектуры RISC-V превращается из экосистемы сотрудничества в высококонкурентную коммерческую среду, отметил ресурс EE Times. На фоне этого один из основных поставщиков EDA-инструментов Synopsys запустил полный набор основных IP-блоков RISC-V. Попутно крупные игроки рынка полупроводников, такие как Bosch, Infineon, NXP, Qualcomm и Nordic Semiconductor, сформировали консорциум Quintauris для разработки собственных процессорных решений для автомобильного сектора. В связи с этим Codasip попала в сложное положение, оказавшись между гигантами, предлагающими интегрированные решения, и крупными вертикальными игроками, разрабатывающими собственные продукты на базе RISC-V, что потенциально может сократить её целевой рынок. Codasip сообщила, что у неё есть несколько бизнес-подразделений, нацеленных на четыре ключевых направления продуктов, с «отделимыми» R&D-командами, намекая таким образом, что можно купить отдельные группы, а не компанию целиком.

Источник изображений: Codasip Как пишет The Register, у Codasip предполагаемая годовая выручка составляет $88,7 млн, что делает её одним из крупнейших разработчиков микросхем в экосистеме RISC-V. У Ventana Micro Systems предполагаемая выручка составляет $37,4 млн за год, а SiFive ожидала получить около $60 млн в прошлом году. Хотя RISC-V вызывает определённый интерес, предлагая открытый набор инструкций, лёгких путей для построения успешного бизнеса здесь не обещают — SiFive ранее уволила 20 % штата, Intel отказалась от программы Pathfinder for RISC-V, а Imagination Technologies отказалась от RISC-V, сосредоточившись на продуктах GPU и ИИ. У Codasip есть портфолио решений для прикладных и встраиваемых процессоров и портфолио процессоров с архитектурой безопасности CHERI с аппаратной защитой памяти, а также сопутствующее ПО. Отдельно разрабатываются высокопроизводительные прикладные процессоры в рамках проекта Евросоюза Digital Autonomy with RISC-V in Europe (DARE). Наконец, у компании есть и собственные EDA-инструменты для разработки и кастомизации чипов. Немалую часть средств компании приносят гранты от различных органов ЕС, многочисленных общеевропейских и национальных проектов, включая DARE, TRISTAN и NEUROKIT2E — более €119 млн ($140 млн). Однако большая часть этих денег пока не получена компанией. На следующих этапах грантовой поддержки компания может получить ещё €210 млн ($248 млн). Codasip также утверждает, что является частью новых консорциумов и проектов, которые могут принести ей финансирование в размере €51 млн ($60) или больше. По словам компании, эти средства могут быть переданы покупателю на разумных условиях. «В первую очередь, быть разработчиком CPU — это дорогостоящий бизнес, поэтому долгосрочное финансирование имеет важное значение — если рыночное признание низкое, доходы не появятся немедленно», — отметил Эндрю Басс (Andrew Buss), старший директор по исследованиям IDC в регионе EMEA. По оценкам EE Times, потенциальные приобретатели Codasip делятся на три категории. Первая включает гигантов в сфере EDA и интеллектуальной собственности (IP), таких как Synopsys, для которой приобретение Codasip означает возможность консолидации рынка благодаря получению уникального набора инструментов Codasip Studio, расширению портфеля интеллектуальной собственности и устранению значительного конкурента. Вторая категория состоит из вертикальных интеграторов, в основном американских технологических титанов, таких как Intel, Qualcomm и Broadcom. Intel уже предлагала в 2021 году более $2 млрд за SiFive, но сделка не состоялась. Приобретение Codasip даст Intel зрелый портфель интеллектуальной собственности для клиентов Intel Foundry Services (IFS), а также надёжную, отличающуюся от x86 архитектуру для собственных продуктов. Для Qualcomm, судящейся с Arm, сделка означала бы снижение зависимости от архитектуры Arm. Сертифицированные IP-блоки для автомобильных решений Codasip идеально соответствует роли Qualcomm в качестве соучредителя в Quintauris, пишет EE Times. Broadcom может быть интересен набор Codasip Custom Compute, который она могла бы использовать для внутренних ядер контроллеров в SoC. Хотя вероятность заявки от Broadcom довольно низкая. И, наконец, третья категория — организации ЕС, которые могли бы купить Codasip для потенциального европейского консорциума. Европейский союз сделал технологический суверенитет центральной политической целью, что очевидно на примере таких инициатив, как «Европейский закон о чипах» (European Chips Act). Для Евросоюза покупка является стратегической: не допустить приобретения неевропейской организацией критически важного европейского технологического актива, в значительной степени субсидируемого за счет средств ЕС. Покупатель из страны, не входящей в ЕС, должен будет предоставить твёрдые, юридически обязывающие обязательства по поддержанию и развитию европейских центров НИОКР Codasip, обеспечению постоянного участия в стратегических проектах ЕС и в целом соответствию технологической повестке ЕС, подчеркнул EE Times.

17.06.2025 [23:55], Владимир Мироненко

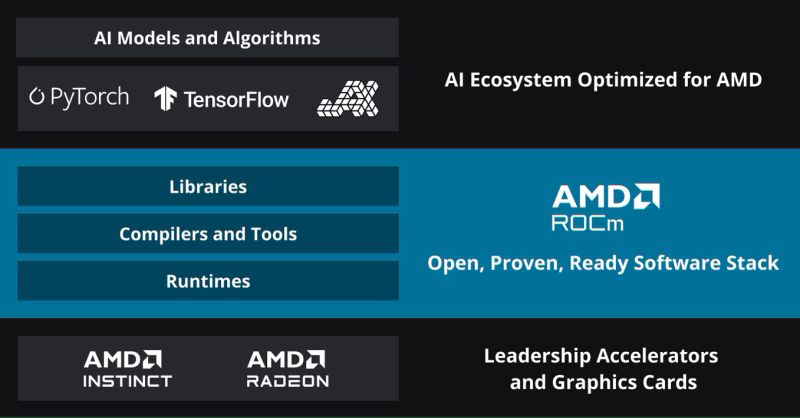

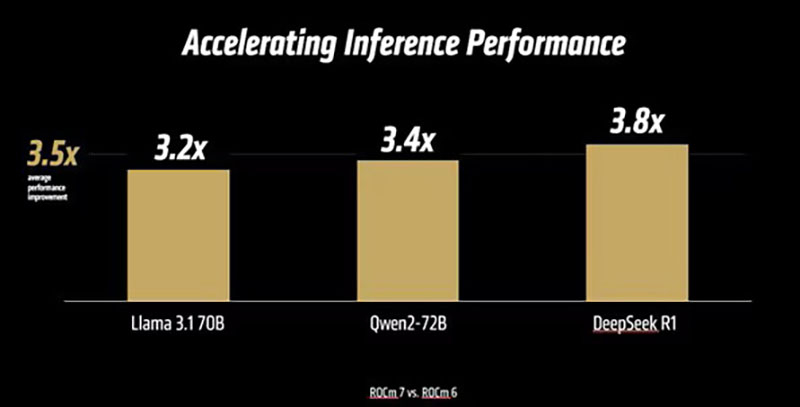

AMD анонсировала платформу ROCm 7.0, облако для разработчиков AMD Developer Cloud и программу Radeon Test DriveAMD вместе с ускорителями Instinct MI350X/MI355X представила 7-ю версию своего открытого программного стека ROCm (Radeon open compute). Как сообщает компания, ROCm 7.0 предназначен для удовлетворения растущих потребностей рабочих нагрузок генеративного ИИ и HPC, одновременно расширяя возможности разработчиков за счёт доступности, эффективности и активного сотрудничества сообщества. По данным AMD, платформа ROCm 7 предлагает более чем в 3,5 раза большую производительность инференса, чем ROCm 6, и в 3 раза большую эффективность обучения. Это стало возможным благодаря улучшениям производительности и поддержке типов данных с меньшей точностью, таких как FP4 и FP6. Дальнейшие улучшения в коммуникационных стеках позволили оптимизировать использование ускорителя и перемещение данных. ROCm 7 поддерживает распределённый инференс, а также фреймворки SGLang, vLLM и llm-d. Платформа ROCm 7 создавалась совместно с этими партнёрами, включая разработку общих интерфейсов и примитивов для обеспечения эффективного распределённого инференса на платформах AMD.

Источник изображений: AMD Вместе с ROCm 7 компания представила MLOps-платформу ROCm Enterprise AI для бесперебойных ИИ-операций в корпоративном сегменте. Платформа предлагает инструменты для тонкой настройки модели и интеграции как со структурированными, так и неструктурированными рабочими процессами. AMD заявила, что работает с партнёрами по экосистеме над созданием эталонных реализаций для таких приложений, как чат-боты и обобщение документов.  AMD отметила, что тесное партнёрство гарантирует разработчикам доступ к лучшим в своем классе инструментам, постоянному улучшению производительности и открытой среде для быстрой итерации и развёртывания. Также AMD представила партнёров экосистемы ROCm, которые используют преимущества данной платформы:

Кроме того, AMD представила «простую в использовании платформу для разработчиков» AMD Developer Cloud, обеспечивающую быстрый доступ к AMD Instinct с возможностью масштабирования от одного (192 Гбайт памяти) до восьми AMD Instinct MI300X (1536 Гбайт памяти). Сообщается, что конфигурации с одним ускорителем в основном используются для рабочих нагрузок инференса на «лёгких» моделях, тогда как максимальная конфигурация обеспечивает распределённое обучение, тонкую настройку и высокопроизводительный инференс для крупномасштабных моделей. AMD сообщила, что платформа AMD Developer Cloud была разработана с учётом четырёх основных целей:

По словам компании, AMD Developer Cloud предполагает различные варианты использования. Решение идеально подходит для независимых разработчиков AI/ML, работающих над низкоуровневым программированием, разработкой ядер (kernel) или корпоративных приложений и проектов, нацеленных на нативную поддержку AMD. Также платформу можно использовать для мероприятий и хакатонов, обеспечивая масштабируемую поддержку образовательных и практических мероприятий с предоставлением кредитов на использование ускорителей во время семинаров, хакатонов, конкурсов и демонстраций. Также с выходом ROCm 7 появилась поддержка ноутбуков и рабочих станциях на Windows с видеокартами Radeon и процессорами Ryzen AI. С этим связан ещё один важный анонс — компания представила программу ROCm on Radeon Test Drive, которая будет запущена этим летом партнёрстве с различными поставщиками оборудования (первыми стали Colfax и System76), чтобы упростить разработчикам возможность опробовать ROCm на GPU Radeon, передаёт Phoronix. В рамках Radeon Test Drive предоставляется возможность удалённо протестировать GPU Radeon (PRO).

13.05.2025 [15:23], Владимир Мироненко

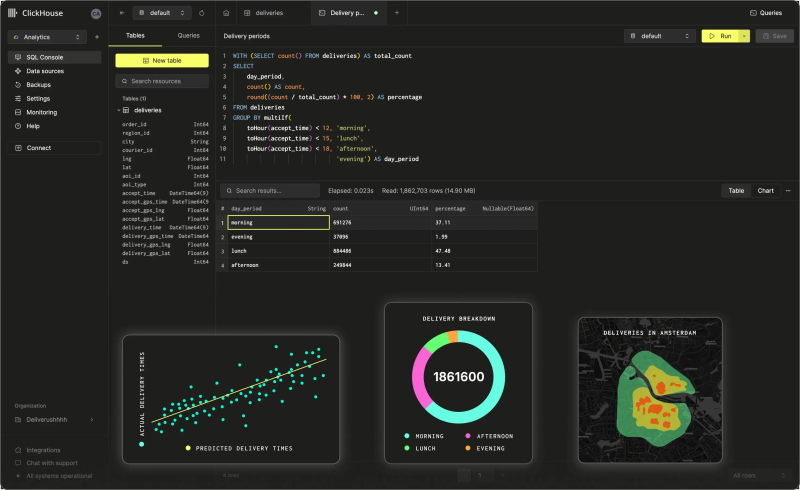

ClickHouse готовится к новому раунду финансирования — оценка капитализации компании выросла до $6 млрдClickHouse, разработчик СУБД с открытым исходным кодом, в настоящее время проводит переговоры по поводу проведения раунда финансирования при оценке рыночной стоимости компании в $6 млрд, пишет MLQ.ai. Целевая оценка капитализации ClickHouse втрое превышает показатель предыдущего раунда финансирования — четыре года назад компания была оценена в $2 млрд. Сообщается, что раунд возглавит Khosla Ventures. Компания намерена привлечь сотни миллионов долларов. Значительный рост оценки ClickHouse подчеркивает быстрый рост компании с увеличивающимся присутствием на высококонкурентном рынке аналитики данных. Также это свидетельствует о значительном интересе инвесторов, поскольку компания расширяет свои технологические предложения по сравнению с гигантами рынка вроде Snowflake, отметил MLQ.ai. Разработанная ClickHouse одноимённая колоночная open source OLAP СУБД известна своей скоростью и эффективностью использования ресурсов при обработке крупномасштабной аналитики. Работа ClickHouse по развитию решения в соответствии со стратегией lakehouse, которая объединяет возможности озёр данных и хранилищ, отражают её амбиции по устранению пробелов в корпоративной инфраструктуре данных, сообщил ресурс MLQ.ai. Технология ClickHouse используется Sony, Lyft, Cisco и GitLab. Новая оценка рыночной стоимости ClickHouse выводит её в ранг заметного конкурента Snowflake, нынешнего лидера данного рынка. Рост доверия инвесторов свидетельствует о том, что рынок рассматривает ClickHouse как крупного игрока, способного влиять на тенденции в более широком секторе инфраструктуры данных. Её ориентация на экономически эффективные решения для аналитики в реальном времени соответствует потребностям корпоративных клиентов. В рамках предыдущих раундов финансирования ClickHouse привлекла $300 млн при поддержке Thrive Capital и Redpoint Ventures. По мнению отраслевых наблюдателей, фокус ClickHouse на объединение традиционных функций хранилища данных и озера данных соответствует текущим тенденциям рынка и потребностям клиентов. Несмотря на значительную конкуренцию, в том числе, со стороны Snowflake, популярность ClickHouse и быстро растущая клиентская база обеспечивают компании устойчивое развитие, которое будет зависеть от её способности поддерживать постоянные инновации. Успешное проведение раунда финансирования позволит ClickHouse ускорить как разработку продукта, так и глобальную экспансию. Эксперты прогнозируют дальнейшее усиление конкуренции в сфере инфраструктур данных, особенно вокруг развивающейся парадигмы lakehouse. Nebius принадлежит 28 % акций ClickHouse.

31.03.2025 [09:54], Сергей Карасёв

Маршрутизатор OpenWrt Two предложит поддержку 10GbE и Wi-Fi 7 за $250Команда OpenWrt, по сообщению ресурса Liliputing, приступила к созданию маршрутизатора OpenWrt Two, который поступит в продажу в конце текущего года. В разработке новинки принимают участие специалисты компании GL.iNet. Маршрутизатор OpenWrt One (на изображении) дебютировал в декабре 2024 года. Устройство, спроектированное в сотрудничестве с Banana Pi, несёт на борту процессор MediaTek Filogic 820 (MT7981B) с двумя ядрами Arm Cortex-A53, 1 Гбайт памяти DDR4 и опциональный SSD формата M.2 2242/2230 с интерфейсом PCIe 2.0 x1 (NVMe). Есть сетевые порты 2.5GbE и 1GbE, а также адаптер Wi-Fi 6. Цена составляет около $90. В основу OpenWrt Two ляжет чип MediaTek Filogic 880 (MT7988), который объединяет четыре ядра Arm Cortex-A73 с частотой до 1,8 ГГц и контроллер памяти DDR3/DDR4 (фактический объём ОЗУ пока не уточняется). Реализована беспроводная связь Wi-Fi 7 (802.11a/b/g/n/ac/ax/be) в частотных диапазонах 2,4, 5 и 6 ГГц. Говорится о поддержке модуляции 4096-QAM. Для новинки по сравнению с оригинальной моделью предусмотрен более широкий набор Ethernet-портов: это 10GbE SFP, 5GbE RJ45, 2.5GbE RJ45 (четыре разъёма) и 1GbE RJ45 (один или два разъёма). Благодаря увеличению количества сетевых гнёзд расширятся функциональные возможности маршрутизатора. В качестве программной платформы, как и прежде, будет применяться OpenWrt — встраиваемая ОС с ядром Linux. По заявлениям разработчиков, это обеспечит возможность модификации и настройки устройства в соответствии с конкретными требованиями. Ожидается, что стоимость OpenWrt Two составит около $250. |

|