Материалы по тегу: microsoft azure

|

14.08.2025 [13:57], Руслан Авдеев

Windows 365 Reserve предложит на время облачный ПК на случай проблем с физическимПользователи Windows 11 смогут пользоваться виртуальными копиями своих компьютеров в облаке в случае поломки ПК. Компаниям предлагается доступ к виртуальным машинам в облаке Azure, если откажет железо или программное обеспечение, сообщает The Register. По словам Microsoft, в условиях постоянного подключения к Сети сбой даже одного устройства может негативно сказаться на работе всей организации, что снизит производительность, создаст дополнительную нагрузку на IT-отделы и др. Как заявляют в компании, если возможные сбои умножить на тысячи сотрудников, последствия станут «колоссальными». Для тех, кто хочет сохранить работоспособность IT-инфраструктуры в любых условиях, предлагается сервис Windows 365 Reserve. Он позиционируется как современное, безопасное и масштабируемое решение, помогающее сотрудникам сохранять продуктивность и быть на связи даже в непредвиденных обстоятельствах. Сервис предназначен для бизнес-пользователей, при этом подписка Reserve не связана с основным продуктом Windows 365.

Источник изображения: Jonathan Borba/unspalsh.com Клиенты могут получить доступ к «временному, безопасному и выделенному облачному ПК», пользоваться которым можно будет до 10 дней, если основная машина выйдет из строя. Виртуальные машины размещаются на облачной платформе Microsoft и управляются через Microsoft Intune, так что их можно предварительно настроить для быстрого развёртывания. Проблема в том, что для использования такого облачного ПК всё равно потребуется ещё одно устройство, имеющее хотя бы рабочий веб-браузер — желательно… ещё один ПК. Ещё одно препятствие для пользователей Windows 365 Reserve — проблема «масштабирования» в случаях, когда неудачное обновление, атака вируса или другая масштабная проблема одновременно оставит без возможности использовать традиционные ПК сразу несколько пользователей. В Microsoft признают, что Windows 365 Reserve ограничен ёмкостью облака Azure и, конечно, требует сетевого подключения для использования виртуального ПК. Пока желающие протестировать Windows 365 Reserve могут подать заявку для доступа к закрытой бета-версии. Участвовать могут только избранные: клиенты Microsoft, MVP-эксперты или партнёры компании, у которых есть лицензии Windows E3, Intune и Azure Active Directory P1 (AADP1). Участники бета-теста Windows 365 Reserve должны выполнить набор тестовых сценариев — как для администраторов, так и для конечных пользователей, предоставив обратную связь о своём опыте использования нового сервиса. Соискателям с одобренными заявками будет предоставлен бесплатный доступ к платформе на срок до 12 недель.

31.07.2025 [14:25], Владимир Мироненко

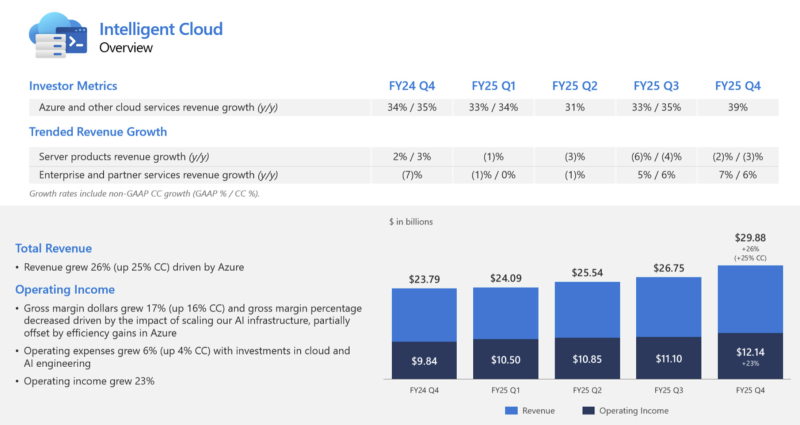

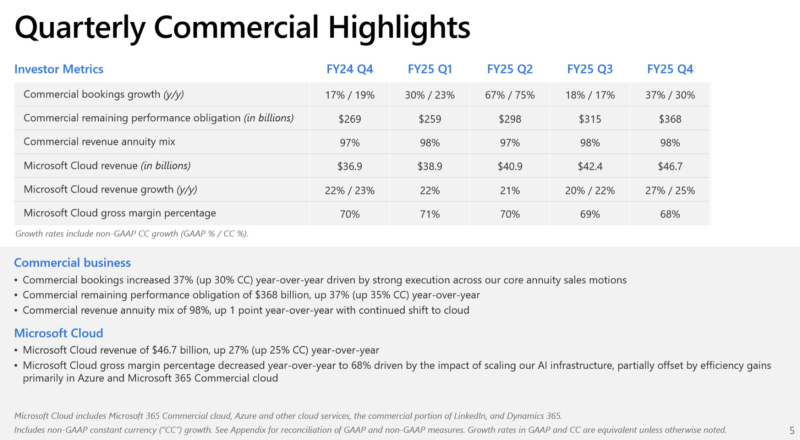

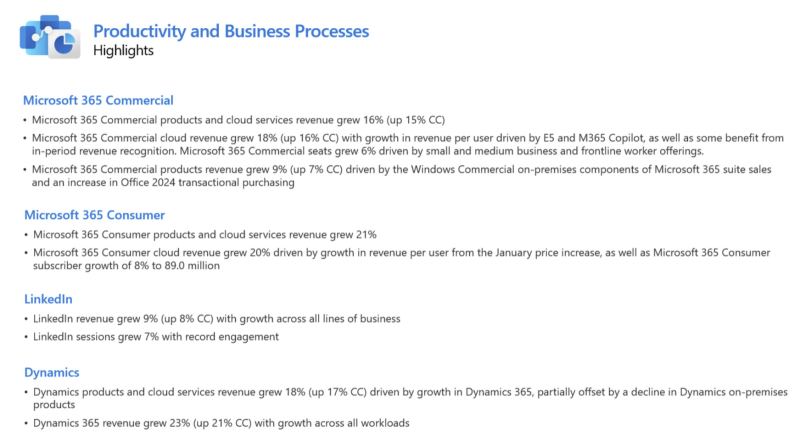

Microsoft увеличила выручку и впервые раскрыла цифры по AzureАкции Microsoft выросли на 9 % в ходе расширенных торгов после публикации компанией отчёта за IV квартал 2025 финансового года, согласно которому её прибыль и выручка превысили ожидания аналитиков. Благодаря росту акций рыночная капитализация Microsoft превысила отметку в $4 трлн, всё же уступая NVIDIA, которая преодолела данный рубеж ранее в этом месяце, отметил ресурс Siliconangle. Microsoft также впервые раскрыла годовой доход облачной платформы Azure, что позволило акционерам получить представление о её положении в облачном сегменте по сравнению с Amazon и Google. Выручка Microsoft за отчётный период выросла на 18 % до $76,44 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $73,81 млрд. Это самый быстрый рост показателя за более чем три года. Чистая прибыль увеличилась на 24 % до $27,23 млрд с $22,04 млрд годом ранее. Чистая прибыль на акцию составила $3,65 по сравнению с $3,37 согласно консенсус-прогнозу аналитиков, опрошенных LSEG. «Мы завершили финансовый год с сильным кварталом, о чем свидетельствует выручка от Microsoft Cloud, достигшая $46,7 млрд, что на 27 % больше по сравнению с аналогичным периодом прошлого года», — отметила Эми Худ (Amy Hood), исполнительный вице-президент и финансовый директор Microsoft. Выручка подразделения Microsoft Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, составила $29,88 млрд (рост год к году на 26 %), что превзошло консенсус-прогноз StreetAccount в $28,92 млрд. Компания сообщила, что выручка облачной платформы Microsoft Azure за 2025 финансовый год превысила $75 млрд, что на 34 % больше, чем годом ранее. Это обусловлено не только спросом на ИИ, но и «ростом во всех рабочих нагрузках», указал генеральный директор Microsoft Сатья Наделла (Satya Nadella) в отчёте. Для сравнения, согласно данным Alphabet, о чём сообщает The Wall Street Journal, годовая выручка Google Cloud превысила $50 млрд, а у AWS — более $111 млрд (с учётом итогов завершившегося в марте квартала). В IV финансовом квартале выручка Azure выросла на 39 %. Аналитики, опрошенные StreetAccount и CNBC, прогнозировали рост Azure на 34,4 % и 35,3 % соответственно. Компания заявила, что ожидает рост на 37 % в текущем квартале, что превзошло прогнозы аналитиков в 33,5 % (согласно данным Visible Alpha), о чём сообщает Reuters. Выручка подразделения Microsoft Productivity and Business Processes составила $33,11 млрд (рост год к году на 16 %), превысив консенсус-прогноз в $32,12 млрд аналитиков, опрошенных StreetAccount. Сатья Наделла рассказал о том, как ставка компании на ИИ, включая значительные инвестиции в OpenAI и многомиллиардные затраты на чипы NVIDIA, способствует росту продаж ПО в этом подразделении. Он отметил, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода на одного пользователя таких продуктов, как Office. В настоящее время насчитывается более 100 млн активных пользователей инструментов Copilot в месяц, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для потребителей в Windows. Ставка Microsoft на ИИ, включая инвестиции в OpenAI и миллиарды долларов, потраченные на чипы NVIDIA, способствует росту продаж бизнес-ПО, отметил Сатья Наделла. Он подчеркнул, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода в расчёте на пользователя таких продуктов, как Office. Количество активных пользователей продуктов Copilot, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для пользователей Windows, составляет 100 млн ежемесячно, сообщил Наделла. Аналитик Valoir Ребекка Веттеманн (Rebecca Wettemann) сообщила SiliconANGLE, что комментарии Наделлы обнадёживают, но отметила, что компания всё ещё испытывает трудности с ростом популярности ИИ по сравнению с некоторыми конкурентами. «Microsoft медленнее, чем некоторые конкуренты, добивается успеха в области ИИ», — сказала аналитик. «Поскольку конкуренты начинают хвастаться корпоративными референциями и говорить о цифрах внедрения, Microsoft необходимо последовать их примеру, чтобы опровергнуть мнение о том, что Copilot всё ещё слишком дорог для широкого внедрения среди клиентов», — предложила она. Подразделение More Personal Computing увеличило выручку на 9 % до $13,45 млрд, что выше консенсус-прогноза StreetAccount в размере $12,68 млрд. Капитальные затраты Microsoft выросли год к году на 27 % до $24,2 млрд, по сравнению с прогнозом аналитиков в $23,08 млрд (согласно Visible Alpha), поскольку компания продолжает активно развивать инфраструктуру ИИ ЦОД. Ещё $1,71 млрд списаны на другие расходы, включая убытки от инвестиций в долевое участие в компаниях, включая OpenAI. Эми Худ сообщила, что компания прогнозирует выручку за I финансовый квартал в пределах от $74,7 до $75,8 млрд со средним показателем в размере $75,25 млрд, превосходящем консенсус-прогноз LSEG в $74,09 млрд Прогноз по операционной рентабельности в размере 46,6 % превышает консенсус-прогноз аналитиков, опрошенных StreetAccount, в 45,7 %. Прогноз Microsoft включает более $30 млрд на капзатраты и активы, приобретённые по финансовой аренде, что в итоге обеспечит рост год к году более 50 %. Аналитики, опрошенные Visible Alpha, ожидают около $24,23 млрд. Microsoft заявила, что её капитальные расходы несколько сместились в сторону активов с длительным сроком службы, таких как ЦОД, хотя ранее компания сообщила инвесторам, что в 2026 финансовом году структура капитальных расходов сместится в сторону активов с малым сроком службы, таких как чипы.

27.07.2025 [23:55], Владимир Мироненко

Microsoft признала, что не может гарантировать суверенитет данных в Европе

aws

microsoft

microsoft azure

software

гиперскейлер

европа

евросоюз

закон

информационная безопасность

конфиденциальность

облако

сша

франция

Microsoft «не может гарантировать» суверенитет данных клиентам во Франции, и, как следствие, всему Европейскому союзу, если администрация Трампа потребует доступ к информации о клиентах, хранящейся на её серверах, пишет The Register. Об этом сообщил, выступая перед Сенатом Франции в рамках расследования государственных закупок и их роли в обеспечении цифрового суверенитета Европы, Антон Карньо (Anton Carniaux), директор по связям с общественностью и правовым вопросам французского отделения Microsoft. Согласно Акту о законном использовании данных за рубежом (The Cloud Act), правительство США наделено правом получать цифровые данные, хранящиеся у американских технологических корпораций, причём в независимости от того, хранятся ли эти данные на серверах внутри страны или за рубежом, и даже если эти данные принадлежат не гражданам США. Отвечая на вопрос о технических или юридических механизмах, которые могли бы помешать такому доступу в соответствии с The Cloud Act, Карньо заявил, что компания «имеет договорное обязательство перед своими клиентами, включая клиентов государственного сектора, отклонять эти запросы, если они необоснованны». Ранее Microsoft заверила, что работа облачных сервисов в ЕС будут контролироваться местным советом директоров и действовать в соответствии с местным законодательством. Карньо подчеркнул, что правительство не может делать запросы, которые не имеют чёткого определения — если такие запросы поступают, компания просит о возможности уведомить об этом соответствующего клиента. Карньо также спросили, может ли он, как представитель руководства Microsoft, в случае юридически обоснованного судебного запрета «гарантировать нашему комитету под присягой», что данные французских граждан не будут переданы американскому правительству без явного согласия французского правительства. «Нет, — сказал Карньо, — я не могу этого гарантировать, но, опять же, такого никогда раньше не случалось». Марк Буст (Mark Boost), генеральный директор облачного провайдера Civo, заявил: «Одна строка показаний только что подтвердила, что американские гиперскейлеры не могут гарантировать суверенитет данных в Европе». По его словам, Microsoft открыто признала то, что многим давно известно: согласно законам вроде The Cloud Act власти США могут принудительно запрашивать доступ к данным, хранящимся у американских провайдеров облачных услуг, независимо от того, где эти данные физически хранятся. «Это больше, чем просто формальность. Это реальная проблема, которая может повлиять на национальную безопасность, конфиденциальность персональных данных и конкурентоспособность бизнеса», — заявил Марк Буст. Параллельно на этой неделе AWS пояснила некоторые моменты реализации требований The Cloud Act в связи с ростом числа «запросов о том, как мы обрабатываем запросы государственных органов на предоставление данных». AWS утверждает, что закон не предоставляет правительству США «беспрепятственный или автоматический доступ к данным, хранящимся в облаке». The Cloud Act позволил США заключать взаимные исполнительные соглашения с доверенными иностранными партнёрами с целью получения доступа к электронным доказательствам для расследования тяжких преступлений, где бы эти доказательства ни находились, устранив препятствия, предусмотренные законодательством США. «Согласно законодательству США, провайдерам фактически запрещено раскрывать данные правительству США при отсутствии предусмотренного законом исключения», — сообщила AWS. — «Чтобы обязать провайдера раскрыть данные, правоохранительные органы должны убедить независимого федерального судью в наличии причины, связанной с конкретным преступлением, и в том, что доказательства преступления будут обнаружены там, где должен быть произведён обыск». AWS заявила, что до этого момента не раскрывала данные корпоративных или государственных клиентов в соответствии с законом The Cloud Act. По словам AWS, принципы закона «соответствуют международному праву и законам других стран»; и закон «не ограничивает технические меры и операционные средства контроля, которые AWS предлагает клиентам для предотвращения несанкционированного доступа к их данным». И последний аргумент AWS, который явно направлен против европейских конкурентов, пытающихся воспользоваться движением за суверенитет данных, заключается в том, что The Cloud Act распространяется не только на компании с головным офисом в США, но и на всех «поставщиков услуг электронной связи или удалённых вычислений», ведущих бизнес в США. То есть поставщики облачных услуг со штаб-квартирой в Европе, ведущие деятельность в США, также подпадают под его действие. Microsoft, AWS и Google пытаются заверить обеспокоенных клиентов в ЕС в том, что они смогут обеспечить суверенитет данных при не совсем дружелюбной позиции США по отношению к странам, некогда считавшимся близкими союзниками. Несмотря на это, в ЕС наблюдается тенденция на создание суверенной инфраструктуры, отметил The Register, хотя не все поддерживают эту идею. Более того, многие в Европе смирились с тем, что без американских облаков уже не обойтись. Согласно данным Synergy Research Group, доля локальных игроков на облачном рынке Европы замерла на уровне 15 %. При этом часть из них ещё и попала в зависимость от новой политики Broadcom в отношении VMware.

03.06.2025 [10:10], Владимир Мироненко

Благодаря ИИ Microsoft из отстающих вышли в лидеры по темпам роста своих акцийПосле нескольких месяцев затишья акции Microsoft возобновили рост, вплотную приблизившись к рекордному максимуму на фоне признаков возвращения к норме бизнеса Azure, пишет Bloomberg. Сейчас акции Microsoft торгуются всего на 2 % меньше рекордного уровня, достигнутого в июле прошлого года, после роста на 16 % в мае, что сделало его лучшим месяцем для компании за более чем три года. Рост акций был обусловлен более широким восстановлением позиций акций американских компаний, а также лучшими, чем ожидали на Уолл-стрит, результатами Azure. Как полагают инвесторы, эта тенденция сохранится, поскольку ИИ становится драйвером роста бизнеса. «ИИ становится всё более важной составляющей доходов», — отметила Нэнси Тенглер (Nancy Tengler), гендиректор инвестиционной компании Laffer Tengler Investments. Темпы роста акций Microsoft резко увеличились по сравнению с прошлым годом, когда из-за опасений инвесторов по поводу отставания компании в гонке ИИ и разочаровывающего роста Azure по сравнению с облачными платформами конкурентов акции софтверного гиганта выросли всего на 12 %. Это был худший показатель среди так называемой «великолепной семёрки», также включающей Apple, NVIDIA, Alphabet, Amazon, Meta✴ и Tesla. В этом году Microsoft с ростом акций на 9 % обошла всех участников семёрки, за исключением Meta✴, у которой рост акций составил 10 %. Помимо того, что Microsoft значительно улучшила финансовое положение, она, в отличие от многих конкурентов, выиграла от введения пошлин новой администрацией США, пишет Bloomberg. Аналитики TD Cowen опубликовали прогноз, согласно которому выручка Azure, связанная с ИИ, вырастет примерно до $24 млрд в 2026 финансовом году с около $4 млрд в 2024 финансовом году. Аналитики повысили целевую цену акций до $540 с $490, что подразумевает потенциальный прирост примерно на 18 % по сравнению с ценой на момент закрытия торгов в прошлую среду. Из 72 аналитиков, опрошенных Bloomberg, которые отслеживают деятельность Microsoft, никто не рекомендует продавать её акции. При прогнозируемом соотношении цены и прибыли на акцию в 30 на следующие 12 месяцев Microsoft оценивается с премией к среднему показателю Nasdaq 100 и собственному 10-летнему среднему показателю в размере около 26, пишет Bloomberg. По мнению Кевина Уолкуша (Kevin Walkush), управляющего портфелем в Jensen Investment Management, акции Microsoft продолжат расти, поскольку компания будет генерировать растущую долю дохода от ИИ-сервисов. «Microsoft, вероятно, является одной из лучших долгосрочных возможностей в ИИ», — заявил он.

30.05.2025 [09:34], Руслан Авдеев

Microsoft закрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентовКомпания Microsoft сделала серьёзную заявку на мировое лидерство в сфере искусственного интеллекта, в своё время инвестировав $13 млрд в стартап OpenAI. Позже компания использовала GPT-модели OpenAI в качестве основы для собственного бота Copilot AI, интегрировав его во многие свои продукты, а теперь вышла на новый уровень, сообщает Computer World. Компания запустила хостинг LLM и ИИ-сервисов крупнейших в мире ИИ-компаний и стартапов, включая собственных конкурентов — всего более 1900 моделей, от Llama AI (Meta✴) до разработок xAI и европейских стартапов Mistral и Black Forest Labs, а также китайского DeepSeek и др. Другими словами, даже если Copilot не оправдает ожиданий Microsoft в полной мере, она в какой-то степени разделит и успехи своих конкурентов и, вероятно, останется крупнейшей в мире ИИ-компанией. ЦОД Microsoft стали залогом её успеха на рынке искусственного интеллекта. Благодаря сделке с OpenAI сама Microsoft получает отчисления от каждого подписчика OpenAI. Для монетизации ИИ-решений в 2023 году Microsoft запустила сервис Azure OpenAI, позволяющий клиентам Azure создавать приложения с использованием моделей OpenAI. По некоторым данным, в сервисе зарегистрировано около 60 тыс. клиентов.

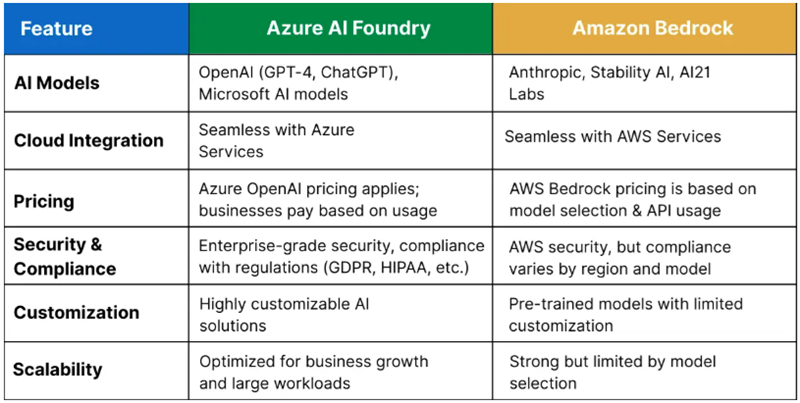

Источник изображения: Craig Sybert/unsplash.com Бизнес компании растёт и благодаря договорённостями с другими ИИ-разработчиками. В середине мая Microsoft объявила о размещении моделей Grok в сервисе Azure AI Foundry. Кроме того, в облаке Microsoft размещены и другие популярные модели. Таким образом, Microsoft получает больше денег даже в том случае, когда конкуренты добиваются новых успехов. Недавно компания подробно рассказала о видении того, каким образом компании смогут создавать ИИ-агентов для выполнения широкого спектра задач. В центре внимания — Azure AI Foundry, позволяющий клиентам создавать ИИ-агентов, использую любую из почти 2 тыс. моделей и объединяя их возможности, в том числе, например, для работы на GutHub. Другими словами, заказчикам не придётся подписываться на использование моделей у каждой из компаний по отдельности.

Источник изображения: Q Service Хотя крупнейшим облачным оператором в мире является Amazon (AWS), Microsoft постепенно сокращает разрыв, а подобные площадки для работы с разными ИИ-моделями обеспечивают ей большую фору. Amazon с аналогом Azure AI Foundry — Amazon Bedrock пыталась повторить нечто подобное, но ИИ-моделей у неё гораздо меньше. Высока вероятность, что в этой схватке первенство останется за Microsoft. По расчётам экспертов Q Services, предложение Bedrock лучше подходит разве что для стартапов и компаний, занимающихся разработкой, а Microsoft доминирует на более широком рынке, в том числе сотрудничая с крупными корпорациями. Большое преимущество компании — в использовании всех продуктов, от Microsoft 365 до Azure для продажи существующим клиентам сервисов Azure AI Foundry. У Amazon такая уникальная возможность отсутствует.

29.05.2025 [18:29], Руслан Авдеев

Microsoft запустила свой первый облачный регион в МалайзииКомпания Microsoft запустила свой первый облачный регион в Малайзии. Malaysia West, расположенный в Куала-Лумпуре, теперь доступен всем желающим, сообщает Datacenter Dynamics. По информации самой Microsoft, регион состоит из трёх зон доступности и классифицирован как «готовый к ИИ» (AI Ready). Малайзийские организации получат доступ к облачным сервисам Microsoft, данные будут размещаться внутри страны. Как заявляют в Министерстве цифровых технологий Малайзии, с новым облачным регионом страна сможет использовать новейшие цифровые и ИИ-технологии для повышения добавленной стоимости и освоения более сложных звеньев производственной цепочки. Утверждается, что правительство заложило основу для этого, разработав первоклассную и надёжную цифровую среду для процветания бизнеса — она соответствует принципам «доверенного облака» Microsoft. По словам представителя Microsoft, компания стремится стать партнёром Малайзии в её ИИ-трансформации, а облачный регион Malaysia West обеспечит для этого инфраструктуру ИИ ЦОД мирового класса и позволит местным организациям и компаниям более безопасно ускорить инновации.

Источник изображения: Hadi ardzani/unsplash.com Среди первых пользователей облачного региона — ключевой малайзийский поставщик энергии Petronas, а также SCICOM Berhad, Senang, SIRIM Berhad, TNG Digital (оператор TNG eWallet), Veeam и другие компании. В 2023 году Microsoft уже разработала для Petronas ИИ-инфраструктуру (HPC AI). Также Microsoft выступила с инициативой BINA AI, направленной на содействие ИИ-трансформации в Малайзии. Также в стране компанией будет создан Национальный центр инноваций в области ИИ (Microsoft National AI Innovation Center). Впервые о планах создания облачного региона в Малайзии в Куала-Лумпуре IT-гигант объявил в 2021 году, а в 2024 году компания обязалась инвестировать $2,2 млрд в облачные вычисления и ИИ в стране в следующие четыре года. В 2024 году компания скупала земли в Джохоре, но пока не объявляла о строительстве облачного региона в этом городе. В прошлом месяце Microsoft запустила облачный регион в соседней Индонезии, он тоже стал первым для компании в этой стране. Примечательно, что совсем недавно разразился скандал, связанный с объявлением о строительстве в Малайзии суверенной ИИ-инфраструктуры на базе ускорителей Huawei Ascend. Буквально через день правительственный анонс был дезавуирован премьер-министром Анваром Ибрагимом (Anwar Ibrahim), который прямо назвал прежние заявления подчинённых «преждевременными» — вполне вероятно, под давлением США.

26.05.2025 [16:59], Руслан Авдеев

Евросоюз готов признать, что отказаться от американских облаков «почти невозможно»

aws

google cloud platform

hardware

microsoft azure

oracle cloud infrastructure

гиперскейлер

евросоюз

импортозамещение

информационная безопасность

кадры

конфиденциальность

миграция

облако

сша

цод

По мнению отраслевых аналитиков, европейские организации, желающие выйти из сферы влияния американских облачных операторов, почти не имеют на это шансов. Евросоюз уже почти смирился — информация об этом, вероятно, будет опубликована официально в ближайшем будущем, сообщает The Register. Приход к власти нового президента США и его противоречивая политика вызвали обеспокоенность в Европе — многие задались вопросом о том, можно ли полагаться на облачные ресурсы американских гиперскейлеров или стоит использовать местные, европейские ресурсы. Издание Politico заявило, что Еврокомиссия готова признать цель обретения полного суверенитета от американских гиперскейлеров нереалистичной — соответствующая точнка зрения будет изложена в документе Digital Strategy for Europe, который намерены опубликовать в начале июня. В проекте якобы говорится, что полное прекращение сотрудничества с AWS, Microsoft Azure и Google Cloud «нереально». В Еврокомиссии отказались комментировать слухи. Тем не менее, отраслевые эксперты, опрошенные The Register, похоже, в основном согласны с предположением, что Евросоюзу не удастся избежать доминирования американских облачных гигантов, поскольку на AWS, Microsoft и Google приходится более 70 % публичного облачного рынка в Европе. Так, в Informa заявили, что в теории ничто не мешает европейским компаниям вернуться в местные облака, но на практике это почти невозможно, а со временем ситуация только усугубляется. Проблема частично в том, что европейские компании тесно сотрудничали с американскими гиперскейлерами, и изучения с нуля новых платформ их пугает и совершенно не привлекает. Ещё одна проблема — это огромный объём всех корпоративных данных и приложений, не только размещённых у «большой тройки» за последние годы, но и объём, все ещё находящийся в корпоративных ЦОД. По данным IDC, если бы в Европе все перешли на публичные облака, для обеспечения достаточной ёмкости потребовалось бы около 20 лет. А в случае ИИ-нагрузок Евросоюзу попросту не хватает мощностей ЦОД для обретения цифрового суверенитета, да и оборудование для ИИ-систем преимущественно американское. Главными проблемами при переносе нагрузок из облаков гиперскейлеров в локальные и/или суверенные облака являются масштаб миграции и технические сложности — «большая тройка» более 10 лет предлагает услуги, выходящие далеко за рамки простого запуска кода в виртуальных машинах или контейнерах. Трио гиперскейлеров, а также Oracle — единственные, кто предлагает действительно полный спектр облачных сервисов и сеть ЦОД в Европе. В Synergy Research Group подчёркивают, что другие облачные компании обычно ограничены спектром поставляемых услуг или географической нишей. Другими словами, выбор для многонациональных компаний с широкими потребностями невелик. Хуже того, многие европейские компании сами являются партнёрами «большой тройки», поэтому даже если их клиент не сотрудничает с гиперскейлерами напрямую, он может быть связан с ними косвенно. В Gartner отмечают, что суммарная доля американских гигантов на глобальном облачном рынке составляет около 84 %. Проблема ещё и в том, что на момент зарождения облачных технологий, конкуренцию американцам не могла составить ни одна европейская компания, а догонять сейчас — ещё проблематичнее. Большинство региональных провайдеров не могут сравниться с ними ни качественно, ни количественно, и зависимость от США без потери функциональности устранить невозможно. Отказ от больших облаков может оказаться сложным и по другим причинам. В своё время быстрая миграция в удобные облака разрушила IT-экосистему внутри самих компаний. Люди, которые знали, как управлять собственными вычислительными мощностями, ушли на пенсию или прошли переподготовку с акцентом на облачные решения. Кроме того, сам процесс извлечения данных из облака на суверенные мощности может оказаться непомерно дорогим с учётом т.н. «платы за выход», которую «большая тройка» формально отменила, но лишь при соблюдении ряда не всегда приемлемых условий. Многие эксперты указывают на практику, когда европейский компании выбирают комбинированный подход к получению услуг. Так, в Omdia утверждают, что миграция — сложный и дорогой процесс, поэтому более вероятно, что новые рабочие нагрузки будут распределяться, например, в пользу суверенного европейского облака, но… от американского поставщика. В марте 2025 года появилась информация, что Microsoft завершила проект EU Data Boundary по созданию суверенного облака для пользователей из Евросоюза, а в мае — новость о том, что Google вслед за Microsoft заявила о готовности поддержать клиентов из Евросоюза и представила новые решения для защиты цифрового суверенитета.

21.05.2025 [12:57], Руслан Авдеев

ИИ-платформа Microsoft Discovery создала жидкость для СЖО за 200 часов вместо нескольких месяцев

hpc

microsoft

microsoft azure

software

ии

ии-агент

квантовые вычисления

погружное охлаждение

разработка

сжо

химия

Компания Microsoft запустила для корпоративных пользователей в тестовом режиме ИИ-платформу Microsoft Discovery, использующую ИИ-агентов и HPC для помощи учёным, которым не придётся самостоятельно писать код для своих исследований. Потенциал системы продемонстрировали на примере самой Microsoft — ИИ помог создать новейшую жидкость для погружного охлаждения всего за 200 часов вместо нескольких месяцев или даже лет, сообщает VentureBeat. Microsoft Discovery использовали для поиска охлаждающей жидкости без «вечных» PFAS-химикатов, часто применяемых в иммерсионных СЖО. Регуляторы во всём мире всё чаще запрещают производство и использование этого класса вещества. ИИ Microsoft проверил 367 тыс. веществ-кандидатов, после чего химикат синтезировал один из партнёров компании. Однако сфера применения такого ИИ простирается далеко за пределы создания охлаждающих жидкостей — новые материалы и химикаты требуются в самых разных сферах, но на их поиск часто уходят годы. Microsoft Discovery позволяет взаимодействовать с «невероятными возможностями» ИИ, используя естественный язык, что полностью меняет весь процесс исследований, говорит компания. Обычно учёным приходилось изучать программирование для того, чтобы создавать вычислительные инструменты. Такая демократизация науки сыграет на руку малым исследовательским группам, у которых нет ресурсов на изучение программирования или привлечения сторонних специалистов в этой сфере. Более того, со временем платформа научится работать и с квантовыми компьютерами, написание кода для которых — ещё более сложная задача.

Источник изображения: National Cancer Institute/unsplash.com Работа выполняется с помощью специальных ИИ-агентов, специально обученных для выполнения отдельных научных задач — от написания литературного обзора до создания компьютерной симуляции. По словам Microsoft, ИИ-агенты — это чуть ли не целая команда учёных с докторскими степенями в различных науках. Платформа интегрирует друг с другом базовые модели, занимающиеся общим планированием, и модели, специализирующиеся на физике, химии или, например, биологии. Также Microsoft Discovery позволяет комбинировать закрытые исследовательские данные и результаты уже опубликованных научных исследований по разным дисциплинам, сохраняя прозрачность моделей и контролируя процесс «рассуждений». Для работы с платформой используется интерфейс Copilot, который занимается оркестрацией агентов. Одновременно интерфейс служит и центральным хабом, в котором учёные управляют своей виртуальной ИИ-командой.

Источник изображения: National Cancer Institute/unsplash.com В платформу встроены защитные механизмы — системе заданы «этические координаты». Также применяется модерация контента с проактивным подходом к выявлению злоупотреблений возможностями платформы — маркируются потенциально вредоносные алгоритмы и действия, поскольку все ИИ-инструменты фактически имеют «двойное назначение». С их помощью можно изобретать не только лекарства, но и опасные биологически опасные субстанции. Для своей платформы Microsoft выстраивает экосистему с участием представителей самых разных отраслей, от фармацевтики (GSK) до индустрии красоты (Estée Lauder). NVIDIA интегрирует с Discover микросервисы ALCHEMI и BioNeMo NIM для биотехнологий и фармацевтики. В полупроводниковой сфере Microsoft планирует интеграцию решений Synopsys для ускорения разработки чипов. Адаптацией под конкретные отраслевые задачи, развёртыванием и масштабированием платформы займутся Accenture и Capgemini.

Источник изображения: Microsoft Успех Microsoft Discovery будет зависеть от того, насколько эффективно систему смогут интегрировать в текущие научные процессы — многие учёные скептически относятся к новым методикам, так что компании придётся показать всё, на что способен ИИ. По словам Microsoft, будущее науки именно за сочетанием умственных возможностей человека и масштабного ИИ. Microsoft уже провела предварительную демонстрацию Discovery для ограниченного круга структур. Цены на платформу пока не названы, но доступ к к ней будет организован посредством Azure.

19.05.2025 [19:36], Руслан Авдеев

Microsoft «провалила» облачную реформу в ЕвропеНесмотря на свои обещания, Microsoft всё ещё не создала продукта, удовлетворяющего требованиям соглашения с ассоциацией европейских облачных провайдеров CISPE. В рамках действующей под эгидой CISPE инициативы European Cloud Competition Observatory (ECCO) было решено, что относительно действий компании всё ещё «существуют опасения, хотя предложены меры для исправления», сообщает Datacenter Dynamics. В июле 2024 года Microsoft заключила антимонопольное соглашение с CISPE, утверждавшей, что условия контрактов, предлагаемых компанией, вредят европейскому облачному бизнесу. Чтобы замять скандал, Microsoft заплатила €20 млн ($21,7 млн), а также согласилась разработать специальную версию платформы Azure Stack HCI (Azure Local) для европейских облачных провайдеров, которая позволит участникам CISPE запускать ПО Microsoft на их собственных облачных мощностях по ценам, эквивалентным предлагаемым для Microsoft Azure. Попытки Google «перекупить» мнение участников альянса не увенчались успехом. Дополнительно компания согласилась компенсировать членам CISPE упущенную за последние два года выручку, связанную со стоимостью лицензирования её ПО. Инициативу ECCO учредили для того, чтобы отслеживать динамику выполнения обязательств. В первом отчёте ECCO, опубликованном в феврале 2025 года, компания также получила «янтарный» статус — по мнению альянса, Microsoft «отклонилась от курса», а Azure Local всё ещё не отвечает оговоренным требованиям. Новейший доклад констатирует, что и Microsoft, и CISPE согласны с тем, что Azure Local не обеспечит полного выполнения соглашения. В связи с этим стороны завершили «первую фазу» работ, чтобы приступить к поиску альтернативного решения. До 10 июля Microsoft должна представить новое предложение. Стоит отметить, что недавно Microsoft и сама вступила в CISPE, желая активнее влиять на европейский облачный рынок, а AWS, отчасти в ответ на это, покинула организацию. Кроме того, Microsoft и AWS попали в поле зрения британского регулятора CMA. В группе Open Cloud Coalition (OCC), фактически созданной Google и призванной обеспечить конкуренцию на облачном рынке, заявили, что Microsoft неоднократно ловили за несоблюдением обещаний. В OCC считают, что текущая ситуация ничем не отличается от прошлых, а инициатива ECCO никоим образом не заменит официальное антимонопольное расследование. У заинтересованных компаний и сформированной ими структуры не хватает полномочий, чтобы призвать кого-либо к ответственности, поэтому облачный рынок остро нуждается во вмешательстве регуляторов, поскольку использование ПО Microsoft в сторонних облаках кратно дороже, чем в Azure.

01.05.2025 [01:35], Руслан Авдеев

Microsoft готова судиться с правительством США, если оно попытается лишить Европу продуктов компанииЕсли президент США Дональд Трамп (Donald Trump) каким-то образом попытается ограничить доступ европейских клиентов Microsoft к сервисам компании, та обещает судиться с ним для защиты интересов жителей Евросоюза. Таким образом IT-гигант пытается убедить ЕС в том, что Трамп не сможет лишить их доступа к критически важным технологиям, сообщает The Financial Times. По словам президента и главного юриста Microsoft Брэда Смита (Brad Smith), европейские лидеры, будучи в шоке от действий Трампа, резонно задаются вопрос, не перекроет ли он доступ к американским технологиям Евросоюзу. Смит утверждает, что компания должна стать источником «цифровой стабильности» в период нестабильности геополитической. В новом обещании упоминаются пять «цифровых обязательств» перед Евросоюзом. Это, например, обязательство оспаривать любой приказ «неевропейского» правительства о прекращении доступа к облачным сервисам европейским клиентам или нарушение их работы, в том числе в суде. Компания намерена включить соответствующий пункт в свои контракты. Смит напомнил, что у компании есть большой опыт судебных тяжб с американскими властями. Также Microsoft обязуется, что облачные сервисы в ЕС будут контролироваться местным советом директоров и действовать в соответствии с местным законодательством. Microsoft стала первым американским IT-гигантом, попытавшимся успокоить клиентов в Евросоюзе на фоне усложняющихся торговых отношений и призывов европейских политиков обеспечить технологический суверенитет, исключив из государственных контрактов любые компании из США. Сообщается, что среди политиков и компаний нарастают опасения относительно конфиденциальности европейских данных и даже возможного запрета США на деятельность американских компаний в Европе. Хотя по словам Смита, последний вариант маловероятен, он признаёт, что у европейских лидеров есть поводы сомневаться в этом. Microsoft хочет развить облачные и ИИ-платформы в Евросоюзе, увеличив мощности своих ЦОД в регионе на 40 % в следующие два года и расширив деятельность в 16 странах, на что компания готова тратить десятки миллиардов долларов ежегодно. По словам Смита, размер европейского рынка (более четверти бизнеса Microsoft) означает, что поддерживать доверие местных клиентов и правительств крайне важно для компании. Она не так давно достигла соглашения с местными облачными операторами — дополнительные проблемы ей вряд ли нужны. |

|