Материалы по тегу: hpc

|

13.07.2023 [14:05], Сергей Карасёв

atNorth, оператор дата-центров для HPC и ИИ, показал рекордную выручку12 июля 2023 года компания atNorth, оператор дата-центров на севере Европы, обнародовала результаты деятельности по итогам 2022-го. Говорится, что выручка достигла рекордного значения в размере 560 млн шведских крон, или приблизительно €53 млн. Показанный результат на 44 % превышает показатель 2021 года. Более того, в перспективе ожидается дальнейшее улучшение финансовых показателей на фоне роста востребованности услуг ЦОД. Компания atNorth в настоящее время управляет шестью дата-центрами в Исландии, Швеции и Финляндии. В ближайшие годы планируется открытие новых современных площадок для предоставления услуг в области цифровой трансформации предприятий и ИИ. Инвестиции в 2022 году в развитие инфраструктуры atNorth составили около 220 млн шведских крон (примерно €20 млн), а в 2023-м этот показатель увеличится.

Источник изображения: atNorth atNorth продолжает продвигать Скандинавский регион в качестве зоны для инвестиций в цифровую инфраструктуру. Говорится, что спрос на высокопроизводительные вычисления (HPC) стимулируется необходимостью обработки больших данных и быстрым развитием приложений на основе ИИ.

10.07.2023 [15:11], Владимир Мироненко

До последней капли: Inno4scale профинансирует разработку эффективных алгоритмов для европейских экзафлопсных суперкомпьютеровСовместное предприятие European High Performance Computing (EuroHPC JU) объявило о запуске нового исследовательского проекта Inno4scale с целью разработки инновационных алгоритмов, которые позволят в полной мере использовать потенциал экзафлопсных и постэкзафлопсных HPC-систем. Консорциум Inno4scale включает Барселонский суперкомпьютерный центр (BSC), SCAPOS, Центр высокопроизводительных вычислений Штутгартского университета (HLRS) и ассоциацию PRACE. Он будет финансировать разработку новых подходов к алгоритмам, выделяя средства на небольшие проекты, которые покажут эффективность для приложений с поддержкой экзафлопсных вычислений. Бюджет проекта Inno4scale составляет €5 млн.

Источник изображения: Inno4scale Консорциум разработает и организует конкурс для предложений на основе механизма каскадного финансирования, приём которых продлится до конца сентября. Предложения будут оцениваться осенью 2023 года внешними экспертами исходя из инновационности дизайна и влияния на повышение эффективности работы экзафлопсных систем. Разработки, как ожидается, начнутся в 2024 году и продлятся год. Наиболее эффективные алгоритмы будут в дальнейшем использоваться для HPC, что, как ожидается, приведёт к значительному повышению производительности и энергоэффективности. EuroHPC планирует построить два экзафлопсных суперкомпьютера для Европы. В прошлом году было объявлено, что в Юлихском суперкомпьютерном центре (JSC) недалеко от Аахена (Германия) будет установлен JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research). А в июне стало известно, что вторая экзафлопная система будет построена консорциумом Jules Verne во Франции.

10.07.2023 [10:30], Сергей Карасёв

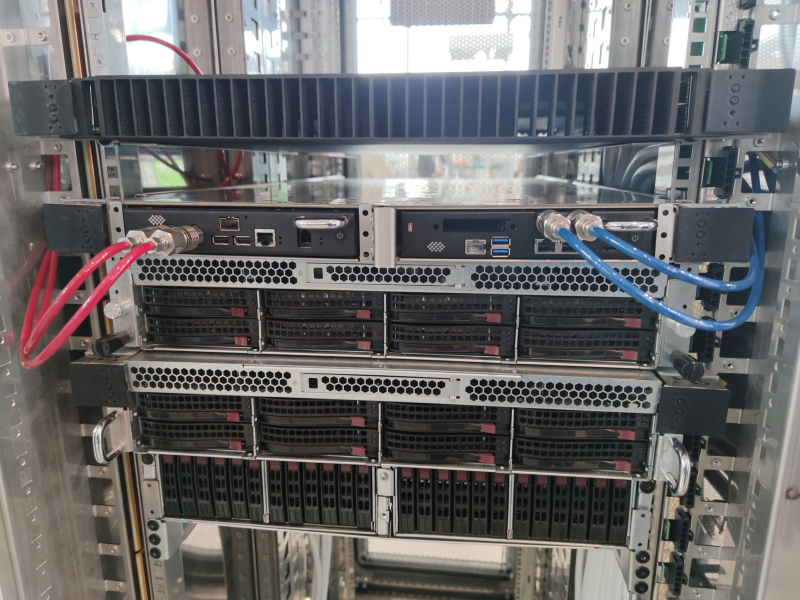

Представлена российская суперкомпьютерная платформа «РСК Экзастрим»: 570+ кВт на шкафГруппа компаний РСК в ходе международной промышленной выставки «Иннопром 2023» анонсировала энергоэффективное и высокопроизводительное кластерное решение «РСК Экзастрим» для создания российских суперкомпьютеров и дата-центров нового поколения. «РСК Экзастрим» — это двухсторонний универсальный вычислительный шкаф с возможностью монтажа 42 серверов формата 1U с каждой стороны (всего 84 сервера). Общие габариты составляют 2000 × 600 × 1200 мм. Платформа предлагает высокую энергетическую плотность (более 570 кВт на шкаф), но вместе с тем есть возможность использования разных типов охлаждения в одном шкафу: 100 % жидкостное, гибридное или воздушное. Среди особенностей «РСК Экзастрим» разработчик называет: полностью отечественную технологическую разработку и производство в РФ; гибкую, управляемую и компонуемую архитектуру; универсальность (применимы стандартные размеры серверного оборудования); большой выбор конфигураций для используемого оборудования; легкость обслуживания; возможность использования узлов на базе разных процессоров (в том числе на основе отечественных чипов «Эльбрус»). Платформа может включать интегрированные программные комплексы «РСК БазИС» и «РСК БазИС СХД» для мониторинга и управления, а также для динамического перераспределения ресурсов системы «по запросу» (как вычислительных, так и для хранения данных) для наиболее эффективного решения каждой задачи. В качестве примера использования «РСК Экзастрим» можно привести размещение узлов высокоплотной системы хранения RSC Tornado AFS на базе SSD форм-фактора E1.L (32 накопителя, 1 Пбайт на узел высотой 1U, со 100 % жидкостным охлаждением). Кроме того, могут использоваться вычислительные серверы «РСК Торнадо» на базе российских процессоров «Эльбрус-8СВ» и «Эльбрус-16С». Ещё один вариант — высокопроизводительные серверы для решения задач ИИ на основе специализированных ускорителей с плотностью размещения до четырёх штук на один узел высотой 1U.

06.07.2023 [20:49], Владимир Мироненко

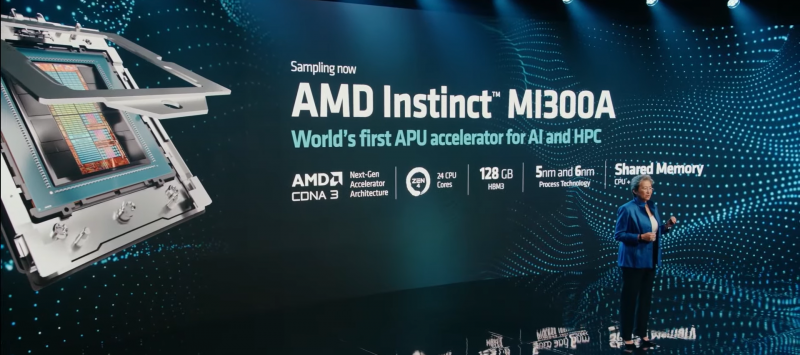

Начата сборка 2-Эфлопс суперкомпьютера El Capitan на базе серверных APU AMD Instinct MI300AЛиверморская национальная лаборатория (LLNL) объявила о получении первой партии компонентов суперкомпьютера El Capitan, которые сразу же начала устанавливать. Система будет запущена в середине 2024 года и, согласно данным LLNL, будет обеспечивать производительность более 2 Эфлопс. Стоимость El Capitan составляет около $600 млн. El Capitan будет использоваться для выполнения задач лабораторий Национальной администрации по ядерной безопасности США, чтобы они «могли поддерживать уверенность в национальных силах ядерного сдерживания», — сообщила LLNL. «На момент принятия проекта в следующем году El Capitan, вероятно, станет самым мощным суперкомпьютером в мире», — указано в заявлении LLNL. Он заменит машину Sierra на базе IBM POWER 9 и NVIDIA Volta, обойдя её производительности более чем на порядок.

Источник изображений: LLNL El Capitan базируется на платформе HPE Cray Shasta, как и две другие экзафлопсные системы, Frontier и Aurora. В отличие от этих систем, использующих традиционную конфигурацию дискретных CPU и ускорителей, El Capitan станет первым суперкомпьютером на базе гибридной архитектуры AMD. APU Instinct MI300A включает 24 ядра с микроархитектурой Zen 4 общего назначения, блоки CDNA 3 и 128 Гбайт памяти HBM3. Правда, пока не уточняется, устанавливаются ли узлы уже с финальной конфигурации «железа» или же пока что предсерийные образцы.

01.07.2023 [21:24], Сергей Карасёв

Второй в Европе экзафлопсный суперкомпьютер расположится во ФранцииЕврокомиссия, по сообщению ресурса Datacenter Dynamics, профинансирует создание второго европейского суперкомпьютера экзафлопсного класса. Безымянный пока вычислительный комплекс будет построен во Франции. Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) выбрало консорциум Жюля Верна для размещения и эксплуатации будущего HPC-комплекса. Суперкомпьютер будет управляться GENCI — французским национальным агентством высокопроизводительных вычислений. Ожидается, что система расположится в вычислительном центре TGCC, принадлежащем Французской комиссии по альтернативным источникам энергии и атомной энергии (CEA). Комплекс будет смонтирован на территории Брюйер-ле-Шатель, к юго-западу от Парижа. Инвестиции в проект составят приблизительно €542 млн, из которых до половины предоставит EuroHPC. Примерно €8 млн вложит Министерство культуры, образования и науки Нидерландов, а ещё €263 млн — французское правительство.

Суперкомпьютер GENCI Jean Zay. Источник изображения: CNRS / Cyril Frésillon Запуск суперкомпьютера запланирован на 2025 год. Применять его планируется для решения ряда сложных задач, таких как моделирование климата с высокой точностью, термоядерный синтез, разработка инновационных материалов, создание цифровых двойников и пр. В настоящее время в TGCC располагается HPC-система Joliot-Curie (22 Пфлопс), установленная в 2019 году. Первым в Европе экзафлопсным суперкомпьютером станет комплекс JUPITER, который будет смонтирован в Юлихском исследовательском центре (FZJ) в Германии. А в США недавно был завершён монтаж суперкомпьютера Aurora с быстродействием на уровне 2 Эфлопс.

01.07.2023 [21:23], Сергей Карасёв

Inflection AI привлекла $1,3 млрд на создание крупнейшего в мире ИИ-кластераМолодая компания Inflection AI, основанная в 2022 году, по сообщению ресурса Datacenter Dynamics, осуществила крупный раунд финансирования, в ходе которого на развитие привлечено $1,3 млрд. Средства предоставят в том числе корпорации Microsoft и NVIDIA. Впрочем, немалая часть этой суммы в конечно итоге всё равно достанется NVIDIA — стартап намерен создать крупнейший в мир ИИ-кластер. Ранее Inflection AI получила финансирование в размере $225 млн. Деньги предоставили Greylock, Microsoft, Рид Хоффман, Билл Гейтс, бывший глава Google Эрик Шмидт и другие. На сегодняшний день рыночная стоимость Inflection AI оценивается в $4 млрд. Inflection AI создана Мустафой Сулейманом (Mustafa Suleyman), одним из основателей Google DeepMind, а также Ридом Хоффманом (Reid Hoffman), одним из учредителей LinkedIn. Штат стартапа насчитывает немногим более 30 сотрудников.

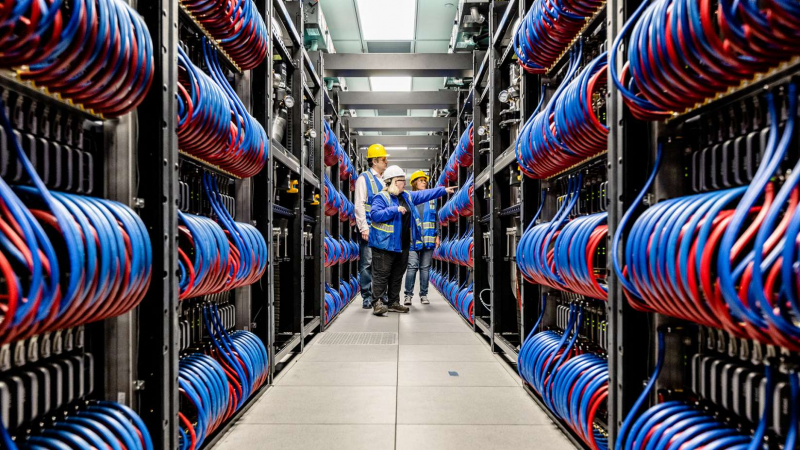

Источник изображения: Inflection AI Inflection AI специализируется на технологиях генеративного ИИ. В частности, недавно компания анонсировала чат-бота Pi — свой аналог ChatGPT. «Персональный ИИ трансформирует нашу жизнь. Это действительно переломный момент. Мы рады сотрудничать с NVIDIA, Microsoft, CoreWeave и многими другими, чтобы воплотить это видение в жизнь», — сказал господин Сулейман. Фирма намерена выступать в качестве ИИ-студии, создавая персонализированные смарт-системы, с которыми пользователи могли бы взаимодействовать простыми и естественными способами. Для этого Inflection AI в партнёрстве с облачным провайдеров CoreWeave намерена развернуть крупнейший в мире кластер ИИ, состоящий из 22 тыс. ускорителей NVIDIA H100. Этот комплекс станет одной из самых мощных НРС-систем в мире: его производительность ожидается на уровне 22 Эфлопс (16-бит точность).

26.06.2023 [15:33], Сергей Карасёв

Eviden (Atos) построит для Индии два суперкомпьютера производительностью 8,3 и 13 ПфлопсКомпания Eviden, дочерняя структура Atos, сообщила о заключении двух контрактов с Национальным центром среднесрочного прогнозирования погоды Индии (NCMRWF) на создание HPC-систем. Основой послужит платформа BullSequana XH2000. Общая сумма соглашений, подписанных от имени Министерства наук о Земле Индии, составляет $100 млн. Один из комплексов расположится в Ноиде в индийском штате Уттар-Прадеш. Эта HPC-система производительностью около 8,3 Пфлопс будет применяться для моделирования погоды и исследования климата. Суперкомпьютер объединит 2100 узлов с процессорами AMD EPYC 7643, а также 18 узлов на базе NVIDIA A100. Предусмотрено использование NVIDIA Quantum InfiniBand и высокопроизводительной памяти Micron. Упомянута система хранения DDN EXAScaler ES400NVX2: 2 Пбайт SSD и 20 Пбайт HDD.

Источник изображения: Atos Второй суперкомпьютер, предназначенный для Индийского института тропической метеорологии (IITM, Пуна), обеспечит производительность до 13 Пфлопс. Его конфигурация включает 3000 узлов с чипами AMD EPYC 7643 и 26 узлов на основе NVIDIA A100. Этот комплекс также получит сетевую платформу NVIDIA Quantum InfiniBand и хранилище DDN EXAScaler ES400NVX2 с 3 Пбайт флеш-памяти и 29 Пбайт памяти на основе HDD.

23.06.2023 [01:42], Владимир Мироненко

Завершён монтаж суперкомпьютера Aurora на базе Intel Max: 2 Эфлопс, более 20 Тбайт HBM2e и 220-Пбайт хранилищеАргоннская национальная лаборатория (ANL) Министерства энергетики США и Intel объявили о завершении установки всех 10 624 блейд-серверов суперкомпьютера Aurora. Система, как сообщается, обеспечит пиковую теоретическую FP64-производительность более 2 Эфлопс, используя массив из десятков тысяч процессоров Intel Xeon Max, а также ускорителей Data Center GPU Max (Ponte Vecchio). Система будет использоваться для самых разных рабочих нагрузок, от моделирования ядерного синтеза до расчётов по аэродинамике и медицинских исследований. Для Intel (в отличие от AMD) это будет первая в истории машина экзафлопсного класса. Ожидается, что Aurora может возглавить ноябрьский рейтинг TOP500. Впрочем, её может опередить El Capitan или неожиданно появившаяся китайская система. Суперкомпьютер Aurora оснащён 21 248 CPU с более чем 1,1 млн ядер и 63 744 ускорителями, которые будут обслуживать рабочие нагрузки в области ИИ и высокопроизводительных вычислений (HPC). Процессоры Aurora имеют 1,36 Пбайт встроенной памяти HBM2E и дополнены 19,9 Пбайт DDR5, ещё 8,16 Пбайт памяти HBM2E входят в состав ускорителей Ponte Vecchio. Машина состоит из 166 стоек (66 «лезвий» в каждой) в восьми рядах. DAOS-хранилище Aurora содержит 1024 All-Flash узла общей ёмкостью 220 Пбайт и пропускной способностью 31 Тбайт/с. На данный момент ANL не сообщила официальные данные об энергопотреблении Aurora и её подсистемы хранения. Aurora создана на базе платформы HPE Cray Shasta с интерконнектом HPE Slingshot. Хотя блейд-серверы Aurora уже установлены, суперкомпьютеру предстоит пройти ряд приёмочных испытаний, что является обычной процедурой для таких систем. А пока он будет использоваться для обучения крупномасштабных научных моделей для генеративного ИИ.

15.06.2023 [19:47], Владимир Мироненко

Genoa стремится в облака: AWS, Microsoft Azure и OCI представили инстансы с AMD EPYC последнего поколенияКомпания Oracle объявила о планах обновить инстансы Oracle Cloud Infrastructure E5, оснастив их процессорами AMD EPYC Genoa. Компания сообщила, что предложит гибкие конфигурации инстансов, позволяя клиентам подбирать параметры под их нужды. Новинки, по словам Oracle, при той же стоимости на треть быстрее инстансов прошлого поколения, а также предлагают большее количество ядер и более высокую ПСП. Так, инстансы E5 Standard предназначены для нетребовательных задач, таких как веб-серверы и серверы приложений или разработка ПО. Будут доступны bare-metal и спот-инстансы. E5 Standard используют внешнее блочное хранилище, которое работает медленнее локального, но вместе с тем дешевле. Высокопроизводительные E5 Dense-IO ориентированы на крупные СУБД, Big Data и приложения, которым требуется быстрое локальное хранилище, которое обеспечивает примерно в 10 раз меньшую задержку, чем стандартное блочное хранилище. Экземпляры E5 HPC созданы для высокопроизводительных вычислений, в том числе ИИ. E5 HPC доступны только в конфигурациях bare-metal и с RDMA-сетью, что позволяет формировать облачные суперкомпьютеры. Также для семейства E5 доступны кластерные ФС для таких сценариев использования, как большие базы данных, обучение ИИ, финансовый анализ, рендеринг видео и моделирование. Новые опции и конфигурации будут доступны в июле–августе.

Источник изображения: Oracle В свою очередь облачный провайдер Amazon Web Services (AWS) запустил предварительную версию инстансов EC2 M7a с процессорами AMD EPYC Genoa, которые будут доступны для общего использования в III квартале этого года. По словам гендиректора Лизы Су (Lisa Su), AMD будет использовать новые инстансы AWS для собственных рабочих нагрузок. Кроме того, AWS присматривается и к новым ИИ-ускорителям AMD Instinct MI300.

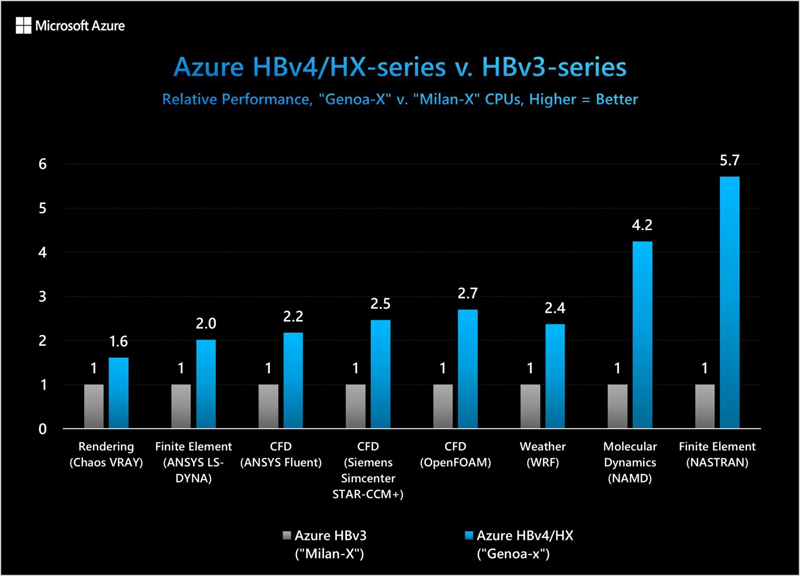

Источник изображения: Microsoft Наконец, в Microsoft Azure стали доступны первые инстансы с AMD EPYC Genoa-X и 400G-интерконнектом NVIDIA Quantum-2 InfiniBand. Как сообщает компания, виртуальные машины серий HBv4 и HX предлагают передовые уровни производительности, эффективности масштабирования и экономичности для различных HPC-нагрузок. Новинки уже доступны в регионе Azure East US, а вскоре появятся в регионах Azure Korea Central, Azure South Central US, Azure Sweden Central и Azure Southeast Asia.

14.06.2023 [03:00], Игорь Осколков

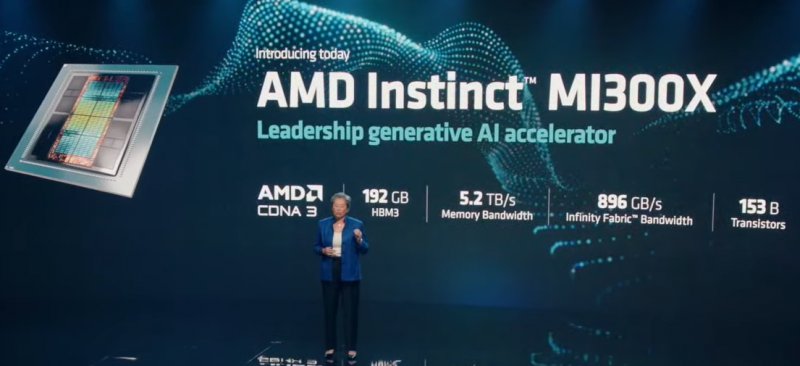

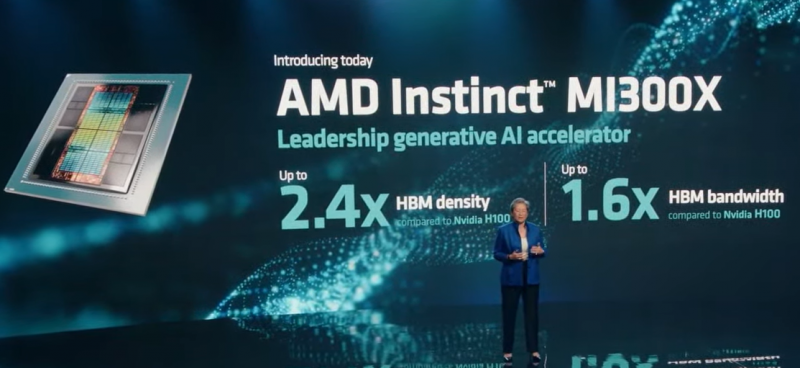

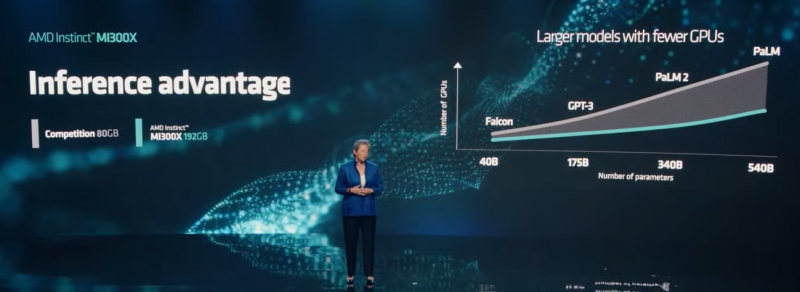

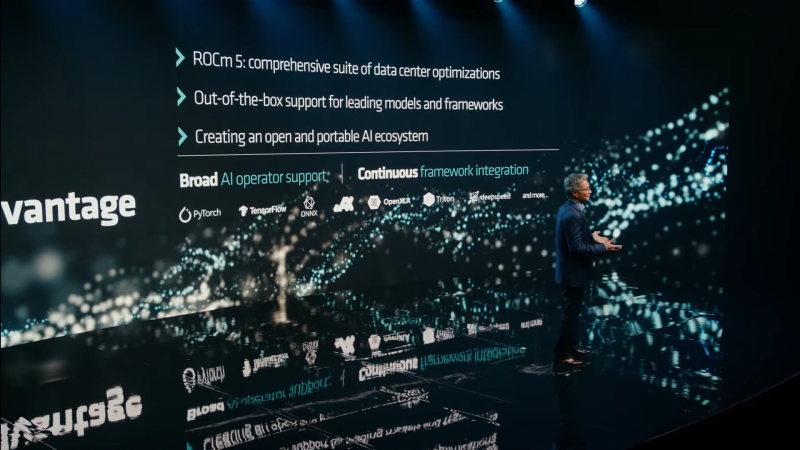

AMD представила ИИ-ускорители Instinct MI300X: 192 Гбайт HBM3 и 153 млрд транзисторовВместе с Bergamo и Genoa-X компания AMD представила и новый ИИ-ускоритель, а точнее два варианта одного и того же продукта — Instinct MI300A и MI300X. Как и в случае с EPYC, модульный подход к построению чипов позволил компании с минимумом усилий расширить портфолио. Об Instinct MI300A компания рассказывала неоднократно. Это самодостаточный APU (или XPU), объединяющий 24 ядра EPYC Genoa (три CCD), ускоритель на базе CDNA3 и 128 Гбайт общей памяти HBM3. Конкурировать он будет с решением NVIDIA Grace Hopper, которое включает 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H100 с 96 Гбайт HBM3. Intel же из гонки гибридов временно выбыла, отказавшись в Falcon Shores от блока CPU. Правда, подход у компаний разный. NVIDIA предпочитает использовать NVLink и для объединения кристаллов внутри Grace Hopper (C2C), и для связи между узлами, что упрощает масштабирование. AMD в случае Instinct MI300 использует большую подложку-интерпозер, которая объединяет HBM-стеки (8 шт.) и блоки Zen 4/CDNA3 (4 шт.), что даёт определённую гибкость в выборе конфигурации чипа. Этим компания и воспользовалась, представив OAM-ускорители MI300X, которые напрочь лишены CPU-блоков. Весьма своевременное появление 24-Гбайт модулей HBM3 позволило поднять общий объём памяти до 192 Гбайт, а её пропускную способность (ПСП) — до 5,2 Тбайт/с. Впрочем, о характеристиках новинки AMD больше ничего и не говорит, если не считать упоминания ПСП шины Infinity Fabric (896 Гбайт/с) и количества транзисторов (153 млрд шт.). Столь большой объём памяти выгодно отличает MI300X от SXM-версии NVIDIA H100, которая может предложить только 80 Гбайт HBM3 и ПСП 3,35 Тбайт/с. Да, у NVIDIA есть «сендвич» H100 NVL, у которого имеется уже 188 Гбайт HBM3 (7,8 Тбайт/с). Но это всё же совсем иной форм-фактор, хотя, как и MI300X, ориентированный на работу с действительно большими ИИ-моделями. Больший объём набортной памяти позволяет избавиться от лишних перемещений данных между ускорителем и основной памятью системы или несколькими ускорителями. Как и полагается, AMD анонсировала Instinct Platform — плату наподобие NVIDIA HGX, которая объединяет восемь ускорителей MI300X и, по-видимому, соответствует стандарту OCP UBB, что упрощает создание узлов на её основе. Первые образцы Instinct MI300X появятся в следующем квартале, а образцы MI300A уже поставляются заказчикам. Впрочем, одним «железом» сыт не будешь — компания активно развивает программную платформу, в том числе ROCm, поскольку в области ПО для ИИ догнать, а уж тем более перегнать NVIDIA будет непросто. Это настолько важный пункт для AMD, что даже в презентации речь сначала долго шла о ПО, а уж потом были представлены новые ускорители. |

|