Материалы по тегу: hardware

|

29.07.2024 [10:42], Сергей Карасёв

Провайдер облачной ИИ-платформы SMC намерен получить на развитие почти $1 млрдСингапурский стартап Sustainable Metal Cloud (SMC), по информации Bloomberg, рассчитывает привлечь почти $1 млрд для создания специализированной облачной платформы для задач ИИ. Речь идёт о системе на основе высокопроизводительных ускорителей NVIDIA. Фирма SMC основана в 2018 году. Она занимается созданием крупномасштабной инфраструктуры ЦОД: мощности площадки смогут использовать сторонние заказчики для разработки и запуска приложений ИИ. На сегодняшний день платформа SMC в Сингапуре объединяет приблизительно 1200 ускорителей NVIDIA H100. До конца текущего года их количество планируется довести до 5000. При этом реализована возможность масштабирования до 32 тыс. ускорителей. SMC использует технологию иммерсионного (погружного) охлаждения, которая, как утверждается, позволяет сократить выбросы углекислого газа в атмосферу на 48 % по сравнению с традиционными решениями (при работе с моделями ИИ).

Источник изображения: SMC Как сообщает Bloomberg, SMC поддерживается сингапурской компанией ST Telemedia Global Data Centers (STT GDC). Говорится, что SMC находится на завершающей стадии осуществления инвестиционного раунда на сумму около $400 млн. Кроме того, компания намерена получить долговое финансирование в размере $550 млн. Таким образом, общая сумма средств, которые рассчитывает привлечь SMC, составляет $950 млн. Компания SMC создаёт новые облачные регионы в Сингапуре, Индии, Таиланде и Австралии. Оборудование размещается в независимо аккредитованных дата-центрах, что, как утверждается, позволяет формировать высокодоступную и безопасную инфраструктуру.

29.07.2024 [10:00], Сергей Карасёв

Kalray и Pliops объединятся для разработки передовых решений для генеративного ИИКомпании Kalray и Pliops, по сообщению ресурса Storage Newsletter, подтвердили информацию о слиянии. Объединённая структура, как утверждается, займётся разработкой передовых решений SoC (System-on-Chips) для генеративного ИИ и ускорения обработки данных. О том, что стартапы Kalray и Pliops ведут переговоры о слиянии, стало известно в июне 2024 года. Kalray проектирует DPU-ускорители на основе чипов с фирменной архитектурой MPPA. В свою очередь, Pliops разрабатывает ускорители Extreme Data Processor (XDP) для различных задач, включая реляционные базы данных, разнородные СУБД NoSQL, платформы 5G и IoT, приложения ИИ и пр.

Источник изображения: Kalray Объединив технологии Pliops и архитектуру Kalray MPPA, стороны намерены предоставить заказчикам высокопроизводительные SoC для обработки данных в системах ИИ. Слияние будет осуществлено путём обмена ценными бумагами, при этом акционеры Kalray сохранят контрольный пакет. В рамках сделки стороны рассматривают возможность привлечения дополнительных средств из различных источников для ускорения развития. При этом Kalray уже получила финансирование в размере €15 млн в рамках возобновляемого банковского кредита. «Слияние представляет собой важную стратегическую возможность для обеих компаний. Объединив наши сильные стороны, мы намерены стать мировым лидером в области решений по ускорению обработки информации для платформ хранения данных и систем ИИ», — говорит Эрик Баиссус (Eric Baissus), генеральный директор Kalray. Отмечается, что технологии Pliops играют ключевую роль в повышении производительности массивов хранения данных на основе накопителей NVMe и приложений баз данных. Pliops привлекла около $200 млн с момента основания в 2017 году; компания насчитывает примерно 120 сотрудников в Израиле, США и Китае. В число её инвесторов входят AMD, Intel Capital, NVIDIA, SoftBank Ventures Asia, Western Digital и др. После завершения слияния существующие акционеры Pliops станут акционерами Kalray.

29.07.2024 [08:11], Сергей Карасёв

Инсбрукский университет запустил гибридный квантово-классический суперкомпьютерИнсбрукский университет имени Леопольда и Франца (UIBK) в Австрии объявил о том, что его НРС-комплекс LEO5 интегрирован с квантовый системой IBEX Q1 компании AQT. Таким образом, сформирован гибридный квантово-классический суперкомпьютер, который, как утверждается, открывает совершенно новые возможности для решения сложных научных и промышленных задач и создания вычислительных платформ следующего поколения. Машина LEO5, запущенная в 2023 году, объединяет 63 узла, каждый из которых содержит два процессора Intel Xeon 8358 (Ice Lake-SP) с 32 ядрами. Применён интерконнект Infiniband HDR100. В состав 36 узлов входят ускорители NVIDIA — A30, A40 или A100. Производительность достигает 300 Тфлопс на операциях FP64 и 740 Тфлопс на операциях FP32. В свою очередь, лазерная квантовая система IBEX Q1, разработанная специалистами AQT (дочерняя структура UIBK), не требует для работы экстремального охлаждения. Утверждается, что она может функционировать при комнатной температуре, а энергопотребление составляет менее 2 кВт. Квантовое оборудование размещено в двух кастомизированных стойках. Проект по созданию гибридного суперкомпьютера реализован в рамках инициативы HPQC (High-Performance integrated Quantum Computing), финансируемой австрийским Агентством по продвижению и стимулированию прикладных исследований, технологий и инноваций (FFG). Новая платформа, как отмечается, создаёт основу для будущих гетерогенных инфраструктур, ориентированных на решение сложных задач. «Успешная интеграция квантового компьютера в высокопроизводительную вычислительную среду знаменует собой важную веху для австрийских и европейских исследований и развития технологий в целом», — говорит Генриетта Эгерт (Henrietta Egerth), управляющий директор FFG.

28.07.2024 [12:36], Сергей Карасёв

Южнокорейский разработчик ИИ-чипов Rebellions получил $15 млн от нефтяного гиганта AramcoWa’ed Ventures, венчурное подразделение саудовского нефтегазового и химического гиганта Aramco, по сообщению Datacenter Dynamics, инвестировало $15 млн в южнокорейский стартап Rebellions, занимающийся разработкой ИИ-чипов для машинного зрения, чат-ботов и больших языковых моделей (LLM). Компания Rebellions основана в 2020 году. Она создаёт специализированные решения для инференса, которые обеспечивают энергоэффективность и высокую производительность при небольших задержках. В 2023-м Rebellions освоила массовое производство чипов ATOM, способных, как утверждается, конкурировать с NVIDIA A100 в некоторых задачах. Изделия ATOM предназначены для обработки LLM в дата-центрах. В январе нынешнего года Rebellions осуществила раунд финансирования Series B, в ходе которого на развитие было привлечено $124 млн. Инвестиционную программу возглавил оператор KT при участии kt cloud, Shinhan Venture Investment, KDB (Корейский банк развития), Noh& Partners, KB Securities, KB Investment, SV Investment, Mirae Asset Venture Investment, IMM Investment, KT Investment, Seoul Techno Holdings, SDB Investment и ряда других инвесторов. А в июне 2024-го стартап Rebellions объявил о слиянии с разработчиком ИИ-чипов Sapeon Korea, который был выделен из SK Telecom в 2016 году. Rebellions также сотрудничает с Samsung Electronics в рамках проекта по созданию ускорителя для генеративного ИИ. Сообщается, что Wa’ed Ventures присоединилась к раунду финансирования Series B. Соучредитель и генеральный директор Rebellions Сонхён Пак (Sunghyun Park) отметил, что инвестиции будут направлены на создание высокопроизводительных и энергоэффективных ЦОД для задач ИИ в Королевстве Саудовская Аравия. Таким образом, Rebellions стала первым корейским стартапом, получившим стратегическое финансирование от Aramco Wa'ed Ventures. В общей сложности на текущий момент компания привлекла более $215 млн финансирования.

27.07.2024 [23:44], Алексей Степин

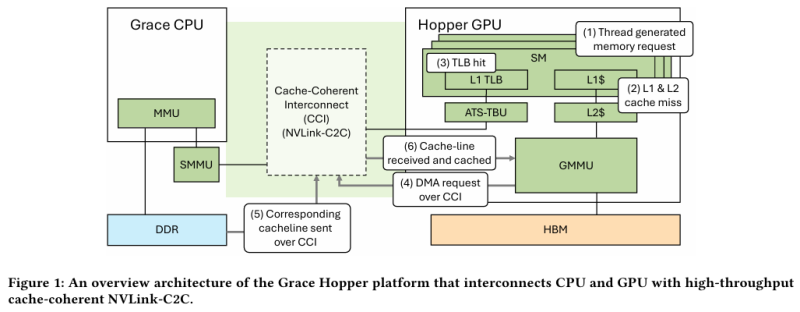

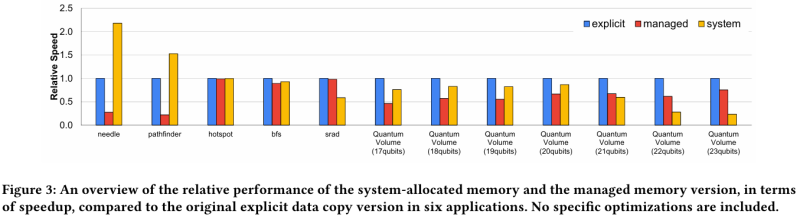

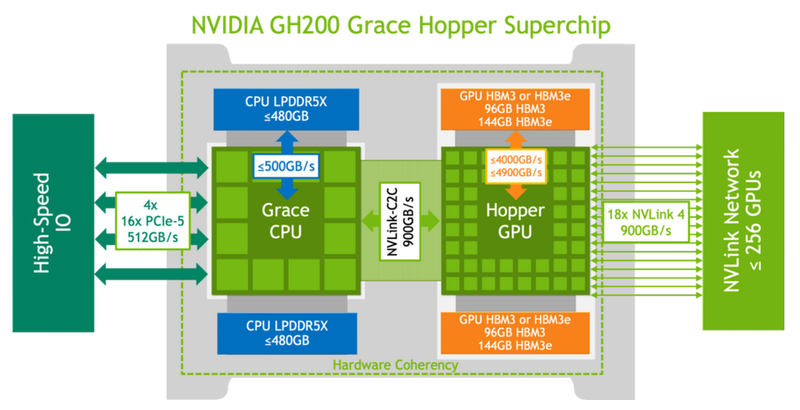

Не так просто и не так быстро: учёные исследовали особенности работы памяти и NVLink C2C в NVIDIA Grace HopperГибридный ускоритель NVIDIA Grace Hopper объединяет CPU- и GPU-модули, которые связаны интерконнектом NVLink C2C. Но, как передаёт HPCWire, в строении и работе суперчипа есть некоторые нюансы, о которых рассказали шведские исследователи. Им удалось замерить производительность подсистем памяти Grace Hopper и интерконнекта NVLink в реальных сценариях, дабы сравнить полученные результаты с характеристиками, заявленными NVIDIA. Напомним, для интерконнекта изначально заявлена скорость 900 Гбайт/с, что в семь раз превышает возможности PCIe 5.0. Память HBM3 в составе GPU-части имеет ПСП до 4 Тбайт/с, а вариант с HBM3e предлагает уже до 4,9 Тбайт/с. Процессорная часть (Grace) использует LPDDR5x с ПСП до 512 Гбайт/с. В руках исследователей оказалась базовая версия Grace Hopper с 480 Гбайт LPDDR5X и 96 Гбайт HBM3. Система работала под управлением Red Hat Enterprise Linux 9.3 и использовала CUDA 12.4. В бенчмарке STREAM исследователям удалось получить следующие показатели ПСП: 486 Гбайт/с для CPU и 3,4 Тбайт/с для GPU, что близко к заявленным характеристиками. Однако результат скорость NVLink-C2C составила всего 375 Гбайт/с в направлении host-to-device и лишь 297 Гбайт/с в обратном направлении. Совокупно выходит 672 Гбайт/с, что далеко от заявленных 900 Гбайт/с (75 % от теоретического максимума).

Источник: NVIDIA Grace Hopper в силу своей конструкции предлагает два вида таблицы для страниц памяти: общесистемную (по умолчанию страницы размером 4 Кбайт или 64 Кбайт), которая охватывает CPU и GPU, и эксклюзивную для GPU-части (2 Мбайт). При этом скорость инициализации зависит от того, откуда приходит запрос. Если инициализация памяти происходит на стороне CPU, то данные по умолчанию помещаются в LPDDR5x, к которой у GPU-части есть прямой доступ посредством NVLink C2C (без миграции), а таблица памяти видна и GPU, и CPU. Если же памятью управляет не ОС, а CUDA, то инициализацию можно сразу организовать на стороне GPU, что обычно гораздо быстрее, а данные поместить в HBM. При этом предоставляется единое виртуальное адресное пространство, но таблиц памяти две, для CPU и GPU, а сам механизм обмена данными между ними подразумевает миграцию страниц. Впрочем, несмотря на наличие NVLink C2C, идеальной остаётся ситуация, когда GPU-нагрузке хватает HBM, а CPU-нагрузкам достаточно LPDDR5x. Также исследователи затронули вопрос производительности при использовании страниц памяти разного размера. 4-Кбайт страницы обычно используются процессорной частью с LPDDR5X, а также в тех случаях, когда GPU нужно получить данные от CPU через NVLink-C2C. Но как правило в HPC-нагрузках оптимальнее использовать 64-Кбайт страницы, на управление которыми расходуется меньше ресурсов. Когда же доступ в память хаотичен и непостоянен, страницы размером 4 Кбайт позволяют более тонко управлять ресурсами. В некоторых случаях возможно двукратное преимущество в производительности за счёт отсутствия перемещения неиспользуемых данных в страницах объёмом 64 Кбайт. В опубликованной работе отмечается, что для более глубокого понимания механизмов работы унифицированной памяти у гетерогенных решений, подобных Grace Hopper, потребуются дальнейшие исследования.

27.07.2024 [15:54], Сергей Карасёв

Поставщик ИИ-услуг Gcore привлёк на развитие $60 млн от Wargaming и других инвесторовПровайдер облачных и периферийных сервисов Gcore, по сообщению Datacenter Dynamics, осуществил раунд финансирования Series A, в ходе которого на развитие получено $60 млн. Инвестиционную программу возглавил разработчик и издатель игр Wargaming при участии Constructor Capital и Han River Partners. Gcore была основана в Люксембурге в 2014 году. Компания управляет инфраструктурой, которая позволяет клиентам развёртывать свои рабочие нагрузки ИИ (обучение и инференс) на периферии. Штаб-квартира Gcore находится в Люксембурге, а представительства располагаются в Вильнюсе, Кракове, Белграде, Никосии, Тбилиси, Ташкенте, Маниле, Сеуле и Токио. На сегодняшний день инфраструктура Gcore объединяет примерно 180 edge-точек на шести континентах и более 25 облачных локаций, а общая пропускная способность сети достигает 200 Тбит/с. В качестве технологических партнёров выступают Intel, Dell, Lenovo, Wallarm, Equinix, Graphcore, Digital-Realty, Wasabi, HP, AMD, Arista и Kentik. Gcore заявляет, что применяет в составе своей сети новейшее оборудование на процессорах AMD и Intel последнего поколения. Реализованы надёжные средства защиты от несанкционированного доступа и кражи данных. Упомянуты система обнаружения вторжений (IDS), инструменты резервного копирования и восстановления, двухфакторная аутентификация, шифрование AES-128/256, сертифицированные операционные системы. Полученные в рамках раунда Series A средства будут направлены на дальнейшее расширение платформы Gcore, включая приобретение новых ИИ-серверов на базе ускорителей NVIDIA. Это первое внешнее привлечение капитала с момента основания компании. «Растущий спрос на инфраструктуру ИИ со стороны предприятий малого и среднего бизнеса подчёркивает важность этого финансирования. Мы очень рады поддержке таких инвесторов, как Wargaming, Constructor Capital и Han River Partners», — говорит Андре Райтенбах (Andre Reitenbach), генеральный директор Gcore.

27.07.2024 [10:30], Сергей Карасёв

Аргоннская национальная лаборатория намерена создать СХД ёмкостью 400 Пбайт за $20 млнАргоннская национальная лаборатория (ANL) Министерства энергетики США (DOE) обнародовала запрос на создание нового кластера хранения данных для своего парка суперкомпьютеров. Как сообщает ресурс Datacenter Dynamics, реализация проекта может обойтись в $15–$20 млн. Речь идёт о создании СХД, которая обеспечит ёмкость и производительность, необходимые для поддержания работы действующих НРС-комплексов, а также будущих суперкомпьютеров. Отмечается, что на площадке Argonne Leadership Computing Facility (ALCF) развёрнуты несколько высокопроизводительных параллельных файловых систем для обработки данных, генерируемых исследователями и инженерами. Это, в частности две системы Lustre вместимостью 100 Пбайт с пропускной способностью 650 Гбайт/с. Обе они используют интерконнект Infiniband HDR. Новая СХД будет обладать ёмкостью на уровне 400 Пбайт. В число требований входят IOPS-производительность до 240 млн, пиковая пропускная способность в 6 Тбайт/с, совместимость с POSIX и возможность одновременного монтирования до 30 тыс. узлов. Поставщик должен обеспечивать поддержку в течение пяти лет. Предполагается, что платформа будет использоваться суперкомпьютером Aurora, который в нынешнем рейтинге TOP500 занимает второе место с быстродействием 1,012 Эфлопс. Кроме того, доступ к СХД получит НРС-комплекс Polaris: его пиковая производительность составляет около 44 Пфлопс. Проектируемая СХД должна обеспечивать «надёжность и масштабируемость, необходимые для следующего поколения HPC и ИИ». Поставку платформы исполнителю работ необходимо осуществить ко II или к IV кварталу 2025 года, если дополнительные полгода позволят внедрить новые технологии.

26.07.2024 [09:50], Сергей Карасёв

Квартальные результаты SK hynix бьют рекорды на фоне бума ИИКомпания SK hynix отрапортовала о работе во II четверти 2024 года. Выручка южнокорейского производителя чипов памяти составила ₩16,42 трлн (корейских вон), или приблизительно $11,86 млрд. Это является абсолютным рекордом. Для сравнения: годом ранее показатель равнялся ₩7,31 трлн, или $5,29 млрд. Таким образом, рост в годовом исчислении оказался на уровне 125 %. SK hynix связывает резкое увеличение денежных поступлений с двумя факторами. Это, в частности, общее повышение цен на память DRAM и NAND. Кроме того, наблюдается растущий спрос на высокоскоростные изделия HBM на фоне бума ИИ и стремительного развития генеративных сервисов.

Источник изображения: SK hynix Операционная прибыль SK hynix во II квартале 2024 года составила ₩5,47 трлн ($3,96 млрд), что является самым высоким показателем с III квартала 2018 года. Чистая прибыль зафиксирована на отметке ₩4,12 трлн ($2,97 млрд), тогда как годом ранее компания понесла чистые убытки в размере ₩2,99 трлн. Продажи чипов HBM подскочили более чем на 80 % по сравнению с I четвертью 2024 года и более чем на 250 % по сравнению со II кварталом 2023-го. Вместе с тем продажи SSD корпорактивного класса в квартальном исчислении поднялись примерно на 50 %. Компания отмечает, что средняя цена реализации продуктов NAND продолжает увеличиваться с IV квартала 2023 года. SK hynix планирует укреплять позиции на рынке HBM. В частности, готовится массовое производство 12-слойных изделий HBM3E, образцы которых компания предоставила клиентам в III квартале прошлого года. Кроме того, во II половине 2024-го SK hynix планирует выпустить чипы DDR5 DRAM ёмкостью 32 Гбит для серверов и модули MCR DIMM для НРС-систем.

26.07.2024 [00:04], Владимир Мироненко

Квартальная выручка Google Cloud впервые превысила $10 млрд, а на серверы Alphabet потратила почти $13 млрдХолдинг Alphabet, материнская структура Google, опубликовал итоги работы во II квартале 2024 года, который завершился 30 июня. Результаты работы Alphabet превысили прогнозы аналитиков. Выручка холдинга составила $84,74 млрд, что на 14 % больше результата годичной давности, превысив при этом консенсус-прогноз аналитиков, опрошенных LSEG, равный $84,19 млрд. Чистая прибыль Alphabet за II квартал равна $23,6 млрд, что больше на $5,2 млрд показателя за аналогичный период 2023 года, равного $18,4 млрд. Прибыль на разводнённую акцию достигла $1,89, превысив прошлогодний результат в $1,44 на акцию и средний прогноз аналитиков, опрошенных LSEG, в размере $1,84 на акцию. Как сообщается, в минувшем квартале выручка облачного подразделения Google Cloud впервые преодолела отметку $10 млрд, составив $10,35 млрд, что больше год к году на $2,32 млрд или 29 %. Также операционная прибыль Google Cloud впервые превысила за квартал рубеж в $1 млрд, составив $1,17 млрд, тогда как годом ранее этот показатель был равен $395 млн. Гендиректор Google Сундар Пичаи (Sundar Pichai) и финансовый директор Рут Порат (Ruth Porat) отметили, что ИИ-инфраструктура Google и решения генеративного ИИ для облачных клиентов уже принесли холдингу «миллиарды» и используются более чем 2 млн разработчиков. По словам Рут, капитальные затраты Alphabet за II квартал в целом составили $13 млрд, при этом большая часть средств была инвестирована в технологическую инфраструктуру — в основном в серверы для ЦОД. Отвечая на вопрос аналитиков и инвесторов об оправданности столь больших инвестиций в инфраструктуру для ИИ, Пичаи ответил, что риск недостаточного инвестирования здесь значительно выше, чем риск чрезмерного инвестирования: «Даже в сценариях, когда окажется, что мы переинвестируем, нам ясно — это инфраструктура, которая нам очень полезна», — заверил аудиторию гендиректор Alphabet. В минувшем квартале Google представила шестое поколение ИИ-ускорителя Trillium, который, по словам Пичаи, «обеспечивает почти пятикратное увеличение пиковой производительности на чип, при этом он на 67 % энергоэффективнее TPU v5e». Пичаи также отметил, что ускорители NVIDIA Blackwell появятся в Google Cloud в начале 2025 года. Также в отчётном периоде Google заключила партнёрское соглашение с Oracle с целью совместного использования решения Google Cloud Cross-Cloud Interconnect, которое упростит клиентам запуск рабочих нагрузок общего назначения как в облаке Oracle, так и в облаке Google без платы за перенос из одного облака в другое. В сентябре компании планируют запустить проект Oracle Database@Google Cloud, в рамках которого Google разместит СУБД-инфраструкту в своих ЦОД.

25.07.2024 [16:41], Руслан Авдеев

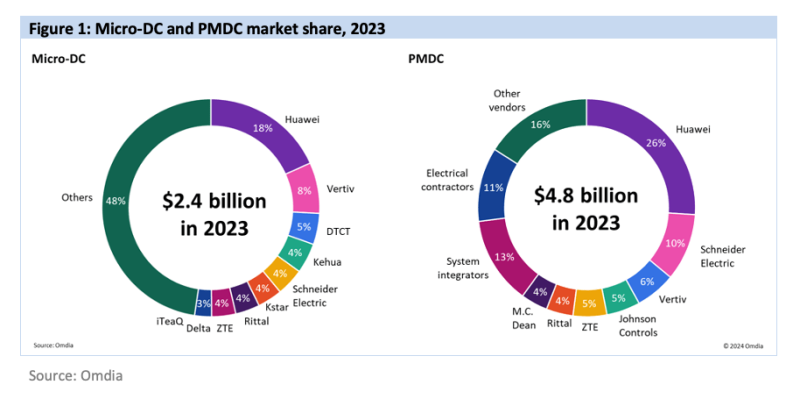

Omdia: спрос на готовые модульные дата-центры и микро-ЦОД вырос благодаря развитию рынка ИИИсследование компании Omdia показало, что рынок готовых модульных дата-центров (PMDC) и микро-ЦОД к 2027 году достигнет $11,7 млрд. По данным пресс-службы компании, пик спроса придется на 2023–2024 гг., причиной стремительного роста спроса станет бум ИИ-технологий. Рынок готовых, заранее собранных на производстве ЦОД включает как отдельные, так и многомодульные конструкции, которые могут выполнять как единичные функции (энергоснабжение, охлаждение), так и составлять ЦОД целиком. В Omdia рассчитывают, что в 2027 году объём продаж PMDC составит $8,6 млрд. Крупнейшей категорией считаются предсобранные модули питания, их сбыт растёт самыми быстрыми темпами — в сравнении со всеми другими модулями, продажи которых тоже отслеживаются Omdia. Основным фактором роста является то, что именно в таких модулях нуждаются как новые, так и действующие ЦОД, требующие увеличения энергетической ёмкости.

Источник изображения: Omdia Модульные микро-ЦОД (micro-DC) состоят или из одного или нескольких модулей, последние обычно поставляются уже в собранном состоянии. В Omdia прогнозируют, что их продажи составят в 2027 году $3,1 млрд. Такие объекты, по данным экспертов компании, подходят как облачным провайдерам, так и корпоративным клиентам. В Omdia утверждают, что подобные ЦОД на много стоек изначально использовались гиперскейлерами — предварительная сборка вдали от места установки ускоряла ввод в эксплуатацию на целевой территории. Подобные решения внедрялись как минимум с 2018 года. Лидером на рынке PMDC является Huawei, за ней следуют Schneider Electric и Veritiv. В Северной Америке крупнейшими вендорами подобных решений являются Johnson Controls, Schneider Electric и M.C. Dean, в Западной Европе — Vertiv и Rittal, а Huawei — в Азии и Океании, а также на рынке Европы, Ближнего Востока и Африки (EMEA) в целом. Что касается рынка модульных микро-ЦОД, он гораздо более насыщеннее вендорами благодаря довольно низкому порогу вхождения. Впрочем, из здесь лидирует Huawei, ненамного от которой отстают Vertiv и DTCT. В Omdia ожидают, что инновации в PMDC и micro-DC продолжатся. Акцент будет сделан на повышении энергетической плотности для того, чтобы обеспечить в новых ЦОД использование серверов с ресурсоёмким ИИ-оборудованием. В первую очередь ожидаются новые решения в сфере интеграции систем жидкостного охлаждения (СЖО) и аккумуляторов. В июне Omdia прогнозировала, что основной нагрузкой в ЦОД станут ИИ-приложения, которые подстегнут рост расходов на серверы. |

|