Материалы по тегу: hardware

|

05.08.2025 [17:01], Руслан Авдеев

ИИ-серверы победили электромобили — Foxconn сменит профиль предприятия в Лордстауне [Обновлено]Тайваньский контрактный производитель Foxconn продал в США завод по выпуску электромобилей. Вместо этого площадка будет использоваться для производства ИИ-серверов, сообщает The Register, и, возможно, получит ИИ ЦОД Stargate. В понедельник компания подала заявление о продаже завода в Лордстауне (Lordstown, Огайо), который Foxconn приобрела в 2022 году у стартапа Lordstown Motors. При этом компания сохранит своё присутствие на объекте и займётся другими видами деятельности. Сообщается, что завод был продан, поскольку североамериканский рынок электромобилей производитель посчитал слишком слабым — производственные мощности значительно превышают спрос. О переходе на выпуск ИИ-серверов сообщили несколько известных изданий, включая The Wall Street Journal и Nikkei. Новость появилась через несколько дней после объявления о заключении стратегического альянса с тайваньской TECO Electric & Machinery. Предполагается, что альянс поможет партнёрам развивать бизнес в сфере ИИ ЦОД. TECO выпускает энергетическую инфраструктуру, необходимую для строительства дата-центров, а Foxconn производит практически всё, что нужно их клиентам.

Источник изображения: Michael Bowman/unsplash.com Foxconn уже пообещала расширить присутствие в США, чтобы производить ИИ-оборудование для Apple и других локальных клиентов. Смена профиля завода в Лордстауне с электромобилей на ИИ-серверы поможет компании развивать более прибыльный бизнес. Впрочем, ранее компания обещала создать базовую платформу для электромобилей, чтобы иметь возможность получать заказы от автоконцернов. Будущее этого плана теперь под вопросом. Foxconn не впервые отказывается от масштабных проектов в США — ранее она не стала строить обещанный завод по выпуску ЖК-дисплеев в Висконсине, который сегодня не пользуется прежним спросом. Площадка досталась Microsoft, которая намеревелась построить ИИ ЦОД в интересах OpenAI, но потом отложила эту затею. Тем не менее, очередная смена профиля завода Foxconn вполне соответствует новому плану президента США, который решительно настроен добиться первенства США в сфере ИИ. В частности, иностранным компаниям, вложившимся в местное производство, обещаны скидки на пошлины. В минувший понедельник совет директоров Tesla объявил о выделении главе компании Илону Маску (Elon Musk) 96 млн акций стоимостью $29 млрд, поскольку «сохранение Илона сейчас важнее, чем когда-либо», т.к. компания переходит от «лидерства в сфере электромобилей и источников энергии к достижению лидерства в области ИИ, робототехники и связанных с ними услуг». Возможно, это будет означать, что Tesla также будет закупать ИИ-серверы у Foxconn или поручит тайваньской компании производить своих роботов. Сама Tesla отказалась от развития собственных ИИ-суперкомпьютеров Dojo. UPD 08.08.2025: по данным Bloomberg, покупателем завода станет SoftBank, которая, возможно, со временем развернёт тут же и дата-центр в рамках проекта Stargate. Сумма сделки составит $375 млн.

05.08.2025 [15:16], Владимир Мироненко

Великобритания не станет соревноваться с США и Китаем в гонке ИИ, а сосредоточится на его внедренииБритании не следует пытаться конкурировать с Америкой, Китаем и странами Персидского залива, которые вливают сотни миллиардов долларов в огромные, энергоёмкие ЦОД для обучения ИИ, поскольку для этого у неё нет ни достаточного количества денег, ни свободной земли, ни энергетических ресурсов, заявил Институт глобальных изменений Тони Блэра (Tony Blair Institute for Global Change, TBI), передаёт The Register. Вместо этого TBI предлагает сосредоточиться на широком внедрении ИИ, хотя и это потребует увеличения местных вычислительных мощностей. Великобритании необходимо «серьёзно относиться к инфраструктуре», чтобы оставаться конкурентоспособной в эпоху ИИ и решать системные проблемы, которые невозможно решить в одночасье, указала в отчёте TBI, добавив, что для этого строительство ЦОД должно стать национальным стратегическим приоритетом. Правительство должно сосредоточиться на развёртывании и широком внедрении ИИ, «демонстрируя миру, как эффективно применять его в таких секторах, как здравоохранение, образование, государственное управление, оборона и наука». Именно здесь будут экономические выгоды, способствующие повышению производительности, улучшению государственных услуг и стимулированию инноваций во всей экономике, утверждает TBI. Институт Тони Блэра назвал нынешнюю ситуацию «катастрофической», поскольку Великобритания поставила ИИ в центр своих целей роста и безопасности, но при этом не имеет достаточной инфраструктуры для их реализации. При нынешних темпах строительства ЦОД Великобритания, вероятно, не достигнет целевого показателя к 2030 году — 6 ГВт ИИ-мощностей. Этому препятствуют задержки в планировании и выдаче разрешений, ограничения национальной энергосети и стремительный рост цен на промышленную электроэнергию. Опасения института подтверждает отчёт fDi Intelligence (подразделение Financial Times), в котором утверждается, что Великобритания может столкнуться к 2030 году с дефицитом необходимых вычислительных мощностей ЦОД до 5 ГВт. Отчёт основан на анализе, проведённом по заказу Министерства науки, инноваций и технологий (DSIT) Великобритании. Согласно документу, предложение ЦОД почти удвоится с нынешних 1,8 ГВт мощностей до 3,3 ГВт, в то время как ожидаемый спрос составит от 5,1 ГВт до 8,5 ГВт. TBI также отметил, что большая часть вычислительных мощностей сосредоточена вокруг Лондона и не оптимизирована для ИИ. Институт рекомендует правительству следовать стратегии «ускоренной диверсификации», что означает быстрое создание устойчивой инфраструктуры, для чего необходимо внести изменения в законодательство для привлечения новых инвестиций, а также распределить вычислительные мощности по регионам для повышения устойчивости и поддержания сильной внутренней экосистемы. Кроме того, Национальный оператор энергетической системы (NESO) обязан учесть спрос на ЦОД (по оценкам DSIT) в национальных планах и поддерживал их «динамические обновления». Институт отметил, что Совет по энергетике ИИ (AI Energy Council), сформированный в прошлом году, было поручено решение этих задач, но он действует в условиях традиционной для британского правительства атмосферы секретности. Поэтому рекомендуется вместо этой структуры сформировать в рамках NESO группу экспертов по ИИ и ЦОД для поддержки планирования спроса и ускорения интеграции ИИ в энергосистему. Также предлагается ускорить процесс планирования, чтобы решения принимались в течение восьми месяцев, и использовать полномочия министерских комиссий для проектов ЦОД и энергетики. Как сообщает The Register, правительство уже приступило к реализации этих предложений, присвоив ЦОД статус критически важной национальной инфраструктуры (CNI). Присвоение им статуса инфраструктурных проектов национального значения (NSIP) позволяет обращаться в центральную Инспекцию по планированию (PINS) за разрешением на строительство, минуя местные органы власти. Рекомендации также включают создание серии гигаваттных АЭС и реформирование регулирования атомной энергетики для ускорения строительства и снижения затрат. Заодно предложены и шаги, аналогичные тем, что были сделаны в США: разрешение размещать ИИ ЦОД рядом с источниками энергии, выделение государственных земель для строительства ЦОД и электростанций, сотрудничество с частным девелоперами. Вместе с тем The Register говорит об опасениях, что все эти инвестиции в ИИ могут оказаться просто раздуванием пузыря. В отчёте McKinsey & Company сообщается о беспокойстве инвесторов по этому поводу, поскольку никто точно не знает, каким будет уровень спроса на ИИ в будущем. В то же время другие исследования показали, что генеративный ИИ до сих пор не оказал существенного влияния на заработки или количество отработанных часов ни в одной из профессий, несмотря на уже потраченные миллиарды долларов на создание и обучение ИИ-моделей. Точность агентского ИИ недавно оказалась в центре внимания общественности, когда Gartner опубликовал прогноз, согласно которому к концу 2027 года 40 % ИИ-проектов будут закрыты из-за роста затрат, неясной ценности для бизнеса или недостаточного контроля рисков.

05.08.2025 [15:13], Руслан Авдеев

Meta✴ продаст часть своих строящихся ЦОД на $2 млрдMeta✴ намерена продать часть своего портфолио дата-центров, находящихся в стадии строительства. В отчёте американскому регулятору SEC сообщается, что в начале июня 2025 года компания одобрила план по продаже ряда активов ЦОД на сумму $2,04 млрд, сообщает Datacenter Dynamics. По словам представителей Meta✴, в основном активы состоят из незавершённых объектов и земельных участков. Они отражаются в отчётности по наименьшей из двух величин: балансовой стоимости или справедливой стоимости за вычетом затрат на продажу. По некоторым данным, это стандартный подход для случаев, когда есть признаки обесценения активов. Компания объявила, что активы должны быть реализованы в следующие 12 месяцев с передачей их третьей стороне для совместного строительства. Подробностей о том, какие именно ЦОД Meta✴ намерена продать, не раскрыто, как и информации о потенциальных покупателях. После продажи и завершения строительства площадки, возможно, будут сданы в аренду. На 30 июня 2025 года стоимость всех активов Meta✴, предназначенных для продажи, составляла $3,26 млрд.

Источник изображения: Glenov Brankovic/unsplash.com На сегодняшний день Meta✴ располагает около 30 действующих и строящихся ЦОД по всему миру, большая часть из которых расположена в США. В то же время компания является крупным арендатором. В конце 2022 года она приостановила строительство порядка дюжины ЦОД для пересмотра проектов, чтобы оптимизировать их под новейшие ускорители и системы жидкостного охлаждения. С тех пор компания возобновила строительство в соответствии с обновлёнными требованиями. Ранее глава компании Марк Цукерберг (Mark Zuckerberg) объявил, что Meta✴ намерена потратить «сотни миллиардов долларов» на ИИ-инфраструктуру ЦОД, а также создать новое подразделение для разработки «суперинтеллекта». По его словам, строится несколько кластеров мощностью несколько гигаватт каждый. В июне появилась информация, что компания ведёт переговоры с Apollo Global Management, KKR, Brookfield, Carlyle и Pimco о заключении сделки на $29 млрд по финансированию строительства ЦОД. Недавно представитель компании заявила, что Meta✴ намерена самостоятельно финансировать большую часть масштабирования своего бизнеса, но также изучает варианты сотрудничества с партнёрами для совместного строительства ЦОД.

05.08.2025 [12:11], Руслан Авдеев

Hyundai поможет Fermi America построить в Техасе «ядерный» ЦОД HyperGridЯдерная энергетика в США переживает своеобразное возрождение — гиперскейлеры и компании поменьше столкнулись с ненасытными аппетитами ИИ. На этом фоне Fermi America выбрала южнокорейскую Hyundai для поддержки развёртывания до 6 ГВт ядерных мощностей в рамках проекта HyperGHrid в Амарилло (Amarillo, Техас), сообщает The Register. Проект строительства «крупнейшего в мире энергетического кампуса» поддержан политиками и инвесторами. Его цель — превратить Техас в крупнейший энергетический и вычислительный центр США. Строительство в Амарилло первого из четырёх реакторов Westinghouse AP1000 планируется начать в 2026 году. Согласно меморандуму, к 2032 году АЭС будет снабжать электричеством ЦОД напрямую. Пока нет гарантий, что проект площадью 2,3 тыс. га действительно будет реализован полностью, но курировать его в любом случае будет Hyundai. Компания хорошо разбирается в атомной энергетике и уже участвовала в развёртывании 22 реакторов. Проект будет довольно дорогим. Один реактор AP1000 оценивался два года назад в $6,8 млрд. Впрочем, с масштабами проектов гиперскейлеров и облачных гигантов это несопоставимо — они ежегодно тратят десятки миллиардов долларов. Правда, строительство может оказаться не таким уж дешёвым и быстрым. Например, на строительство двух аналогичных реакторов в Джорджии ушло 15 лет и более $36 млрд. Конечно, ситуацию не улучшило и банкротство Westinghouse в 2017 году, в самый разгар строительства.

Источник изображения: Gabriel Tovar/unsplash.com Как именно Fermi America намерена оплатить строительство хотя бы одного реактора AP1000, не говорится. Известно, что Hyundai также поддержит развертывание газовых электростанций с парогазовым циклом мощностью 4 ГВт, 1 ГВт солнечных электростанций и накопителей, а также малых модульных реакторов (SMR) на 2 ГВт. Кто именно будет поставщиком SMR, пока не сообщается. На данный момент только NuScale ближе всех к запуску своего первого SMR. Пока Fermi America и Hyundai решают вопросы с регуляторами относительно ядерного проекта, строительство «газовой» части 11-ГВт мегапроекта уже началось. В июле Fermi America сообщила о намерении купить газогенераторы мощностью 600 МВт для поддержки первых дата-центров, которые должны быть запущены до конца текущего года. Речь идёт о шести газовых турбинах Siemens Energy SGT800, и одной паровой турбине SST600, которые в совокупности обеспечат 478 МВт. Также Fermi America объявила о покупке «восстановленных» турбин GE Frame 6B мощностью 135 МВт. По словам компании, новые генераторы на треть «чище» традиционных, а использование специальных каталитических систем дополнительно сократит выбросы. К концу 2026 года Fermi America намерена довести генерацию до 1 ГВт. Впрочем, это далеко не первая компания, предложившая концепцию «атомных» ЦОД. За последние годы появилось множество подобных инициатив. Ещё в 2023 году Green Energy Partners представила концепцию строительства огромного ЦОД в Вирджинии, полностью работающего на SMR и водородных генераторах. Не так давно Amazon потратила $650 млн, чтобы приобрести объекты Cumulus Data у АЭС Susquehanna. Microsoft намерена возродить АЭС Three Mile Island, Мета✴ выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд, а Oracle заявлила о намерении развернуть три SMR общей мощностью более 1 ГВт.

05.08.2025 [11:28], Владимир Мироненко

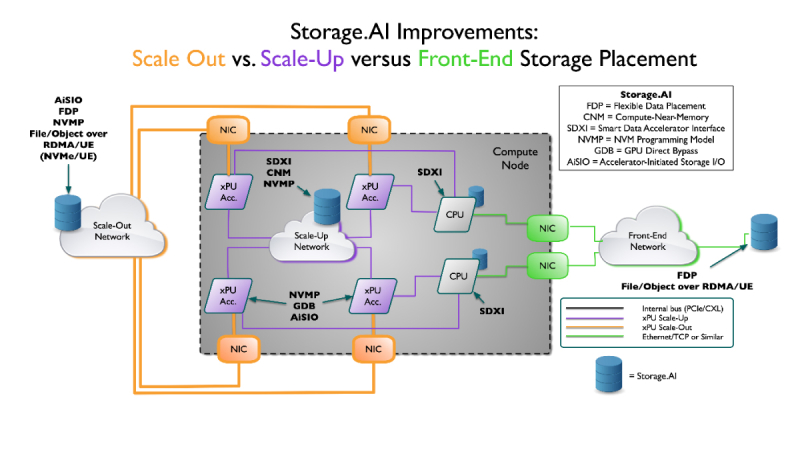

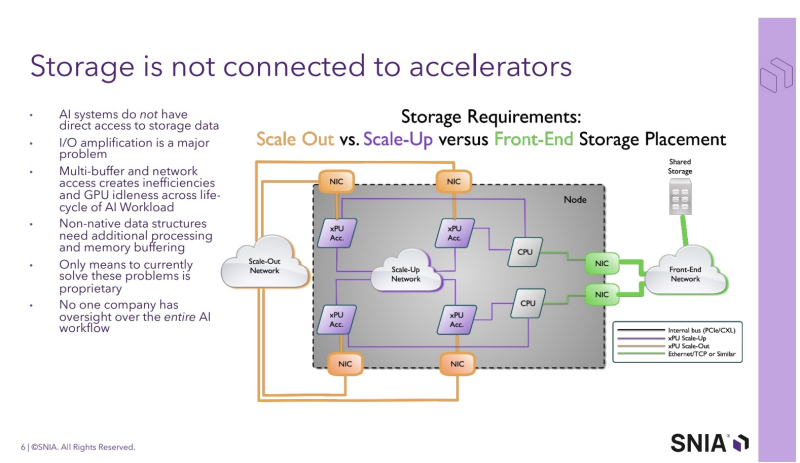

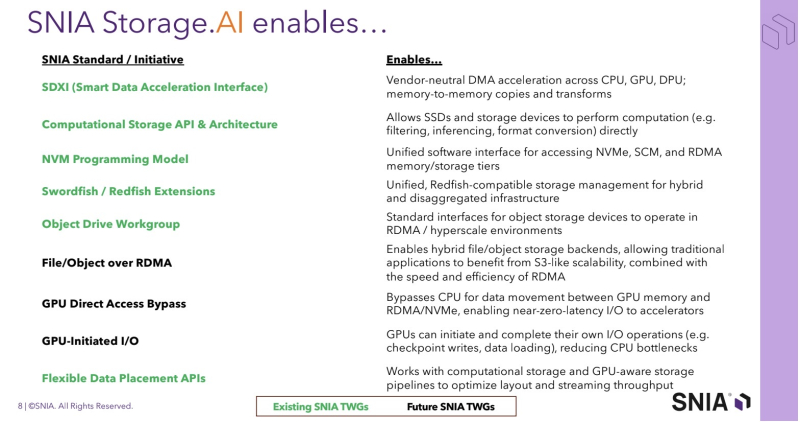

SNIA анонсировала проект Storage.AI для стандартизации обработки ИИ-нагрузокStorage Networking Industry Association (SNIA) — некоммерческая организация, специализирующаяся на технологиях обработки и оптимизации данных — анонсировала проект Storage.AI, основанный на открытых стандартах для эффективных сервисов обработки данных, связанных с рабочими ИИ-нагрузками. Проект будет сфокусирован на стандартных для отрасли, непатентованных и нейтральных подходах к решению задач, связанных с обработкой данных для ИИ, с целью оптимизации производительности, энергоэффективности и экономичности соответствующих рабочих процессов. К инициативе уже присоединились AMD, Cisco, DDN, Dell, IBM, Intel, KIOXIA, Microchip, Micron, NetApp, Pure Storage, Samsung, Seagate, Solidigm и WEKA. Отдельно отмечается отсутствие NVIDIA — крупнейшего поставщика ИИ-ускорителей. Как указано в пресс-релизе, рабочие ИИ-нагрузки чрезвычайно сложны и ограничены такими факторами, как задержки, доступное пространство, энергопотребление и охлаждение, объём памяти и стоимость. Решение этих проблем в рамках открытой отраслевой инициативы рассматривается как наиболее быстрый путь к оптимизации и широкому внедрению ИИ. По словам Дж. Метца (J Metz), председателя SNIA, беспрецедентные требования со стороны ИИ требуют целостного взгляда на весь конвейер данных — от храненилищ и памяти до сетевых технологий и вычислений. Он подчеркнул, что Storage.AI предоставляет отраслевому сообществу независимую от вендоров платформу, предназначенную для координации широкого спектра сервисов обработки данных и создания эффективных, открытых решений, необходимых для ускоренного внедрения ИИ-технологий. Инициатива координирует ряд технических спецификаций, которые до сих пор существовали обособленно и не были адаптированы под нужды ИИ-нагрузок. Первоначальный набор спецификаций включает:

Предполагается, что в рамках проекта Storage.AI будет создана открытая экосистема эффективных сервисов обработки данных, способных справляться с наиболее сложными задачами, связанными с ИИ-нагрузками, и устранять текущие пробелы в обработке и доступе к данным. В обеспечении широкой поддержки экосистемы также примут участие партнёры SNIA, включая UEC, NVM Express, OCP, OFA, DMTF и SPEC.

05.08.2025 [11:16], Сергей Карасёв

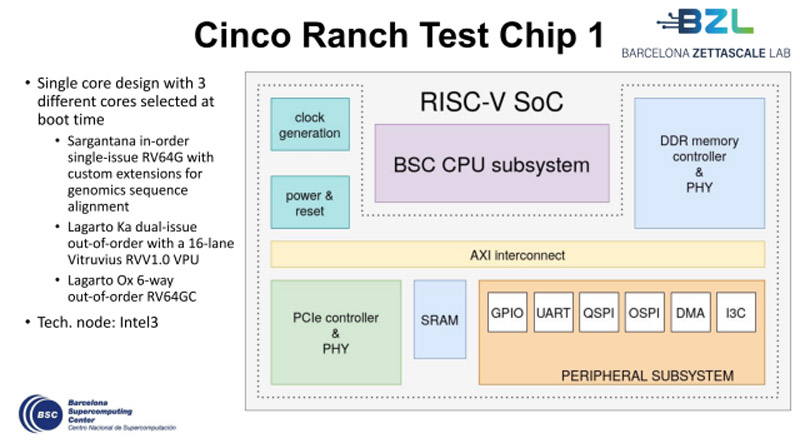

Европейские чипы Cinco Ranch на базе RISC-V близки к началу массового производстваУчастники проекта Barcelona Zettascale Laboratory (BZL), координируемого Барселонским суперкомпьютерным центром (BSC) в Испании, по сообщению ресурса EETimes, достигли фазы Tape-out в рамках разработки европейских процессоров Cinco Ranch на открытой архитектуре RISC-V. Tape-out — это финальная стадия проектирования интегральных схем или печатных плат перед их отправкой в производство. Данный процесс предполагает перенос цифрового макета чипа на фотошаблон для последующего изготовления. Производством изделий займётся предприятие Intel Foundry с применением техпроцесса Intel 3. Cinco Ranch представляет собой пятое поколение чипов серии Lagarto. По сути, это «система на кристалле» (SoC) промышленного класса с высокой энергетической эффективностью. Конструкция чипа включает три отдельных специализированных ядра, каждое из которых оптимизировано под определённые вычислительные задачи. В частности, присутствует ядро Sargantana (RV64G) с однопоточным выполнением инструкций по порядку. Кроме того, имеется двухпоточное ядро Lagarto Ka с внеочередным исполнением машинных инструкций. Довершает картину высокопроизводительное 6-поточное ядро Lagarto Ox (RV64GC) с внеочередным исполнением инструкций. Нужное ядро выбирается в момент загрузки системы.

Источник изображения: BSC Решение Cinco Ranch содержит 16-канальный векторный блок Vitruvius++ VPU и трёхуровневую систему кеша. Реализована поддержка памяти DDR5 и интерфейса PCIe 3.0. Площадь чипа составляет 16 мм2. Главной целью проекта BZL является разработка суверенных суперкомпьютерных технологий в Европе. Предполагается, что создаваемые чипы найдут применение в различных областях, включая НРС-платформы, автономные транспортные средства, системы ИИ и пр. После всестороннего тестирования чипов Cinco Ranch будет освоено их массовое производство.

04.08.2025 [16:21], Руслан Авдеев

AEP увеличит мощности подключений ЦОД на 18 ГВт к 2029 году — Exelon, PPL и PG&E прогнозируют ещё десяткиКлючевая для США коммунальная группа American Electric Power (AEP) сообщила о планах увеличить электрические мощности для ЦОД на 18 ГВт к 2029 году. Не менее впечатляющие цифры обнародовали и некоторые другие коммунальные компании США, а некоторые даже превзошли AEP, сообщает Datacenter Dynamics. В финансовом отчёте AEP за II квартал говорится о росте операционной прибыли на акцию, что в первую очередь обусловлено увеличением числа подключаемых дата-центров. Именно на их долю придётся наибольшая часть новой нагрузки из 24 ГВт, прогнозируемой к концу десятилетия. Благодаря развитию рынка ЦОД объём проектов в очереди на подключение к сети вырос до 190 ГВт, что привело к увеличению пятилетнего инвестиционного плана на 30 % — до $70 млрд. Средства распределены на развитие передачи электроэнергии (50 %), генерации (40 %) и распределительных сетей (10 %). Сообщается, что на все 24 ГВт уже подписаны будущие соглашения, что защищает от возможных колебаний спроса.

Источник изображения: Randy Laybourne/unsplash.com Энергокомпания зафиксировала рост пикового спроса на электроэнергию более чем на 4 ГВт по сравнению с прошлым годом. Основная причина — ввод в эксплуатацию новых ЦОД в Индиане, Огайо и Техасе. По словам руководства компании, район её ответственности чрезвычайно привлекателен для операторов ЦОД: здесь есть достаточное количество оптоволоконных соединений, доступ к воде и крупнейшая в стране ЛЭП, включая магистральную сеть на 765 кВ. Впрочем, в компании признают, что в сфере ЦОД остаётся немало нерешённых задач. Приоритет AEP — предложение инновационных решений. Особо отмечено соглашение с AWS и Cologix о поставке электроэнергии с помощью твёрдооксидных топливных элементов Bloom Energy. В прошлом году AEP Ohio подписала с Bloom соглашение о поставке до 1 ГВт для ЦОД. Также подчёркивается важность нового законодательства для ЦОД. Недавно регуляторы в Огайо утвердили нормы, согласно которым новые дата-центры должны будут оплачивать не менее 85 % заявленной ежемесячной потребности в энергии, даже если фактическое потребление окажется меньше, — для покрытия расходов на инфраструктуру. Тем временем Exelon объявила, что в очереди на подключение к её сетям находятся ЦОД общей мощностью 33 ГВт. Компания обслуживает более 10 млн клиентов в Делавэре, Иллинойсе, Мэриленде, Нью-Джерси, Пенсильвании и Вашингтоне, контролируя шесть коммунальных предприятий. Из этих 33 ГВт 17 ГВт уже находятся в очереди на подключение, а ещё 16 ГВт, вероятно, будут официально добавлены в этом году. От общего объёма 10 % должны быть подключены к 2028 году, ещё треть — к 2030-му и 75 % — к 2034-му. Для удовлетворения спроса владелец сетей даже рассматривает возможность строительства собственных электростанций. Правда, в нескольких штатах такая практика запрещена по антимонопольным соображениям, но законы могут пересмотреть на фоне энергодефицита. В целом финансовые показатели компании заметно различаются по штатам.

Источник изображения: Miguel Bruna/unsplash.com Также появились данные о показателях за II квартал крупнейшей в Калифорнии коммунальной компании Pacific Gas and Electric Company (PG&E). Сейчас в очереди на подключение к её сетям находятся ЦОД суммарной мощностью 10 ГВт, которые должны быть подключены в течение ближайших десяти лет. Ещё в мае речь шла о 8,7 ГВт, а в феврале — о 5,5 ГВт. Из этих 10 ГВт 17 проектов дата-центров суммарной мощностью 1,5 ГВт находятся в завершающей стадии проектирования. Их ввод в эксплуатацию намечен на 2026–2030 гг. Большинство объектов расположено в Кремниевой долине. Предполагается, что подключения благоприятно скажутся на стоимости электричества для налогоплательщиков, обеспечив экономию на уровне 1–2 % в месяц. Кроме того, рост спроса позволит активнее использовать энергетическую инфраструктуру: по данным PG&E, в зоне ответственности компании она задействована лишь на 45 %. При этом компания сможет получать за это больше дохода. Однако, несмотря на прогресс в подключении ЦОД, финансовые показатели PG&E во II квартале оказались слабыми: операционные и эксплуатационные расходы выросли на 3,7 %. Ранее компанию обвиняли в причастности к пожарам из-за неудовлетворительного обслуживания сетей, что вынудило увеличить расходы. В прошлом году компания объявила о планах построить три ЦОД в Сан-Хосе (San Jose) общей мощностью 200 МВт. Проект реализуется совместно с Westbank. В прошлом месяце PG&E подписала первое в своём роде соглашение с Сан-Хосе об оптимизации и гарантиях поставок энергии для дата-центров и других крупных клиентов. Также недавно компания заключила соглашение с бизнесом Smart Wires о проекте по повышению надёжности сети и поддержке роста энергопотребления ЦОД в Сан-Хосе. Наконец, PPL Electric, которая в основном обслуживает Пенсильванию, объявила, что запросы со стороны ЦОД вырастут с 800 МВт в 2026 году до 14,4 ГВт в 2034-м. Часть проектов общей мощностью 5 ГВт уже были публично анонсированы. Среди них гигантский ИИ ЦОД AWS стоимостью $20 млрд, а также целый ряд других объектов поменьше. В конце 2024 года сообщалось, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны.

04.08.2025 [16:08], Руслан Авдеев

CoreWeave заняла ещё $2,6 млрд для масштабирования ИИ-проектов OpenAICoreWeave закрыла сделку по получению отложенного кредита (DDTL 3.0) на сумму $2,6 млрд. Средства будут потрачены на покупку и обслуживание современного оборудования и элементов облачной инфраструктуры для предоставления услуг в рамках долгосрочного соглашения с OpenAI, сообщает Datacenter Dynamics. Раунд финансирования возглавили Morgan Stanley и MUFG, в качестве организатора выступила Goldman Sachs. В сделке также приняли участие JPMorgan Chase, Wells Fargo, BBVA, Crédit Agricole, SMBC, PNC и Société Générale. В CoreWeave подчеркнули, что гордятся сотрудничеством с ведущими финансовыми учреждениями на пути масштабирования узкоспециализированной облачной ИИ-платформы для удовлетворения потребностей клиентов-инноваторов. В OpenAI отметили, что CoreWeave является важным партнёром для комплексной инфраструктуры компании. Масштабирование ИИ-проектов требует вычислительных ресурсов мирового уровня, а партнёрство с CoreWeave и ведущими финансовыми учреждениями даёт возможность обучать более эффективные ИИ-модели и предоставлять более качественные услуги. В мае 2025 года CoreWeave подписала с OpenAI новый контракт на $4 млрд, дополнив предыдущее соглашение на $11,9 млрд. Также сообщается, что CoreWeave предоставит часть вычислительных мощностей для сделки OpenAI и Google.

Источник изображения: CoreWeave Кредит DDTL 3.0 предоставлен CoreWeave под плавающую ставку SOFR + 4 % (SOFR — базовая ставка ФРС) и должен быть погашен к 21 августа 2030 года. Залогом выступают практически все активы дочерней компании CoreWeave Compute Acquisition Co. VII, LLC. Новый раунд финансирования состоялся после закрытия 28 июля продажи облигаций на $1,75 млрд. Первоначально планировалось привлечь $1,5 млрд, однако сумма была увеличена. Средства будут направлены на общие корпоративные цели, включая погашение долгов и покрытие сопутствующих расходов. Это уже третий крупный раунд финансирования в 2025 году после майского привлечения $2 млрд. По данным CoreWeave, за последние 18 месяцев компания привлекла более $25 млрд как за счёт акционерного капитала, так и за счёт заёмных средств. Это превысило план в $21 млрд, озвученный в мае 2025 года. Дополнительно стало известно, что CoreWeave заключила соглашение с Applied Digital об аренде ЦОД мощностью 150 МВт, дополнив июньское соглашение с той же компанией на 250 МВт. Совокупная выручка Applied Digital составит $11 млрд за 15 лет. Кроме того, CoreWeave приобрела дата-центр Northeast Science & Technology Center (NEST) за $322 млн в Кенилворте (Нью-Джерси). Площадь кампуса составляет более 43 га, продавцами выступили Machine Investment Group и Onyx Equities. CoreWeave арендовала здание № 11 в кампусе ещё в октябре 2024 года, планируя превратить лабораторный и промышленный корпус площадью 26 тыс. м² в ЦОД, инвестировав $1,2 млрд. Ещё $50 млн на модернизацию должны были вложить предыдущие владельцы. Теперь компания приобрела весь кампус «смешанного назначения» площадью 185 тыс. м², включающий офисные здания, подстанцию на 50 МВт, котельную и другие помещения. В 2023 год нынешние владельцы купили кампус за $187,5 млн, но не преуспели в его использовании. В последнее время CoreWeave стремится получить управляемые ей ЦОД в собственность — в июле она сообщила о покупке компании Core Scientific за $9 млрд, у которой сейчас арендет ЦОД на 840 ГВт.

04.08.2025 [14:17], Владимир Мироненко

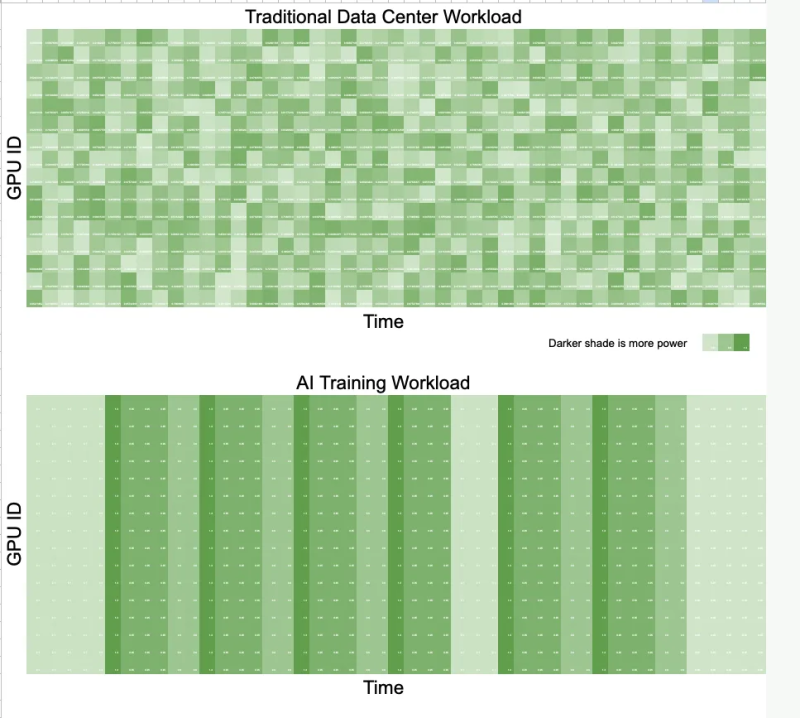

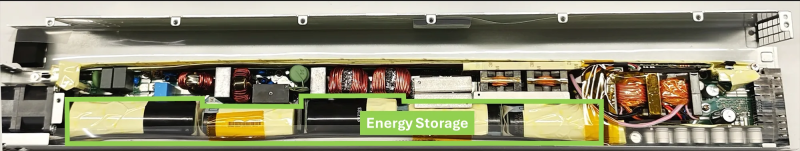

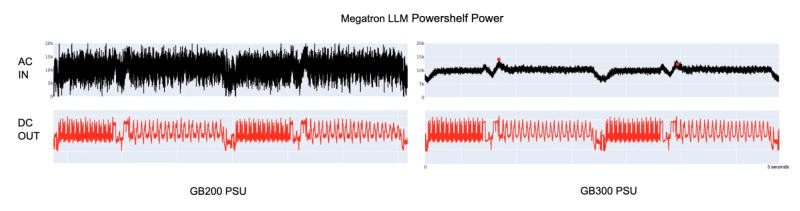

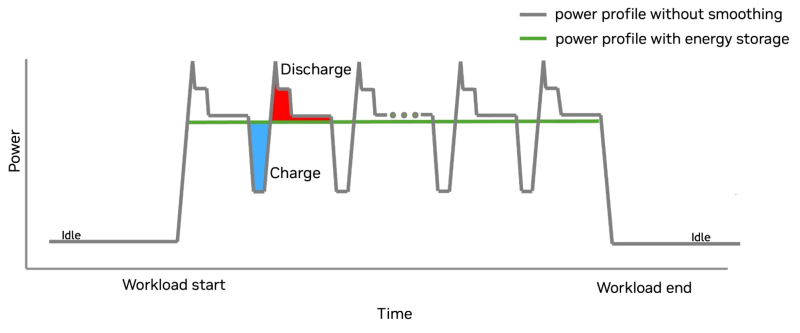

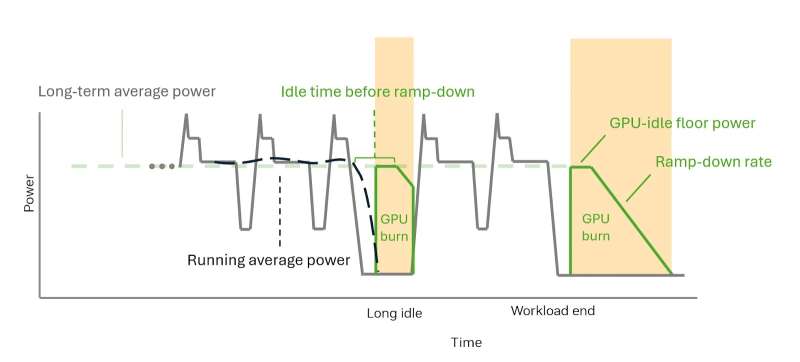

Суперускоритель с «батарейкой» — NVIDIA GB300 NVL72 получили особые блоки питания для сглаживания энергопотребленияNVIDIA представила решение для платформы GB300 NVL72, которое позволяет смягчать колебания напряжения, вызванные синхронной работой тысяч ускорителей (GPU) при работе ИИ-систем, и снижать пиковую нагрузку на сеть до 30 %. Подобные колебания крайне негативно влияют на энергосеть и других потребителей. Новое решение NVIDIA также будет использоваться в системах GB200 NVL72. В процессе обучения ИИ-моделей тысячи ускорителей работают синхронно и выполняют одни и те же вычисления с разными данными. Эта синхронизация приводит к колебаниям мощности на уровне сети — падению напряжения или появлению излишков энергии при внезапных простоях, в отличие от традиционных рабочих нагрузок ЦОД, где ускорители работают асинхронно и некоррелированные задачи «сглаживают» нагрузку. Meta✴ даже пришлось в качестве временной меры добавить в PyTorch опцию PYTORCH_NO_POWERPLANT_BLOWUP, которая загружает ускорители бессмысленной работой в моменты простоя. Для решения этой проблемы компания оснастила NVIDIA GB300 блоком питания с конденсаторами, т.е. накопителями энергии, разработанными с привлечением компании LITEON Technology, а также необходимым аппаратным и программным обеспечением. На разных этапах работы системы используется несколько механизмов, включая ограничение мощности, накопление энергии и «сжигание» энергии — функция NVIDIA GPU Burn. Электролитические конденсаторы обеспечивают равномерное энергопотребление непосредственно в стойке. Они занимают почти половину объёма БП и обеспечивают накопление 65 джоулей энергии на каждый ускоритель. Накопитель (конденсатор) заряжается при низком потреблении энергии ускорителем и разряжается при высоком. Этот своего рода буфер помогает снизить колебания энергопотребления, что продемонстрировано в сравнительных тестах GB200 и GB300 при одинаковой нагрузке. GB300 снижает пиковую нагрузку на сеть на 30 %, обеспечивая при этом аналогичную мощность для ускорителей. GB300 ограничивает скачки, пошагово увеличивая энергопотребление ускорителя. Ограничение по мощности увеличивается постепенно, в соответствии с возможностями сети. По завершении задания, программный драйвер, реализующий алгоритм сглаживания энергопотребления, активирует аппаратное снижение энергопотребления. Ускоритель продолжает потреблять постоянную мощность благодаря функции NVIDIA GPU Burn, ожидая возобновления нагрузки. Если нагрузка не возобновляется, ускоритель плавно снижает энергопотребление. Если нагрузка на ускоритель возобновляется, функция NVIDIA GPU Burn мгновенно отключается. После завершения нагрузки ускоритель с помощью NVIDIA GPU Burn постепенно снижает энергопотребление со скоростью, соответствующей возможностям сети, а затем отключается. Эти параметры контролируются такими настройками, как минимальное энергопотребление в режиме ожидания и время постепенного снижения нагрузки, которые можно настроить с помощью NVIDIA SMI или Redfish. Такой полный контроль энергопотребления снижает нагрузку на электросеть и делает планирование заданий более предсказуемым. Как отметил ресурс The Futurum Group, благодаря предложенной NVIDIA схеме питания ЦОД больше не нужно строить с учётом пиковых потребностей в мощности. Вместо этого их можно масштабировать ближе к средним показателям использования, что означает возможность размещения большего количества оборудования в том же пространстве или снижение общих затрат на электроэнергию. Суперконденсаторы в качестве энергетического буфера для всего объекта целиком предлагает Siemens, хотя уже есть и более компактные решения размером со стойку. Кроме того, поскольку сглаживание потребления мощности ограничено стойкой без её подачи обратно в сеть, операторы получают больше контроля над энергопотреблением. Такое сочетание аппаратного и программного обеспечения обеспечивает масштабируемость и делает ЦОД дружественными к энергосети, независимо от того, используют ли они системы GB200 или GB300 NVL72. Как отметил ресурс ServeTheHome, использование дополнительных аккумулирующих модулей в стойке, предложенное LITEON, также поможет более равномерному распределению нагрузки между крупными ИИ-кластерами. Сантьяго Грихальва (Santiago Grijalva), профессор электротехники и вычислительной техники в Технологическом институте Джорджии, назвал новую технологию «довольно серьёзным событием», учитывая доминирующую роль NVIDIA в этой области. «Но это решение ограничено высококлассными системами NVIDIA, — указал он в электронном письме ресурсу Utility Dive. — Это решение конкурирует с решениями Tesla и аппаратными оптимизациями Meta✴, предлагая существенное, но не революционное усовершенствование существующих методов управления питанием».

04.08.2025 [12:39], Руслан Авдеев

Meta✴ начала пилотный проект по использованию древесины для строительства дата-центровКомпания Meta✴ начала использовать массив древесины при строительстве собственных кампусов ЦОД. IT-гигант запустил пилотный проект в начале текущего года, стремясь заменить сталь и другие строительные материалы продукцией на основе деревянных элементов, разработанных с учётом требований к прочности и долговечности, сообщает Datacenter Dynamics. Meta✴ готовится активно внедрять древесину во всех своих ЦОД и уже сообщила, что планирует применять её при строительстве административных зданий, складов и даже критически важных машинных залов. По данным Meta✴, такое деревянное сырьё предназначено для промышленного применения, в том числе в ЦОД. Речь идёт о клеёном брусе, деревянных балках и колоннах, фанере и конструкциях для стен. В текущем году Meta✴ построила первое административное здание из массива древесины на территории своего кампуса в Эйкене (Aiken, Южная Каролина) совместно с компаниями DPR и SmartLam. В 2025 году компания намерена начать возводить другие здания из массива древесины на территории объекта в Шайенне (Cheyenne, Вайоминг) вместе с Fortis Construction и Mercer Mass Timber. Кроме того, использовать природные материалы планируется в Монтгомери (Montgomery, Алабама) в сотрудничестве с Hensel Phelps и Binderholz.

Источник изображения: Meta✴ Использование таких материалов может существенно улучшить экологические показатели ЦОД, снизив «углеродную ёмкость» строительства. В Meta✴ отмечают, что применение массива древесины позволит сократить содержание «воплощённого углерода» примерно на 41 % по сравнению с материалами, которые она заменяет. Кроме того, большинство деревянных изделий применяется в быстровозводимых сборных зданиях, что значительно уменьшает потребность в сварке стали на месте и позволяет сократить сроки строительства на несколько недель. Материалы обладают огнестойкостью благодаря специальному углеродному слою. Для обеспечения экологической устойчивости Meta✴ требует проведения независимых аудитов, подтверждающих ответственное происхождение и переработку древесины, а также возможность отслеживания её происхождения, что способствует сохранению окружающей среды. Компания заявила, что новые решения тесно связаны с её усилиями по устойчивому использованию лесных ресурсов. Так, в прошлом году она подписала соглашение с BTG Pactual Timberland Investment Group о сокращении выбросов углерода в рамках лесовосстановительных проектов на 1,3 млн т углеродных кредитов в Латинской Америке. Meta✴ не первой применила массив древесины для строительства своих дата-центров. В октябре о строительстве двух ЦОД в Северной Вирджинии, частично с использованием клееной древесины (CLT), объявила Microsoft. Она заявила, что это позволит сократить углеродный след дата-центров приблизительно на 35 %. Древесину использует и шведский застройщик EcoDataCenter. Кроме того, в начале 2025 года немецкая Prior1, занимающаяся дата-центрами, объявила о запуске сборного деревянного модуля ЦОД, в котором достаточно места для размещения пяти стоек, системы непрямого охлаждения на основе пропана на 14 кВт и ИБП на 15 кВА. |

|