Материалы по тегу: hardware

|

04.08.2025 [14:17], Владимир Мироненко

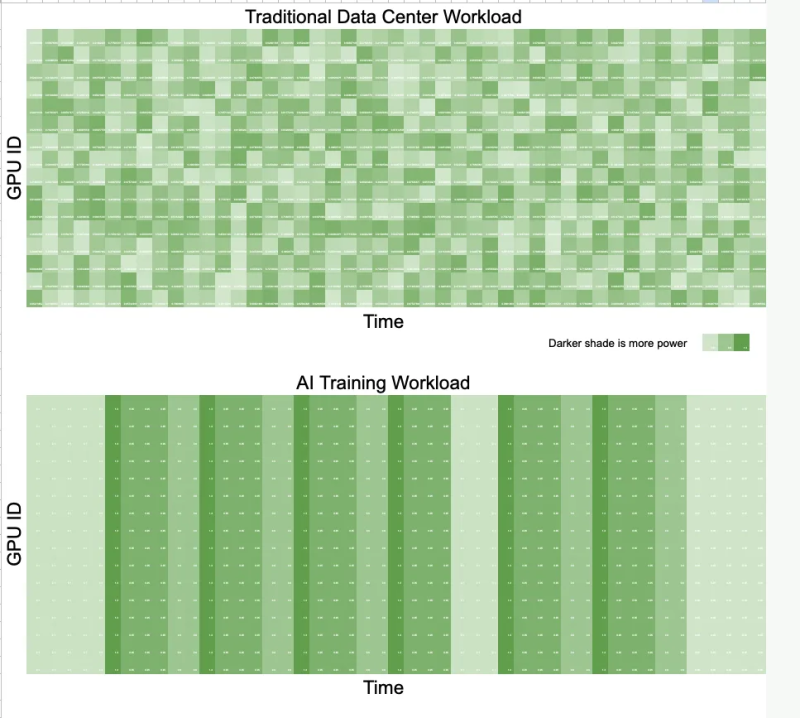

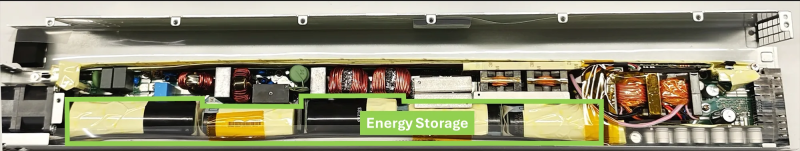

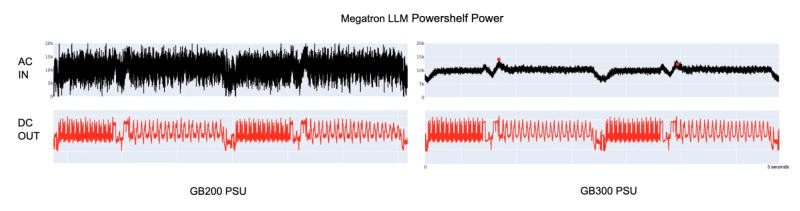

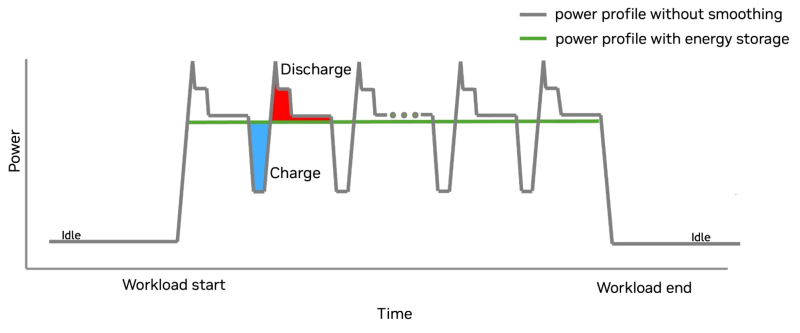

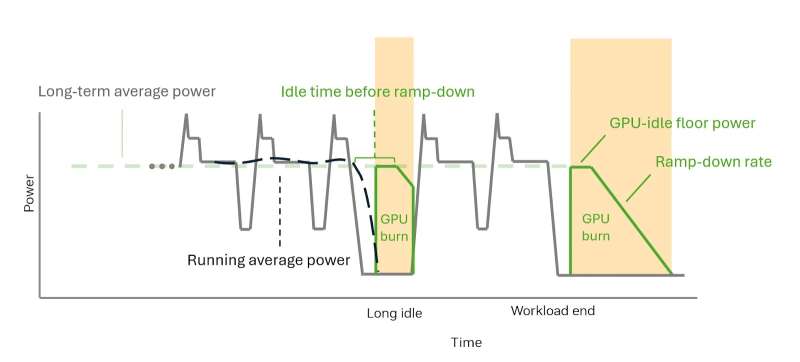

Суперускоритель с «батарейкой» — NVIDIA GB300 NVL72 получили особые блоки питания для сглаживания энергопотребленияNVIDIA представила решение для платформы GB300 NVL72, которое позволяет смягчать колебания напряжения, вызванные синхронной работой тысяч ускорителей (GPU) при работе ИИ-систем, и снижать пиковую нагрузку на сеть до 30 %. Подобные колебания крайне негативно влияют на энергосеть и других потребителей. Новое решение NVIDIA также будет использоваться в системах GB200 NVL72. В процессе обучения ИИ-моделей тысячи ускорителей работают синхронно и выполняют одни и те же вычисления с разными данными. Эта синхронизация приводит к колебаниям мощности на уровне сети — падению напряжения или появлению излишков энергии при внезапных простоях, в отличие от традиционных рабочих нагрузок ЦОД, где ускорители работают асинхронно и некоррелированные задачи «сглаживают» нагрузку. Meta✴ даже пришлось в качестве временной меры добавить в PyTorch опцию PYTORCH_NO_POWERPLANT_BLOWUP, которая загружает ускорители бессмысленной работой в моменты простоя. Для решения этой проблемы компания оснастила NVIDIA GB300 блоком питания с конденсаторами, т.е. накопителями энергии, разработанными с привлечением компании LITEON Technology, а также необходимым аппаратным и программным обеспечением. На разных этапах работы системы используется несколько механизмов, включая ограничение мощности, накопление энергии и «сжигание» энергии — функция NVIDIA GPU Burn. Электролитические конденсаторы обеспечивают равномерное энергопотребление непосредственно в стойке. Они занимают почти половину объёма БП и обеспечивают накопление 65 джоулей энергии на каждый ускоритель. Накопитель (конденсатор) заряжается при низком потреблении энергии ускорителем и разряжается при высоком. Этот своего рода буфер помогает снизить колебания энергопотребления, что продемонстрировано в сравнительных тестах GB200 и GB300 при одинаковой нагрузке. GB300 снижает пиковую нагрузку на сеть на 30 %, обеспечивая при этом аналогичную мощность для ускорителей. GB300 ограничивает скачки, пошагово увеличивая энергопотребление ускорителя. Ограничение по мощности увеличивается постепенно, в соответствии с возможностями сети. По завершении задания, программный драйвер, реализующий алгоритм сглаживания энергопотребления, активирует аппаратное снижение энергопотребления. Ускоритель продолжает потреблять постоянную мощность благодаря функции NVIDIA GPU Burn, ожидая возобновления нагрузки. Если нагрузка не возобновляется, ускоритель плавно снижает энергопотребление. Если нагрузка на ускоритель возобновляется, функция NVIDIA GPU Burn мгновенно отключается. После завершения нагрузки ускоритель с помощью NVIDIA GPU Burn постепенно снижает энергопотребление со скоростью, соответствующей возможностям сети, а затем отключается. Эти параметры контролируются такими настройками, как минимальное энергопотребление в режиме ожидания и время постепенного снижения нагрузки, которые можно настроить с помощью NVIDIA SMI или Redfish. Такой полный контроль энергопотребления снижает нагрузку на электросеть и делает планирование заданий более предсказуемым. Как отметил ресурс The Futurum Group, благодаря предложенной NVIDIA схеме питания ЦОД больше не нужно строить с учётом пиковых потребностей в мощности. Вместо этого их можно масштабировать ближе к средним показателям использования, что означает возможность размещения большего количества оборудования в том же пространстве или снижение общих затрат на электроэнергию. Суперконденсаторы в качестве энергетического буфера для всего объекта целиком предлагает Siemens, хотя уже есть и более компактные решения размером со стойку. Кроме того, поскольку сглаживание потребления мощности ограничено стойкой без её подачи обратно в сеть, операторы получают больше контроля над энергопотреблением. Такое сочетание аппаратного и программного обеспечения обеспечивает масштабируемость и делает ЦОД дружественными к энергосети, независимо от того, используют ли они системы GB200 или GB300 NVL72. Как отметил ресурс ServeTheHome, использование дополнительных аккумулирующих модулей в стойке, предложенное LITEON, также поможет более равномерному распределению нагрузки между крупными ИИ-кластерами. Сантьяго Грихальва (Santiago Grijalva), профессор электротехники и вычислительной техники в Технологическом институте Джорджии, назвал новую технологию «довольно серьёзным событием», учитывая доминирующую роль NVIDIA в этой области. «Но это решение ограничено высококлассными системами NVIDIA, — указал он в электронном письме ресурсу Utility Dive. — Это решение конкурирует с решениями Tesla и аппаратными оптимизациями Meta✴, предлагая существенное, но не революционное усовершенствование существующих методов управления питанием».

04.08.2025 [12:39], Руслан Авдеев

Meta✴ начала пилотный проект по использованию древесины для строительства дата-центровКомпания Meta✴ начала использовать массив древесины при строительстве собственных кампусов ЦОД. IT-гигант запустил пилотный проект в начале текущего года, стремясь заменить сталь и другие строительные материалы продукцией на основе деревянных элементов, разработанных с учётом требований к прочности и долговечности, сообщает Datacenter Dynamics. Meta✴ готовится активно внедрять древесину во всех своих ЦОД и уже сообщила, что планирует применять её при строительстве административных зданий, складов и даже критически важных машинных залов. По данным Meta✴, такое деревянное сырьё предназначено для промышленного применения, в том числе в ЦОД. Речь идёт о клеёном брусе, деревянных балках и колоннах, фанере и конструкциях для стен. В текущем году Meta✴ построила первое административное здание из массива древесины на территории своего кампуса в Эйкене (Aiken, Южная Каролина) совместно с компаниями DPR и SmartLam. В 2025 году компания намерена начать возводить другие здания из массива древесины на территории объекта в Шайенне (Cheyenne, Вайоминг) вместе с Fortis Construction и Mercer Mass Timber. Кроме того, использовать природные материалы планируется в Монтгомери (Montgomery, Алабама) в сотрудничестве с Hensel Phelps и Binderholz.

Источник изображения: Meta✴ Использование таких материалов может существенно улучшить экологические показатели ЦОД, снизив «углеродную ёмкость» строительства. В Meta✴ отмечают, что применение массива древесины позволит сократить содержание «воплощённого углерода» примерно на 41 % по сравнению с материалами, которые она заменяет. Кроме того, большинство деревянных изделий применяется в быстровозводимых сборных зданиях, что значительно уменьшает потребность в сварке стали на месте и позволяет сократить сроки строительства на несколько недель. Материалы обладают огнестойкостью благодаря специальному углеродному слою. Для обеспечения экологической устойчивости Meta✴ требует проведения независимых аудитов, подтверждающих ответственное происхождение и переработку древесины, а также возможность отслеживания её происхождения, что способствует сохранению окружающей среды. Компания заявила, что новые решения тесно связаны с её усилиями по устойчивому использованию лесных ресурсов. Так, в прошлом году она подписала соглашение с BTG Pactual Timberland Investment Group о сокращении выбросов углерода в рамках лесовосстановительных проектов на 1,3 млн т углеродных кредитов в Латинской Америке. Meta✴ не первой применила массив древесины для строительства своих дата-центров. В октябре о строительстве двух ЦОД в Северной Вирджинии, частично с использованием клееной древесины (CLT), объявила Microsoft. Она заявила, что это позволит сократить углеродный след дата-центров приблизительно на 35 %. Древесину использует и шведский застройщик EcoDataCenter. Кроме того, в начале 2025 года немецкая Prior1, занимающаяся дата-центрами, объявила о запуске сборного деревянного модуля ЦОД, в котором достаточно места для размещения пяти стоек, системы непрямого охлаждения на основе пропана на 14 кВт и ИБП на 15 кВА.

04.08.2025 [10:16], Руслан Авдеев

Новый ИИ ЦОД в Вайоминге будет потреблять больше энергии, чем все дома штатаСогласно расчётам компании Rocky Mountain Power, новый ИИ-объект в Вайоминге, вероятно, будет потреблять больше электричества, чем все жилые дома штата вместе. Это лишь очередное свидетельство тренда, когда ИИ-инфраструктура развивается быстрее, чем может адаптироваться энергетическая инфраструктура. Это ставит новые задачи перед коммунальными службами, правительствами и потребителями, сообщает TechRepublic. На днях сообщалось, что Crusoe и Tallgrass построят в Вайоминге ИИ ЦОД мощностью 1,8 ГВт. Поскольку обучение ИИ-моделей и инференс становятся всё более ресурсоёмкими задачами, крупные ЦОД меняют подход к энергопотреблению и водопользованию в США. Согласно отраслевым оценкам, на дата-центры уже приходится 4,4 % потребления местного электричества, а к 2028 году оно может вырасти до 12 %. По другим оценкам, в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. Некоторые коммунальные компании предупреждают, что спрос на электроэнергию в США может вырасти на 50 % за 5 лет. Отмечается, что с такими темпами роста не может справиться ни один штат. В некоторых случаях планируется строительство гигаваттных ЦОД. При этом обращение к ИИ обычно дороже простого интернет-поиска — например, типичный запрос в ChatGPT требует около 2,9 Вт·ч, а при стандартном веб-поиске расходуется около 0,3 Вт·ч. Растущая нагрузка на энергосистему уже ведёт к изменению стратегии местных коммунальных компаний. Так, Pacific Gas & Electric (PG&E) отказалась выводить из эксплуатации три угольные электростанции, а операторы электросетей Техаса экстренно объявили об ожидаемом росте спроса на электричество. Более того, при президенте Дональде Трампе похоже, готовы и вовсе покончить с «зелёной повесткой». Вайоминг уже стал ключевой локацией для размещения новой ИИ-инфраструктуры благодаря «географической стабильности» и подключению к национальной энергетической магистрали, проложенной вдоль трассы I-80. Компании вроде Microsoft и Meta✴ ведут свою деятельность в штате. Планируемый Meta✴ ЦОД гиперскейл-уровня площадью более 364 га недалеко от Шайенна (Cheyenne) должен заработать в течение трёх лет.

Источник изображения: Gustavo Quepóns/unsplash.com Немалую роль играет и связанное с ИИ потребление воды, особенно в засушливых регионах. Многие ИИ-ЦОД применяют испарительные системы охлаждения, потребляющие немало водных ресурсов. Каждый ЦОД, по некоторым оценкам, может потреблять 2 тыс. м³ воды в день, что приблизительно эквивалентно водопотреблению 6,5 тыс. американских домохозяйств. Особенно сложная ситуация обстоит в западных штатах США, таких как Невада, Юта и Колорадо, где уже наблюдается дефицит воды. Так, в некоторых районах Невады прогнозируется спрос на электричество, который может потребовать расширения энергосистемы штата на 40 % в следующие 10 лет. Front Range в Колорадо намерена утроить мощность ЦОД, при этом каждый новый ЦОД будет потреблять 160 МВт — общее энергопотребление будет больше, чем у сталелитейных заводов и горнодобывающих предприятий. Экономические и экологические последствия такого прогресса могут переложить на плечи потребителей. ЦОД США, возможно, скоро будут потреблять больше энергии, чем целые страны. По одной из оценок, в будущем на них придётся столько же энергопотребления, сколько потребляла Польша в 2023 году. Один Amazon, если построит все запланированные объекты, будет потреблять до 49 ТВт·ч ежегодно, что примерно сопоставимо с энергопотреблением всей Невады в 2024 году. Хотя отдельные штаты уже начинают выпускать законы, посвящённые развитию энергетики и «зелёной» энергетики для потребителей с высоким спросом, к 2030 году расходы на соответствие требованиям к инфраструктуре могут достичь $2 трлн. При этом генерация энергии приведёт к расходам на здравоохранение в объёме $5,7-9,2 млрд из-за увеличения выбросов, связанных с энергетикой. По мнению экспертов, издержки, вероятно, будут переложены на плечи потребителей — в связи с повышением счетов на коммунальные услуги и экологическими последствиями. По мере распространения ИИ его энергопотребление может напрямую влиять на бюджеты домохозяйств, отражаясь не только в тратах на цифровые сервисы, но и в ежемесячных платежах за электроэнергию.

04.08.2025 [08:57], Сергей Карасёв

Teco и Foxconn объединили усилия в области ИИ ЦОДКомпании Hon Hai Technology Group (Foxconn) и Teco Electric & Machinery объявили о формировании стратегического альянса с целью совместного развития решений для дата-центров, ориентированных на задачи ИИ. Foxconn является одним из крупнейших в мире контрактных OEM-производителей электроники. Кроме того, компания занимается выпуском серверов. В свою очередь, Teco Electric & Machinery специализируется на поставках электродвигателей. Эта фирма участвовала в реализации ЦОД-проектов общей мощностью более 700 МВт в Юго-Восточной Азии. Партнёрство компаний будет сосредоточено на модульных конструкциях для дата-центров. Производство продукции планируется организовать на Тайване и в США. В частности, Teco намерена осуществлять выпуск изделий на американском совместном предприятии Teco-Westinghouse. Клиентам будут предлагаться комплексные вертикально интегрированные решения. В число заказчиков, как ожидается, войдут гиперскейлеры и крупные операторы ЦОД. Сотрудничество Foxconn и Teco оформлено путём обмена акциями. Teco приобретёт 0,519 % ценных бумаг Hon Hai Precision Industry Co Ltd. В свою очередь, Foxconn будет владеть 10 % акций Teco. В рамках соглашения Teco выпустит 237 644 068 новых ценных бумаг для Foxconn, тогда как Foxconn выпустит 72 481 441 новую акцию для Teco, что подразумевает обмен бумагами с коэффициентом примерно 1 к 0,305. Сделку без денежных средств планируется завершить в IV квартале текущего года при условии получения необходимых разрешений со стороны регулирующих органов.

03.08.2025 [19:14], Владимир Мироненко

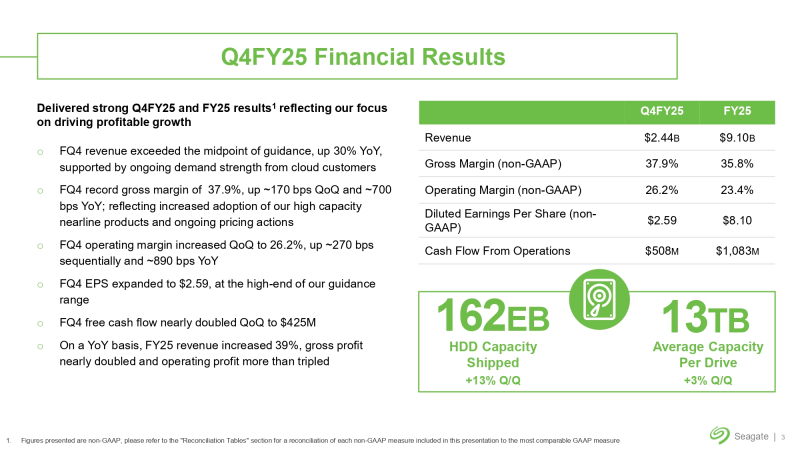

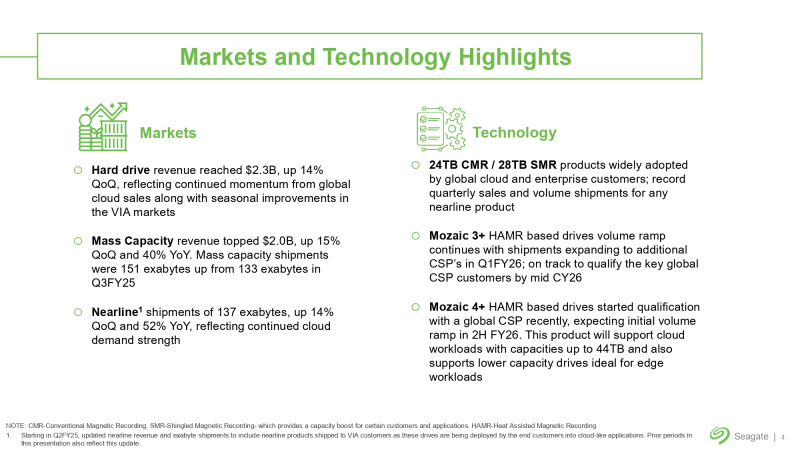

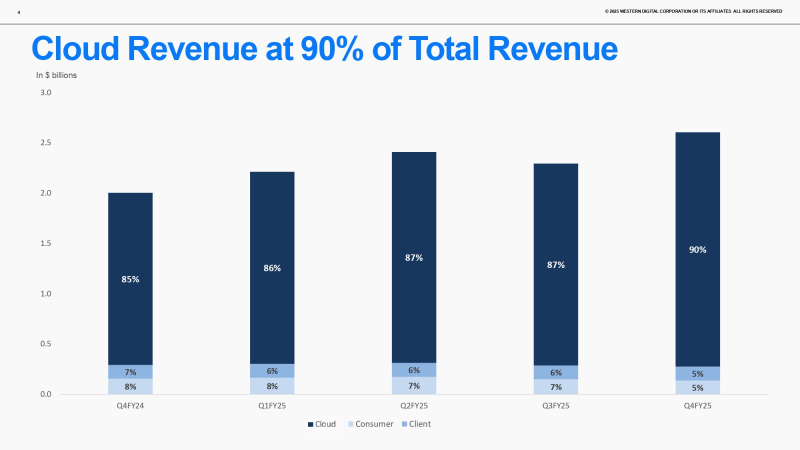

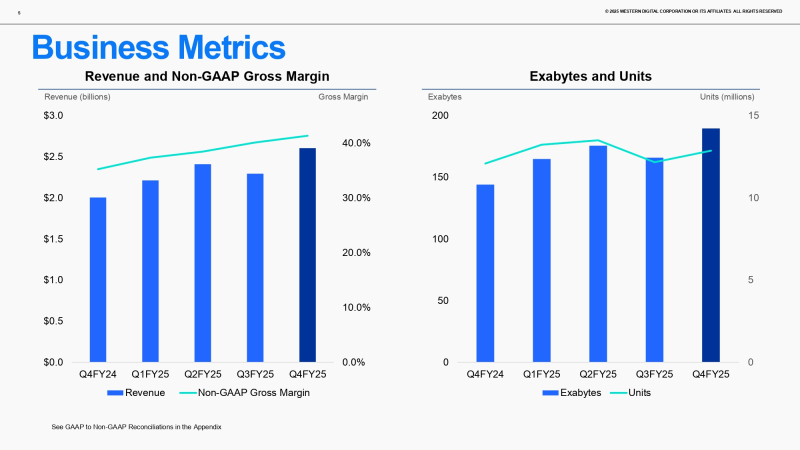

Seagate Technology и Western Digital показали значительный рост в прошлом квартале благодаря ИИКомпания Seagate Technology и Western Digital опубликовали финансовые результаты за минувший квартал, продемонстрировав рост выручки на фоне увеличения спроса на ИИ-технологии и поставок накопителей для ЦОД. Seagate Technology сообщила о росте выручки в IV квартале 2025 финансового года, закончившемся 27 июня, на 29,5 % до $2,44 млрд, что немного выше прогноза аналитиков FactSet в $2,42 млрд, как сообщает ресурс Investor's Business Daily. При этом чистая прибыль (GAAP) компании упала на 4,9 % до $488 млн. А скорректированная прибыль на акцию (non-GAAP) составила $2,59, что на 146 % больше, чем годом ранее, и выше прогноза аналитиков FactSet в размере $2,45. «Seagate завершила 2025 финансовый год с высокими финансовыми результатами за июньский квартал, показав рост выручки на 30 % по сравнению с аналогичным периодом прошлого года и рекордную валовую прибыль, которая улучшалась девятый квартал подряд. Эта тенденция, несомненно, сохранится по мере роста внедрения HAMR», — цитирует Blocks & Files слова гендиректора Дэйва Мосли (Dave Mosley). Выручка Seagate от продажи накопителей большой ёмкости (Mass Capacity) для СХД в IV квартале составила $2 млрд, увеличившись год к году на 40 % и обеспечив 88 % общей выручки от продаж жёстких дисков ($2,28 млрд). Всего было поставлено таких дисков на 150,9 Эбайт. Средняя ёмкость этих дисков увеличилась за год на 31 % — с 12,6 до 16,5 Тбайт. Компания поставила Nearline-дисков на 136,6 Эбайт (рост год к году — на 52 %) на фоне роста спроса со стороны провайдеров ЦОД, а также 11,5 Эбайт старых моделей жёстких дисков, что на 12 % больше, чем годом ранее. Средняя вместимость всех HDD за год увеличилась на 40 % — с 9,3 до 13,0 Тбайт. При этом годовая выручка Seagate всё ещё заметно ниже пикового значения 2012 года в размере $14,9 млрд. В последующие годы компании так и не удалось достичь этого рубежа, поскольку SSD-накопители подорвали продажи её высокопроизводительных корпоративных дисков, а также HDD для ноутбуков, ПК и рабочих станций. Seagate сообщила, что три крупных провайдера облачных услуг сертифицировали HAMR-диски, но этот процесс ещё не завершён. По словам Мосли, в целом процесс сертификации идёт весьма успешно, и ожидается, что основные глобальные провайдеры проведут сертификацию к середине календарного 2026 года. Seagate также меняет отчётность по сегментам выручки. Финансовый директор Джанлука Романо (Gianluca Romano) сообщил, что, начиная с сентябрьского квартала, компания сосредоточится на двух основных областях: ЦОД и периферийных устройствах/Интернете вещей (Edge/IoT). На рынки ЦОД пришлось около 75 % выручки Seagate в 2025 финансовом году. Они включают в себя продукты и системы, реализуемые облачным и корпоративным клиентам, а также приложения VIA (VGG Image Annotator) для облака. Edge/IoT охватывает потребительские и клиентоориентированные рынки, а также сетевые хранилища. «Мы считаем, что эта новая структура лучше соответствует отраслевой практике и отражает специфику рынка, ориентированного на ИИ, который мы обслуживаем сегодня», — отметил Романо. В текущем I квартале 2026 финансового года компания ожидает получить выручку в размере до $2,5 млрд ± $150 млн, что на 15 % больше год к году в среднем значении, но ниже консенсус-прогноза аналитиков в $2,51 млрд, опрошенных LSEG (согласно Reuters). Прогноз компании по разводнённой прибыли на акцию (non-GAAP) составляет $2,30 ± $0,20 при прогнозе аналитиков $2,33. Из-за слабого прогноза акции Seagate упали на 8 % с отметки $154,75 в ходе расширенных торгов. Western Digital тоже демонстрирует увеличение доходов на фоне роста спроса на ИИ-сервисы, требующие инфраструктуру для хранения больших объемов данных для обучения ИИ-моделей. В IV квартале 2025 финансового года, закончившемся 27 июня, её выручка составила $2,61 млрд, превысив показатель аналогичного квартала годом ранее на 30 %, а также консенсус-прогноз аналитиков, опрошенных LSEG, в размере $2,47 млрд. Выручка от облачных решений составила $2,3 млрд, что составляет 90 % от общей выручки и на 36 % больше показателя годом ранее. Клиентские и потребительские решения принесли компании соответственно $140 млн (5 % от общего дохода, рост год к году на 2 %) и $136 млн (5 %, снижение год к году на 12 %). Скорректированная прибыль на акцию (non-GAAP) за отчётный квартал равняется $1,61, что выше прогноза Уолл-стрит в размере $1,43 (по данным Investing.com). Чистая прибыль за квартал составила $282 млн, тогда как годом ранее этот показатель равнялся $39 млн. Выручка Western Digital за 2025 финансовый год равняется $9,52 млрд, что на 51 % больше, чем в предыдущем финансовом году, и выше её собственного прогноза. Чистая прибыль за год составила $1,9 млрд, а в 2024 году у неё были убытки в $798 млн. Western Digital поставила в IV квартале 12,9 млн жёстких дисков, что больше на 0,8 млн единиц, чем годом ранее. В том числе было поставлено 9,3 млн накопителей Nearline по сравнению с 7,9 млн штук годом ранее, 2,1 млн клиентских устройств против 2,3 млн штук в 2024 финансовом году и 1,5 млн потребительских накопителей против 1,9 млн единиц годом ранее. Ёмкость дисков, поставленных в отчётном квартале, составила 190 Эбайт, включая диски Nearline на 170 Эбайт. Финансовый директор Крис Сеннесаэль (Kris Sennesael) отметил, что рост поставок был достигнут благодаря, в том числе, росту продаж дисков CMR ёмкостью 26 Тбайт и UltraSMR ёмкостью 32 Тбайт. Большинство дисков Nearline приобрели пять крупнейших клиентов WD, являющихся гиперскейлерами. Два из них используют диски UltraSMR, третий прошёл квалификацию, а четвёртый в настоящее время проходит квалификацию на использование этих дисков. В I квартале 2026 года Western Digital прогнозирует выручку в размере $2,70 млрд ± $100 млн при прогнозе аналитиков в размере $2,54 млрд. Прогноз по скорректированной прибыли (non-GAAP) на акцию равен $1,54 ± $0,15, тогда как аналитики ожидают $1,38 на акцию. Акции компании выросли более чем на 4 % в ходе расширенных торгов.

03.08.2025 [12:14], Сергей Карасёв

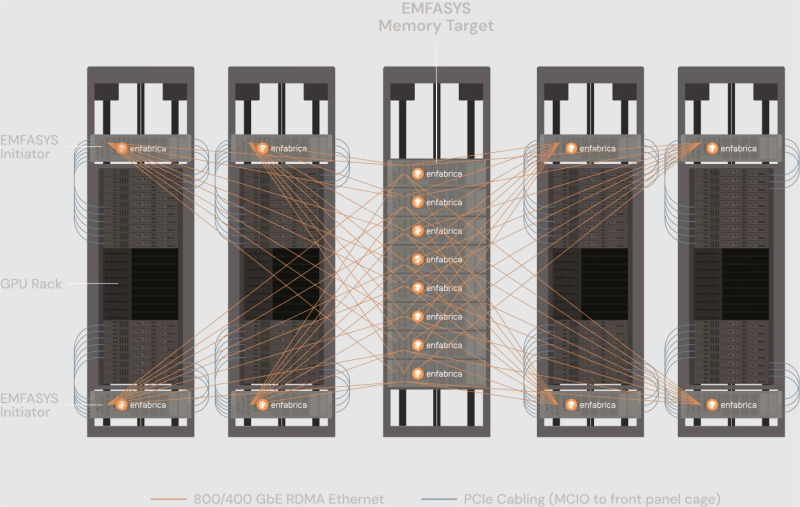

Enfabrica представила технологию EMFASYS для расширения памяти ИИ-системКомпания Enfabrica анонсировала технологию EMFASYS, которая объединяет Ethernet RDMA и CXL для создания пулов памяти, предназначенных для работы с серверными ИИ-стойками на базе GPU. Решение позволяет снизить нагрузку на HBM-память ИИ-ускорителей и тем самым повысить эффективность работы всей системы в целом. Enfabrica основана в 2019 году. Стартап предлагает CXL-платформу ACF на базе ASIC собственной разработки, которая позволяет напрямую подключать друг к другу любую комбинацию GPU, CPU, DDR5 CXL и SSD, а также предоставляет 800GbE-интерконнект. Компания создала чип ACF SuperNIC (ACF-S) для построения высокоскоростного интерконнекта в составе кластеров ИИ на основе GPU. В рамках платформы EMFASYS специализированный пул памяти подключается к GPU-серверам через чип-коммутатор ACF-S с пропускной способностью 3,2 Тбит/с, который объединяет PCIe/CXL и Ethernet. Поддерживаются интерфейсы 100/400/800GbE, 32 сетевых порта и 160 линий PCIe. Могут быть задействованы до 144 линий CXL 2.0, что позволяет использовать до 18 Тбайт памяти DDR5 (в перспективе — до 28 Тбайт). Вместо копирования и перемещения данных между несколькими чипами на плате Enfabrica использует один SuperNIC, который позволяет представлять память в качестве целевого RDMA-устройства для приложений ИИ. Высокая пропускная способность памяти достигается за счёт распределения операций более чем по 18 каналам на систему. Время доступа при чтении измеряется в микросекундах. Программный стек на базе InfiniBand Verbs обеспечивает массовую параллельную передачу данных с агрегированной полосой пропускания между GPU-серверами и памятью DRAM через группы сетевых портов 400/800GbE. Enfabrica отмечает, что рабочие нагрузки генеративного, агентного и рассуждающего ИИ растут экспоненциально. Во многих случаях таким приложениям требуется в 10–100 раз больше вычислительной мощности на запрос, чем большим языковым моделям (LLM) предыдущего поколения. Если память HBM постоянно загружена, дорогостоящие ускорители простаивают. Технология EMFASYS позволяет решить проблему посредством расширения памяти: в этом случае ресурсы GPU используются более полно, а заявленная экономия достигает 50 % в расчёте на токен на одного пользователя.

03.08.2025 [10:17], Сергей Карасёв

Rebellions и Marvell займутся разработкой решений для суверенного ИИЮжнокорейская компания Rebellions, занимающаяся созданием специализированных ИИ-чипов, объявила о сотрудничестве с американским разработчиком процессоров, микроконтроллеров и телекоммуникационных изделий Marvell Technology. Цель партнёрства — выпуск высокопроизводительных и энергоэффективных ИИ-решений для суверенных платформ в Азиатско-Тихоокеанском регионе и на Ближнем Востоке. Стартап Rebellions основан в 2020 году. Компания проектирует чипы для инференса, способные обеспечить энергоэффективность и высокую производительность при небольших задержках. В январе 2024 года Rebellions провела раунд финансирования Series B, в ходе которого на развитие было привлечено $124 млн. Позднее стартап получил $15 млн от Wa’ed Ventures — венчурного подразделения саудовского нефтегазового и химического гиганта Aramco. Кроме того, фирма Rebellions объявила о слиянии с разработчиком ИИ-чипов Sapeon Korea, который был выделен из SK Telecom в 2016 году. В заявлении Rebellions говорится, что инфраструктура ИИ становится всё более важной в плане обеспечения национальной конкурентоспособности. На этом фоне наблюдается переход от стандартизированных архитектур на базе GPU к специализированным системам, построенным с применением ASIC. Такой трансформации способствуют суверенные инициативы и проекты региональных поставщиков облачных услуг, которым требуется инфраструктура, обеспечивающая масштабируемость, эффективность и контроль. Предполагается, что новое партнёрство позволит Rebellions разрабатывать кастомизированные ИИ-ускорители с использованием специализированных платформ Marvell. При этом будут использоваться передовые технологии упаковки чипов, высокоскоростные SerDes-блоки и межкомпонентные соединения. Новые чипы, как ожидается, обеспечат возможность высокопроизводительного и энергоэффективного инференса. В целом, сотрудничество позволит объединить достижения Rebellions в области разработки ИИ-решений с передовыми технологиями интеграции кремниевых компонентов Marvell для создания специализированной инфраструктуры ИИ, отвечающей потребностям государственных организаций.

02.08.2025 [21:58], Владимир Мироненко

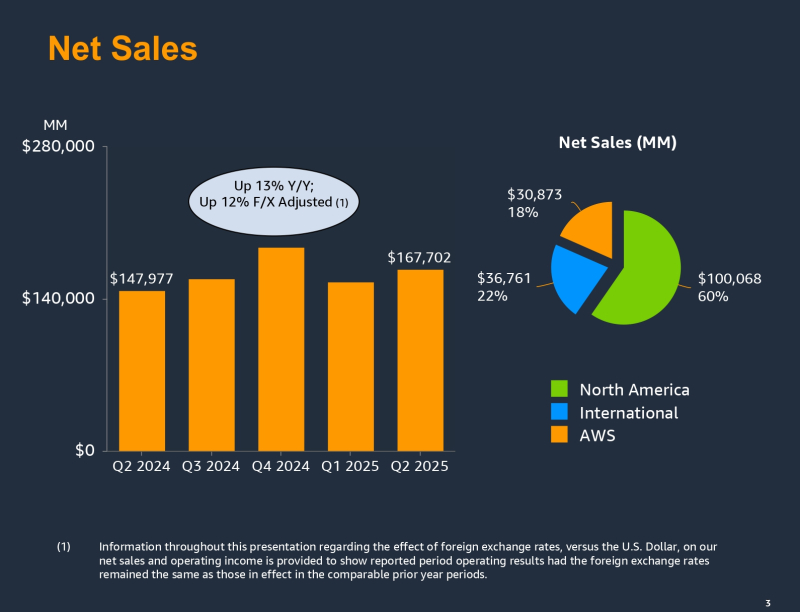

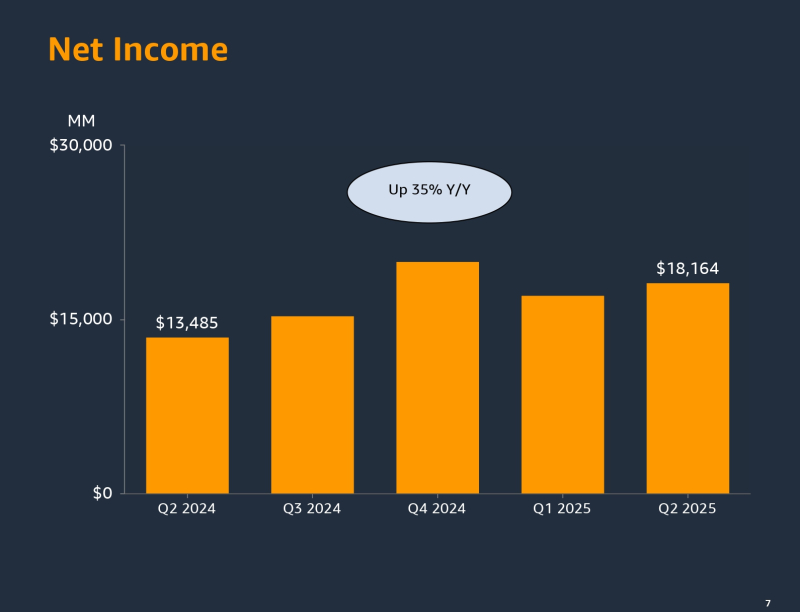

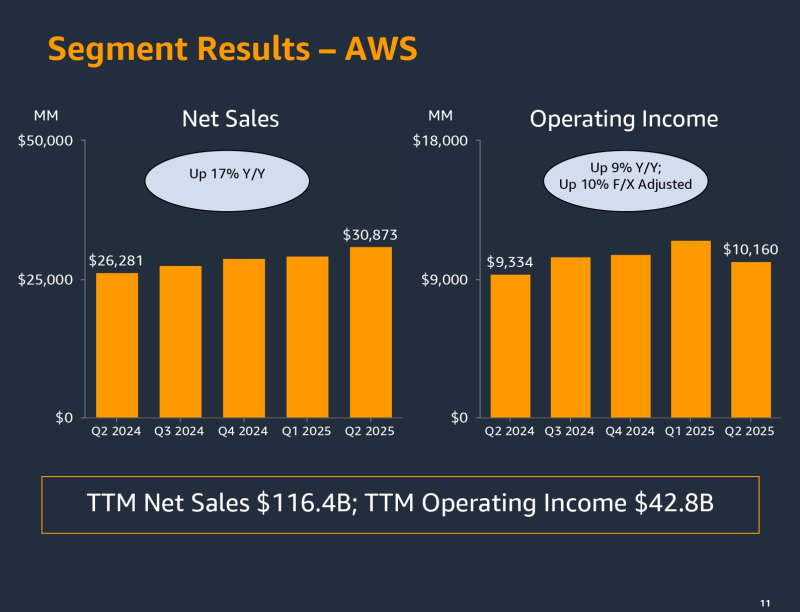

Amazon за год вложит в инфраструктуру рекордные $118 млрд, но рост ИИ ЦОД сдерживает нехватка электроэнергииAmazon.com сообщила о значительном росте выручки и прибыли во II квартале 2025 года, завершившемся 30 июня, но акции гиганта электронной коммерции упали более чем на 7 % после закрытия торгов, поскольку темпы роста её подразделения облачных вычислений Amazon Web Services (AWS) не оправдали ожиданий инвесторов, пишет Reuters. Вместе с тем результаты II квартала показали, что Amazon лучше справляется с меняющейся тарифной политикой США, чем опасались на Уолл-стрит, отметил ресурс CNBC. Amazon увеличила выручку на 13 % до $167,7 млрд, превысив прогноз Уолл-стрит в размере $162.1 млрд. Чистая прибыль компании составила $18,2 млрд, что на 35 % больше результата годом ранее. Прибыль на разводнённую акцию составила $1,68 при прогнозе аналитиков $1,33. Облачное подразделение AWS принесло компании $30,9 млрд, что на 17,5 % больше, чем годом ранее, и на 3 % — чем в предыдущем квартале. Выручка AWS больше, чем у облачных подразделений Microsoft и Google, сообщивших о $29,9 и $13,6 млрд соответственно, но инвесторы отметили значительно более низкие темпы роста выручки AWS. У Google Cloud выручка выросла за последний квартал на 32 % в годовом исчислении, у Microsoft Azure — на 26 %. Согласно публикации Data Center Dynamics, глава Amazon Энди Джасси (Andy Jassy) сказал: «Годовые проценты и темпы роста всегда зависят от базы, с которой вы работаете. И наш бизнес в сегменте AWS значительно крупнее, чем у других. Думаю, доля второго игрока составляет около 65 % от размера AWS». В отчётном квартале у AWS была более низкая рентабельность, чем в предыдущих кварталах. Его операционная прибыль составила $10,2 млрд, что ниже средней оценки аналитиков в $10,9 млрд, согласно StreetAccount. Это чуть более половины операционной прибыли компании, равной $19,2 млрд. Доход AWS составляет небольшую часть общей выручки Amazon, но является ключевым источником прибыли, обычно обеспечивая около 60 % от общей операционной прибыли компании. Во II квартале капитальные вложения Amazon составили $31,4 млрд, что выше прогноза Уолл-стрит, равного $26,4 млрд (по данным The Wall Street Journal). По словам Джасси, Amazon будет тратить примерно столько же в следующих двух кварталах. С учётом того, что капзатраты в I квартале составили $24,3 млрд общая сумма капвложений в 2025 финансовом году составит $118 млрд, что намного больше прогнозируемых $100 млрд. Капитальные вложения Google в последнем квартале составили $22,4 млрд, Microsoft — $24,2 млрд. Энди Джасси отметил ряд факторов, сдерживающих развёртывание облачной инфраструктуры компании и не позволяющий обеспечить растущий спрос на ИИ-сервисы. Наибольшее влияние оказывают проблемы с обеспечением объектов электроэнергией. За ними следуют «периодические ограничения, связанные с чипами, а затем с некоторыми компонентами для производства серверов». Он заявил, что вряд ли эти проблемы решатся в 2025 году, но выразил уверенность, что ситуация будет улучшаться с каждым кварталом. Несмотря на большие вложения в ИИ-инфраструктуру аналитики отмечают, что отсутствие у AWS сильной ИИ-модели вызывает опасения, что компания может отставать от конкурентов в разработке ИИ. Результаты AWS «вызывают тревогу», заявил Дэйв Вагнер (Dave Wagner), управляющий портфелем Aptus Capital Advisers, владеющей акциями Amazon. В ответ Джасси сообщил, что «сейчас ещё слишком рано говорить об ИИ», отметив партнёрство компании с Anthropic, которая обучает свои модели на ускорителях Trainium2 от Amazon. Он добавил, что чипы собственной разработки компании предлагают на 30–40 % лучшее соотношение цены и производительности. «Я думаю, что значительная часть вычислений и инференса в конечном итоге будет выполняться на базе Tranium. И я думаю, что это соотношение цены и производительности будет иметь значение для людей по мере масштабирования», — сообщил руководитель Amazon. Джасси также отметил то, что 85–90 % мировых ИТ-расходов приходится на локальные, а не на облачные решения, и компания ожидает, что ситуация изменится в ближайшие 10–15 лет. Этот сдвиг, по словам Джасси, принесёт пользу AWS. «Значительная часть инференса генеративного ИИ станет просто ещё одним строительным блоком, таким как вычисления, хранение и базы данных. И пользователи захотят запускать эти приложения рядом с теми местами, где работают их другие приложения, где находятся их данные. В AWS обрабатывается гораздо больше приложений и данных, чем где-либо ещё», — отметил глава Amazon. Касаясь миграции из локальной среды в облако, Джасси также отметил несколько новых соглашений с такими компаниями, как PepsiCo, Airbnb, Peloton, Nasdaq, Лондонская фондовая биржа, Nissan Motor, GitLab, SAP, Warner Bros. Discovery, Twelve Labs, FICO, Iberia Airlines, SK Telecom и NatWest. Amazon сообщила о сокращении 14 тыс. рабочих мест в отчётном квартале, в том числе в AWS, книжном подразделении, отделе гаджетов и подкастов, что стало первым сокращением с начала 2024 года. В настоящее время штат компании составляет 1,46 млн человек. Согласно прогнозу Amazon, в III квартале 2025 года выручка будет находиться в диапазоне $174,0– $179,5 млрд, что представляет собой рост год к году от 10 до 13 % и выше консенсус-прогноза аналитиков, опрошенных LSEG, в $173,08 млрд. Прогноз компании по операционной прибыли оказался ниже ожиданий аналитиков — $15,5–$20,5 млрд, что в средней точке ниже целевого показателя Уолл-стрит в $19,45 млрд.

02.08.2025 [15:12], Сергей Карасёв

Нордический Stargate: OpenAI получит в Норвегии 230-МВт ИИ ЦОД со 100 тыс. ИИ-ускорителей NVIDIAКомпания OpenAI анонсировала проект Stargate Norway — это первый в Европе дата-центр для задач ИИ, создающийся в рамках программы OpenAI for Countries. Объект расположится в Норвегии, в Квандале (Kvandal) неподалёку от Нарвика (Narvik) на севере страны. В проекте принимают участие компания Nscale, поставщик ИИ-инфраструктуры с опытом предоставления облачных решений в Европе и Северной Америке, а также инжиниринговая фирма Aker. На начальном этапе мощность нового ЦОД составит 230 МВт с перспективой добавления ещё 290 МВт. К концу 2026 года в дата-центре будут размещены 100 тыс. ИИ-ускорителей NVIDIA, а в последующие годы планируется «значительное расширение». Территория Нарвика выбрана не случайно. Обилие гидроэнергии, её низкая стоимость, прохладный климат и развитая промышленная база региона делают его оптимальным местом для масштабного и устойчивого развития ИИ-платформ. Новый дата-центр будет получать питание исключительно от возобновляемых источников энергии. Упомянуто применение прямого жидкостного охлаждения для дальнейшего повышения энергетической эффективности. Избыточное тепло будет использоваться для централизованного теплоснабжения. Управлять новым ЦОД предстоит совместному предприятию Nscale и Aker с равным долевым участием. Компании выделили около $1 млрд на начальный этап проекта, включая более $250 млн в виде акционерного капитала. Утверждается, что это одна из самых крупных инвестиций в ИИ-инфраструктуру в Европе на сегодняшний день. Площадка в Нарвике обладает потенциалом десятикратного масштабирования и, помимо OpenAI, может использоваться другими клиентами. Aker и Nscale будут в приоритетном порядке предоставлять ресурсы Stargate Norway норвежским стартапам в области ИИ и научным организациям. Излишки мощностей станут доступны государственным и частным пользователям в Великобритании и странах Северной Европы. Добавим, что мегапроект Stargate — это совместное предприятие OpenAI, SoftBank и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. При этом один из крупнейших ИИ ЦОД Stargate расположится в Объединённых Арабских Эмиратах (ОАЭ): мощность этого кампуса составит 5 ГВт. Впрочем, пока развитие проекта идёт ни шатко, ни валко — OpenAI предпочитает искать ресурсы напрямую.

02.08.2025 [13:53], Сергей Карасёв

VAST Data готовится к новому раунду финансирования при оценке $30 млрдКомпания VAST Data, по информации Reuters, готовится провести очередной раунд финансирования, в ходе которого на развитие будет привлечено «несколько миллиардов долларов». При этом рыночная стоимость стартапа может увеличиться примерно до $30 млрд. VAST Data была основана в 2016 году. Она специализируется на разработке инфраструктуры для ИИ. В частности, Vast Data предоставляет программную платформу для управления хранилищами в ЦОД. Решение позволяет осуществлять раздельное масштабирование СХД и вычислительных ресурсов, что обеспечивают экономию средств и энергии. При этом могут применяться накопители на основе флеш-чипов QLC NAND. Как сообщает Reuters, ссылаясь на информацию, полученную от двух осведомлённых источников, в новом инвестиционном раунде Vast Data примут участие NVIDIA и CapitalG — частный инвестиционный фонд Alphabet (материнская структура Google). Предполагается, что раунд может быть закрыт в ближайшие недели. В случае привлечения средств VAST Data станет одним из самых дорогих стартапов в сфере ИИ. Предыдущий раунд финансирования VAST Data осуществила в конце 2023 года: тогда компания получила $118 млн, а её рыночная оценка выросла до $9,1 млрд. В инвестиционной программе приняли участие Fidelity Management & Research Company, New Enterprise Associates (NEA), BOND Capital и Drive Capital. В число клиентов VAST Data входят такие компании, как xAI Илона Маска и CoreWeave. По данным Reuters, годовая регулярная выручка VAST Data в 2024-м превысила $200 млн, а в 2026 году, по прогнозам, достигнет $600 млн. На сегодняшний день компания привлекла в общей сложности около $380 млн. В прошлом году VAST Data назначила своим первым финансовым директором Эми Шаперо (Amy Shapero), которая ранее занимала аналогичную должность в Shopify. Аналитики полагают, что это может говорить о подготовке к первичному публичному размещению акций (IPO). |

|