Материалы по тегу: aws

|

22.02.2025 [22:38], Сергей Карасёв

STMicroelectronics представила фотонный чип для 1,6-Тбит/с сетейКомпания STMicroelectronics объявила о разработке фотонного чипа PIC100, предназначенного для организации высокоскоростного оптического интерконнекта в дата-центрах, ориентированных на задачи ИИ. Изделие создано в сотрудничестве с Amazon Web Services (AWS). Чипы PIC100 планируется изготавливать с использованием технологического процесса BiCMOS на основе 300-мм кремниевых пластин. Метод BiCMOS предполагает объединение биполярных и КМОП-транзисторов на одном кристалле. Такой подход позволяет совместить преимущества компонентов обоих типов: технология обеспечивает улучшенную производительность по сравнению с КМОП-решениями при меньшей рассеиваемой мощности по сравнению с продуктами на основе только биполярных транзисторов. По заявлениям STMicroelectronics, на начальном этапе чипы PIC100 смогут поддерживать пропускную способность до 200 Гбит/с на линию. Это даёт возможность формировать соединения, обеспечивающие скорость передачи данных до 800 Гбит/с и 1,6 Тбит/с. Более того, STMicroelectronics работает над решениями с пропускной способностью до 400 Гбит/с на линию, что в конечном итоге, как ожидается, позволит создавать оптические интерконнекты со скоростью до 3,2 Тбит/с. Одной из проблем на пути практического применения подобных изделий являет рост выделяемого тепла, что может приводить к снижению производительности или увеличению частоты сбоев оборудования. Для минимизации таких негативных эффектов специалисты STMicroelectronics разработали специальные волноводы и оптоволоконные адаптеры. Производить чипы PIC100 планируется на предприятии STMicroelectronics в Кроле (Crolles) во Франции. Выпуск будет организован к концу текущего года.

21.02.2025 [10:04], Руслан Авдеев

Нужно больше дата-центров: AWS намерена построить по ЦОД в «каждом округе» между Северной Вирджинией и РичмондомAmazon Web Services (AWS) готовится создать центр обработки данных в каждом округе между Северной Вирджинией и городом Ричмонд (штат Вирджиния), сообщает Datacenter Dynamics. Наиболее крупным кампусом, по-видимому, станет проект Mattermeade на территории сразу двух округов, Спотсильвания (Spotsylvania) и Кэролайн (Caroline), где предполагается построить 11 двухэтажных ЦОД и ряд других вспомогательных строений на площади почти 463 га. Здесь AWS намерена развернуть не менее 770 МВт к 2027 году. К Северной Вирджинии относятся округа Фэрфакс (Fairfax), Арлингтон (Arlington), Лаудон (Loudoun), Принс-Уильям (Prince William), Спотсильвания (Spotsylvania) и Стаффорд (Stafford), а также города Александрия (Alexandria), Фэрфакс (Fairfax), Фолс-Чёрч (Falls Church), Фредериксбург (Fredericksburg), Маннасас (Manassas) и Маннасас-Парк (Manassas Park). AWS уже имеет кампусы в Лаудоне и Фэрфаксе, а также в округе Принс-Уильям. Ранее она подала заявки на реализацию проектов в Спотсильвании и Стаффорде, хотя, похоже, ещё не ведёт дел в Арлингтоне. Также известно о строительстве объектов AWS в округах Луиза (Louisa), Фокье (Fauquier), Калпепер (Culpeper), Кинг-Джордж (King George), Спотсильвания (Spotsylvania), Ориндж (Orange) и Каролайн (Caroline). Ранее Amazon планировала создать ЦОД в округе Фредерик (Frederick), но в начале 2022 года компания отказалась от этих намерений. С учётом планов компании дотянуть цепочку дата-центров до столицы штата, «пострадать» может ещё дюжина округов. Впрочем, действительно пострадать могут местные жители, которые уже не первый год жалуются на «катастрофический шум» от дата-центров и судятся с местными властями и компаниями, в том числе с той же Amazon, которая уже потратила $35 млрд на ЦОД в Северной Вирджинии и намерена потратить ещё $35 млрд. Бурное развитие сектора ЦОД в штате, подстёгиваемое ростом спроса на ИИ, может привести к проблемам с энергетикой и питьевой водой. Вместе с тем Северная Вирджиния является безусловным лидером по ёмкости ЦОД гиперскейлеров.

19.02.2025 [16:44], Руслан Авдеев

Только для европейцев: AWS вынужденно покидает совет директоров CISPEAmazon (AWS) покинула совет директоров европейской ассоциации облачных операторов CISPE после недавнего обновления устава организации. Теперь в её управлении могут участвовать только компании, базирующиеся в самой Европе, сообщает The Register. Впрочем, «неместные» провайдеры облачных услуг, с годовым доходом, превышающим €10 млрд, тоже могут быть постоянными участниками, но непосредственно в управлении они участвовать не будут. Дополнительно CISPE приняла решение о создании «Комитета по суверенитету и стратегической автономии» (Sovereignty and Strategic Autonomy Committee). Краткий пресс-релиз опубликован на сайте ассоциации. Теперь в совет входят представители компаний из Нидерландов, Франции, Италии, Австрии и Великобритании. С полным составом можно ознакомиться на сайте организации. Представители Gigas и UpCloud решили не баллотироваться на переизбрание. В CISPE утверждают, что решения стали ответом на растущий спрос пользователей облачных сервисов из Европы на конкурентоспособную местную инфраструктуру и решения на базе ИИ. В ассоциации добавили, что изменения происходят в судьбоносный момент, когда обеспокоенность геополитической зависимостью становится всё более выраженной — формирование собственной облачной экосистемы ещё никогда не было столь очевидно. Примечательно, что в Евросоюзе на AWS, Microsoft и Google приходится около 70 % расходов клиентов на облачную инфраструктуру, а многие рассматривали CISPE как лоббистскую группу AWS. Ассоциация резко критиковала Microsoft за политику лицензирования своего ПО в сторонних облаках. В июле прошлого года Microsoft заключила сделку с CISPE, отозвавшую антимонопольную жалобу 27 европейских облачных провайдеров на стоимость ПО Microsoft в облаках, отличных от Azure, а также другие проблемы. Google пыталась помешать соглашению, но у компании ничего не вышло. Более того, позже Microsoft сама вступила в ассоциацию в качестве участника без права голоса. Хотя AWS выступила против, компания оказалась в меньшинстве. В AWS заявляют, что гордятся вкладом в достижения организации за годы членства и сейчас сложилась подходящая возможность передать руководящие роли другим операторам. При этом компания продолжит активно участвовать в инициативах CISPE, поддерживающих облачную индустрию и повышающих конкурентоспособность Европы. Пока нет данных, не намерена ли AWS войти в состав другой торговой организации аналогичного профиля. Например, не так давно Google фактически основала группу Open Cloud Coalition (OCC), которую в Microsoft теперь называют «лоббистским фронтом». Как утверждают в Synergy Research Group, в 2024 году глобальный рынок облачных вычислений составил порядка $330 млрд, на Европу обычно приходится около 20 % от этой суммы. На AWS, Microsoft и Google приходится 30 %, 21 % и 12 % соответствующих расходов клиентов соответственно, а в Европе доля их рынка значительно выше.

07.02.2025 [14:31], Владимир Мироненко

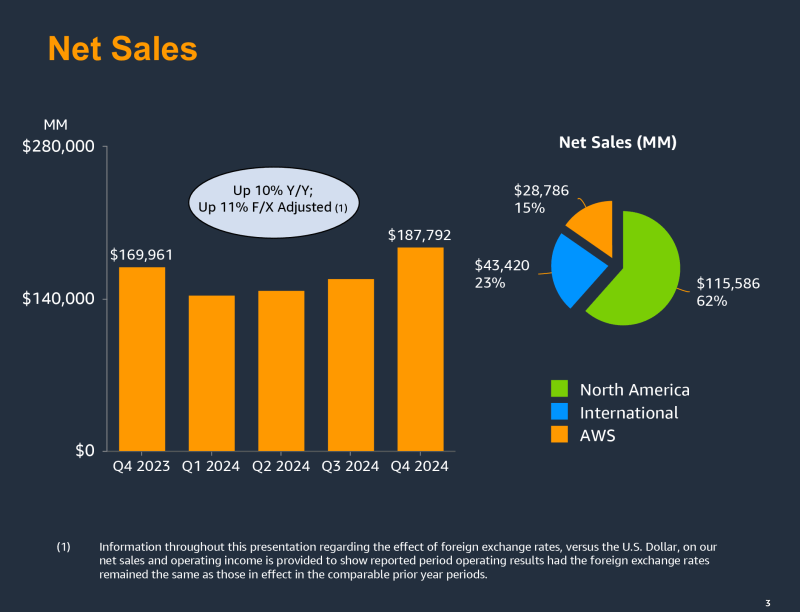

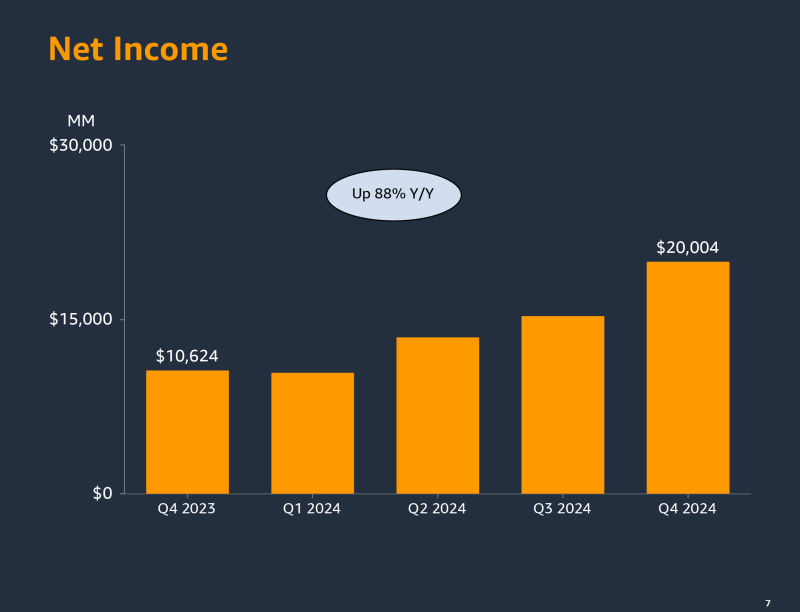

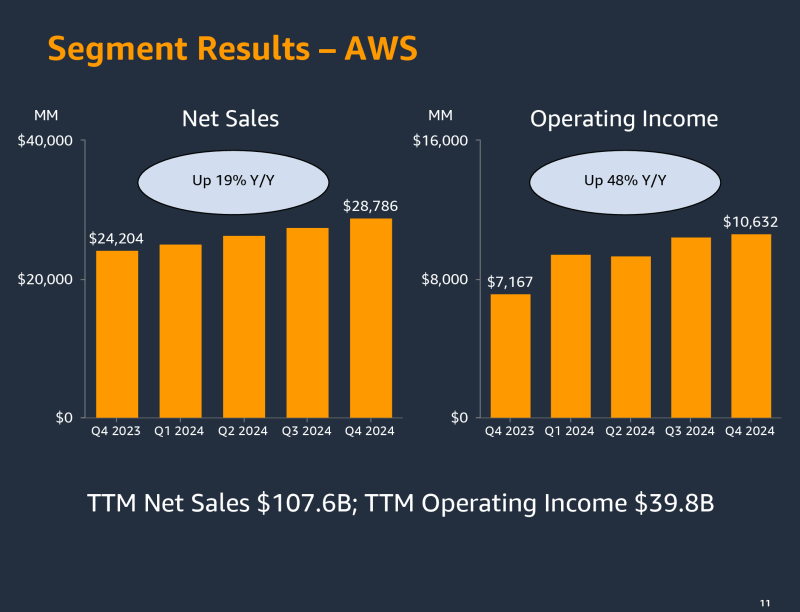

Amazon увеличит в 2025 году капзатраты на ЦОД и ИИ-ускорители до $100 млрдAmazon объявила финансовые результаты IV квартала и 2024 года в целом, завершившегося 31 декабря 2024 года. Итоги за квартал в основном превысили прошлогодние показатели и ожидания аналитиков, но слабый прогноз на I квартал 2025 года вызвал падение акций компании на внебиржевых торгах на 5 %. Слабый прогноз компания объяснила неблагоприятными валютными курсами. За 2024 год выручка Amazon составила $638,0 млрд, увеличившись на 11 % по сравнению с $574,8 млрд в 2023 году. Выручка AWS выросла на 19 % до $107,6 млрд. Операционная прибыль Amazon увеличилась до $68,6 млрд с $36,9 млрд в предыдущем году, у AWS — на 62 % до $39,8 млрд. Акции Amazon выросли на 9 % с начала 2025 года. В 2024 году их рост составил 44 % при росте Nasdaq на 29 %. Выручка Amazon в IV квартале составила $187,79 млрд, что больше результата годичной давности на 10 %, и выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $187,30 млрд. Операционная прибыль компании выросла до $21,2 млрд с $13,2 млрд годом ранее. Чистая прибыль Amazon увеличилась почти вдвое до $20,0 млрд или $1,86 на разводнённую акцию с $10,6 млрд или $1,00 на разводнённую акцию в IV квартале 2023 года при консенсус-прогнозе аналитиков от LSEG в размере $1,49 на разводнённую акцию. Amazon увеличила прибыль за счет сокращения расходов и сохранения устойчивости в высокодоходном облачном бизнесе. Операционная маржа Amazon (прибыль, оставшаяся после учёта расходов на ведение бизнеса) выросла до 11,3 % за IV квартал с 11 % в предыдущем квартале и 7,8 % в IV квартале 2023 года. Гендиректор Amazon Энди Джесси (Andy Jassy) проводит кампанию по сокращению расходов с конца 2022 года. В 2022 и 2023 годах было уволено более 27 тыс. сотрудников. Сокращение рабочих мест продолжалось в 2024 году и проводится в текущем. Выручка облачного подразделения Amazon Web Services (AWS) составила $28,79 млрд, что выше прошлогоднего результата на 19 % и соответствует консенсус-прогнозу аналитиков, опрошенных StreetAccount. Операционная прибыль подразделения выросла до $10,63 млрд с $7,17 млрд годом ранее. Выручка AWS росла в IV квартале быстрее чем годом ранее, когда рост составил 13 %, но его темпы роста по-прежнему ниже, чем у конкурентов. Для сравнения, выручка Azure и других облачных сервисов Microsoft выросла на 31 %, у Google Cloud Platform холдинга Alphabet рост составил 30 %. Компания вкладывает миллиарды долларов в ЦОД и оборудование для них, включая ускорители NVIDIA, на фоне усилившейся конкуренции на рынке ИИ. Также AWS активно развивает собственную серию ускорителей Trainium, чтобы снизить зависимость от NVIDIA — как собственную, так и своих партнёров. Капитальные затраты Amazon составили $27,83 млрд за IV квартал по сравнению с $14,59 млрд в аналогичном квартале годом ранее. За 2024 год капзатраты достигли $83 млрд. По словам финансового директора Amazon Брайана Олсавски (Brian Olsavsky), в 2025 году капзатраты вырастут до $100 млрд. Скачок расходов «в первую очередь связан с AWS, в том числе для поддержки спроса на услуги ИИ, а также с технической инфраструктурой для поддержки североамериканских и международных сегментов». Компания разработала новую архитектуру ИИ ЦОД и скорректировала планы строительства некоторых объектов. Для сравнения: Microsoft в этом году намерена потратить на инфраструктуру $80 млрд, Google — $75 млрд, а Meta✴ — до $65 млрд. Amazon прогнозирует получить в I квартале выручку в пределах от $151 до $155,5 млрд, что означает рост год к году на 5–9 %. Согласно LSEG, аналитики ожидают в текущем квартале выручку в $158,5 млрд. Слабый прогноз компания объясняет влиянием колебаний курса валюты на $2,1 млрд или 150 базисных пунктов.

02.02.2025 [15:17], Сергей Карасёв

Строящийся ИИ ЦОД AWS в Миссисипи подорожал сразу на 60 % — до $16 млрдПланируемые затраты Amazon Web Services (AWS) в рамках масштабного проекта по строительству дата-центров в Миссисипи, по сообщению Bloomberg, увеличились более чем в полтора раза. Это отражает значительный рост расходов на стремительно расширяющуюся инфраструктуру ИИ. Речь идёт об инициативе под названием «Проект Атлас» (Project Atlas), которая впервые была анонсирована в январе 2024 года. Тогда говорилось, что AWS потратит около $10 млрд на создание сети ЦОД в округе Мадисон (Миссисипи, США). Планируется строительство объектов в двух промышленных зонах, а общая площадь кампуса составит примерно 688 га. Проект позволит сформировать не менее 1 тыс. рабочих мест, тогда как сама Amazon получит ряд льгот, включая возврат в размере 3,15 % от затрат на строительство и полное освобождение от налога на продажи и использование оборудования. Кроме того, предусмотрено аннулирование корпоративного подоходного налога на 10 лет. Как теперь сообщается, с момента анонса Project Atlas расходы были пересмотрены в сторону увеличения. Ожидается, что суммарные затраты достигнут $16 млрд, что на 60 % больше первоначальной оценки. Самая значительная часть — $7,2 млрд — пойдёт на серверы, компоненты оптоволоконной сети и другую технологическую инфраструктуру. Ещё в $4,8 млрд обойдутся непосредственно строительные работы. На оборудование, не связанное с IT-системами, потребуется $4 млрд. Отмечается также, что власти Миссисипи предоставили Amazon не только налоговые льготы, но и стимулы на сумму $278 млн. Примерно $172 млн от этих средств пойдёт на модернизацию канализации, включая строительство новой очистной станции, способной обрабатывать до 30 млн литров (30 тыс. тонн) в сутки. Дата-центры генерируют значительные объёмы сточных вод в процессе охлаждения энергоемких серверов и другого оборудования, из-за чего необходимо создание новой сопутствующей инфраструктуры. Местные чиновники говорят, что проект будет стимулировать экономику, формировать высокооплачиваемые рабочие места, а также способствовать развитию смежных отраслей, таких как строительство, жилье и развлечения. В целом, как ожидается, создание дата-центров в США ускорится в ближайшие годы. В частности, OpenAI, Softbank и Oracle анонсировали мегапроект Stargate стоимостью в $500 млрд по развёртыванию дата-центров для ИИ. Вместе с тем Atlas Development предлагает построить неподалёку от Атланты (Джорджия, США) кампус из 13 дата-центров стоимостью $17 млрд. Однако расширение отрасли сдерживается нехваткой энергетических мощностей. Это вынуждает американские энергокомпании пересматривать планы по развитию.

29.01.2025 [15:54], Руслан Авдеев

Британский регулятор CMA выявил проблемы на облачном рынке страны — под ударом AWS и MicrosoftУправление по конкуренции и рынкам Великобритании (CMA) высказало опасение, что рынок публичных облачных сервисов в стране недостаточно конкурентен, сообщает Silicon Angle. Весьма вероятно, что CMA присвоит «стратегический» статус Amazon Web Services (AWS) и Microsoft, считающихся крупнейшими облачными провайдерами Великобритании. Это повлечёт за собой ужесточение внешнего антимонопольного контроля. Расследование CMA стартовало после того, как ещё один местный регулятор Ofcom, отвечающий за телеком-сектор, в апреле 2023 года опубликовал результаты собственных изысканий. Они показали, что ключевые поставщики облачных сервисов могут навредить конкурентам, используя неоднозначные бизнес-практики. Информацию передали в CMA, запустив механизм государственного расследования. Кроме того, Google сама направила жалобу на Microsoft, её поддержала AWS. В CMA обобщили предварительные выводы в семистраничном документе. Одним из ключевых пунктов является вывод о том, что поставщики облачных услуг фактически берут плату за уход клиентов с их платформ. В CMA считают, что подобная практика способна помешать пользователям переносить рабочие нагрузки из одного облака в другое или использовать мультиоблачный подход.

Источник изображения: engin akyurt/unsplash.com С тех пор, как началось расследование, некоторые участники рынка уже скорректировали свои бизнес-модели, в прошлом году платежи за выгрузку данных при миграции на другую платформу отменили AWS и Google, хотя последняя в этом случае требовала полного закрытия аккаунта. Продолжается расследование в отношении софтверного бизнеса Microsoft. По данным CMA, использование Windows Server и SQL Server в Google Cloud и AWS зачастую вдвое дороже, чем в Microsoft Azure. Также выявлен ряд проблем, вытекающих из некоторых экономических и технических факторов, а не из деловой практики облачных операторов. Например, для входа на рынок поставщиков облачных услуг и масштабирования требуются большие вложения, что затрудняет появление и рост альтернативных облачных провайдеров. AWS и Microsoft могут получить статус «стратегических» игроков, если CMA примет решение, что у них есть «существенное и закрепившееся влияние на рынок». Кроме того, для получения такого статуса годовая выручка компаний должна составлять не менее £25 ($31 млрд) млрд в масштабах мира или £1 млрд ($1,24 млрд) в Великобритании. Компании с подобным статусом могут оштрафовать на сумму до 10 % годового мирового дохода за нарушения антимонопольного законодательства. Регулятор также вправе потребовать изменения бизнес-практик — так, CMA рассматривает необходимость потребовать от Microsoft изменить практику лицензирования ПО, а также обязать поставщиков облачных сервисов снизить плату за уход из облака. В Google уже заявили, что рады тому, что в CMA смогли оценить, что такое «ограничительное» лицензирование вредит британским клиентам облачных сервисов, угрожает экономическому росту и мешает инновациям. Позицию поддерживают и в AWS, также пытающейся бороться с монополией Microsoft. Ранее сообщалось, что CMA продлило сроки антимонопольного расследования на облачном рынке страны на четыре месяца — до 4 августа 2025 года. До этого планировалось завершить его до 5 апреля. В Европе Microsoft удалось добиться компромисса с мелкими облачными операторами, ассоциация CISPE отозвала жалобы в ответ на изменения политики IT-гиганта и денежную компенсацию, а позже Microsoft сама вошла в её состав, дополнительно подрывая попытки Google справиться с конкурентом.

27.01.2025 [15:35], Руслан Авдеев

До 2030 года AWS вложит $8,3 млрд в облачную инфраструктуру в МумбаиAmazon Web Services (AWS) намерена инвестировать $8,3 млрд в развитие облачной инфраструктуры в регионе AWS Asia Pacific (Мумбаи), расположенном в индийском штате Махараштра (Maharashtra). По оценкам Amazon, её инвестиции приведут к увеличению ВВП страны на $15,3 млрд к 2030 году. Ещё в 2024 году появилась информация, что AWS купила участок площадью около 15,5 га в Палаве недалеко от Мумбаи. Впервые AWS вышла на рынок Индии в 2016 году, запустив регион Мумбаи. По 2022 год было инвестировано $3,7 млрд, а позднее в 2022 году AWS запустила и облачный регион в Хайдарабаде (Hyderabad). Кроме того, с 2017 года компания обучила 5,9 млн человек навыкам работы с облаками. Новые инвестиции в облачный регион Мумбаи в объёме $8,3 млрд являются частью более масштабного плана. Всего AWS рассчитывает потратить в Индии $12,7 млрд, об этом сообщалось ещё в мае 2023 года. Также планируется открытие локальных зон в Ченнаи, Бангалоре, Дели и Калькутте. Как сообщает ряд изданий, в ходе Всемирного экономического форума в Давосе AWS обещала потратить $6,95 млрд на регион в Хайдарабаде в штате Телингана (Telangana). В 2024 году сообщалось о готовности вложить в штат $2 млрд. В начале 2025 года Microsoft заявила, что инвестирует $3 млрд в ИИ и облачные вычисления в Индии.

25.01.2025 [00:20], Руслан Авдеев

AWS не спешит раскрывать реальные данные о выбросах ЦОД, да и Google с Microsoft ведут себя не лучшеПоскольку всё больше компаний переносят рабочие нагрузки в облако, для их руководства становятся важными экологические показатели самих облаков. Но AWS, как выяснилось, не спешит делиться с клиентами данными о выбросах, сообщает The Register. По словам Canalys, Amazon решила не раскрывать детальные сведения, связанные с экологическими показателями AWS, но предоставила их для остальных подразделений. В Canalys считают AWS главным «плохишом», хотя Google и Microsoft ведут себя немногим лучше. В Canalys подчёркивают, что в последние годы выбросы значительно возросли, причём не только у гиперскейлеров. Нюанс в том, что они, вероятно, более чем в семь раз выше, чем декларируется официально. Во многом это связано с практиками учёта выбросов, применяемых гиперскейлерами — часто они «маскируют» ситуацию, указывая в отчётности выбросы, компенсированные «зелёными» сертификатами на покупку возобновляемой энергии. Та же Amazon не публикует данные с привязкой к местоположению дата-центров AWS, поэтому реальные цифры выяснить практически невозможно.

Источник изображения: Sam Jotham Sutharson/unsplash.com Компания сознательно не выделяет отчётность AWS. Несколько лет назад она начала выпускать ESG-отчёты, но в сравнении с отчётами Google и Microsoft статистика Amazon весьма оптимистична — выбросы, со слов компании, снижаются с 2021 года, хотя AWS растёт стремительными темпами. По итогам 2024 года капитальные затраты компании могут перевалить за $75 млрд, а в 2025 года они станут ещё выше. Большая часть средств уйдёт на облачную инфраструктуру. При этом у Microsoft выбросы выросли почти на 30 % с 2020 года, а у Google — на 48 % с 2019 года. В интервью The Register представитель Canalys отметил, что доступны данные только об общих выбросах Amazon, включая гигантское розничное подразделение. Amazon лишь сообщила, что приняла ряд мер по уменьшению углеродного следа ЦОД, а в прошлом году компенсировала 100 % своих энергозатрат за счёт покупки возобновляемой энергии, что значительно сократило выбросы Scope 2. Microsoft тоже публикует лишь общие данные о выбросах, но всё же выделяет Scope 1, 2 и 3. На вопрос The Register о выбросах именно ЦОД компания не ответила. В Google тоже предпочитают не выделять дата-центры из общей статистики. В Canalys уверены, что прозрачность отчётности становится всё более важной при выборе клиентами поставщиков облачных услуг. При этом AWS продолжает отставать от конкурентов, не предоставляя данных о выбросах Scope 3. Это может создать проблемы в первую очередь для клиентов из Евросоюза с его Директивой о корпоративной отчетности в области устойчивого развития (CSRD), требующей соответствующей информации. Не так давно в отчёте Uptime Institute сообщалось, что приоритетное развитие ИИ грозит неисполнением обязательств по достижению нулевого выброса парниковых газов в заявленные сроки. Ещё год назад эксперты предсказывали отказ операторов ЦОД от прежних «зелёных» обещаний и сокрытие экологических показателей.

21.01.2025 [13:27], Руслан Авдеев

Amazon снова стала крупнейшим в мире корпоративным покупателем возобновляемой энергии в 2024 году

amazon

aws

hardware

аэс

ветроэнергетика

возобновляемая энергия

зеленая энергетика

солнечная энергия

экология

энергетика

Пятый год подряд компания Amazon становится крупнейшим покупателем возобновляемой энергии в мире, сообщает Datacenter Dynamics. В 2024 году компания подписала серию соглашений о ставших уже традиционными поставках солнечной и ветряной энергии, а также обязалась внедрять новые низкоуглеродные решения вроде малых модульных реакторов (SMR). Как заявляют в блоге самой компании, на сегодня она поддержала более 600 проектов ветряной и солнечной энергетики. При этом 40 из них реализуются в странах с высоким уровнем использования ископаемого топлива — Австралии, Китае, Греции, Индии, Индонезии, Польше, а также Южной Африке. Кроме того, прогресс коснулся и традиционных в энергетических пристрастиях штатов вроде Луизианы и Миссисипи. По данным Amazon, приоритет отдаётся проектам в тех регионах, где экобезопасные решения могут максимально сократить выбросы и улучшить местную окружающую среду. Так, в Индии, в основном полагающейся на ископаемое топливо, Amazon вложила средства в девять ветряных и солнечных электростанций. В апреле 2024 года AmpIn Energy Transition запустила солнечную станцию на 100 МВт, которая будет обслуживать потребности AWS в стране. В Польше Amazon будет закупать электричество у двух ветряных электростанций, находящихся в собственности Vortex Energy. В ноябре минувшего года подписано четыре соглашения о покупке ветряной энергии в Греции. Вырабатываемая тремя проектами энергия будет передаваться в греческую электросеть, способствуя общей декарбонизации местной энергетической инфраструктуры. В марте 2024 года подписано PPA c Iberdrola на 159 МВт, источником электричества станет британская ветряная электростанция East Anglia Three, речь идёт о 700 ГВт∙ч ежегодно. В феврале подписано ещё одно PPA с Iberdrola, источником энергии станет ветряная электростанция Juniper IIA на 98,4 МВт в Орегоне. Наконец, в августе того же года Amazon подписала соглашение о закупке 9,5 МВт у Eneos Renewable с солнечной электростанции Kudamatsu в японской префектуре Ямагути. Помимо традиционных закупок, средства вложены и в другие технологии, способные обеспечить стабильную подачу электричества при отсутствии возобновляемых источников в должных объёмах. Всего задействованы технологии хранения и другие решения на 2,7 ГВт. Например, проект Baldy Mesa, включающий 150-МВт солнечную электростанцию и энергохранилище на 75 МВт/300 МВт∙ч, тоже поддерживается Amazon. Большие средства вложены в рынок атомной энергетики — подписаны четыре соглашения, связанные с соответствующими технологиями. Три из них связаны с SMR в Вирджинии и Пенсильвании. Ещё одно связано с покупкой AWS 960-МВт кампуса Cumulus компании Talen Energy. Последняя владеет расположенной поблизости АЭС Susquehanna Steam Electric Station (SSES) на 2,5 ГВт. Talen будет продавать AWS электричество АЭС в рамках PPA сроком на 10 лет и не намерена отказываться от некоторых проектов даже несмотря на противодействие американских регуляторов.

17.01.2025 [07:35], Руслан Авдеев

Amazon подала заявку на прокладку своего первого подводного трансатлантического интернет-кабеляAmazon намерена проложить подводный кабель от южного побережья Ирландии до восточного побережья США. По данным блогеров и местных СМИ, ирландское подразделение Amazon летом прошлого года подало местному регулятору заявку, описывающую планы компании, сообщает Datacenter Dynamics. Amazon MCS Ireland Ltd. намерена провести в графстве Корк геофизические изыскания для выбора маршрута кабеля и местоположения посадочной станции будущей ВОЛС. Кабель должен быть проложен от селения Каслфрик (Castlefreke) до пока не выбранной точки на востоке Соединённых Штатов. В заявке упомянуты два потенциальных вывода кабеля на сушу в Ирландии. Более подробная информация о пропускной способности кабеля и времени реализации проекта не разглашается. Согласно информации Telegeography, Amazon является совладельцем и основным пользователем кабелей Havfrue (AEC-2), Hawaiki, Jupiter и Marea. AEC-2 связывает Ирландию, Норвегию и Данию и США. Совместно с Vodafone ведутся работы над кабелем Beaufort, призванным связать Ирландию и Великобританию. Ранее ожидалось, что он заработает уже в 2024 году. Вместе с тем Amazon отстаёт от Google и Meta✴ по количеству собственных подводных кабельных систем. Большинство подводных кабелей выходят в Ирландии в окрестностях столицы — Дублина. Единственный кабель, выходящий на берег в графстве Корк на станции Cork Internet eXchange/CloudCIX — Exa Express компании Exa. Кабельная система ёмкостью 53 Тбит/с была запущена в 2015 году как цифровой «мост» между Ирландией, Великобританией и Канадой. По мнению экспертов, наличие отличного от остальных кабелей маршрута улучшит надёжность подключения ирландских дата-центров AWS. |

|