Материалы по тегу: сжо

|

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

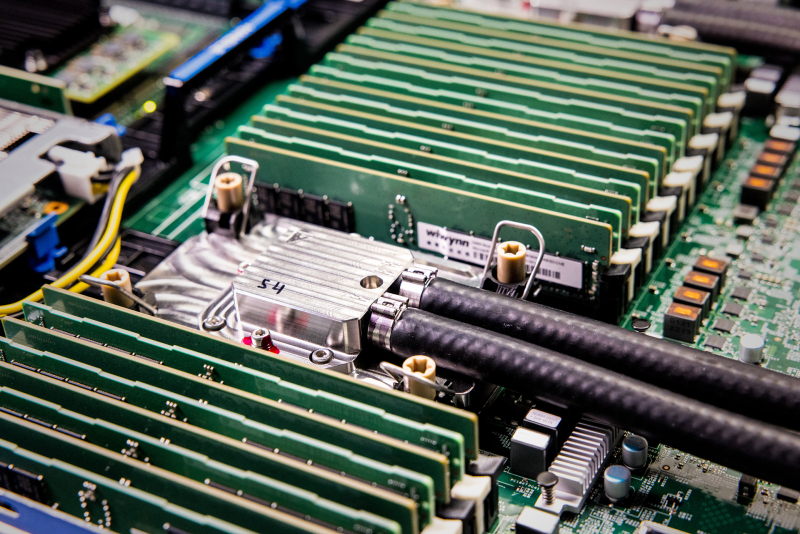

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории.

29.09.2025 [10:35], Сергей Карасёв

JetCool представила модульные CDU для СЖО, способные отвести до 1,8 МВтКомпания JetCool, являющаяся подразделением производителя электроники и инфраструктуры для дата-центров Flex, анонсировала модульные блоки распределения охлаждающей жидкости (CDU), предназначенные для использования в составе масштабных платформ ИИ и НРС. В основу представленного решения положены изделия SmartSense CDU. Это высокопроизводительный CDU, способный справляться с охлаждением ИТ-оборудования суммарной мощностью до 301 кВт. Температура теплоносителя может варьироваться от +15 до +70 °C, а скорость потока достигает 400 л/мин, обещает разработчик. При модульном развёртывании в одной стойке типоразмера 19″ или ORv3 могут быть размещены до шести CDU. Таким образом, суммарная охлаждающая ёмкость достигает 1,8 МВт. Это обеспечивает высокую плотность вычислений на единицу площади, что позволяет экономить пространство в дата-центре. Кроме того, допускается формирование различных конфигураций CDU, серверов и хранилищ данных на базе одной и той же стойки. Благодаря показателю расхода 1–1,5 л/мин/кВт возможно эффективное охлаждение различного оборудования при разных рабочих нагрузках, говорит компания. Разработчик говорит об использовании насосов с резервированием, функционирующих на скорости 3600 об/мин. За счёт этого достигается не только высокая надёжность, но и низкий уровень шума. Благодаря модульности операторы ЦОД могут постепенно наращивать мощность и быстро адаптироваться к меняющимся потребностям. Flex придерживается комплексного подхода в отношении компонентов СЖО — от проектирования и производства до развёртывания и поддержки. Таким образом, клиенты могут реализовывать проекты в более короткие сроки при сокращении количества точек взаимодействия с поставщиками, сообщается в пресс-релизе.

27.09.2025 [16:18], Сергей Карасёв

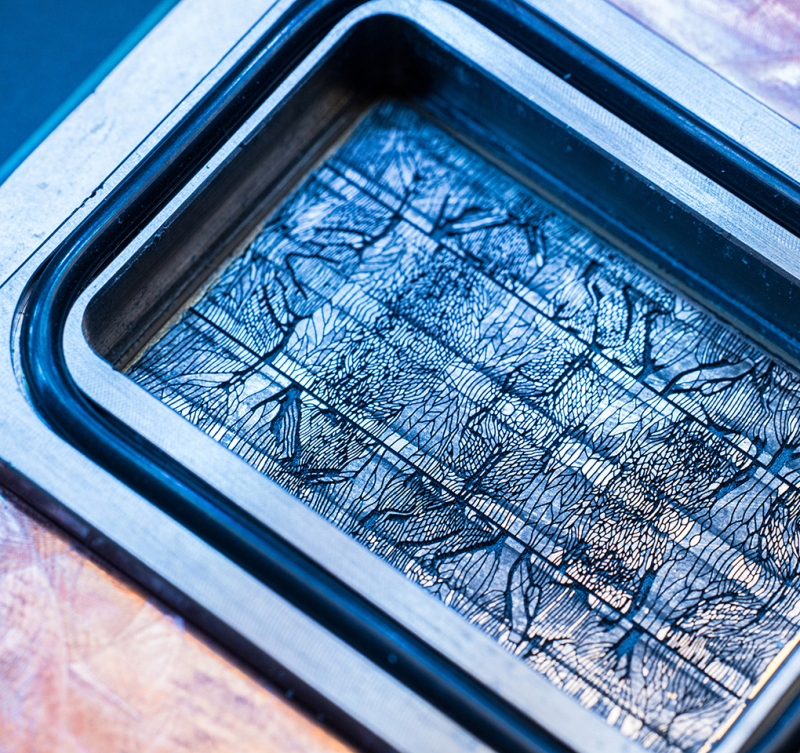

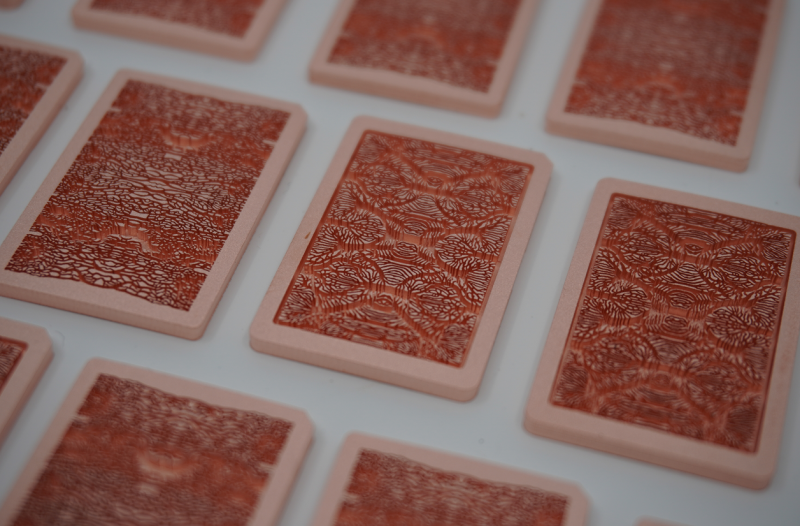

Чип с «сосудами»: Microsoft и Corintis вытравили микроканалы для СЖО прямо в кремнииВедущие разработчики ИИ-ускорителей продолжают наращивать мощность своих устройств, что требует применения передовых систем охлаждения. Речь идёт прежде всего о системах прямого жидкостного охлаждения, способных отводить тепло непосредственно от поверхности чипов. Корпорация Microsoft сообщила о разработке совместно со швейцарским стартапом Corintis альтернативной СЖО, которая охлаждает процессоры изнутри. Новая технология базируется на принципах микрогидродинамики (microfluidic). Подход основан на формировании крошечных каналов на обратной стороне кремниевого кристалла: циркулируя через эти канавки, жидкость эффективно отводит тепло от наиболее горячих зон чипа. Для оптимизации расположения каналов, которые по толщине сопоставимы с человеческим волосом, использовался ИИ. Полученный рисунок вытравленных канавок напоминает прожилки на листе дерева или крыло бабочки. При разработке системы нужно было убедиться, что каналы обеспечивают возможность циркуляции необходимого объема охлаждающей жидкости без засорения, но при этом не ухудшают прочность кристалла из-за своих размеров и расположения. Только за последний год команда Microsoft опробовала четыре разных варианта конструкции. Для практического использования такой СЖО потребовалась разработка герметичного корпуса для чипов. Кроме того, были опробованы различные методы травления каналов: специалистам пришлось создать пошаговую схему добавления этапа травления в стандартный процесс производства чипов. Наконец, была разработана специальная формула охлаждающей жидкости. По заявлениям Microsoft, предложенная технология по сравнению с традиционными водоблоками способна повысить эффективность отвода тепла до трёх раз — в зависимости от нагрузки и конфигурации. При этом максимальный рост температуры кремния внутри GPU снижается на 65 %, хотя этот показатель варьируется в зависимости от типа чипа. Плюс к этому повышается энергоэффективность. В дальнейшем Microsoft намерена изучить возможность внедрения технологии охлаждения нового типа в будущие поколения собственных изделий для дата-центров. Корпорация также сотрудничает с производителями и партнёрами по вопросу использования предложенного решения. Предполагается, что в дальнейшем результаты работы откроют путь к совершенно новым архитектурам микросхем, основанным на 3D-компоновке: в этом случае охлаждающая жидкость сможет протекать через слои в многоярусных чипах. Между тем стартап Corintis, основанный на базе Федеральной политехнической школы Лозанны (EPFL), провёл раунд финансирования Series A, в ходе которого на развитие привлечено $24 млн. Инвестиционную программу возглавил BlueYard Capital при участии Founderful, Acequia Capital, Celsius Industries и XTX Ventures. Таким образом, на сегодняшний день компания получила в общей сложности $33,4 млн. Corintis направит средства на расширение деятельности и дальнейшее развитие новой технологии охлаждения чипов. Будут открыты несколько офисов в США и инженерный центр в Мюнхене.

26.09.2025 [10:33], Руслан Авдеев

Media Stream AI построит в Манчестере 2-МВт ИИ ЦОД с охлаждением водой из местного каналаБританская медиакомпания Media Stream AI (MSAI) намерена открыть в Солфорде (Salford, Большой Манчестер) дата-центр в популярном «творческом» районе Media City. Объект мощностью 2 МВт будет использовать для охлаждения воду из канала Рочдейл (Rochdale), сообщает Datacenter Dynamics. Система охлаждения будет состоять из замкнутого контура с теплообменниками и драйкулеров. При поддержке Lenovo объект стоимостью £50 млн ($67,3 млн) сможет обеспечить плотность стоек на уровне 30–60 кВт при PUE менее 1,2. На площадке планируется разместить 1,1 тыс. ускорителей NVIDIA H200 в составе серверов Lenovo ThinkSystem с СЖО Neptune. В будущем возможно расширение до 2,3 тыс. ускорителей. Объект должен заработать в I квартале 2026 года. Компания намерена создать там же собственную виртуальную продакшн-студию и робототехническую лабораторию. Media Stream AI рассчитывает предоставлять ИИ-сервисы медиакомпаниям и работникам творческих профессий. На сайте стартапа объявлено, что он намерен предоставить доступ к ускорителям NVIDIA L4, A10G, A4000, A5000, A100, H100 и L40. Также компания намерена развернуть к концу 2026 года площадки в Германии и Франции. Более того, MSAI заключила соглашение с властями Ямайки о строительстве и эксплуатации первого на острове ИИ ЦОД. Прецеденты использования похожих систем охлаждения есть. Например, Digital Realty использует для охлаждения ЦОД во Франции и Великобритании проточную речную воду. Green Mountain намерена развернуть систему охлаждения речной водой на своём новом объекте в Германии. Речное охлаждение также используют Denv-R во Франции и Nautilus в Калифорнии. Наконец, сеть европейских супермаркетов Lidl объявила, что один из её ЦОД в Германии тоже использует охлаждение речной водой, а норвежский оператор дата-центров Polar утверждает, что для охлаждения одного из своих ЦОД намерен использовать близлежащую реку. Участвуют в подобных проектах и гиперскейлеры. Площадка Google в Финляндии использует для охлаждения и морскую воду.

25.09.2025 [11:28], Сергей Карасёв

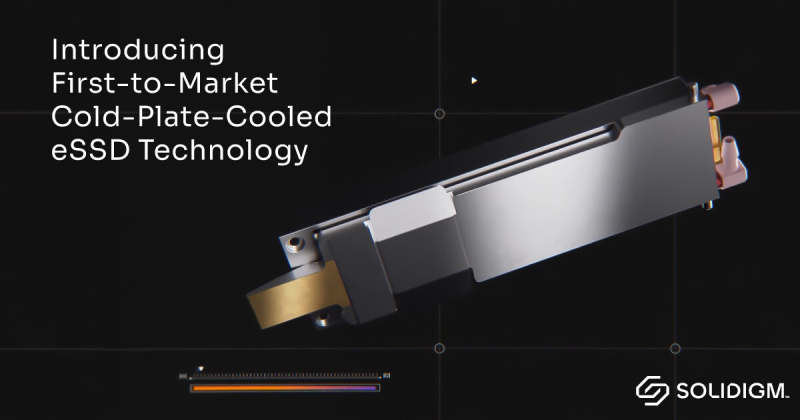

Solidigm представила первые в мире E1.S SSD с СЖО для ИИ-серверовКомпания Solidigm, принадлежащая южнокорейской SK Hynix, анонсировала, как утверждается, первые в мире SSD формата E1.S, оснащённые системой жидкостного охлаждения. Устройства предназначены для использования в безвентиляторных серверах с высокой плотностью компоновки, ориентированных на приложения ИИ. О новой СЖО для SSD впервые стало известно в марте нынешнего года. Решение предполагает использование охлаждающей пластины, которая располагается с одной стороны накопителя. При этом сами водоблоки и SSD монтируются бок о бок в дисковой корзине, что позволяет отводить тепло от обеих сторон твердотельного устройства хранения. Допускается горячая замена накопителей. СЖО подходит для использования с накопителями Solidigm D7-PS1010 стандарта E1.S толщиной 9,5 и 15 мм. Эти изделия, построенные на 176-слойных чипах флеш-памяти TLC 3D NAND, оснащены интерфейсом PCIe 5.0 x4 (NVMe). Доступны варианты вместимостью 3,84 и 7,68 Тбайт. Скорость передачи данных при последовательном чтении достигает 14 500 Мбайт/с, при последовательной записи — 10 500 Мбайт/с (8400 Мбайт/с у модификации на 3,84 Тбайт). Показатель IOPS при произвольном чтении находится в диапазоне 3,2–3,3 млн, при произвольной записи — 315–400 тыс.

Solidigm отмечает, что СЖО обеспечивает целенаправленный отвод тепла непосредственно от критически важных компонентов по обеим сторонам SSD, благодаря чему повышаются стабильность и производительность при высоких нагрузках. При этом увеличивается плотность монтажа компонентов, что помогает экономить пространство в серверах и, в конечном итоге, в дата-центрах. Компания Solidigm сотрудничает с ведущими производителями серверного оборудования для интеграции нового решения в передовые ИИ-системы. В число партнёров, в частности, входит Supermicro. Утверждается, что новые SSD могут использоваться в самых современных архитектурах с жидкостным охлаждением, включая серверы Supermicro на базе NVIDIA HGX B300.

22.09.2025 [11:40], Сергей Карасёв

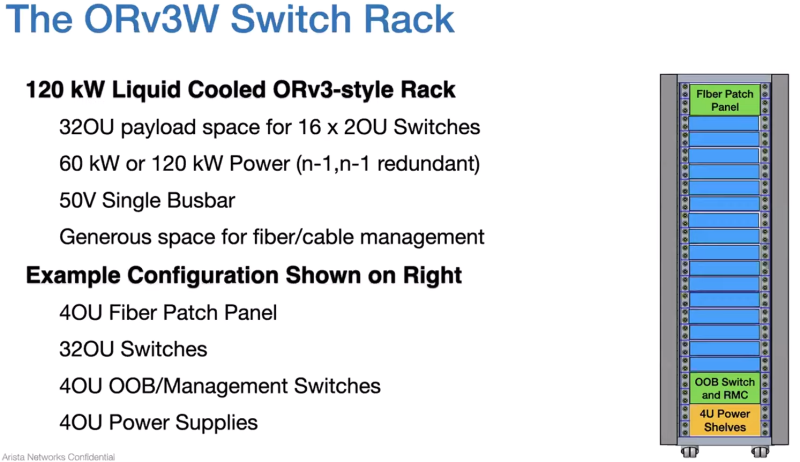

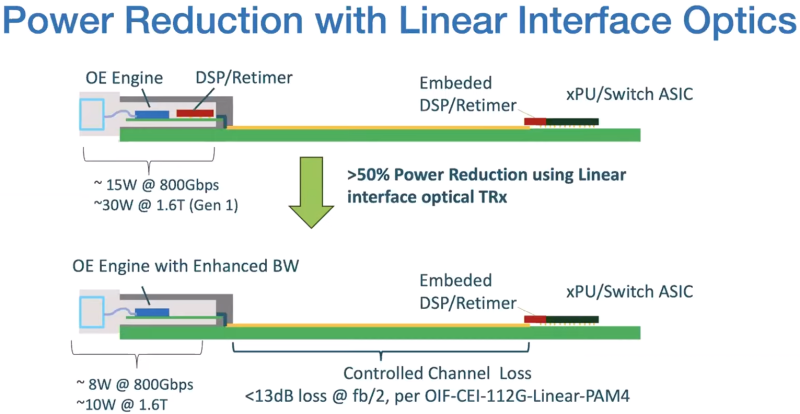

Arista проектирует коммутаторы с СЖО для ИИ ЦОДКомпания Arista, по сообщениям интернет-источников, поделилась планами по созданию оборудования для дата-центров. В разработке в числе прочего находятся коммутаторы и серверные стойки с жидкостным охлаждением. Как рассказал соучредитель Arista Андреас Бехтольшайм (Andreas Bechtolsheim), проектируемые коммутаторы будут на 100 % использовать СЖО. Это, как ожидается, обеспечит экономию электроэнергии на системном уровне от 5 % до 10 % в зависимости от температуры и повысит надёжность из-за отсутствия вибраций, вызываемых вентиляторами. NVIDIA уже анонсировала свои коммутаторы с СЖО. Кроме того, разрабатывается серверная стойка стандарта ORv3W, поддерживающая мощность до 120 кВт. Она сможет вместить до 16 2OU-коммутаторов, а также блоки управления, силовые полки и коммутационные панели. Стойка будет оснащена специальными фитингами для развёртывания СЖО и единой шиной питания. По словам Бехтольшайма, значительная часть разработок Arista связана с новыми системами охлаждения. Применение СЖО позволит создавать конфигурации с высокой плотностью размещения коммутаторов. Это важно в свете строительства ЦОД нового поколения, ориентированных на ресурсоёмкие задачи ИИ и НРС. Соучредитель Arista также затронул тему LPO (Linear Pluggable Optics) — технологии, которая позволяет формировать прямые соединения между оптоволоконными модулями, устраняя необходимость в традиционных компонентах вроде цифровых сигнальных процессоров (DSP). Бехтольшайм отмечает, что LPO может обеспечить дополнительную экономию энергии на 20 % по сравнению с другими оптическими системами. По его мнению, в перспективе данная технология будет востребована в сетях, поддерживающих приложения ИИ.

21.09.2025 [13:40], Сергей Карасёв

Schneider Electric готовит стойки NVIDIA GB300 NVL72 мощностью 142 кВтКомпания Schneider Electric анонсировала две эталонные платформы, призванные ускорить построение инфраструктур для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ и НРС. Разработка систем ведётся в партнёрстве с NVIDIA. Один из проектов предусматривает создание референсных стоек для суперускорителей NVIDIA GB300 NVL72. Такие стойки смогут обеспечивать мощность до 142 кВт. Предусмотрено использование жидкостного охлаждения. В одном машинном зале могут быть расположены три кластера GB300 NVL72, насчитывающих в общей сложности до 1152 ускорителей. Отмечается, что в основу решения положены наработки и опыт, полученные в ходе реализации аналогичного проекта для NVIDIA GB200 NVL72. Клиентам будет доступна специальная среда моделирования на базе вычислительной гидродинамики (CFD): могут применяться цифровые двойники для оценки различных конфигураций электропитания и охлаждения с целью оптимизации платформ под определённые нужды.

Источник изображения: Schneider Electric Второй эталонный проект, как утверждается, представляет собой первую и единственную в отрасли платформу, предполагающую интеграцию систем управления питанием и жидкостным охлаждением, включая решения Motivair (контрольный пакет акций этой фирмы Schneider Electric приобрела в конце 2024 года). Для новой платформы заявлена совместимость с NVIDIA Mission Control — программным обеспечением NVIDIA для контроля производственных процессов и оркестрации работы ИИ-систем, включая управление кластерами и рабочими нагрузками. В таких системах могут применяться суперускорители GB300 NVL72 и GB200 NVL72. Подчёркивается, что новые эталонные решения являются результатом продолжающегося сотрудничества Schneider Electric и NVIDIA, которое направлено на удовлетворение растущих потребностей операторов дата-центров в области ИИ.

15.09.2025 [12:27], Сергей Карасёв

Квартальные затраты на рынке физической инфраструктуры ЦОД приблизились к $9 млрд — продажи СЖО подскочили на 156 %По оценкам Dell'Oro Group, расходы на мировом рынке физической инфраструктуры дата-центров во II квартале текущего года достигли $8,9 млрд. Это на 18 % больше по сравнению с аналогичным периодом 2024-го, когда объём отрасли оценивался примерно в $7,5 млрд. Аналитики учитывают затраты на системы охлаждения, питания и пр. Отмечается, что основным драйвером рынка является стремительное внедрение ИИ, на фоне которого операторы ЦОД и гиперскейлеры активно наращивают вычислительные мощности. Третий квартал подряд рост расходов на инфраструктуру ЦОД в годовом исчислении превышает 10 %. В сегменте систем охлаждения зафиксирован рост на 29 % по отношению ко II четверти 2024 года. При этом продажи решений прямого жидкостного охлаждения (DLC) подскочили на 156 %. Как отмечает Dell'Oro Group, такие системы фактически становятся стандартом для крупных вычислительных кластеров ИИ. В сфере распределения энергии затраты поднялись в годовом исчислении на 26 %. Драйвером данного сектора является внедрение серверных стоек с высокой плотностью размещения оборудования для поддержания ресурсоёмких нагрузок ИИ. Выручка в секторе ИБП выросла на 13 %, достигнув $3,3 млрд. При этом наибольший спрос наблюдался в области трёхфазных решений мощностью 251 кВА и больше. В географическом плане во II квартале 2025 года лидировала Северная Америка с ростом около 23 %: затраты на строительство дата-центров в США достигли исторического максимума. В Европе, на Ближнем Востоке и в Африке (EMEA), а также в Азиатско-Тихоокеанском регионе темпы ниже, но в дальнейшем ожидается повышение рыночной активности. В мировом масштабе более 80 % роста во II квартале текущего года пришлось на гиперскейлеров и колокейшн-провайдеров, что указывает на их центральную роль в развитии ИИ ЦОД.

12.09.2025 [11:35], Сергей Карасёв

150 кВт на стойку для тестов: Digital Realty открыла лабораторию DRIL для ускорения внедрения ИИ и гибридного облакаОператор дата-центров Digital Realty объявил об открытии лаборатории инноваций DRIL (Digital Realty Innovation Lab) — специализированной тестовой площадки, призванной ускорить внедрение ИИ и гибридного облака. Партнёрами в рамках данного проекта являются Lenovo, AMD, Cisco и CommScope, которые предоставляют различные аппаратные и инфраструктурные решения. Отмечается, что ИИ оказывает преобразующее влияние на самые разные отрасли. Однако при его масштабном развёртывании предъявляются высокие требования к инфраструктуре ЦОД в плане обеспечения необходимой производительности при одновременной оптимизации энергопотребления. Площадка DRIL призвана помочь компаниям в создании сложных архитектур, ориентированных на ресурсоёмкие задачи ИИ. DRIL предоставляет партнёрам и клиентам полностью поддерживаемую реальную тестовую среду для апробации ИИ-развёртываний и гибридных облачных сред перед их масштабированием. Компании могут запускать собственные рабочие нагрузки с целью проверки эффективности и оптимизации.

Источник изображения: Digital Realty Лаборатория DRIL сформирована на базе кампуса Digital Realty в Северной Вирджинии. На площадке, оснащённой серверами с процессорами AMD EPYC и ускорителями AMD Instinct, могут тестироваться рабочие нагрузки ИИ и HPC. Говорится о высокоплотном размещением оборудования — свыше 150 кВт на серверную стойку. Задействована технология прямого жидкостного охлаждения (DLC) Lenovo Neptune. Лаборатория DRIL, как подчёркивается, позволяет компаниям раскрыть весь потенциал ИИ и корпоративных рабочих нагрузок, даже если у них нет собственного дата-центра с современным оборудованием. Используя DRIL, клиенты могут снизить риски, оптимизировать конфигурацию своих систем и ускорить переход от этапа проверки концепции к фактическому внедрению. Предприятия могут тестировать различные сценарии задержек в разных локациях, оценивать требования к питанию, охлаждению и GPU-ресурсам, а также управлять ИИ-нагрузками.

01.09.2025 [23:40], Руслан Авдеев

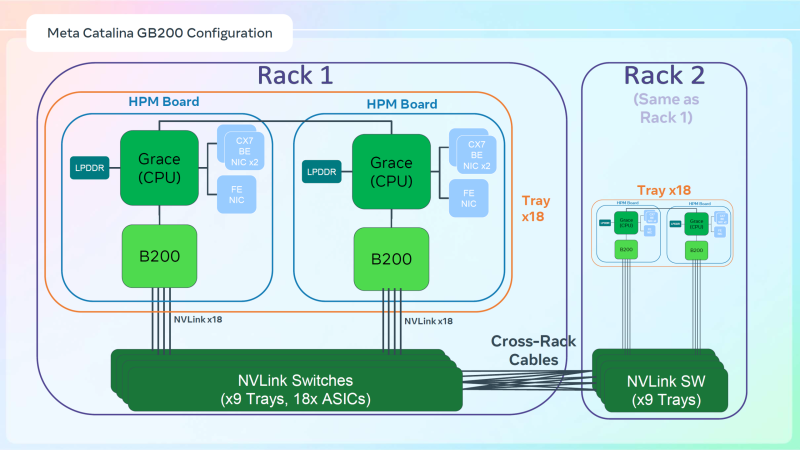

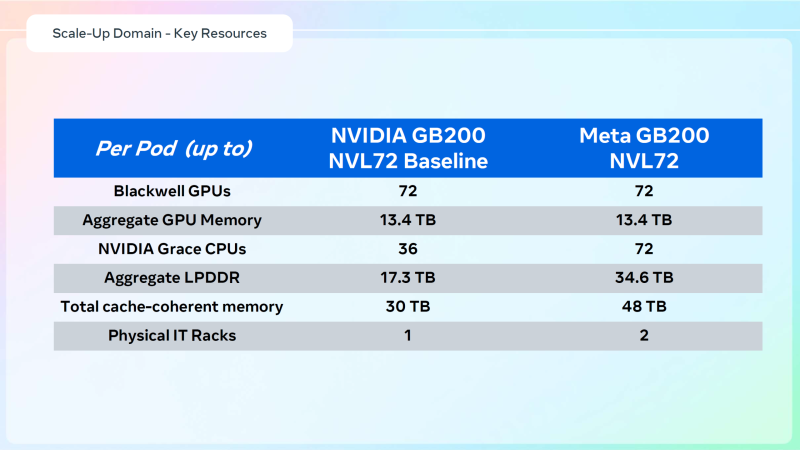

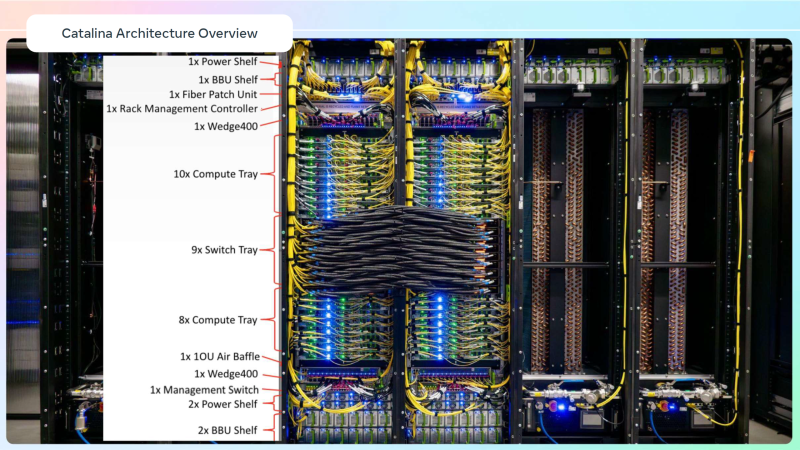

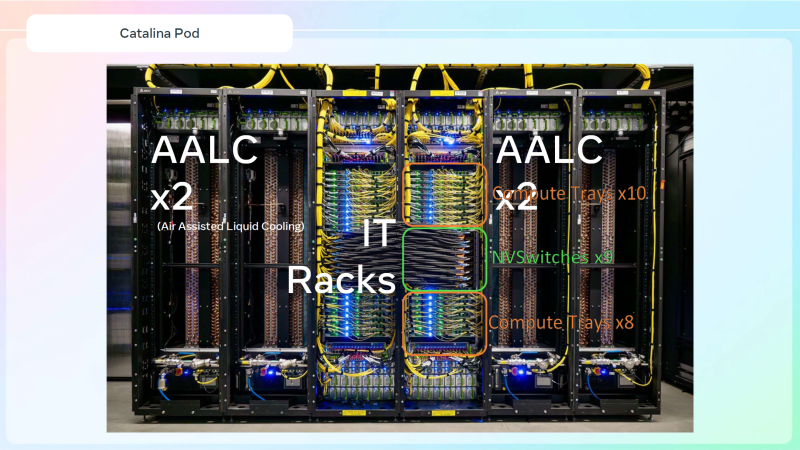

Meta✴ «растянула» суперускорители NVIDIA GB200 NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждениемДля того, чтобы развернуть в традиционных ЦОД с воздушным охлаждением современные высокоплотные стойки с ИИ-ускорителями, приходится идти на ухищрения. Один из вариантов предложила Meta✴, передаёт Wccftech. Хотя у Meta✴ есть собственный полноценный вариант суперускорителя NVIDIA GB200 NVL72 на базе ORv3-стоек Catalina (до 140 кВт) со встроенными БП и ИБП, компания также разработала также вариант, схожий с конфигурацией NVL36×2, от производства которого NVIDIA отказалась, посчитав его недостаточно эффективным. Ускоритель NVL36×2 задумывался как компромиссный вариант для ЦОД с воздушным охлаждением — одна стойка (плата Bianca, 72 × B200 и 36 × Grace) «растянута» на две.

Источник изображений: Meta✴ via Wccftech Meta✴ пошла несколько иным путём. Она точно так же использует две стойки, одна конфигурация узлов другая. Если в версии NVIDIA в состав одно узла входят один процессор Grace и два ускорителя B200, то у Meta✴ соотношение CPU к GPU уже 1:1. Все вместе они точно так же образуют один домен с 72 ускорителями, но объём памяти LPDDR5 в два раза больше — 34,6 Тбайт вместо 17,3 Тбайт. Эту пару «обрамляют» четыре стойки — по две с каждый стороны. Для охлаждения CPU и GPU по-прежнему используется СЖО, теплообменники которой находятся в боковых стойках и продуваются холодным воздухом ЦОД. Это далеко не самая эффективная с точки зрения занимаемой площади конструкция, но в случае гиперскейлеров оплата в арендуемых дата-центрах нередко идёт за потребляемую энергию, а не пространство. В случае невозможности быстро переделать собственные ЦОД или получить площадку, поддерживающую высокоплотную энергоёмкую компоновоку стоек и готовую к использованию СЖО, это не самый плохой вариант. В конце 2022 года Meta✴ приостановила строительство около дюжины дата-центров для пересмотра их архитектуры и внедрения поддержки ИИ-стоек и СЖО. Первые ЦОД Meta✴, построенные по новому проекту, должны заработать в 2026 году, передаёт DataCenter Dynamics. На сегодня у Meta✴ около 30 действующих или строящихся кампусов ЦОД, большей частью на территории США. Планируются ещё несколько кампусов, включая гигаваттные. Также компания выступает крупным арендатором дата-центров, а сейчас в пылу гонки ИИ и вовсе переключилась на быстровозводимые тенты вместо капитальных зданий, лишённые резервного питания и традиционных систем охлаждения. Собственные версии GB200 NVL72 есть у Google, Microsoft и AWS. Причём все они отличаются от эталонного варианта, который среди крупных игроков, похоже, использует только Oracle. Так, AWS решила разработать собственную СЖО, в том числе из-за того, что ей жизненно необходимо использовать собственные DPU Nitro. Google ради собственного OCS-интерконнекта «пристроила» к суперускорителю ещё одну стойку с собственным оборудованием. Microsoft же аналогично Meta✴ добавила ещё одну стойку с теплообменниками и вентиляторами. |

|