Материалы по тегу: ии

|

26.09.2025 [13:01], Руслан Авдеев

OpenAI заказала у CoreWeave ИИ-мощности ещё на $6,5 млрд — общая сумма контрактов выросла до $22,4 млрдCoreWeave расширила партнёрские отношения с OpenAI, заключив новое соглашение на сумму $6,5 млрд. Таким образом, общая сумма контрактов с OpenAI достигла $22,4 млрд, сообщает Reuters. Речь идёт уже о третьей крупном заказе OpenAI мощностей у CoreWeave в этом году. Первоначальный договор на $11,9 млрд заключили в марте 2025 года, в мае последовало новое соглашение на $4 млрд. Партнёры продолжают углублять сотрудничество, поскольку OpenAI ищет всё новые вычислительные мощности. Объявление последовало за анонсом, обещающим крупные обновления инфраструктурного проекта Stargate, курируемого OpenAI. На днях компания объявила, что намерена открыть в США пять новых ЦОД совместно с Oracle и SoftBank. В компании утверждают, что совокупная мощность пяти новых площадок, флагманского объекта в техасском Абилине (Abilene и проектов с CoreWeave составит до 7 ГВт, а инвестиции — более $400 млрд в следующие три года. В CoreWeave заявляют, что предложение на рынке очень отстаёт от спроса. В компании стремятся диверсифицировать свои партнёрские отношения, сократив зависимость от Microsoft, которая некогда была эксклюзивным поставщиком инфраструктуры для создателей ChatGPT. В 2024 году на инфраструктуру для Microsoft (в интересах OpenAI) приходилось 62 % выручки CoreWeave. Однако разлад между OpenAI и Microsoft усиливается, так что последняя теперь намерена самостоятельно наращивать ИИ-мощности. CoreWeave же обещает «квартал диверсификации» с привлечением «действительно замечательных, известных и кредитоспособных клиентов». Ранее на этой неделе NVIDIA заявила, что намерена инвестировать до $100 млрд в OpenAI и поставит ей ИИ-ускорители для дата-центров, это знаменует собой объединение крупнейших отраслевых бизнесов в гонке ИИ. Сделка NVIDIA и OpenAI обеспечит первой долю в капитале одного из крупнейших клиентов и уже вызвала опасения у антимонопольных органов. Более того, NVIDIA также инвестировала и в CoreWeave, она владеет более 5 % компании и является вторым по величине её клиентом (15 %). CoreWeave, в свою очередь, приобрела немало оборудования NVIDIA и подписала с компанией соглашение на $6,3 млрд, согласно которому производитель чипов гарантированно выкупит все облачные мощности, не проданные клиентам до апреля 2032 года.

26.09.2025 [11:35], Сергей Карасёв

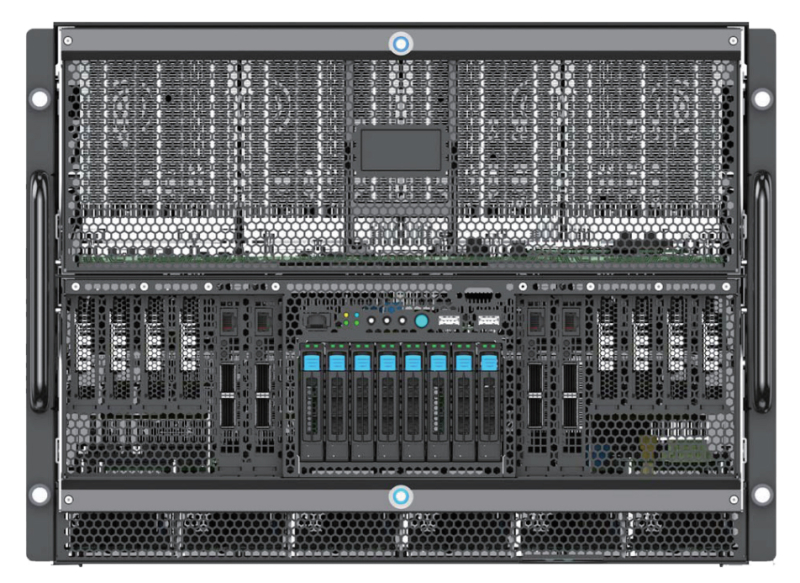

Стартап FuriosaAI представил ИИ-сервер NXT RNGD с производительностью 4 ПфлопсЮжнокорейский стартап FuriosaAI анонсировал высокопроизводительный сервер NXT RNGD для ресурсоёмких нагрузок ИИ. Утверждается, что в сценариях частного облака и локальных дата-центров новинка обеспечивает большую эффективность и меньшую стоимость владения по сравнению с решениями, оборудованными ускорителями на базе GPU. Система NXT RNGD заключена в корпус форм-фактора 4U. Она оснащена восемью специализированными ускорителями RNGD, которые выполнены в виде карт расширения PCIe 5.0 x16. Каждая из карт располагает 48 Гбайт памяти HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт памяти SRAM (384 Тбайт/с). Таким образом, суммарный объём памяти HBM3 составляет 384 Гбайт.

Источник изображения: FuriosaAI Ускорители RNGD обладают ИИ-производительностью до 512 Тфлопс в режиме FP8 и до 512 TOPS в режиме INT8. Таким образом, сервер NXT RNGD демонстрирует показатели до 4 Пфлопс и 4 тыс. TOPS соответственно. При этом общая потребляемая мощность составляет 3 кВт против 10,2 кВт у NVIDIA DGX H100. Таким образом, как отмечает FuriosaAI, стандартная серверная стойка мощностью 15 кВт способна вместить до пяти систем NXT RNGD, в то время как в случае NVIDIA DGX H100 может поддерживаться работа только одной машины. Среди других преимуществ платформы NXT RNGD разработчик называет простоту и удобство развёртывания в любом месте (в том числе с ограничениями по доступной мощности), суверенитет данных (подходит для приложений с обработкой конфиденциальной информации), гибкость в плане новых вариантов использования (доступен комплект SDK) и существенное снижение совокупной стоимости владения. В настоящее время сервер предлагается для тестирования клиентам по всему миру. Приём заказов на NXT RNGD начнётся в 2026 году.

26.09.2025 [10:33], Руслан Авдеев

Media Stream AI построит в Манчестере 2-МВт ИИ ЦОД с охлаждением водой из местного каналаБританская медиакомпания Media Stream AI (MSAI) намерена открыть в Солфорде (Salford, Большой Манчестер) дата-центр в популярном «творческом» районе Media City. Объект мощностью 2 МВт будет использовать для охлаждения воду из канала Рочдейл (Rochdale), сообщает Datacenter Dynamics. Система охлаждения будет состоять из замкнутого контура с теплообменниками и драйкулеров. При поддержке Lenovo объект стоимостью £50 млн ($67,3 млн) сможет обеспечить плотность стоек на уровне 30–60 кВт при PUE менее 1,2. На площадке планируется разместить 1,1 тыс. ускорителей NVIDIA H200 в составе серверов Lenovo ThinkSystem с СЖО Neptune. В будущем возможно расширение до 2,3 тыс. ускорителей. Объект должен заработать в I квартале 2026 года. Компания намерена создать там же собственную виртуальную продакшн-студию и робототехническую лабораторию. Media Stream AI рассчитывает предоставлять ИИ-сервисы медиакомпаниям и работникам творческих профессий. На сайте стартапа объявлено, что он намерен предоставить доступ к ускорителям NVIDIA L4, A10G, A4000, A5000, A100, H100 и L40. Также компания намерена развернуть к концу 2026 года площадки в Германии и Франции. Более того, MSAI заключила соглашение с властями Ямайки о строительстве и эксплуатации первого на острове ИИ ЦОД. Прецеденты использования похожих систем охлаждения есть. Например, Digital Realty использует для охлаждения ЦОД во Франции и Великобритании проточную речную воду. Green Mountain намерена развернуть систему охлаждения речной водой на своём новом объекте в Германии. Речное охлаждение также используют Denv-R во Франции и Nautilus в Калифорнии. Наконец, сеть европейских супермаркетов Lidl объявила, что один из её ЦОД в Германии тоже использует охлаждение речной водой, а норвежский оператор дата-центров Polar утверждает, что для охлаждения одного из своих ЦОД намерен использовать близлежащую реку. Участвуют в подобных проектах и гиперскейлеры. Площадка Google в Финляндии использует для охлаждения и морскую воду.

25.09.2025 [11:37], Сергей Карасёв

Edgecore Networks представила ИИ-сервер AGS8600 на базе AMD EPYC Turin и Instinct MI325XКомпания Edgecore Networks анонсировала сервер AGS8600 формата 8U, построенный на аппаратной платформе AMD. Устройство, уже доступное для заказа, предназначено для решения ресурсоёмких задач в сферах ИИ, машинного обучения, НРС, научных исследований и пр. Система несёт на борту два 64-ядерных процессора EPYC 9575F поколения Turin с показателем TDP в 400 Вт. Доступны 24 слота для модулей оперативной памяти DDR5. Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 (NVMe): базовая конфигурация включает шесть SSD вместимостью 7,68 Тбайт каждый и два SSD на 1,92 Тбайт. Сервер укомплектован восемью GPU-ускорителями Instinct MI325X с 256 Гбайт памяти HBM3e и производительностью до 2,6 Пфлопс в режиме FP8. Задействованы семь линий Infinity Fabric в расчёте на GPU. В оснащение включены восемь однопортовых сетевых адаптеров BCM957608-P1400GDF00 400G QSFP112-DD PCIe Ethernet NIC. Кроме того, присутствуют два двухпортовых адаптера BCM957608-P2200GQF00 200GbE QSFP112 PCIe Ethernet NIC, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, два порта USB 3.0 и интерфейс D-Sub. За возможности расширения отвечают восемь слотов PCIe 5.0 x16 для карт половинной высоты и четыре разъёма PCIe 5.0 x16 для карт полной высоты. Питание обеспечивают шесть блоков мощностью 3300 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с 15 вентиляторами, допускающими горячую замену. Габариты составляют 448 × 850 × 351 мм. Диапазон рабочих температур — от +10 до +35 °C. На сервере используется ОС с ядром Linux. Среди поддерживаемого ПО упомянуты ROCm 6.2.4, RCCL 2.20.5, PyTorch 2.3/2.2/2.1/2.0/1.13, TensorFlow 2.16.1/2.15.1/2.14.1, JAX 0.4.26 и ONNX Runtime 1.17.3.

25.09.2025 [11:28], Сергей Карасёв

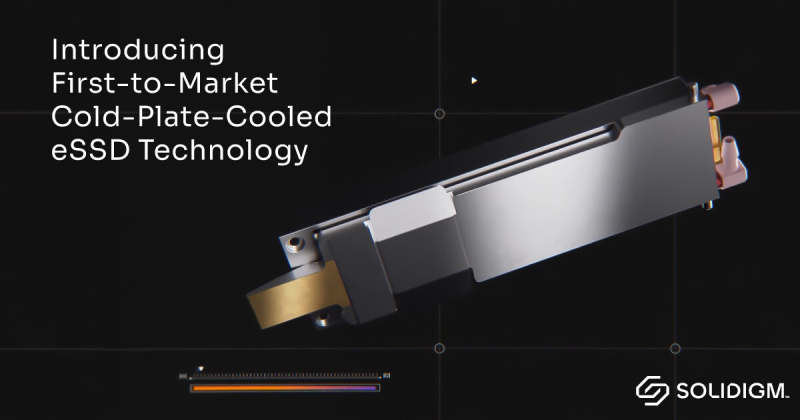

Solidigm представила первые в мире E1.S SSD с СЖО для ИИ-серверовКомпания Solidigm, принадлежащая южнокорейской SK Hynix, анонсировала, как утверждается, первые в мире SSD формата E1.S, оснащённые системой жидкостного охлаждения. Устройства предназначены для использования в безвентиляторных серверах с высокой плотностью компоновки, ориентированных на приложения ИИ. О новой СЖО для SSD впервые стало известно в марте нынешнего года. Решение предполагает использование охлаждающей пластины, которая располагается с одной стороны накопителя. При этом сами водоблоки и SSD монтируются бок о бок в дисковой корзине, что позволяет отводить тепло от обеих сторон твердотельного устройства хранения. Допускается горячая замена накопителей. СЖО подходит для использования с накопителями Solidigm D7-PS1010 стандарта E1.S толщиной 9,5 и 15 мм. Эти изделия, построенные на 176-слойных чипах флеш-памяти TLC 3D NAND, оснащены интерфейсом PCIe 5.0 x4 (NVMe). Доступны варианты вместимостью 3,84 и 7,68 Тбайт. Скорость передачи данных при последовательном чтении достигает 14 500 Мбайт/с, при последовательной записи — 10 500 Мбайт/с (8400 Мбайт/с у модификации на 3,84 Тбайт). Показатель IOPS при произвольном чтении находится в диапазоне 3,2–3,3 млн, при произвольной записи — 315–400 тыс.

Solidigm отмечает, что СЖО обеспечивает целенаправленный отвод тепла непосредственно от критически важных компонентов по обеим сторонам SSD, благодаря чему повышаются стабильность и производительность при высоких нагрузках. При этом увеличивается плотность монтажа компонентов, что помогает экономить пространство в серверах и, в конечном итоге, в дата-центрах. Компания Solidigm сотрудничает с ведущими производителями серверного оборудования для интеграции нового решения в передовые ИИ-системы. В число партнёров, в частности, входит Supermicro. Утверждается, что новые SSD могут использоваться в самых современных архитектурах с жидкостным охлаждением, включая серверы Supermicro на базе NVIDIA HGX B300.

24.09.2025 [18:13], Руслан Авдеев

AI Pathfinder намерена потратить £18,4 млрд на два ИИ ЦОД в ВеликобританииКомпания AI Pathfinder, новичок на рынке ЦОД, объявила о намерении вложить до £18,4 млрд ($24,86 млрд) в цифровую инфраструктуру Великобритании. В частности, планируется строительство объектов в Англии и Шотландии, сообщает Datacenter Dynamics. Компания готовится потратить £3,4 млрд ($4,6 млрд) на дата-центр в графстве Нортгемптоншир (Northamptonshire). Первую фазу проекта намерены ввести в эксплуатацию ещё до конца текущего года. До £15 млрд ($20,2 млрд) пойдут на ЦОД в Эйршире (Ayrshire) в технопарке i3. Хотя компания не раскрывает точное местоположение нового ЦОД в Англии, она сообщила, что тот будет готов к эксплуатации к декабрю 2025 года. Первый этап строительства включает создание «ИИ-фабрики» на решениях Dell и NVIDIA, способной выполнять сложные ИИ-задачи. В Шотландии первоначальные инвестиции намечены на 2026 год, там будет развёрнуто значительно количество ИИ-ускорителей. Ожидается, что площадка на 1 ГВт превратится в один из крупнейших узлов ИИ-инфраструктуры в Европе, с потенциалом масштабирования до 1,5 ГВт. По данным AI Pathfinder, компания будет использовать мощности для предоставления ИИ-сервисов клиентам из частных и государственных структур, без сдачи в аренду гиперскейлерам. В компании заявляют, что медленное внедрение ИИ может стать экзистенциальным риском для организаций всех профилей, а её платформа «ИИ как услуга» (AI-as-a-Service) позволит бизнесу, госслужбам и публичным сервисам внедрять инновации «со скоростью гиперскейлеров» без ущерба безопасности и конфиденциальности. По некоторым данным, AI Pathfinder является дочерней структурой инвестиционной группы Salamanca Group, специализирующейся на недвижимости. Последний утверждает, что привлёк £14 млрд ($18,9 млрд) на финансирование своих проектов, в том числе не связанных с ЦОД. Обе компании имеют общий адрес в Лондоне, а также «делят» некоторых топ-менеджеров. Как будут финансироваться новые ЦОД и в какие сроки потратят все выделяемые средства, пока не разглашается. На прошлой неделе также были анонсировании крупные инвестиции в ИИ-инфраструктуру Великобритании со стороны американских IT-компаний. Google потратит £5 млрд ($6,9 млрд), а BlackRock — $678 млн. Также об инвестициях в ИИ ЦОД в Великобритании на £1,5 млрд ($2 млрд) заявила CoreWeave, а OpenAI и NVIDIA объявили о запуске проекта Stargate UK совместно с Nscale.

24.09.2025 [16:55], Владимир Мироненко

OpenAI арендует, а не купит чипы у NVIDIA в рамках $100-млрд сделкиВ СМИ появились новые подробности о сделке NVIDIA и OpenAI, в рамках которой чипмейкер инвестирует в OpenAI $100 млрд. Как сообщает газета The Financial Times, переговоры прошли напрямую между гендиректором NVIDIA Дженсеном Хуангом (Jensen Huang) и главой OpenAI Сэмом Альтманом (Sam Altman). Главы компаний обсуждали подробности соглашения практически без официальных консультаций с банками, которые обычно выступают посредниками в подобных случаях. По данным The Information, в числе обсуждаемых вопросов было применение новой бизнес-модели лизинга чипов. Вместо того чтобы напрямую приобретать ускорители NVIDIA, OpenAI фактически будет брать у NVIDIA чипы в аренду с постепенной оплатой, что потенциально снизит первоначальные затраты на 10–15 % в течение пяти лет. Точные условия аренды или лизинга не разглашаются. У кого останутся чипы после окончания срока действия договора, тоже не говорится.

Источник изображения: NVIDIA Данный подход отражает более широкую тенденцию в ИИ-отрасли, где капиталоёмкая ИИ-инфраструктура рассматривается скорее как услуга, чем как основной актив. Такая бизнес-модель позволяют компаниям быстро масштабироваться без значительных капитальных затрат, в то время как NVIDIA обеспечивает себе долгосрочные источники дохода. Как отметил Альтман, сделка знаменует собой «новую модель финансирования <…>, при которой мы можем платить постепенно, а не покупать всё сразу». «Чипы и системы составляют огромную [долю] стоимости, и оплатить её авансом сложно», — добавил он. По словам аналитиков, действия Хуанга, направленные на то, чтобы сделать NVIDIA «предпочтительным стратегическим партнёром OpenAI в области вычислений и сетевых технологий», затруднят переход ИИ-разработчиков на конкурирующие чипы. Также укрепляет позиции компании в отрасли программная платформа NVIDIA CUDA, ставшая стандартным инструментом написания ИИ-приложений. Удерживая ИИ-разработчиков в своей экосистеме, Хуанг инвестирует в OpenAI, а также в десятки других стартапов, занимающихся ИИ-приложениями, облачными вычислениями, робототехникой и здравоохранением, что «многократно окупится для NVIDIA в будущем», говорят эксперты.

24.09.2025 [12:52], Руслан Авдеев

Гигаватт в неделю: OpenAI задумала развернуть крупнейшее производство ИИ-инфраструктурыПо словам главы OpenAI Сэма Альтмана (Sam Altman), ИИ-сервисы растут удивительными темпами, а в будущем они будут ещё более впечатляющими. По его мнению, по мере того как искусственный интеллект становится всё «умнее», доступ к нему становится базовым драйвером экономики и, в конце концов, такой доступ, возможно, признают одним из фундаментальных прав человека. Практически каждый захочет, чтобы ИИ всё больше работал от его имени. Для того, чтобы обеспечить мировые потребности в инференсе и обучении ИИ-моделей для их дальнейшего совершенствования, уже сегодня закладываются основы для значительного расширения строительства ИИ-инфраструктуры. Как утверждает Альтман, если ИИ останется на той траектории развития, которую прогнозируют в компании, пользователям будут доступны весьма впечатляющие возможности. Возможно, обладая 10 ГВт вычислительных мощностей, ИИ сможет найти способ лечения рака или оптимизировать процесс получения знаний для каждого учащегося в мире персонально. Если же человечество будет ограничено в вычислительных мощностях, придётся выбирать, чему отдать приоритет. При этом никто не хочет делать такой сложный выбор, поэтому стоит наращивать вычислительную инфраструктуру. Год назад Альтман убеждал власти США в необходимости постройки целой сети 5-ГВт ЦОД для обеспечения национальной безопасности. OpenAI рассчитывает создать производство, способное создавать 1 ГВт ИИ-инфраструктуры еженедельно. Выполнить этот план будет нелегко, на это уйдут годы и потребуются инновации на всех уровнях, от чипов до энергетики, строительства и робототехники. Тем не менее бизнес активно работает по всем этим направлениям и считает эпохальные изменения возможными. В OpenAI считают, что речь идёт о самом важном инфраструктурном проекте за всю историю, причём компания немало делает в США уже сегодня. При этом Альтман отметил, что «прямо сейчас» некоторые страны строят заводы по производству чипов и новые энергетические мощности намного быстрее, чем в США, но Альтман и его единомышленники намерены изменить такое положение дел. В следующую пару месяцев компания намерена раскрыть некоторые из своих планов, чтобы претворить их в жизнь. Позже в этом году компания расскажет и про финансовую сторону вопроса. С учётом того, что увеличение вычислительных мощностей способствует росту выручки, у компании уже есть некоторые «интересные новые идеи». На днях сообщалось, что OpenAI потратит $100 млрд на аренду резервных ИИ-серверов у облачных провайдеров, а чуть позже появились данные, что NVIDIA инвестирует в OpenAI $100 млрд, в основном пойдут на покупку её же ускорителей.

24.09.2025 [12:27], Руслан Авдеев

OpenAI, Oracle и SoftBank построят в США ещё пять ИИ ЦОД для проекта StargateOpenAI, Oracle и SoftBank объявили о намерении построить пять новых дата-центров для ИИ-проекта Stargate, реализуемого в США, сообщает Reuters. По-видимому, партнёрам удалось преодолеть препятствия, которые мешали активному развитию проекта. По словам главы OpenAI Сэма Альтмана (Sam Altman), ИИ сможет выполнить своё предназначение только если создать для него вычислительную базу. Сообщается об открытии трёх новых дата-центров совместно с Oracle в округах Шакелфорд (Shackelford,Техас), Донья-Ана (Doña Ana, Нью-Мексико) и где-то на Среднем Западе. Ещё два ЦОД построят в Лордстауне (Lordstown, Огайо) и округе Майлам (Milam, Техас) будут построены OpenAI, SoftBank и её дочерней структурой. Новые площадки, расширение кампуса Oracle-OpenAI в Абилине (Abilene, Техас) и совместные проекты с CoreWeave позволят в следующие три года довести общую мощность ЦОД Stargate до почти 7 ГВт, а инвестиции должны превысить $400 млрд. В целом проект предполагал строительство ЦОД мощностью 10 ГВт за $500 млрд. Ранее глава OpenAI заявил, что компания готова потратить триллионы долларов на ИИ-инфраструктуру.

Источник изображения: Mohamed Nohassi/unsplash.com Альтман также сообщил о намерении создать в США фабрику для производства 1 ГВт ИИ-инфраструктуры в неделю. Ранее NVIDIA объявила о намерении инвестировать в OpenAI $100 млрд в обмен на закупки её ИИ-чипов. Но по словам, источников, знакомых с вопросом, OpenAI и партнёры намерены использовать и заёмное финансирование для аренды ИИ-ускорителей в рамках проекта Stargate.

24.09.2025 [09:37], Владимир Мироненко

Расходы ИИ-отрасли к 2030 году могут оказаться на $800 млрд больше её доходовЗаявления ИИ-компаний о планах потратить гигантские суммы на расширение инфраструктуры вызывают у аналитиков резонные вопросы о том, насколько такие вложения экономически и технологически обоснованы и подтверждены расчётами, отмечает Bloomberg. Так, OpenAI намерена со временем потратить триллионы долларов на ИИ ЦОД, но пока не спешит продемонстрировать, как она заработает, чтобы покрыть такие расходы. По оценкам консалтинговой фирмы Bain & Co., дефицит средств может быть гораздо больше, чем предполагалось ранее. Согласно отчёту Bain Global Technology Report к 2030 году компаниям в сфере ИИ потребуется $2 трлн совокупной годовой выручки для покрытия затрат на вычислительные мощности, необходимые для удовлетворения прогнозируемого спроса. Но их выручка, вероятно, будет на $800 млрд меньше этой суммы, поскольку, по прогнозам Bain, монетизация сервисов вроде ChatGPT отстаёт от потребностей в расходах на ЦОД и связанную с ними инфраструктуру. Экономическая эффективность ИИ-решений, т.е. прибыль ИИ-компаний, отстаёт от темпов роста спроса на вычислительные мощности и электроэнергию. OpenAI ежегодно теряет миллиарды долларов и ставит во главу угла рост, а не прибыль, но ожидает выхода на положительный денежный поток к 2029 году, сообщает Bloomberg. По данным Bloomberg Intelligence, к началу следующего десятилетия общие годовые расходы крупнейших технологических компаний, включая Microsoft., Amazon и Meta✴, на ИИ-технологии вырастут до более чем $500 млрд. Выпуск новых ИИ-моделей от OpenAI, DeepSeek и др. стимулирует спрос на ИИ-сервисы и побуждает всю отрасль увеличивать инвестиции. По оценкам Bain, к 2030 году глобальные ИИ-мощности вырастут до 200 ГВт, при этом на США будет приходиться половина этого объёма. Прорывы в разработке технологий и алгоритмов позволят облегчить задачу, однако ограничения в цепочке поставок или дефицит электричества могут помешать прогрессу, утверждают аналитики. «Если нынешние законы масштабирования останутся в силе, ИИ будет создавать всё большую нагрузку на цепочки поставок по всему миру», — отмечает Bain. Помимо инфраструктуры, компании в сфере ИИ тратят огромные средства на разработку продуктов. Одним из направлений является создание ИИ-агентов, способных автономно выполнять многоэтапные задачи. По оценкам Bain, в течение следующих трёх-пяти лет до 10 % расходов компаний на технологии будут приходиться на развитие основных возможностей ИИ, включая платформы ИИ-агентов. Отчёт Bain также содержит прогноз роста в таких областях, как квантовые вычисления. Эта новая технология может увеличить рыночную стоимость на $250 млрд в таких отраслях, как финансы, фармацевтика, логистика и материаловедение. Несмотря на ожидания некоторых аналитиков прорыва, Bain прогнозирует постепенный рост рынка квантовых вычислений с ранним внедрением в узких областях в течение следующих 10 лет и более широким внедрением со временем. Bain также отметила, что гуманоидные роботы становятся всё более распространёнными, привлекая инвестиции, но их внедрение находится на ранней стадии и в значительной степени зависит от человеческого контроля. По словам консалтинговой компании, коммерческий успех этого направления будет зависеть от готовности экосистемы, и компании, которые первыми начнут внедрять роботов, скорее всего, станут лидерами отрасли. |

|