Лента новостей

|

21.08.2025 [10:03], Сергей Карасёв

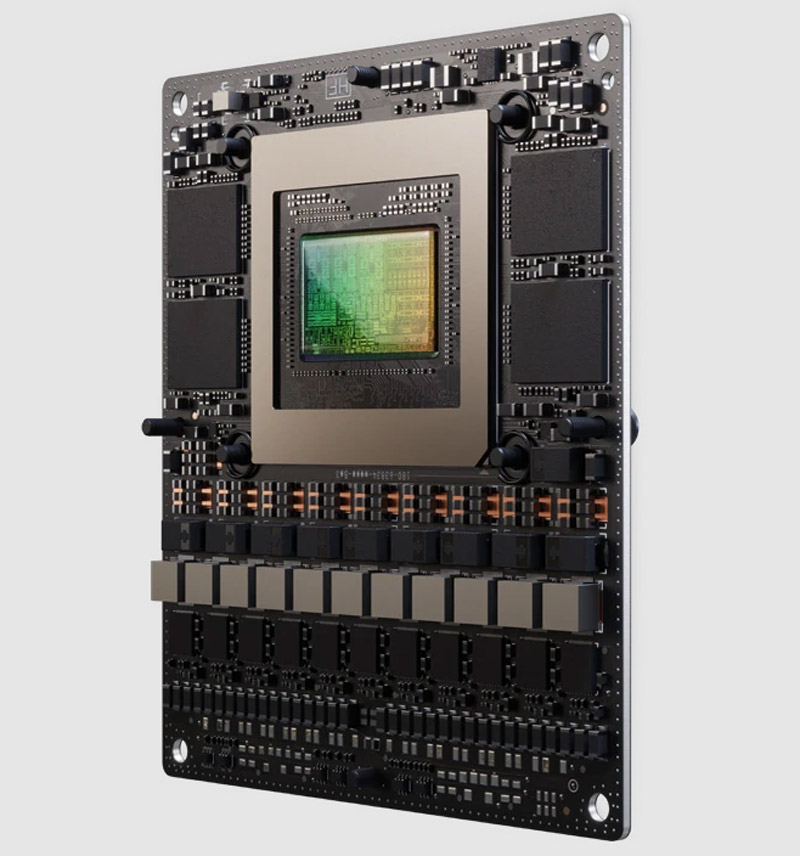

NVIDIA представила ИИ-платформу Jetson AGX Thor Developer Kit с GPU BlackwellКомпания NVIDIA анонсировала вычислительные модули Jetson T5000 и T4000, а также комплект для разработчиков Jetson AGX Thor Developer Kit. Изделия предназначены для создания роботов, периферийных ИИ-систем, обработки данных от камер и сенсоров и других задач. Решение Jetson T5000 объединяет CPU с 14 вычислительными 64-бит ядрами Arm Neoverse-V3AE с максимальной тактовой частотой 2,6 ГГц, а также 2560-ядерный GPU на архитектуре Blackwell с частотой до 1,57 ГГц (задействованы 96 тензорных ядер пятого поколения). Объём памяти LPDDR5X с пропускной способностью 273 Гбайт/с составляет 128 Гбайт. Заявленная производительность достигает 2070 Тфлопс (FP4—Sparse). Реализована поддержка четырёх интерфейсов 25GbE. В свою очередь, модель Jetson T4000 содержит CPU с 12 ядрами Arm Neoverse-V3AE (до 2,6 ГГц) и 1536-ядерный GPU на архитектуре Blackwell (до 1,57 ГГц; 64 тензорных ядра пятого поколения). Объём памяти LPDDR5X равен 64 Гбайт (273 Гбайт/с). У этого решения быстродействие составляет до 1200 Тфлопс (FP4—Sparse). Упомянуты три интерфейса 25GbE. Обе новинки обеспечивают возможность кодирования видео в многопоточных режимах: 6 × 4Kp60 (H.265), 12 × 4Kp30 (H.265), 24 × 1080p60 (H.265), 50 × 1080p30 (H.265), 48 × 1080p30 (H.264) или 6 × 4Kp60 (H.264). Декодирование возможно в следующих форматах: 4 × 8Kp30 (H.265), 10 × 4Kp60 (H.265), 22 × 4Kp30 (H.265), 46 × 1080p60 (H.265), 92 × 1080p30 (H.265), 82 × 1080p30 (H.264) и 4 × 4Kp60 (H.264). Допускается подключение до 20 камер посредством HSB, до 6 камер через 16 линий MIPI CSI-2 или до 32 камер через виртуальные каналы.  Среди прочего упомянута поддержка восьми линий PCIe 5.0, интерфейсов USB 3.2 (×3) и USB 2.0 (×4), HDMI 2.1 и DisplayPort 1.4a, I2S/2x (×5), DMIS (×2), UART (×4), SPI (×3), I2C (×13), PWM (×6). Габариты модулей составляют 100 × 87 мм. Решение Jetson AGX Thor Developer Kit построено на основе Jetson T5000. Система несёт на борту накопитель M.2 NVMe SSD вместимостью 1 Тбайт и комбинированный адаптер Wi-Fi 6E / Bluetooth (M.2 Key-E). Реализованы порты HDMI 2.0b и DisplayPort 1.4a, 5GbE RJ45 и QSFP28 (4 × 25 GbE), по два разъёма USB 3.2 Type-A и USB 3.1 Type-C. Размеры устройства составляют 243,19 × 112,4 × 56,88 мм. Комплект доступен для заказа по ориентировочной цене $3500.

20.08.2025 [23:51], Владимир Мироненко

Lenovo откроет в Саудовской Аравии штаб-квартиру и развернёт производство IT-оборудованияКитайская компания Lenovo Group объявила о решении открыть новую региональную штаб-квартиру в Саудовской Аравии, которая разместится в бизнес-центре Al-Majdoul Tower в Эр-Рияде, сообщили Digitimes, Reuters и ряд арабских СМИ. Возглавит штаб-квартиру ветеран Lenovo Лоуренс Ю (Lawrence Yu). Также сообщается о назначении Джованни Ди Филиппо (Di Filippo) гендиректором Lenovo Saudi Arabia, а Зорана Радумило (Zoran Radumilo) — главным технологическим директором. «Размещение штаб-квартиры в знаменитом Al-Majdoul Tower подчёркивает долгосрочную приверженность Lenovo поддержке программы Vision 2030 Саудовской Аравии и продвижению программы цифровой трансформации и экономической диверсификации королевства», — отметила Lenovo. Компания добавила, что это событие является развитием стратегического партнёрства Lenovo с ALAT, дочерней компанией Суверенного фонда Саудовской Аравии (PIF), направленного на расширение глобального производственного присутствия компании и ускорение её трансформации. Этот шаг также соответствует поддерживаемой правительством Саудовской Аравии программе создания региональных штаб-квартир в Эр-Рияде, запущенной в 2021 году, отметил ресурс Arab News. Данная программа предусматривает ряд льгот, включая освобождение от налога на прибыль предприятий на 30 лет и т.п., а также регуляторную поддержку для транснациональных корпораций, работающих в Королевстве. В феврале Lenovo и ALAT провели церемонию закладки первого камня в фундамент современного производственного комплекса площадью 200 тыс. м2 в Эр-Рияде, входящего в Специальную интегрированную логистическую зону. Запуск завода запланирован на 2026 год. Он будет выпускать устройства с отметкой «Сделано в Саудовской Аравии», что подтвердит стремление Королевства локализовать высокотехнологичное производство. Ранее малотиражное производство серверов в стране наладила HPE. «Наши инициативы в Саудовской Аравии, включая штаб-квартиру, флагманские торговые площади и производственный комплекс в Эр-Рияде, по прогнозам, внесут вклад в ненефтяной ВВП до $10 млрд к 2030 году, что подтверждает нашу приверженность долгосрочному развитию Королевства», — сообщил Мэтт Добродзей (Matt Dobrodziej), старший вице-президент и президент Lenovo EMEA. Расширение присутствия компании также будет способствовать развитию инициатив Саудовской Аравии по созданию умных городов, включая NEOM и проект «Красное море», которые, по оценкам IDC, к 2030 году принесут $135 млрд в виде инвестиций в технологии. Сообщается, что Радумило возглавит разработку решений в области ИИ, облачных технологий и Интернета вещей для удовлетворения этих потребностей. Председатель совета директоров и гендиректор Lenovo Ян Юаньцин (Yuanqing Yang) заявил на прошлой неделе, что компания наблюдает высокий спрос на ИИ-технологии в трёх основных сегментах своего бизнеса, причем спрос в Китае на ИИ-инфраструктуру опережает спрос в остальном мире. Саудовская Аравия стала ведущей цифровой экономикой в Персидском заливе: по данным Министерства связи и информационных технологий, в 2024 году сектор ИКТ вырос на 7,5 %. Прямые иностранные инвестиции в технологический сектор выросли на 18 % в годовом исчислении благодаря реформам регулирования и другим стимулам.

20.08.2025 [16:15], Руслан Авдеев

Fluidstack арендовала 360 МВт у криптомайнера TeraWulf, который частично принадлежит GoogleКриптомайнинговая компания TeraWulf и провайдер ИИ-облака Fluidstack расширили договор аренды, подписанный буквально на прошлой неделе. На тот момент стороны заключили соглашение, предусматривавшее аренду Fluidstack 200 МВт IT-нагрузки (около 250 МВт общей мощности) в кампусе TeraWulf Lake Mariner в Нью-Йорке, а теперь решили добавить ещё 160 МВт, сообщает Datacenter Dynamics. Благодаря очередному расширению законтрактованная мощность увеличилась до 360 МВт, что соответствует $6,7 млрд выручки с потенциалом увеличения до $16 млрд путём дальнейшего развития бизнеса. Для поддержки расширения Google увеличит вливания до $3,2 млрд, доведя свою долю в TeraWulf приблизительно до 14 %. В настоящее время общая мощность кампуса Lake Mariner, расположенного на месте закрытой угольной электростанции, составляет 500 МВт с возможностью расширения до 750 МВт. Изначально кампус был ориентирован на криптомайнинг, но теперь обслуживает ИИ- и HPC-нагрузки. Так, одним из арендаторов кампуса стала Core42 (G42) из ОАЭ. Сделка позволит Fluidstack развернуть 40 МВт IT-нагрузок в I полугодии 2026 года, а 200 МВт будут развёрнуты к концу 2026 года на объектах CB-3 и CB-4. Оставшиеся 160 МВт будут развёрнуты на объекте CB-5, который должен заработать во II полугодии 2026 года. По словам TeraWulf, расширение подчёркивает масштаб и возможности кампуса. Построив CB-5, компания не только увеличит контрактные мощности для Fluidstack, но и укрепит стратегическое сотрудничество с ключевым финансовым партнёром в лице Google для создания ИИ-инфраструктуры нового поколения. Fluidstack основана в 2017 году в Оксфордском университете. Сегодня компания располагает более 100 тыс. ИИ-ускорителей, в число клиентов входят Mistral AI, Character.AI, Poolside и Black Forest Labs. В 2025 году компания объявила о соглашении с Macquarie Group об обеспечение ИИ-мощностями европейских исследовательских лабораторий, занимающихся ИИ-проектами. Кроме того, сообщалось о сотрудничестве с NVIDIA, Borealis и Dell для создания экзафлопсных ИИ-кластеров в Исландии и Северной Европе. В феврале 2025 года Fluidstack подписала меморандум о взаимопонимании с французским правительством, согласно которому она построит во Франции ИИ-суперкомпьютер мощностью 1 ГВт.

20.08.2025 [14:08], Руслан Авдеев

Amazon, Google и Microsoft призвали США сохранить субсидии на возобновляемые источники энергии ради борьбы с КНР за первенство в сфере ИИ

amazon

google

hardware

microsoft

возобновляемая энергия

гиперскейлер

дефицит

закон

ии

сша

цод

экология

энергетика

Объединение крупных владельцев ЦОД Data Center Coalition, включающее Microsoft, Amazon (AWS), Google, Meta✴, CyrusOne, Stack, CloudHQ, Vantage и др. призвало Министерство финансов США не отменять субсидии на ветряную и солнечную энергетику. По словам представителей коалиции, имеющиеся льготы дают отрасли в США преимущество перед конкурентами из Китая, передаёт Reuters. Как заявляется в письме коалиции главе министерства, любые регуляторные препятствия, замедляющие развёртывание новых генерирующих мощностей, напрямую влияют на способность удовлетворять энергетические потребности ИИ. Администрация Трампа предпринимает активные попытки отменить ряд налоговых льгот, способствующих росту возобновляемой энергетики США. Так, один из основополагающих новых законопроектов предполагает налог в 50 % с ветряных генерирующих мощностей и 30 % с солнечной энергетики, если соответствующие проекты завершены после декабря 2027 года. Во всяком случае, если те не смогут доказать, что в них не использовались китайские комплектующие. Если же строительство объекта «чистой» энергетики начнётся после 2032 года, то размер налоговых кредитов (Clean Electricity Tax Credits) будет автоматически уменьшаться, независимо от того, достигнуты ли общие целевые показатели по сокращению выбросов, установленные законом. В поддержку такого решения президент США заявил, что возобновляемые источники дорого обходятся, нестабильны, зависят от цепочек поставок, контролируемых из-за рубежа, и даже наносят вред окружающей среде и стабильности электросетей. На прошлой неделе Министерство финансов США опубликовало правила, регламентирующие получение налоговых льгот для проектов, связанных с ветряной и солнечной энергетикой. Они, в частности, отменяют налоговый вычет в размере 5 % для любых проектов мощнее 1,5 МВт — это может оказать негативное влияние на уже запланированные инвестиции в отрасль в объёме более $100 млрд в рамках проектов общей мощностью 6 ГВт.

Источник изображения: Laura Ockel/unsplash.com При этом источники возобновляемой энергии, особенно солнечные, в среднем дешевле других альтернатив ископаемому топливу. Опубликованное в 2023 году исследование Energy Innovation показало, что 99 % действующих угольных электростанций США дороже в эксплуатации, чем солнечные или ветряные электростанции. Утверждается, что солнечная энергия минимум на 30 % дешевле. Впрочем, Трамп принимает меры для реанимации угольных ТЭС и других источников на ископаемом топливе. Крупнейшими потребителями возобновляемой энергии в США являются операторы дата-центров, особенно крупные гиперскейлеры. В марте 2025 года сообщалось, что американские технологические бизнесы заключили контракты о поставке в общей сложности 48 ГВт «чистой» энергии (в годовом исчислении). Это на 66,4 % больше год к году. Большинство соответствующих договоров представляют собой соглашения о покупке электроэнергии (PPA), например, на 300 МВт между Meta✴ и Longroad Energy, на 734 МВт — между Google и Leeward Energy, отмечает DataCenter Dynamics.

20.08.2025 [13:24], Руслан Авдеев

Vantage построит за $25 млрд 1,4-ГВт кампус ИИ ЦОД неподалёку от первого дата-центра Crusoe StargateVantage Data Centers занялась расширением ЦОД в Техасе. Новый кампус Frontier площадью более 485 га и мощностью 1,4 ГВт появится в округе Шакелфорд (Shackelford, Техас), сообщает Datacenter Dynamics. Кампус станет крупнейшим в глобальном портфолио компании, и самым дорогим — Vantage потратит в общей сложности более $25 млрд. На территории разместятся 10 объектов общей площадью около 345 тыс. м2. Строительство уже началось, первое здание должно быть готово в I полугодии 2026 года. Кампус Frontier получит поддержку 250-кВт стоек. В кампусе будет применяться СЖО с замкнутым циклом, требующая минимального расхода воды. Компания намерена получить для объекта сертификат LEED (Leadership in Energy and Environmental Design). Телекоммуникационная инфраструктура здания получит три операторских точки подключения (Meet-Me-Room, MMR) и один ввод. По словам Vantage, Техас стал критически важным рынком для поставщиков ИИ-решений. В частности, запуск кампуса Frontier знаменует переломный момент для Vantage. В компании уверены, что инвестиции в Техас станут драйвером экономического роста региона. По словам губернатора штата, инвестиции Vantage в строительство нового кампуса помогут создать тысячи хорошо оплачиваемых рабочих мест для местных жителей и обеспечить доход местной и региональной экономике.

Источник изображения: Vivian Arcidiacono/unspalsh.com Новости о том, что Vantage намерена строить крупный кампус в Техасе, появились в июле 2025 года. Компания подтвердила данные, но не раскрыла подробностей. Сообщалось, что строительство планировалось на пересечении трасс 604 и 351. Frontier находится вблизи Абилина (Abilene), где Crusoe строит первый крупный кампус для Oracle и OpenAI в рамках проекта Stargate. Vantage Data Centers, принадлежащая DigitalBridge, управляет или строит дата-центры по всей территории США, в том числе в Огайо, Джорджии, Техасе, Калифорнии, Вирджинии, Аризоне, Индиане, Неваде, Висконсине и Вашингтоне.

20.08.2025 [12:11], Руслан Авдеев

Applied Digital построит в Северной Дакоте 280-МВт ИИ ЦОД с СЖОБывший криптовалютный бизнес Applied Digital, сменивший профиль на работу с ИИ ЦОД, намерен построить новый кампус близ Харвуда (Harwood, Северная Дакота). Кампус Polaris Forge 2 стоимостью $3 млрд и мощностью 280 МВт будет использовать СЖО, разработанную компанией, сообщает Datacenter Dynamics. Начало строительства запланировали на сентябрь текущего года, а запуск первой очереди должен состояться в 2026 году. Полной мощности проект достигнет в начале 2027 года. На участке около 365 га поначалу будут располагаться два здания, электроснабжение обеспечат через профильный кооператив местного округа Касс (Cass County Electric Cooperative) и Электрический кооператив Миннкота (Minnkota Power Cooperative). Как заявляют в Applied Digital, Polaris Forge 2 свидетельствует о новом этапе роста компании и укреплении её лидирующих позиций в области обеспечения клиентов высокороизводительной ИИ-инфраструктурой. В компании уверены, что спрос на ИИ-мощности продолжает расти, а Северная Дакота всё ещё является одним из стратегически важных мест в США для удовлетворения потребностей потребителей. По имеющимся данным, к площадке проявлен большой интерес, идут «продвинутые переговоры» с одним из гиперскейлеров. Считается, что кампус укрепит позиции Applied Digital, расширит её возможности по масштабированию и обеспечит долгосрочные перспективы для клиентов и местных сообществ.

Applied Digital Сейчас Applied Digital управляет HPC-кампусом в Эллендейле (Ellendale, Северная Дакота), известным как Polaris Forge 1 — приблизительно в 225 км к юго-западу от нового объекта. Первый кампус, рассчитанный на 400 МВт с потенциалом расширения до более 1 ГВт оснащён замкнутой «безводной» системой прямого охлаждения чипов. После начала работ в 2022 году площадка в Эллендейле перепрофилирована с нужд криптомайнинга на ИИ и HPC в рамках крупной сделки с облачной компанией CoreWeave. Applied Digital, ранее известная как Applied Blockchain, ранее ориентировалась на майнеров и размещала их оборудование в своих дата-центрах. Теперь она также размещает оборудование для HPC и ИИ. Applied предлагает и собственные облачные сервисы, ранее она заявляла о намерении развернуть у себя ускорители NVIDIA Blackwell. Дополнительно она владеет объектом JMS01 мощностью 106 МВт в Джеймстауне (Jamestown, Северная Дакота). Также планируется строительство кампуса на 200 МВт в Айове и рассматривает возможность реализации крупного проекта в Южной Дакоте. В Эллендейле компания инвестировала в «человеческий капитал», предоставив жильё сотрудникам и создав прочные партнёрские отношения на местном уровне, говорят местные власти. В новом кампусе будет трудиться более 200 сотрудников, нанятых на полный рабочий день.

20.08.2025 [11:13], Сергей Карасёв

SSSTC представила SSD серии CA8 — первые на рынке индустриальные M.2-накопители с памятью Kioxia BiCS Flash восьмого поколенияКомпания Solid State Storage Technology Corporation (SSSTC) анонсировала SSD семейства CA8, предназначенные для применения в интеллектуальных устройствах интернета вещей, платформах промышленной автоматизации, периферийных компьютерах, автомобильных системах и пр. По заявлениям SSSTC, изделия CA8 — это первые на рынке индустриальные устройства M.2 2280 с памятью Kioxia BiCS Flash восьмого поколения. Применены 218-слойные флеш-чипы 3D TLC NAND с технологией CBA (CMOS direct Bonded to Array), которая, как утверждается, существенно повышает энергоэффективность, производительность и плотность хранения данных по сравнению с решениями предыдущего поколения.

Источник изображения: SSSTC В серию CA8 вошли модели вместимостью 512 Гбайт, а также 1, 2 и 4 Тбайт. Для подключения служит интерфейс PCIe 5.0 х4 (NVMe 2.0). Заявленная скорость последовательного чтения информации достигает 14 000 Мбайт/с, скорость последовательной записи — 12 000 Мбайт/с. Величина IOPS (операций ввода/вывода в секунду) составляет до 2 млн при произвольном чтении и 1,6 млн при произвольной записи: это, как подчеркивается, одни из самых высоких значений для индустриальных SSD, доступных на рынке. Диапазон рабочих температур простирается от 0 до +85 °C. Значение MTBF (средняя наработка на отказ) превышает 3 млн часов. Упомянута поддержка AES-256 и TCG Opal. Функция Power Loss Notification (PLN) предотвращает повреждение данных при неожиданных отключениях питания. Накопители способны выдерживать более одной полной перезаписи в сутки (1 DWPD) на протяжении пяти лет.

20.08.2025 [09:34], Владимир Мироненко

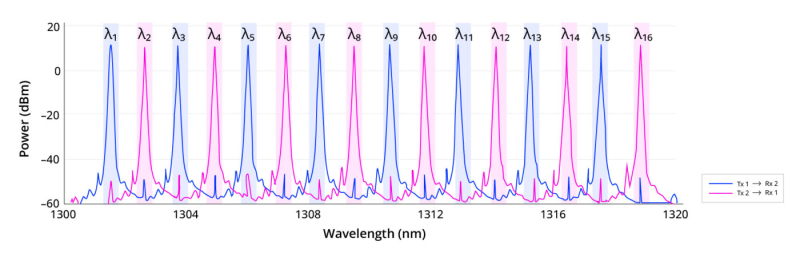

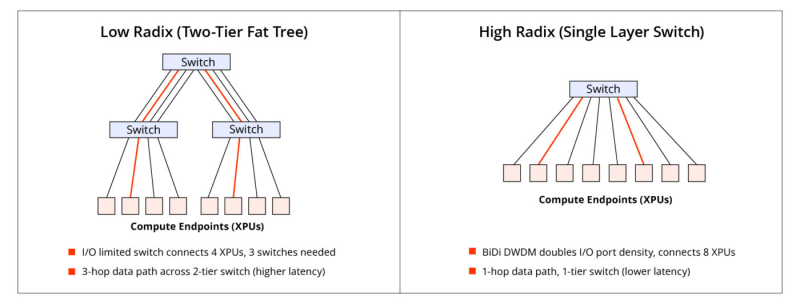

Lightmatter «упаковала» 16 длин волн в одномодовое волокноLightmatter объявила о новом достижении в области оптической связи: двунаправленном оптическом канале связи Lightmatter Passage 3D CPO с 16 λ и DWDM, работающем на одном одномодовом оптоволокне. Как сообщает компания, решение, основанное на интерконнекте Lightmatter Passage и лазерной технологии Lightmatter Guide, устраняет прежние ограничения по плотности полосы пропускания волокна и использованию спектра, устанавливая новый стандарт для высокопроизводительных и отказоустойчивых интерконнектов в ЦОД. Lightmatter отметила, что с ростом числа сложности MoE-моделей с триллионами параметров масштабирование ИИ-нагрузок будет ограничено количеством портов и их пропускной способности. Lightmatter Passage 3D обеспечивает «беспрецедентную» двунаправленную пропускную способность 800 Гбит/с (по 400 Гбит/с для передачи и для приёма) для одномодового оптоволокна на расстоянии до 1 км. Это восьмикратный скачок пропускной способности на волокно по сравнению с традиционными решениями, говорится в блоге Lightmatter. При этом не требуется более дорогостоящее волокно с поддержкой поляризации (PM). Как и прежде, решение Lightmatter относится к системам интегрированной фотоники (CPO). Оно объединяет восемь сверхэффективных кольцевых микромодуляторов (MRM), фотодетекторы и аналоговые схемы на одном монолитном кремниевом кристалле с запатентованной системой термической стабилизации. Замкнутая система цифровой стабилизации активно компенсирует любой тепловой дрейф, обеспечивая непрерывную передачу данных с низким уровнем ошибок даже при заметных колебаниях температуры кристалла. В решении компании чередуются нечётные и чётные длины волн в диапазоне 1310 нм: восемь нечётных каналов передают в одном направлении, а восемь чётных — в противоположном. Каждый канал работает со скоростью 50 Гбит/с с интервалом 200 ГГц между соседними каналами передачи/приёма и 400 ГГц между каналами, передающими данные в одном направлении. Удваивая количество I/O-портов на коммутатор или XPU, технология сокращает количество сетевых переходов, снижает задержку и энергопотребление, а также минимизирует затраты в крупных ИИ-кластерах. В крупных MoE-моделях интерконнект с большим радиксом обеспечивают взаимодействие «экспертов» с высокой пропускной способностью, что позволяет избежать узких мест при масштабировании и сократить время обучения. Lightmatter позиционирует новое решение как естественную эволюцию технологии CPO для создания ИИ-суперкомпьютеров следующего поколения. Развитием направления CPO также активно занимаются ведущие разработчики ИИ-ускорителей. AMD недавно приобрела стартап Enosemi, который специализируется на разработке фотонных чипов. NVIDIA в марте нынешнего года анонсировала 800G-коммутаторы Spectrum-X и Quantum-X, в которых применены новые ASIC, объединяющие на одной подложке чип-коммутатор и фотонные модули.

19.08.2025 [23:10], Руслан Авдеев

NVIDIA готовит для Китая урезанный ИИ-ускоритель на архитектуре BlackwellNVIDIA работает над новым ИИ-ускорителем, предназначенным специально для китайского рынка. Модель на основе новейшей архитектуры Blackwell будет мощнее модели H20, допущенной для продаж в КНР, сообщает Reuters со ссылкой на осведомлённые источники. Как сообщают источники, новый чип, предварительно названный B30A, будет представлять собой однокристальную систему, которая, вероятно, обеспечит половину чистой вычислительной мощности флагманской модели NVIDIA B300 на двух кристаллах. Новый чип получит высокоскоростную память и поддержку технологии NVIDIA NVLink. Впрочем, эти функции имеются и в H20, основанном на устаревшей архитектуре Hopper. Источники сообщают, что окончательные характеристики чипа не определены, но NVIDIA рассчитывает предоставить китайским клиентам образцы для тестирования уже в следующем месяце. Компания подчёркивает, что рассматривает выпуск различных продуктов в той мере, в какой это позволяет американское правительство. Всё, что предлагается, одобрено компетентными органами и предназначено исключительно для коммерческого использования. В прошлом году на долю Китая пришлось 13 % выручки NVIDIA, поэтому глава компании Дженсен Хуанг (Jensen Huang) жёстко раскритиковал американские запреты. Ускоритель H20 был разработан специально для КНР ещё в 2023 году, но в апреле 2025 года он попал под санкции. AMD также разработала для Китая ослабленные ускорители MI308, которые тоже попали под санкции. Теперь уже сам Китай говорит, что H20 может представлять опасность для национальной безопасности и призывает отказаться от использования этих чипов.

Источник изображения: Boudewijn Huysmans/unsplash.com На прошлой неделе США допустили возможность продажи в Китай урезанных чипов нового поколения. Информация появилась после сделки, в результате которой NVIDIA и AMD будут отдавать правительству США 15 % выручки от продаж ИИ-ускорителей в Китае. По данным CNBC, Трамп заявлял, что сначала он рассчитывал на 20 %, но позже согласился и на меньшее. Тем не менее, американские парламентарии обеспокоены продажей даже ослабленных чипов в Китай. Предполагается, что это помешает США добиться мирового лидерства в сфере ИИ. NVIDIA и другие компании уверены, что интерес Китая к американской продукции необходимо сохранить, иначе бизнесы из Поднебесной перейдут на продукцию местных конкурентов. Ранее сообщалось, что NVIDIA готовит для Китая чипы на архитектуре Blackwell, предназначенные для инференса. В мае Reuters сообщало, что ускоритель на базе RTX6000D (возможно, B30/B40) будет дешевле H20. Он разработан с учётом ограничений, введённых американскими властями, и использует обычную память GDDR с пропускной способностью 1398 Гбайт/сек, т.е. чуть ниже установленного регуляторами «экспортного» порога в 1,4 Тбайт/с — якобы именно из-за этого H20 и попал под запрет. Один из источников сообщает, что поставки небольших партий в Китай NVIDIA намеревается начать уже в сентябре 2025 года.

19.08.2025 [22:51], Руслан Авдеев

Foxconn будет производить ИИ-оборудование для проекта Stargate на заводе, который она продала SoftBankТайваньская Hon Hai Precision Industry Co. (Foxconn) будет управлять в США объектом, принадлежащим SoftBank Group. Это станет первой производственной площадкой в совместном проекте Stargate, активными участниками которого также являются OpenAI и Oracle Corp, сообщает Bloomberg. SoftBank купила завод Foxconn по производству электромобилей в Огайо, но тайваньский бизнес продолжит управлять комплексом даже после его преобразования в предприятие по выпуску ИИ-серверов. SoftBank намерен поставлять производственное оборудование для завода. Параллельно SoftBank изучает ряд потенциальных площадок для размещения дата-центров, которые могли бы стать флагманами проекта Stargate. Компания оценивает их доступ к воде, электричеству и сетям. Участие Foxconn желательно для SoftBank, поскольку она уже имеет большой опыт выпуска серверов для NVIDIA. Реализация проекта Stargate замедлилась в связи с экономическими рисками, связанными с новыми американскими пошлинами. Кроме того, на проект повлияло и появление относительно дешёвых альтернатив американским ИИ-системам, вроде решений китайского стартапа DeepSeek, что осложнило формирование ценовых моделей и привлечение финансирования. При этом SoftBank опровергла наличие проблем с финансированием проекта.

Источник изображения: Robert Conklin/unspalsh.com В начале августа Foxconn подала в Огайо заявление о продаже SoftBank завода по выпуску электромобилей в Лордстауне (Lordstown), который она приобрела в 2022 году у стартапа Lordstown Motors. При этом сообщалось, что компания сохранит своё присутствие на объекте и займётся другими видами деятельности. Сообщается, что завод был продан, поскольку североамериканский рынок электромобилей производитель посчитал слишком слабым — производственные мощности значительно превышают спрос. |

|