Материалы по тегу: ibm

|

25.07.2025 [14:36], Владимир Мироненко

Выход нового поколения мейнфреймов подстегнул рост выручки IBMIBM сообщила финансовые результаты II квартала 2025 года, превысившие прогнозы аналитиков Уолл-стрит по основным показателям. Выручка компании выросла год к году на 8 % до $16,98 млрд при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $16,59 млрд. Это намного лучше, чем в предыдущем квартале, когда выручка компании выросла в годичном исчислении менее чем на 1 %. Скорректированная прибыль (Non-GAAP) на акцию тоже превзошла ожидания Уолл-стрит, составив $2,80 против $2,64 согласно прогнозу. Чистая прибыль (GAAP) составила $2,19 млрд, превысив показатель в $1,83 млрд годом ранее. По состоянию на закрытие торгов в среду акции IBM выросли на 28 % с начала 2025 года, в то время как индекс S&P 500 за тот же период вырос примерно на 8 %. В значительной степени рост выручки был достигнут благодаря инфраструктурному подразделению, запустившему поставки мейнфреймов z17. Продажи этого подразделения выросли год к году на 14 % до $4,14 млрд, превысив прогноз Уолл-стрит в $3,66 млрд, пишет Bloomberg. Финансовый директор IBM Джим Кавано (Jim Kavanaugh) назвал в интервью Bloomberg нынешний первоначальный запуск мейнфрейма самым успешным в истории компании. Высокий спрос, по его словам, был обусловлен заказами крупных предприятий, особенно в финансовой сфере и розничной торговле. Аналитик Constellation Research Хольгер Мюллер (Holger Mueller) отметил, что мейнфрейм IBM был в центре внимания в этом квартале, в целом очень успешном для IBM. Он добавил, что ценностное предложение IBM в области ПО для ИИ продолжает расти, а платформа watsonX всё чаще рассматривается как «Швейцария» среди ИИ-стеков благодаря своей портативности. Анонсированная ранее платформа watsonx Orchestrate, по словам IBM, позволяет компаниям создавать автономных ИИ-агентов, способных выполнять задачи без человеческого контроля, менее чем за пять минут. «Благодаря watsonX можно работать в любом облачном стеке, поэтому предприятиям не нужно беспокоиться о рисках, связанных с привязкой к облаку, — пояснил аналитик. — Это даёт IBM преимущество, и, учитывая, что новый цикл обновления мейнфреймов только начинается, мы можем ожидать усиления динамики развития инфраструктуры в следующих кварталах». Арвинд Кришна (Arvind Krishna) заявил, что геополитическая напряжённость побуждает некоторых клиентов действовать осторожно, хотя в целом не является определяющим фактором. «Федеральные расходы США также были несколько ограничены в I половине года, но мы не ожидаем, что это создаст долгосрочные препятствия», — добавил он. Кришна отметил, что портфель заказов IBM в сфере генеративного ИИ продолжает расти и в настоящее время составляет $7,5 млрд, тогда как в I квартале этот показатель составлял $6 млрд. «Благодаря нашим высоким показателям в I полугодии мы повышаем наш годовой прогноз по свободному денежному потоку, который, как мы ожидаем, превысит $13,5 млрд», — сообщил гендиректор IBM. Выручка от разработки ПО выросла примерно на 10 % до $7,39 млрд, что ниже консенсус-прогноза аналитиков, опрошенных StreetAccount, в $7,43 млрд. Вместе с тем, выручка в категории гибридного облачного ПО, включающей Red Hat, показала рост на 16 %, что немного выше прогнозов. Валовая рентабельность подразделения ПО в размере 83,9 % оказалась лишь немного ниже консенсус-прогноза StreetAccount в 84,0 %. Выручка подразделения по автоматизации увеличилась год к году на 16 %, выручка подразделения по обработке данных и ИИ — на 9 %. Снижение выручки вызвано тем, что многие клиенты «переориентировали свои расходы на аппаратное обеспечение», сообщил Кришна. Он пояснил, что всё больше предприятий переключают своё внимание на расходы на расширение ИИ-инфраструктуры из-за неопределённой макроэкономической обстановки. В свою очередь, Кавано заявил, что продажи ПО Red Hat, как ожидается, продолжат расти в пределах 15–16 %. Выручка от консалтинговых услуг в отчётном квартале выросла почти на 3 % до $5,31 млрд, что выше консенсус-прогноза StreetAccount в $5,16 млрд. «Задержки с принятием решений, особенно по необязательным проектам, а также продления контрактов в прошлом году повлияли на наши контракты в течение отчётного периода», — отметил Джим Кавано. Вместе с тем, по словам Кришны, компании всё чаще обращаются к ним за помощью, поскольку им сложно самостоятельно интегрировать ИИ в свои системы. Они также стремятся оптимизировать свои IT-операции, чтобы иметь возможность быстрее реагировать на быстро меняющуюся экономическую ситуацию. Компания не предоставила прогноз на текущий квартал, отметив, что по-прежнему прогнозирует рост выручки не менее чем на 5 % при постоянном курсе валюты за год. Джим Кавано заявил, что компания также надеется на расширение своего бизнеса за счёт новых приобретений. «То, что мы наблюдали за последние четыре месяца, вселяет в нас оптимизм и позволяет нам надеяться на то, что мы находимся в условиях рационального регулирования, где разумные сделки слияния и поглощения будут одобрены в разумные сроки», — сказал он.

13.07.2025 [11:21], Владимир Мироненко

Вопреки слухам IBM рассчитывает на дальнейшее расширение присутствия в КитаеПо мере обострения торговой войны между США и Китаем деятельность американских компаний в стране сталкивается со всё большими трудностями, пишет ресурс DIGITIMES. IBM объявила о массовых увольнениях в Китае и закрыла центр исследований и разработок в Пекине, что можно было бы расценивать как признаки её грядущего исхода. Но генеральный директор IBM в Азиатско-Тихоокеанском регионе Ханс Деккерс (Hans Dekkers) утверждает, что это не так. В недавнем интервью DIGITIMES Деккерс заявил, что присутствие IBM в Китае фактически увеличилось как в плане персонала, так и в разрезе бизнеса. Он добавил, что IBM присутствует на рынке Китая уже 40 лет и продолжит здесь работу в течение следующих 40 лет. 43-летний Деккерс был назначен на должность гендиректора в августе 2024 года. В IBM он работает около 18 лет, до этого курировал такие регионы как Шанхай, Сингапур и Европа. Деккерс заявил, что IBM продолжит работу на долгосрочной основе в Китае, являющемся экономическим гигантом. Он допустил, что центр исследований и разработок, о закрытии которого ходят слухи, возможно, был перенесён в другой город. Деккерс отметил, что не разделяет позицию многих компаний, которые делят свой глобальный бизнес на «китайские» и «некитайские» территории. Он пояснил, что с точки зрения бизнеса важно, где клиенты хотят развиваться и какие возможности для этого им могут предоставить технологии IBM. Геополитические ситуации могут меняться, но конечная цель — поддержка клиентов, заявляется менеджер. Онднако несмотря на то, что и Китай, и Тайвань входят в регион «Большого Китая» IBM, уровень их доступа к конфиденциальным технологиям различается, сообщил Деккерс. Многие китайские компании по-прежнему ценят и используют технологии и сервисы IBM, особенно в сфере финансов и производства. Будучи глобально интегрированной компанией, IBM имеет все возможности для помощи клиентам в расширении их бизнеса, заявил Деккерс. Сюйдун Чэнь (Xudong Chen), председатель и генеральный директор IBM Greater China, заявил в июне во время визита в Шаньдун, что фокус IBM в Китае сместился на частные предприятия и иностранные компании, дав тем самым понять, что компания не будет развивать связи с китайскими госпредприятиями. В последнее время IBM сосредоточилась на гибридном облаке, ИИ и квантовых вычислениях как на трёх основных стратегиях, хотя в Китае IBM не участвует в проектах, связанных с квантовыми технологиями. Вместе с тем она продолжает развивать сотрудничество в области квантовых технологий с компаниями в Японии, Южной Корее и на Тайване. Недавно компания представила серверы POWER11. Китайский же рынок считается одним из ключевых для POWER-платформ.

09.07.2025 [14:35], Владимир Мироненко

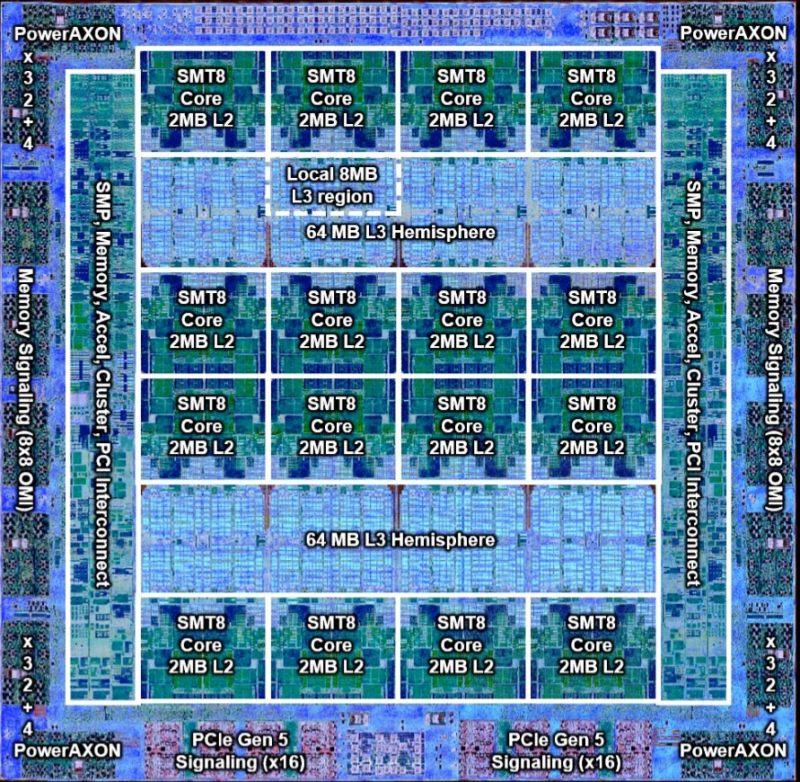

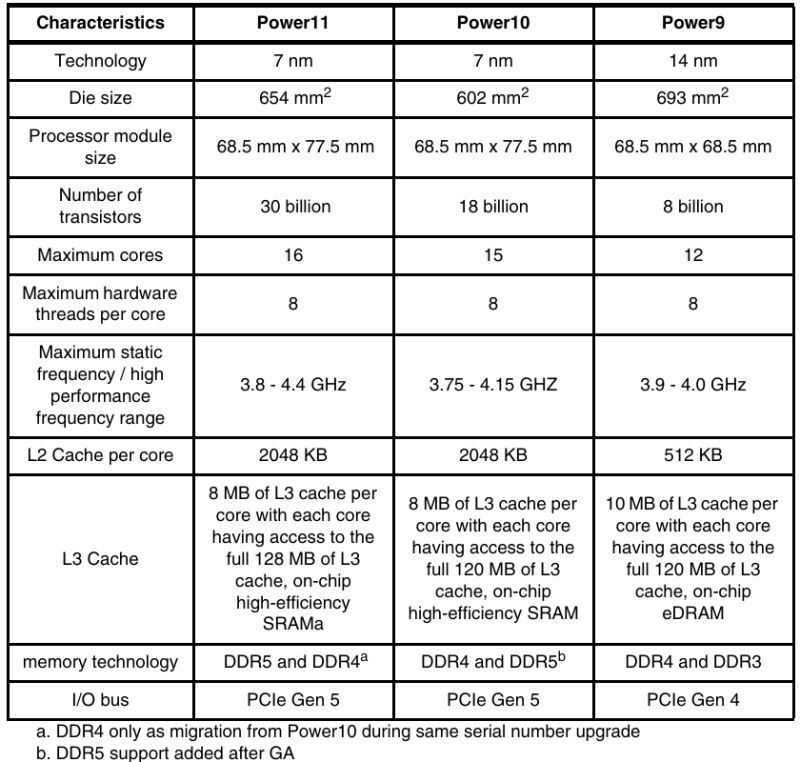

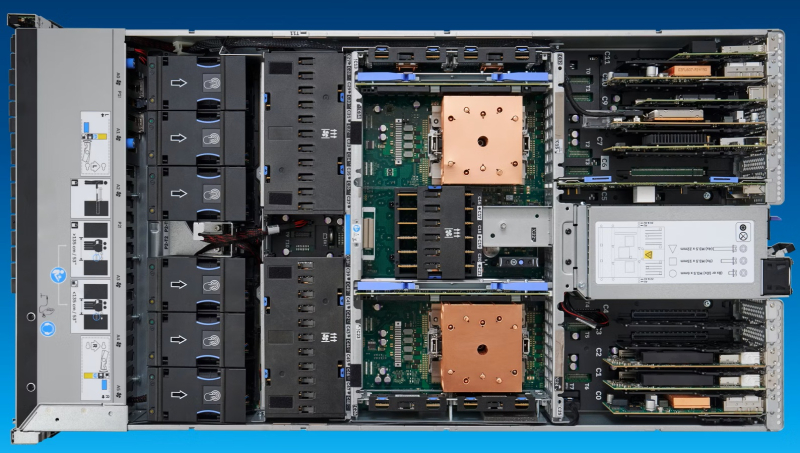

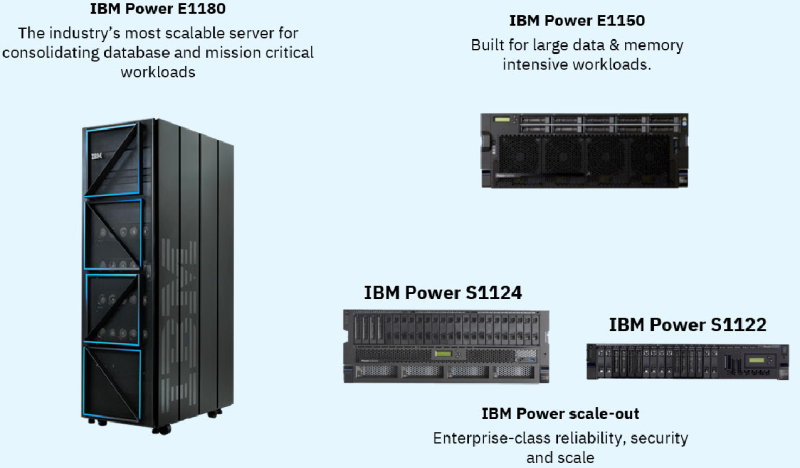

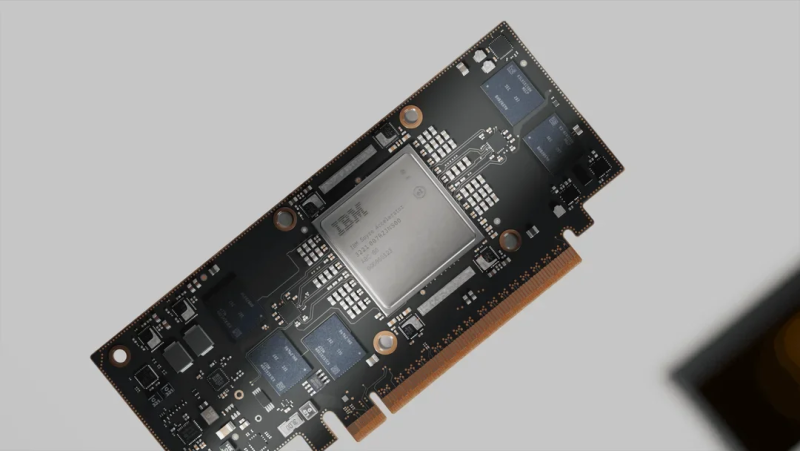

256 ядер, 2048 потоков и 64 Тбайт DDR5: IBM анонсировала «бесперебойные» серверы POWER11IBM представила серверы POWER11, получившие усовершенствованные процессоры, аппаратную архитектуру и программный стек виртуализации. Как заявила компания, POWER11 разработаны для обеспечения доступности, отказоустойчивости, производительности и масштабируемости, которые требуются предприятиям для бесшовного гибридного развёртывания on-premise или в облаке IBM Cloud. POWER11 представляет собой самый отказоустойчивый сервер в истории платформы IBM POWER с доступностью на уровне 99,9999 %, заявляет компания. Вместе с нулевым запланированным простоем для обслуживания системы и менее чем одной минутой гарантированного обнаружения угроз программ-вымогателей с помощью IBM POWER Cyber Vault, POWER11 устанавливает новую планку непрерывности ведения бизнеса, говорит IBM. Впервые общедоступная версия POWER11 будет одновременно включать высокопроизводительные серверы, модели среднего и начального уровня, а также решение IBM POWER Virtual Server (POWERVS) в IBM Cloud, обеспечивающее быстрый доступ в облако для рабочих нагрузок POWER и сертифицированное как гипермасштабируемая платформа для пакета RISE with SAP. POWER11 также является первым сервером семейства IBM POWER, поддерживающим 32-ядерные 5-нм ИИ-ускорители IBM Spyre Accelerator, которые будут доступны в IV квартале 2025 года. Они же используются в семействе мейнфреймов IBM z17. Процессор POWER11 изготавливается по 7-нм техпроцессу Samsung с использованием 18 слоёв металла и 2.5D-упаковки. Чип состоит из 30 млрд транзисторов, площадь кристалла, как и у предшественника, составляет 602 мм2. Процессор имеет 16 вычислительных ядер с поддержкой SMT8 15. Каждое ядро получило четыре блока MMA (Matrix Math Accelerator) для задач инференса. Как отмечает IT Jungle, в отличие от POWER10, 16-е ядро теперь является запасным, и может быть активировано в случае нештатной ситуации. Объём кеша L2 составляет 2 Мбайт на ядро, объём кеша L3 — 8 Мбайт на ядро, но суммарный объём L3 — до 120 Мбайт. Интерфейс POWERAXON/OMI обеспечивает пропускную способность до 2 Тбайт/с (32 ГТ/с). Возможна установка до 64 Тбайт DDR5 в модулях DDIMM, но в некоторых случаях осталась поддержка DDR4. Доступны 64 линии PCIe 5.0 и SMP-соединение для объединения до 16 сокетов. Для расширения доступны дисковые полки (24 × NVMe) и шасси с PCIe-слотами. Для обеспечения гибкости и масштабируемости POWER11 использует разные способы упаковки. Для высокопроизводительного сервера POWER E1180 задействован одночиповый вариант Single Chip Module (SCM), который обеспечивает один чип на сокет и до шестнадцати сокетов на систему. Для сервера среднего уровня POWER E1150 использовалась упаковка с двумя чипами на сокет Dual Chip Module (DCM) с поддержкой до четырёх сокетов на систему. Версия DCM также используется в линейке масштабируемых серверов POWER S1122/L1122 и POWER S1124/L1124 с двумя сокетами на систему. Также есть третий вариант упаковки — Single Core Module (eSCM), который используется для систем начального уровня POWER S1122 (4 или 10 ядер). POWER11 обеспечивает до 55 % более высокую производительность ядер по сравнению с POWER9 и до 45 % большую ёмкость с большим количеством ядер в системах начального и среднего уровня по сравнению с POWER10. Благодаря этому с POWER11 предприятия получат повышенную гибкость и безопасность, что повысит эффективность корпоративных процессов за счёт автоматизации, говорит IBM. Нулевой запланированный простой для обслуживания системы. POWER11 позволяет избежать дорогостоящего запланированного простоя и помочь снизить операционный риск. Благодаря использованию таких технологий, как автономное исправление и автоматизированное перемещение нагрузок, запланированные события по обслуживанию системы могут происходить без остановки критически важных приложений. Кроме того, IBM POWER будет взаимодействовать с IBM Concert, используя генеративный ИИ, чтобы помочь выявить операционные риски и автоматизировать их исправление, в том числе в области безопасности. Обнаружение угроз программ-вымогателей менее чем за минуту достигается с помощью IBM POWER Cyber Vault, интегрированного решения по обеспечению киберустойчивости, которое соответствует стандартам NIST. Cyber Vault умеет идентифицировать и автоматически реагировать на киберугрозы, защищая от кибератак, таких как повреждение данных и шифрование, с помощью проактивных неизменяемых снимков, которые автоматически создаются, сохраняются и тестируются по заданному пользователем расписанию. POWER 11 также использует одобренную NIST встроенную квантово-безопасную криптографию, предназначенную для защиты систем от атак с отложенной расшифровкой (HNDL) и атак на целостность встроенного ПО. IBM также отметила, что POWER11 обеспечивает значительный рост эффективности во всём ИТ-стеке. С точки зрения энергоэффективности POWER11 предлагает вдвое большую производительность на Вт (SPECint2017_rate) по сравнению с сопоставимыми x86-серверами — до двух раз в случае Intel Xeon Emerald Rapids. Кроме того, теперь разница в энергопотреблении между режимами максимальной производительности и режимом энергосбережения достигает 28 %, при этом пропускная способность падает всего на 6 %. Как утверждает ресурс StorageReview.com, этот режим будет полезен для сред разработки и тестирования с интенсивной загрузкой CPU. Вариант с прямым жидкостным охлаждением поддерживает 75 кВт на стойку (64 сокета в 42U), по сравнению с примерно 28 кВт для аналогичных x86-систем с воздушным охлаждением. Ожидается, что серверы IBM POWER11 — POWER E1180 (до 256 ядер, до 64 Тбайт DDR5), POWER E1150 (до 120 ядер, до 16 Тбайт DDR5), POWER S1124 (до 60 ядер, до 8 Тбайт DDR5) и POWER S1122 (до 60 ядер, до 4 Тбайт DDR5) поступят в продажу 25 июля.

07.07.2025 [14:05], Сергей Карасёв

Суперкомпьютер Doudna получит смешанное All-Flash хранилище IBM и VAST DataНациональная лаборатория им. Лоуренса в Беркли (Berkeley Lab), принадлежащая Министерству энергетики США (DOE), сообщила о том, что суперкомпьютер Doudna получит передовую подсистему хранения данных на основе технологий IBM и VAST Data. Эта платформа сможет с высокой эффективностью справляться с интенсивными нагрузками, связанными с обучением ИИ-моделей и инференсом. НРС-комплекс Doudna (NERSC-10) расположится в Национальном вычислительном центре энергетических исследований США (NERSC) в составе Berkeley Lab. Основой суперкомпьютера послужат системы Dell Integrated Rack Scalable Systems и серверы PowerEdge с ускорителями NVIDIA Vera Rubin. По предварительным данным, машина обеспечит FP64-быстродействие до 790 Пфлопс при потреблении 5,8–8,7 МВт. С целью достижения стабильной и предсказуемой производительности в задачах, требующих анализа данных в режиме, близком к реальному времени, для Doudna выбрана гибридная подсистема хранения, включающая зоны QSS (Quality-of-service Storage System) и PSS (Platform Storage System). Первая ориентирована прежде всего на ИИ-нагрузки: предполагается применение решений VAST Data, включая платформу VAST AI OS. Эта платформа, как утверждается, «объединяет возможности хранения информации, базы данных, вычислений, обмена сообщениями и рассуждений в единую инфраструктуру, созданную с нуля для ИИ и программных агентов». В свою очередь, PSS использует в качестве основы программно-определяемое решение IBM Storage Scale: этот сегмент будет функционировать как быстродействующая параллельная файловая система. Говорится о высокой производительности, масштабируемости и эффективности, что поможет устранить узкие места и оптимизировать рабочие процессы, связанные с обработкой данных. Для обоих сегментов СХД предусмотрено использование архитектуры All-Flash, то есть, будут задействованы исключительно SSD. Как отмечает Berkeley Lab, гибридная подсистема хранения обеспечит в пять раз более высокую производительность, нежели нынешний НРС-комплекс NERSC. Это позволит справляться с крупномасштабными рабочими нагрузками в таких областях исследований, как молекулярная динамика и геофизическое моделирование. Ввести суперкомпьютер в эксплуатацию планируется в 2026 году.

02.06.2025 [12:24], Сергей Карасёв

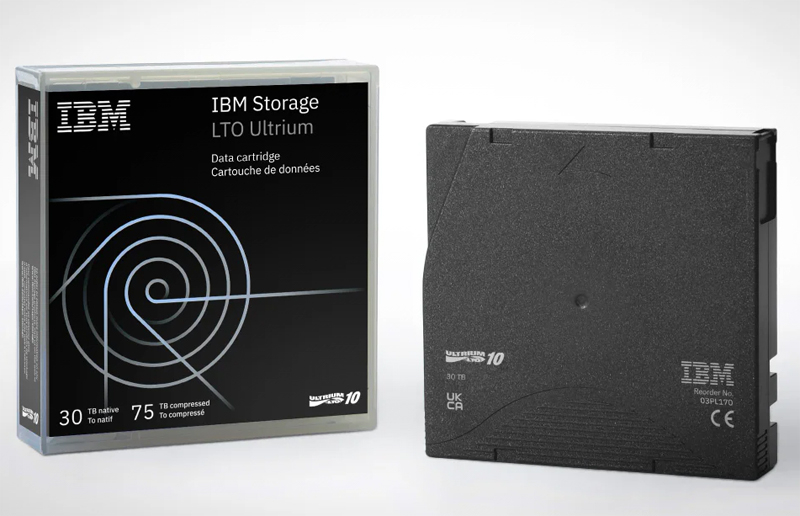

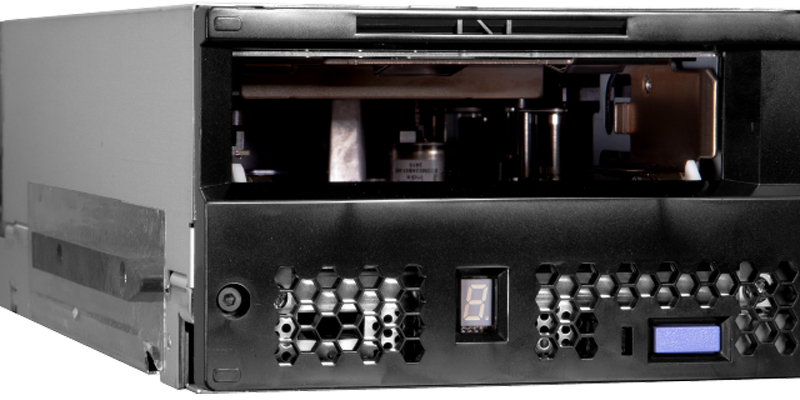

Представлены ленточные приводы и картриджи LTO-10 ёмкостью до 75 ТбайтIBM анонсировала ленточные картриджи LTO Ultrium 10 и приводы LTO-10 Tape Drive поколения LTO-10 для «холодного» хранения больших объёмов информации. Изделия могут применяться в таких областях, как облачные вычисления, мультимедиа и развлечения, цифровое видеонаблюдение, архивирование файлов и резервное копирование. Картриджи LTO Ultrium 10 имею «сырую» ёмкость 30 Тбайт, которая может быть увеличена до 75 Тбайт при использовании сжатия 2,5:1. Это несколько расходится с ранее опубликованными планами, которые предполагают, что изделия LTO-10 имеют вместимость 36 Тбайт и могут хранить до 90 Тбайт данных со сжатием. Возможно, консорциум LTO пересмотрел свою спецификацию в отношении LTO-10. Не исключено, что в будущем появятся более ёмкие накопители.

Источник изображений: IBM Ленточные накопители поддерживают шифрование по алгоритму AES-256. Доступны варианты с возможностью перезаписи, а также картриджи WORM (однократная запись и многократное чтение). IBM также будет предлагать изделия со встроенными RFID-метками. В свою очередь, приводы LTO-10 Tape Drive в зависимости от модификации оснащаются двумя портами FC32 или двумя портами SAS-3, что позволяет последовательно подключать второе устройство. В обоих случаях предусмотрен один разъём Ethernet. Скорость передачи несжатых данных достигает 400 Мбайт/с (как у LTO-9), данных с компрессией — 1000 Мбайт/с. Приводы доступны в форм-факторах полной и половинной высоты.  Для изделий LTO-10, по-видимому, не предусмотрена обратная совместимость с LTO-оборудованием предыдущих поколений. Отмечается, что привод имеет новую конструкцию, включая ASIC, головку чтения/записи и механизм загрузки. Ленточные системы могут быть интегрированы в инфраструктуры на базе Windows и Unix/Linux.

08.05.2025 [19:20], Сергей Карасёв

IBM представила сервер LinuxONE Emperor 5 на платформе Telum II для ИИ-задачКомпания IBM анонсировала сервер LinuxONE Emperor 5, который, как утверждается, обеспечивает высокие показатели производительности, безопасности и масштабируемости. Новинка ориентирована на работу с ИИ-приложениями и нагрузками, для которых требуется интенсивное использование данных. В основу LinuxONE Emperor 5 положена фирменная аппаратная платформа Telum II. Этот процессор содержит восемь ядер с фиксированной рабочей частотой 5,5 ГГц, а также ИИ-блок с производительностью 24 TOPS. Система может объединять до четырёх узлов (drawer) на базе Telum II. Максимальный объём памяти составляет 64 Тбайт.

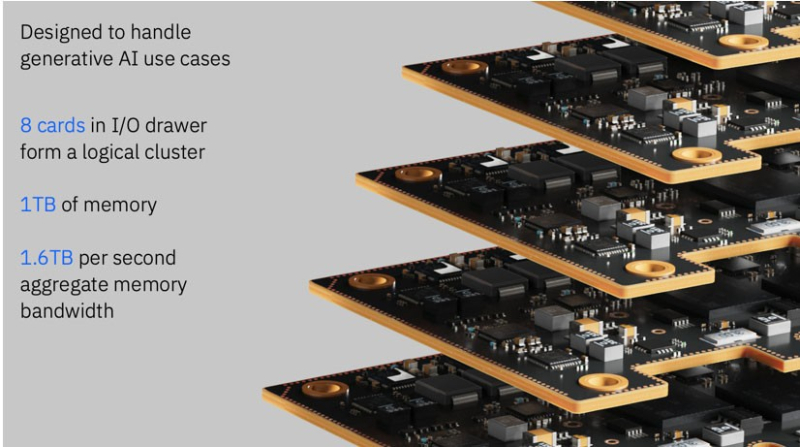

Источник изображения: IBM Модель LinuxONE Emperor 5 спроектирована с прицелом на экономию энергопотребления, финансовых затрат и занимаемой площади в дата-центре. По заявлениям IBM, благодаря консолидации рабочих нагрузок система обеспечивает снижение общей стоимости владения до 44 % за пятилетний период лет по сравнению с сопоставимыми по классу x86-серверами. При этом заявлена высокая надёжность: доступность достигает 99,999999 %, что эквивалентно всего 315 мс простоя в течение года. «Организации могут сэкономить до 94 % затрат на программное обеспечение за пять лет, переместив облачные контейнерные рабочие нагрузки с платформ x86 на LinuxONE Emperor 5», — заявляет IBM. В IV квартале текущего года для LinuxONE Emperor 5 станут доступны ИИ-ускорители IBM Spyre Accelerator, выполненные в виде карт расширения PCIe. Они оптимизированы специально для генеративного ИИ. Для машины сертифицировано использование Red Hat Enterprise Linux, SUSE Enterprise Linux и Ubuntu Linux.

07.05.2025 [09:05], Владимир Мироненко

IBM разработала инструменты для быстрого создания и интеграции ИИ-агентовIBM планирует укрепить свои позиции на быстрорастущем рынке ИИ-технологий с помощью увеличения инвестиций в США и предложения собственных инструментов, которые помогут клиентам управлять ИИ-агентами для их ключевых бизнес-приложений. Об этом сообщил генеральный директор IBM Арвинд Кришна (Arvind Krishna) в интервью агентству Reuters. Глава IBM заявил, что разработанное компанией ПО позволяет клиентам создавать собственные ИИ-системы, а также интегрировать ИИ-агентов от других провайдеров, включая Salesforce, Adobe и Workday. Это поможет удовлетворить потребность в кастомных решениях во многих областях бизнеса. Подход IBM заключается в том, чтобы предложить полный спектр облачных и ИИ-сервисов остальным компаниям, которые в настоящее время полагаются на лидеров рынка AWS и Microsoft. Особое внимание IBM уделяет внедрению функций ИИ в мультиоблачных платформах, что найдёт спрос среди тех, кому нужны кастомные ИИ-решения, а также в собственные инфраструктуры заказчиков для управления данными.

Источник изображения: IBM По словам гендиректора IBM, предлагаемые инструменты, позволяющие создавать собственных ИИ-агентов в течение не более пяти минут, основаны на семействе LLM Granite, а также на альтернативных моделях от Meta✴ Platforms и Mistral. IBM сообщила, что уже получила заказы на создание решений на базе генеративного ИИ на $6 млрд. Также компания объявила в апреле о планах инвестировать в течение пяти лет $150 млрд в США, где она в течение более 60 лет производит мейнфреймы. Кришна подчеркнул, что квантовые компьютеры тоже будут производиться в США. Глава IBM отметил, что синергия мейнфреймов, ИИ и квантовых вычислений, как ожидается, создаст надёжный и устойчивый рынок, в который следует инвестировать и который позволит компании использовать эти достижения в течение следующего десятилетия. Кришна добавил, что фокус на технологии и сокращение регулирования со стороны администрации оказали благотворное влияние на экономику США, способствуя её росту. Это позволяет IBM наращивать инвестиции и инновации, тем самым потенциально укрепляя свою конкурентную позицию как поставщика бизнес-решений на основе ИИ.

28.04.2025 [22:55], Владимир Мироненко

IBM пообещала инвестировать $150 млрд в США в течение пяти лет, но где она возьмёт столько денег — не сказалаIBM объявила о планах инвестировать в расширение присутствия в США в течение пяти лет $150 млрд, в том числе более $30 млрд на исследования, а также разработку мейнфреймов и квантовых компьютеров. Компания заявила, что ее цель — подпитывать экономику страны и «ускорять свою роль мирового лидера в области вычислений», пишет агентство Bloomberg. Вместе с тем компания в последние годы неуклонно переносила разработку за рубеж. В настоящее время у IBM есть производственная площадка по выпуску мейнфреймов в Покипси (Poughkeepsie) в штате Нью-Йорк. Она также управляет парком квантовых компьютеров и активно расширяет присутствие на рынке ПО. Компания заявила, что планы по инвестициям подтверждают её приверженность инновациям и экономическим возможностям США. После победы на президентских выборах в США Дональда Трампа (Donald Trump) и увеличения им ввозных пошлин на электронику и компоненты американские технологические гиганты, включая Apple и NVIDIA начали наращивать инвестиции в производство в стране. К ним присоединились зарубежные производители, такие как TSMC. Где IBM возьмёт $150 млрд, не уточняется. В последнем квартале её выручка составила $14,54 млрд, а чистая прибыль — $1,06 млрд. «Мы были сосредоточены на американских рабочих местах и производстве с момента нашего основания 114 лет назад, и с этим инвестиционным и производственным обязательством мы гарантируем, что IBM останется центром самых передовых в мире вычислительных и ИИ-возможностей», — указал в заявлении генеральный директор IBM Арвинд Кришна. IBM также заявила, что она несёт ответственность за инновации, «включая системы обработки данных, которые обеспечили работу системы социального обеспечения США, программу Apollo, которая отправила человека на Луну, и решения, которые двигают бизнес во всех отраслях». Она также охарактеризовала себя как «одного из крупнейших в стране работодателей в сфере технологий». Как отметил ресурс The Register, заявления IBM контрастируют с реальным положением дел, поскольку в течение многих лет компания активно перемещала рабочие места в страны с более низкой стоимостью труда, и сейчас не менее трети её глобального штата приходится на Индию и Бангладеш. Уже по состоянию на 2017 года там работало около 122 тыс., что стало известно благодаря внутренней утечке служебной записки от Ти-Джей Шембекара (TJ Shembekar), директора IBM по управлению глобальным персоналом. Как пишет The Register, после этого IBM неоднократно сокращала сотрудников в США. В марте она провела очередную серию увольнений в США, открыв вакансии на аналогичные должности в Индии. Благодаря такой политике средняя зарплата в IBM гораздо ниже, чем в других крупных компаниях. По данным The Register, средняя заработная плата сотрудника IBM за 2024 год составила $48 582, тогда как в Dell она была равна $73 283, а в HPE — $66 886. Сам генеральный директор IBM Арвинд Кришна (Arvind Krishna) получил полный пакет компенсаций свыше $25 млн.

25.04.2025 [00:32], Владимир Мироненко

Стараниями Илона Маска IBM потеряла миллионные контракты, но всё равно превзошла ожидания аналитиков по итогам кварталаIBM сообщила финансовые результаты I квартала 2025 года, завершившегося 31 марта. Несмотря на то, что выручка компании и прибыль превзошли ожидания аналитиков Уолл-стрит, её акции упали на 6 %, что отчасти связано с потерей ряда контрактов, которые отменил или отложил Департамент эффективности правительства (DOGE) под руководством Илона Маска (Elon Musk). Финансовый директор IBM Джим Кавано (Jim Kavanaugh) сообщил агентству Bloomberg, что рекомендации DOGE привели к отмене или приостановке 15 контрактов компании с государственными учреждениями на сумму около $100 млн. Однако, как пишет The Register, в ходе телефонной конференции с аналитиками Уолл-стрит он уже говорил об отмене всего лишь «нескольких контрактов», из-за чего потери составили менее $100 млн. Генеральный директор IBM Арвинд Кришна (Arvind Krishna) заявил, что усилиями DOGE в I квартале была отменена всего лишь «пара контрактов». Это, например, сделка с агенством USAID, которое был закрыто агентством Маска. Он назвал влияние расторжения контрактов незначительным, но отказался делать прогнозы по этому поводу относительно будущих кварталов.

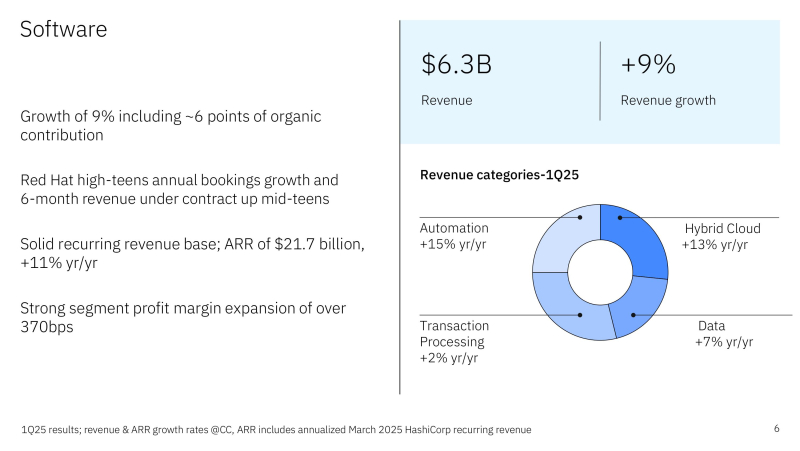

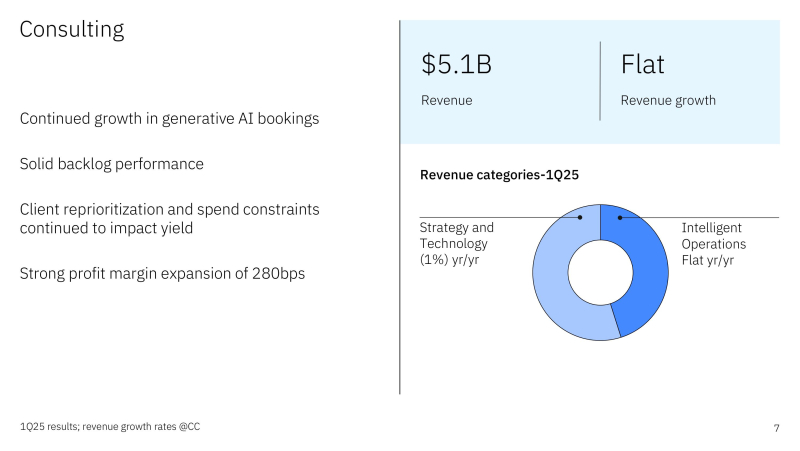

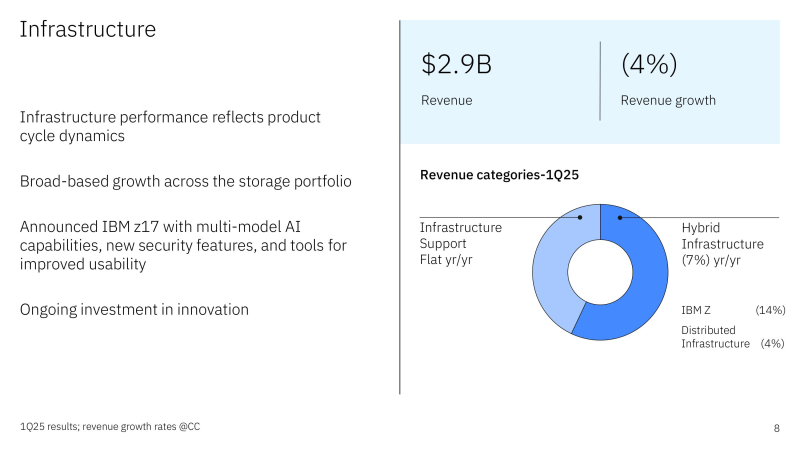

Источник изображений: IBM Чистая прибыль (GAAP) компании составила $1,06 млрд или $1,12 на акцию, что меньше результата в $1,61 млрд или $1,72 на акцию годом ранее. Скорректированная чистая прибыль (Non-GAAP) в размере $1,60 на акцию оказалась ниже прошлогоднего показателя в $1,68, но превзошла прогноз аналитиков в размере $1,40 (по данным CNBC). Выручка выросла на 0,6 % за квартал с $14,46 млрд годом ранее до $14,54 млрд в отчётном квартале при прогнозе $14,4 млрд. При этом выручка от разработки ПО выросла на 7 % до $6,34 млрд, что соответствует консенсус-прогнозу аналитиков, опрошенных StreetAccount. Категория гибридного облачного ПО, включающая Red Hat, показала рост на 12 %, тогда как в IV квартале рост составил 16 % — это уже седьмой квартал подряд продолжающегося роста выручки подразделения. Выручка подразделения по автоматизации увеличилась год к году на 14 %, выручка подразделения по обработке данных и ИИ — на 5 %. Консалтинговое подразделение IBM принесло $5,07 млрд дохода, что на 2 % меньше год к году и немного выше консенсус-прогноза аналитиков StreetAccount в $5,05 млрд. Доходы консалтингового сегмента IBM остались почти на прежнем уровне, поскольку «клиенты откладывают принятие решений в дискреционных (зависящих от личного усмотрения) проектах», сообщил Кавано. IBM прогнозирует, что её консалтинговый бизнес будет в обозримом будущем расти на 5–6 % в год и видит стратегическую ценность в его способности стимулировать продажи инфраструктуры. Инфраструктурное подразделение компании, сообщило о снижении дохода на 6 % до $2,89 млрд, что выше консенсус-прогноза аналитиков в $2,76 млрд. Падение произошло в основном из-за сокращения продаж мейнфреймов z16, находящихся в конце жизненного цикла. Ранее в этом месяце IBM представила их замену — мейнфрейм z17. По словам Кришны, z17 обеспечивает улучшенные ИИ-возможности за счёт мультимодальности, новых функций безопасности для защиты данных и инструментов, которые используют ИИ для повышения удобства использования системы. Кроме того, новинка более энергоэффективна и производительна, добавил он. Также упала выручка от гибридной инфраструктуры — на 9 %, распределённой инфраструктуры — на 5 % и инфраструктуры поддержки — на 3 %. «Мы превзошли ожидания по выручке, прибыльности и свободному денежному потоку, чему способствовала сила всего нашего портфолио ПО», — заявил Кришна. «По-прежнему сохраняется высокий спрос на генеративный ИИ, и наш портфель заказов составляет более $6 млрд с начала года по сегодняшний день, увеличившись более чем на $1 млрд за квартал», — добавил он. Кавано отметил, что компания внедрила ИИ в более чем 70 рабочих процессов и сократила расходы более чем на $1 млрд за счёт повышения эффективности цепочки поставок. Чтобы укрепить доверие инвесторов, IBM вопреки своей давней практике не публиковать квартальные прогнозы, сообщила прогноз на II квартал. «Сейчас, в свете беспрецедентной динамики неопределённости, происходящей на рынке, мы решили дать прогноз по выручке на II квартал, — сказал Кавано. — Мы сочли себя обязанными предоставить как можно больше прозрачности нашей группе инвесторов». Во II квартале IBM прогнозирует выручку в размере от $16,4 до $16,75 млрд. В середине диапазона — $16,58 млрд — это опережает консенсус-прогноз аналитиков, опрошенных LSEG, в $16,33 млрд. IBM также подтвердила свой прогноз на 2025 год по свободному денежному потоку в размере $13,5 млрд и росту выручки не менее 5 %. Акции IBM выросли с начала года почти на 12 %, в то время как индекс S&P 500 упал более чем на 8 %. Руководство IBM утверждает, что компания хорошо подготовилась к тому, чтобы выдержать торговую войну, поскольку всего 5 % её расходов приходится на импортные товары, пишет SiliconANGLE. Федеральные правительственные контракты также составляют менее 5 % выручки компании.

08.04.2025 [17:41], Алексей Степин

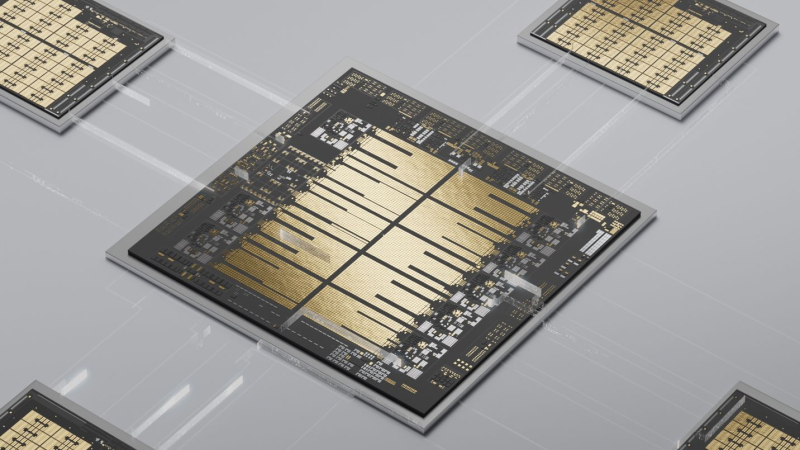

Мейнфрейм для ИИ: IBM представила платформу z17 с восьмиядерными процессорами Telum II и ускорителями SpyreХотя слово «мейнфрейм» и может вызвать ассоциации с катушками магнитной ленты и зелёными символами на экране терминала, системы такого класса продолжают оставаться ключевыми для крупного бизнеса: 71 % компаний из списка Fortune 500 используют для критических задач именно мейнфреймы. Объём рынка мейнфреймов в прошлом году составил $5,3 млрд, так что это весьма лакомый кусок, упускать который главный производитель этих систем, компания IBM, не собирается. Сегодня она анонсировала мейнфреймы z17 — они идут на смену поколению z16 и обладают куда большей производительностью в актуальных на сегодня ИИ-сценариях. В основе новой платформы лежат анонсированные осенью прошлого года процессоры Telum II с архитектурой z/Architecture. Это поколение чипов использует техпроцесс Samsung 5HPP и включает в себя восемь улучшенных ядер Telum с частотой 5,5 ГГц с переработанной и существенно усиленной подсистемой кеширования. Новые веяния в полной мере коснулись Telum II: каждый процессор получил поддержку форматов INT8/FP16, а также ИИ-сопроцессор с производительностью 25 Топс (768 Топс для полностью сконфигурированного мейнфрейма). По нынешним меркам эти цифры не выглядят слишком высокими, однако в составе z17 процессоры Telum II будут работать совместно с 32-ядерными ИИ-ускорителями Spyre. На момент анонса речь идёт о 48 чипах Spyre в составе каждого мейнфрейма z17, что при 300 Топс на ускоритель суммарно даёт 14,4 Попс (петаопс), но в течение года планируется нарастить этот показатель вдвое — до 96 ускорителей на мейнфрейм, что с учётом возможностей самих Telum II даст уже 30 Попс. Переварить объёмы данных, характерные для современных ИИ-моделей платформе поможет интегрированный в Telum II блок DPU. Согласно анонсу, z17 может обработать за день до 450 млрд. инференс-операций, что на 50 % больше показателей предыдущегоz16. При проектировании z17 IBM потратила более 2 тыс. часов, исследуя отклики от более чем сотни клиентов. Компания считает новинку универсальным решением с более чем 250 вариантами использования в ИИ-задачах, в том числе в качестве платформы для генеративного ИИ.  Первые поставки z17 начнутся 18 июня, однако пока без плат ускорителей Spyre — последние дебютируют позднее, в IV квартале. Для новой платформы IBM готовит и новую операционную систему z/OS 3.2, которая должна дебютировать в III квартале. В ней появится родная поддержка аппаратных ускорителей ИИ, а также ИИ-элементы управления самой системой. Кроме того, в z/OS 3.2 будет реализована поддержка новых типов доступа к данным, баз данных типа NoSQL, а также гибридных облачных вычислений. |

|