Материалы по тегу: ff

|

15.02.2025 [23:59], Сергей Карасёв

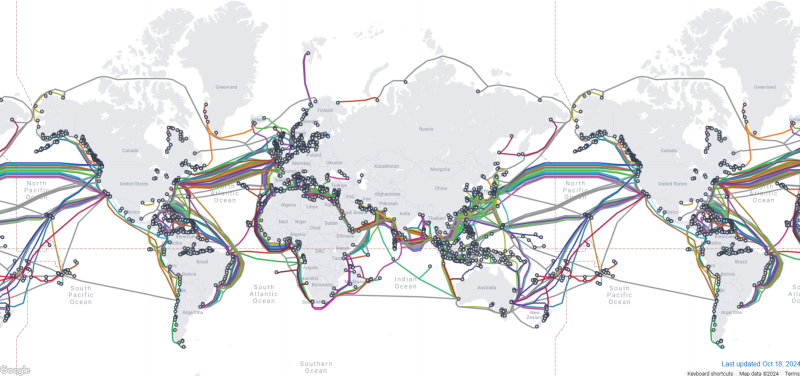

50 тыс. км под водой: Meta✴ представила проект Waterworth по созданию самого протяжённого в мире интернет-кабеляКомпания Meta✴ официально анонсировала инициативу Project Waterworth по строительству самого протяжённого в мире подводного интернет-кабеля. После завершения прокладки новая оптоволоконная линия длиной около 50 тыс. км обеспечит высокоскоростную связь в глобальном масштабе, охватив пять континентов. О дорогостоящем проекте сообщалось в декабре прошлого года. Тогда говорилось, что его реализация потребует инвестиций в размере $10 млрд. В результате, Meta✴ получит собственный выделенный канал для передачи данных по всему миру. Это в числе прочего поможет укрепить позиции компании в области ИИ. Подводный кабель Waterworth соединит США, Индию, Бразилию, Южную Африку и другие регионы. Конкретные детали маршрута и сроки реализации проекта не раскрываются. Известно, что линия предусматривает использование 24 пар волокон. Кабель будет проходить на глубине до 7000 м. При развёртывании системы Meta✴ намерена применять усовершенствованные методы заглубления в зонах повышенного риска, таких как мелководье вблизи побережья: это обеспечит улучшенную надёжность и защиту от возможных повреждений якорями морского транспорта.

Источник изображений: Meta✴ Meta✴ заявляет, что многомиллиардный многолетний проект Waterworth поможет в расширении и повышении стабильности глобальных цифровых магистралей благодаря формированию трёх новых океанических коридоров с высокой пропускной способностью. Это, как утверждается, откроет дополнительные возможности в плане внедрения инноваций в области ИИ по всему миру. В частности, Waterworth поможет в укреплении цифровой инфраструктуры в Индии — самой густонаселённой стране мира. Нужно отметить, что Meta✴ участвует в ряде других проектов по прокладке интернет-кабелей, включая Echo и Bifrost, Havhingsten, Amite и Anjana. Кроме того, компания является ключевым владельцем самой протяжённой на данный момент кабельной системы 2Africa. В январе сообщалось, что Meta✴ также проложит тихоокеанский интернет-кабель ORCA, связывающий Тайвань с США. Эксперты отмечают, что теперь именно гиперскейлеры контролируют большинство подводных интернет-кабелей, что ставит под угрозу открытость и стабильность Сети.

14.02.2025 [09:45], Сергей Карасёв

Arm выпустит собственные чипы для ЦОД, а их первым покупателем станет Meta✴Британская компания Arm, 90 % которой принадлежит японскому холдингу SoftBank, выйдет на рынок процессоров для серверов, ориентированных на крупные дата-центры. Как сообщает газета Financial Times, эти изделия дебютируют в текущем году, а их первым заказчиком станет Meta✴ Platforms. Весной 2024 года сообщалось, что Arm намерена разработать собственный ИИ-чип. Тогда говорилось, что его массовый выпуск будет налажен к осени 2025-го на мощностях контрактного производителя. В частности, холдинг SoftBank вёл переговоры на соответствующую тему с TSMC.

Источник изображения: Arm Как теперь стало известно, первым изделием собственной разработки Arm станет серверный CPU, а не ИИ-чип. Архитектура готовящегося решения предполагает возможность кастомизации под нужды заказчика. Этим воспользуется Meta✴, которая активно расширяет инфраструктуру ЦОД, а перспективе намерена потратить «сотни миллиардов долларов» на развитие ИИ-экосистемы. Рене Хаас (Rene Haas), генеральный директор Arm, отметил, что компания намерена официально представить процессор предстоящим летом. При этом вдаваться в подробности о технических характеристиках изделия он не стал. Выход Arm на рынок аппаратных решений будет означать серьёзное изменение бизнес-модели: ранее компания зарабатывала на лицензировании своих разработок другим участникам рынка, в том числе поставщикам решений для дата-центров и облачных платформ. Вместе с тем в ИИ-сегменте Arm увеличивает выручку путём постоянного повышения лицензионных сборов за свои технологии и благодаря взиманию роялти за каждый чип, продаваемый другими компаниями. Недавно также сообщалось, что SoftBank вскоре может заключить сделку по покупке разработчика серверных Arm-чипов Ampere за $6,5 млрд. Таким образом, японский холдинг и подконтрольная ему британская Arm готовятся составить серьёзную конкуренцию другим игрокам рынка процессоров для серверов. У AWS, Google Cloud и Microsoft Azure уже есть собственные серверные Arm-процесоры: Graviton, Axion и Cobalt 100.

13.02.2025 [01:05], Владимир Мироненко

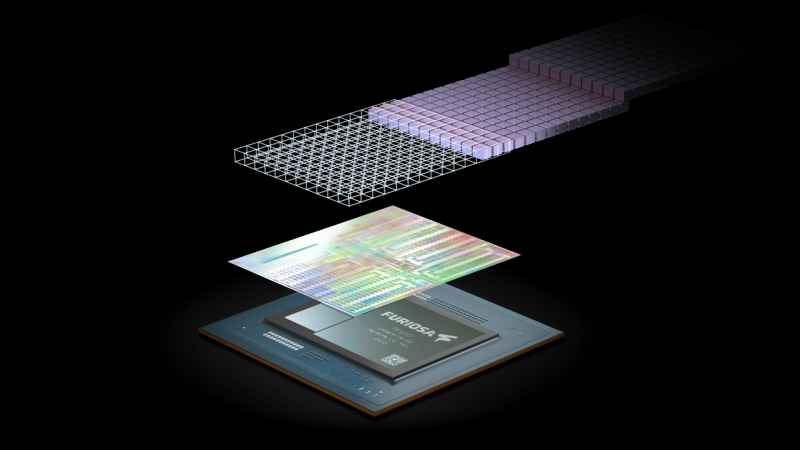

Meta✴ намерена купить разработчика ИИ-ускорителей FuriosaAI, и не одна онаMeta✴ ведет переговоры о приобретении южнокорейского стартапа FuriosaAI, разработчика ИИ-ускорителей, базирующегося в Сеуле (Южная Корея) и Санта-Кларе (США), что позволит ей выпускать собственные кастомные чипы на фоне нехватки ускорителей NVIDIA, сообщил Forbes со ссылкой на информированные источники. По словам одного из источников, сделка может быть заключена уже в этом месяце. Другой источник утверждает, что ещё несколько компаний ведут переговоры о приобретении FuriosaAI. Компанию основал в 2017 году Джун Пайк (June Paik), ранее работавший в Samsung Electronics и AMD и занимающий сейчас пост гендиректора. FuriosaAI привлекла в общей сложности около ₩170 млн (около $115 млн) венчурного финансирования. Среди первых инвесторов были южнокорейский интернет-гигант Naver и базирующаяся в Сеуле DSC Investment. В последнем раунде финансирования, прошедшем на прошлой неделе, FuriosaAI получила ₩2 млрд (около $1,4 млн) от южнокорейской CRIT Ventures. В августе прошлого года FuriosaAI представила энергоэффективный ИИ-ускоритель RNGD, который был разработан в партнёрстве с тайваньским производителем микросхем Global Unichip Corp. По словам компании, RNGD является идеальным выбором для крупномасштабного развёртывания продвинутых моделей генеративного ИИ, таких как Llama 2 и Llama 3, поскольку не уступает передовым ускорителям по производительности, отличаясь при этом низким TDP в пределах 150 Вт. RNGD предназначен для инференса и оснащён HBM3-памятью SK hynix. FuriosaAI сообщила, что RNGD показывает в три раза большую производительность в расчёте на 1 Вт, чем ускорители NVIDIA H100 при запуске продвинутых больших языковых моделей (LLM). Как ожидается, массовое производство RNGD начнётся во II половине 2025 года. При этом сама Meta✴ разработала уже два поколения собственных ИИ-ускорителей для инференса. И если от MTIA v1 в итоге было решено отказаться в пользу в первую очередь продуктов NVIDIA, то MTIA v2, судя по всему, активно внедряются, но их всё ещё не хватает для удовлетворения потребностей компании.

Источник изображения: Meta✴ По данным Forbes, заинтересованность в RNGD также продемонстрировали исследовательская ИИ-лаборатория LG и Saudi Aramco. В сентябре последняя подписала меморандум о взаимопонимании с FuriosaAI и Cerebras Systems, ещё одним производителем ИИ-ускорителей, для «изучения сотрудничества в области суперкомпьютеров и ИИ». Переговоры проходят спустя несколько месяцев после того, как ещё один южнокорейский стартап в сфере ИИ Rebellions, завершил слияние с поддерживаемой SK hynix компанией Sapeon. Объединённая компания, которая осуществляет деятельность под брендом Rebellions, является первым в Южной Корее единорогом в области производства чипов ИИ.

11.02.2025 [11:35], Сергей Карасёв

QNAP представила стоечное хранилище TS-h765eU с поддержкой накопителей LFF, SFF, E1.S и М.2Компания QNAP Systems анонсировала гибридное стоечное хранилище TS-h765eU в форм-факторе 1U. Устройство выполнено в корпусе уменьшенной глубины, которая составляет 292,1 мм: благодаря этому новинка подходит для применения в помещениях с ограниченным пространством, например, в комнатах видеонаблюдения или небольших офисах. В основу положен процессор Intel Atom x7405C поколения Amston Lake с четырьмя ядрами (до 3,4 ГГц) и показателем TDP в 12 Вт. Объём оперативной памяти DDR5 в базовой конфигурации составляет 8 Гбайт (один слот SO-DIMM) с возможностью расширения до 16 Гбайт. Во фронтальной части NAS расположены четыре отсека для HDD или SSD типоразмера LFF или SFF с интерфейсом SATA-3. В тыльной области находятся три слота для накопителей E1.S NVMe PCIe SSD толщиной 5,9/9,5/15 мм: благодаря специальным адаптерам можно также устанавливать модули M.2 2280 NVMe PCIe SSD. Хранилище располагает двумя сетевыми портами 2.5GbE RJ-45. При необходимости могут быть добавлены два адаптера QXG-ES10G1T (монтируются в слоты E1.S) с портом 10GbE. Устройство получило по одному разъёму USB 3.2 Gen 1 и USB 2.0. Габариты составляют 43 × 430 × 292,1 мм, вес — 4,51 кг. За охлаждение отвечают три вентилятора диаметром 40 мм. Диапазон рабочих температур — от 0 до +40 °C. В качестве программной платформы применяется ОС QuTS hero h5.2.3. Задействована высоконадёжная файловая система ZFS для обеспечения максимальной целостности данных и стабильности. Доступны гибкие средства для резервного копирования, синхронизации и восстановления информации.

31.01.2025 [14:15], Руслан Авдеев

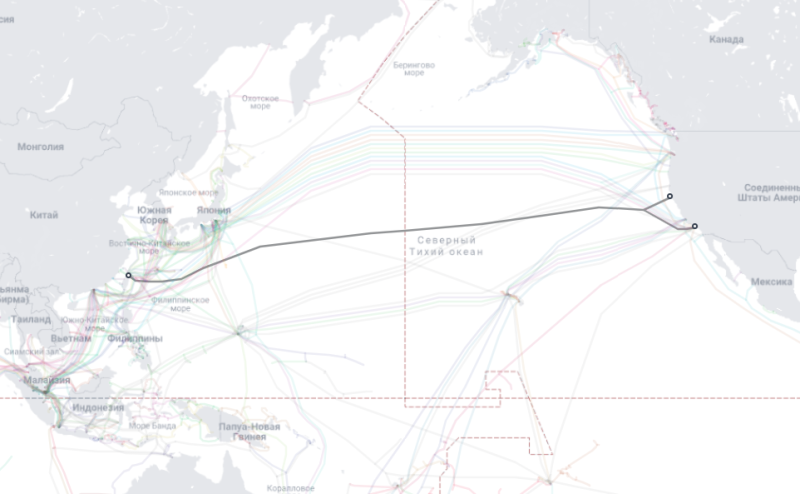

От Тайваня до США: Meta✴ проложит тихоокеанский интернет-кабель ORCAMeta✴ (Facebook✴) проложит кабель ORCA из шести оптоволоконных пар, напрямую связывающих Тайвань с США. Посадочные станции будут работать в Точэне (Toucheng) на Тайване, в Эрмоса-Бич (Hermosa Beach) в Калифорнии и Манчестере (тоже в Калифорнии), сообщает Subsea Cables. Предполагается, что кабель будет готов к эксплуатации во II квартале 2027 года. В заявке на подключение подводного кабеля к наземной инфраструктуре Facebook✴ отметила, что руководствуется быстрым ростом трафика между Тайванем и США. В связи с тем, что протяжённость кабеля составляет 12 тыс. километров, а по пути не будет возможности регенерации сигнала, проектная пропускная способность кабеля не слишком велика: 12,8 Тбит/с на пару или 76,8 Тбит/с совокупно. ORCA представляет собой «открытый» кабель, каждая пара в котором будет иметь управляющееся отдельными собственниками оконечное оборудование, коллективным будет только энергоснабжение. Поскольку Meta✴ является единственным владельцем цифровой магистрали, вероятно, она будет продавать ёмкость сторонним клиентам, чтобы окупить капиталовложения и разделить операционные расходы.

Источник изображения: TeleGeography У компании есть и другие, ещё более масштабные проекты. В декабре 2024 года сообщалось, что Meta✴ готовит кругосветный подводный кабель протяжённостью 40 тыс. км, стоимость проекта составляет $10 млрд. Кроме того, компания является совладельцем кабельной системы 2Africa длиной порядка 45 тыс. км.

25.01.2025 [00:59], Владимир Мироненко

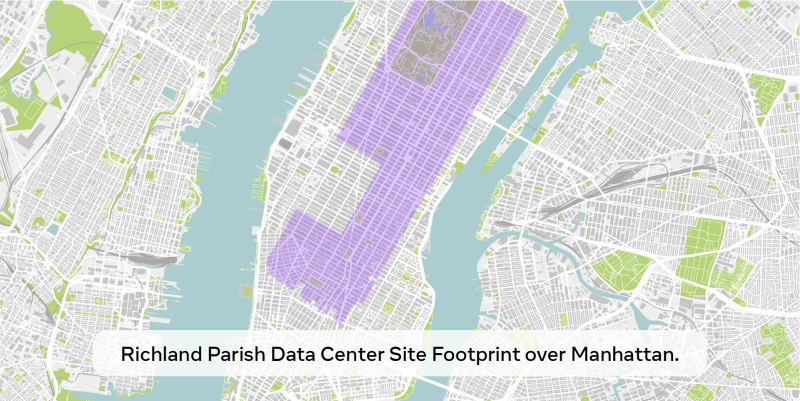

Meta✴ выделит $60–65 млрд на развитие ИИ в 2025 годуMeta✴ Platforms планирует в 2025 году выделить на капитальные затраты $60–65 млрд. Эти средства будут направлены в основном на строительство ЦОД и серверы, а также на «значительное» расширение команды ИИ-специиалистов. Об этом сообщил гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) в своём аккаунте в соцсети Facebook✴. С учётом того, что в прошлом году капиталовложения Meta✴ составили от $35 до $40 млрд, это представляет собой значительный рост расходов, отметил DataCenter Dynamics. Для сравнения, Microsoft заявила, что потратит в этом году $80 млрд на ИИ ЦОД. В своём сообщении Цукерберг подтвердил планы Meta✴ инвестировать $10 млрд в строительство гигантского ЦОД в Луизиане. Meta✴ сообщила, что специально спроектированный кампус площадью 1,2 млн м2 станет крупнейшим дата-центром компании. «Meta строит ЦОД мощностью более 2 ГВт, который будет настолько большим, что покроет значительную часть Манхэттена», — сказал Цукерберг. На строительной площадке уже начались подготовительные работы, а строительство кампуса будет продолжаться до 2030 года. Цукерберг отметил, что этот год будет определяющим для ИИ. Meta✴ планирует ввести в 2025 году в эксплуатацию около 1 ГВт мощностей и иметь к концу года парк из более чем 1,3 млн ускорителей. Он также добавил, что у компании есть «капитал для продолжения инвестиций в ближайшие годы», что может быть отсылкой к критике Илоном Маском (Elon Musk) проекта Stargate, усомнившегося в том, что на его реализацию у SoftBank, OpenAI и остальных найдётся заявленная сумма в $500 млрд. Масштаб и сравнения, которые использовал Цукерберг, могут иметь более глубокий смысл: согласно документации, с которыми ознакомился Bloomberg, первый кампус Stargate будет размером с Центральный парк в Нью-Йорке, который сам по себе является всего лишь частью Манхэттена.

10.12.2024 [15:21], Владимир Мироненко

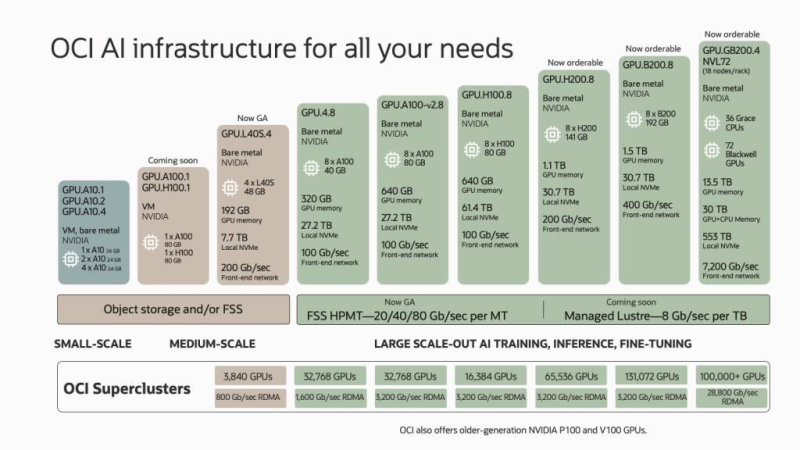

Спрос на ИИ-ускорители в облаке Oracle вырос за квартал на 336 %, а новым крупным клиентом стала Meta✴Американская корпорация Oracle сообщила результаты работы во II квартале 2025 финансового года, закончившемся 30 ноября 2024 года. Результаты и прогноз на текущий квартал оказались ниже ожиданий аналитиков Уолл-стрит и инвесторов, в связи с чем акции корпорации упали в понедельник в ходе расширенных торгов на 7 %. Выручка Oracle составила $14,06 млрд, превысив результат аналогичного финансового квартала годом ранее на 9 %, а также консенсус-прогноз аналитиков, опрошенных LSEG, в размере $14,1 млрд. Вместе с тем скорректированная прибыль на акцию (non-GAAP), составившая $1,47 и превысившая прошлогодний результат на 10 %, оказалась ниже ожиданий Уолл-стрит в размере $1,48 на акцию. Чистая прибыль (GAAP) увеличилась на 26 % до $3,15 млрд, или $1,10 на акцию, с $2,5 млрд, или $0,89 на акцию годом ранее. Выручка в сфере облачных сервисов и поддержки Oracle выросла по сравнению с прошлым годом на 12 % до $10,81 млрд, что составляет 77 % от общей выручки корпорации. Выручка от лицензирования облачных и локальных продуктов увеличилась всего на 1 % до $1,2 млрд. Вместе с тем упали продажи оборудования — на 4 % год к году до $728 млн, и сократилась выручка от сервисов — на 3 % до $1,33 млрд.

Источник изображения: Oracle Генеральный директор Oracle Сафра Кац (Safra Catz) заявила в ходе отчёта, что рекордный спрос на ИИ привёл к росту выручки Oracle Cloud Infrastructure во II квартале на 52 %, что намного выше темпов роста любого из гиперскейлеров. «Рост в сегменте ИИ нашего инфраструктурного бизнеса был необычайным — потребление GPU выросло на 336 % за квартал — и мы развернули самый большой и быстрый в мире облачный ИИ-суперкомпьютер из 65 тыс. ускорителей NVIDIA H200», — сообщила она, добавив, что в этом финансовом году общий доход Oracle Cloud должен превысить $25 млрд. Oracle заявила, что только что подписала соглашение с Meta✴, позволяющее последней использовать её инфраструктуру для работы в различных проектах, связанных с семейством больших языковых моделей Llama. Одним из ключевых заказчиков ИИ-ускорителей в облаке Oracle также являются Microsoft с OpenAI. «Oracle Cloud Infrastructure обучает несколько важнейших в мире моделей генеративного ИИ, поскольку мы быстрее и дешевле других облаков», — указал основатель и главный технический директор Oracle Ларри Эллисон (Larry Ellison) в своем заявлении. В III квартале 2025 финансового года Oracle ожидает роста выручки на 7–9 % — около $14,3 млрд в средней точке, что ниже прогноза Уолл-стрит в размере $14,65 млрд (согласно LSEG). Прогноз по скорректированной прибыли Oracle находится в пределах от $1,50 до $1,54 на акцию. Аналитики прогнозируют прибыль на акцию в размере $1,57. В сентябре Oracle повысила прогноз выручки на 2026 финансовый год до $66 млрд, что примерно на $1,5 млрд больше, чем ожидают аналитики. Также Oracle тогда объявила, что ее облачное подразделение начнёт принимать заказы клиентов на вычислительные кластеры из более чем 131 тыс. ускорителей NVIDIA Blackwell.

07.12.2024 [01:58], Руслан Авдеев

Новый гигантский ИИ-кампус Meta✴ похож на процессор, и это не случайностьНа днях Meta✴ объявила о намерении построить свой самый крупный дата-центр стоимостью $10 млрд в Луизиане (США). По данным Silicon Angle, объект станет крупнейшим дата-центром компании. Строительство кампуса Franklin Farm начнётся уже в декабре и продлится до 2030 года. Инфраструктура, включая сетевое оборудование и серверы, будет изначально оптимизирована для ИИ-нагрузок. Общая площадь кампуса составит чуть более 900 га, площадь строений более 370 тыс. м2. Власти Луизианы заявили, что постройка кампуса ЦОД обеспечит регион новыми технологическими возможностями. В Meta✴ объявили, что помимо создания рабочих мест компания инвестирует $200 млн и в совершенствование местной инфраструктуры, в т.ч. в дороги и системы водоснабжения. После запуска ЦОД стартует и программа грантов Community Action Grants для организации партнёрских связей с местными школами и организациями — кузницей будущих кадров для компании. В ходе строительства будет задействовано более 5 тыс. рабочих, а после окончания штат ЦОД составит около 500 человек.

Источник изображения: Meta✴ Как подметили в The Next Platform, рендер кампуса очень напоминает AMD EPYC. И это не случайность — вычислительные «чиплеты»-здания расположены вокруг центрального «IO-хаба». Современные ИИ-кластеры действительно состоят из отдельных т.н. «островов», внутри которых скорость обмена данными и связность гораздо выше, чем за их пределами. Здания справа вверху могут выполнять некие функции хранения данных. «Зелёные зоны» в окружении деревьев, вероятно — пруды для хранения воды для охлаждения. Для своего кампуса Meta✴ пообещала использовать на 100 % «чистую» и возобновляемую энергию. Правда, обольщаться на этот счёт не стоит. Компания будет выкупать «зелёную» энергию где-то ещё, а вот сам 1,5-ГВт кампус будет запитан от строящейся поблизости газовой электростанции Entergy общей мощностью 2,2 ГВт. В отчёте об устойчивом развитии Meta✴ объявила, что в 2023 году располагала контрактами на 11,7 ГВт возобновляемой энергии для компенсации потребления своих ЦОД, 6,7 ГВт из которой приходилось на США. Общемировое энергопотребление Meta✴ превышает 12 ГВт, но компания намерена получить ещё 1–4 ГВт от АЭС к концу десятилетия.

Источник изображения: Meta✴ Также Meta✴ объявила, что намерена свести к минимуму потребление воды новым ЦОД. По данным NPR, средний дата-центр требует более 1135 м3 воды в день — столько же потребляют 1 тыс. домохозяйств США. В Meta✴ обещают, что проекты «восстановления» воды в Луизиане позволят получать в результате деятельности компании больше пресной воды, чем она будет тратить сама. Правда, куда будет деваться осадок после очистки вод дата-центра, пока не уточняется. По предварительным оценкам, из $10 млрд инвестиций около половины придётся на ИИ-ускорители. При средней цене в районе $25 тыс. речь может идти о 200 тыс. ИИ-ускорителей. Если же Meta✴ задействуют ускорители MTIA собственной разработки, которые вдвое дешевле сторонних, речь может идти уже о 400 тыс. На фоне планов xAI расширить ИИ-кластер Colossus со 100 тыс. ускорителей NVIDIA до 1 млн проект Franklin Farm смотрится скромно. Впрочем, как выяснилось, для обучения модели Llama-4 уже используются более 100 тыс. NVIDIA H100.

04.12.2024 [15:09], Руслан Авдеев

Meta✴ готова инвестировать в атомную энергетику для питания своих ЦОД в СШАКомпания Meta✴ ищет подрядчиков, способных к началу 2030-з годов начать поставки энергии от атомных реакторов в США. Проекты должны обеспечить энергией дата-центры компании и ближайшие поселения. Фактически компания вступает в своеобразный «клуб» гиперскейлеров, готовых использовать атомную энергию для питания дата центров. Над аналогичными проектами уже работают AWS, Google, Microsoft, Oracle и другие техногиганты, желающие получать «безуглеродную» энергию. «Запрос предложений» (request for proposals, RFP) предусматривает строительство значительных мощностей нового поколения, от одного до четырёх гигаватт. Хотя некоторые игроки рынка заключили сделки с конкретными энергетическими стартапами, Meta✴ предлагает широкое «окно возможностей» и открыта для самых разных идей и работы с всевозможными типами реакторов, разными локациями и т.п. Компания ищет партнёров, способных повысить доступность атомных реакторов, причём в масштабах, позволяющих значительно снизить себестоимость проектов, использовав многочисленные модули. Meta✴ ищет партнёров, способных выполнить проект от начала до конца — от поиска подходящих площадок и получения разрешений до разработки, работы с финансами, ввода в эксплуатацию, обслуживания и т.д. Это позволит быстро масштабировать проекты. В Meta✴ допускают, что места, в которых реакторы можно будет запустить быстрее всего, могут оказаться довольно далеко от её собственных кампусов ЦОД. Meta✴ признаёт, что в отличие от проектов возобновляемой энергетики, атомные проекты будут дороже, но зато они рассчитаны на более длительную эксплуатацию. Компания готова и покупать энергию, когда объекты заработают, и разделить расходы на строительство новых атомных мощностей. При этом компания подчёркивает, что нуждается в больших объёмах энергии и намерена преодолеть «нерешительность» инвесторов, намеренных потратить деньги на масштабные стройки. Ранее Meta✴ ужа прошла похожий путь с возобновляемой энергетикой, которая более десяти лет назад была намного дороже, а её востребованность была под вопросом. Утверждается, что с 2020 года все глобальные операции компании на 100 % обеспечиваются «чистой» и возобновляемой энергией. Сейчас на долю Meta✴ уже приходится 12 ГВт возобновляемой энергии по всему миру, но для ИИ ЦОД будущего этого может и не хватить. Первоначальных откликов на PFR будут ожидать до 7 февраля 2025 года.

02.12.2024 [12:36], Руслан Авдеев

Вокруг света за $10 млрд: Meta✴ намерена проложить собственный подводный интернет-кабель протяжённостью более 40 тыс. кмНа сервисы Meta✴ сегодня приходится 10 % кабельного и 22 % мобильного трафика мира. Инвестиции компании в ИИ должны даже увеличить эту долю, поэтому в Meta✴ готовят новую инфраструктуру для поддержки соответствующего бизнеса, сообщает TechCrunch. Речь идёт о новом кабеле огромной протяжённости. По данным источников TechCrunch, компания намерена проложить оптоволоконный кабель протяжённостью более 40 тыс. км, опоясывающий буквально весь мир, на что потребуются инвестиции в объёме $10 млрд. Проект рассчитан на годы работы. Впрочем, пока он находится на ранних стадиях, а сама компания должна официально объявить о новой инициативе в начале 2025 года. Задача будет непростой, поскольку компании вроде SubCom, способные прокладввать необходимую инфраструктуру, завалены контрактами на годы вперёд, в том числе от других гиперскейлеров. После завершения строительства Meta✴ получит собственный выделенный канал для передачи данных по всему миру. По словам источников, кабель протянется от восточного побережья США до Индии через Южную Африку, а оттуда дойдёт до западного побережья США через Австралию. Фактически появится огромная W-образная структура.

Источник изображения: frank mckenna/unsplash.com Meta✴ уже является совладельцем 16 существующих кабельных систем, включая 2Africa, опоясывающий африканский континент. При этом в Африке участниками проекта являются и многие другие компании, а владельцем нового кабеля глобального масштаба станет только Meta✴. В результате компания станет полноправным игроком на рынке кабельной инфраструктуры наравне с Google — последняя участвует приблизительно в 33 кабельных проектах. Долю в некоторых также имеют Amazon (AWS) и Microsoft, хотя в полной собственности кабелей у них нет. Тем не менее, ландшафт уже поменялся — в скором времени значительную часть подводных интернет-магистралей будут контролировать мегакорпорации. Владение собственным кабелем даст Meta✴ возможность распределять трафик на территориях его пролегания. При этом компания утверждает, что экономический эффект от её инвестиций в подводную инфраструктуру регионов превысил $500 млрд. Конечно, основной мотив более прагматичен — IT-компании не желают полагаться на операторов связи для доставки контента, рекламы и прочей информации по всему миру. При этом внутри стран для получения доступа к «последней миле» всё ещё приходится договариваться с местными операторами. Ещё одной причиной прокладки собственных кабелей является геополитика. Кабели уже повреждали в Красном море, в недавнем инциденте в Балтийском море тоже искали политическую подоплеку. По данным источников TecCrunch, задуманный Meta✴ маршрут поможет компании избежать «зон напряжённости» — Красного и Южно-Китайского морей, Египта, Марселя, Малаккского пролива и Сингапура. Другим стимулом может стать пересмотр Федеральной комиссии по связи США (FCC) принципов лицензирования подводных кабелей — Meta✴ станет буквально единственным владельцем кабеля, проходящего через безопасные коридоры. Также имеет значение и возможное строительство участка до Индии — страна имеет большие планы по развитию ИИ и дополнительная пропускная способность обязательно будет востребована. Кроме того, Индия сама по себе является ключевым рынком для Meta✴ — это крупнейший пользователь Facebook✴, Instagram✴ и WhatsApp в мире с большим потенциалом роста. Пока источники не знают, является ли ИИ значимой частью «уравнения» Meta✴ в новом проекте, так и того, откроет ли компания новую цифровую магистраль и для других пользователей или будет применять её только в собственных нуждах. Ранее уже появлялась информация о гипотетическом кабеле Meta✴ глобального масштаба, но тогда шла речь об инвестициях лишь $2 млрд. |

|