Материалы по тегу: lambda

|

02.10.2025 [21:02], Владимир Мироненко

Microsoft потратит $33 млрд на доступ к 100+ тыс. NVIDIA GB300 в неооблаках, но со временем хочет перейти на свои ИИ-ускорителиВ Сети появились новые подробности о сделке стоимостью до $19,4 млрд, заключённой Microsoft с Nebius Group NV в начале сентября. Как сообщает Bloomberg со ссылкой на информированные источники, Microsoft получит пятилетний доступ к выделенной инфраструктуре на базе более чем 100 тыс. суперускорителей NVIDIA GB300. Ранее сообщалось, что речь идёт о мощностях нового ЦОД Nebius в Вайнленде (Нью-Джерси, США). Как пишет Forbes, Nebius отличается от многих облачных провайдеров тем, что фокусируется только на рабочих нагрузках ИИ и МО, что позволяет лучше оптимизировать архитектуру ЦОД в отличие от гиперскейлеров, которые занимаются решением множества задач. Кроме того, Nebius отличается от других неооблаков, таких как CoreWeave, тем, что предоставляет инструменты и сервисы для разработчиков, которые позволяют совершенствовать ИИ-модели, выполнять инференс и разрабатывать кастомные решения, а не просто фокусируется на «чистой» вычислительной мощности. При этом Nebius начала наращивать вычислительные мощности ещё до того, как возник спрос на эти ресурсы, отметил Forbes. Подобные контракты Microsoft заключила с ещё несколькими неооблаками (neocloud), включая CoreWeave, Nscale и Lambda, на общую сумму в $33 млрд, и они обеспечивают её большую выгоду. Вместо того, чтобы тратить огромные ресурсы на строительство собственных ЦОД, Microsoft обращается к проверенному поставщику ИИ-инфраструктуры, благодаря чему может быстрее совершенствовать свою ИИ-инфраструктуру с меньшими первоначальными затратами, используя высвободившиеся мощности для предоставления клиентам прибыльных услуг на базе ИИ. Вдобавок такой подход позволяет Microsoft быстрее менять стратегию, чем при использовании собственных дата-центров. В начале бума ИИ Microsoft арендовала мощности даже у Oracle, своего прямого конкурента, для поддержки ИИ-функций в поиске Bing. Эти сделки также устраняют для Microsoft значительную часть финансовых рисков, связанных со строительством собственных ЦОД. Она не только сразу получает необходимые мощности для своих ИИ-сервисов, вместо того чтобы тратить годы на строительство ЦОД, но и перекладывает на других вопросы строительства, финансирования и управление этими ЦОД, что даёт компании большую финансовую гибкость. Так, Microsoft может отнести некоторые затраты к операционным, а не капитальным, что, по словам аналитика Bernstein Марка Мёрдлера (Mark Moerdler), даёт потенциальные преимущества для денежного потока, налогообложения и способа представления прибыли в финотчётах. Компания использует серверы неооблаков не только для обучения ИИ-моделей, но и для сложного инференса. Сделки с неооблаками становятся популярными и у конкурентов Microsoft, хотя им далеко до её масштабов. В мае 2025 года OpenAI расширила с конкурирующей с Nebius компанией CoreWeave контракт стоимостью $11,9 млрд на $4 млрд, после чего заключила ещё одно соглашение на $6,5 млрд, увеличив общую сумму соглашений до $22,4 млрд. Ещё один технологический гигант Meta✴ подписал сделку с CoreWeave на сумму в $14,2 млрд, обеспечив себе доступ к её облачным ИИ-сервисов на период до 2031 года. Вместе с тем в долгосрочной перспективе Microsoft намерена переключиться на ИИ-ускорители собственной разработки, которые обеспечивают лучший показатель TCO, передаёт CNBC. Два года назад компания представила первые ИИ-чипы Maia 100. Следующее поколение этих чипов, как ожидается, появится в 2026 году. При этом компания сосредоточится не на чипах в отдельности, а будет использовать более системный подход, учитывающий вопросы охлаждения, интерконнекта и т.д. Пока что, признаёт Microsoft, в течение многих лет решения NVIDIA обеспечивали лучшее соотношение цены к производительности.

28.09.2025 [12:30], Сергей Карасёв

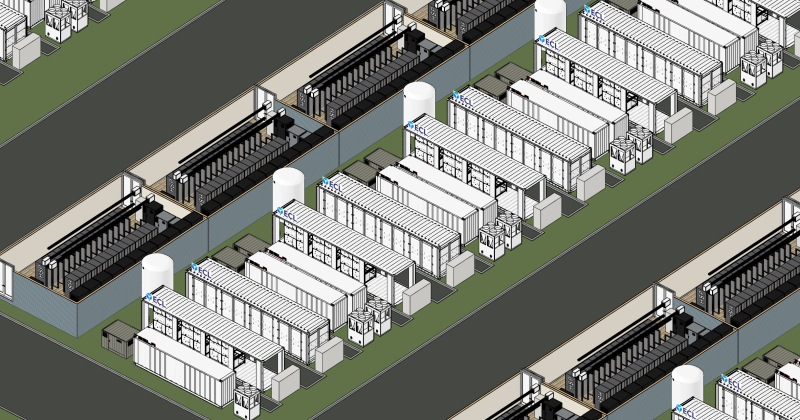

«Зелёная» энергия для «зелёных» ускорителей: Lambda и ECL впервые запитали NVIDIA GB300 NVL72 от водородаОблачный провайдер Lambda и стартап ECL объявили о развёртывании первых в отрасли систем NVIDIA GB300 NVL72 с питанием от водорода. Высокопроизводительная платформа предназначена для обучения базовых ИИ-моделей, инференса и других ресурсоёмких задач. ECL специализируется на создании автономных модульных дата-центров с питанием от водорода, при возведении которых применяются технологии 3D-печати. Первым ЦОД компании стал объект MV1 мощностью 1 МВт на площадке в Маунтин-Вью (Калифорния, США). Кроме того, ECL заявила о намерении построить ИИ ЦОД TerraSite-TX1 мощностью 1 ГВт к востоку от Хьюстона (Техас, США). Как сообщается, системы NVIDIA GB300 NVL72 компании Lambda смонтированы на базе модульного дата-центра MV1. Эта площадка отличается нулевым потреблением воды и нулевым уровнем выбросов вредных газов в атмосферу. Питание обеспечивается исключительно от водородных топливных элементов. Развёрнутые устройства GB300 NVL72 разработаны компанией Supermicro. Они обладают мощностью 142 кВт. Для отвода тепла применяется система прямого жидкостного охлаждения, вода для которой поступает от водородных топливных элементов, на которых вырабатывается в качество побочного продукта при генерации электричества. Задействованы централизованные блоки распределения охлаждающей жидкости (CDU). Утверждается, что это первое в отрасли подобное сочетание инфраструктуры на базе ускорителей NVIDIA с водородным источником «зеленой» энергии. Отмечается, что развёртывание систем NVIDIA GB300 NVL72, масса которых составляет примерно 1800 кг, сопряжено с серьёзными трудностями. Лишь немногие дата-центры способны справиться с требованиями к плотности мощности и охлаждению. Водородные топливные элементы рассматриваются в качестве одного из наиболее перспективных способов решение проблемы питания таких объектов. При этом становится возможным устойчивое развитие облачных ИИ-платформ.

07.09.2025 [01:30], Владимир Мироненко

NVIDIA потратит $1,5 млрд на аренду собственных ИИ-ускорителей у Lambda, в которую сама же и инвестировалаNVIDIA, являющаяся поставщиком и инвестором Lambda, стала её крупнейшим клиентом. Как сообщает ресурс The Information, компания заключила соглашения со стартапом на общую сумму $1,5 млрд, которая пойдёт на аренду серверов, оснащённых её собственными ускорителями. По данным источников The Information, NVIDIA заключила соглашение под кодовым названием Project Comet об аренде 10 тыс. ускорителей NVIDIA сроком на четыре года на сумму около $1,3 млрд, а также отдельную сделку на $200 млн на аренду еще 8 тыс. ускорителей NVIDIA (возможно, более низкого класса или более старых моделей). Похожую сделку по аренде собственных ускорителей NVIDIA ранее заключила с CoreWeave в которую до этого она же и инвестировала. Такие сделки относятся к разряду «циклических» финансовых соглашений, используемых NVIDIA для продвижения своих чипов и оказания помощи небольшим поставщикам облачных услуг в конкуренции с традиционными гиперскейлерами. В режиме «внутреннего круговорота» ИИ-рынка NVIDIA одновременно выступает поставщиком, инвестором и заказчиком, поддерживая несколько неооблаков. По неофициальным данным, точно такая же ситуация и у AMD с TensorWave. Эти циклические соглашения подчёркивают, насколько ограниченным стало предложение мощных ускорителей. Несмотря на то, что NVIDIA доминирует в разработке и производстве чипов, она предпочитает сотрудничать с более мелкими игроками, такими как Lambda и CoreWeave, чтобы обеспечить себе доступ к готовой ИИ-инфраструктуре. Бизнес-модель Lambda такая же, как у CoreWeave. Она включает в себя аренду площадей в ЦОД, развёртывание серверов, оснащённых ускорителями NVIDIA, с последующим предоставлением мощностей в аренду. Что примечательно, NVIDIA, подобно Amazon и Microsoft, будет использовать арендуемые у Lambda серверы для собственных исследований. Контракты с Amazon и Microsoft принесли Lambda во II квартале почти $114 млн дохода. Как сообщает futunn.com, Lambda ожидает, что её выручка от облачных технологий превысит $1 млрд к 2026 году и $20 млрд к 2030 году и надеется на контракты с крупными разработчиками в сфере ИИ, такими как OpenAI, Google, Anthropic и xAI. Lambda также ожидает, что к 2030 году её мощности достигнут почти 3 ГВт, тогда как во II квартале она составляла всего 47 МВт. К этому моменту компания рассчитывает получить в своё распоряжение 1 млн ускорителей NVIDIA. Сейчас Lambda готовится к выходу на биржу, что упростит расширение деятельность за счёт заёмного финансирования. С Lambda связана и ещё одна необычная сделка — в прошлом году Supermicro, которая является одним из ключевых поставщиков Lambda, впервые арендовала дата-центр и тут же сдала его в субаренду Lambda. По словам экспертов, NVIDIA высоко оценивает сотрудничество с Lambda из-за нескольких факторов, один из которых заключается в том, что Lambda привлекает всё больше клиентов к переходу на её ускорители. Например, недавно Lambda подписала годовое соглашение со стартапом Midjourney, которое позволило ему перейти от ИИ-чипов Google TPU к ускорителям NVIDIA Blackwell. При этом Google, по слухам, тоже предлагает неооблаками свои фирменные ускорители.

20.02.2025 [15:46], Сергей Карасёв

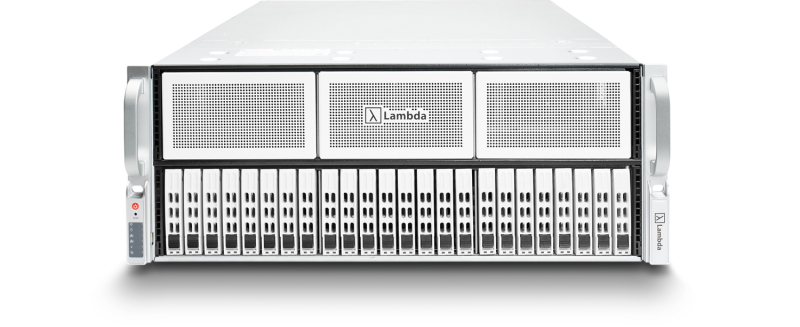

NVIDIA и Андрей Карпатый вложились в Lambda Lambs: стартап привлёк ещё $480 млн, получив оценку в $2,5 млрдКомпания Lambda Lambs объявила о проведении раунда финансирования Series D, в ходе которого на развитие привлечено $480 млн. По данным Reuters, в результате стартап получил оценку в $2,5 млрд, хотя официально цифра не раскрывается. Lambda была основана в 2012 году. Компания предоставляет разработчикам облачную платформу для обучения моделей ИИ, их тонкой настройки под конкретные задачи и инференса. На сегодняшний день в дата-центрах Lambda задействованы более 25 тыс. ускорителей NVIDIA. Стартап занимается расширением вычислительной инфраструктуры путём добавления изделий NVIDIA B200. Облачные серверы Lambda используют фирменную программную платформу Lambda Stack на основе Ubuntu, которая включает предварительно настроенные версии ряда инструментов ИИ-разработки. Благодаря этому автоматизируется значительная часть традиционной ручной работы. Кроме того, Lambda продаёт специализированные рабочие станции Vector: разработчики могут использовать эти машины для таких задач, как тестирование ранее обученных моделей ИИ. Стартап также намерен выпустить системы Scalar Server с восемью ускорителями NVIDIA для локальных ЦОД. Раунд финансирования Series D возглавили Andra Capital и SGW при участии ряда новых инвесторов, в число которых вошли словацко-канадский специалист в области машинного обучения Андрей Карпатый (Andrej Karpathy), а также ARK Invest, Fincadia Advisors, G Squared, In-Q-Tel (IQT), KHK & Partners и NVIDIA. Кроме того, получены стратегические инвестиции от Pegatron, Supermicro, Wistron, Wiwynn и многих существующих инвесторов, включая 1517, Crescent Cove и USIT. Ранее Lambda провела несколько раундов финансирования на общую сумму в сотни миллионов долларов. Так, в марте 2023 года стартап привлёк $44 млн, а в феврале 2024-го — $320 млн. В апреле прошлого года компания объявила о получении ещё $500 млн. Собранные в рамках Series D средства стартап намерен направить на расширение своей облачной платформы.

28.01.2025 [12:10], Сергей Карасёв

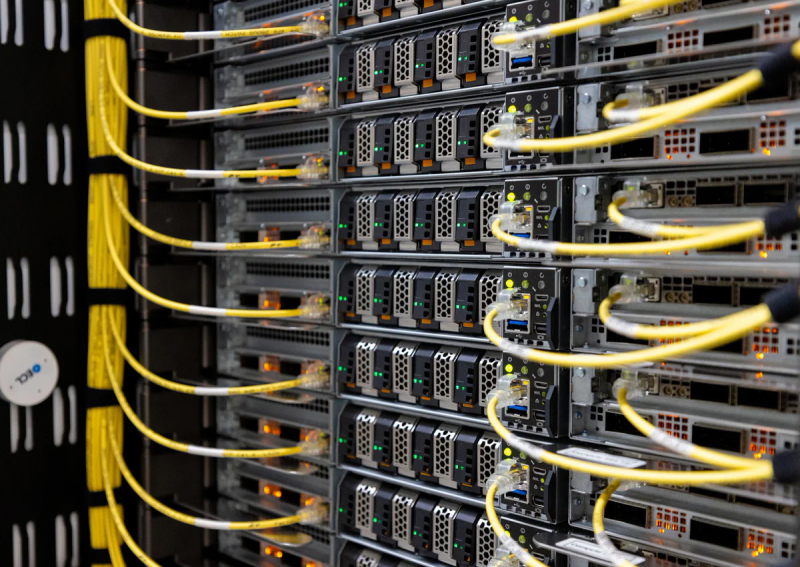

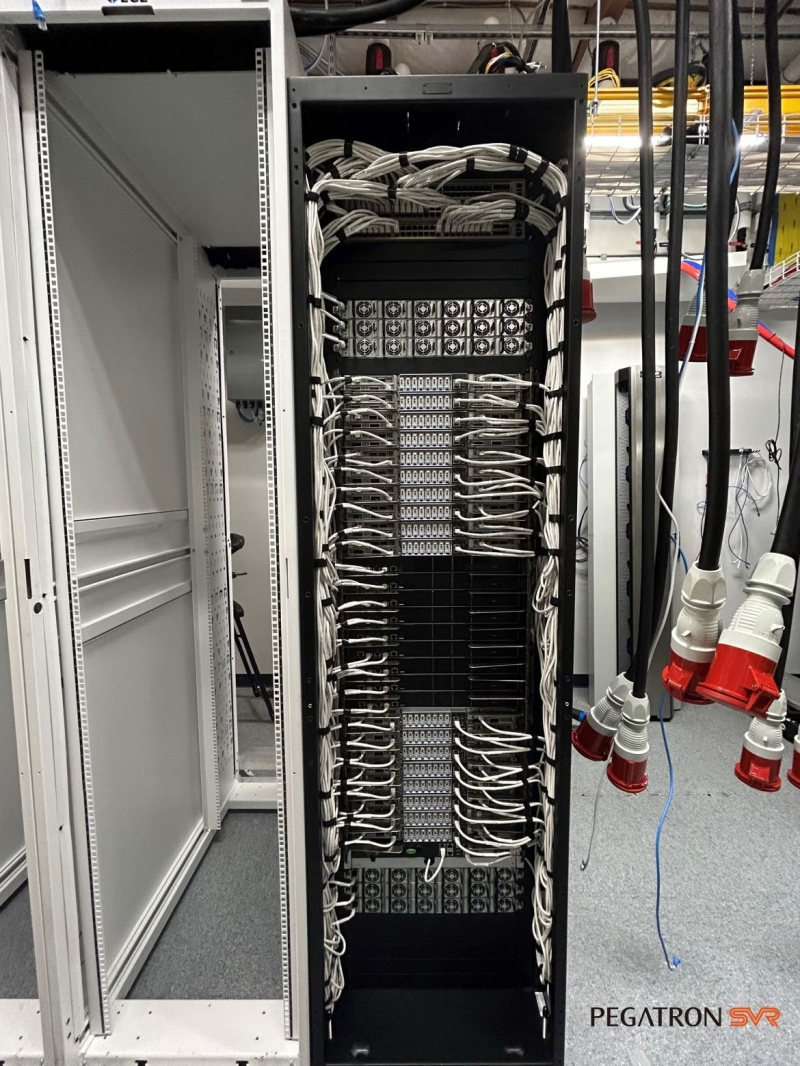

Pegatron поставит суперускорители NVIDIA GB200 NVL72 ИИ-стартапу Lambda LabsСтартап Lambda Labs, по сообщению ресурса Datacenter Dynamics, заключил партнёрское соглашение с серверным подразделением тайваньского ODM-производителя компьютерных комплектующих Pegatron. В рамках договора Pegatron развернёт суперускорители NVIDIA GB200 NVL72 для ИИ-инфраструктуры Lambda Labs. Напомним, фирма Lambda Labs была основана в 2012 году. Она предоставляет услуги облачных ИИ-вычислений с использованием собственных систем, оснащённых ускорителями NVIDIA, а также процессорами AMD и Intel. Кроме того, компания продаёт рабочие станции на базе GPU и предоставляет услуги колокации. Lambda Labs провела несколько раундов финансирования: полученные средства направляются на наращивание вычислительных мощностей и увеличение штата. В июле 2024 года сообщалось, что у суперускорителей с чипами NVIDIA GB200 возникли проблемы с СЖО: из-за дефектных компонентов фиксировались протечки. А в ноябре появилась информация, что стойки NVL72 перегревались, в связи с чем NVIDIA была вынуждена обратиться к поставщикам с просьбой внести ряд изменений в конструкцию стоек. Кроме того, NVIDIA и Schneider Electric занялись разработкой эталонной архитектуры охлаждения для ЦОД на основе GB200 NVL72. Впрочем, на текущий момент все проблемы устранены, а NVIDIA и партнёры организовали полномасштабное производство серверов на базе Blackwell. При этом клиенты уже приступили к монтажу суперускорителей GB200 NVL72. Такие системы, в частности, устанавливает стартап xAI Илона Маска (Elon Musk). Как отмечается, стратегическое партнёрство с Lambda Labs позволит Pegatron выйти на стремительно расширяющийся рынок ИИ-серверов. Первая система GB200 NVL72 (производства Supermicro), принадлежащая Lambda, была запущена на прошедших выходных в «водородном» дата-центре EdgeCloudLink.

26.09.2024 [16:51], Руслан Авдеев

Гигаватт на водороде: ECL построит гигантский «зелёный» ЦОД TerraSite-TX1, а первым арендатором станет ИИ-облако LambdaСтартап EdgeCloudLink (ECL), разрабатывающий автономные модульные ЦОД с питанием от водорода, возводимые методом 3D-печати, заявил о намерении построить за $8 млрд ИИ ЦОД TerraSite-TX1 ёмкостью 1 ГВт к востоку от Хьюстона (Техас). В перспективе кампус может вырасти и до 2 ГВт, но пока планируется к лету 2025 года ввести в эксплуатацию 50 МВт, что обойдётся в $450 млн. Первым клиентом станет оператор ИИ-облака Lambda Labs. К ЦОД будут вести три ветки газопровода, по которым и будет поставляться водород для питания кампуса. Как уточняет, DataCenter Dynamics, энергия будет обходиться в $0,08–$0,12/кВт·ч. В Lambda уверены, что новая «зелёная» инфраструктура обеспечит исследователей и разработчиков существенными вычислительными ресурсами, при этом проект позволяет снизить нагрузку ИИ-технологий на окружающую среду. В компании неоднократно подчёркивали нулевой выброс своих ЦОД. Правда, это не касается всей цепочки поставок, поскольку новый ЦОД будет питаться от водорода, полученного методом паровой конверсии, который сопровождается выбросами углекислоты. Ожидается, что в 2025 году половина поставок будет приходиться именно на такой «серый» водород, а вторая половина — на «голубой», который тоже получается в результате паровой конверсии метана, но при этом CO2 в процессе захватывается и сохраняется. Годом позже компания намерена перейти к соотношению 80/20 «голубого» и «зелёного» водорода, последний добывается с помощью возобновляемой энергии. Как заявляют в ECL, пока другие говорят о создании водородных дата-центров без подключения к магистральным электросетям через 5–20 лет, только ECL готова реализовать проект в кратчайшие сроки, в том числе благодаря использованию 3D-печати для строительства объектов — на возведение, оснащение и ввод в эксплуатацию уходит менее одного года. Первый модульный ЦОД компании ёмкостью 1 МВт был запущен в мае 2024 года на небольшой площадке в Маунтин-Вью (Калифорния). Теперь ECL ищет средства для финансирования всего $8-млрд проекта, а не только первого этапа. Ранее в этом году она уже привлекла несколько миллионов долларов инвестиций.

22.08.2024 [18:15], Елена Копытова

Lambda Labs и SK Telecom построят крупнейший в Южной Корее облачный ИИ-кластерСтартап Lambda Labs, специализирующийся на предоставлении в аренду облачных ИИ-мощностей, заключил партнёрство с крупнейшей южнокорейской телекоммуникационной компанией SK Telecom (SKT), пишет DataCentre Dynamics. В рамках сотрудничества SK Telecom до конца года развернёт облачную ИИ-платформу Lambda AI Cloud в дата-центре SK Broadband в Касане (Gasan). Со временем планируется разместить в ЦОД тысячи ускорителей. «SKT разделяет наше видение того, как сделать GPU-вычисления такими же повсеместными, как электричество», — говорит генеральный директор и соучредитель Lambda Стивен Балабан (Stephen Balaban). «Учитывая быстрый темп инноваций в области ИИ, происходящих в Южной Корее, мы рады сотрудничать с SKT в их миссии по превращению своей компании и страны в глобальную ИИ-державу». ЦОД в Касане был запущен в 2021 году. На тот момент он имел ёмкость 46 МВт и площадь 69,3 тыс. м². SKT говорит, что сейчас площадка предлагает до 44 кВт на стойку. SK Broadband также управляет дата-центрами в Сочхо (Seocho), Илсане (Ilsan) и Пундангу (Bundang). «Мы построим крупнейший в Корее кластер ускорителей, чтобы повысить конкурентоспособность национального ИИ, и выйдем на мировой рынок», — сказал Ким Кён Док (Kim Kyeong Deog), вице-президент и глава корпоративного подразделения SK Telecom. Какие именно ускорители будут использоваться в ИИ-облаке, не уточняется, хотя Lambda традиционно полагается на чипы NVIDIA. SK Group владеет долями в южнокорейских разработчиках ИИ-ускорителей Sapeon и Rebellions, которые объединятся под началом SK, чтобы вместе противостоять NVIDIA. В свою очередь в прошлом месяце SKT объявила об инвестировании $200 млн в американскую компанию Smart Global Holdings (Penguin Solutions), которая занимается ИИ- и HPC-инфраструктурой. А для Lambda сотрудничество с SKT стало первым за пределами Северной Америки, где компания управляет двумя ЦОД.

15.08.2024 [22:28], Руслан Авдеев

Supermicro впервые арендовала дата-центр за $600 млн и тут же сдала мощности в субаренду ИИ-облаку LambdaПроизводитель оборудования Supermicro в июне арендовал 21 МВт в ЦОД компании Prime Data Centers в Верноне (Калифорния). Datacenter Dynamics сообщает, что в докладе по форме K-8, поданным в Комиссию по ценным бумагам и биржам США (SEC), вендор объявил, что намерена сдать полученные площади и ёмкости стартапу Lambda Labs. В докладе Supermicro упомянула, что заключила т.н. соглашение Master Colocation Services Agreement относительно дата-центра общей ёмкостью 33 МВт. Supermicro впервые заключила подобную сделку, во всяком случае публично. При этом уже отмечалось, что компания расширяет спектр своей деятельности в сфере ЦОД. Сделка сроком 10 лет оценивается в $600 млн. Сюда входят ежемесячные платежи, счета за энергию и прочие выплаты. Эти расходы будут компенсироваться Lambda в рамках сублицензионного соглашения (помимо дополнительных ежемесячных платежей). Пока неизвестно, согласилась ли Lambda в рамках сделки покупать серверы у Supermicro. Компания помимо облака Lambda Cloud предлагает покупателям и собственные аппаратные платформы на основе оборудования Supermicro и Gigabyte, а также программный стек для ИИ-задач. Lambda намерена привлечь ещё $800 млн для экспансии на рынке дата-центров. Сегодня компания управляет ЦОД в Сан-Франциско (Калифорния) и Аллене (Техас). Стартап CoreWeave, прямой и гораздо более успешный конкурент Lambda Labs, к концу году хочет управлять уже 28 ИИ ЦОД, преимущественно в США. Но и в материковой Европе компания готова вложить $2,2 млрд в развитие своих ИИ ЦОД (и ещё £1 млрд в Великобритании). Ранее CoreWeave попыталась купить за $1 млрд своего же колокейшн-провайдера Core Scientific, но в итоге стороны подписали два 12-летних контракта по аренде мощностей.

02.07.2024 [20:35], Владимир Мироненко

Lambda Labs готовит новый раунд финансирования на $800 млнСтартап Lambda Labs, специализирующийся на предоставлении в аренду облачных вычислительных мощностей с использованием ИИ-ускорителей NVIDIA, планирует провести третий раунд финансирования с целью привлечения $800 млн, сообщила газета Financial Times. По словам источников газеты, условия проведения раунда финансирования станут известны в середине июля. Его подготовкой, включая координацию сбора средств, занимается JPMorgan. Lambda Labs стремится получить максимум выгоды из ажиотажа вокруг ИИ-технологий на фоне нехватки ускорителей. Привлечение новых инвестиций сделает Lambda Labs одним из наиболее финансируемых стартапов Кремниевой долины за последние годы. Привлечённые в рамках нового раунда инвестиции предполагается направить на приобретение ИИ-ускорителей NVIDIA и соответствующего ПО для облачных сетей, а также использовать для найма дополнительного персонала. До этого компания из Сан-Хосе провела в феврале раунд финансирования Series C на сумму в $320 млн, в результате которого оценка её рыночной стоимости выросла до $1,5 млрд. Затем в апреле ей удалось привлечь инвестиции в размере $500 млн в рамках программы под руководством Macquarie Group при участии Фонда промышленного развития (IDF). Несмотря на значительное финансирование Lambda Labs, ей пока далеко до её конкурента — компании CoreWeave, которая в мае 2024 года привлекла $7,5 млрд в ходе раунда под руководством Blackstone и при стратегическом участии Magnetar и Coatue, и в том же месяце закрыла раунд финансирования серии C на сумму $1,1 млрд. Годом ранее CoreWeave получила $2,3 млрд долгового финансирования под залог ускорителей NVIDIA. На данный момент её рыночная стоимость оценивается в $19 млрд.

05.06.2024 [22:51], Илья Коваль

ИИ-кластер в один клик и без долгого ожидания: Lambda Labs представила услугу краткосрочной аренды до 512 NVIDIA H100Облачный провайдер Lambda Labs представил услугу 1-Click Clusters, которая позволяет без длительного ожидания получить ИИ-кластер, включающий от 64 до 512 ускорителей NVIDIA H100, на срок от двух недель по единой цене $4,49/час за каждый ускоритель. По словам сооснователя компании, данное предложение является уникальным и с рыночной, и с технической точки зрения. Lambda Labs говорит, что на практике большинству ИИ-разработчиков как правило требуется доступ к кластерам из десятков или сотен ускорителей на относительно короткие периоды обучения и проверки моделей длительностью несколько недель. При этом долгосрочная аренда кластера, который будет периодически простаивать, обходится дорого. А аренда на короткий срок нередко сопряжена с длительным ожиданием доступности ускорителей как раз в тот момент, когда они больше всего нужны. При этом без общения с отделом продаж вряд ли удастся обойтись. Именно поэтому Lambda Lambs и предложила услугу 1-Click Clusters, в рамках которой на получение ИИ-кластера уходит не более нескольких дней. Аппаратная составляющая включает узлы на базе HGX H100 с 208 vCPU, 1,9 Тбайт RAM и локальным NVMe-хранилищем ёмкостью 24 Тбайт. Все узлы связаны 400G-интерконнектом NVIDIA Quantum-2 InfiniBand, а каждому ускорителю полагается свой адаптер NVIDIA ConnectX-7. Как утверждает сооснователь Lambda Labs, мало кто из облачных провайдеров способен «нарезать» крупную InfiniBand-фабрику, объединяющую тысячи ускорителей, на небольшие виртуализированные кластеры, причём делать это без участия человека. В состав каждого кластера также входят три управляющих узла: 8 vCPU, 34 Гбайт RAM, 208 Гбайт NVMe SSD и один внешний IP-адрес. За интернет-подключение отвечают два общих 100-Гбит/с канала, причём плата не берётся ни за входящий, ни за исходящий трафик. Дополнительно можно арендовать сетевое хранилище по цене $0,20/мес. за каждый Гбайт. Кластеры поставляются вместе с набором ПО Lambda Stack, который включает все необходимые драйверы и библиотеки, популярные фреймворки и средства разработки. |

|