Материалы по тегу: hardware

|

21.10.2025 [21:50], Владимир Мироненко

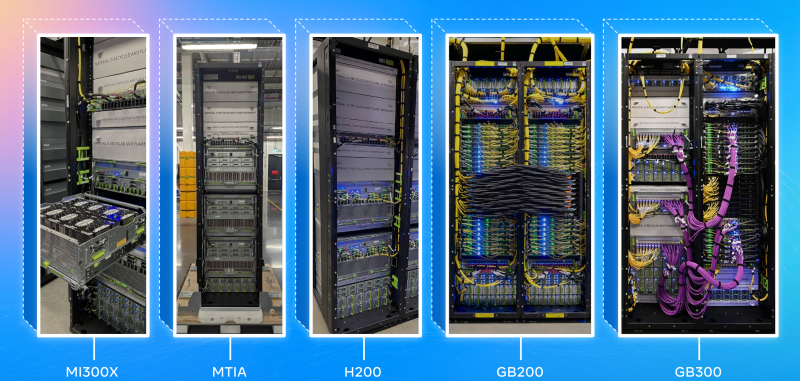

Nebius запустила первый в Израиле ИИ ЦОД с NVIDIA HGX B200Компания Nebius объявила о доступности платформы Nebius AI Cloud в своем новом ЦОД в Израиле, запущенном на площадке в Модиине (Modiin). Сообщается, что это один из крупнейших в стране ИИ-кластеров и первый на архитектуре NVIDIA Blackwell. Кластер включает 4 тыс. ускорителей в составе HGX B200, объединённых интерконнектом NVIDIA Quantum InfiniBand, и предоставляет доступ к стеку NVIDIA AI Enterprise, в том числе к микросервисам NVIDIA NIM и инструментам управления ИИ-агентами NeMo. Запуск в Израиле последовал за аналогичными развёртываниями Nebius в Европе и США. Новая площадка объединяет передовую аппаратную и программную инфраструктуру, включая усовершенствованные системы охлаждения, системы управления энергопотреблением и механизмы управления данными, разработанные для интенсивных рабочих ИИ-нагрузок. Nebius — партнёр NVIDIA по облачным технологиям (NCP). «Запуск Nebius крупнейшего в Израиле облака ИИ на базе Blackwell знаменует собой начало развития инфраструктуры ИИ в стране», — сообщил директор представительства NVIDIA в Израиле, отметив, что благодаря суверенному доступу к передовым вычислительным, сетевым технологиям и ПО, израильские компании и разработчики смогут внедрять инновации, развёртывать и масштабировать следующее поколение агентного и физического ИИ. Nebius входит в число первых партнёров NCP, получивших сертификат Exemplar Cloud для учебных рабочих нагрузок на базе NVIDIA H100, продемонстрировав производительность в пределах 95 % от референсной архитектуры NVIDIA. Платформа Nebius AI Cloud получила сертификацию SOC2 Type II, включая HIPAA, и обеспечивает сквозное шифрование, а также полное соответствие стандартам защиты данных GDPR и CCPA.

21.10.2025 [16:14], Руслан Авдеев

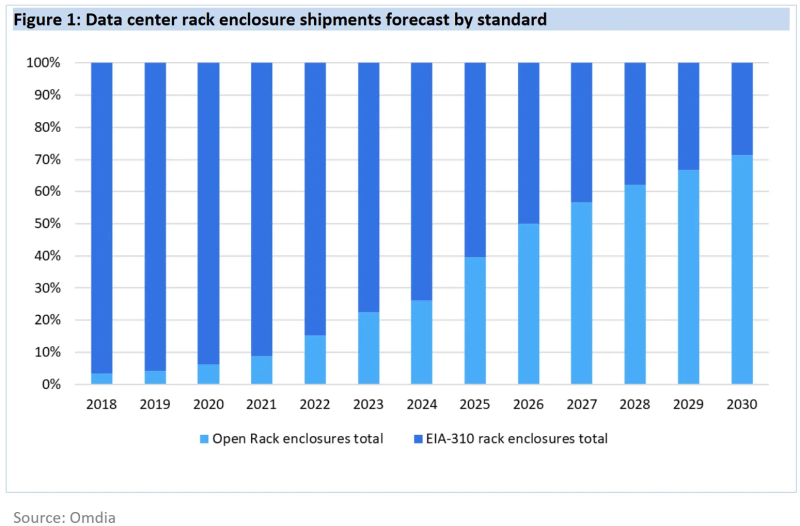

К 2030 году 21″ OCP-стойки станут доминирующим стандартом в ЦОДДата-центры намерены стандартизировать использование более крупных 21″ стоек вместо обычных 19″ к 2030 году. По данным Omdia, гиперскейлеры и производители серверов полностью поддерживают такой переход, а корпоративные ЦОД всё ещё будут придерживаться старого типоразмера, сообщает The Register. По некоторым данным, 19″ стойки (EIA-310) ведут свою «родословную» от релейных шкафов на железных дорогах — там подобный стандарт появился ещё до того, как его приняли телефонные компании, а позже и IT-индустрия. Meta✴ (Facebook✴) ещё в 2012 году столкнулась с ограничениями старого формата и основала OCP для того, чтобы организовать разработку и принятие более эффективных индустриальных стандартов. По прогнозам аналитиков, на более крупный формат, продвигаемый OCP, к концу десятилетия придётся более 70 % поставок, поскольку он активно внедряется крупными вендорами вроде Dell и HPE — одними из лидеров в гонке по выпуску ИИ-оборудования. По данным Omdia, на сегодня все крупнейшие сервис-провайдеры, включая Microsoft, Amazon, Meta✴, Google, ByteDance, Huawei и Oracle уже перешли на использование 21″ стоек в своих ЦОД. Так, Huawei ещё в 2019 году объявила, что её дата-центры будут опираться на 21″ стандарт.

Источник изображения: Meta✴ Преимуществами более крупных стоек является лучшая циркуляция воздуха и возможность устанавливать более крупные массивы вентиляторов, что улучшает охлаждение. Кроме того, такие стойки допускают установку более крупных модулей питания и трубок СЖО, что важно для ИИ-серверов. При этом сохраняется совместимость с 19″ решениями. В Omdia ожидают, что полностью укомплектованные стойки вроде NVIDIA DGX GB200 NVL72 станут фактическим стандартом. Кроме того, Dell и HPE продвигают предложенную OCP модульную серверную архитектуру Data Center Modular Hardware System (DC-MHS), которая позволяет по отдельности обновлять IO-модули и остальное «железо». Omdia прогнозирует, что на долю ИИ-серверов будет приходиться всё большая часть расходов на серверы в целом. Уже в 2024 году речь шла о 66 %, причём ключевые игроки рынка, включая гиперскейлеров и облачных ИИ-провайдеров, поддерживают именно 21″ стандарт, поэтому победа OCP над другими стандартами стала лишь вопросом времени.

21.10.2025 [00:35], Владимир Мироненко

Ещё одна альтернатива платформам NVIDIA — IBM объединила усилия с GroqIBM и Groq объявили о стратегическом партнёрстве с целью предоставления клиентам возможностей высокоскоростного ИИ-инференса по доступной цене путём объединения watsonx Orchestrate от IBM с аппаратными решениями Groq, что позволит ускорить развёртывание агентных систем ИИ. В рамках партнёрства Groq и IBM планируют интегрировать и усовершенствовать технологию Red Hat vLLM с архитектурой LPU Groq. Ожидается, что совместное решение позволит клиентам использовать возможности watsonx Orchestrate привычным образом и с привычными инструментам в инференс-платформе GroqCloud, предоставляющей разработчикам доступ к высокоскоростной и недорогой обработке LLM. Эта интеграция позволит удовлетворить ключевые потребности разработчиков ИИ-решений, включая оркестрацию инференса, балансировку нагрузки и аппаратное ускорение, что в конечном итоге оптимизирует сам процесс инференса. Также планируется поддержка моделей IBM Granite в GroqCloud для клиентов IBM. IBM отметила, что предприятия при переводе ИИ-агентов из пилотной версии в промышленную эксплуатацию продолжают сталкиваться с проблемами обеспечения скорости, стоимости и надёжности. Партнёрство IBM и Groq позволяет объединить скорость инференса Groq, экономическую эффективность и доступ к новейшим open source моделям с оркестрацией агентского ИИ IBM, предоставляя клиентам инфраструктуру, необходимую для их масштабирования, говорит компания. IBM сообщила, что LPU обеспечивают минимум в пять раз более быстрый и экономичный инференс, чем системы на ускорителях конкурентов, имея, по всей видимости, в виду NVIDIA. Это позволяет обеспечить стабильно низкую задержку и производительность при масштабировании нагрузок, что особенно важно для ИИ-агентов в регулируемых отраслях. В качестве примера IBM привела деятельность клиентов из сферы здравоохранения, которые одновременно получают тысячи сложных вопросов пациентов. Благодаря Groq ИИ-агенты IBM смогут анализировать информацию в режиме реального времени и мгновенно предоставлять точные ответы, позволяя организациям в этой сфере принимать более оперативные и обоснованные решения. В нерегулируемых отраслях клиенты IBM с помощью платформы GroqCloud смогут ускорить работу ИИ-агентов и повысить автоматизацию кадровых процессов и производительность сотрудников. IBM объявила, что сразу же предоставит клиентам доступ к возможностям GroqCloud, а совместные с Groq команды сосредоточатся на предоставлении заказчикам IBM следующих возможностей:

Groq привлекла инвестиции в размере $1,8 млрд, включая раунд финансирования на сумму $750 млн в прошлом месяце с оценкой в $6,9 млрд. В числе её инвесторов — Cisco и Samsung. Также Groq сотрудничает с саудовской Aramco Digital. По данным WSJ, компания развернула в этом году 12 ЦОД и намерена развернуть как минимум ещё 12 в 2026 году. В 2024 году Groq сменила модель работы — с тех пор она больше не продаёт свои ИИ-ускорители, предлагая вместо этого создание ЦОД или облака.

20.10.2025 [16:00], Сергей Карасёв

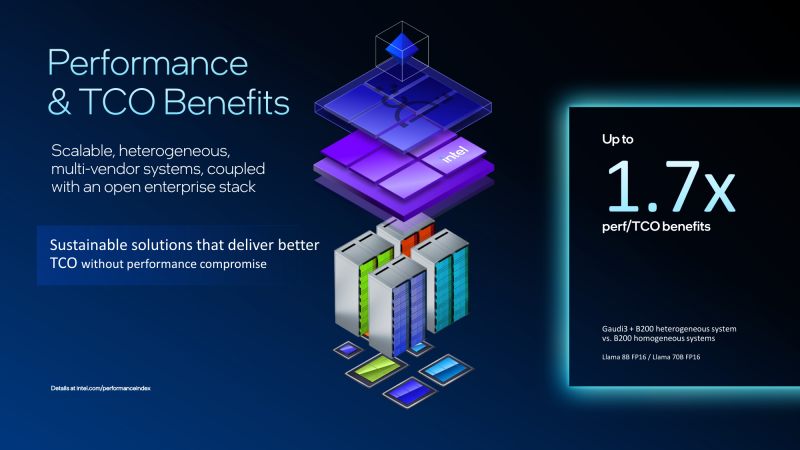

Экономичный гибрид: Intel объединила ускорители Gaudi 3 и NVIDIA B200 в одной ИИ-платформеКорпорация Intel показала гибридную стоечную систему Устройство объединяет посредством Ethernet массивы ускорителей Gaudi3 и NVIDIA B200. Платформа Gaudi3 Rack Scale 64 содержит до 16 вычислительных узлов. Каждый из них оснащён двумя неназванными процессорами Intel Xeon, четырьмя OAM-ускорителями Intel Gaudi 3 (64 в одном домене), четырьмя 400GbE-адаптерами NVIDIA ConnectX-7 и одним DPU NVIDIA BlueField-3, отмечает SemiAnalysis. Суммарно доступно 8,2 Тбайт HBM2e, а агрегированная пропускная способность составляет 76,8 Тбайт/с. Мощность суперускорителя составляет 120 кВт. Кроме того, задействованы 12 коммутаторов на чипах Broadcom Tomahawk 5 (51,2 Тбит/с). Для масштабирования и связи с другими узлами, в том числе NVIDIA, используется именно Ethernet. В составе гибридной системы ускорители Intel Gaudi 3 используются на decode-стадии, т.е. для генерации токенов, где важен объём и пропускная способность памяти, тогда как чипы NVIDIA B200 отвечают за prefill-задачи инференса, т.е. за обработку контекста и заполнение KVCache, где важна скорость вычислений. NVIDIA сама стремится к этому же подходу и уже анонсировала соускорители Rubin CPX, которые как раз будут заниматься работой с контекстом в сверхбольших моделях и созданием KV-кеша. Intel утверждает, что гибридная конфигурация из Gaudi3 и B200 позволяет достичь 1,7-кратного прироста производительности в расчёте на доллар совокупной стоимости владения (TCO) по сравнению с платформами, использующими только B200. Однако, как отмечается, эти заявления пока не подтверждены независимыми тестами. К тому же, программная платформа Gaudi3 отстаёт от платформы NVIDIA и является закрытой. Кроме того, нынешняя архитектура Gaudi приближается к концу своего существования, что ставит под сомнение жизнеспособность предложенной платформы в долгосрочной перспективе. Для Intel это, возможно, один из немногих шансов продать остатки Gaudi3. Между тем Intel недавно анонсировала GPU-ускоритель Crescent Island, разработанный специально для ИИ-инференса. Решение, в основу которого положена архитектура Xe3P, получит 160 Гбайт памяти LPDDR5X. Массовые поставки будет организованы не ранее 2027 года. Ранее компания отказалась от планов по выпуску Falcon Shores, сосредоточившись на Jaguar Shores. Сейчас же компания начала сворачивать поддержку ускорителей Ponte Vecchio (Intel Max) и Arctic Sound (Flex).

20.10.2025 [12:13], Сергей Карасёв

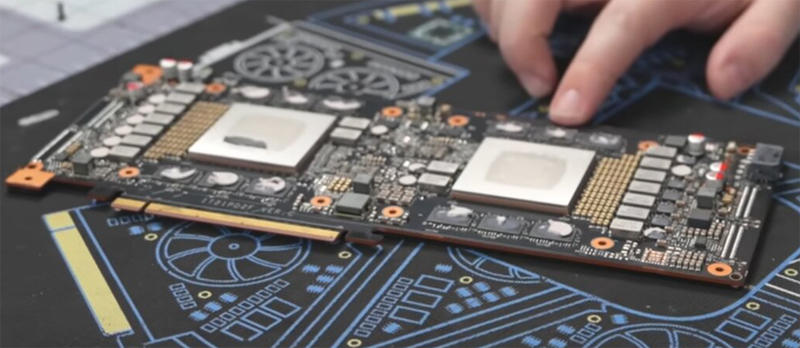

ИИ-ускоритель Huawei Atlas 300I Duo получил однослотовое исполнениеВ распоряжении сетевых источников оказалась информация о необычном ускорителе Atlas 300I Duo, разработанном компанией Huawei для решения задач в области ИИ: это двухпроцессорное изделие, оснащенное пассивной системой охлаждения. Карта получила однослотовое исполнение. В оснащение входят два GPU серии Ascend 310 и 96 Гбайт памяти LPDDR4X, пропускная способность которой достигает 408 Гбайт/с. Используется интерфейс PCIe 4.0 х16. Утверждается, что Atlas 300I Duo может декодировать до 256 потоков видео в формате Full HD со скоростью 30 к/с или 32 потока 4K со скоростью 60 к/с. Возможно кодирование 48 видеопотоков Full HD со скоростью 30 к/с. ИИ-производительность на операциях INT8 достигает 280 TOPS. При этом показатель TDP находится на отметке 150 Вт.

Источник изображений: Gamers Nexus via YouTube Применённая пассивная система охлаждения предусматривает использование радиаторов в области каждого GPU, соединённых тепловыми трубками. Кроме того, имеется металлическая пластина для рассеяния тепла. Для подачи дополнительного питания используется специальный 8-контактный разъём, не совместимый со стандартными гнёздами. Стоимость Huawei Atlas 300I Duo составляет около $1600.  Между тем Huawei продолжает развивать семейство ИИ-ускорителей Ascend. В I квартале 2026 года компания намерена представить ускоритель Ascend 950PR, который обеспечит производительность до 1 Пфлопс на операциях FP8. После этого последуют устройства Ascend 950DT, Ascend 960 и Ascend 970.

20.10.2025 [09:52], Руслан Авдеев

VoltaGrid обеспечит Oracle 2,3 ГВт электроэнергии газовых генераторов для ИИ ЦОДТехасская VoltaGrid, специалист в области энергетических решений, поставит Oracle энергетическую платформу Qpac мощностью 2,3 ГВт на базе газовых генераторов, разработанную совместно с INNIO Jenbacher и ABB, для питания ИИ ЦОД, сообщает Datacenter Dynamics. Поставки природного газа будут осуществляться через сеть трубопроводов компании Energy Transfer. По словам OCI, ИИ потребляет очень много энергии, а рабочие нагрузки часто меняются, что может вести к заметным колебаниям спроса на электричество. Платформа VoltaGrid Qpac способная сглаживать колебания, благодаря чему энергопотребление ЦОД становится более стабильным, предсказуемым и безопасным для электросетей. При этом платформа VoltaGrid обеспечивает не только энергоснабжение объектов, но и легко поддаётся масштабированию. VoltaGrid Qpac представляет собой модульную энергосистему, работающую на газе. Каждый её узел генерирует до 20 МВт. Узлы можно легко объединить для обеспечения до 200 МВт основной мощности — если регуляторы допустят заранее оговоренные выбросы в атмосферу. Как считают в VoltaGrid, речь идёт больше, чем просто о сделке в сфере электроснабжения. Это совместная с Oracle работа по разработке масштабируемых решений, компенсирующих колебания спроса на электричество ИИ-системами. Вместе обеспечивается сверхбыстрый отклик на спрос, нулевая зависимость от аккумуляторов и практически нулевые выбросы. В VoltaGrid отмечают, что сделка расширит мощности в районах Далласа и Хьюстона (Техас).

Источник изображения: VoltaGrid Компания уже подписала ряд важных соглашений о поставках электричества с компаниями, занятыми строительством дата-центров. Так, в феврале она заключила соглашение с Vantage Data Centers для развёртывания автономных от общих энергосетей газовых генераторов мощностью 1 ГВт на североамериканском рынке. В августе 2024 года она обязалась поставить для ЦОД xAI в Мемфисе 14 мобильных газовых генераторов, которые обеспечили 35 МВт дополнительной мощности в кратчайшие сроки. Местные жители были этому не слишком рады. Oracle уже подписала ряд соглашений с поставщиками электричества для снабжения американских дата-центров. В июле она заключила договор с производителем топливных элементов Bloom Energy о развёртывании соответствующих решений в нескольких ЦОД на территории США.

20.10.2025 [09:11], Сергей Карасёв

Pegatron представила ИИ-систему RA4802-72N2 на базе NVIDIA GB300 NVL72Компания Pegatron представила систему RA4802-72N2, предназначенную для наиболее ресурсоёмких ИИ-нагрузок, включая обучение больших языковых моделей (LLM) в масштабе и инференс. В основу положена платформа NVIDIA GB300 NVL72. Изделие GB300 содержит Arm-процессор Grace с 72 ядрами Neoverse V2 (Demeter) и два чипа Blackwell Ultra. В составе RA4802-72N2 объединены 18 вычислительных лотков, каждый из которых несёт на борту два Grace и четыре Blackwell Ultra. В сумме это даёт 36 процессоров Grace и 72 чипа Blackwell Ultra. Каждый из вычислительных узлов располагает 960 Гбайт памяти LPDDR5X и 1152 Гбайт памяти HBM3e. Таким образом, в общей сложности система оперирует примерно 17 Тбайт LPDDR5X и 20 Тбайт HBM3e. ИИ-производительность достигает 720 Пфлопс на операциях FP8/FP6. В состав RA4802-72N2 также входят девять коммутационных лотков. Общая пропускная способность интерконнекта NVLink составляет 130 Тбайт/с. В расчёте на вычислительный узел используются два адаптера NVIDIA ConnectX-8 и один DPU NVIDIA BlueField-3. Прочие характеристики включают контроллер Aspeed AST2600, модуль TPM 2.0, восемь отсеков для накопителей E1.S NVMe, коннектор M.2 2280/22110 NVMe. Система выполнена в форм-факторе 48U MGX с габаритами 600 × 2296 × 1200 мм. Применяется полностью жидкостное охлаждение. Полка питания оснащена шестью 1U-модулями мощностью 33 кВт. Поставки машины RA4802-72N2 уже начались.

19.10.2025 [13:51], Руслан Авдеев

Alibaba Cloud запустила свой второй ЦОД в ДубаеКитайская Alibaba Cloud ввела в эксплуатацию свой второй дата-центр в Дубае (ОАЭ). Новый ЦОД появился через девять лет после открытия первого объекта компании в городе, сообщает Datacenter Dynamics. Новый дата-центр — часть планов по глобальному масштабированию бизнеса. В его рамках Alibaba обязалась потратить $52,7 млрд на облачную и ИИ-инфраструктуру. Как сообщает Alibaba, новый объект позволит компании расширить предложение новых облачных технологий и систем искусственного интеллекта в Дубае. По словам Alibaba, запуск нового дата-центра и объявление об инновационных проектах на GITEX Global 2025 — важные вехи на пути расширения бизнеса компании в регионе. Готовность Ближнего Востока к быстрому внедрения ИИ и готовая к сотрудничеству экосистема — важнейшие факторы, способствующие процветанию структур в частном и государственном секторах, говорит Alibaba Cloud.

Источник изображения: Alibaba Cloud Дополнительно Alibaba Cloud объявила о подписании меморандума о взаимопонимании c ближневосточной цифровой финансовой платформой Wio Bank. Соглашение позволит использовать облачные технологии и ИИ Alibaba в рамках мультиоблачной стратегии платформы. В частности, Wio Bank будет использовать дубайские ЦОД комапнии. В Wio Bank подчёркивают, что масштабируя возможности с помощью передовых технологий Alibaba Cloud, компания создаёт ИИ-агентов, упрощающих операции и позволяющих клиентам безопасно расти, процветать и достигать большего. Среди прочих организаций, подписавших соглашение о переходе на Alibaba Cloud — облачная игровая платформа The Game Company и оказывающая услуги по переработке отходов компания Accumed. Alibaba Cloud стремительно развивается за пределами КНР. В сентябре она подтверждала, что намерена запустить до конца года восемь новых дата-центров, в том числе в Дубае. Среди прочих регионов — Мексика, Япония, Малайзия и очередная локация в Южной Корее, где в текущем году компания открыла две новые. В конце августа сообщалось, что Alibaba разработала собственный ИИ-ускоритель для инфреренса, который поможет компании избавиться от зависимости от ИИ-чипов NVIDIA и других зарубежных продуктов.

19.10.2025 [13:09], Сергей Карасёв

Meta✴ привлекла почти $30 млрд на строительство гигантского ИИ ЦОД Hyperion в ЛуизианеКомпания Meta✴ Platforms, по информации Bloomberg, получит от частной инвестиционной фирмы Blue Owl Capital финансирование в размере почти $30 млрд для строительства гигантского кампуса дата-центров в округе Ричленд в Луизиане (США) для масштабных нагрузок ИИ. Речь идёт о проекте Hyperion, который был анонсирован в конце 2024 года. Комплекс расположится на 910 га бывших сельскохозяйственных угодий. Общая площадь сооружений в составе кампуса превысит 371 тыс. м2. Завершить строительные работы планируется к 2030 году. Как сообщает Bloomberg, ссылаясь на данные, полученные от осведомлённых источников, финансирование строительства будет осуществляться через компанию специального назначения (SPV), созданную Morgan Stanley для этого проекта. Партнёрами в рамках соглашения выступают Meta✴, Blue Owl Capital и ещё один инвестиционный фонд — Pimco. Вложения составят $2,5 млрд в виде акционерного капитала и $27 млрд в виде заёмных средств. Привлечение структуры SPV означает, что сама Meta✴ формально не заимствует средства, а следовательно, не должна отражать большую задолженность на своём балансе. Кроме того, благодаря формированию SPV повысится эффективность управления финансовыми потоками и операциями, связанными с инициативой Hyperion.

Источник изображения: Meta✴ Соглашение предполагает, что Meta✴ будет владеть только 20 % долей в новом кампусе ИИ ЦОД. Долг должен быть полностью погашен к 2049 году. Meta✴ будет отвечать за создание и эксплуатацию объекта после его ввода в строй в конце текущего десятилетия. При этом сама компания будет арендовать вычислительные ресурсы площадки. Изначально предполагалось, что мощность Hyperion составит до 2 ГВт. Однако впоследствии Meta✴ повысила планку до 5 ГВт. Для удовлетворения таких потребностей понадобится существенное расширение энергетической инфраструктуры в регионе размещения кампуса. С этой целью Meta✴ заказала строительство новой газогенераторной установки у местного оператора коммунальных услуг Entergy. На начальном этапе на этой станции будут смонтированы три парогазовых турбины общей генерирующей мощностью более 2,2 ГВт, а также ЛЭП. Суммарная стоимость строительства Hyperion с учётом оборудования может достигнуть $50 млрд. В целом, Meta✴ намерена инвестировать «сотни миллиардов долларов» в мультигигаваттные дата-центры для задач ИИ. В частности, помимо кампуса Hyperion в Луизиане, будет создан ЦОД мощностью 1 ГВт в Эль-Пасо (El Paso) в Техасе (США). На этот объект компания планирует потратить более $1,5 млрд.

19.10.2025 [09:36], Владимир Мироненко

Micron покидает серверный рынок Китая после санкций правительстваКомпания Micron прекратит поставки серверных чипов памяти китайским провайдерам ЦОД, сообщило агентство Reuters со ссылкой на информированные источники. После введения в 2023 году правительством КНР запрета на использование чипов Micron в ключевых инфраструктурных проектах ей так и не удалось восстановить свой бизнес в стране в этом сегменте. Вместе с тем Micron продолжит поставки продукции двум компаниям, имеющим крупные ЦОД за пределами Китая. По словам источников, одна из них — Lenovo. Micron стал первым американским производителем чипов, попавшим под ограничения Пекина, которые были восприняты как ответ на серию ограничений, введённых Вашингтоном с целью сдерживания технологического прогресса китайской полупроводниковой промышленности. За последний финансовый год Micron получила $3,4 млрд — 12 % от общего объёма выручки — от операций на материковом Китае. По данным Reuters, в настоящее время в команде Micron, занимающейся поставками для ЦОД в Китае, работает более 300 человек. И насколько значительным будет её сокращение, пока неизвестно. «Micron будет искать клиентов за пределами Китая в других частях Азии, в Европе и Латинской Америке», — сообщил Reuters Джейкоб Борн (Jacob Bourne), аналитик Emarketer. Он отметил, что Китай является критически важным рынком, однако сейчас наблюдается расширение ЦОД по всему миру, обусловленное спросом на ИИ, и Micron рассчитывает на то, что сможет компенсировать на других рынках потерю бизнеса в Поднебесной. Запрет на использование продукции Micron в критически важной инфраструктуре Китая принёс выгоду её конкурентам — Samsung и SK hynix, а также китайским компаниям YMTC и CXMT, которые активно расширяют деятельность при поддержке китайского правительства. Согласно обзору государственных закупок, проведенному агентством Reuters, в прошлом году инвестиции в ЦОД в Китае выросли в девять раз и достигли ¥24,7 млрд ($3,4 млрд). Тем не менее Micron удалось компенсировать сокращение выручки в Китае поставками в другие страны благодаря огромному спросу на ЦОД и сопутствующие инструменты и добиться рекордной квартальной выручки. Вместе с тем Micron продолжит поставлять чипы китайским компаниям, занятым в автомобильной отрасли и секторе производства мобильных телефонов. Также производитель микросхем памяти продолжил расширять некоторые другие направления в стране, включая завод по упаковке микросхем памяти в Сиане. «У нас сильное производственное и клиентское присутствие в Китае, и Китай остаётся важным рынком для Micron и полупроводниковой промышленности в целом», — сообщила Micron агентству Reuters. Как пишет Data Center Dynamics, в июне Micron заявила о планах инвестировать $200 млрд в расширение производства микросхем памяти в США. Средства будут направлены на строительство второй фабрики по производству чипов памяти в Бойсе (Айдахо), двух дополнительных фабрик в Нью-Йорке и расширение производства в Манассасе (Вирджиния). |

|