Материалы по тегу: охлаждение

|

24.03.2025 [10:56], Сергей Карасёв

Chemours, NTT Data и Hibiya Engineering опробуют передовую жидкость для двухфазных систем погружного охлажденияКомпании Chemours, NTT Data и Hibiya Engineering объявили об объединении усилий с целью полномасштабных испытаний системы двухфазного иммерсионного (погружного) охлаждения для дата-центров. Речь идёт, в частности, об использовании специальной жидкости Chemours Opteon 2P50. Партнёры отмечают, что сектор ЦОД быстро развивается на фоне активного внедрения ИИ и НРС. Однако существует значительный разрыв между ростом энергопотребления таких объектов и повышением эффективности систем охлаждения. Сотрудничество Chemours, NTT Data и Hibiya Engineering направлено на исследование технологий охлаждения следующего поколения, которые обеспечат повышение эффективности и устойчивости дата-центров при увеличении их мощности.

Источник изображения: Chemours Проект ориентирован на тестирование Opteon 2P50 с целью последующей коммерциализации. Эта запатентованная диэлектрическая жидкость разработана специально для двухфазного иммерсионного охлаждения. Жидкость выполнена на основе гидрофторолефина (HFO) с нулевым озоноразрушающим потенциалом (ODP). Коэффициент GWP (потенциал глобального потепления), определяющий степень воздействия различных парниковых газов на глобальное потепление, равен 10 (AR6). По заявлениям разработчика, жидкость Opteon 2P50 позволяет снизить энергозатраты ЦОД на охлаждение до 90 % и уменьшить общее энергопотребление дата-центров на 40 %. Кроме того, в большинстве климатических зон Opteon 2P50 даёт возможность практически полностью исключить использование воды, а также значительно уменьшить шумовое загрязнение внутри помещений. Физическая площадь ЦОД может быть сокращена на 60 %. Плюс к этому жидкость может повторно использоваться неограниченное количество раз. В испытаниях системы двухфазного иммерсионного охлаждения на основе Opteon 2P50 примут участие различные заинтересованные стороны — от операторов дата-центров, производителей оборудования и проектно-конструкторских фирм до поставщиков ИТ-услуг и научно-исследовательских институтов.

14.03.2025 [10:46], Сергей Карасёв

Congatec представила кулер с тепловыми трубками на ацетоне для работы в экстремальных условияхКомпания Congatec анонсировала новый кулер на основе радиатора и тепловых трубок, предназначенный для отвода тепла от чипов в экстремальных условиях эксплуатации. Особенность изделия заключается в применении ацетона в качестве рабочей жидкости вместо традиционной воды. У ацетона температура замерзания находится на уровне −95 °C. Такие свойства ацетона предотвращают образование льда и снижают риски конденсации, благодаря чему формируется стабильный механизм теплопередачи даже при резких колебаниях температуры. Благодаря этому новый кулер может применяться в устройствах, которые рассчитаны на использование в суровых условиях — например, на открытых пространствах в Арктике. Диапазон рабочих температур у новинки простирается от −40 до +85 °C.

Источник изображения: Congatec По заявлениям Congatec, представленное изделие невосприимчиво к механическим нагрузкам, таким как удары и вибрация. Среди сфер применения кулера называются автономные и обычные транспортные средства, подвергающиеся воздействию экстремальных температур: это машины для портовых терминалов, железнодорожных и авиационных платформ и пр. Кроме того, охладитель может устанавливаться в индустриальные устройства, эксплуатация которых сопряжена с физическими возмущениями, в частности, тряской. Компания Congatec отмечает, что появление кулера на ацетоне расширяет сферу применения так называемых «компьютеров-на-модуле» (COM), которым ранее требовались сложные и дорогостоящие конструкции для работы при низких температурах. Решение может быть интегрировано с различными продуктами Congatec, включая COMe, COM-HPC и COM-HPC mini.

27.02.2025 [08:27], Руслан Авдеев

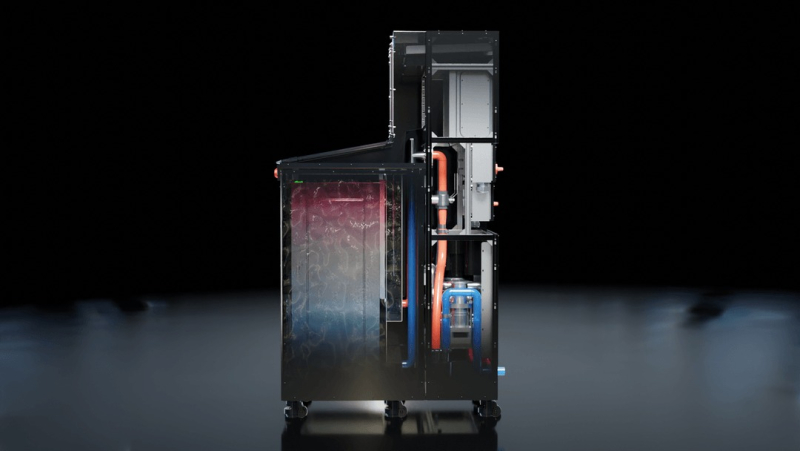

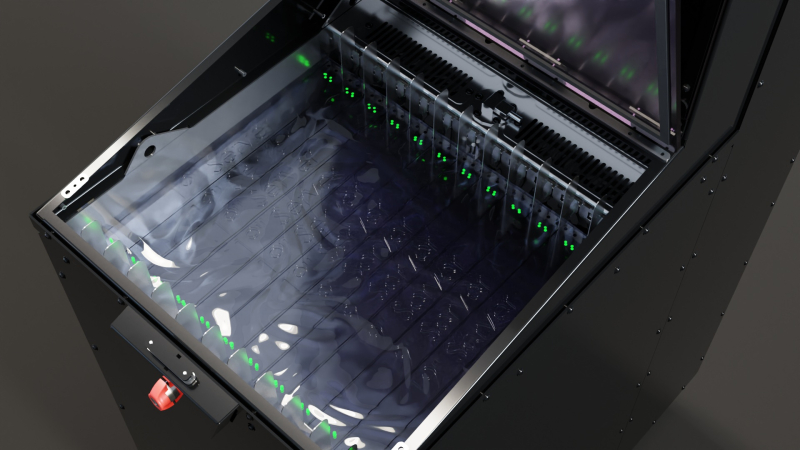

Asperitas выпустила модульные погружные СЖО Direct Forced Convection для GPU-серверовЗанимающаяся разработкой СЖО серверов компания Asperitas запустила новую линейку модульных продуктов Direct Forced Convection (DFCX) для систем иммерсионного охлаждения. Речь идёт о модульных ёмкостях, предназначенных для Edge-объектов, сообщает пресс-служба компании. Продукты были анонсированы ещё в июне 2024 года. Ранее Asperitas предлагала иммерсионный бак с естественной конвекцией, а теперь представлен вариант с принудительной циркуляцией жидкости. Модульная архитектура обеспечивает размещение стоек размером от 12U в каждой ёмкости. Также поддерживаются конфигурации «суперкластера» с многочисленными ёмкостями и блоками распределения жидкости (CDU). Ёмкости для стоек размера 12U обеспечивают отвод до 5 кВт на 1U или более 1 кВт на чип. Решение DFCX1 обеспечивает поддержку кластеров из трёх 4U-узлов с 24 ускорителями с возможностью отвода до 60 кВт. По данным на сайте компании, размеры модуля составляют 600 × 1215 × 1990 мм. Он весит около 1120 кг с вместе с установленным оборудованием. На бак требуется минимум 352 л диэлектрической жидкости, поставщиком которой является Shell. Впрочем, тут же описаны и чуть более скромные возможности охлаждения: до 3,6кВт/1U. Также предусмотрены два места для 19″ коммутаторов глубиной до 480 мм. В компании заявляют, что надёжность и бесшовная интеграция являются базовыми ценностями при разработке продуктов, бизнес компании успешно растёт с системами на основе естественной конвекции Perpetual Natural Convection (PNC) и технологией DFCX, особенно теперь, в эпоху ИИ. Вскоре производитель намерен представить новые продукты серии DFCX, которые поддержат растущие потребности цифровой инфраструктуры.

24.02.2025 [18:12], Руслан Авдеев

Submer выпустит автономного робота для систем погружного охлажденияКомпания Submer, специализирующаяся на системах погружного (иммерсионного) охлаждения, работает над роботом ADA (Autonomous Datacenter Assistant) для автоматизации процесса установки и извлечения серверов из резервуаров СЖО, сообщает Datacenter Dynamics. Резервуары в помещениях дата-центров значительно отличаются от традиционных стоек. Серверы и оборудование из охлаждающей жидкости необходимо погружать и извлекать вертикально. Нередко для этого применяется переносной кран, похожий на лебёдку для снятия автомобильных двигателей. Встречаются и стационарные подвесные системы, если это позволяют ресурсы и размеры помещения. После извлечения серверов необходимо очистить их от диэлектрической жидкости — нередко в процессе используется специальный поддон и чистящий раствор. Робот может значительно ускорить и упростить процесс извлечения и очистки. Сообщается, что подвижная роботизированная платформа появится в продаже в конце 2025 года, хотя исходная версия ADA была представлена ещё в октябре 2021 года. Систему изначально разрабатывали для мониторинга, а также вывода серверов из эксплуатации и ввода в эксплуатацию, в том числе для установки и извлечения серверов из резервуаров с жидкостью. Дополнительной информации о новинке журналистам не представили. По последним данным Submer получила на развитие $55,5 млн. Помимо Submer автоматизацией установки серверов в резервуарах занималась, например, TMGcore. Она запустила платформу двухфазного иммерсионного охлаждения Otto, которая включала роботизированную лебёдку. Разработанная при сотрудничестве с Olympus Controls, система обеспечивала «горячую замену» с использованием расположенного рядом резервного сервера. В 2021 году была анонсирована версия Ottomobile, которая крепилась к задней части грузовика Ford, спроектированного как мобильный микро-ЦОД. С тех пор компанию купила Modline и включила её в подразделение Airedale.

23.02.2025 [13:10], Сергей Карасёв

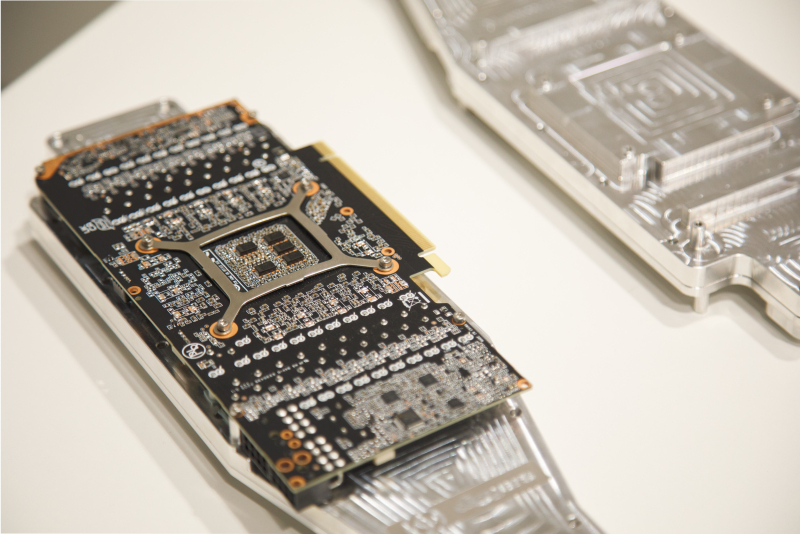

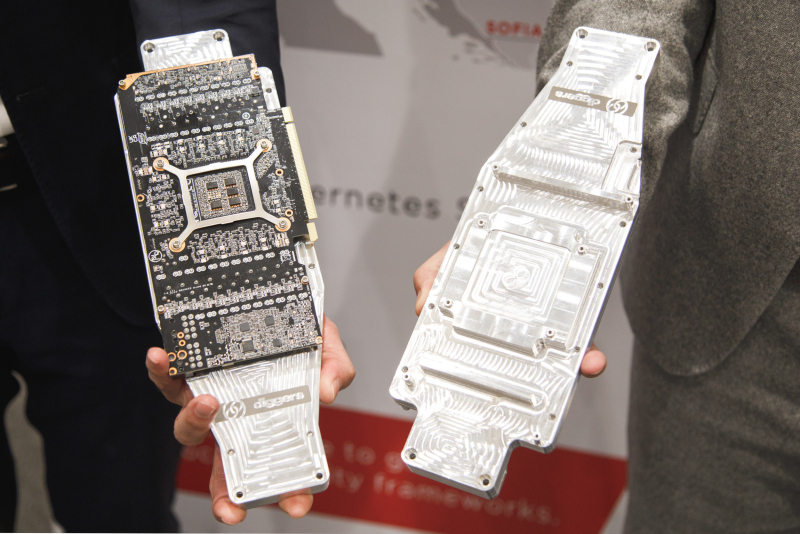

Австрийская Diggers разработала новую СЖО для GPU-серверовЕвропейский поставщик облачных услуг Exoscale, входящий в состав A1 Digital, в партнёрстве с австрийской компанией Diggers работает над созданием устойчивых дата-центров нового поколения, ориентированных на ресурсоёмкие задачи ИИ. Речь идёт о внедрении новой технологии прямого жидкостного охлаждения (DLC). Архитектура, разработанная специалистами Diggers, предполагает размещение серверов в «холодных ящиках» — шкафах, в которые не попадает и не выходит воздух. Для отвода тепла от CPU и GPU служат специальные пластины с микроканалами, через которые циркулирует охлаждающая жидкость. Для работы системы требуется подача только электричества и воды. Водоблоки выполнены из алюминия, что предотвращает коррозию. Микроканалы распределяют жидкость таким образом, чтобы увеличить теплопередачу. Каждый водоблок может отводить тепло от двух GPU, которые монтируются с противоположных сторон. Предложенная архитектура устраняет необходимость в холодном коридоре. Утверждается, что по сравнению с обычными системами охлаждения энергопотребление сокращается на 50 %. Показатель PUE составляет до 1,05. «Мы достигаем практически таких же технических показателей, что и при использовании погружного охлаждения, но при этом не применяется минеральное масло и нет сложностей с обслуживанием. Всё легко меняется. Вы можете менять память и накопители», — говорит генеральный директор Diggers Мартин Шехтнер (Martin Schechtner). Вода на выходе имеет температуру около 50 °C: она может использоваться либо для нужд самого дата-центра, либо направляться в местную отопительную сеть. Решение может быть интегрировано как в новые, так и в существующие ЦОД. Exoscale испытывает систему на своём объекте в Вене (Австрия).

29.01.2025 [19:20], Руслан Авдеев

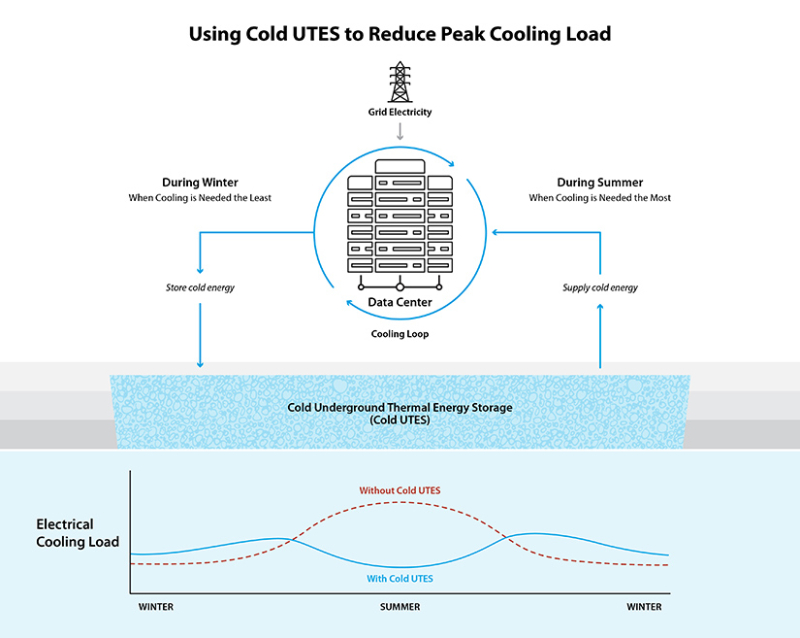

NREL протестирует подземные хранилища холода Cold UTES для ЦОДНациональная лаборатория по изучению возобновляемой энергии США (NREL) при поддержке Национальной лаборатории Лоуренса в Беркли (LBNL), Принстонского и Чикагского университетов представила проект, призванный решить проблему растущего потребления энергии ЦОД. Новое решение позволит обеспечить эффективное охлаждение ЦОД благодаря использованию технологии подземного хранения тепловой энергии (UTES). Финансированием проекта занимается Управление геотермальных технологий (GTO) Министерства энергетики США (DoE). Считается, что он поможет ускорить разработку и коммерческое внедрение нового поколения геотермальных технологий — с закреплением лидерства США в данной сфере. Обычно UTES предполагает нагрев (или охлаждение) теплоносителя на поверхности в ходе естественных дневных или сезонных циклов с его последующей прокачкой через подземные хранилища различных типов. По статистике NREL, на долю традиционных систем охлаждения приходится до 40 % годовых энергозатрат дата-центров. Система подземного хранения Cold UTES позволит использовать электричество вне пиковых периодов для формирования запасов «холода» под землёй. Эти резервы можно будет включить в действующие системы охлаждения ЦОД и применять в периоды, когда нагрузки на электросети максимальны, что в итоге сократит объёмы потребления энергии. В NREL считают, что технология во многом похожа на использование обычных аккумуляторов с учётом наиболее благоприятного времени их заряда/разряда, что позволит снизить эксплуатационные расходы ЦОД. Предполагается, что Cold UTES сможет стать коммерчески привлекательным и технически жизнеспособным решением для ЦОД. Проект позволит подтвердить потенциал соответствующих систем для операторов ЦОД, коммунальных служб и операторов электросетей. В NERL считают, что система сможет обеспечить как краткосрочное, так и долгосрочное хранение. Похожий проект финансировало правительство Австралии для суперкомпьютера Pawsey Centre в Перте, отмечает DataCenter Dynamics. Т.н. CSIRO Geothermal Project предусматрвиает перекачивание холодной воды из неглубокого водоносного слоя для охлаждения суперкомпьютера. Нагретая вода возвращается обратно в водоносный слой ниже по течению. По оценкам, такая система сэкономит порядка 14,5 млн л чистой воды только в первые два года работы. Есть и другие геотермальные варианты, предназначенные для интеграции с ЦОД. Например, в 2024 году появилась новость о том, что тепло суперкомпьютера в Эдинбургском университете будут закачивать в заброшенные шахты с последующим использованием для отопления местных домов.

25.12.2024 [13:05], Сергей Карасёв

Compal представила сервер SD220-8 с «высокоточной» погружной СЖО Intel Targeted Flow

compal electronics

emerald rapids

hardware

intel

sapphire rapids

xeon

погружное охлаждение

сервер

сжо

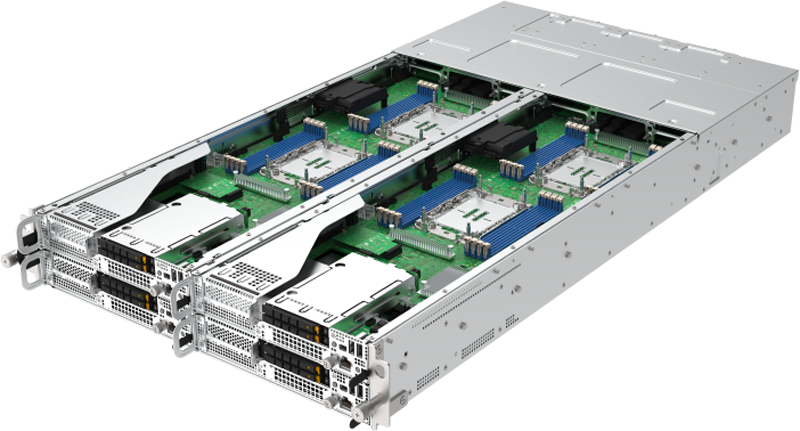

Компания Compal Electronics, по сообщению ресурса DigiTimes, объединила усилия с Intel, BP Castrol, JWS и Priver Technology с целью создания решений с передовой системой жидкостного охлаждения Targeted Flow. Эта технология применяется во флагманском сервере SD220-8. Инновационная СЖО использует запатентованную технологию Intel Targeted Flow, включая проприетарные резервуар Targeted Flow Tank и теплоотвод Targeted Flow Heat Sink. В последнем задействованы специальные методы для направления охлаждающей жидкости именно в те зоны процессора, которые имеют самую высокую температуру. Такой подход гарантирует максимальную эффективность охлаждения и минимизирует вероятность перегрева. В СЖО применяется улучшенная охлаждающая жидкость BP Castrol DC 20 — это синтетический углеводородный диэлектрический хладагент с низкой вязкостью и хорошей текучестью. Применённая система охлаждения допускает повторное использование сгенерированного тепла.

Источник изображений: Compal Сервер SD220-8 представляет собой четырёхузловое решение в форм-факторе 2U. Каждый узел может нести на борту два процессора Intel Xeon Sapphire Rapids или Emerald Rapids, а также 16 модулей DDR5-5600 (L)RDIMM. Во фронтальной части узлов могут быть установлены четыре SFF-накопителя SATA/SAS/NVMe U.2. Кроме того, есть два внутренних коннектора для SSD M.2 2280. Предусмотрен разъём OCP 3.0, а также один или два слота (в зависимости от конфигурации — два или четыре фронтальных SSD) для карт PCIe 5.0 x16 HHHL.  Узлы располагают контроллером BMC/CMC Aspeed AST 2600/2620, опциональным модулем TPM 2.0, портом USB 3.2 Gen1 Type-A. Сервер комплектуется четырьмя блоками питания мощностью 1600 Вт с сертификатом 80 Plus Platinum/Titanium.

11.12.2024 [00:24], Руслан Авдеев

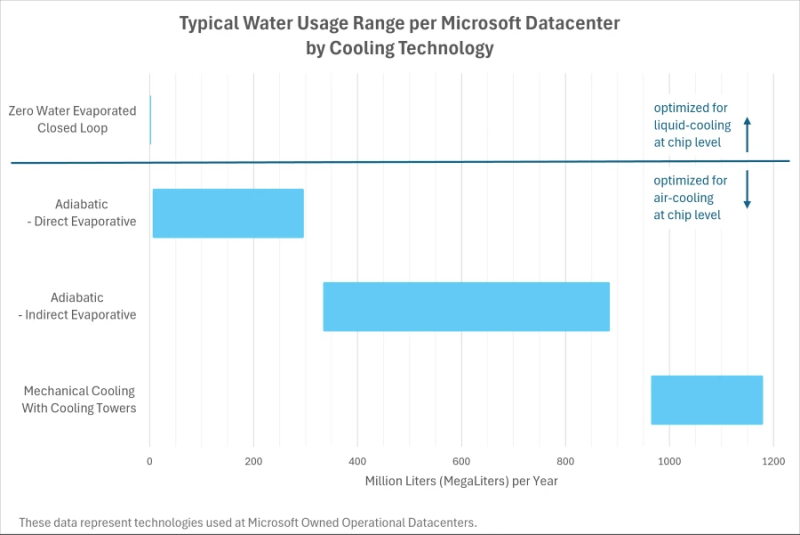

Бессточные ЦОДы: новые дата-центры Microsoft будут иметь околонулевой расход водыMicrosoft анонсировала новую архитектуру охлаждения своих ЦОД, где вода циркулирует в замкнутом контуре, а испарения вообще нет. Все дата-центры Microsoft, разрабатываемые с августа 2024 года, получат новые системы охлаждения. Они, как ожидается, заработают к концу 2027 года. А впервые новые подходы будут опробованы в строящихся ЦОД в Финиксе (Аризона) и Маунт-Плезанте (Висконсин) в 2026 году, сообщает пресс-служба компании. Впрочем, существующие объекты по-прежнему будут использовать различные комбинации систем охлаждения. По словам Microsoft, новая архитектура снизит потребление питьевой воды каждым дата-центром компании более чем на 125 млн л/год. Эта цифра рассчитана с учётом среднего показателя эффективности использования воды (WUE) на уровне 0,30 л/кВт∙ч, который за последние три года улучшился на 39 %. А с начала 2000-х, когда компания стала сама строить ЦОД, WUE снизился на 80 %. Это результат усилий по уменьшению объёма сточных вод, повышению температур в ЦОД и усилению контроля за работой оборудования. Кроме того, в Техасе, Вашингтоне, Калифорнии и Сингапуре компания использует очищенные сточные и оборотные воды. В компании заявляют, что новые технологии используют замкнутые контуры жидкостного охлаждения — как только система заполнена водой во время монтажа, вода будет циркулировать между серверами и охладителями без необходимости постоянной «дозаправки». Этот подход сочетается с прямым жидкостным охлаждением, что позволяет использовать в контурах более тёплую воду, улучшая не только WUE, но PUE.

Источник изображения: Microsoft Правда, параллельно ожидается «номинальное увеличение» расхода электроэнергии каждым новым дата-центром на основе соответствующих технологий. Впрочем, в компании заявляют, что работают над другими инновациями для обеспечения «более целевого охлаждения» и снижения энергозатрат. Новая архитектура в некоторых случаях позволит избежать ситуаций, когда компания вынужденно использует воздушное охлаждение или строит системы очистки сточных вод своих дата-центров.

09.12.2024 [13:24], Сергей Карасёв

До 132 кВт на стойку: Schneider Electric и NVIDIA разработают эталонную архитектуру охлаждения для ЦОД на основе GB200 NVL72Французская корпорация Schneider Electric, по сообщению ресурса Datacenter Dynamics, совместно с NVIDIA разрабатывает эталонную архитектуру охлаждения для дата-центров, рассчитанных на решение ИИ-задач. Речь, в частности, идёт о ЦОД с суперускорителями GB200 NVL72 (Blackwell). О том, что Schneider Electric и NVIDIA объединили усилия с целью оптимизации инфраструктуры ЦОД, стало известно в марте нынешнего года. Тогда говорилось, что стороны создадут первые в своём роде общедоступные эталонные проекты дата-центров, призванные переопределить стандарты развёртывания и эксплуатации ИИ. Как теперь стало известно, эталонный дизайн охлаждения Schneider Electric предусматривает применение специализированных блоков распределения охлаждающей жидкости (CDU), а также решений прямого жидкостного охлаждения Direct-To-Chip (DTC). Говорится, что такие системы обеспечат возможность охлаждения стоек с вычислительным оборудованием суммарной мощностью до 132 кВт. Финансовые условия сотрудничества не раскрываются. В октябре нынешнего года Schneider Electric приобрела контрольный пакет акций компании Motivair Corporation, которая специализируется на системах жидкостного охлаждения для HPC- и ИИ-платформ. Не исключено, что изделия Motivair будут применяться в составе эталонных СЖО для серверов на базе Blackwell. Апарна Прабхакар (Aparna Prabhakar), старший вице-президент подразделения электропитания Schneider, сообщила, что компания совместно с NVIDIA работает над несколькими вариантами систем охлаждения, которые можно масштабировать в зависимости от количества установленных серверов и потребляемой ими энергии. Это, как ожидается, поможет в развёртывании дата-центров нового поколения, ориентированных на ресурсоёмкие ИИ-вычисления.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

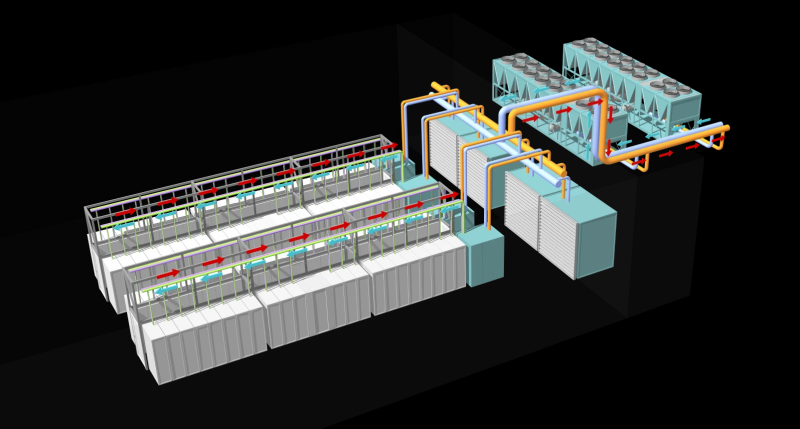

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15. |

|