Материалы по тегу: ram

|

03.03.2025 [08:13], Сергей Карасёв

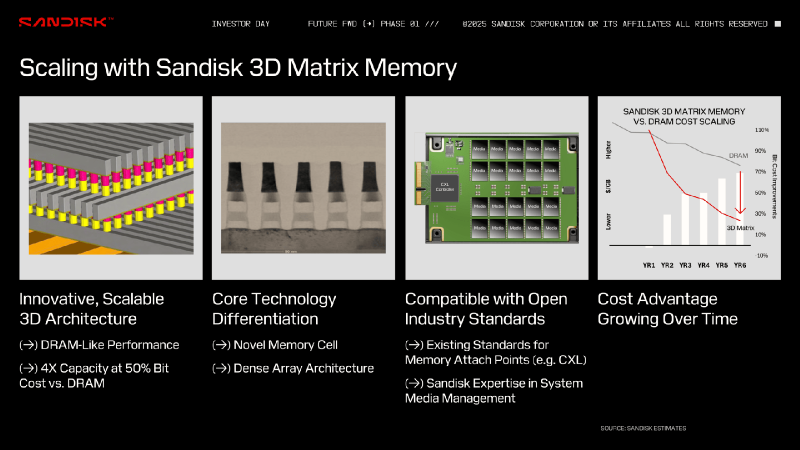

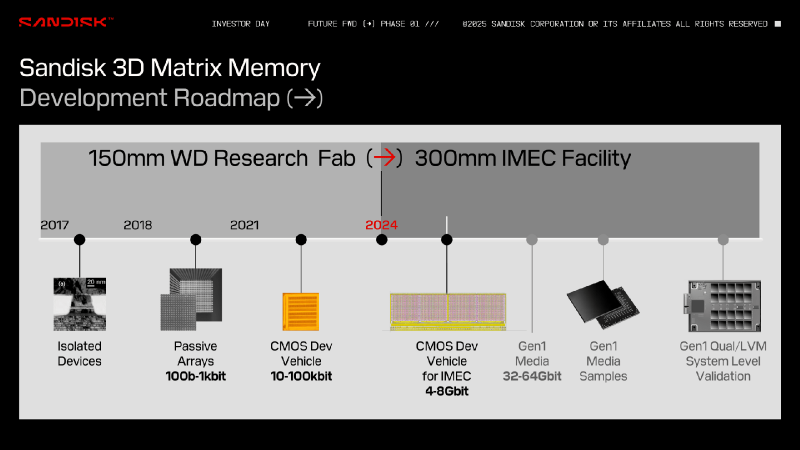

Больше бит за те же деньги: память Sandisk 3D Matrix Memory обещает производительность на уровне DRAM при снижении цены и увеличении ёмкостиКомпания Sandisk, по сообщению TechRadar, обнародовала информацию о памяти нового типа 3D Matrix Memory, которая, как ожидается, в перспективе станет более доступной альтернативой DRAM. Работы над 3D Matrix Memory ведутся с 2017 года в сотрудничестве со специалистами международного микро- и наноэлектронного научно-исследовательского центра IMEC в Лёвене (Бельгия). 3D Matrix Memory использует архитектуру плотного массива с ячейками памяти нового типа. Говорится о совместимости с открытыми отраслевыми стандартами, такими как CXL. По утверждениям Sandisk, разрабатываемая технология позволит преодолеть ограничения в плане ёмкости и пропускной способности, с которыми столкнулись другие типы памяти на фоне стремительного развития ИИ. Для 3D Matrix Memory заявлен высокий уровень масштабируемости. Предполагается, что в перспективе такая память обеспечит в четыре раза большую ёмкость по сравнению с DRAM при сопоставимой производительности и двукратном снижении стоимости. Sandisk утверждает, что характеристики памяти 3D Matrix Memory с течением времени будут улучшаться, повышая её экономическую эффективность. Изделия 3D Matrix Memory первого поколения будут обладать ёмкостью 32–64 Гбит. Одним из первых покупателей памяти станет Министерство обороны США, которое намерено использовать её в аэрокосмическом секторе. О сроках начала массового производства пока ничего не сообщается. Нужно отметить, что ранее Sandisk предложила технологию флеш-памяти с высокой пропускной способностью HBF (High Bandwidth Flash), которая может стать альтернативой HBM (High Bandwidth Memory) в ИИ-ускорителях при решении определённых задач, таких как инференс. По сравнению с HBM использование HBF позволит увеличить объём памяти ИИ-карт в 8 или даже 16 раз при сопоставимой цене. Кроме того, Sandisk проектирует SSD сверхвысокой вместимости для дата-центров: накопители на фирменной платформе UltraQLC смогут вмещать до 1 Пбайт информации.

17.01.2025 [13:54], Сергей Карасёв

ADATA представила модули DDR5-6400 CU-DIMM и CSO-DIMM с широким температурным диапазономКомпания ADATA Industrial анонсировала модули оперативной памяти промышленного класса DDR5-6400 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Изделия рассчитаны на эксплуатацию в суровых условиях. Они могут применяться в оборудовании для дата-центров, в ИИ-устройствах для периферийных вычислений, транспортных системах, IoT-приборах и пр. Модули функционируют при напряжении 1,1 В. Вне зависимости от форм-фактора доступны варианты ёмкостью 8, 16 и 32 Гбайт. Говорится о поддержке ECC. ADATA предлагает модификации со стандартным и расширенным температурным диапазоном: в первом случае он простирается от 0 до +95 °C, во втором — от -40 до +95 °C. Реализована технология TVS (Transient Voltage Suppressor), обеспечивающая защиту от перепадов напряжения. Специальное конформное покрытие помогает минимизировать негативное влияние факторов окружающей среды: повышенных температур, влаги, загрязнений, химических веществ и механических воздействий. По желанию заказчика может быть добавлена защита от сульфирования. Отмечается, что в среде с высокой концентрацией серы при определённых условиях (высоких температурах, влажности и загрязнениях) могут образовываться различные виды соединений серы, которые воздействуют на серебряные сплавы в DRAM-чипах. Это может приводить к выводу модулей из строя. Для решения проблемы ADATA предлагает соответствующую защиту.

16.01.2025 [08:04], Алексей Степин

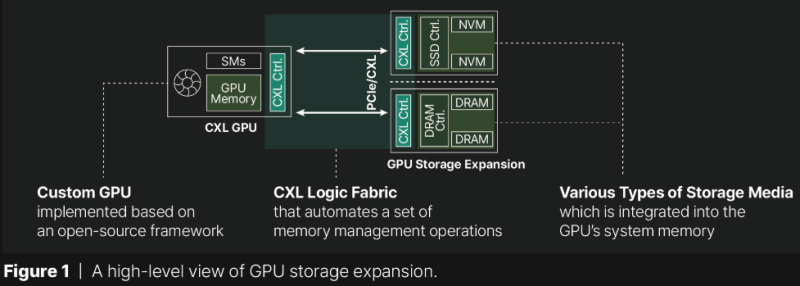

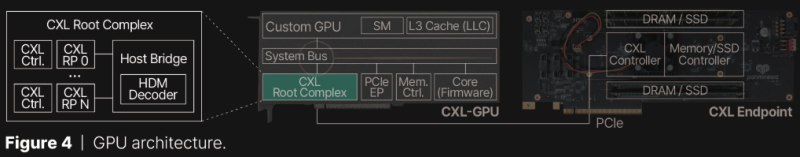

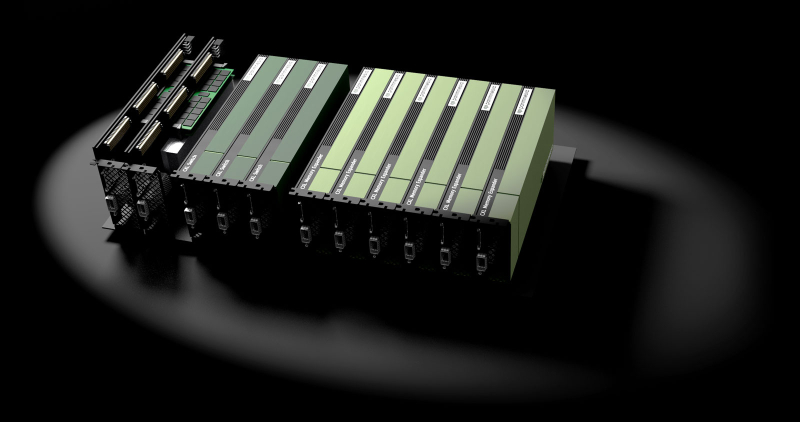

Терабайтные GPU: Panmnesia продемонстрировала CXL-память для ИИ-ускорителейКомпания Panmnesia работает в области проектирования CXL-пулов DRAM довольно давно: в 2023 году она демонстрировала систему, оставляющую позади все решения на базе RDMA и обеспечивающую доступ к 6 Тбайт оперативной памяти. Но большие объёмы памяти сегодня, в эпоху всё более усложняющихся ИИ-моделей, нужны не только и не столько процессорам, сколько ускорителям, априори лишённым возможности апгрейда набортной RAM. На выставке CES 2025 компания продемонстрировала решение данной проблемы. По мнению разработчиков Panmnesia, производительность при обучении масштабных ИИ-моделей упирается именно в объёмы набортной памяти ускорителей: вместо десятков гигабайт требуются уже терабайты, а установка дополнительных ускорителей может обходиться слишком дорого при том, что вычислительные мощности окажутся избыточными. Продемонстрированная на выставке CXL-система построена на базе новейшего контроллера Panmnesia с поддержкой CXL 3.1. В двунаправленном режиме латентность доступа составила менее 100 нс и находится примерно на уровне 80 нс. Ключ к успеху здесь кроется в фирменной реализации CXL 3.1, включая программную часть, благодаря которой GPU могут обращаться к общему пулу памяти, используя те же инструкции типа load/store, что при доступе к набортной HBM или GDDR. Однако технология требует наличия на борту GPU фирменного контроллера CXL Root Complex, одной из важнейших частей которого является декодер HDM, отвечающий за управление адресным пространством памяти (host physical address, HPA), так что уже выпущенные ускорители напрямую работать с системой Panmnesia не смогут. Тем не менее, технология выглядит многообещающей. Она уже привлекла внимание со стороны компаний, занимающихся ИИ, как потенциально позволяющая снизить стоимость инфраструктуры ЦОД.

25.12.2024 [12:55], Сергей Карасёв

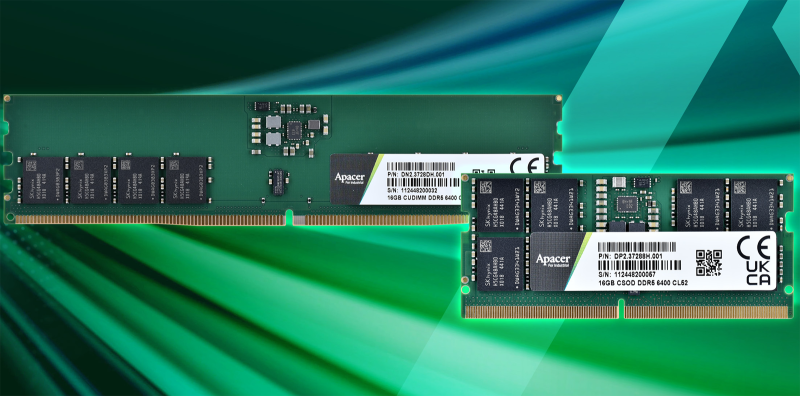

Apacer представила индустриальные модули DDR5-6400 CU-DIMM и CSO-DIMMКомпания Apacer Technology объявила о начале массового производства модулей оперативной памяти DDR5-6400 индустриального класса, спроектированных специально для задач ИИ и НРС. Изделия могут применяться в системах автоматизации, медицинском оборудовании, IoT-устройствах, интеллектуальных автомобильных платформах и пр. Представлены решения DDR5-6400 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Они функционируют при напряжении 1,1 В. Ёмкость модулей составляет 8, 16, 32 и 64 Гбайт. По заявлениям Apacer Technology, в конструкции изделий применяются компоненты высокого качества. Упомянуты полностью бессвинцовые резисторы. Кроме того, модули удовлетворяют новейшим стандартам JEDEC Raw Card Revision 1.0, обеспечивая стабильность передачи данных и высокую производительность. Для изделий в качестве опции доступно специальное конформное покрытие, предназначенное для защиты от негативного влияния факторов окружающей среды: повышенных температур, влаги, загрязнений, химических веществ и механических воздействий. Диапазон рабочих температур простирается от 0 до +85 °C. Кроме того, может быть добавлена защита от сульфирования. Сера широко используется во многих отраслях промышленности. Когда серебряные сплавы в DRAM-чипах подвергаются воздействию сернистых газов, происходит коррозионная реакция: сульфирование приводит к снижению проводимости и быстрому выходу изделий из строя. Для решения проблемы Apacer применяет запатентованную технологию.

11.12.2024 [23:47], Владимир Мироненко

BadRAM: для обхода защиты виртуальных машин в процессорах AMD EPYC достаточно оборудования стоимостью всего $10

amd

cpu

ddr4

ddr5

dram

epyc

hardware

виртуализация

информационная безопасность

уязвимость

шифрование

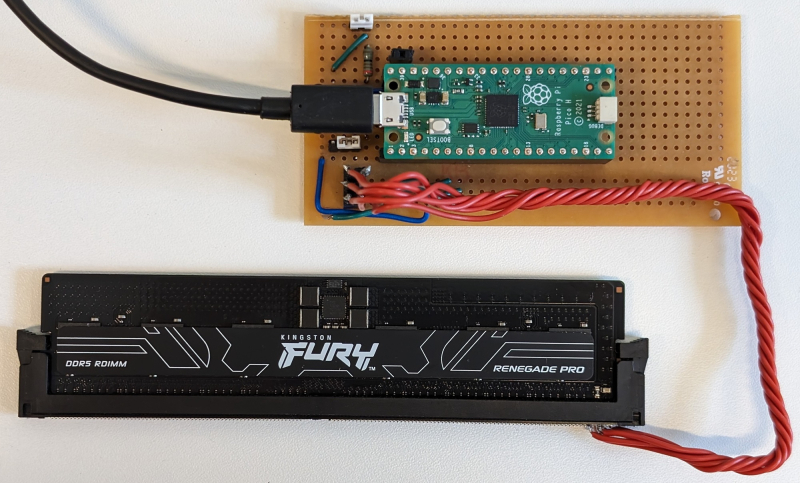

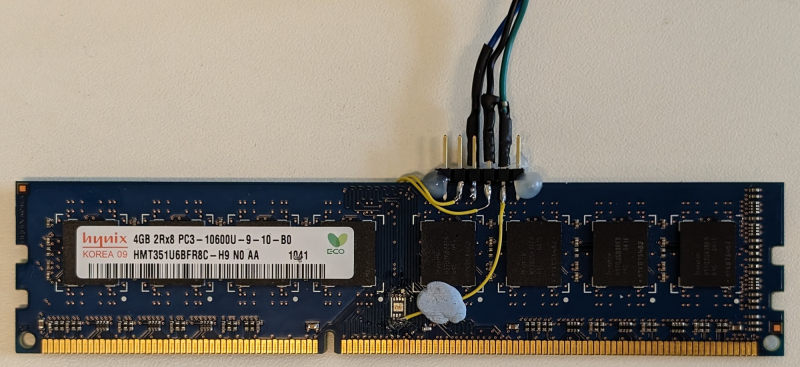

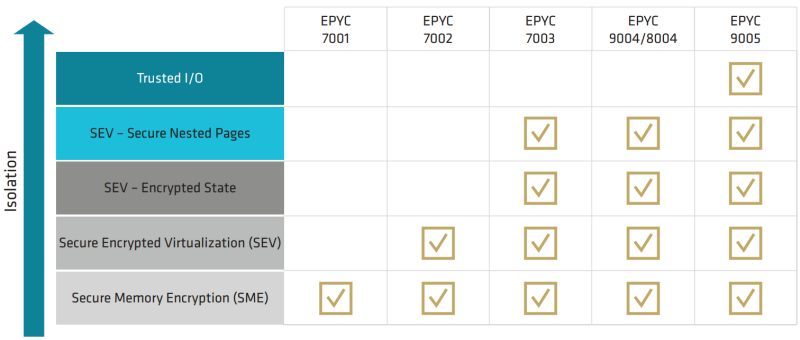

Исследователи Лёвенского католического университета (Бельгия), Любекского университета (Германия) и Бирмингемского университета (Великобритания) обнаружили, что система защиты виртуальных машин от атак с использованием вредоносного гипервизора AMD SEV-SNP (Secure Nested Paging), не так безопасна, как утверждает разработчик, пишет The Register. Технологии Secure Encrypted Virtualization (SEV) предоставляют доверенную среду исполнения (TEE), призванную обеспечить защиту виртуальных машин от незаконных попыток вмешательства со стороны тех, кто имеет доступ к оборудованию ЦОД. Механизм SEV-SNP реализован в процессорах AMD EPYC, начиная с 7003 (Milan). Аналогичные механизмы есть и у конкурентов: Intel Software Guard Extensions (SGX) и Trusted Domain Extensions (TDX), а также Arm Confidential Compute Architecture (CCA). Все эти технологии отвечают за шифрование памяти и изоляцию ресурсов. Исследователи разработали способ обхода SEV-SNP, который они назвали BadRAM (CVE-2024-21944 и AMD-SB-3015). Для атаки требуется оборудование стоимостью около $10, включая Raspberry Pi Pico, разъём DDR и батарею на 9 В. Атака BadRAM требует наличие физического доступа к оборудованию. Она основана на манипуляциях с чипом SPD (Serial Presence Detect), который передаёт данные о модуле DDR4/DDR5 во время загрузки системы. Манипулируя SPD, злоумышленники создают адреса-фантомы для физической памяти, благодаря которым можно незаметно получить доступ к данным в виртуальной машине. «Мы удваиваем видимый в системе объём DIMM, чтобы обмануть контроллер памяти CPU и заставить его использовать дополнительные «фантомные» биты адресации, — объясняют авторы исследования. — Два разных физических адреса теперь ссылаются на одно и то же местоположение DRAM». С помощью таких фантомов злоумышленники могут обойти защиту памяти, раскрывая конфиденциальные данные или вызывя сбои. BadRAM позволяет подделать критически важные отчёты удалённой аттестации и вставлять необнаруживаемые бэкдоры в любую виртуальную машину, защищённую SEV-SNP. Атака может быть реализована и без физического доступа к оборудованию, поскольку некоторые поставщики DRAM оставляют чип SPD разблокированным, что противоречит спецификациям JEDEC. Авторы исследования обнаружили по крайней мере два DDR4-модуля Corsair без должной защиты SPD. Память DDR3 тоже может быть взломана путём замены чипа SPD. «BadRAM полностью подрывает доверие к технологии защищённой зашифрованной виртуализации AMD (SEV-SNP), которая широко используется крупными поставщиками облачных услуг, включая Amazon AWS, Google Cloud и Microsoft Azure», — сообщил The Register Джо Ван Балк (Jo Van Bulck), профессор лаборатории DistriNet на кафедре компьютерных наук KU Leuven. Исследователи отметили, что решения SGX и TDX Intel не имеют такой уязвимости, поскольку в них реализованы контрмеры против создания псевдонимов (alias) памяти. Arm CCA, судя по спецификации, тоже не имеет проблем, но для проверки этого у исследователей не было коммерческих чипов. Полный доклад об атаке исследователи планируют представить в мае 2025 года на конференции IEEE Symposium on Security and Privacy. Исследователи уведомили AMD о найденных проблемах в феврале 2024 года. «AMD рекомендует использовать модули памяти, которые блокируют SPD, а также следовать передовым практикам в области физической безопасности систем. AMD также выпустила обновления прошивок защиты от уязвимости», — сообщили в AMD ресурсу The Register в ответ на просьбу прокомментировать публикацию исследователей.

27.11.2024 [10:39], Владимир Мироненко

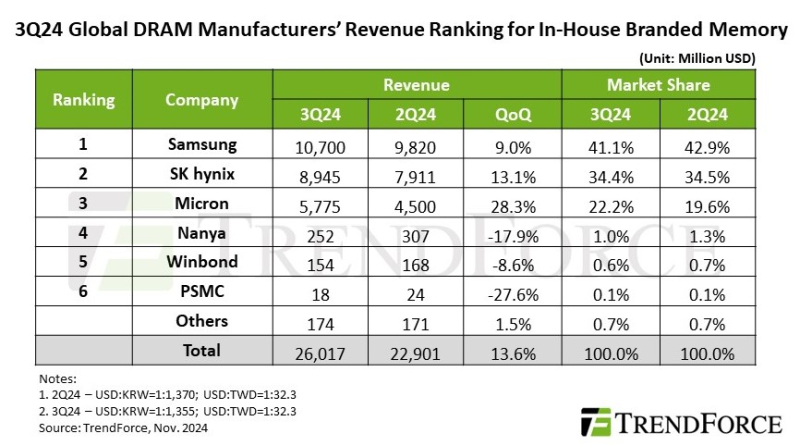

TrendForce: высокий спрос на память DDR5 и HBM для ЦОД подстегнул рост доходов отрасли в III кварталеСогласно оценкам аналитической компании TrendForce, в III квартале 2024 года глобальный доход производителей памяти DRAM достиг $26,02 млрд (последовательный рост на 13,6 %) на фоне растущего спроса на память DDR5 и HBM для ЦОД, несмотря на снижение поставок памяти LPDDR4 и DDR4 из-за сокращения запасов китайскими брендами смартфонов и расширения мощностей китайскими поставщиками DRAM. Как и в предыдущем квартале средняя цена продажи (ASP) продолжала расти, чему способствовало, в том числе, вытеснение памятью HBM производства обычной DRAM. При этом контрактные цены выросли на 8–13 %. В IV квартале TrendForce ожидает квартальный рост общих поставок DRAM в битах, полагая при этом, что ограничения мощностей, вызванные производством HBM, окажут более слабое, чем ожидалось, влияние на цены. Кроме того, расширение мощностей китайскими поставщиками может побудить производителей ПК и бренды смартфонов активно расходовать имеющиеся запасы, чтобы пополнять их более дешёвой DRAM. Это может привести к снижению контрактных цен на обычную DRAM.

Источник изображения: SK hynix Благодаря росту контрактных цен на DRAM для серверов и ПК в III квартале увеличились доходы трёх крупнейших производителей памяти. Samsung сохранила лидерство с доходом в $10,7 млрд, что на 9 % больше показателя предыдущего квартала. В связи со стратегическим снижением запасов LPDDR4 и DDR4 поставки компанией памяти в битах остались на уровне предыдущего квартала. На втором месте по-прежнему находится SK hynix с доходом в $8,95 млрд (последовательный рост на 13,1 %). Несмотря на рост поставок HBM3e, более слабые продажи LPDDR4 и DDR4 привели к снижению показателя поставок в битах на 1–3% в квартальном исчислении. Доход Micron вырос на 28,3 % в квартальном исчислении до $5,78 млрд благодаря значительному росту поставок серверной памяти DRAM и HBM3e, что привело к увеличению поставок в битах на 13 % по сравнению с предыдущим кварталом. Тайваньские поставщики DRAM, столкнувшиеся в III квартале с падением выручки, значительно отстали от тройки лидеров. У Nanya Technology было отмечено падение поставок в битах более чем на 20 % в квартальном исчислении из-за более слабого спроса на потребительскую DRAM и усиления конкуренции на рынке DDR4 со стороны китайских поставщиков. Операционная прибыль ещё больше снизилась (с -23,4 % до -30,8 %) из-за инцидента с отключением электроэнергии. Выручка Winbond снизилась в квартальном исчислении на 8,6 % до $154 млн на фоне падения спроса на потребительскую DRAM снизился, что также негативно отразилось на объёме поставок в битах. Наконец, PSMC сообщила о падении выручки от собственного производства потребительской DRAM на 27,6 %. Однако, с учётом полупроводникового производства, её общая выручка от поставок DRAM выросла на 18 % в квартальном исчислении, что обусловлено продолжающимся пополнением запасов клиентами в сфере производства полупроводников.

06.11.2024 [10:27], Сергей Карасёв

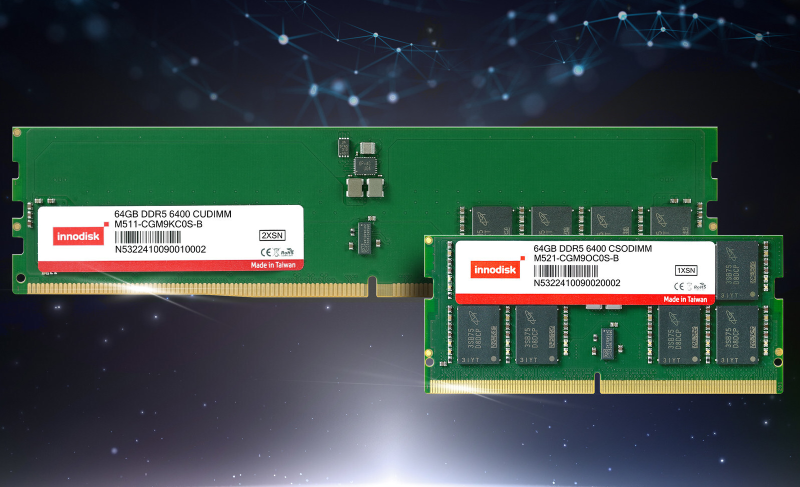

Innodisk представила индустриальные модули DDR5-6400 ёмкостью 64 ГбайтКомпания Innodisk анонсировала модули памяти DDR5-6400 ёмкостью 64 Гбайт, предназначенные для задач с интенсивным использованием данных. Это могут быть приложения ИИ (в том числе генеративного), платформы смешанной реальности, большие языковые модели (LLM), автономные транспортные средства, телемедицинские системы и пр. Изделия доступны в различных вариантах исполнения — CUDIMM, CSODIMM, ECC CUDIMM, ECC CSODIMM и RDIMM. Помимо версии на 64 Гбайт, серия включает варианты объёмом 8, 16, 32, 24 и 48 Гбайт. Модули функционируют при напряжении питания 1,1 В. Диапазон рабочих температур простирается от 0 до +95 °C. Реализована технология TVS (Transient Voltage Suppressor), которая обеспечивает защиту от перепадов напряжения. Контакты модулей имеют покрытие золотом толщиной 30 мкм, благодаря чему улучшается проводимость и обеспечивается защита от окисления: это увеличивает срок службы. По заявлениям Innodisk, модули памяти DDR5-6400 полностью совместимы с новейшими процессорами AMD и Intel. Среди ключевых сфер применения изделий названы индустриальные и встраиваемые устройства, серверное оборудование, системы видеонаблюдения, платформы промышленной автоматизации и пр. В частности, память может поддерживать работу ресурсоёмких приложений ИИ на периферии. Применительно к телемедицине 3D-визуализация с высоким разрешением и анализ данных в режиме реального времени позволят удалённо проводить пациентам хирургические операции с высокой точностью, говорит компания.

05.11.2024 [11:11], Сергей Карасёв

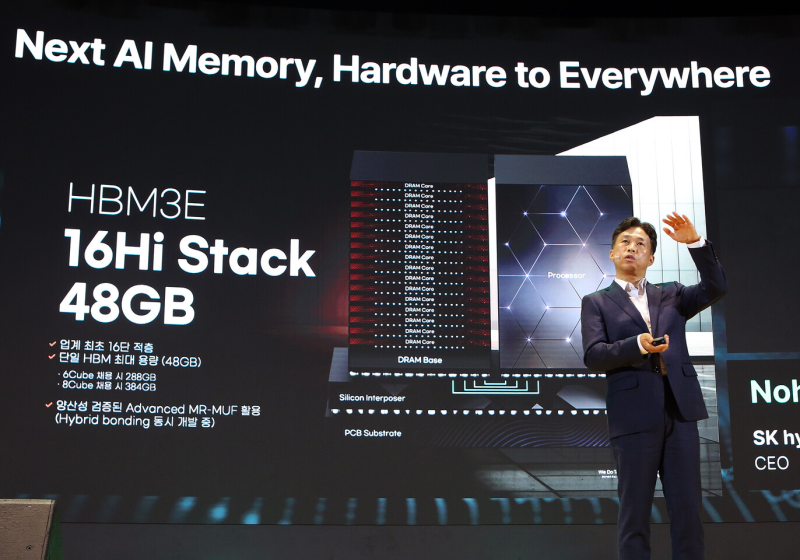

SK hynix представила первые в отрасли 16-ярусные чипы HBM3E ёмкостью 48 ГбайтКомпания SK hynix на мероприятии SK AI Summit в Сеуле (Южная Корея) сообщила о разработке первых в отрасли 16-ярусных чипов памяти HBM3E, ёмкость которых составляет 48 Гбайт. Клиенты получат образцы таких изделий в начале 2025 года. Генеральный директор SK hynix Квак Но-Джунг (Kwak Noh-Jung) сообщил, что компания намерена трансформироваться в поставщика ИИ-памяти «полного стека». Ассортимент продукции будет охватывать изделия всех типов — от DRAM до NAND. При этом планируется налаживание тесного сотрудничества с заинтересованными сторонами. При производстве 16-Hi HBM3E компания будет применять передовую технологию Advanced MR-MUF, которая ранее использовалась при изготовлении 12-слойных продуктов. Память рассчитана на высокопроизводительные ИИ-ускорители. Утверждается, что 16-ярусные изделия по сравнению с 12-слойными аналогами обеспечивают прирост быстродействия на 18 % при обучении ИИ-моделей и на 32 % при инференсе. SK hynix намерена предложить заказчикам кастомизируемые решения HBM с оптимизированной производительностью, которые будут соответствовать различным требованиям к ёмкости, пропускной способности и функциональности. Плюс к этому SK hynix планирует интегрировать логику непосредственно в кристаллы HBM4. Ранее говорилось, что компания рассчитывает начать поставки памяти HBM4 заказчикам во II половине 2025 года. В числе других готовящихся продуктов SK hynix упоминает модули LPCAMM2 (Compression Attached Memory Module 2) для ПК и ЦОД, решения LPDDR5 и LPDDR6 с технологией производства 1c-класса, SSD с интерфейсом PCIe 6.0, накопители eSSD и UFS 5.0 большой вместимости на основе чипов флеш-памяти QLC NAND.

04.11.2024 [11:44], Сергей Карасёв

TeamGroup анонсировала индустриальные CAMM2-модули DDR5-6400Компания TeamGroup анонсировала модули оперативной памяти DDR5 стандарта CAMM2 (Compression Attached Memory Module 2), предназначенные для использования в промышленной и корпоративной сферах. Изделия подходят для edge-систем, приложений ИИ, платформ управления производственным процессом и пр. Отмечается, что модули CAMM2 обладают рядом преимуществ по сравнению с SO-DIMM, U-DIMM и R-DIMM. В частности, решения CAMM2 поддерживает двухканальный режим работы с одним модулем, что упрощает архитектуру системы и значительно снижает энергопотребление.

Источник изображения: TeamGroup Модули CAMM2 используют горизонтальное расположение, то есть монтируются параллельно материнской плате. Благодаря этому повышается эффективность рассеяния тепла. Для установки применяются резьбовые стойки. Утверждается, что память CAMM2 превосходит предыдущие стандарты по возможностям разгона, скорости чтения и задержкам. Полностью характеристики анонсированных изделий компания TeamGroup пока не раскрывает. Известно, что они функционируют на частоте 6400 МГц. Массовые поставки планируется организовать в I квартале 2025 года. Нужно отметить, что Комитет стандартизации полупроводниковой продукции (JEDEC) утвердил стандарт CAMM2 в декабре 2023 года. Ширина модулей данного типа составляет 78 мм. На момент анонса спецификации говорилось о поддержке ёмкостей до 128 Гбайт. Предусмотрена возможность использования памяти DDR5 для настольных компьютеров и рабочих станций, а также LPDDR5X для тонких и лёгких ноутбуков. При необходимости модули могут оснащаться радиатором охлаждения.

26.10.2024 [13:19], Сергей Карасёв

Бренд XPG представил модули AICORE DDR5-8000 для мощных рабочих станцийКомпания ADATA Technology анонсировала под брендом XPG свои первые разогнанные модули оперативной памяти DDR5 RDIMM: изделия серии AICORE предназначены для рабочих станций, ориентированных на 3D-рендеринг, приложения ИИ и другие ресурсоёмкие задачи. Регистровая память AICORE будет предлагаться в версиях DDR5-6400/7200/8000. Ёмкость модулей составляет 16 Гбайт. Изделия совместимы с процессорами AMD Ryzen Threadripper 7000 и Ryzen Threadripper Pro 7000WX, а также с чипами Intel Xeon Emerald Rapids и Xeon Sapphire Rapids. Говорится о поддержке профилей AMD Expo и Intel XMP 3.0. Реализованы две технологии коррекции ошибок — On-die ECC и Side-band ECC, что, по заявлениям разработчика, гарантирует точную и надёжную передачу данных. Контакты модулей имеют покрытие золотом толщиной 30 мкм, благодаря чему улучшается проводимость, обеспечивается защита от окисления и увеличивается долговечность. Применены графеновые радиаторы, которые эффективно отводят тепло, позволяя памяти стабильно работать при длительных высоких нагрузках. Упомянут датчик мониторинга температуры в режиме реального времени. «Разогнанная память AICORE RDIMM спроектирована для высокой скорости и стабильности, идеально подходя для обработки больших объёмов данных, искусственного интеллекта, 3D-рендеринга и графики, видеомонтажа и многозадачности», — заявляет XPG. Изделия будут предлагаться по отдельности, а также в комплектах из двух штук суммарным объёмом 32 Гбайт. Такие наборы появятся в продаже в I квартале 2025 года. |

|