Материалы по тегу: охлаждение

|

10.12.2023 [21:00], Сергей Карасёв

Более 60 стран обязались сократить парниковые выбросы от охлаждения почти на 70 % к 2033 годуВ ходе 28-й Конференции ООН по изменению климата (COP28), которая проходит в Дубае (ОАЭ) с 30 ноября по 12 декабря 2023 года, 63 государства, включая США и Канаду, подписали обязательство сократить выбросы парниковых газов в сфере охлаждения примерно на две трети до 2033 года. Отмечается, что охладительные установки, такие как системы кондиционирования воздуха, не только приносят людям облегчение во время жары, но также критически важны для целого ряда областей. Холодильное оборудование применяется для обеспечения сохранности продуктов питания, при доставке лекарственных препаратов и пр. Одним из крупнейших секторов использования охладительных установок является сегмент дата-центров. Традиционные методы охлаждения провоцируют изменение климата. По данным ООН, на такие системы приходится более 7 % от общего объёма глобальных выбросов парниковых газов. Эксперты говорят, что при сохранении нынешних тенденций к 2050 году потребность в энергии для охлаждения помещений возрастёт в три раза. А это спровоцирует рост вредных выбросов в атмосферу. Ситуация ухудшается из-за быстрорастущей плотности и мощности ЦОД на фоне стремительного развития сервисов ИИ и НРС. Если не предпринять необходимые меры, затраты на охлаждающее оборудование к 2050 году, как ожидается, увеличатся более чем в два раза. В соответствии с подписанным обязательством страны должны сократить выбросы парниковых газов в сфере охлаждения на 68 % к 2033-му, а также повысить энергоэффективность такого оборудования. Сообщается также, что высокому риску воздействия экстремальной жары из-за отсутствия доступа к охлаждению подвергаются более 1 млрд жителей планеты, подавляющее большинство из которых проживают в Африке и Азии. Более того, почти треть населения Земли сталкивается со смертельно опасными тепловыми волнами более 20 дней в году. Поэтому охлаждение имеет важное значение для защиты здоровья. Между тем принятие мер по снижению энергопотребления холодильного оборудования не только поможет уменьшить вредные выбросы, но и позволит снять нагрузку с энергосетей и сэкономить триллионы долларов.

06.12.2023 [20:09], Руслан Авдеев

Министерство энергетики США выявило плохое обслуживание экзафлопсного суперкомпьютера FrontierУправление генерального инспектора (OIG) Министерства энергетики США провело проверку ЦОД Национальной лаборатории Ок-Ридж, на базе которой работают передовые суперкомпьютеры, в том числе — первая в мире экзафлопсная система Frontier. Как сообщает The Register, результаты оставляют желать лучшего. В сентябре прошлого года в OIG поступило заявление о необходимости проверки качества обслуживания и калибровки оборудования (в первую очередь речь температурных датчиках и автоматике систем охлаждения) на площадке лаборатории, расположенной в Теннеси. Лаборатория занимается проектами в области атомной энергетики и обеспечения национальной безопасности. Доклад по результатам проверки связан с ЦОД на площадке Ок-Ридж. В одном из кампусов находится центр Oak Ridge Leadership Computing Facility (OLCF), управляющий суперкомпьютером Frontier. Инспекция проводилась с января по сентябрь 2023 года и подтвердила данные поступившего регулятору заявления. Согласно докладу OIG, в заявлении сообщалось, что программа калибровки не соответствовала нормам, а предохранительные клапаны (PRV) в ЦОД или совсем не обслуживались, или обслуживались недобросовестно. Сбой работы клапанов мог привести к повышению давления выше допустимых пределов, что потенциально могло нанести вред как оборудованию, так и персоналу. Как сообщают в OIG, поскольку инфраструктура не обслуживалась должным образом, этом могло ограничить доступность вычислительных ресурсов и поставить под угрозу выполнение целей миссии лаборатории. Управление вычислительными мощностями лаборатории выполняет некоммерческая организация UT-Battelle, созданная в 2000 году исключительно для контроля над площадкой Ок-Ридж в интересах Министерства энергетики при сотрудничестве с Университетом Теннесси и некоммерческим Мемориальным институтом Баттеля. В OIG заявляют, что программа обслуживания UT-Battelle не соответствовала необходимым требованиям. В самой UT-Battelle сообщили регулятору, что регулярная калибровка не нужна, поскольку каждый элемент оборудования калибруется при установке, а позже системы ЦОД постоянно контролируются субподрядчиком с помощью ПО, уведомляющего об инцидентах. В OIG подчёркивают, что хотя такая практика разрешена, всё ПО должно контролироваться с помощью специальной программы обеспечения качества, описывающей, каким именно образом соблюдаются требования к безопасности. Однако лаборатория не смогла предоставить таких документов — в UT-Battelle фактически не знают, предоставляет ли ПО корректные данные. Кроме того, UT-Battelle не проверяла вовремя все воздушные клапаны, а почти половина клапанов для воды и теплоносителя не была протестирована и/или обследована в соответствиями с инструкциями. В некоторых случаях тесты проводили в соответствии с рекомендациями производителя, а не принятыми в лаборатории правилами. UT-Battelle заявляет, что процедура проверки сейчас пересматривается. В отчёте OIG подчёркивается, что в 2020 году уже проводилась аналогичная проверка, выявившая буквально те же проблемы. Хотя в некоторых аспектах положение улучшилось, требуются дальнейшие меры для приведения дел в порядок. При этом в UT-Battelle полностью признали правомерность рекомендаций и согласились разработать план обеспечения качества для мониторингового ПО и обеспечить работу и обслуживание PRV-клапанов в соответствии с актуальными процедурами и требованиями.

03.12.2023 [22:57], Сергей Карасёв

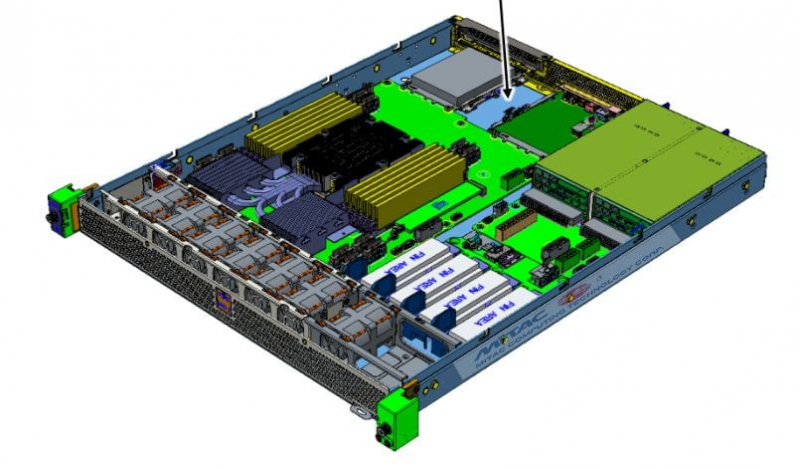

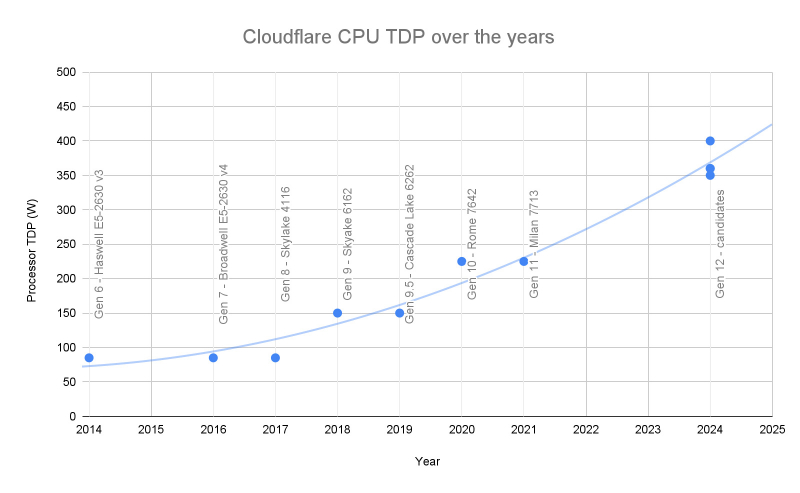

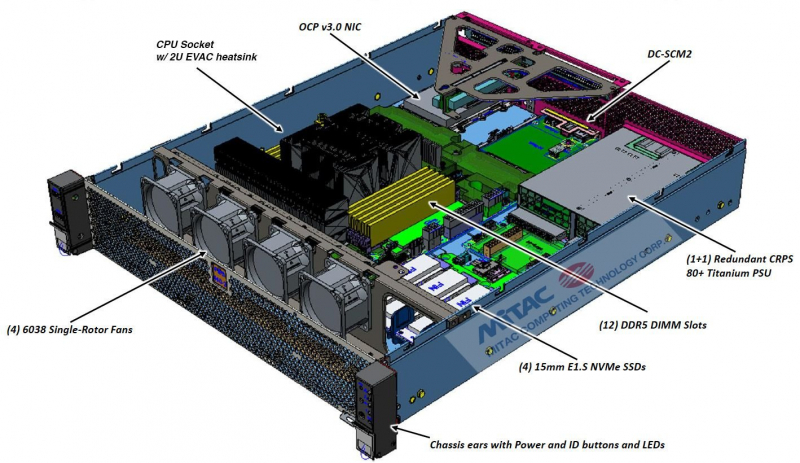

Размер имеет значение: Cloudflare перейдёт от 1U- к 2U-серверам ради экономии энергии и снижения затратКомпания Cloudflare, предоставляющая услуги CDN, поделилась планами по модернизации своей инфраструктуры: речь идёт о переходе на серверы 12-го поколения (Gen 12), которые позволят решать в том числе ресурсоёмкие задачи в области ИИ. Развёртывание оборудования нового поколения запланировано на 2024 год. Cloudflare отмечает, что, помимо применения более мощных процессоров, будут задействованы последние достижения в области памяти, хранения данных и безопасности. Каждый элемент проектируемых серверов тщательно оценивается, включая форм-фактор и средства охлаждения. Отмечается, что одной из основных проблем является постоянный рост TDP чипов. Так, серверы Cloudflare 9-го поколения были основан на Intel Xeon 6162 (Skylake) с TDP 150 Вт, серверы 10-го поколения — на AMD EPYC 7642 (Rome) с TDP до 240 Вт, а решения 11-го поколения — на AMD EPYC 7713 (Milan) с мощностью 240 Вт. У процессоров AMD EPYC Genoa значение TDP по умолчанию достигает 360 Вт и может быть настроено до 400 Вт, а у Intel Xeon Sapphire Rapids этот показатель составляет до 350 Вт. Следующее поколение процессоров x86 от AMD и Intel рассчитано на TDP до 500 Вт. Таким образом, возникает необходимость в более эффективном охлаждении. Серверы Cloudflare Gen 10 и Gen 11 выполнены в форм-факторе 1U1N с воздушным охлаждением. При использовании процессоров с TDP более 350 Вт в таких серверах требуется задействовать 7–8 двухроторных вентиляторов, постоянно работающих на максимальной скорости — они могут справиться и с 400-Вт CPU. В таком режиме энергопотребление каждого из вентиляторов достигает 40 Вт, что в сумме даёт до 320 Вт только на охлаждение. При пиковых нагрузках общая потребляемая мощность сервера, включая компоненты охлаждения, собственно процессор и другие комплектующие, может превысить 750 Вт. Однако многие площадки, где Cloudflare размещает серверы, имеют ограничение по мощности на уровне стойки. При энергопотреблении 750 Вт/узел компания может оказаться заполненной лишь наполовину. Поэтому принято решение перейти от серверов 1U1N к системам формата 2U1N. Это, как утверждается, обеспечит ряд преимуществ, в том числе:

Тепловое моделирование показало, что четырёх однороторных вентиляторов диаметром 60 или 80 мм мощностью менее 40 Вт каждый достаточно для охлаждения системы 2U с процессорами с показателем TDP более 350 Вт. В сравнении с восемью вентиляторами диаметром 40 мм в 1U-шассии экономия теоретически составляет минимум 150 Вт. Таким образом, переход на форм-фактор 2U даст Cloudflare возможность полностью использовать ресурсы CPU и стоечное пространство, а также поможет снизить затраты на энергию и совокупную стоимость владения.

03.12.2023 [00:43], Сергей Карасёв

Infosys и Shell помогут в развёртывании экологичных ЦОД для ИИ с погружным охлаждениемИндийский технологический гигант Infosys, специализирующийся на разработке ПО, консалтинге и аутсорсинге, объявил о заключении соглашения о сотрудничестве с международной энергетической компанией Shell New Energies UK с целью ускорения внедрения систем погружного охлаждения в дата-центрах. По оценкам, на ЦОД приходится до 1,5 % мирового потребления электроэнергии и 1 % глобальных выбросов углекислого газа. Повсеместное внедрение ИИ, как отмечается, увеличит эти показатели. Вместе с тем технологии погружного охлаждения потенциально могут обеспечить снижение выбросов CO2 на 30 % и сокращение энергопотребления на 48 %. Infosys намерена использовать синтетическую охлаждающую жидкость Shell Immersion Cooling Fluid для однофазных систем погружного охлаждения вместе со своей ИИ-платформой Topaz. Она включает набор услуг для генеративного ИИ. Это, в частности, более 150 предварительно обученных моделей и всевозможные ресурсы для ИИ.

Источник изображения: Shell После пилотного тестирования нового решения для охлаждения ЦОД на своих площадках компании намерены предлагать технологию корпоративным заказчикам по всему миру. Жидкости Shell, как ожидается, помогут клиентам сократить расходы и повысить производительность своих дата-центров, а также снизить негативное воздействие на окружающую среду. Около года назад Shell присоединилась к программе GRC ElectroSafe по сертификации альтернативных жидкостей для систем погружного охлаждения. Составы Shell основаны на запатентованной технологии «газ-жидкость» (GTL). Такие жидкости предотвращают появление коррозии, а также обеспечивают улучшенную совместимость материалов и компонентов.

01.12.2023 [22:17], Руслан Авдеев

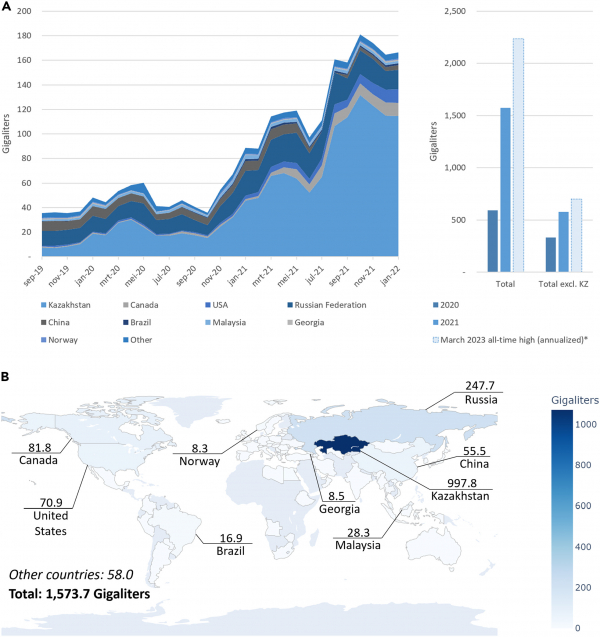

На каждую транзацию биткоина уходит примерно 16 тыс. л водыХотя многие знают, что на операции с биткоинами тратится очень много электроэнергии, не всем известно, что соответствующая экосистема требует для работы и существенных объёмов воды. Как сообщает The Register, основатель Digiconomist и эксперт Амстердамского свободного университета Алекс де Врис (Alex de Vries) предполагает, что экосистема биткоина только в 2023 году потратит 2237 гигалитров пресной воды (1 гигалитр = 1 млн м3). В США на добычу этой криптовалюты за год ушло 39–120 гигалитров воды, примерно столько же потребляют 300 тыс. домохозяйств или город размером с Вашингтон. В прошлом году биткоин подешевел, что привело к некоторому спаду использования энергии и воды, но в текущем году его цена снова выросла, а в марте 2023 года потребление энергии взлетело до рекордных значений. По итогам года на биткоин уйдёт 141,9 ТВт·ч, т.е. на треть выше в сравнении с 2021 годом. В 2021 году на биткоины во всём мире было потрачено почти 1600 гигалитров — примерно 16 тыс. литров на каждую транзакцию, т.е. в 6,2 млн раз больше, чем обходится обработки транзакции банковской карты. По мнению эксперта, способы снизить расход воды и энергии имеются, но, похоже, никто не намерен ими воспользоваться, поскольку биткоин-сообщество весьма консервативно. Переход на более эффективные механизмы, как это произошло с Ethereum, не предвидится. Более того, держатели и майнеры во многом видят залог относительной надёжности и стабильности биткоина в том, что никаких изменений и не будет. Эксперт отмечает, что огромный урон окружающей среде может привести к серьёзным проблемам, особенно на фоне острой нехватки воды в мире. Например, в Казахстане, ставшем крупной площадкой для майнинга биткоинов после запрета аналогичной деятельности в Китае, нехватка воды приведёт к настоящему кризису. Ожидается, что с учётом климатических изменений дефицит воды в стране к 2030 году составит 75 гигалитров. В 2021 году на майнинг биткоинов в Казахстане ушло около 1 тыс. гигалитров воды. При этом, как утверждает учёный, нет никаких свидетельств того, что тревожные новости вызывают какую-либо озабоченность в биткоин-сообществе. На этом фоне затраты воды на обучение и запуск нейросетей уже не кажутся такими уж большими.

24.11.2023 [17:17], Сергей Карасёв

AWS всё активнее использует оборотную воду для охлаждения дата-центровОблачная платформа Amazon Web Services (AWS), по сообщению ресурса Datacenter Dynamics, переводит системы охлаждения в своих ЦОД на сточные воды. Технология уже используется примерно на 20 площадках компании, а в перспективе её внедрение расширится. Дата-центры обычно расходуют воду из питьевых источников, которая многократно циркулирует в контурах охлаждения. Из-за накопления бактерий и известкового налёта воду обрабатывают специальными химическими веществами, что делает её непригодной для дальнейшего использования в обычных бытовых целях. Точное количество питьевой воды, используемой индустрией ЦОД, неизвестно, но, по оценкам, оно исчисляется миллиардами литров в год. Новая технология AWS предполагает повторное применение сточных вод, которые проходят трехэтапный процесс очистки: при этом удаляются 99 % всех примесей и бактерий. После того, как такая вода проходит через систему охлаждения, она снова попадает на станцию очистки для прохождения следующего цикла фильтрации.

Источник изображения: AWS На сегодняшний день AWS применят комплекс очистки сточных вод в 16 дата-центрах в Вирджинии и на нескольких объектах в Санта-Кларе (Калифорния). В целом, компания управляет более чем 100 площадками по всему миру, а ещё десятки находятся в разработке. В конце 2022 года AWS заявила о намерении добиться положительного водного баланса к 2030 году: компания будет отдавать больше чистой воды, чем потреблять. Аналогичные инициативы реализуют и другие гиперскейлеры. Так, Google ранее заявляла, что использует очищенную или непитьевую воду более чем в 25 % кампусов ЦОД. Microsoft также пообещала добиться положительного водного баланса к 2030-му: корпорация использует оборотную воду в своих дата-центрах в Сан-Хосе (Калифорния), Куинси (Вашингтон), Техасе и Сингапуре. К концу десятилетия отдавать больше чистой воды, чем расходовать рассчитывает и Meta✴. А европейские дата-центры планируют снизить потребление воды до 400 мл/кВт·ч к 2040 году.

23.11.2023 [00:10], Руслан Авдеев

Минус 900 МВт·ч ежегодно: ИИ Etalytics помог Equinix снизить энергозатраты во франкфуртском ЦОДОператор ЦОД Equinix повысил энергоэффективность своего дата-центра FR6 во Франкфурте (Германия) на 9 %, оптимизировав распределение энергоресурсов при поддержке ИИ. Как сообщает Datacenter Dynamics, этот результат достигнут с помощью интеллектуальной системы управления охлаждения Etalytics. ПО Etalytics позволило снизить индекс PUE почти до 1,2 и, как ожидается, даст возможность сократить энергопотребление на 900 МВт·ч ежегодно. В дальнейшем Equinix намерена внедрить аналогичные ИИ-решения почти во всех своих франкфутских ЦОД IBX, включая объекты FR4, FR6, FR8 и FR2.6. Стартап Etalytics был сформирован в 2020 году одной из исследовательских групп Технического университета Дармштадта. Сотрудничество с Equinix началось тогда же. ИИ-платформа Etalyctics позволяет регулировать работу систем охлаждения, что ведёт к экономии электроэнергии. ПО собирает телеметрию с помощью IIoT-датчиков для формирования «цифрового двойника», который может использоваться для «динамических расчётов» оптимальной стратегии охлаждения в реальном времени. Учитывается температура, влажность и т.д. Как сообщают в Equinix Germany, речь идёт о многообещающем примере позитивного эффекта цифровизации и влиянии ИИ на рост энергоэффективности. Это, в частности, позволило получить награду Energy Efficiency Award от Германского энергетического агентства (DENA). Впрочем, ПО Etalytics с не меньшим успехом может применяться в химической, фармацевтической и автомобильной промышленности. Считается, что внедрение подобных технологий станет ещё одним ключевым фактором достижения «климатической нейтральности», особенно на фоне амбициозных целей нового Закона об энергоэффективности Германии. В Equinix сообщили, что обсуждают с немецкими политиками способы достижения ещё большей энергоэффективности и устойчивости для того, чтобы новые нормы не помешали цифровизации страны.

21.11.2023 [10:50], Сергей Карасёв

LiquidStack представила однофазную систему иммерсионного охлаждения для ИИ-системКомпания LiquidStack, специализирующаяся на разработке систем погружного (иммерсионного) жидкостного охлаждения, анонсировала однофазное решение для дата-центров. Новая СЖО, как утверждается, подходит для платформ, предназначенных для решения ресурсоёмких задач в области ИИ. Отмечается, что решение, которое пока не получило определённого названия, предоставляет операторам ЦОД экономичный вариант перехода от воздушного охлаждения к энергоэффективному иммерсионному охлаждению.

Источник изображения: LiquidStack Ранее LiquidStack предлагала двухфазные иммерсионные СЖО. Однако в таких системах используются фторированные растворители, такие как Novec от 3M, который недавно был снят с производства из-за опасений по поводу негативного влияния на здоровье людей. В однофазной СЖО применяются неопасные жидкости. По заявлениям LiquidStack, представленное решение позволяет отводить более 2,8 кВт тепла в расчёте на единицу оборудования 1U или до 110 кВт на стойку. Это позволяет создавать НРС-системы на базе GPU для приложений ИИ. Система занимает такую же площадь, что и четыре стандартные стойки на 19″ или 21″. Говорится о совместимости с изделиями стандартов 1U, 2U, 4U, 600 мм, 750 мм, OCP, ORv3 и др. Однофазная СЖО LiquidStack будет доступна для предварительного заказа с 1 декабря 2023 года, а поставки начнутся в III квартале 2024 года. Кроме того, LiquidStack объявила о выпуске новой серии универсальных блоков распределения охлаждающей жидкости (CDU), которые совместимы с большинством имеющихся на рынке систем прямого охлаждения. Изделия обеспечивают отвод тепла от 800 кВт до 1,5 МВт, благодаря чему подходят для задач НРС и ИИ. Среди преимуществ решений названы компактный шумоизолированный корпус, простота установки и обслуживания. Поставки начнутся во II четверти 2024 года.

23.10.2023 [15:57], Сергей Карасёв

Intel и Submer разрабатывают систему погружного охлаждения для киловаттных процессоров и ускорителейКомпании Intel и Submer сообщили о новом достижении в области разработки систем однофазного иммерсионного (погружения) жидкостного охлаждения: предложенная технология, как утверждается, позволяет эффективно отводить тепло от процессоров с показателем TDP до 1000 Вт.

Источник изображения: Submer Речь идёт о решении под названием Forced Convection Heat Sink (FCHS) — радиатор с принудительной конвекцией. Говорится, что технология сочетает «эффективность принудительной конвекции с пассивным охлаждением», позволяя отводить тепло от высокопроизводительных CPU и GPU. Система включает массивный радиатор с двумя винтами в одной из торцевых частей. Это является основным отличием от традиционной концепции пассивного иммерсионного охлаждения, основанного на естественной конвекции. «Погружной радиатор, использующий принудительную конвекцию, является ключевой инновацией, позволяющей вывести однофазное погружное охлаждение за пределы существующих барьеров», — заявляет Мохан Джей Кумар (Mohan J Kumar), научный сотрудник Intel. Отмечается, что некоторые элементы новой системы охлаждения могут быть изготовлены методом 3D-печати. Intel и Submer продемонстрировали, что решение способно справляться с охлаждением неназванного процессора Xeon, TDP которого превышает 800 Вт.

19.10.2023 [20:31], Руслан Авдеев

ExxonMobil представила серию жидкостей для погружных СЖОХотя нефтегазовый гигант ExxonMobil и не пользуется прежним авторитетом в эпоху продвижения экобезопасных технологий, его продукция по-прежнему востребована. Как сообщает Datacenter Dynamics, в числе прочего речь идёт и об охлаждающих жидкостях на основе ископаемых углеводородов — они используются в СЖО, а экономия на совокупной стоимости владения (TCO) ЦОД с их применением составляет до 40 % в сравнении с классическим воздушным охлаждением, заявляет компания. Кроме того, улучшается показатель PUE. Так, в рамках мероприятия Open Compute Project (OCP) Global Summit компания анонсировала серию «синтетических и несинтетических жидкостей» EM DC 3152/3150/315, 3220, 3235 Super, 3250, 1150 и 1210 (AP). Поскольку дата-центры давно испытывают проблемы в связи с ростом спроса и вычислительной плотности, вопрос использования СЖО, в том числе иммерсионных, становится всё более актуальным. При этом будущее весьма эффективных PFAS-химикатов пока что находится под вопросом. Впрочем, сегодня доступны даже охлаждающие жидкости растительного происхождения, а ExxonMobil предлагает собственные варианты на основе углеводородов. Похожие решения есть у Castrol и Shell. ExxonMobil намеревается расширять добычу ископаемых ресурсов и дальше, несмотря на заявления ООН и прочих структур о вреде такой деятельности для окружающей среды. Вместе с тем компания вкладывает миллионы долларов в исследования, свидетельствующие об отсутствии влияния использования ископаемого топлива на глобальное потепление. Кроме того, ExxonMobil обещает к 2050 году свести к нулю выбросы в атмосферу, связанные с её действиями, параллельно отказываясь нести какую-либо ответственность за последствия использования добытых ей нефти и газа. |

|