Материалы по тегу: цод

|

16.05.2023 [19:10], Руслан Авдеев

Поллитра воды на полсотни вопросов: ИИ-серверы с ChatGPT потребляют не только много энергии, но и немало воды для охлажденияХотя в генеративных ИИ-моделях вроде GPT-4 или Midjourney отдельные эксперты усматривают много угроз человечеству, далеко не все обращают внимание на важный фактор — не исключено, что скоро ИИ и люди будут конкурировать за обычную пресную воду. Как сообщает The Register, по прогнозам учёных, её будет всё больше требоваться для охлаждения ЦОД. Проблема привлекла внимание учёных Калифорнийского университета в Риверсайде и Техасского университета в Арлингтоне. По оценкам исследователей, обучение языковой модели уровня GPT-3 требует использования около 700 тыс. литров воды — столько тратится на выпуск 320 электромобилей Tesla. Более того, на простой диалог из 20-50 вопросов ChatGPT требуется около 500 мл воды, а с развитием ИИ потребление воды такими системами достигнет огромных масштабов — если заранее не принять меры по оптимизации охлаждения ЦОД.

Источник изображения: Drew Dizzy Graham/unsplash.com При этом эксперты обещают, что к середине века огромные территории в США будут страдать от засухи. Уже сейчас ЦОД крайне неохотно делятся информацией о потреблении воды, при этом используя разные системы подсчёта и, как Google, пытаясь скрыть следы в судебном порядке. В результате учёным приходится при расчётах пользоваться преимущественно косвенными данными. Впрочем, утверждается, что можно повсеместно использовать модель, разработанную SPX Cooling Technologies, и это позволит определить, сколько воды уходить на обучение и эксплуатацию языковых моделей. Но, как считают в Dell'Oro Group, проблема на деле не в ИИ — он не испытывает настоящей жажды. В первую очередь речь идёт о рационализации систем терморегулирования. Даже от того, где находится ЦОД с ИИ, может значительно меняться потребление воды. Многие ЦОД используют не жидкостное охлаждение, а другие варианты. Например, в прошлом месяце Microsoft говорит об использовании систем с нулевым водопотреблением в ЦОД Аризоны — но они потребляют больше энергии. Предлагается немало вариантов — от воздушного до водяного или погружного охлаждения, каждый из которых имеют свои преимущества и недостатки. Впрочем, вендоры вроде Submer и LiquidStack предлагают системы иммерсионного охлаждения, обеспечивающие PUE на уровне менее 1,05, тогда как системы воздушного охлаждения обычно обеспечивают лишь 1,4–1,5.

Источник изображения: redcharlie | @redcharlie1/unsplash.com В научной работе приводятся не только возможные пути оптимизации систем охлаждения, но и рекомендации для того, чтобы ЦОД в принципе выделяли меньше тепла. В частности, речь идёт о том, что дата-центры стоит строить в местах с прохладным климатом вместо жарких азиатских стран, а некоторые задачи можно выполнять во второй половине дня, когда становится прохладнее. Хотя это ограничивает использование солнечных элементов питания, сам собой напрашивается вывод о применении резервных аккумуляторных источников вместо генераторов для накопления энергии днём. Учёные считают, что залогом эффективного использования энергетических систем и охлаждения является большая прозрачность деятельности ЦОД. В Европе, например, пересматривают поправки к Директиве об энергоэффективности, которые заставят отчитываться по многим параметрам всё ЦОД кроме самых мелких. Как заявил один из учёных, «индустрия ЦОД столь скрытна, что иногда трудно получить подходящие данные для построения моделей». Впрочем, учёные опасаются, что у гиперскейлеров может не хватить времени на внедрение качественной отчётности — индустрия ИИ развивается чересчур быстро.

16.05.2023 [13:18], Сергей Карасёв

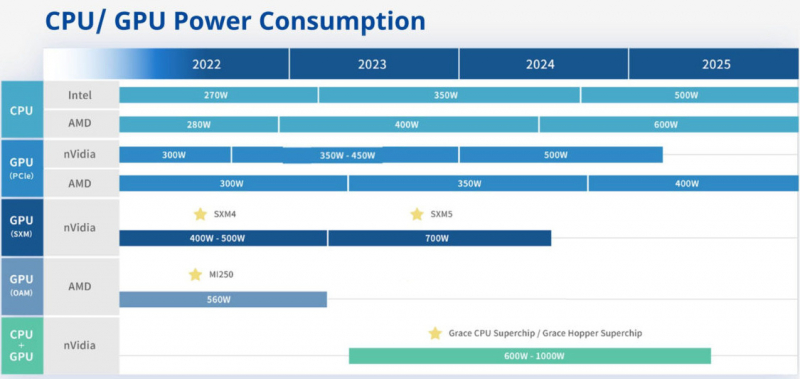

Giga Computing выпустит ЦОД-платформы на базе CPU/GPU с мощностью до 1000 ВтВ распоряжении сетевых источников, по сообщению ресурса VideoCardz, оказалась информация о планах компании Giga Computing (серверное подразделение Gigabyte) по развитию аппаратных платформ для дата-центров на ближайшие несколько лет — вплоть до 2025 года. Судя по обнародованному слайду, Giga Computing в течение нынешнего года и большей части 2024-го будет применять процессоры Intel Xeon поколений Sapphire Rapids-SP/Emerald Rapids-SP с показателем TDP до 350 Вт. К концу 2024 года появятся чипыGranite Rapids, энергопотребление которых будет достигать 500 Вт. Что касается CPU разработки AMD, то в 2023-м компания будет использовать решения с TDP до 400 Вт, а во второй половине следующего года перейдёт на чипы с архитектурой Zen 5 и TDP до 600 Вт. В сегменте GPU энергопотребление ускорителей NVIDIA с интерфейсом PCIe возрастёт с 350–450 Вт в текущем году до 500 Вт в 2024-м. В случае GPU-решений AMD показатель TDP поднимется с 350 Вт до 400 Вт во второй половине 2024-го и 2025 году. Кроме того, Giga Computing намерена взять на вооружение изделия NVIDIA SXM5 с энергопотреблением до 700 Вт. В случае связки CPU+GPU упомянуты такие продукты, как Grace и Grace Hopper с величиной TDP в диапазоне 600–1000 Вт. Они будут применяться в серверах Giga Computing в 2023–2025 гг.

16.05.2023 [09:04], Сергей Карасёв

NTT потратит на развитие инфраструктуры ЦОД более $10 млрд в течение пяти летЯпонская телекоммуникационная корпорация Nippon Telegraph and Telephone (NTT), по сообщению ресурса Datacenter Dynamics, планирует на протяжении пяти лет инвестировать 8 трлн иен (приблизительно $59 млрд) в развитие перспективных направлений. В их числе названы дата-центры, ИИ-платформы и пр. Отмечается, что из указанной суммы не менее 1,5 трлн иен (около $11 млрд) пойдут на расширение или модернизацию инфраструктуры ЦОД. Цифровой бизнес, в который входят ИИ-решения и роботизированные системы, получит на развитие 3 трлн иен ($22 млрд). По оценкам самой NTT, указанные инвестиции позволят в финансовом году, который завершится в марте 2028-го, повысить показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) примерно на 20 % по сравнению с предыдущим финансовым годом. Это означает прибыль на уровне 4 трлн иен (приблизительно $29,4 млрд).

Источник изображения: NTT Сообщается, что в июне текущего года NTT сформирует новую компанию для коммерциализации своей технологии Innovative Optical and Wireless Network (IOWN). Концепция IOWN базируется на использовании оптических коммуникаций, что позволит повысить пропускную способность сетей, уменьшить задержки и энергопотребление. В целом, как ожидается, планируемые вложения помогут NTT укрепить положение на рынке и значительно улучшить финансовые показатели деятельности.

15.05.2023 [13:19], Сергей Карасёв

Первый дата-центр с хранилищем данных на ДНК может появиться в течение 5–10 летГруппа исследователей из Технического университета Эйндховена (Нидерланды) предложила новую технологию хранения информации при помощи ДНК. Предполагается, что результаты работы приведут к появлению дата-центров нового поколения, обладающих сверхвысокой плотностью записи данных и занимающих при этом небольшую площадь. Развёртывание таких ЦОД может начаться в течение пяти–десяти лет. Идея использования нитей ДНК для хранения данных возникла в 1980-х годах, но в то время практическая реализация была слишком дорогой и сложной. Технически это стало возможным три десятилетия спустя, когда синтез ДНК начал набирать обороты.

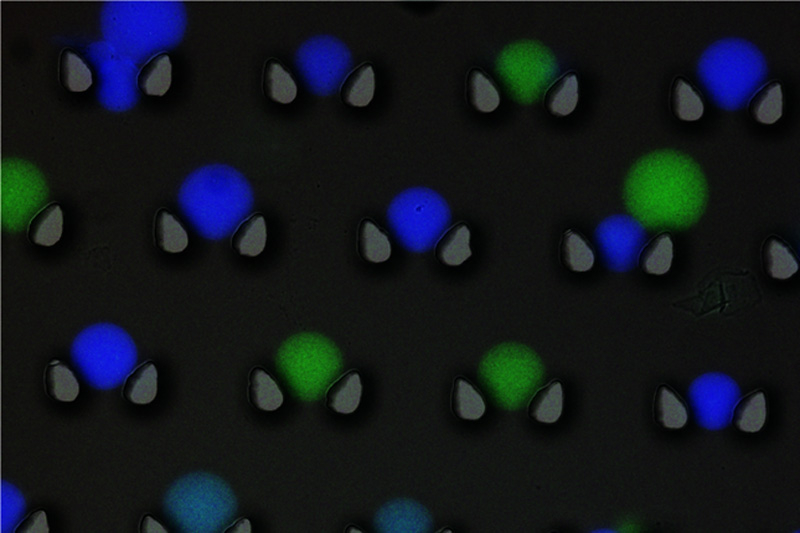

Капсулы с флуоресцентными метками. Источник изображения: Технический университет Эйндховена Рассматриваемый принцип теоретически позволяет хранить огромные массивы информации в компактных устройствах. К примеру, до 215 Пбайт данных можно упаковать в решение размером с обувную коробку. В перспективе плотность записи можно удвоить. Ещё одно преимущество подхода — долговечность: ДНК при правильных условиях потенциально может сохраняться в течение миллионов лет. Наконец, для обслуживания таких систем требуется гораздо меньше энергии, что крайне важно в случае крупных дата-центров. Однако есть сложности: запись данных в ДНК и их считывание — кропотливые и дорогостоящие процессы, которые могут повредить саму ДНК и привести к ошибкам. Новое исследование позволяет частично решить проблемы. В настоящее время получение данных из ДНК осуществляется с помощью полимеразной цепной реакцией (ПЦР). Нити ДНК, содержащие информацию, свободно плавают в своего рода «супе». Для получения определённого файла подаётся праймер, инициирующий ПЦР. После этого ДНК копируется миллионы раз, чтобы система могла найти её и считать информацию. Однако этот процесс ухудшает исходные данные при каждом считывании; кроме того, крайне сложно получить сразу несколько файлов. Чтобы обойти эту проблему, исследователи заключают ДНК в микрокапсулы, состоящие из белков и полимера — в каждой такой капсуле находится один файл. При нагревании выше 50 °C капсулы запечатываются: это означает, что качество исходного файла не ухудшается при каждом чтении, что значительно снижает количество ошибок. Более того, учёные говорят, что система смогла считывать до 25 файлов одновременно. Чтобы упростить поиск, специалисты присвоили каждому файлу флуоресцентную метку, а каждой капсуле — свой цвет, что позволяет классифицировать, разделять и сортировать данные.

15.05.2023 [09:40], Сергей Карасёв

VK развернёт сеть дата-центров в Москве и Санкт-ПетербургеКомпания VK, по сообщению газеты «Ведомости», намерена создать собственную сеть ЦОД в Москве и Санкт-Петербурге. По имеющейся информации, VK уже завершает процедуру покупки земельных участков для строительства объектов. Известно, что в состав сети войдёт дата-центр «Пахра» в Домодедово: открытие этой площадки запланировано на IV квартал текущего года. Кроме того, в Московском регионе разместятся ещё два ЦОД компании. В Санкт-Петербурге VK развернёт облачную инфраструктуру. Ввод новых комплексов в эксплуатацию начнётся в 2025 году. В настоящее время VK использует мощности двух собственных дата-центров в Санкт-Петербурге и Москве на 1200 стоек в общей сумме, а также арендует ресурсы у сторонних провайдеров. По оценкам участников рынка, стоимость аренды одной серверной стойки может обходиться компании в 85–100 тыс. руб. в месяц, а всего арендуется около 3000 стоек. Таким образом, ежегодные затраты достигают 3,0–3,6 млрд руб. Создание сети собственных ЦОД поможет VK уменьшить эти расходы и переложить их в капитальные затраты на строительство своих вычислительных мощностей.

Источник изображения: vk.com Эксперты полагают, что с учётом растущего трафика и постоянно увеличивающихся нагрузок компании VK в течение ближайших пяти лет потребуется строительство дата-центров суммарной ёмкостью около 4000–4500 стоек. На реализацию такого масштабного проекта, по различным данным, может уйти от 20 млрд до 40 млрд руб. Столь значительная разница в оценках обусловлена несколькими факторами. Прежде всего растёт цена оборудования из-за ухода из России зарубежных поставщиков в сложившейся геополитической обстановке. Кроме того, необходимо учитывать стоимость земли, электроснабжения и замены оборудования в процессе эксплуатации. Участники рынка отмечают, что собственные ЦОД необходимы VK для хранения трафика российских пользователей в соответствии с «пакетом Яровой». На базе таких площадок компания сможет разворачивать CDN-сеть, развивать контентные и облачные сервисы.

12.05.2023 [21:44], Руслан Авдеев

В Германии появится ЦОД, напечатанный на 3D-принтере с использованием экологичного бетонаВ немецком Гейдельберге началось строительство дата-центра для оператора Heidelberg iT Management. Как сообщает DataCenter Dynamics, здание печатается на 3D-принтере с помощью перерабатываемых строительных материалов. По данным заказчика, это будет «самое большое строение в Европе, напечатанное на 3D-принтере». Эксплуатация ЦОД начнётся до конца текущего года. На строение уйдёт около 450 т специального, на 100 % пригодного к переработке бетона. При этом связующее вещество, предположительно, обеспечит на 55 % меньший выброс CO2 в сравнении с цементом. Отделкой стен займётся специальный робот-маляр.

Источник изображения: Kraus Group Площадь ЦОД Baufeld 5 составит менее 600 м2. Хотя непосредственно на печать принтеру Cobod BOD2 3D понадобится всего 140 часов, есть и другие работы. Строительство началось ещё в марте, а закончится в июле текущего года, после чего начнётся отделка помещений. Новый ЦОД, по имеющимся данным, станет для Heidelberg iT Management четвёртым в Гейдельберге. 3D-печать зданий практикуется в мире довольно давно, в том числе и центров обработки данных. Так, известно, что американская EdgeCloudLink (ECL) намерена выпускать модульные ЦОД с питанием от водородных генераторов, строительство которых тоже будет выполняться с помощью технологий 3D-печати.

12.05.2023 [15:05], Сергей Карасёв

Для HPC и ИИ: Digital Realty внедрила в своём парижском ЦОД систему прямого жидкостного охлаждения для мощных серверовКомпания Digital Realty развернула в своём дата-центре PAR8 в Ла-Курнёве (находится в 10 км к северу от Парижа) систему прямого жидкостного охлаждения (DLC). Применённое решение снижает эксплуатационные расходы, сокращает энергопотребление и выбросы углерода в атмосферу. По заявлениям Digital Realty, внедрённая технология позволяет клиентам использовать приложения, для которых требуются большие вычислительные ресурсы, в среде, оптимизированной для повышения энергоэффективности. Компания не назвала поставщика DLC-системы, но сообщила, что охлаждение является замкнутым. Парижский дата-центр Digital Realty разработан таким образом, чтобы его можно было адаптировать к меняющимся потребностям клиентов. ЦОД ориентирован прежде всего на выполнение НРС-задач. Утверждается, что благодаря применению концепции DLC клиенты ощутят снижение затрат на обработку данных по сравнению с традиционными методами воздушного охлаждения.

Источник изображения: Digital Realty ЦОД Digital Realty PAR8 имеет общую площадь объектов приблизительно 26 000 м2. Суммарная мощность достигает 19,2 МВт. Это первый из четырех дата-центров в планируемом Парижском цифровом парке (Paris Digital Park), который предложит 40 000 м2 полезных площадей и до 85 МВт мощности.

12.05.2023 [14:27], Сергей Карасёв

Kao Data построит в Великобритании экологичный 40-МВт ЦОД специально для нагрузок HPC и ИИБританская компания Kao Data, специализирующаяся на HPC-платформах и облачных сервисах, объявила о планах по строительству крупного дата-центра в Манчестере. Этот ЦОД обеспечит мощность до 40 МВт, а начало его коммерческой эксплуатации запланировано на 2025 год. Для строительства дата-центра выбрана бывшая промышленная зона в Кенвуд-Пойнт площадью приблизительно 39 тыс. м2. На территории комплекса расположатся девять залов для оборудования. Инвестиции в проект оцениваются в £350 млн, или приблизительно $440 млн. Предполагается, что объект получит сертификацию OCP Ready и NVIDIA DGX Ready. Площадка предоставит эффективную инфраструктуру для НРС-задач и проектов в области ИИ. Коэффициент PUE нового ЦОД заявлен на уровне 1,2. Питание дата-центр будет на 100 % получать от возобновляемых источников. Для резервных генераторов планируется применение гидрированного растительного масла (HVO) вместо традиционного дизельного топлива. Кроме того, при проектировании ЦОД учитывается возможность утилизации выделяемого тепла.

Источник изображения: Kao Data Дата-центр в Манчестере станет первой площадкой Kao Data уровня Tier II в Европе. «Мы считаем, что наш объект установит новый стандарт для устойчивых дата-центров в регионе и обеспечит часть базовой инфраструктуры, которая поддерживает как передовые вычислительные кластеры Северной Англии, так и стремление правительства Великобритании стать технологическим и экономическим центром НРС и ИИ», — заявляет Kao Data.

11.05.2023 [20:02], Руслан Авдеев

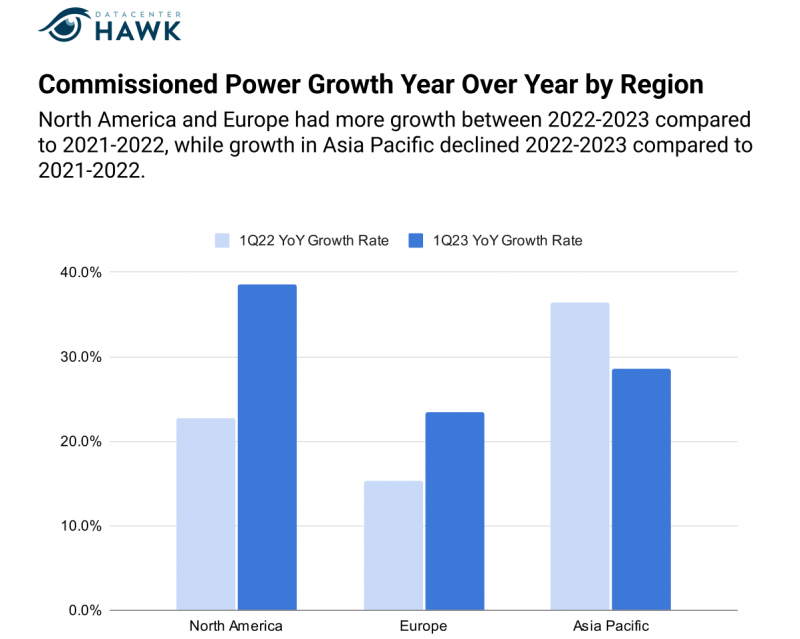

В североамериканских ЦОД заканчиваются места — виноваты гиперскейлеры и дефицит ресурсовНа североамериканском рынке сложилась необычная ситуация — компании, желающие заполучить колокейшн-мощности, столкнулись с тем, что их либо нет совсем, либо за них придётся платить намного больше, чем обычно. По данным Network World, растущие аппетиты гиперскейлеров ставят под вопрос возможность доступа к необходимой инфраструктуре для всех участников рынка. Как сообщают эксперты datacenterHawk, на долю гиперскейлеров приходится уже 80 % арендуемых в североамериканских ЦОД мощностей. Особенную активность большие игроки демонстрировали в прошлом и позапрошлом годах, забирая почти все доступные мощности. По мнению экспертов, хотя темпы роста на североамериканском рынке замедлились, спрос на мощности ЦОД остаётся рекордным, поскольку на основных региональных рынках свободны лишь 2,88 % мощностей, на вторичных рынках — 5 %. Другими словами, свободных мест в ЦОД, особенно на крупных рынках вроде Северной Вирджинии или штата Вашингтон, почти не осталось. Если пару лет назад на рынке имелось до 10 провайдеров, способных предоставить до 4 МВт ёмкости, то теперь таковых не более четырёх, а цены выросли на 5–20 %. Причём мощности часто полностью забронированы гиперскейлерами, что не оставляет возможностей более мелким компаниям. Операторы не могут удовлетворить спрос, и вряд ли свободные ёмкости вскоре появятся. Одна только Серверная Вирджиния обгоняет по ёмкости сверхкрупных дата-центров Европу и Китай. Хотя операторы работают над расширением своей инфраструктуры, ключевые компоненты — землю, энергию и финансирование — в последние два года становится всё труднее получить, так что темпы строительства падают, а его стоимость — растёт. Эксперты предрекают сохранение такого положения в ближайшие 3–5 лет. Многим компаниям приходится просто оптимизировать свои нагрузки или уменьшать их. Теперь операторы ищут необходимые ресурсы для развёртывания ЦОД за пределами крупных агломераций и даже вне США — индустрия ЦОД в Латинской Америке переживает стремительное развитие. Во многом это обусловлено прогнозируемым постпандемийным ростом внедрения передовых технологий на континенте, что приведёт и к росту спроса на колокейшн-сервисы в Мексике, Бразилии, Чили и Колумбии в следующее десятилетие. При этом страны вроде Мексики будут не только сами потреблять новые мощности, но и, вероятно, обслуживать близлежащие государства.

11.05.2023 [15:55], Сергей Карасёв

Парижский ЦОД Google Cloud почти три недели не мог справиться с последствиями затопленияЧасть сервисов Google Cloud Platform региона europe-west9-a, по сообщению The Register, остаются недоступными уже третью неделю. Причина — затопление и пожар в парижском ЦОД Global Switch. О сроках полного восстановления работоспособности облачных служб информации по-прежнему нет. Сейчас компания готовит отчёт об инциденте. Инцидент, о котором идёт речь, произошёл 25 апреля нынешнего года. Из-за поломки насоса охлаждающей системы произошла протечка воды в аккумуляторном зале одного из двух дата-центров на территории парижского кампуса Global Switch. Это спровоцировало возгорание батарей и последующее отключение облачных сервисов. Отмечается, что возгорание аккумуляторных блоков сопровождалось очень высокими температурами, а поэтому пожарные не могли приступить к тушению в течение нескольких часов.

Источник изображения: Google На устранение последствий подобных инцидентов требуется много времени. Кроме того, необходимо заменить вышедшее из строя оборудование и восстановить работоспособность подсистемы резервного питания от батарей. Затопление нанесло наибольший ущерб зоне europe-west9-a — одной из трёх в парижском регионе. Более того, в минувшие выходные в течение приблизительно пяти часов наблюдались неполадки в работе сервисов Google Cloud в зоне europe-west9-c. В течение последнего времени пожары охватили сразу несколько крупных ЦОД. Так, в марте 2021 года пожар уничтожил дата-центр французской компании OVHcloud в Страсбурге: в результате этого ЧП оказались недоступны в общей сложности 3,6 млн веб-сайтов. Возгорание также произошло в ЦОД иранской Telecommunication Infrastructure Company (TIC). Затем пожар привёл к самому масштабному в мире сбою ЦОД: в результате инцидента произошёл массовый сбой в работе мессенджера KakaoTalk. |

|