Материалы по тегу: энергоэффективность

|

07.04.2023 [20:36], Сергей Карасёв

Google заявила, что её ИИ-кластеры на базе TPU v4 и оптических коммутаторов эффективнее кластеров на базе NVIDIA A100 и InfiniBandКомпания Google обнародовала новую информацию о своей облачной суперкомпьютерной платформе Cloud TPU v4, предназначенной для решения задач ИИ и машинного обучения с высокой эффективностью. Система может использоваться в том числе для работы с крупномасштабными языковыми моделями (LLM). Один кластер Cloud TPU Pod содержит 4096 чипов TPUv4, соединённых между собой через оптические коммутаторы (OCS). По словам Google, решение OCS быстрее, дешевле и потребляют меньше энергии по сравнению с InfiniBand. Google также утверждает, что в составе её платформы на OCS приходится менее 5 % от общей стоимости. Причём данная технология даёт возможность динамически менять топологию для улучшения масштабируемости, доступности, безопасности и производительности. Отмечается, что платформа Cloud TPU v4 в 1,2–1,7 раза производительнее и расходует в 1,3–1,9 раза меньше энергии, чем платформы на базе NVIDIA A100 в системах аналогичного размера. Правда, пока компания не сравнивала TPU v4 с более новыми ускорителями NVIDIA H100 из-за их ограниченной доступности и 4-нм архитектуры (по сравнению с 7-нм у TPU v4). Благодаря ключевым инновациям в области интерконнекта и специализированных ускорителей (DSA, Domain Specific Accelerator) платформа Google Cloud TPU v4 обеспечивает почти 10-кратный прирост в масштабировании производительности по сравнению с TPU v3. Это также позволяет повысить энергоэффективность примерно в 2–3 раза по сравнению с современными DSA ML и сократить углеродный след примерно в 20 раз по сравнению с обычными дата-центрами.

28.07.2022 [18:12], Руслан Авдеев

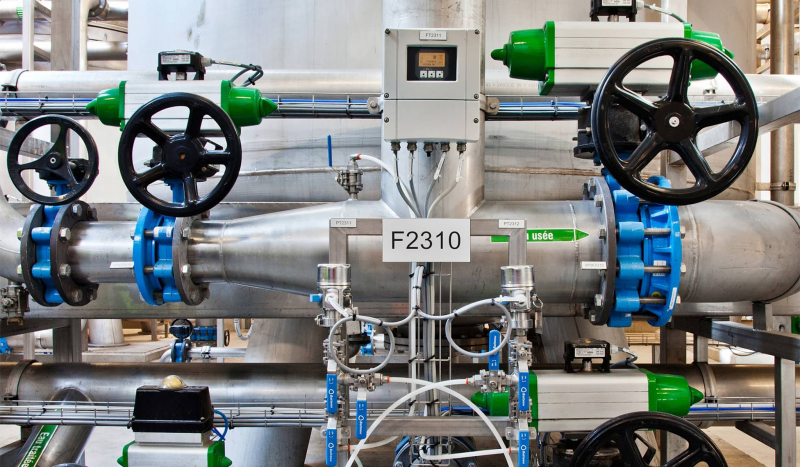

Европейские дата-центры хотят снизить потребление воды до 400 мл/кВт·ч, но только к 2040 годуГруппа Climate Neutral Data Centre Pact (CNDCP), объединяющая 90 % европейских операторов ЦОД, предложила добровольно снизить потребление воды до 400 мл на 1 кВт·ч к 2040 году и добиться углеродной нейтральности намного раньше 2050 года. Соответствующая цель уже поставлена ЕС, но операторы намерены добиваться её без законодательного принуждения и с опережением графика, — сообщает Data Center Dynamics. Хотя использование воды способно оказать значительное влияние на экологию, этот фактор часто недооценивают, учитывая только расход энергии. При этом многие ЦОД активно используют воду для охлаждения оборудования, благодаря чему снижается расход всё той же энергии, но растут затраты самой жидкости, что имеет критическое значение для некоторых регионов. Группу CNDCP сформировали в 2021 году с намерением достичь углеродной нейтральности европейских ЦОД к 2030 году, а также обеспечить достойный ответ прочим экологическим вызовам, в том числе снизить расход воды. Для оценки эффективности использования воды используется коэффициент WUE, который отражает расход воды на каждый затраченный киловатт·час электричества. Например, исследование 2016 года показало, что на тот момент WUE для ЦОД в США составлял в среднем 1,8 л/кВт·ч.

Источник изображения: Christian Lue/unsplash.com Цели поставлены с учётом жизненного цикла уже действующих систем охлаждения, поскольку их немедленная массовая замена может принести больше вреда, чем пользы из-за ущерба экологии в процессе производства самих систем. Поэтому в CNDCP заявили, что все 74 оператора ЦОД, участвовавшие в заключении пакта, добьются потребления не более 400 мл/кВт·ч только к 2040 году. Такой показатель вывели с учётом разницы технологий, климатических и иных условий, характерных для тех или иных ЦОД. Отдельные участники рынка уже заявили о намерении добиться положительного водного баланса для своих дата-центров — ЦОД будут отдавать больше чистой воды, чем потреблять. Так, Meta✴ и Microsoft планируют добиться этой цели к 2030 году. Последняя также начала устанавливать станции для очистки сточных вод ЦОД. А вот Google отметилась тем, что пыталась всеми возможными способами скрыть расход воды своими дата-центрами даже от властей. Помимо ограничения расхода воды, подписанты CNDCP предложили ввести и другие цели для дата-центров. Например, уже сформированы две рабочие группы для подготовки к переходу на «циркулярную экономику» со вторичным использованием материалов и переработкой различных ресурсов. В частном порядке аналогичную инициативу уже несколько лет развивает Microsoft в рамках проекта Circular Center.

07.12.2016 [14:50], Андрей Крупин

Видео: как работает дата-центр «Яндекса» в ФинляндииКомпания «Яндекс» разместила на своей странице видеохостинга YouTube ролик, рассказывающий об особенностях работы самого энергоэффективного центра обработки данных (ЦОД) российского интернет-гиганта, расположенного в городе Мянтсяля в шестидесяти километрах от Хельсинки (Финляндия). Финский центр обработки данных «Яндекса» является одиннадцатым по счёту ЦОД компании и первым, созданным в соответствие с концепцией GreenField, предполагающей проектирование и строительство здания под дата-центр «с нуля». Площадь вычислительного комплекса составляет 3400 кв. м, его проектная мощность достигает 40 МВт. Объект подключён к двум независимым магистральным источникам электроэнергии по 110 киловольт каждый. Для резервирования энерговводов предусмотрено резервное питание от семи установок DRUPS, за счёт кинетической энергии вращающихся барабанов обеспечивающих автономную работу систем дата-центра на момент запуска дизель-генераторных источников бесперебойного питания. Особенностью дата-центра «Яндекса» в Финляндии является система охлаждения, функционирующая по принципу Free Cooling (для охлаждения оборудования применяется наружный воздух) и позволяющая использовать тепло от серверов в полезных целях — для отопления жилых домов Мянтсяля. Серверы финского ЦОД «Яндекса» охлаждаются уличным воздухом, который впоследствии нагнетается в теплообменники, а те, в свою очередь, нагревают воду до 30-45 градусов. После этого станция донагрева увеличивает температуру воды до 55-60 градусов, которая затем поступает в городскую сеть. Такое сотрудничество с городом позволяет «Яндексу» экономить до трети расходов на электроэнергию, потребляемую дата-центром. «Яндекс» намерен и впредь совершенствовать систему охлаждения серверов уличным воздухом. Задействованные в финском ЦОД энергоэффективные технологии и инновационные решения компания планирует использовать в строящемся во Владимире центре обработки данных. Запуск нового дата-центра ожидается в первом квартале 2017 года. |

|