Hewlett Packard Enterprise (HPE) и NVIDIA представили платформу NVIDIA AI Computing by HPE — портфель совместно разработанных решений для ускорения внедрения генеративного ИИ.

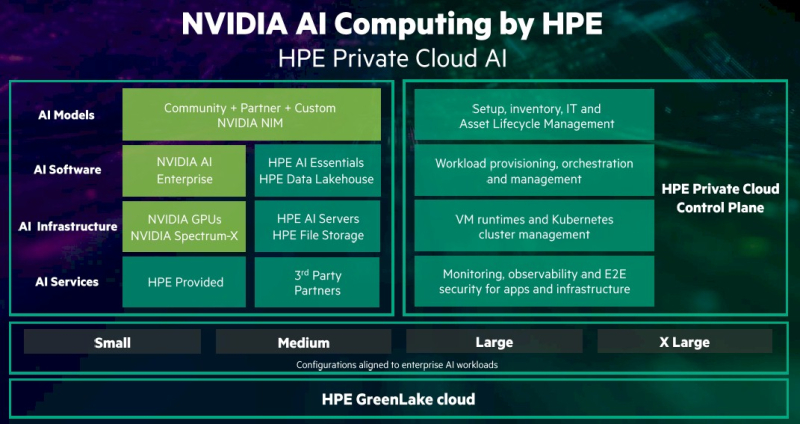

Ключевым в портфеле является предложение HPE Private Cloud AI. Как указано в пресс-релизе, это первое в своём роде комплексное решение, которое обеспечивает самую глубокую на сегодняшний день интеграцию вычислительных технологий, сетей и ПО NVIDIA с хранилищем, вычислительными ресурсами и облачной платформой HPE GreenLake. Решение предоставляет предприятиям любого размера возможность быстрой и эффективной разработки и развёртывания приложений генеративного ИИ.

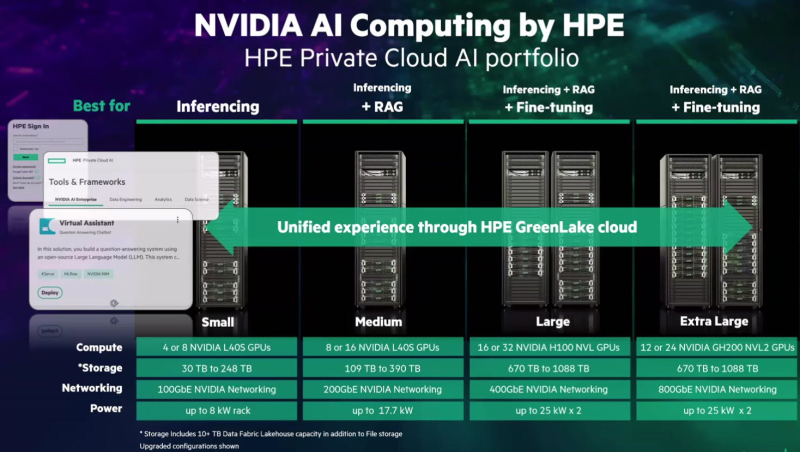

Решение HPE Private Cloud AI с новой функцией OpsRamp AI Copilot, которая позволяет повысить эффективность ИТ-операций и обработки рабочих нагрузок, включает в себя облачную среду самообслуживания с полным управлением жизненным циклом. Оно доступно в четырёх конфигурациях (Small, Medium, Large и Extra Large) для поддержки рабочих нагрузок ИИ различной сложности.

HPE Private Cloud AI также поддерживает инференс, точную настройку моделей и их дообучение посредством RAG с использованием собственных данных. Решение сочетает в себе средства контроля конфиденциальности, безопасности, прозрачности и управления данными, в том числе средства ITOps и AIOps. AIOps использует машинное обучение и анализ данных для автоматизации и улучшения ИТ-операций. ITOps включает в себя ряд инструментов, обеспечивающих бесперебойное функционирование ИТ-инфраструктуры организации.

Конфигурация HPE Private Cloud AI Small, предназначенная для инференса, включает от четырёх до восьми ускорителей NVIDIA L40S, до 248 Тбайт дискового пространства и 100GbE-подключение в стойке мощностью 8 кВт. Конфигурация Medium, предназначенная для инференса и RAG, включает до 16 ускорителей NVIDIA L40S, до 390 Тбайт дискового пространства и 200GbE-подключение в стойке мощностью 17,7 кВт.

Конфигурации Large и Extra Large предлагают дополнительные возможности по обработке нагрузок ИИ и ML, а также тонкой настройке ИИ-модели. Конфигурация Large включает до 32 ускорителей NVIDIA H100 NVL, до 1,1 Пбайта дискового пространства и 400GbE-интерконнект в двух стойках мощностью 25 кВт каждая. В свою очередь, конфигурация Extra Large включает до 24 ускорителей NVIDIA GH200 NVL2, до 1,1 Пбайта дискового пространства и 800GbE-интeрконнект в двух стойках мощностью 25 кВт каждая.

Стойки могут управляться клиентом самостоятельно или обслуживаться HPE. Каждая конфигурация может работать как автономное локальное решение ИИ или в составе гибридного облака. Используется программная платформа NVIDIA AI Enterprise, включающая микросервисы инференса NIM. Её дополняет ПО HPE AI Essentials.

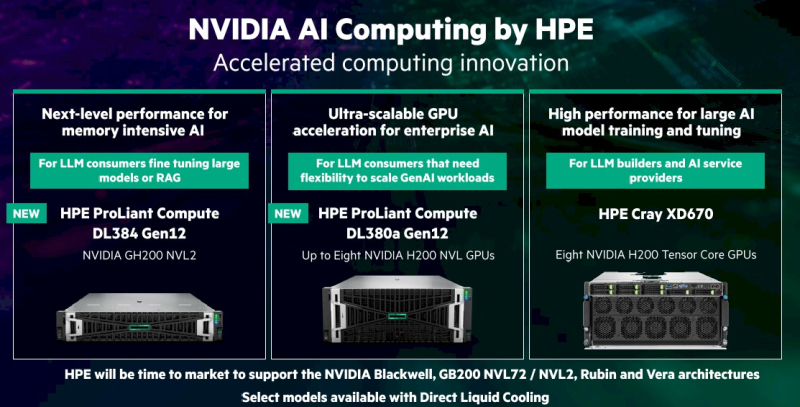

Кроме того, поддержку новых ускорителей NVIDIA получили три аппаратные платформы:

- базовая модель HPE ProLiant Compute DL384 Gen12 с NVIDIA GH200 NVL2 предназначена для заказчиков, использующих достаточно крупные ИИ-модели или RAG.

- сервер среднего уровня HPE ProLiant DL380a Gen12 включает до восьми ускорителей NVIDIA H200 NVL и подходит тем, кому нужна гибкость в масштабировании рабочих нагрузок генеративного ИИ;

- топовая модель HPE Cray XD670 с узлами на базе восьми ускорителей NVIDIA H200 NVL называется идеальной для разработки LLM.

HPE также объявила, что её облачная платформа HPE GreenLake for File Storage прошла сертификацию Nvidia DGX BasePOD и валидацию хранилища NVIDIA OVX, HPE Private Cloud AI, а также анонсированное оборудование будут доступны этой осенью за исключением платформы Cray XD670 на базе NVIDIA H200 NVL, который поступит в продажу этим летом. А после станут доступны и решения на базе Blackwell.

Источник: