TrendForce отметила в своём новом исследовании, что в связи с резким ростом популярности приложений генеративного ИИ ведущие провайдеры облачных решений, включая Microsoft, Google, AWS, а также китайские технологические гиганты, такие как Baidu и ByteDance, значительно увеличили приобретение ИИ-серверов, необходимых для обучения и оптимизации ИИ-моделей.

Ажиотаж вокруг генеративного ИИ стал стимулом для разработки более мощных ИИ-серверов и роста этого сегмента рынка. Как полагают аналитики TrendForce, производители будут расширять использование в ИИ-системах передовых технологий, применяя мощные ускорители вычислений и высокопроизводительную память HBM в сочетании с современными методами упаковки чипов. Согласно прогнозу TrendForce, в течение 2023–2024 гг. вырастет спрос на HBM, а также на 30–40 % увеличатся мощности для выпуска чипов с использованием передовых методов упаковки.

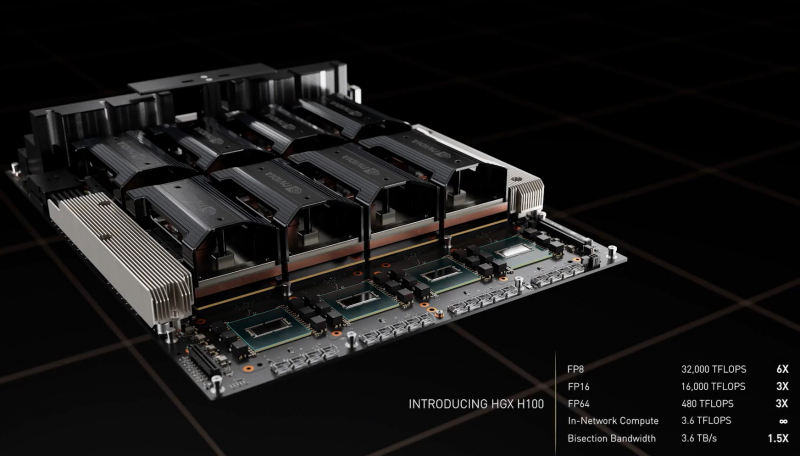

TrendForce отметила, что для повышения вычислительной эффективности ИИ-серверов и увеличения пропускной способности памяти ведущие производители ИИ-микросхем, включая NVIDIA, AMD и Intel, наращивают использование HBM. В настоящее время у чипов NVIDIA A100/H100 имеется 80 Гбайт памяти HBM2e/HBM3. В суперчипе GH200 Grace Hopper используется ускоритель NVIDIA H100 с 96 Гбайт памяти HBM3.

В чипах серии AMD Instinct MI300 тоже используется память HBM3: у версии MI300A её ёмкость составляет 128 Гбайт, а у более продвинутой версии MI300X — 192 Гбайт. Также ожидается, что Google в рамках расширения ИИ-инфраструктуры начнёт в конце 2023 года в партнёрстве с Broadcom производство обновлённых тензорных чипов TPU, тоже с использованием памяти HBM.

Согласно прогнозу TrendForce, в 2023 году будет выпущено ИИ-ускорителей с общим объёмом памяти HBM в пределах 290 млн Гбайт, что означает рост год к году на 60 %. В 2024 рост объёмов выпуска памяти HBM составит 30 % или более. Также будет расти спрос на передовые технологии упаковки чипов для сферы ИИ и высокопроизводительных вычислений (HPC). При этом преобладающим методом для ИИ-чипов будет Chip on Wafer on Substrate (CoWoS) от TSMC, позволяющий разместить на одной подложке до 12 стеков памяти HBM.

По оценкам TrendForce, с начала 2023 года спрос на CoWoS вырос почти на 50 % на фоне роста популярности ускорителей NVIDIA A100 и H100. Ожидается, что к концу года ежемесячный выпуск TSMC чипов с применением CoWoS вырастет до 12 тыс. Во второй половине 2023 года возможности заказа выпуска чипов с применением CoWoS будут ограничены в связи с растущим спросом на ИИ-чипы со стороны AMD, Google и других компаний.

Высокий спрос на использование CoWoS сохранится до 2024 года с прогнозируемым ростом производственных мощностей по упаковке этим методом на 30–40 % с учётом готовности соответствующего оборудования. Аналитики TrendForce не исключают возможности использования NVIDIA альтернативных технологий упаковки для производства ускорителей в случае сохранения высокого спроса на системы ИИ. Речь идёт о разработках компаний Samsung и Amkor.

Источник: