Материалы по тегу: llm

|

22.08.2023 [20:39], Алексей Степин

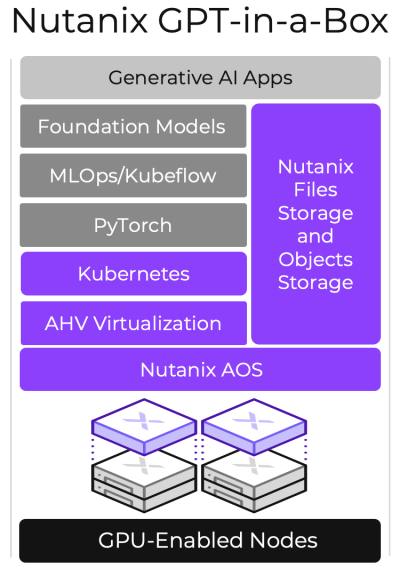

ИИ-из-коробки: Nutanix представила GPT-in-a-Box для быстрого развёртывания LLM-инфраструктурВ эпоху быстрого развития ИИ-систем многие компании интересуются данной темой, в частности, большими языковыми моделями, но они обеспокоены сохранностью и целостностью собственных данных, чего не могут полностью гарантировать облачные сервисы. Специально для таких случаев компания Nutanix, разработчик решений для мультиоблачных и гиперконвергентных инфраструктур, предложила своё решение — платформу GPT-in-a-Box. За этим названием скрывается программно-определяемая ИИ-платформа, базирующаяся на разработках Nutanix, открытых фреймворках, включая PyTorch и KubeFlow, и вычислительных узлах, оснащённых ускорителями NVIDIA. Она позволяет в кратчайшие сроки развернуть защищённую ИИ-среду в ЦОД или на периферии заказчика. Комплекс задействует файловое и объектное хранилище Nutanix Unified Storage, а также Kubernetes-платформу Karbon 2 с пробросом ускорителей. В число поддерживаемых базовых языковых моделей входят Llama2, Falcon LLM и MosaicML, но возможен запуск и других GPT-моделей, а также тонкая подстройка с использованием данных из интегрированного хранилища. При этом GPT-in-a-Box вовсе не требует повышенных затрат, связанных с поддержкой, масштабированием и администрированием. Система функционирует в рамках Nutanix Cloud Platform, которая сертифицирована для NVIDIA AI Enterprise. |

|