Тема искусственного интеллекта оказалась настолько важной, что Intel провела отдельный AI Day (День ИИ) в Сан-Франциско, где представила специализированные ускорители Lake Crest и Knights Crest. Это, впрочем, неудивительно, так как компания утверждает, что 97 % серверных мощностей, занятых работой с ИИ, используют её продукты. Кроме того, Intel рассказала о стратегии дальнейшего развития исследований в этой области, а также заключила несколько соглашений и вступила в альянс с Google. Помимо создания нового «железа», компания также будет заниматься разработкой и поддержкой ПО для работы с ИИ – на сайте появился особый раздел, посвящённый этой теме.

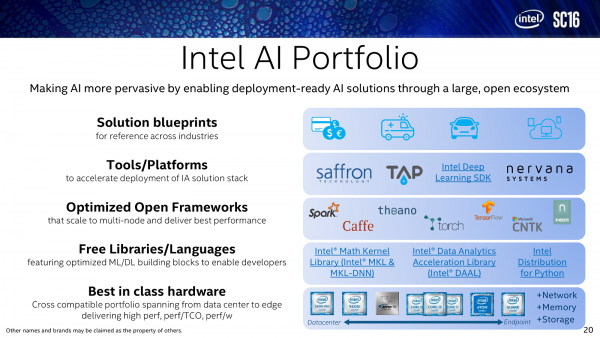

На выставке SC16 в Солт-Лейк-Сити компания рассказала о целом комплексе своего ПО для ИИ и HPC. Под ИИ обычно подразумевается технология глубинного обучения (Deep Learning), то есть, если попытаться описать это кратко, создание многослойных нейросетей, способных обучаться самостоятельно. У Intel для подобных задач есть отдельный SDK, к тому же компания успела на удивление быстро интегрировать купленную в августе этого года платформу Nervana. Да и в целом имеется поддержка других популярных фреймворков и платформ. Были доработаны бесплатные библиотеки Intel Math Kernel Library (MKL) и Intel Data Analytics Acceleration Library (DAAL), причём первая совсем недавно обзавелась новым комплексом функций Deep Neural Networks (MKL-DNN). К концу года должен выйти OpenMP 5, который также будет поддерживаться. Прелесть программной платформы в том, что она позволяет работать со всем тем разнообразием оборудования, что есть у Intel: Xeon и Xeon Phi, FPGA и всё те же решения Nervana/Crest, а заодно и OPA.

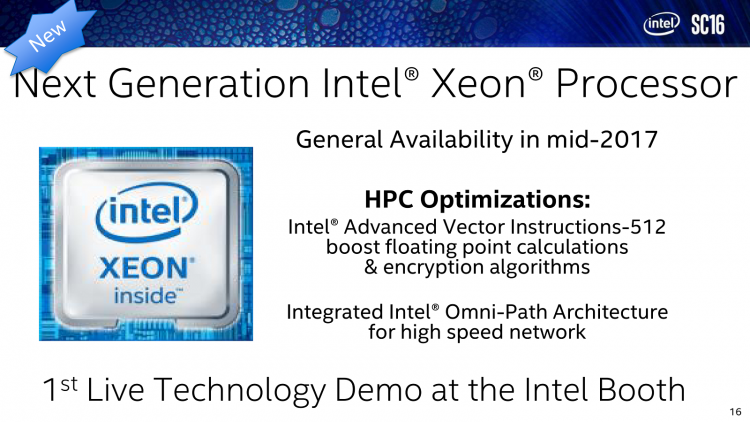

Именно «железных» новинок на SC16 было мало. Самая главная – это, конечно, новая модификация CPU Xeon E5-2699A v4. Штука весьма и весьма специфичная, так как у данной модели незначительно подняли базовую тактовую частоту, а вот цена выросла заметно. Согласно внутренним тестам, данная модель в LINPACK опережает обычную версию без индекса всего на 4,8 %. Впрочем, гораздо интереснее новые Xeon поколения Skylake, которые выйдут в следующем году. На выставке Intel показала шкаф с прототипами этих CPU, оснащёнными адаптерами Omni-Path. Удивительно, что в Китае в частном порядке уже продаются некие «прототипы» Skylake в конструктиве LGA3647. Правда, деталей о них пока всё равно мало. Новинки будут изготавливаться по техпроцессу 14 нм, получат более высокую производительность в операциях с плавающей запятой, а также с шифрованием.

Самое главное – они получат набор инструкций AVX-512 с соответствующей длиной. Вообще говоря, 512 бит – это почти что «сакральное» число для Intel, потому что длина кеш-линии составляет как раз 64 байта, что по идее позволит ещё больше повысить производительность благодаря меньшим накладным расходам при обращении к кеш-памяти. К тому же новые CPU и наборы логики для них получат полноценную поддержку памяти 3D XPoint. Правда, сами накопители 3D X-Point нигде не «засветились». А среди прочих живых демонстраций Intel интересна технология NVMe-over-Fabric, показанная на стенде РСК. Строго говоря, таких машин на выставке было представлено две – вторая была сделана местным ODM-производителем.

С помощью NVMe-over-Fabric организуется прозрачный удалённый доступ к блочным устройствам (в данном случае Intel SSD DC P3700) поверх фабрики Omni-Path. Теоретически данный вариант позволяет достичь скорости обмена данными на уровне 1,8 Гбайт/с с задержкой в районе 20 мс. Фактически NVMe-пакеты напрямую упаковываются в OPA-кадры. Поддержка технологии уже имеется в стабильной версии ядра Linux 4-й ветки, также есть отдельные утилиты для работы с ней. Ну а сама она, очевидно, нужна для быстрого доступа к большим массивам данных внутри кластера. Фактически на каждом узле можно отказаться от локального хранилища и работать только с удалёнными накопителями.

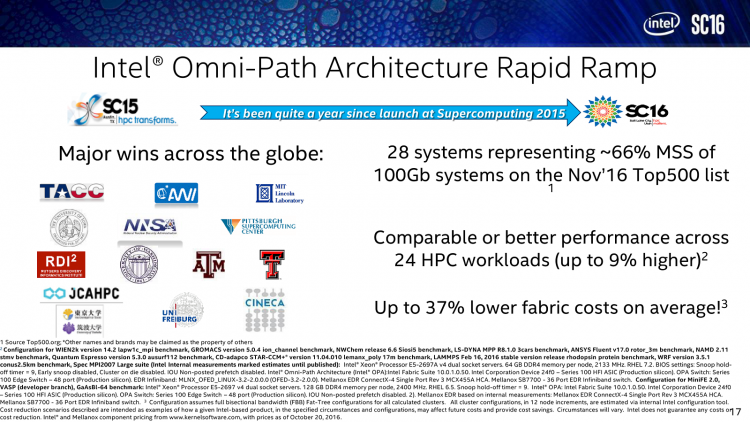

Подробно про Intel Omni-Path мы рассказывали почти год назад. За это время новый интерконнект успел «захватить» немало суперкомпьютеров – им оснащают как новые машины, так и обновляют уже имеющиеся. В свете этих событий весьма любопытно, какие шаги будет предпринимать Mellanox – основной конкурент Intel в области интерконнектов. В частных разговорах предполагались и создание коалиции с другими гигантами рынка, и разработка собственного CPU, и поглощение других компаний или даже продажа самой компании. Впрочем, это пока всего лишь домыслы, а сама Mellanox на выставке представила свой новый, вдвое более быстрый адаптер InifniBand, но это задел на будущее.

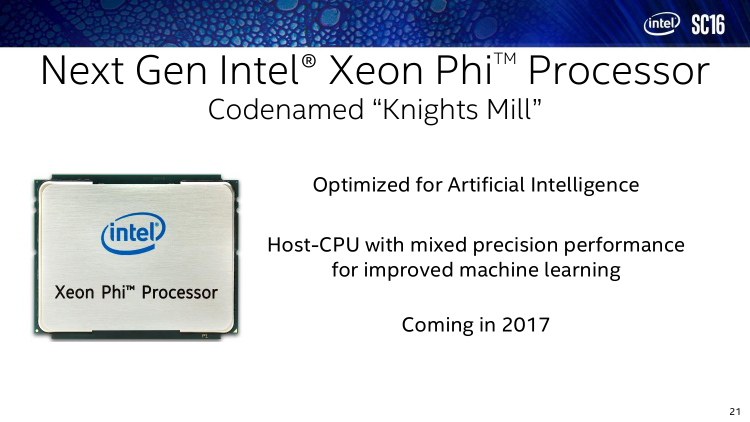

Внедрение Intel Xeon Phi Knights Landing, по словам компании, идёт успешно. Впрочем, в этом можно было убедиться и без слов – практически на всех стендах присутствовали машины с этими ускорителями. А вот про грядущие Xeon Phi Knights Mill ничего нового толком не рассказали. Да, это будут ускорители, ориентированные в первую очередь на ИИ и Deep Learning, которые получат много быстрой локальной памяти типа HBM. Появятся они в 2017 году, как и ещё один продукт для этой же области – PCIe-карта Intel Deep Learning Inference Accelerator (DLIA) с FPGA Intel Arria 10. Процесс программирования и переноса ПО для неё будет облегчён за счёт добавления поддержки карты в распространённые библиотеки и фреймворки.

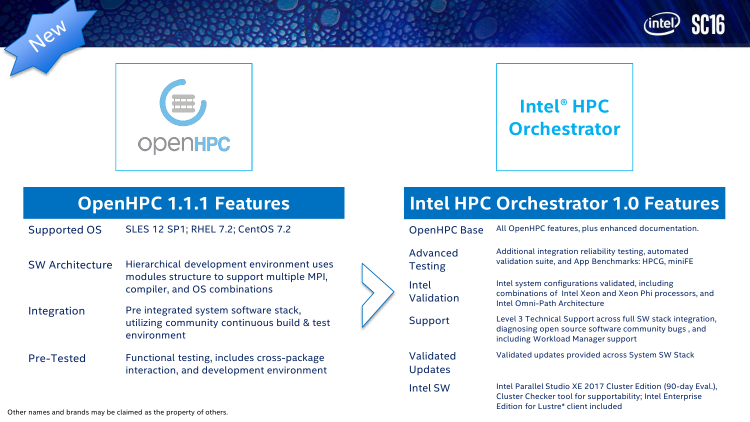

Впрочем, вопросами оптимизации, упрощения написания и исполнения кода для своего «железа», а также управления им Intel и так постоянно занимается – в том числе и трудится над запуском старых бинарных приложений на современных Xeon/Xeon Phi. И вот как раз для контроля над ПО и «железом» предназначена ещё одна новинка Intel на SC16 – HPC Orchestrator. Данный продукт базируется на бесплатной и открытой платформе OpenHPC. Собственно говоря, никто не мешает использовать OpenHPC в чистом виде, однако в случае Orchestrator – за отдельную плату, естественно, – инженеры Intel помогут заказчику правильно сконфигурировать кластер и приложения, которые будут на нём запускаться, что в конечном итоге может значительно сэкономить и время, и деньги.

Заключение

Несмотря на то, что почти все анонсы Intel на SC16 были «бумажными», примерное направление дальнейшего развития продуктов компании понятно и так. Собственно говоря, Intel планомерно расширяет поле своей деятельности в HPC, а в каком-то смысле даже потихоньку монополизирует эту область. К уже имеющимся CPU для, скажем так, «классических» задач и Big Data – ажиотаж вокруг этой темы спал, но сама по себе она никуда не делась и стала скорее обыденной – добавились решения для массивно-параллельной обработки данных. Затем Intel пошла в область интерконнектов (Omni-Path) и быстрых хранилищ (3D X-Point) — и сейчас готова поменять иерархию памяти в целом. Мало? Да, мало. В самом начале говорилось о 97 % серверов с продуктами Intel. Это утверждение верно, но есть один нюанс – никто не говорит, какие именно продукты в них используются. Надо полагать, что это всё-таки обычные Xeon, так как и нагрузка сейчас всё равно смешанная, и вообще без привычных CPU не обойтись.

В то же время уже в прошлогоднем рейтинге TOP500 более сотни машин использовали продукцию NVIDIA, да и вообще эту компанию теперь можно смело называть не разработчиком игровых видеокарт, а производителем ускорителей – особенно после весьма удачного по времени выхода новых Tesla на фоне роста интереса к ИИ и нейронным сетям. А рост этот очень заметен – на той же SC16 было объявлено о заключении множества альянсов, анонсирована масса обучающих программ и ПО для упрощения разработки. И у Intel есть решения для всего этого. Главный интерес вызывает вовсе не Xeon Phi Knights Mill, а наследник Nervana – специализированный ASIC Crest, оптимизированный для обучения нейронных сетей. Оба эти ускорителя гармонично дополнены FPGA, на которых можно очень быстро исполнять уже обученные сети. И всё это в рамках единой программно-аппаратной платформы. Так что да, все эти анонсы можно назвать открытой войной с GPU, которая развернётся в следующем году!

Отдельный вопрос – нужен ли нам так называемый ИИ, по крайней мере в текущем его виде? Даже не все участники выставки считают, что нужен, а некоторые открыто говорят, что это просто очередной баззворд, громкое слово. Несмотря на то, что иллюстрировали полезность этих технологий в основном на довольно простых и понятных примерах – генетика, физика, медицина и даже проектирование микросхем, фундаментально ИИ даёт лишь одно весомое преимущество, а именно резкое снижение цены и времени создания прогнозов, которые для многих областей деятельности человека являются очень важными. Перспективы развития ИИ и будоражат воображение, и одновременно пугают. Потому что, к сожалению, за всё время, проведённое на выставке, никто ни разу не сказал об этичном использовании новых технологий.