По словам организаторов, в этом году у ISC новый рекорд по числу посетителей. При этом визуально стендов стало меньше, да и в целом распределение площадей поменялось. Часть компаний отказались от размещения стендов, хотя и отправили своих представителей в качестве обычных посетителей или докладчиков. Благодаря этому производители помельче смогли арендовать стенд побольше, а некоторые вендоры вообще впервые приехали на ISC.

Ряд компаний поступили хитрее — формально на выставке они присутствовали, но фактически их мероприятия проходили в близлежащих отелях. По словам некоторых из них, сделано это из соображений экономии. В конце концов, полноценное участие в выставке — это во многом имидж и PR. Зато, по субъективным ощущениям, гораздо заметнее стали китайские компании. Для них-то как раз важно именно сейчас рассказать миру о себе. Впрочем, о них мы, кажется, ещё наговоримся в следующем году, а пока посмотрим, какие важные или просто интересные анонсы, продукты и тенденции были на ISC 2016.

Intel Xeon Phi Knights Landing

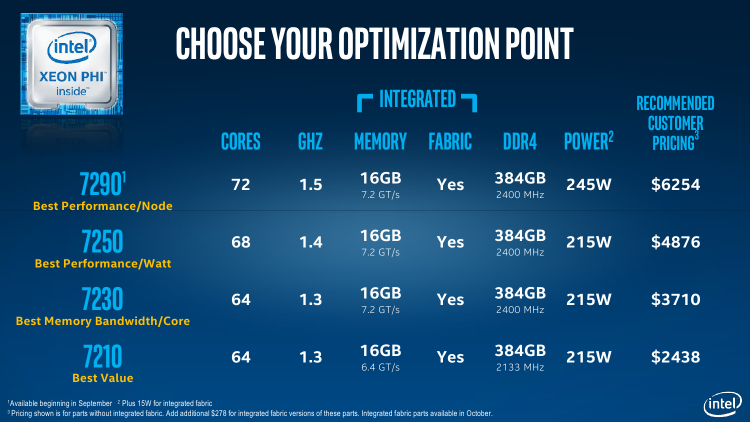

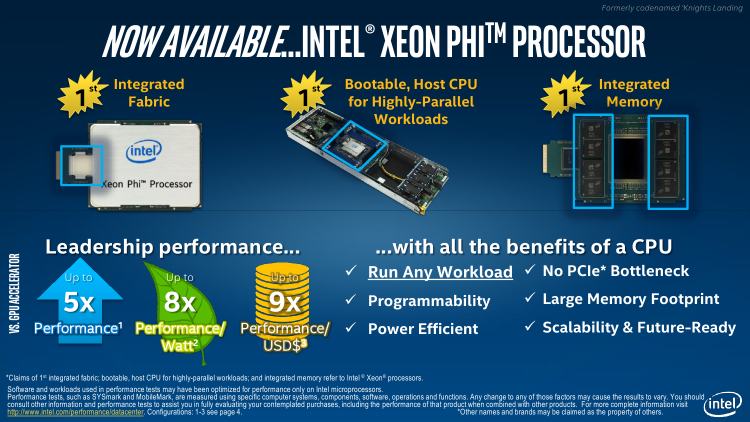

Главным событием ISC 2016, конечно, стал официальный анонс нового процессора — сопроцессором его назвать уже нельзя — Intel Xeon Phi Knights Landing, более известного в народе как просто KNL. Краткие характеристики семейства новинок таковы: 64-72 ядра x64 с частотой 1,3-1,5 ГГц, 32-36 Мбайт L2-кеша, Hyper-Threading (до 4 потоков на ядро), 128-144 блока AVX-512, 16 Гбайт набортной памяти MCDRAM, поддержка до 6 каналов ECC-памяти DDR4-2133/2400 суммарной ёмкостью 384 Гбайт, 36 линий PCI-Express 3.0, TDP 215-245 Вт, техпроцесс 14 нм. Осенью станут доступны версии со встроенным интерконнектом Intel Omni-Path (OPA), которые будут дороже базовых на $278, да и TDP у них будет на 15 Вт больше. Тогда же появится и старшая модель KNL 7290 с пиковой теоретической производительностью до 3 Тфлопс.

Интегрированная память MCDRAM, которая является разновидностью HBM, примерно в четыре раза быстрее DDR4. Она может быть сконфигурирована в качестве «продолжения» кеша, в качестве обычной памяти или же в смешанном режиме, где под кеш отдаётся только часть объёма. Процессоры KNL поддерживают исполнение x86/x64-кода, и на них можно запустить ОС. Пока что поддерживаются только конфигурации с одним процессорным разъемом. По словам Intel, новые Xeon Phi в разы эффективнее GPU, причём как по скорости расчётов, так и по цене решения и энергопотреблению. Сравнение проводилось на двух машинах схожей конфигурации. Машина с NVIDIA Tesla K80 стоимостью около 13 750 долларов потребляла 683 Вт, а вариант с Intel Xeon Phi 7250, MCDRAM в качестве обычной памяти и отдельным контроллером OPA потреблял 378 Вт, а стоил при этом примерно $7 300 (согласно рекомендованным ценам Intel).

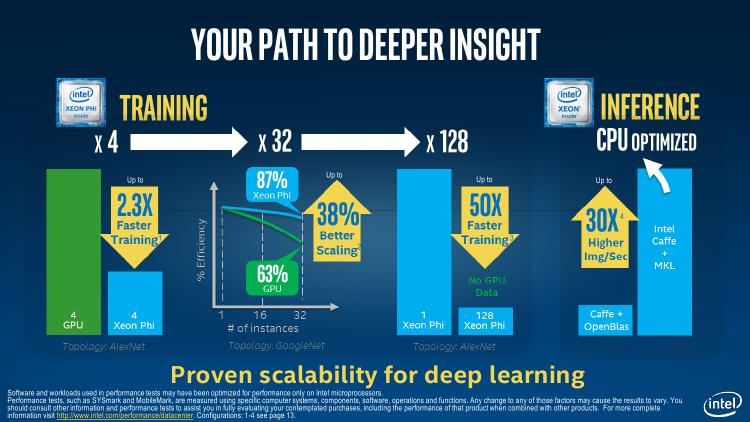

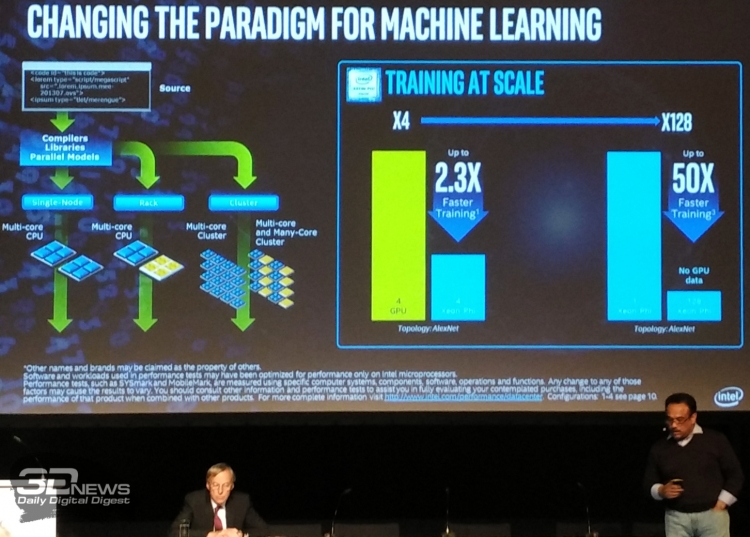

Также утверждается, что с ростом числа узлов решения на базе KNL масштабируются лучше, нежели системы с GPU. В качестве примера приводится работа с нейронными сетями. Правда, для сравнения в качестве источника данных о GPU используется сторонняя работа, а не собственные измерения. Машины с KNL были объединены с помощью Intel Omni-Path. К слову, последняя технология постепенно становится всё более популярной. На текущий момент уже продано около 80 000 узлов с контроллерами OPA, и примерно половина заказчиков HPC-решений в своих запросах предложения (Request for Proposal, RFP) указывают и данную технологию.

Строго говоря, KNL и OPA уже довольно давно используются некоторыми американскими компаниями и научными лабораториями. Одной из основных сфер применения обеих новинок Intel видит как раз нейронные сети и глубокое обучение, а не только «классические» вычисления. Речь не столько о развлечениях вроде Prisma, сколько о действительно полезных технологиях. В качестве примера — а на него ушла чуть ли не половина презентации на ISC 2016 — компания приводит создание беспилотных автомобилей и переход транспортной инфраструктуры города к их обслуживанию. И обучение, и обработка данных со множества датчиков, и быстрая реакция на дорожную ситуацию в масштабах современного мегаполиса требуют невероятных по сегодняшним меркам вычислительных мощностей, сетей связи и хранилищ данных. Если интерес к нейронным сетям останется столь же сильным, то в следующем поколении Xeon Phi Intel ожидаемо сделает тот же финт ушами, что и NVIDIA, — выпустит процессор с упором на вычисления одинарной и половинной точности. И да, кажется, нам пора привыкать к тому, что CPU становятся всё крупнее, и к тому, что всё больше системных элементов переезжает под одну с ними крышку. Глядишь, через несколько лет мы забудем уже и про южный мост.

Впрочем, это пока лишь теории, а сейчас же продукты с KNL и/или OPA были представлены чуть ли не на каждом стенде разработчиков железа для HPC. Исключением стали лишь приверженцы альтернативных лагерей OpenPOWER и ARM, которые предлагали решения с ускорителями Tesla. Из российских производителей, приехавших в этом году на ISC, был только один — РСК. На стенде компании демонстрировалась новая версия узлов «РСК Торнадо» на базе платы Intel S7200AP и процессора Xeon Phi 7250. Благодаря новым CPU почти вдвое выросла производительность решения — до 528 Тфлопс для шкафа 42U (0,8 × 0,8 × 2 м). Также обновление получил дизайн вычислительных шкафов, так как теперь появилась поддержка интерконнекта Intel Omni-Path. При этом осталась поддержка охлаждения узлов горячей водой с t +63 °С на входе и резервирование СЖО уровня от N+1 до N+N.

«Классические» узлы «РСК Торнадо» — те, что использовались, например, при построении российского суперкомпьютера «Политехник», — получили поддержку новых процессоров Xeon E5 v4, в том числе и старшей модели E5-2699 v4 с включенным режимом TurboBoost. С ними вычислительная плотность достигает уровня 237 Тфлопс для шкафа 42U (0,8 × 0,8 × 2 м). Все узлы поддерживают установку до 192 Гбайт DDR4-2400 RAM, а подсистема хранения теперь включает поддержку двух SATA-накопителей и одного NVMe-модуля для PCI-E в форм-факторе M.2. Собственно говоря, на стенде как раз и показывался узел «РСК Торнадо» с Xeon Phi KNL, адаптером Omni-Path, двумя SATA-дисками Intel SSD DC S3500 и одним пока ещё не анонсированным NVMe-накопителем Intel ёмкостью 512 Гбайт.

Были представлены и новые блоки питания в форм-факторе узлов для установки в вычислительный шкаф, преобразующие входящее питание 220 В в 400 В DC. Наконец, последняя новинка РСК — это шлюз для соединения сетей InfiniBand EDR и Intel Omni-Path. Пока что он представлен в виде стандартного 2U-рэка, но позже будет выпущен вариант высотой в два узла — для установки в вычислительные шкафы РСК.

изображения (11)

У прочих крупных вендоров на стенде почти всегда присутствовало хотя бы одно решение на базе KNL. Некоторые предпочли взять готовые платформы самой Intel, но многие разработали их с нуля, причём в различных форм-факторах — от компактных плат до здоровенных узлов на несколько CPU. Что характерно, очень многие предлагают продукты с жидкостным охлаждением или хотя бы два варианта — на воздухе и на воде. Однако про СЖО будет отдельный разговор ниже. Из слегка необычных платформ стоит отметить только плату Cray с маркировкой KPDC5, предназначенную для четырёх Intel Xeon Phi KNL и, предположительно, одного обычного CPU. А необычно в ней то, что она охлаждается воздухом.

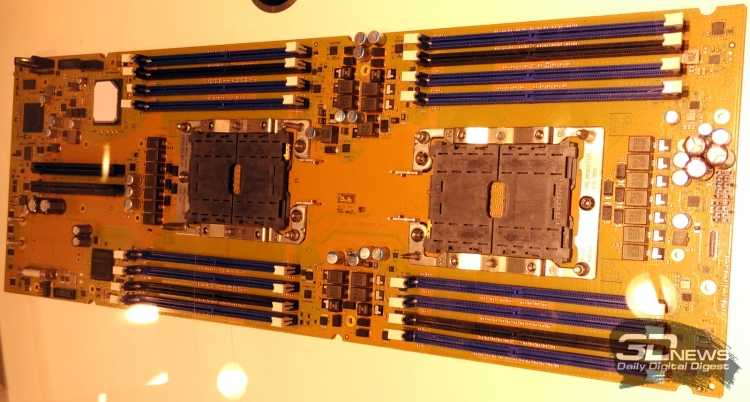

Ещё из любопытных новинок — прототипы решений для грядущих «старших» Intel Xeon Skylake и платформы Intel Purley, выход которых ожидается в следующем году. Процессорный разъем внешне очень похож на таковой у новых Intel Xeon Phi — крупный, с выемкой под коннектор Intel Omni-Path — хотя о физической совместимости площадок официально пока никто не говорит. Кроме того, на глаза попадались и проекты с иным подходом, а именно серверы с массивами из относительно простых и «холодных» Intel Xeon D — например, AsRock Rack 3U16N (3U, 16 CPU) или детище японских компаний ExaScaler Inc. и PEZY Computing.

Параллельная вселенная

Детище это является представителем удивительного для европейца японского мира. Разработчики создали собственные MIMD-процессоры (MIMD — Multiple Instruction stream, Multiple Data stream, "множественный поток команд, множественный поток данных"), которые и занимаются вычислениями. Предлагаются и, так сказать, традиционные узлы с 16 CPU Intel Xeon E5-2600 v3/v4 или с 64 CPU Intel Xeon D, и узлы для восьми полноразмерных GPGPU-карт, а также узлы хранилища на базе традиционных накопителей (24 HDD/SSD 3,5”/2,5”) или M.2 SSD (1520 терабайтных модулей, но наружу «смотрит» соединение всего 10 Гбайт/с). В общем, вещь в себе! Ни с чем не совместимая, никому не известная — и всё-таки завораживающая. Используются все эти узлы в суперкомпьютере Shoubu, который третий раз подряд занимает первое место в рейтинге энергоэффективных систем Green500 — последний сертификат он получил уже во время выставки ISC 2016.

Первый в этом году рейтинг Top500, который с этого момента будет включать в себя и Green500, тоже примечателен тем, что лидирует в нём китайский суперкомпьютер Sunway TaihuLight на базе загадочных 64-битных RISC-процессоров Sunway SW26010 260C с частотой 1,45 ГГц. Про эти CPU информации толком-то и нет, однако считается, что они примерно в два раза менее энергоэффективны в сравнении с нынешним поколением Intel Xeon Phi Knights Landing. Впрочем, это не так уж важно, если учесть, что почти весь суперкомпьютер собран из компонентов, разработанных в Китае. Чем не экзотика?

Если продолжать тему необычных машин, то нельзя не вспомнить и других «японцев»: Fujitsu и NEC. Хотя обе компании в некотором смысле «сдались», выпустив серверы с Intel Xeon Phi KNL, свои собственные разработки они бросать, кажется, не собираются. Fujitsu который год подряд возит на выставку модули PRIMEHPC FX100 с процессорами SPARC64 XIfx, а NEC всё так же рассказывает о преимуществах своих векторных суперкомпьютеров, правда, уже ничего такого на стенде не показывает. Зато на ISC 2016 NEC привезла свой модульный сервер DX2000, который состоит из 3U-рэков. В каждый из них можно установить до 44 микросерверов на базе Intel Xeon D, то есть плотность получается даже выше, чем у упомянутого ранее решения ASRock Rack. В данном случае были установлены неназванные платы производства Gigabyte.

Sugon Galaxias SDC1000: «лезвия» с CPU Intel Xeon D и FPGA-ускорителями Altera или с ARM Cavium ThunderX

Китайская компания Sugon показала оригинальное решение — сервер Galaxias SDC1000 высотой 4U. Он тоже использует CPU Intel Xeon D (32 шт.), а изюминка его в том, что процессоры работают вместе с ускорителями на базе FPGA Altera. Разработчик даже предлагает концепцию FPGA-as-a-Service, то есть, по сути, облачный доступ к ускорителям. Иных необычных вычислителей на ISC 2016 замечено не было. Даже Micron не привезла на выставку новые Automata-процессоры. Что же, тогда вернёмся к более привычным архитектурам: ARM и OpenPOWER. А заодно и к их общей пассии — NVIDIA.

изображения (7)

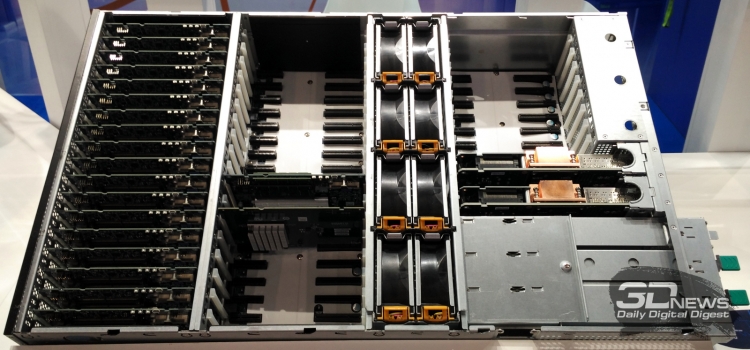

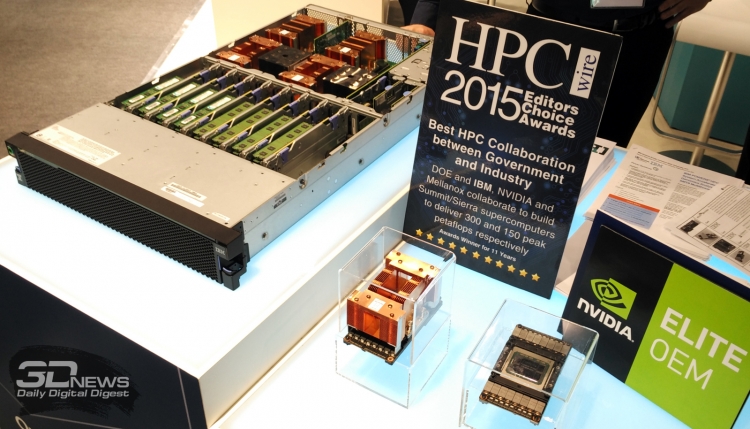

Собственно говоря, серверными ARM-процессорами, как и прежде, «заведует» Cavium, которая недавно удивила желанием купить QLogic за миллиард долларов. Далеко за примерами решений с Cavium ходить не надо — упомянутый выше Sugon Galaxias SDC1000 теперь поддерживает установку до 16 «лезвий» с CPU ThunderX (64-бит ARMv8-A). Кроме того, сервера с ThunderX традиционно показали Gigabyte, Penguin Computing и E4 Computer Engineering. Правда, почти все они демонстрировались ранее. Зато E4 представила ещё и продукты на базе OpenPOWER и NVIDIA Tesla P100/K80: Arka OP106, OP205, OP206. Впрочем, решения на базе Tesla P100 сразу с несколькими ускорителями на одной плате — обычные PCI-E-карты и так были на почти на каждом стенде — подготовили и крупные игроки. В частности, Dell, SuperMicro и, конечно, IBM.

изображения (6)

Последняя, по ощущениям, неплохо поработала над OpenPOWER. Во всяком случае, с момента прошлой выставки демонстрируемые продукты на этой платформе перестали быть похожими на странные прототипы. Сама IBM привезла на ISC 2016 только сервер серии Power System S822LC с четырьмя NVIDIA Tesla P100 (NVLINK/CAPI). Кстати, обратите внимание на вырезы в радиаторах ускорителей первой линии — судя по всему, сделаны они из-за недостатка охлаждения последнего ряда радиаторов. Более того, есть вариант этой машины без ускорителей, но с СЖО. И это плавно подводит нас к следующей теме.

Системы жидкостного охлаждения

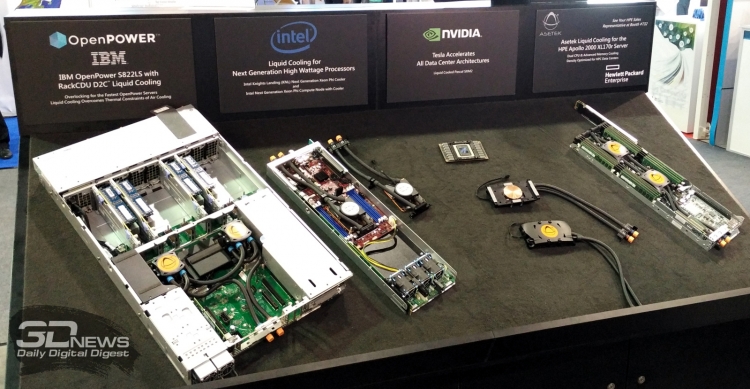

Наконец-то произошёл важный сдвиг — практически все производители показали системы с СЖО. Те, кто уже давно занимается этой темой, просто обновили уже имеющиеся разработки. Все остальные особо не раздумывали и заказали СЖО у сторонних компаний. Фактически этих компаний сейчас только две — Asetek и CoolIT, и они успешно поделили между собой рынок. Есть ещё замечательная Calyos со своими беспомповыми СЖО на фреоне, но пока что-то не похоже, что производители спешат внедрять её решения в свои продукты. В этом году она и вовсе представила концепт бесшумного игрового ПК и другие прототипы СЖО для обычных ПК, а не серверов.

Любопытно, что представленные на выставке решения Asetek, в отличие от продуктов CoolIT, были предназначены исключительно для подключения к внешнему контуру СЖО на целый шкаф. У CoolIT же были варианты для простого переноса тепла внутри узла. Увы, оба производителя пока что предлагают решения скорее для быстрой смены воздушного охлаждения на жидкостное, в связи с чем у некоторых посетителей возникали вопросы относительно их надёжности. Для сравнения: у вендоров, изначально проектирующих системы исключительно с СЖО, строение охлаждения иное — как правило, без лишних соединений внутри узла и с аккуратным расчётом теплообмена всей системы в целом.

All-flash array

Наконец, последнее отрадное веяние времени — это all-flash array, то есть хранилища, построенные исключительно из твердотельных накопителей. Причём подключённых через PCI-E и с помощью NVMe, что позволяет не только по полной использовать все возможности SSD, но и организовывать быстрый доступ к данным внутри фабрики. На ISC 2016 наиболее примечательными решениями такого класса были SuperMicro SSG-2028R-DN2R40L на 48 NVMe-накопителей и совместный продукт Samsung и StackVelocity на 24 диска NVMe. Оба сервера имеют высоту 2U. Вероятно, на следующей суперкомпьютерной конференции подобных продуктов будет гораздо больше, да и Intel обещает вскоре показать накопители Optane. Впрочем, с выходом Xeon Phi KNL с MCDRAM иерархия памяти уже начинает потихоньку меняться. И NVMe-массивы, подключённые к фабрикам Intel Omni-Path, будут очень кстати.

TL; DR

Итак, тезисно о важном на ISC 2016. Самое главное и долгожданное событие — это выход процессоров Intel Xeon Phi Knights Landing (KNL) и продуктов на его основе. Старшая модель 7290 и версии с контроллером Omni-Path появятся осенью. Хотя собственно Omni-Path уже достаточно активно внедряется в действующие суперкомпьютеры и другие вычислительные системы, так что у него есть все шансы потеснить InfiniBand. Кроме того, был замечен прототип материнской платы для грядущих «старших» Intel Xeon Skylake и платформы Intel Purley. Примечательны в данном случае площадки под процессор — визуально они очень похожи на разъемы для Xeon Phi KNL и обладают таким же вырезом сбоку для подключения коннекторов Intel Omni-Path.

Альтернативные x86-архитектуры тоже не стоят на месте. Во-первых, оба лидера свежих рейтингов Top500 и Green500 используют вычислители собственной разработки. Самый быстрый в мире китайский суперкомпьютер Sunway TaihuLight построен на загадочных 64-битных RISC-процессорах Sunway SW26010 260C. Да и вообще китайцы стали намного заметнее на рынке. А самый «зелёный» суперкомпьютер Shoubu из Японии создан на базе проприетарных MIMD-процессоров. Во-вторых, развиваются ARM и OpenPOWER. Cavium выпустила новое поколение CPU ARMv8-A ThunderX 2, а решения на основе платформ IBM приобрели вид законченных продуктов. И те и другие в качестве ускорителей часто используют NVIDIA Tesla. Ну и конечно, самый свежий чип Tesla P100 тоже был представлен на стендах выставки.

Ещё один важный «сдвиг в сознании» производителей серверов — это понимание растущей необходимости систем жидкостного охлаждения. Почти на всех стендах демонстрировались узлы с СЖО в качестве основного или как минимум альтернативного охлаждения. Активнее всего на этом рынке два вендора — Asetek и CoolIT. Однако пока, честно говоря, их решения больше похожи на быстрый способ заменить «воздух» «водой». Всё-таки когда узлы изначально разрабатываются для СЖО и вся система делается внутри одной компании, результат выходит лучше, чем попытка прицепить к уже имеющимся продуктам стороннее охлаждение. Как и прежде, актуальна тема охлаждения систем горячей водой. Лидером в этой области остаётся российская компания РСК, продукты которой поддерживают охлаждение водой с температурой выше 60 °С на входе в узел.

Наконец, последняя важная тенденция — появление хранилищ, состоящих исключительно из SSD (all-flash array) с интерфейсом PCI-E и поддержкой NVMe. Благодаря этим технологиям появляется возможность быстрой работы с хранилищем внутри фабрики. Кроме того, они являются одним из необходимых шагов для смены иерархии памяти. Для рынка серверов все вышеперечисленные моменты будут актуальны в ближайшем будущем, а позже эти технологии появятся и в домашних ПК. В общем, рынок развивается, и на следующей ISC наверняка тоже будет на что посмотреть.

Источник: