Fujitsu объявила о доступности ПО (middleware), предназначенного для оптимизации использования ускорителей ИИ. Как указано в пресс-релизе, это решение позволяет повысить эффективность работы ускорителей, что особенно актуально в условиях дефицита вычислительных ресурсов такого типа.

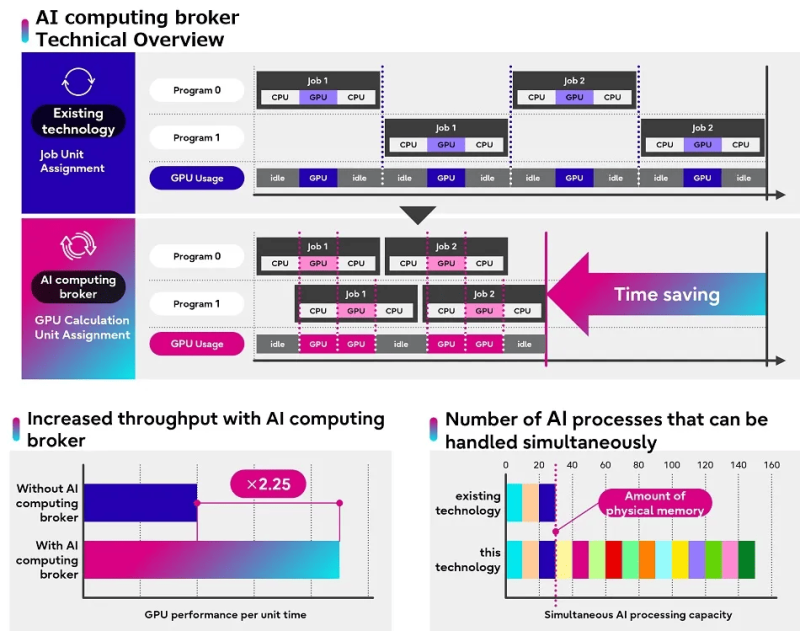

ПО различает код, для запуска которого требуется GPU, и тот, что может работать и с использованием одного только CPU, оптимизируя распределение ресурсов и управление памятью на различных платформах и в приложениях ИИ. Кроме того, ПО управляет приоритетностью запуска вычислений, отдавая предпочтение более эффективным процессам. Интересно, что распределение не использует традиционный подход, когда выбор ресурсов основывается на задаче целиком.

Компания анонсировала решение (Adaptive GPU Allocator) в ноябре 2023 года. Тогда говорилось о необходимости использования фирменного фреймворка на базе TensorFlow и PyTorch. В нынешнем анонсе про это явно не говорится, но сообщается, что продукт объединяет технологию адаптивного распределения ресурсов каждого отдельного ускорителя с некой оптимизацией на базе ИИ. Более того, новинка позволяет эффективно обрабатывать даже те задачи, которые целиком в памяти ускорителя не помещаются. В ходе тестирования даже удалось наладить обработку 150 Гбайт ИИ-данных на GPU с приблизительно 30 Гбайт свободной RAM.

Fujitsu заявила, что решение позволило увеличить в 2,25 раза эффективность ИИ-вычислений в ходе тестирования на реальных задачах компаний AWL, Xtreme-D и Morgenrot. А два крупных заказчика, Tradom и Sakura Internet, уже начали внедрять новый инструмент. «Решая проблемы нехватки ускорителей и энергии, вызванные растущим мировым спросом на ИИ, Fujitsu стремится внести свой вклад в повышение производительности бизнеса и креативности для своих клиентов», — заявила компания.

Впрочем, пока решение способно ускорить только работу ускорителей в составе одного сервера, но компания работает над тем, чтобы она могла обслуживать множества GPU, установленных в нескольких серверах. Иными словам она не пока что позволит ускорить целый ИИ-кластер ускориться, но это всё равно удобный способ «выжать больше» из GPU-сервера, отметил ресурс The Register.

Источники: