Осенью этого года в России прошло множество мероприятий, посвященных высокопроизводительным вычислительным системам сегодняшнего и завтрашнего дня. На международной конференции Russian Supercomputing Days и локальных форумах МСКФ-2015, НСКФ-2015 представители эксплуатирующих организаций и разработчики вычислительных комплексов среди прочих вопросов аппаратного обеспечения много времени уделили теме отвода тепла, производимого компьютерным оборудованием при работе.

Воздушная система охлаждения электроники хорошо зарекомендовала себя в компьютерах предыдущих поколений. Однако сейчас такие СО уже не всегда отвечают запросам разработчиков вычислительных компонентов. Так как воздушная технология подходит к физически обоснованным пределам эффективности, каждый дополнительный киловатт, отведенный от современного вычислительного комплекса, становится «золотым» по стоимости.

⇡#Рынок ЦОД как потенциал для развития сегмента

В среде специалистов по эксплуатации ЦОД существует понятие «эффективность использования энергии», или, кратко, PUE (Power Usage Efficiency).

В ЦОД параллельно функционируют информационная, телекоммуникационная и инженерная инфраструктура. Полезную для пользователя IT-функцию выполняют первые две, а инженерная инфраструктура, в свою очередь, обеспечивает возможность их надежной работы. Отношение потребляемой всем ЦОД электроэнергии к объему, затрачиваемому на работу непосредственно IT-оборудования, определяет эффективность работы ЦОД.

Задача улучшения работы ЦОД состоит в оптимизации работы всех подсистем и является комплексной. Очевидно, что чем ближе PUE системы к 1, тем большая часть энергии комплекса «работает» на владельца ЦОД. Система жидкостного охлаждения (СЖО), в теории являясь более эффективной преемницей воздушной, должна позволить существенно сократить эксплуатационные расходы. Но чтобы потеснить уже проверенные временем воздушные системы охлаждения, бизнесу важны количественные, а не только качественные показатели преимущества СЖО. Насколько новая технология будет востребована целевой аудиторией?

⇡#Современное состояние и тенденции развития ЦОД за рубежом и в России

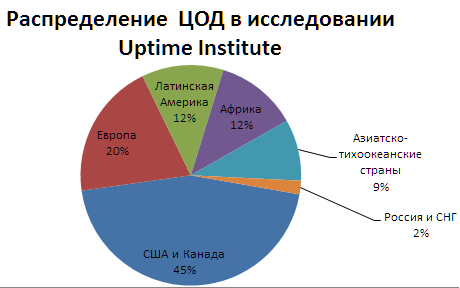

В сентябре 2015 г. компания Uptime Institute (эксперт в области ЦОД) в очередной раз опубликовала ежегодное исследование, в котором проанализированы 1000 ЦОД по всему миру.

Согласно исследованию, в 2015-м по сравнению с 2014 г. наблюдалось 74%-е увеличение бюджета ЦОД, предлагающих аренду своей инженерной инфраструктуры для размещения оборудования заказчика (colocation — «колокация»), и 47%-е увеличение бюджета прочих коммерческих ЦОД. Для данного сектора IT тенденция роста бюджетирования примерно на таком же уровне наблюдалась в 2013-2014 гг. Также опрос показал уверенный рост строительства новых ЦОД.

Среди опрошенных управленцев ЦОД одним из наиболее волнующих вопросов завтрашнего дня является увеличение стоимости электроэнергии, а так же физическая возможность получения требуемой электрической мощности под будущие проекты. В 72% компаний из опрошенных респондентов подсчитывается PUE. Но только 10% компаний публикуют эти цифры. В списке важности задач оптимизации PUE на первых трех местах расположились:

- операционные издержки;

- соотношение кВт/стойка;

- обновление серверов.

За период с 2007 по 2014 г. среднее значение показателя PUE улучшилось с 2,5 до 1,7. При этом наибольший рост эффективности использования электроэнергии наблюдался в последние 5 лет. Однако существующие показатели PUE не удовлетворяют многих руководителей ЦОД, о чем свидетельствуют заявленные целевые значения PUE.

Для достижения поставленных показателей применяются различные подходы. Первый подход – наведение порядка среди используемых серверов. Исследование выявило примерно 20% устаревших или неиспользуемых серверов в ЦОД. Такой балласт влияет на эффективность общего рационального использования инфраструктуры и площадей ЦОД. Примерно половина респондентов не проводит плановых проверок для выявления и утилизации подобного неэффективного оборудования. После проведения инвентаризации и устранения 15 000 единиц оборудования финансовая компания Barclays за 2 года сэкономила более $10 миллионов.

Второй подход предполагает использование продвинутых технологий охлаждения. Как показала статистика, в 11% из 1000 ЦОД, принявших участие в исследовании, уже применяется охлаждение жидкостью.

Рынок инженерной инфраструктуры ЦОД делится на похожие, но все же различающиеся сегменты – рынок суперкомпьютеров (СК) и рынок вычислительных систем широкого назначения. На рисунке ниже представлен совокупный рынок систем охлаждения по оценке компании Asetek. В общей емкости рынка систем охлаждения высокопроизводительных систем с большим отрывом от суперкомпьютеров лидирует сегмент систем широкого назначения.

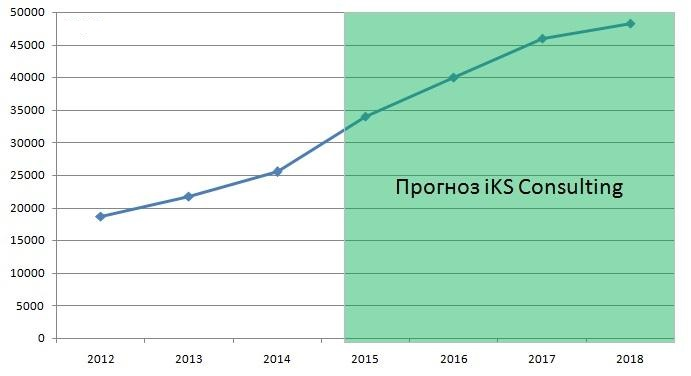

Двукратный рост объема ЦОД с увеличением количества серверных стоек до 48,3 тыс. к 2018 г. в России прогнозирует агентство iKS-Consulting. В таком случае объем данного рынка составит более 26,3 миллиарда рублей. На рост рынка ЦОД должен повлиять Федеральный закон №242-ФЗ от 21.07.2014, вступивший в действие с 01.09.2015 г., который требует хранить персональные данные граждан на территории РФ. Ужесточающееся финансовое и банковское законодательство, а также растущая конкуренция в розничной торговле и телекоммуникационной отрасли будут увеличивать количество компаний, пользующихся услугами коммерческих ЦОД.

Несмотря на то, что это только проекты, решение о том, какой системе охлаждения отдать предпочтение, можно принимать уже сегодня.

⇡#Возможности оптимизации затрат на содержание ЦОД

ЦОД представляет собой сложный комплекс, центральными элементами которого являются вычислительные узлы. В процессе своей работы вычислительные узлы выделяют тепло, которое, для обеспечения нормальной работы компонентов, необходимо отводить. Традиционная система охлаждения в качестве теплоотводящей среды (теплоносителя) использует воздух. Но чтобы этот воздух подавать с заданными физическими свойствами (температура, влажность, объем в единицу времени), работает целый комплекс обслуживающего оборудования, который, в свою очередь, также потребляет электроэнергию и выделяет тепло. По данным технического комитета ASHRAE 9.9 (Американское общество инженеров по отоплению, охлаждению и кондиционированию воздуха), около 40% всей электроэнергии, потребляемой дата центром, приходится на систему охлаждения, причем 30% расходуется компрессорами охлаждения.

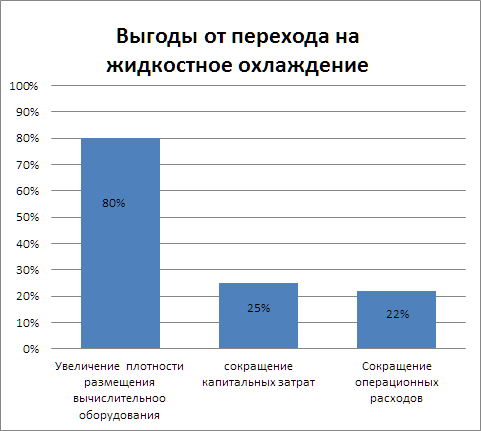

При переходе на технологию жидкостного охлаждения могут быть достигнуты следующие выгоды относительно систем воздушного охлаждения:

Больше плотность вычислительного оборудования — меньше нужно места для его размещения. К сокращению капитальных затрат ведет также экономия на инфраструктурных системах, которые больше не нужны. А если часть оборудования ЦОД удалось устранить, не снижая вычислительную мощность системы, то экономия на снижении общего потребления электроэнергии очевидна. Кстати, уровень шума в машинном зале благодаря СЖО может быть снижен вплоть до полной тишины.

Зарубежные компании-гиганты, владеющие ЦОД, ищут пути снижения не только расходов, но и негативного воздействия на природу. Компания Google — одна из первых в одном из своих ЦОД в течение 10 месяцев в 2008 году для охлаждения аппаратуры использовала воздух окружающей среды, не используя охладители. Эксперты считают, что в мировом масштабе только за счет экономии электроэнергии, требуемой на охлаждение воздуха на 5 °С, снижается общее потребление электроэнергии на 8%, что эквивалентно $2,16 млрд или месячной норме потребления такого государства, как... Испания! Что касается воздействия на природу, то выброс СО2 снизится на объем, эквивалентный очищению воздуха 43 млн деревьев, растущих в течение 10 лет.

На конец 2014 г. на ЦОД пришлось 2,5% от электроэнергии, потребленной всей планетой, что в денежном выражении равно $27 млрд. Во всем мире ЦОД производят порядка 210 млн тонн СО2, что эквивалентно работе 41 млн автомобилей.

В рамках программы Wells Fargo’s 2020 Environmental Commitment, ориентированной на улучшение экологии, фондом Wells Fargo в сотрудничестве с Национальной лабораторией возобновляемых источников энергии (NREL) выделено $11 млн на 5 лет на исследование технологии жидкостного охлаждения для ЦОД. Ожидается ускорение коммерциализации перспективных технологий для зданий, которые смогут обеспечить масштабируемые решения для снижения энергетического воздействия сооружений на окружающую среду.

В Великобритании 1 июля 2014 года вступило в силу Соглашение об изменении климата, дающее право на налоговые льготы компаниям, внедряющим технологии энергосбережения в своих ЦОД. Цель данной программы — увеличение энергоэффективности ЦОД на 15% к 2020 г. Таким образом, учет фактора экологичности носит не только этический, но и экономический характер. В 2014 г. Европейская комиссия постановила к 2030 г. снизить уровень выброса СО2 на 40% по отношению к уровню 1990г. Стоит отметить, что и в России ведутся мероприятия по сокращению объема выбросов парниковых газов в целях реализации Климатической доктрины Российской Федерации. Согласно Указу Президента РФ №752 от 30.09.2013г. Правительству РФ поручено обеспечить к 2020 г. сокращение указанного фактора загрязнения окружающей среды до уровня не более 75% объема по отношению к 1990г.

Поскольку ЦОД становятся все более подотчетны экологическому регулированию, влияние парникового эффекта при их проектировании скоро будет иметь большое значение.

Зарубежный опыт больших вычислительных комплексов

Зарубежный рынок СЖО находится на этапе интенсивного роста. К примеру, компания CoolIT (Канада) за последние 5 лет показала рост прибыли в 578%, получив в 2014 году рекордную выручку в $27 миллионов. С 2001 г. эта компания запатентовала 50 технологий в сфере СЖО. На сегодня компанией продано более 2 млн комплектов СЖО по всему миру, часть из которых пошла на оснащение 30 ЦОДов.

Компанию CoolIT преследует ее главный конкурент в данном сегменте рынка — компания Asetek (Дания), показавшая в 2014 г. выручку в $20,8 млн. На 2015 г. сохранилась тенденция увеличения продаж, и на начало октября выручка компании составила $23,5 млн, что на 44% больше, чем за аналогичный период прошлого года. Под марками партнеров и своей маркой уже продано более 2,5 млн комплектов СЖО.

Запатентованная Asetek технология охлаждения для серверов RackCDU D2C является надежной и эффективной, о чем свидетельствуют заключенные в этом году соглашения на поставку данных систем трем крупным OEM-клиентам. Так, недавно компания Fujitsu заключила контракт на $0,5 млн. Fujitsu обещает уже в конце этого года предложить своим клиентам продукт Cool-Central Liquid Cooling, который позволит сократить расходы на охлаждение ЦОД вдвое. Технология охлаждения непосредственно на уровне микросхем позволит довести показатель PUE до 1,06.

Вторым крупным партнером стала Энергетическая компания штата Калифорния. Благодаря контракту на $3,5 млн партнер укомплектует два своих ЦОД энергоэффективными СЖО.

Третьим крупным партнером этого года стала компания Penguin Computing, принеся Asetek контракт на $1-1,5 млн. О деталях контракта с такими заказчиками как Министерство обороны США, по понятным причинам информации нет. Но в совокупности именитые партнеры своим интересом к технологии RackCDU D2C показывают, что «у них» технология жидкостного охлаждения потеснит системы воздушного охлаждения уже в ближайшее время, когда будет всесторонне проверена ее надежность и экономическая целесообразность.

Достоинства СЖО наиболее очевидны для больших систем. Одной из разновидностей таких систем являются суперкомпьютеры. Рейтинговый список TOP500 (ноябрь 2015 г.) отражает текущее распределение самых производительных вычислительных комплексов всего мира, и попасть в него считается весьма престижным в IT-сообществе. Интервенция систем на базе СЖО в этот список может рассматриваться как негласное признание жидкостной технологии ведущими в отрасли компаниями.

Как видно из рисунка, законодателями в этой отрасли по-прежнему остаются зарубежные страны. Лидер среди суперкомпьютеров, комплекс TIAHNE-2 (Китай), потребляет 17,8 МВт электроэнергии. Если учесть, что переход на СЖО может принести экономию электроэнергии хотя бы в 20%, то становится очевидным, что данная технология постепенно будет отвоевывать рынок у воздушных систем.

Место в общем зачете отражает одну сторону экономики страны. Место вычислительной машины в рейтинговых списках показывает определенные характеристики конкретной реализации проекта, в частности энергопотребление. Другой рейтинг, Green500 (ноябрь 2015), отображает энергоэффективную сторону системы.

Чем выше место в TOP500, тем серьезнее система, чем она выше в Green500, тем энергоэффективнее. Далее для рассматриваемых систем будет приводиться их рейтинг по обоим спискам.

Типы СЖО и их производители

Пока крупные отечественные игроки в основном следят за развитием событий у зарубежных коллег, вторые семимильными шагами реализуют у себя дорогостоящие, но перспективные проекты. Главная идея заключается в том, что при использовании жидкого теплоносителя суммарная стоимость эксплуатации ЦОД должна быть ниже, чем при воздушном охлаждении. Очевидным становится вопрос: какие существуют подходы в жидкостном охлаждении и чем они отличаются друг от друга?

Так как предлагаемые решения различаются по типу теплоносителя, архитектуре теплообменных модулей и самому подходу к охлаждению, то для удобства понимания достоинств и недостатков того или иного подхода необходимо рассмотреть системы структурированно. Условно СЖО электроники можно разделить на группы:

- контактное охлаждение;

- погружное охлаждение;

- кипящее (двухфазное) охлаждение.

Пройдемся по каждой из них в отдельности.

При данном способе охлаждения нагревающийся элемент электроники непосредственно контактирует с теплосъемником, нагревая его. «Холодная» жидкость поступает в камеру теплосъемника и, нагреваясь, отводит тепло из контура с электроникой. Чем больше теплоемкость рабочего тела, тем медленнее его можно прокачивать через теплообменный контур. Тут в качестве рабочего, отводящего тепло тела используется раствор дистиллированной воды с пропиленгликолем. Соотношение воды и присадки подобрано таким образом, чтобы устранить коррозию, но оставить величину теплоемкости смеси на приемлемом уровне. К поверхностям, лежащим на пути следования тепла от нагревающейся электроники к жидкости, предъявляется требование минимального теплового сопротивления. Поэтому теплосъемники преимущественно изготавливают из меди или алюминия, в зависимости от варианта реализации СЖО.

В зависимости от степени покрытия теплосъемными элементами материнской платы данный тип охлаждения делится на 2 варианта:

⇡#Вариант 1. Точечное охлаждение

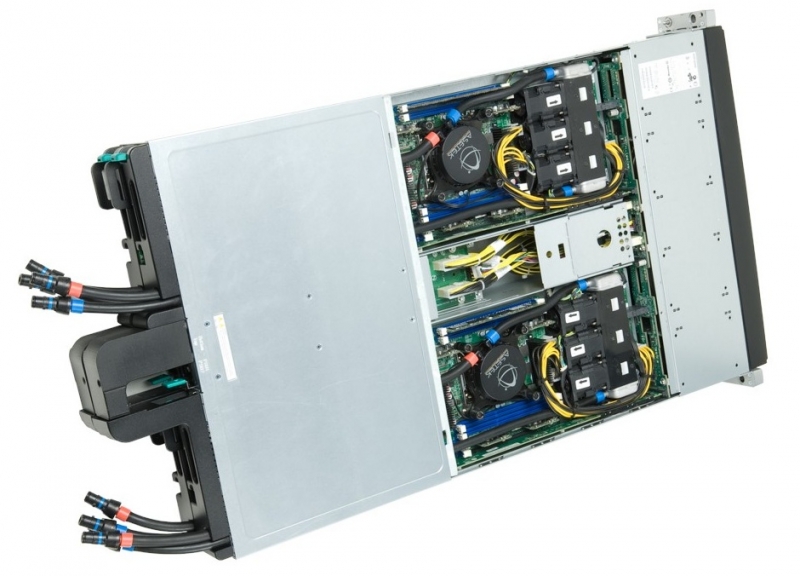

Тепло снимается с самых горячих компонентов, доля тепловыделения которых ярко выражена на фоне общего. К таким компонентам относятся процессоры, видеокарты и сопроцессоры. Такой подход ориентирован на минимальную доработку систем, разработанных для охлаждения воздухом. Это является неоспоримым достоинством для тех, кто планирует постепенный переход с воздуха на жидкость. При этом допускается использование части штатных вентиляторов. Другим достоинством является удобство сервисного обслуживания модернизированных таким образом систем. Для замены компонентов сервера, например модуля памяти, достаточно провести привычные стандартные процедуры: открыть корпус, заменить модуль, закрыть корпус.

Данную нишу зарубежного рынка делят в основном две компании, CoolIT и Asetek, время от времени судясь по поводу нарушения патентов столь схожих технологий.

Согласно исследованию Asetek, при использовании в ЦОД ее системы ISAC достигается экономия в 50% расходов на охлаждение, на 25% снижаются общие расходы на электроэнергию, а плотность размещения оборудования увеличивается в 2,5 раза. Такая система позволит отвести почти 100% всего выделившегося в сервере тепла. Благодаря совокупной экономии, достигаемой при использовании решений для ЦОД, срок окупаемости инвестиций перехода на СЖО в среднем составляет один год.

Национальная лаборатория Sandia модернизировала в 2015 г. кластер SKY BRIDGE, охлаждаемый водоблоками Asetek (227-е место в Green500 и 158-е в TOP500, P=675 кВт). Модули Asetek также работают в кластере SHADOW Государственного университета Миссисипи (36-е место в Green500 и 193-е в TOP500, P=193,4 кВт).

Система Rack DCLC производства CoolIT позволяет перевести разработанное под воздушное охлаждение оборудование на жидкостное охлаждение. Теплообменники AHx позволяют адаптировать уже существующую воздушную инфраструктуру машинного зала под жидкостное охлаждение, отводя до 35 кВт тепла от стойки.

При возможности подвести холодную воду к стойке централизованно больше подойдет теплообменный блок CHx40, позволяющий отводить до 40 кВт от стойки. Управление группой стоек может осуществить насосный модуль CHx650 с общим теплоотводом до 650 кВт. Совместно с Supermicro на базе водоблоков CoolIT была запущена система Cherry Creek (184-е место в Green500 и 394-е в TOP500, P=222,5 кВт).

Среди отечественных компаний разработкой систем точечного охлаждения занимается проект ЭкоФЛОПС компании ЗАО «Интерконсул» с партнерами.

Согласно анонсированному концепту «МК-5», ведутся разработки по созданию системы уровня стойки, способной отводить до 550 кВт тепла от обслуживаемого вычислительного кластера. Точечные водоблоки оригинального дизайна позволяют отводить тепло от процессоров, видеокарт и сопроцессоров.

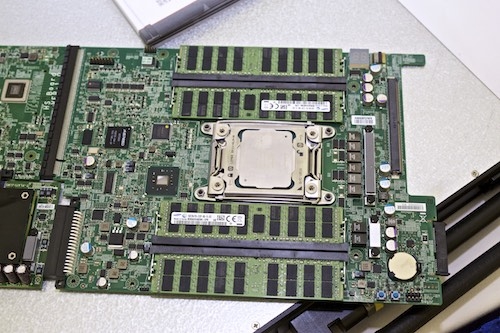

Вариант 2. Холодная плита

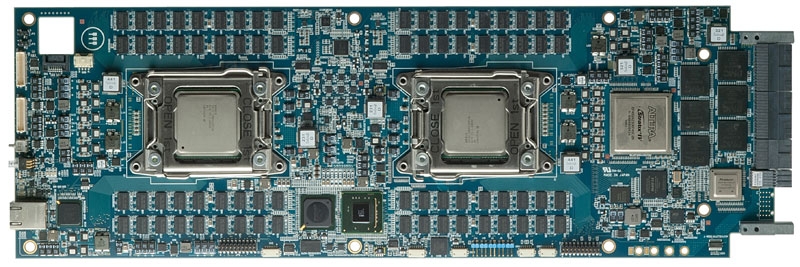

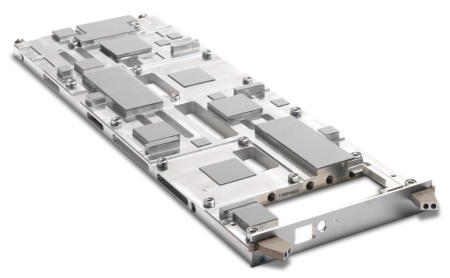

В системе Booster компании Eurotech (Италия) тепло отводится единым радиатором от процессоров, модулей памяти и остальных чипов. Для достижения этой цели пришлось изготовить материнскую плату собственного дизайна, на которой горизонтально расположенные чипы памяти теперь стали несъемными.

Все чипы прилегают к радиатору, внутри которого протекает жидкость. Однако, т.к. чипы имеют разную высоту, то радиатор имеет сложную геометрию.

По данной технологии создан суперкомпьютер QPACE2, установленный в Регенсбургском университете в Германии (15-е место в Green500 и 499-е в TOP500, P=78 кВт). В Москве СЖО от Eurotech можно увидеть в компании «Прософт». Кроме продвижения этой технологии в России, «Прософт» совместно с компанией ProModz (Россия) разрабатывает «холодную плиту» для ПЛИС (программируемые логические интегральные схемы), анонсированную на МСКФ-2015.

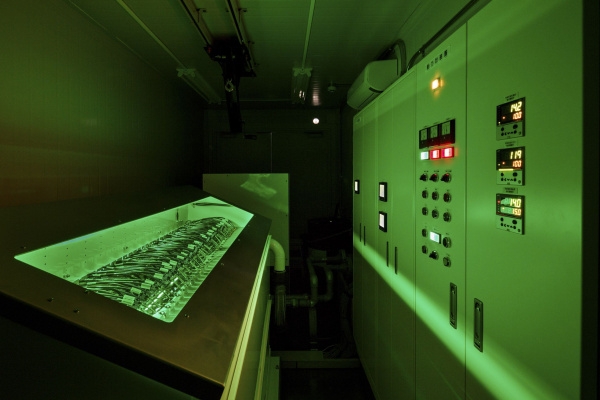

В России такой же принцип охлаждения реализован компанией РСК в линейке «Торнадо».

В своих последних исследованиях разработчики заявляют, что при достигнутом PUE=1,06, им удалось почти в 2 раза сократить общие затраты на электроэнергию. В ходе развития этой технологии была создана архитектура RSC PetaStream.

Благодаря использованию передовых сопроцессоров семейства Intel Xeon Phi 7120D удалось достигнуть рекорда вычислительной плотности, разместив в одном шкафу на 1 м2 систему производительностью 1,2 ПФЛОПС, а так же энергетической плотности в 400 кВт.

По технологии «Торнадо» построено 3 комплекса, входящих в список TOP500, самый мощный из которых «Политехник РСК «Торнадо» (73-е место в Green500 и 129-ое в TOP500, P=320кВт).

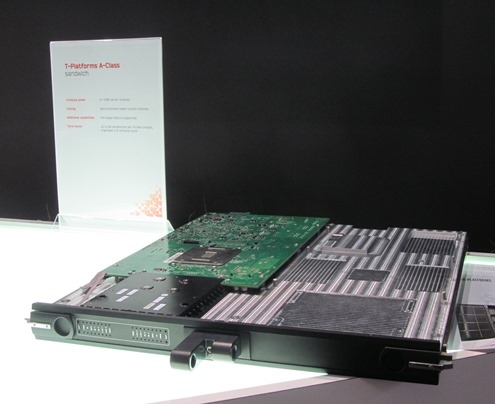

«Мэтр» отечественного «суперкомпьютеростроения», компания «Т-Платформы», использует «холодную плиту» с жидким охлаждением в своей линейке A-Class.

На базе системы V-Class в немецком вычислительном центре «Юлих» была запущена система JURECA (112-е место в Green500 и 50-е в TOP500, P=1016кВт). Новый комплекс состоит из 34 стоек, объединенных интерконнектом (межблочные кабели) нового поколения EDR InfiniBand.

Похоже, что в последнем поколении вычислительных модулей производители все же учли недостаток предыдущих версий, когда модули памяти были жестко впаянными, что создавало проблемы в случае необходимости их замены. Теперь модули стали съемными.

При использовании варианта «холодная плита» производители СЖО замыкают заказчика на свое вычислительное железо. Основными недостатками «холодной плиты» является сложность ее геометрии, влекущая удорожание системы и трудность модернизации.

Второй разновидностью жидкостного охлаждения являются системы погружного охлаждения. Как следует из названия, нагревающиеся компоненты погружают в жидкий теплоноситель. Данная технология уже давно применяется для охлаждения масляных трансформаторов. В качестве рабочего тела здесь используются такие диэлектрические жидкости, как минеральные или синтетические масла. Основные требования к ним – безопасность для электроники и обслуживающего персонала плюс достаточный теплоотвод.

Вентиляторы, типичные для воздушных систем охлаждения, тут заменяются насосами. Теплоноситель имеет большую, чем воздух, тепловую объемную емкость, а значит для одинакового количества отводимого тепла жидкости нужно на несколько порядков меньше. К тому же насосы можно вынести за пределы стойки или машинного зала. Так достигается устранение шума от системы охлаждения, и такое помещение по уровню комфорта сопоставимо с обычным офисным помещением. Как и в предыдущем разделе, данный класс делится на 2 варианта.

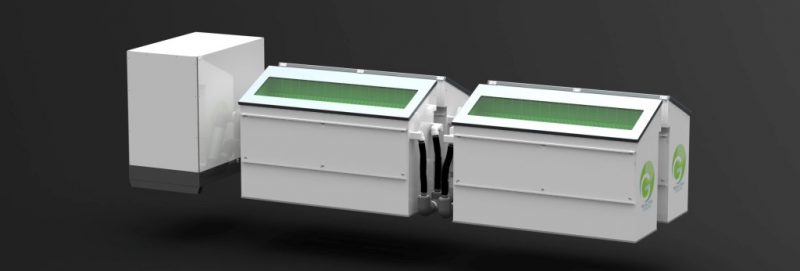

Классический вариант представлен зарубежной компанией Green Revolution Cooling (США), пионером в этой области. Она основана в 2009 году, а уже в 2010-м была произведена первая установка рабочего образца системы CarnotJet в ЦОД. С тех пор первые места списка Green500, ранжирующего суперкомпьютеры по энергоэффективности, занимают машины, выполненные на базе CarnotJet. Система представляет собой герметичный контейнер, наполненный минеральным диэлектрическим маслом, с теплоемкостью в 1200 раз большей, чем у воздуха. В контейнере, фактически являющемся положенной горизонтально стойкой, можно разместить до 42 серверных юнитов.

Однако, как следствие, под такие системы требуется большая площадь, чем под вертикальные. Хотя теплоноситель нагревается в 1200 медленнее, чем воздух, остановка его циркуляции в контуре нежелательна, и, на случай аварийной остановки насоса, в работу включается запасной, стоящий в горячем резерве. За счет устранения дополнительных барьеров на пути следования тепла от электроники в теплоотводящую среду данная технология гарантирует нормальную работу серверов при температуре диэлектрической жидкости до 50 градусов Цельсия. Такую горячую жидкость можно охлаждать без специальных установок, просто за счет более низкой температуры окружающей среды, что позволит экономить электроэнергию.

Производители системы CarnotJet заявляют, что данная технология позволяет достичь снижения энергопотребления вычислительных узлов на 8-20% и добиться значения параметра PUE=1,02. При этом сама система расходует порядка 5% потребляемой вычислительным оборудованием энергии. Максимально один контейнер может отвести до 100 кВт тепловой нагрузки. Пользователи подтверждают 35%-е снижение общих расходов на электроэнергию.

Для охлаждения в такой «ванне» серверного оборудования необходимо удалить из него все вентиляторы и термопасту. Современное оборудование, в основном блоки питания, может не включаться, обнаружив отсутствие вентилятора. В таком случае необходимо установить особую прошивку.

Эта технология подтвердила статус самой энергоэффективной. Первое место по энергоэффективности в прошлом году занимал суперкомпьютер Tsubame-KFC (Япония), охлаждаемый полным погружением в жидкость. В этом году самым экономичным является к омплекс Shoubu (Япония) — 1-е место в Green500 и 133-е в TOP500, P=50 кВт. При энергоэффективности 8 ГФЛОПС/Вт производительность по тесту LINPACK в 412 ТФЛОПС достигнута без применения ускорителей. Для наглядности сравним параметры его соседа по TOP500 – кластер Triolith при производительности по тесту LINPACK в 407 ТФЛОПС без ускорителей и потреблении 519 кВт имеет энергоэффективность в 0,78 ГФЛОПС/Вт. На примере этих систем можно наглядно увидеть, что если задаться целью создать энергоэффективную систему, то необходимо подойти к решению проблемы комплексно. Следует подобрать электронные компоненты (модель процессора, памяти и т.д.) и выбрать оптимальную систему охлаждения.

В России по пути полного погружения вычислительной техники в общий контейнер пошла компания Иммерс. Ее решения IMMERS660 и 880 рассчитаны на отвод 12 и 18 кВт тепловой энергии соответственно, при уровне энергоэффективности PUE=1,037. Конструктивно системы выполнены по принципу GreenRevolution. Компания анонсировала данные системы в конце 2014 года.

Системы IMMERS предполагают использование вычислительных модулей собственной разработки, что сужает диапазон охлаждаемого оборудования.

Основным преимуществом погружного охлаждения в общем контейнере является простота изготовления корпусов, т.к. не надо изготавливать полностью герметичные системы, работающие под давлением. Дополнительно снижается нагрузка на перекрытие за счет распределения нагрузки в горизонтальной плоскости. К недостатку рассмотренных систем стоит отнести необходимость очищать от масла извлеченное оборудование.

⇡#Вариант 2. Индивидуальный корпус

В этом варианте каждый вычислительный модуль помещается в отдельный корпус. В зависимости от требований, он может быть даже полностью герметичным. Электроника работает в таком же режиме, как и в предыдущем варианте. Здесь появляются дополнительные сложности с индивидуальным контейнированием. Но за счет разделения единой массы «вычислительной стойки» на отдельные контейнеры система получила большую гибкость в плане монтажа.

Охлаждением таким методом в 2005 г. занялась группа английских энтузиастов, которые уже тогда задумались об удешевлении охлаждения в ЦОД. На базе этой идеи была основана компания Iceotope, которая в течение 9 лет разрабатывала свою систему. В конце 2014 года, после успешных испытаний системы в университете Лидса (Великобритания) и Центре суперкомпьютерных вычислений Познани (Польша), компания Iceotope сообщила о готовности своей системы PetaGen к серийному производству.

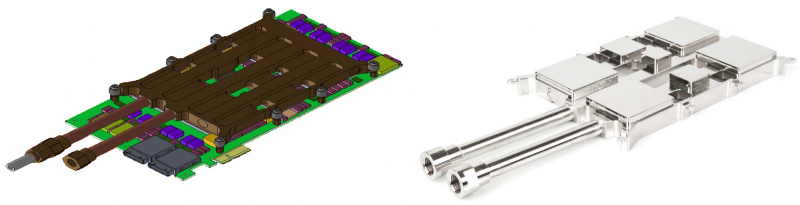

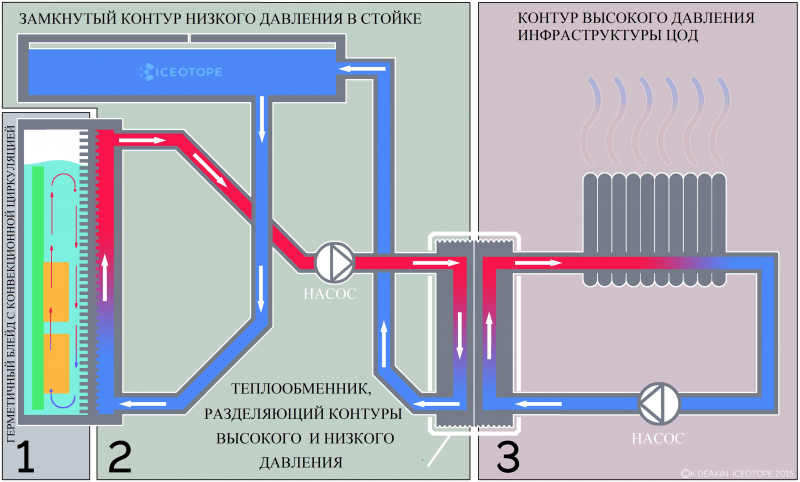

Систему PetaGen можно условно представить состоящей из трех контуров (рисунок приведен ниже). Первый контур (охлаждаемый) находится в камере герметичного контейнера с вычислительным оборудованием. Камера наполнена диэлектрической жидкостью фирмы 3М, которая не оставляет следов на плате и полностью с нее испаряется после извлечения из контейнера. Как видно на рисунке, наиболее греющиеся элементы (ЦПУ) расположены внизу платы, что создает конвекционные потоки, перемешивающие жидкость внутри без участия насосов.

Второй контур (охлаждаемый) отделен от первого стенкой теплообменника, где по каналам подается охлажденный теплоноситель второго контура – вода с присадками. Масса снаряженного блейда, представляющего собой систему двух емкостей, составляет 15 кг. Из расширительного бака, расположенного на верхнем ярусе стойки, вода поступает самотеком в охлаждающую камеру контейнера через нижний клапан. Под действием давящего с самой верхней точки стойки водяного столба вода проходит через теплообменник, где нагревается, забирая тепловую энергию от первого контура.

Третий контур осуществляет вывод тепла из стойки через теплообменник и представляет собой зону ответственности заказчика. Производитель гарантирует качественный теплоотвод при подаче на вход стойки воды в рабочем диапазоне температур (от +10 до +45 °С).

Стойка в варианте максимального количества блейдов, рассчитанная на размещение 72 вычислительных модулей, способна отвести до 60 кВт тепла. При этом в жидкость погружаются не только процессоры на материнских платах, но и блоки питания и современные коммутаторы. Таким образом, получается современная высокопроизводительная Intel-ориентированная система, работающая в полной тишине.

В США по данному пути в охлаждении пошла компания Liquid Cool Solution. Хотя бизнес компании ориентирован на разработку технологий СЖО и последующую продажу лицензий заинтересованным в производстве компаниям, все же в ее арсенале есть несколько систем, произведенных по данной технологии.

Основным достоинством данной архитектуры является возможность создания систем, предназначенных для мобильной эксплуатации во всепогодных условиях. Оборудование серии Compute Anywhere может работать на воде, под водой, в условиях песчаных бурь, загазованности, высоких и низких температур. Единственное требование — возможность подведения охлажденного хладагента. Вычислительный модуль представляет собой герметичный контейнер, заполненный диэлектрическим маслом, что создает некоторые неудобства в случае необходимости сервисного доступа к начинке. При транспортировке и монтаже контейнер находится всегда в заполненном состоянии. Поэтому к системе предъявляются повышенные требования по герметичности и осторожности извлечения из стойки.

Серия Liquid Submerged Server (LSS) предназначена для размещения в вычислительных стойках в ЦОД. Образец вычислительного модуля LSS этой компании представлен в ЭкоФЛОПС (Москва).

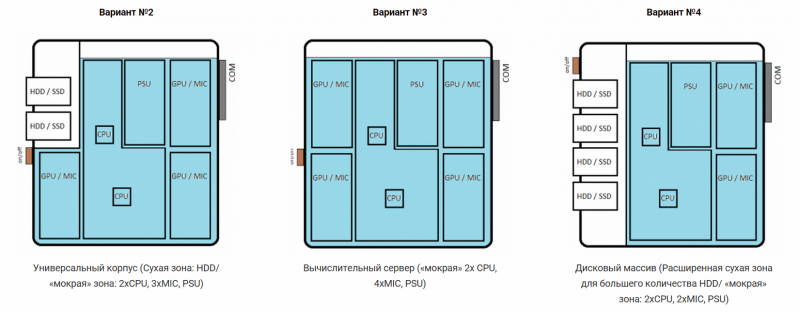

Коллектив ЭкоФЛОПС разрабатывает свою гибридную СЖО погружного типа ВК-3. Корпус представляет собой индивидуальный корпус, наполненный диэлектрической жидкостью. Система ВК-3 стала гибридной из-за дополнительного внутреннего контура, отводящего тепло от самых горячих точек (процессоров и сопроцессоров Intel Phi). Корпус имеет связь с атмосферой, что исключает увеличение давления внутри и снижает требования по его герметичности.

Корпус содержит «сухие» зоны, позволяющие работать с обычными HDD и SSD, а также снижающие класс герметичности коммутационных разъемов. Вся коммутация производится в «сухой» зоне. При извлечении из стойки производится слив жидкости, что существенно уменьшает массу модуля.

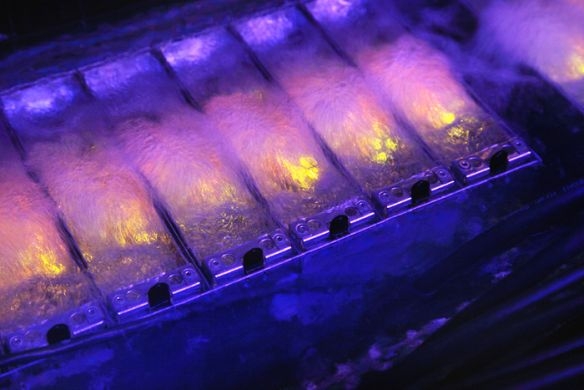

Данный тип теплоотвода только на первый взгляд похож на рассмотренный ранее метод охлаждения полным погружением. Но стоит вычислительной технике, охлаждаемой таким экзотическим способом, начать производить тепло, как первое впечатление буквально испарится — вместе с недоверием к технологии.

Остановимся поподробнее на физике процесса и ответим, почему данная технология называется двухфазной. Рассмотрим данный процесс на примере воды. Из школьного курса физики известно, что для нагрева 1 л воды на 1 градус необходимо затратить 4,187 кДж. Для того чтобы испарить этот же объем, необходимо примерно 2260 кДж, то есть в 540 раз больше энергии. Дойдя до точки кипения — 100°C, — температура воды перестает расти, и при дальнейшем нагреве происходит только испарение. Долгое время этот принцип невозможно было применить для охлаждения электроники по причине высокой температуры кипения. Но несколько лет назад компания 3М разработала продукцию семейства Novec.

В жидкостях этого семейства были реализованы несколько требований промышленности: безопасность для природы, низкая температура кипения, отсутствие проводимости тока и теплота парообразования выше, чем удельная теплоемкость воды. Данные жидкости, в зависимости от типа, начинают кипеть при атмосферном давлении при температурах 34, 49 или 56 °C. Удельная теплота парообразования для данных систем составляет 88,1 кДж/кг. И хотя до коэффициента парообразования воды далеко, но зато являясь диэлектриком, Novec позволяет охлаждать электронику прямым контактом. Если сравнить водяную систему с теплоносителем, нагретым до температуры, например, в 56 °С, то при нагреве 1 л воды на 1 °С можно отвести только 4,178 кДж. В случае для 1 л жидкости Novec, находящейся на границе кипения, эта величина составит 88,1 кДж, что в 21 раз лучше. При переходе жидкости в газообразное фазовое состояние тратится большой объем энергии. Далее, в верхней части герметичного контейнера пар, соприкасаясь с радиатором, конденсируется. При конденсации пар отдает энергию, которую получил от электроники, будучи жидкостью, в теплоноситель конденсатора. Таким образом, происходит второй фазовый переход — из пара в жидкость. Образовавшаяся капля под собственной тяжестью возвращается в общий резервуар.

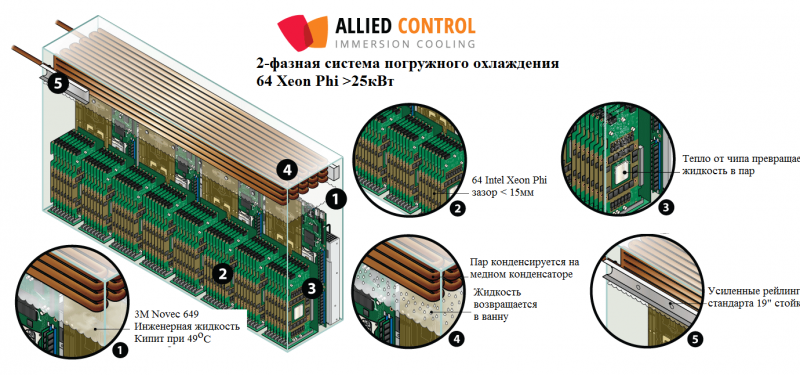

Там, где тепловыделяющие поверхности имеют сложную геометрию и требуется обеспечить экстремальную производительность при максимальной плотности размещения электроники, технология двухфазного охлаждения представляет собой самый передовой вариант. Первыми на эту технологию обратили внимание инженеры компании Allied Control (Гонконг). Их стартап, начавшийся в 2012 г. уже в первый год своего существования реализовал систему Immersion-I для охлаждения кластера из 6048 FPGA. Была достигнута рекордная для того времени энергоэффективность PUE=1,02. Через год был создан концепт на базе 64 сопроцессоров Intel Xeon Phi, который был представлен на SC13’s. Компания побила свое достижение, установив новый мировой рекорд — PUE=1,01.

В начале этого года стартап был приобретен компанией BitFury, которой технология двухфазного охлаждения необходима для построения высокоэффективной майнинговой фермы. В начале ноября было сообщено, что компании 3М и Allied Control построят в Грузии ЦОД, общей мощностью 40 МВт. При этом данная технология позволит отводить от одной стойки до 250 кВт тепловой мощности. В новом ЦОД ожидается 95%-я экономия электроэнергии, затрачиваемой на охлаждение, по сравнению с воздушными системами.

К достоинствам также относится тот факт, что плата, побывавшая в жидкости, после извлечения попадает на стол обслуживающего персонала чистая и сухая, так как остатки жидкости тут же улетучиваются.

Данный принцип пока что не получил широкого применения по причине дороговизны изготовления контейнеров (ведь в этой технологии требуется обеспечить герметичность системы с внутренним избыточным давлением), а также из-за высокой стоимости теплоносителя. Стоит заметить, что для уникальных свойств жидкости 3М, к которым относится длительный срок службы (30 лет), вредны доступ ультрафиолета и превышение рабочего давления.

Сравнительная таблица

Объединим полученные сведения в одну сравнительную таблицу:

| Компания | Технология СЖО | Возможность модернизации стандартных систем с воздушным охлаждением | Тепло-носитель -внутренний контур | Стоимость тепло-носителя | Вертикальное расположение вычислительных элементов в стойках | Использование только SSD | Снижение требований к "чистоте" помещений и пожаро-безопасности | Наличие компонентов воздушного охлаждения (вентиляторов) |

| Asetek (Дания) | Контактное - точечное | Да | Вода | * | Да | Нет | Нет | Да |

| CoolIT Systems (США) | Контактное - точечное | Да | Вода | * | Да | Нет | Нет | Да |

| ЭкоФЛОПС МК-5 (Россия) | Контактное - точечное | Да | Вода | * | Да | Нет | Нет | Да |

| Eurotech (Италия) | Контактное - плита | Нет | Вода | * | Да | Да | Нет | Нет |

| «Прософт» (Россия) | Контактное - плита | Нет | Вода | * | Да | Нет | Нет | Да |

| «РСК - Торнадо» (Россия) | Контактное - плита | Нет | Вода | * | Да | Да | Нет | Нет |

| «T-Платформы» (Россия) | Контактное - плита | Нет | Вода | * | Да | Да | Нет | Нет |

| Green Revolution Cooling (США) | Погружное - контейнер | Да | Диэлектрик | ** | Нет | Да | Да | Нет |

| IMMERS (Россия) | Погружное - контейнер | Нет | Диэлектрик | ** | Нет | Да | Да | Нет |

| Iceotope (Великобритания) | Погружное - индивидуальный корпус | Нет | Диэлектрик (3М) + Вода | *** | Да | Да | Да | Нет |

| Liquid Cool Solutions (США) | Погружное - индивидуальный корпус | Нет | Диэлектрик | ** | Да | Да | Да | Нет |

| ЭкоФЛОПС ВК-3 (Россия) | Погружное + контактное точечное - индивидуальный корпус | Да | Диэлектрик + Вода | ** | Да | Да | Да | Нет |

| Allied Control (Гон-Конг) | Двухфазное охлаждение ("кипящее") | Нет | Диэлектрик (3М) | ***** | Возможно | Да | Да | Нет |

| Вода - дистиллированная вода с присадками |

3М "кипящие" дорогие | экономит место в ЦОД | SSD - дороже | экономия на специальном оборудовании |

для "сдувания пыли" и отвода тепла от второстепенных источников тепла на мат.плате |

Очевидно, что технология охлаждения воздухом вот-вот достигнет физических пределов, но это не станет фактором, сдерживающим развитие вычислительной техники, так как уже существуют коммерческие варианты СЖО промышленного исполнения.

Приведенный обзор решений лидирующих производителей СЖО подтверждает готовность жидкостных технологий конкурировать с традиционными воздушными системами на рынке охлаждения высокопроизводительных систем. Проникновение к нам зарубежных технологии СЖО сдерживается традиционной инертностью отечественных управленцев. Однако строить с нуля легче, чем перестраивать.

В России уже началось строительство высокопроизводительных вычислительных центров, изначально спроектированных под СЖО. При этом отечественные разработчики СЖО активно включились в гонку технологий, предлагая решения, разработанные под нужды наших заказчиков. Период торговой и экономической нестабильности, а также зарождающаяся новая отраслевая ниша в сфере систем охлаждения вычислительной техники могут быть рассмотрены как благоприятные для отечественных разработчиков факторы.

В зависимости от специфики задачи, разработчик инженерной инфраструктуры сегодня имеет свободу выбора решения на базе существующих технологий. Каждая система имеет свои плюсы и минусы. Но на какой СЖО ни остановился бы выбор, в той или иной степени она покажет выигрыш в следующих аспектах:

- снижение энергопотребления;

- уменьшение требуемой площади под инженерную инфраструктуру;

- увеличение производительности;

- увеличение срока службы компонентов;

- снижение шума.

На СЖО постепенно увеличивается спрос не только в зарубежных странах, но и в России. А есть спрос — будет предложение. Успеют ли отечественные разработчики заполнить новую нишу – покажет время. Но с уверенностью можно констатировать, что время СЖО в России настало!