Одно очень древнее проклятие «Чтоб жили вы в эпоху перемен» в полной мере соответствует событиям ушедшего года. Пандемия сильно повлияла на весь мир, и не всегда очевидным образом. IT-сектор, испытав пики и провалы, сумел в итоге довольно быстро адаптироваться к новым условиям. Не все проблемы были решены, но это не остановило выход новых продуктов и технологий, о которых мы и расскажем. Материал получился большим, поэтому для удобства приведём ссылки на разделы:

CPU

В последнем отчёте о серверном рынке IDC между делом отметила, что в годовом исчислении квартальная выручка от реализации серверов на базе AMD поднялась на 112,4 %, а на чипах ARM — подскочила на 430,5 %. В обоих случаях можно сказать, что с нуля расти легко. Причём для ARM это утверждение справедливо в большей степени, чем для AMD, которая в середине года отрапортовала о двузначной доле (то есть более 10 %) на рынке серверов, не уточнив, правда, ни методику подсчёта, ни конкретные цифры.

Все, конечно, ждут официальных анонсов AMD EPYC Milan на базе Zen 3 и Intel Xeon Ice Lake-SP, о которых осталось узнать самое главное — число ядер и частотные формулы. Причём "Зеоны" задержатся с выходом, что явно пойдёт на пользу AMD. Пока же Intel напирает на конкурентоспособность грядущих CPU в высокопроизводительных вычислениях (HPC), но компании борются не только в этом сегменте, и, судя по всему, стратегия AMD по вытеснению двухпроцессорных платформ Intel однопроцессорными EPYC работает, пусть и не во всех сегментах и вертикалях. Хотя и имеет побочные эффекты.

Часть ядра AMD Zen 3. Фото: Fritzchens Fritz

Выпуск AMD EPYC Rome на базе Zen 2 в августе прошлого года привёл к быстрой (по корпоративным меркам, конечно) реакции со стороны Intel. В начале 2020 года она отказалась от M-версий Xeon Scalable второго поколения (Cascade Lake-SP) и резко снизила цены на L-версии с поддержкой большего объёма памяти, что, впрочем, актуально скорее для систем с Optane DCPMM. Ну а через пару месяцев компания представила процессоры Cascade Lake Refresh, которые по большому счёту представляют собой переформатирование имеющегося модельного ряда с кратным снижением цен.

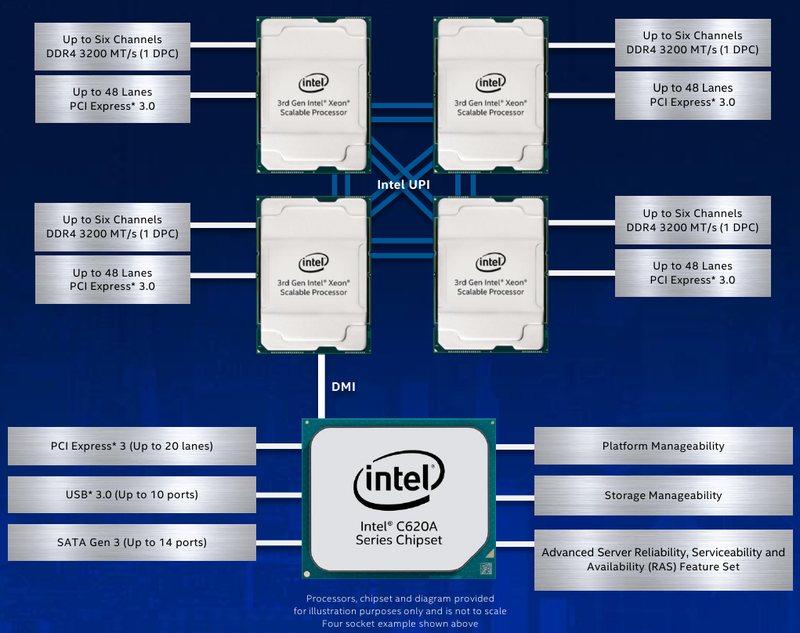

Анонс Intel Xeon Cooper Lake является значимым лишь для узкого круга потребителей, так как это далеко не массовый продукт. Да, у них стала побыстрее память, подросли частоты, появилась поддержка bfloat16 для VNNI, что, по словам Intel, даёт возможность использовать CPU не только для инференса, но и для обучения. Но главное в них всё же наличие 6 UPI-линков, позволяющих создавать бесшовные 4S/8S-системы для платформ наподобие HPE Superdome Flex 280 (224 ядра + 24 Тбайт RAM). Кроме того, это первые CPU с поддержкой Optane DCPMM (или просто PMem) второго поколения Barlow Pass.

AMD же в этом году больших анонсов не делала: чуть расширила модельный ряд «обычных» EPYC и добавила серию EPYC 7FX2 с относительно небольшим числом ядер, но со значительно увеличенными частотами и L3-кешем. Кроме того, компания обновила серию EPYC Embedded 3000 и, наконец, представила Ryzen Embedded V2000 на базе Zen 2 — это серьезное обновление по сравнению с V1500. У Intel в модельном ряду индустриальных SoC вышла целая плеяда чипов: Atom x6000E, Pentium и Celeron серий N/J, а также Core i3/i5/i7 11-го поколения (Tiger Lake).

Из альтернативных поставщиков серверных x86-процессоров осталась ещё пара, причём со сложными схемами лицензирования: тайваньская VIA и китайская Hygon. Весной снова «засветился» чип VIA CenTaur, подробности о котором стали известны ранее. Ближе к концу года китайская Zhaoxin, совместное предприятие Shanghai SASAC и VIA, получила от последней некоторые патенты на x86. Hygon же после окончательного «развода» с AMD так и осталась с Dhyana, клонами первых EPYC на базе Zen 1. И под угрозой лишения производства от GlobalFoundries пообещала перевести эти CPU на 7-нм техпроцесс Samsung или TSMC, что звучит довольно фантастично.

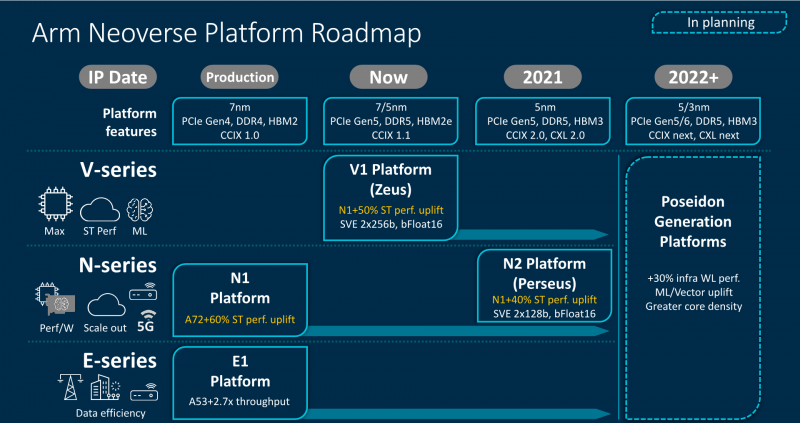

Зато в стане ARM в этом году царило большое оживление. Осенью Arm анонсировала ядра Neoverse V1 Zeus и N2 Perseus, в которых наконец появились инструкции Scalable Vector Extensions (SVE, аналог современных AVX) — в базовом варианте SVE-256, но разработчики SoC могут выбрать длину от 128 до 2048 бит — и поддержка bfloat16. Первое ядро ориентировано на максимальную производительность, пусть даже в ущерб энергоэффективности. Второе — более сбалансированное, но именно оно, по мнению Arm, станет наиболее востребованным за счёт лёгкого масштабирования SoC: от 8 до 192 ядер на кристалле с TDP от 20 до 350 Вт соответственно.

Ещё один важный шаг, даже не столько технический, сколько психологический, Arm сделала в конце года, заявив, что перенесёт большинство своих задач проектирования (EDA), автоматизации и разработки в облако AWS. Да не просто в облако, а на инстансы c ARM-процессорами Graviton2, на которые, кстати, сама Amazon стала переводить некоторые публичные сервисы AWS. И всё это произошло в тот же год, когда наследие Calxeda, первого разработчика серверных ARM CPU, закончившего свою деятельность из-за недостатка средств, было окончательно убрано из Linux.

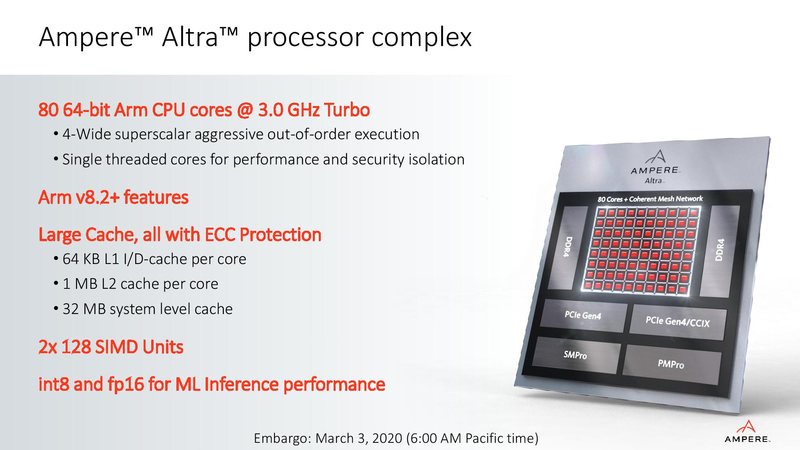

Из заметных продуктов в этом сегменте можно отметить Ampere с процессорами Altra (до 80 ядер) и Altra Max (до 128 ядер). Первые даже успели появиться в составе нескольких платформ, тесты которых внушают оптимизм и надежду на здоровую конкуренцию с x86-64. Из не самых современных, но любопытных решений можно вспомнить Bamboo. NUVIA пока ничего не выпустила, но пообещала, что Phoenix обойдут AMD и Intel. Отечественная «Байкал электроникс» ничего такого не обещает, но разрабатывает 48-ядерный "Байкал-S".

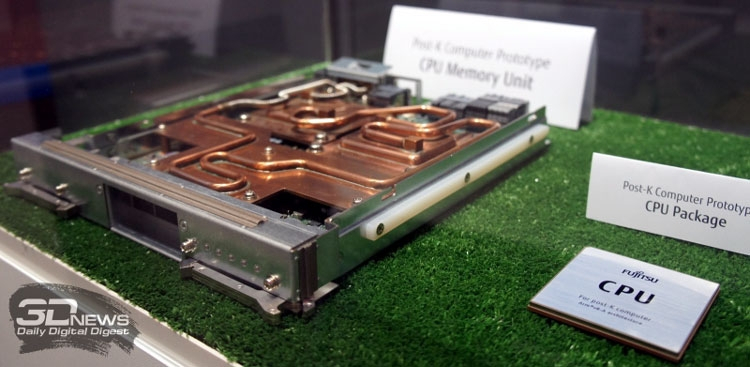

Из HPC-решений на базе ARM запомнились европейский CPU SiPearl Rhea (72 ядра), китайский Phytium Tengyun S2500 (64 ядра), а также корейский K-AB21, который в чём-то похож на непобедимый Fujitsu A64FX (48 ядер). Последний, повторимся, трудно назвать классическим CPU, так как он концептуально ближе к окончательно почившему в этом году Xeon Phi: много быстрой памяти на борту, стандартные ядра и «прилепленные» к ним сбоку инструкции SVE-512.

Но не обошлось и без потерь! Marvell внезапно отказалась от очень интересных ThunderX3, уволив команду разработчиков ровно в тот момент, когда процессоры уже были готовы. У этого семейства CPU в целом непростая судьба, но позиции были не так уж плохи: готовые платформы, партнёрства с крупными вендорами, наработки для программной экосистемы и даже парочка не самых хилых суперкомпьютеров на счету. Увы, судьба ThunderX4 теперь под вопросом.

То же можно сказать и о развитии HiSilicon KunPeng, которые стали первыми 7-нм 64-ядерными ARM-процессорами и на которые Huawei стала переводить не только свои серверы, но и другие решения, например СХД. Весной мы протестировали систему TaiShan 2280 v2 с CPU Kunpeng 920, самым мощным в серии, и отметили общую для всех новых платформ черту — не лучшую программную экосистему, во всяком случае на старте. Но на неё компания готова потратиться, равно как и на развитие партнёрских отношений, включая локализацию производства серверов в России.

Ряд санкций США в течение 2020 года последовательно лишил Huawei доступа к части ресурсов, включая и современные техпроцессы TSMC. Компания сделала запасы чипов, но насколько их хватит и как будет развиваться KunPeng, Ascend и другие серверные решения Huawei, пока не очень понятно. Загадывать не будем, лучше вспомним о более экзотических или просто менее распространённых процессорных архитектурах, которые «засветились» в ушедшем году.

Осенью были получены первые инженерные образцы "Эльбрус-16С", разработка которых вместе с "Эльбрус-12С" должна завершиться в 2021 году. А к 2025 году дело дойдёт и до 32-ядерных "Эльбрус-32С". А самой интригующей новинкой является, пожалуй, Tachyum Prodigy — разработчики обещают до 128 ядер, которые смогут справиться и с ИИ, и обычными вычислениями. А системы на их базе даже смогут запускать бинарные файлы x86, ARMv8 или RISC-V (со штрафом в производительности, конечно). Чудо, а не архитектура, но нишевая — как, например, и архитектура мейнфреймов IBM z15.

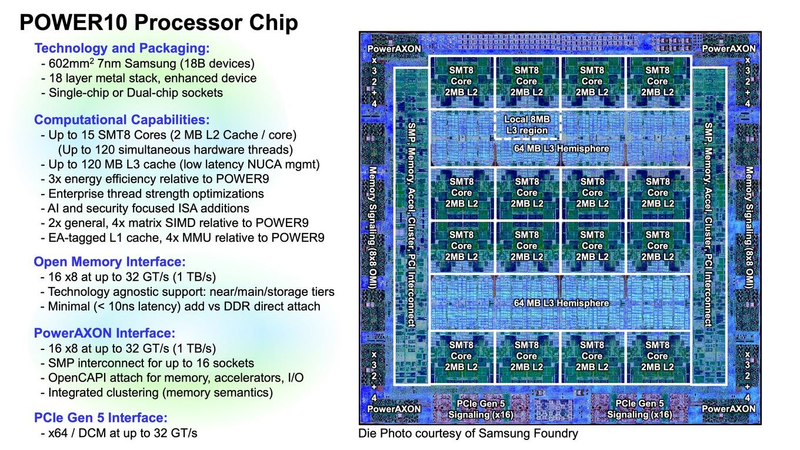

Чуть особняком стоит IBM со своими POWER10. Это очень интересные чипы, особенно в отношении памяти OMI и шин PowerAXON 2.0 и PCI Express 5.0. Но у POWER-систем небольшая доля рынка, и ни открытие ISA, ни организация OpenPOWER её заметному росту не способствовали, хотя и открыли, например, для Китая возможность использовать наработки IBM. И похоже, единственным крупным разработчиком POWER-чипов, помимо самой IBM, всё ещё остаётся китайская Suzhou PowerCore Technology, а поставщиком систем — Inspur. Но эта продукция в большей степени ориентирована на внутренний рынок.

Некоторые вообще считают, что к 2030 году массовыми будут только архитектуры x86-64, ARM и RISC-V. Последняя быстро развивается, но всё ещё очень молода. И её открытость может в конечном итоге и помочь ей, и до некоторой степени навредить из-за фрагментации. Иронично, кстати, что Arm разрешила разработчикам чипов добавлять собственные инструкции (пока только в ARMv8-M). То есть сделала ровно то, за что пару лет назад критиковала RISC-V.

Наконец, в ушедшем году было много новостей о квантовых вычислениях, которые не заменят традиционные системы, но дополнят — этот рынок был оценён в $320 млн в 2020 году, а к 2024 году он достигнет объёма $830 млн. Больше всех пока интригует компания IonQ, которая уже к 2023 году обещает выпустить модульные квантовые компьютеры для монтажа в стойку. Она же открыла собственный квантовый дата-центр и предложила бенчмарк для квантовых компьютеров. Atos тоже представила свою версию универсального бенчмарка Q-Score.

Ускорители

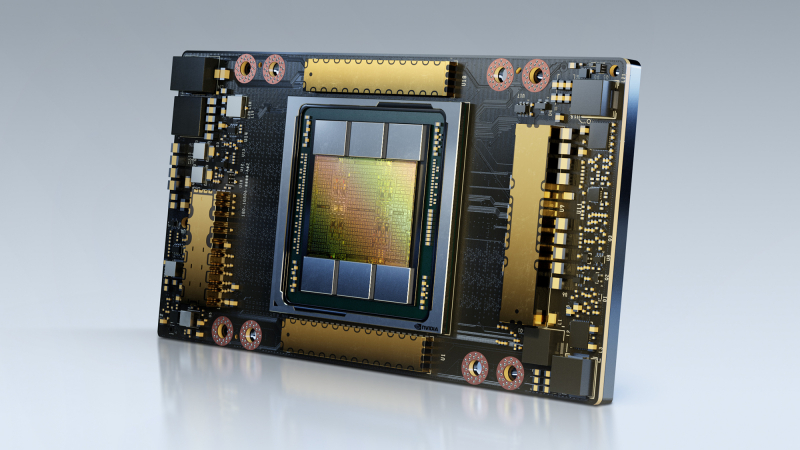

В прошлом году два главных производителя GPU представили ускорители, которые уже почти и нет смысла называть графическими. NVIDIA выпустила A100 на базе архитектуры Ampere — сначала 40-Гбайт SXM3-версию, потом в «классическом» исполнении в виде PCIe-карты, а затем 80-Гбайт SXM3-вариант. Если не говорить про простое увеличение производительности, то наиболее интересной особенностью новинок является поддержка MIG (Multi-Instance GPU) — возможности разделить ускоритель на несколько виртуальных (до 7 шт.) для наиболее полного использования ресурсов. Попутно компания также показала решения на базе A100: системы DGX/HGX, референсный дизайн суперкомпьютера DGX SuperPOD for Enterprise и рабочую станцию DGX STATION.

AMD ответила выпуском ускорителей Instinct MI100 на базе новой архитектуры CDNA, которые обгоняют A100 в FP64-производительности, но отстают в задачах машинного обучения. Intel формально представила свой первый серверный GPU на базе четвёрки Xe-LP, но предназначен он не для вычислений, а для облачного гейминга. Из других известных игроков можно вспомнить ещё NEC, которая не забросила идею векторных ускорителей и под конец года выпустила второе поколение SX-Aurora TSUBASA.

Зато ускорителей для машинного обучения появилась целая масса. И для тренировки, и в особенности для инференса (эти все перечислять устанешь). Из наиболее ярких представителей: чип Cerebras размером с целую кремниевую пластину; Groq TSP с производительностью 1 Петаопс; фотонный процессор Lightmatter; творения Tenstorrent, к которой присоединился Джим Келлер, IPU Graphcore Colossus Mk2 второго поколения, которым на смену придут уже 3-нм чипы; TPU v4 в составе самого быстрого, по мнению Google, ИИ-суперкомпьютера; Kunlun от Baidu; наконец, Habana Gaudi, на которую Intel променяла Nervana, и грядущий AWS Trainium.

FPGA тоже обзавелись тензорными и прочими ИИ-блоками. Тут можно вспомнить, например, об Intel Stratix 10 NX или решениях с Xilinx Versal AI. Переходным звеном между FPGA и ASIC обещают стать eASIC — Intel в этом году представила первое семейство N5X. Впрочем, оно относится к платформе для периферийных вычислений и 5G, куда входят и обычные FPGA, и CPU (Atom P5900). В целом же нельзя не отметить рост числа различного рода ускорителей, которые покрывают более узкие типы задач, но всё же стараются оставаться гибкими. Это привело к зарождению нового класса устройств: DPU.

DPU и SPU

DPU (Data Processing Unit) — это (со-)процессоры для обработки данных, если переводить термин дословно. Однако чёткого определения для этих устройств нет. Объединяет их то, что они берут на себя массу типовых задач, связанных с вводом-выводом и работой с данными: компрессию и дедупликацию, шифрование, контроль доступа, защиту, транскодирование и иную обработку информации. А вот делают они это совершенно по-разному. И цели тоже разнятся — от простой разгрузки CPU и до попытки полной дезагрегации ресурсов, чего отчасти пытается добиться AWS с помощью Nitro.

У таких устройств, как правило, есть собственная память (быстрая и/или ёмкая), аппаратные движки для ускорения отдельных операций, дополнительные контроллеры, какая-то программируемая логика (CPU, GPU, FPGA) и быстрая сеть/интерконнект. Всё это в том или ином виде было и в других продуктах, SmartNIC’и, например, никуда не делись. В целом DPU пытаются выстроить всю архитектуру вокруг данных, а не вокруг вычислений, как было прежде.

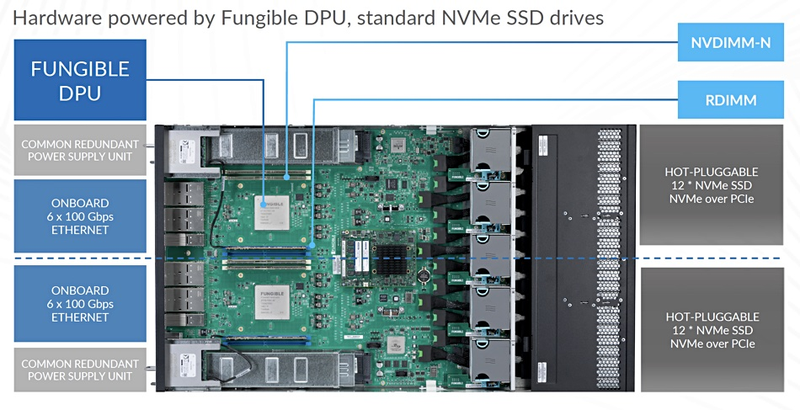

Эталоном сейчас можно назвать решение Fungible, которая вообще считает, что DPU в серверах должны стать «третьим сокетом» после CPU и GPU. Чип F1 предлагает два типа интерфейсов: 8 × 100GbE и 4 × PCIe 3.0/4.0 x16, причём PCIe включает собственный root-комплекс. Первый же продукт, СХД FS1600, показал себя очень достойно: 24 NVMe SSD (до 576 Тбайт) в 2U-шасси выдают 15 млн IOPS и 60 Гбайт/с при задержке не выше 110 мкс. То есть она в среднем в несколько раз быстрее привычных all-flash хранилищ, хотя по функциональности пока не дотягивает до них.

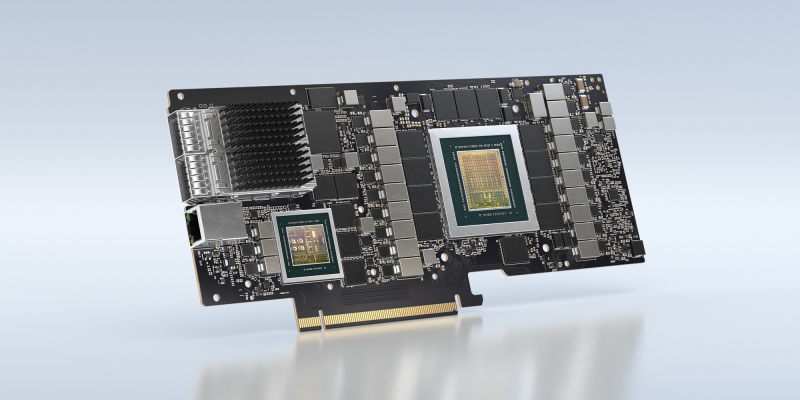

Увы, Fungible целится только в облачных провайдеров и гиперскейлеров. На эти же сегменты ориентированы и решения на базе продукции Intel: Silicom SmartNIC N5010 и Inventec SmartNIC C5020X. У обеих карт сетевая часть дополнена FPGA, а у второй есть ещё процессор Xeon-D. Именно она, несмотря на название, больше похожа на DPU. NVIDIA свои новые адаптеры, напротив, именует именно DPU: BlueField-2 и BlueField-2X основаны на ConnectX-6 Dx с ядрами ARM и VLIW, а X-версия ещё и снабжена GPU на базе Ampere. Компания позиционирует эти решения, в частности, и для периферийных вычислений в рамках платформы EGX.

Ну и для СХД с RDMA (GPUDirect Storage), которые способны «прокормить» данными DGX/HGX, они тоже нужны. Кроме того, решения Intel и NVIDIA совместимы с Project Monterey от VMware, в задачи которого входит перенос части функций — как минимум по работе с хранилищем и сетью — с CPU именно на DPU/SmartNIC. В него же входит и портированная на ARM версия ESXi. Поддержка со стороны столь крупного софтверного вендора очень важна для продвижения идей DPU.

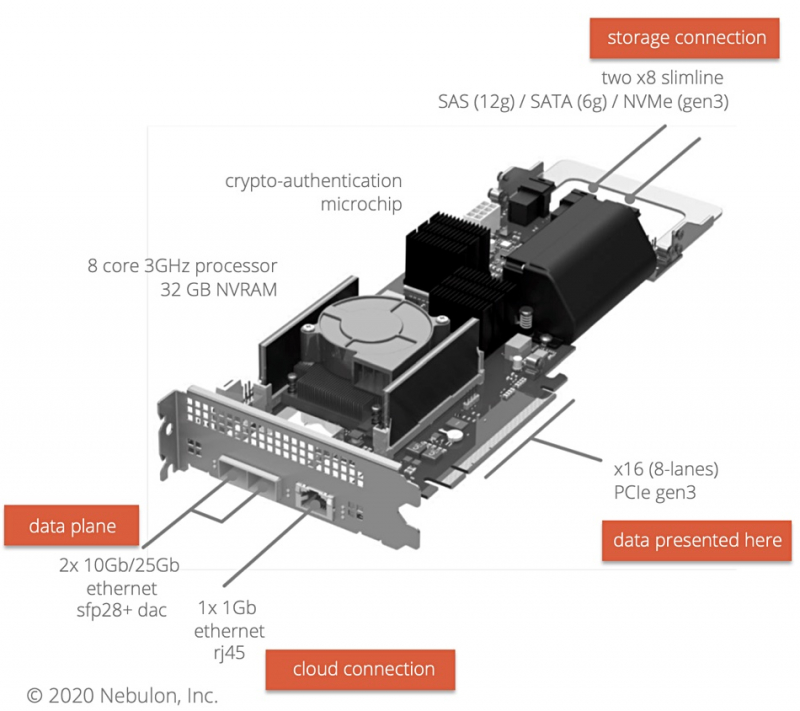

SPU (Storage Processing Unit) можно считать разновидностью DPU, но с упором именно на подсистему хранения данных. Однако и тут определение класса устройств несколько размыто. Например, Nebulon пытается совместить функции контроллера RAID/HBA и SAN: с одной стороны у него интерфейсы SAS/SATA/NVMe, с другой — 2 × 25GbE. Pliops тоже называет свой продукт Storage Processosor, но он нацелен на довольно узкую задачу оптимизации работы СУБД с SSD — он «прячет» за собой массив накопителей, предоставляя системе NVMe-интерфейс.

Память и хранилище

SPU родственны концепции computational storage, то есть обработки данных непосредственно в месте их хранения. Она не нова, но в 2020 году вышло несколько интересных SSD: от Samsung и ScaleFlux с FPGA и NGD с ARM-чипами. Сама Arm представила новую SoC Cortex-R82 специально для таких накопителей. UPMEM пошла ещё дальше, встроив сопроцессоры в DRAM-модули, и сдаваться не намерена — компания продолжает совершенствовать технологию.

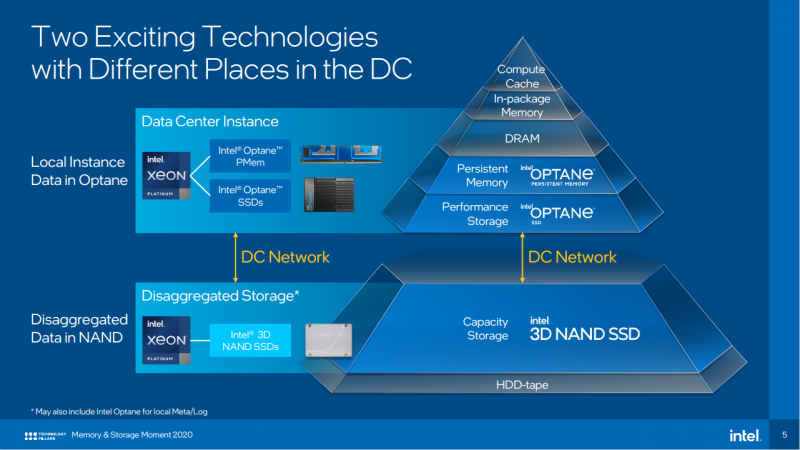

Обратный подход — принести побольше памяти поближе к CPU — оказался более жизнеспособным. Речь, конечно, про Intel Optane. Летом компания выпустила второе поколение DIMM-модулей, PMem 200. Оно несколько быстрее первого, но всё равно остаётся компонентом исключительно платформ Intel. Мы уже не раз говорили о том, что компания хочет поменять иерархию памяти, и последняя её версия выглядит вот так:

Optane (ну или другая память Storage Class Memory, SCM) дополняет DRAM и вместе с тем является хранилищем «горячих» данных. А вот NAND, нередко дополненная опять-таки SCM, относится скорее к «холодному слою» вместе с HDD и ленточными накопителями. Intel прогнозирует, что уже через пару лет совокупная стоимость владения SSD сравняется с аналогичным показателем nearline HDD, а потом будет даже ниже. Речь здесь всё же про TCO, а не про стоимость самих SSD, но основания для таких прогнозов есть.

Во-первых, ещё в конце прошлого года IDC отметила рост All-flash (AFA) и падение рынка гибридных систем хранения данных (СХД), и эта тенденция продолжилась. Впрочем, что теперь называть гибридными СХД — ещё вопрос: осенью NetApp представила FAS500f, которое формально относится к FAS-серии, куда традиционно входили гибридные хранилища, но по факту оно является AFA и базируется на QLC-накопителях. И это во-вторых: производители флеш-памяти активно осваивают производство QLC NAND с числом слоёв более 100, что позволяет значительно снизить цену и повысить ёмкость и плотность.

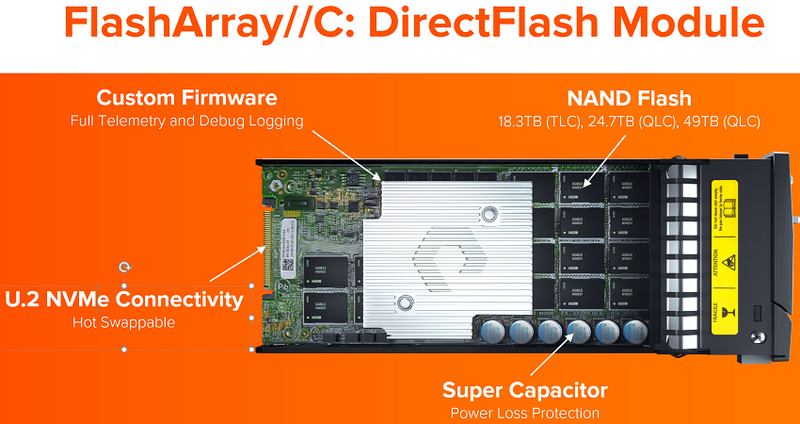

Да, QLC менее надёжная и быстрая, чем TLC и уж тем более MLC, но на это есть ответ — правильное управление данными и непосредственно флешем. В самом простом варианте это подразумевает использование кеша на базе быстрой памяти (Optane SSD или PMem, например) с анализом нагрузки и подстройкой под неё. Как, например, в StorONE S1. Но можно пойти ещё дальше, добавив компрессию и дедупликацю на лету, а также оптимизировав контроллер. Из значимых СХД такого рода можно вспомнить Pure Storage FlashArray//C и VAST Data, которые обещают приличные ёмкости и невысокую цену в сочетании с высокой скоростью, а также Flash Core Module нового поколения в IBM FlashSystem 9200.

Последние вообще очень интересны. Тут и STT-MRAM для буфера, и SLC-кеширование, и кастомный контроллер на базе FPGA, и ряд других оптимизаций. Всё это в сумме, по словам IBM, позволило «добить» характеристики QLC до уровня TLC. Аналогичные решения будут развивать и другие производители, но не обязательно такими же методами. Поможет в этом новый стандарт NVMe 2.0, который сейчас находится в разработке и некоторые возможности которого уже есть в более ранних версиях. Он ориентирован на современные архитектуры хранилищ и имеет две ключевых особенности.

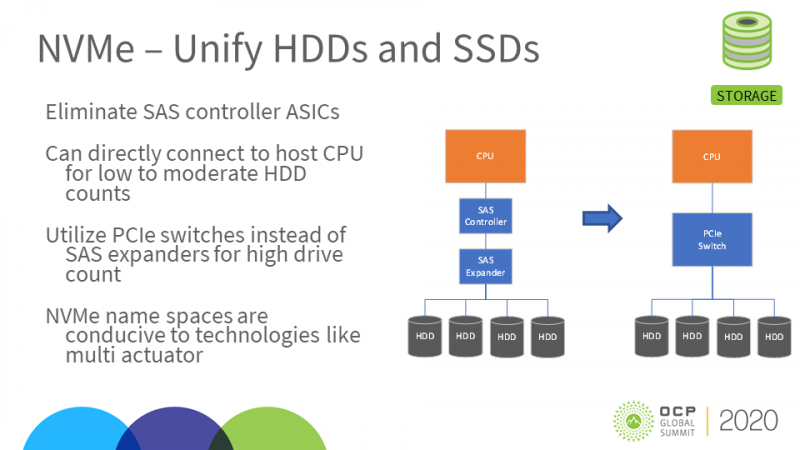

Первая — это обязательная поддержка в базовой версии NVMe-over-Fabric (NVMe-oF), передачи NVMe-команд по сети, и абстрагирование транспортного уровня. То есть NVMe больше не привязан строго к PCIe и старается стать единым интерфейсом для любых устройств хранения данных. Собственно NVMe-oF СХД уже никого не удивить, но это обычно всё же хосты с CPU, чьи PCIe-линии через свитчи делятся между SSD и сетевыми адаптерами или DPU (см. Pavilion Data, например).

Но можно пойти ещё дальше и уже сейчас встроить адаптер и NVMe-oF непосредственно в накопители, что и сделали Kioxia и Samsung. Для создания JBOF-массивов из них достаточно будет и Ethernet-коммутатора, что, правда, тоже порождает дополнительные трудности. Ну а если нужно абстрагироваться ещё сильнее, то в наборе NVMe 2.0 предусмотрена и спецификация для Key-Value-накопителей. Вполне вероятно, что появятся и другие расширения, к примеру для объектного доступа. Однако и безо всяких дополнений NVMe может преобразить облик SAN так, что 64GFC может стать последним массовым вариантом Fibre Channel (хотя реализация NVMe-oF поверх FC тоже есть).

Вторая особенность стандарта — это зонирование, которое уже стало частью NVMe 1.4 и было воплощено в Ultrastar DC ZN540. Оно, в общих чертах, подразумевает перенос логики работы с флеш-памятью с контроллера накопителя на хост, что позволяет повысить износостойкость, скорость и предсказуемость работы, но накладывает ряд ограничений. В перспективе обе эти особенности дают поддержку SMR HDD, для которых зонирование также является более чем актуальным, равно как и для QLC. И обе технологии (QLC и SMR) с нами теперь, судя по всему, уже надолго.

Из новых разработок можно вспомнить X-NAND, обещающую совместить плотность QLC и скорость SLC. Альтернативу памяти 3D XPoint, за которую, к слову, обещала взяться Micron, могут составить только вариации SLC (Z-SSD и XL-Flash) и в меньшей степени MRAM, которой активно занимаются Everspin и IBM. На противоположном конце спектра памяти тоже есть новости. Был представлен стандарт LTO-9, который позволяет создавать менее ёмкие устройства, чем ожидалось: 18 Тбайт вместо 24. Но в будущем удвоение объёма с каждым новым поколением сохранится. В экспериментах же ёмкость «ленточки» сумели довести до 580 Тбайт.

Среди продуктовых новинок нельзя не вспомнить про Intel P5800X — самый быстрый SSD в мире на текущий момент — и Nimbus ExaDrive NL (3,5” SATA/SAS, 64 Тбайт QLC), один из самых ёмких SSD, если не считать 100-Тбайт модель ExaDrive DC той же компании. Но такие накопители Nimbus — очень специфичные решения, которые пытаются заменить nearline HDD, достигшие в этом году ёмкости 20 Тбайт. Именно этот тип накопителей в ближайшее время поможет рынку жёстких дисков оставаться на плаву.

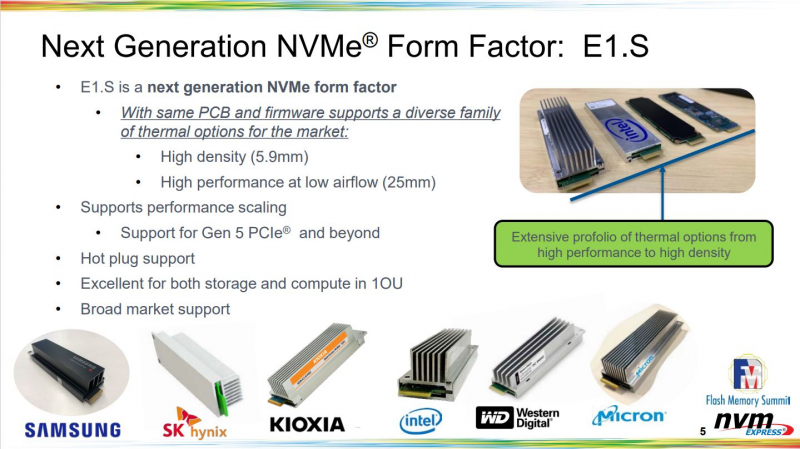

Наконец, ещё одно важное изменение касается форм-фактора — в ушедшем году практически все производители представили EDSFF-накопители. В первую очередь E1.S и E1.L. Первые идут на смену M.2, которому, видимо, останется только роль загрузочного, а вторые на пару с E3.S постараются сместить U.2. В обоих случаях речь идёт о большей гибкости при выборе между производительностью/тепловыделением и ёмкостью/плотностью. «Рулеры» E.1L уже сейчас позволяют получить порядка 1 Пбайт «сырой» ёмкости в 1U-шасси и могут быть дополнены DPU/SPU, а E1.S может быть использован не только для SSD, но и для ускорителей. Всё это сейчас актуально больше для гиперскейлеров, но мы наверняка увидим их и в корпоративных системах.

Шины и интерфейсы

Одна из ключевых и более чем ожидаемых тенденций в 2020 году — рост экосистемы PCI Express 4.0. Появилось множество компонентов: контроллеров, свитчей, адаптеров, накопителей и даже фабрик. Но это только начало, так как с выходом Intel Xeon следующего поколения поддержка PCIe 4.0 станет намного более актуальной. Однако сейчас есть рабочие компоненты PCIe 5.0, а PCIe 6.0 может быть представлен уже в следующем году.

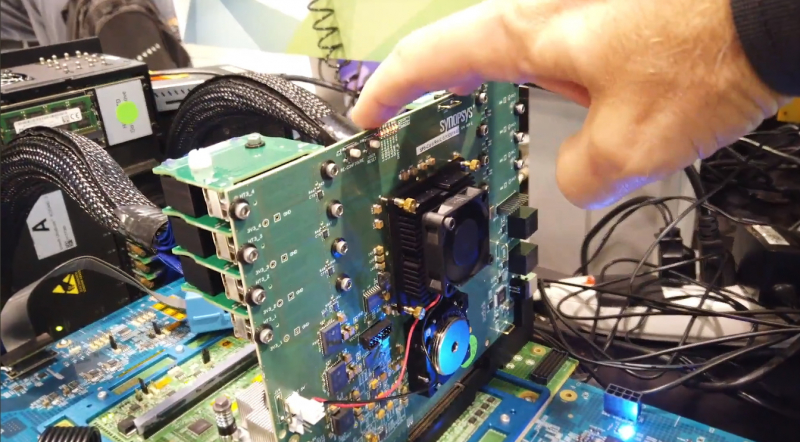

PCIe 5.0 интересен не сам по себе, а в качестве основы для стандарта Compute Express Link (CXL), который в этом году дорос до второй версии и «подружился» со стандартом Gen-Z. Оба они переопределяют способ общения устройств между собой для более эффективного обмена данными и дезагрегации ресурсов. Впрочем, о массовой поддержке CXL 1.1 и PCIe 5.0 пока говорить очень-очень рано. Равно как и о DDR5, первые модули которой успели появиться в 2020 году.

Увы, рано или поздно электрические интерфейсы перестанут быть достаточно эффективными, поэтому крупные компании уже сейчас разрабатывают решения в области интегрированной кремниевой фотоники, перед которой стоят проблемы удешевления производства (без использования германия или индия, например) и интеграции с обычной электроникой. Причём так, чтобы всё это вписывалось в массовые техпроцессы.

И в 2020 году в этой области наметился прогресс. В декабре Ayar Labs сообщила об освоении 45-нм техпроцесса GlobalFoundries для 300-мм пластин. Чуть раньше NVIDIA рассказала о возможности использования фотоники для объединения ускорителей в большие кластеры. Intel же успела доложить о текущих успехах, своём видении будущего и показала свой первый коммутатор с интегрированными оптическими трансиверами 400 Гбит/с.

Сети

Упомянутый выше коммутатор Intel включает ASIC Tofino2. Он является одним из ряда представленных в этом году решений, поддерживающих скорости 12,8 и 25,6 Тбит/c, которые открывают путь к массовым коммутаторам с портами 200/400GbE или сразу 800GbE, как у Xsight Labs, нового игрока на рынке. Аналитики предрекают резкий рост спроса на 400GbE-модели со стороны гиперскейлеров и других крупных операторов ЦОД в ближайшие пару лет. Ещё одна тенденция — уход от проприетарного «кремния» и популяризация открытых NOS вроде Cumulus (куплена NVIDIA), SONiC, Nokia SR Linux или свежей DentOS.

Индустриальный консорциум 25G Ethernet Consortium уже переименовался в Ethernet Technology Consortium и опубликовал весной первую версию спецификаций 800GbE. Однако массовыми пока остаются 25GbE-порты, а максимум, который сейчас могут предложить большинство вендоров, — это 200GbE-адаптеры (опять-таки из-за ограничений PCIe). 400G-адаптерам InfiniBand NDR уже понадобятся или 32 линии PCIe 4.0, или 16 линий 5.0. Столько же потребуется будущим поколениям внезапно возродившегося Omni-Path.

Если же говорить об абсолютных рекордах скорости, то в 2020 году снова отличился NICT: 172 Тбит/с для мультиядерного оптоволоконного кабеля длиной 2040 км, 1 Пбит/с для одного 23-км многомодового волокна и 10,66 Пбит/с для 38-ядерного многомодового волокна длиной 13 км. Правда, для пиковых результатов требуется нестандартное волокно, так что гораздо интереснее достижение скорости «всего» в 800 Гбит/с на «живой» линии связи. Кроме того, не стоит забывать про уже проложенное «тёмное» волокно, которое никуда не денется в ближайшие годы и значимость которого будет только расти.

Беспроводной сегмент по числу анонсов в 2020 году возглавляли технологии Wi-Fi 6 (E) и 5G. Обе интересны не столько высокими скоростями и низкими задержками, сколько увеличением плотности и ёмкости, что важно для IoT, IIoT и теперь ещё и AIoT. Причём 5G отчасти может заместить Wi-Fi — например, при создании частных сетей. Кроме того, 5G дала толчок развитию корпоративных и промышленных MVNO и, конечно, периферийных вычислений. Увы, России это сейчас не очень касается — 5G пока совсем мало, а сертификация Wi-Fi 6 началась только в августе прошлого года.

По прогнозам, edge-рынок вырастет до $250 млрд к 2024 году, а всего в него будет вложено $700 млрд в течение 10 лет. Важную роль в этом сыграют телеком и облака — как первого, так и второго эшелона. Крупные игроки уже предлагают различные комплексные решения по монетизации 5G — от простого CDN до аналитики и других сервисов реального времени. Более актуальными становятся модульные и микроЦОД. А в целом всё это меняет сетевой ландшафт (облачные провайдеры уже и за спутниковую связь взялись), размывает границы и требует большей автоматизации, телеметрии и защиты.

Это касается и локальных, и глобальных сетей. Но, как предсказывает MTN Consulting, к 2025 году сама структура последних существенно поменяется: традиционному телекому без сотрудничества с гиперскейлерами, видимо, будет непросто. Доходы его по итогам 2020 года заметно упадут, а расходы будут расти. Отчасти в этом виновата пандемия, которая дала кратковременные пики трафика до +30%, но со временем его рост нормализовался. А мобильный трафик, по данным Ericsson, вырос, но рост его остался в пределах нормы и до пиков 2018-2019 гг. ему далеко.

HPC

Июньский и ноябрьский рейтинги TOP500 в этом году поставили антирекорд по числу новых машин. Зато у нас появился новый лидер сразу в нескольких дисциплинах — суперкомпьютер Fugaku. Почему так — объясняется в анализе HPC-рынка от Intersect360. Но если говорить кратко, то из-за пандемии многие проекты были отложены или отменены, а некоторая часть нагрузок переехала и будет переезжать в облако. Немало мощностей, в том числе Fugaku и других суперкомпьютеров, включая российские, в ушедшем году было брошено на борьбу с коронавирусом.

В конце года нас ожидает появление первого экзафлопсного компьютера — им станет Frontier, а не Aurora — и впоследствии ряда других сверхмощных машин. Многие из этих гигантов построит HPE, которая теперь является лидером и значительно укрепила позиции после покупки SGI и Cray, и многие будут использовать свежие решения AMD. В целом первая волна ввода в эксплуатацию экзафлопсных систем должна начаться уже в 2022-2023 гг.

Отдельно отметим очевидный факт — HPC-системы становятся всё более гетерогенными. Поэтому для упрощения разработки под них Intel и AMD представили платформы oneAPI и ROCm 4.0 соответственно, которые облегчают написание единого кода для запуска на CPU, GPU, FPGA и других вычислительных архитектурах. Обе, к слову, предлагают возможность портирования CUDA-приложений.

Облака и ЦОД

В отличие от многих других рынков, которые на фоне пандемии показывали то рост, то упадок, рынки ЦОД и облаков в ушедшем году ставили один рекорд за другим. Только на слияния и поглощения (M&A) ЦОД пришлось почти $31 млрд, а запрос на новые площади настолько велик, что в аренду сдаются места в ещё не достроенных дата-центрах. Гиперскейлеры за три квартала суммарно потратили $99 млрд на капитальные вложения и открыли ещё 26 сверхкрупных ЦОД. При этом облачные провайдеры очень быстро расширяют географию присутствия, открывая всё новые регионы, а вот рынок колокации всё ещё достаточно централизован, но операторы активно налаживают связи с облаками.

Вместе с тем, с одной стороны, провайдеры стараются привлечь новых клиентов с помощью массы вариантов гибридного облака. Самым взыскательным доступны и bare-metal-хосты, и конфиденциальные вычисления. С другой — традиционные вендоры всё больше предлагают HCI-решения, решения по подписке и опять-таки возможность интеграции сразу с несколькими публичными облаками (мы наглядно убедились, что они тоже могут «лежать» по несколько часов), а это в условиях пандемии стало очень актуально.

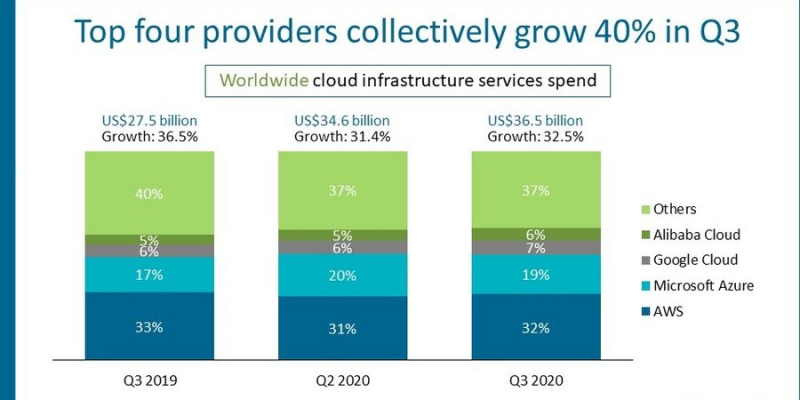

Собственно говоря, «большая четвёрка» извлекла максимум из неё — рост доходов год к году составил 40% (лидер всё так же AWS). А IDC прочат всему облачному рынку объём в $1 трлн к 2024 году. В России, для сравнения, по данным IDC, он только в 2019 году достиг отметки $1 млрд, но и у нас пандемия подстегнула его рост. Хотя локальная специфика такова, что быстрее всех растёт IaaS (причём быстрее, чем IT-рынок вообще), тогда как в мире в основном тратятся на SaaS и, чуть в меньшей степени, на PaaS. Плюс на фоне пандемии резко вырос сегмент DaaS. К тому же российские заказчики, если иного не требует закон, охотно используют зарубежные облака, которые пока напрямую разворачивать регионы или зоны в РФ не спешат.

Пандемия также «подсветила» несколько важных моментов. Во-первых, стало понятно, что недостаточно развиты средства удалённого управления ЦОД, что, как и в случае с сетями, приведёт к росту средств автоматизации, телеметрии и защиты. Во-вторых, во многих странах ЦОДы наконец были официально признаны критически важными инфраструктурными объектами.

А ещё в 2020 году операторы ЦОД и причастные активно говорили про заботу о природе. У многих крупных игроков есть официальные планы по снижению углеродного следа до нуля и устойчивому развитию к концу десятилетия. Это обычно подразумевает переход к возобновляемым и «зелёным» источникам энергии, улучшение охлаждения, отдачу мусорного тепла, общее повышение энергоэффективности, повторное использование оборудования и так далее. В некоторых странах эти меры планируют сделать обязательными для дата-центров. Но в этом есть всё же некоторое лукавство.

Например, в проекте Switch по объединению солнечной электростанции и аккумуляторов Tesla MegaPack для компании важнее то, что она получит независимый источник энергии, исключённый из общей энергосистемы. Google теперь тоже экспериментирует с заменой дизель-генераторов аккумуляторами, а Microsoft присматривается к водородным топливным элементам, но причина скорее в том, что эти технологии стали дешевле и надёжнее. Производство батарей, водорода и панелей при этом тоже нельзя назвать очень уж экологичным. Кроме того, большая тройка облаков, к примеру, всё равно закупает REC, в том числе «непривязанные», что позволяет им заявлять о 100 %-м использовании возобновляемой энергии.

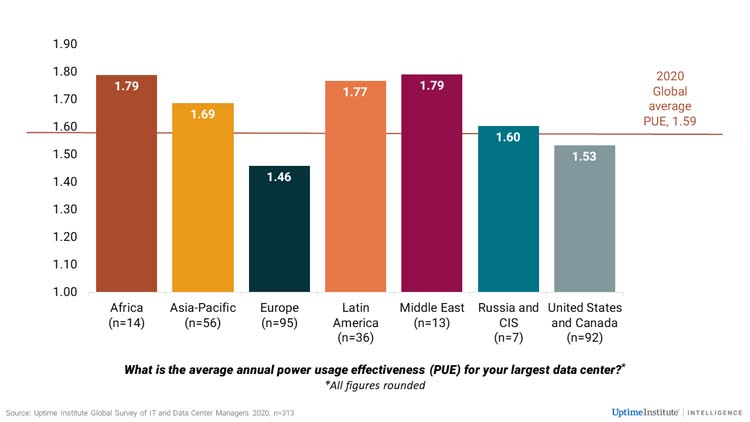

Отдача мусорного тепла в теплосети позволяет меньше думать о его утилизации. Улучшение показателей энергоэффективности само по себе экономически выгодно в долгосрочной перспективе. Но если у той же Google показатель PUE находится около 1,1, то по всему миру это значение в среднем составляет 1,59 и его падение замедлилось. В мировом масштабе на энергопотребление ЦОД всё ещё приходится лишь 1%, но такое замедление PUE может изменить картину. Кроме того, есть и другие аспекты. Гринпис, в частности, критикует крупные облака за сотрудничество с нефтедобывающими компаниями, деятельность которых отчасти нивелирует все старания облаков быть более «зелёными». А крупные ЦОД, как настоящие заводы, помимо электроэнергии требуют ещё и уйму воды.

ПО

Завершился год не лучшим образом — выявлением одной из самых значимых атак на SolarWinds, последствия которой будут «радовать» нас ещё долго. Это не первая крупная атака на цепочку поставок (supply chain), год тоже начался с раскрытия инцидента в Citrix. Увы, подобных атак в будущем будет не меньше — ускорение IT-трансформации компаний из-за пандемии более защищёнными их не делает. 2020 год вообще стал рекордным по числу выявленных уязвимостей.

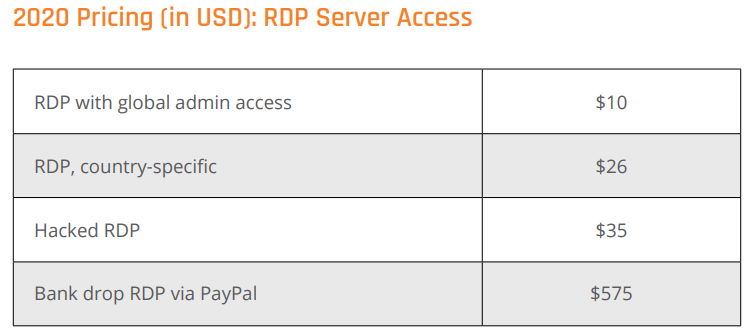

Переход на «удалёнку» спровоцировал, с одной стороны, рост атак на сервисы для совместной работы, а с другой — рост атак на RDP и прочие сервисы удалённого доступа. Так что производители вынуждены разрабатывать решения для защиты такого распределённого штата сотрудников. Сохранилась и тенденция использования злоумышленниками легитимных инструментов, что затрудняет обнаружение атак.

Другая беда 2020 года — активизация программ-вымогателей и шифровальщиков, особенно в индустриальном и медицинском секторах. Это привело к росту предложений в сфере резервного копирования и восстановления. На этом фоне в даркнете выросли цены и появились новые услуги. Наконец, рост облаков также привёл к активному развитию средств их защиты — например, стартап Lacework получил инвестиции на сумму $525 млн и теперь оценивается более чем в $1 млрд. Тут зачастую проблема в неправильных настройках и, как следствие, утечках данных.

При этом сами облака тоже меняются и предлагают всё больше и больше serverless- и managed-решений. Они готовы приютить «старые» системы, но подталкивают разработчиков к созданию cloud-native ПО, что чаще всего подразумевает использование контейнеров. Отдельной строкой надо отметить появление поддержки VMware-нагрузок в крупных облаках и вместе с тем унификацию поддержки виртуализации и контейнеризации в продуктах самой VMware.

В целом активность вокруг контейнеров сейчас очень высока. IBM они помогут в реализации облачной стратегии, а SUSE, отказавшись от Openstack, с той же целью купила Rancher Labs. Kubernetes же, самая популярная платформа для управления контейнерами, окончательно перешла на CRI, что делает её только более открытой. Побочный эффект — роль ОС как таковых несколько снижается, так как дистрибуция ПО понемногу смещается в сторону готовых образов для ВМ или контейнеров, и важнее становится оркестрация.

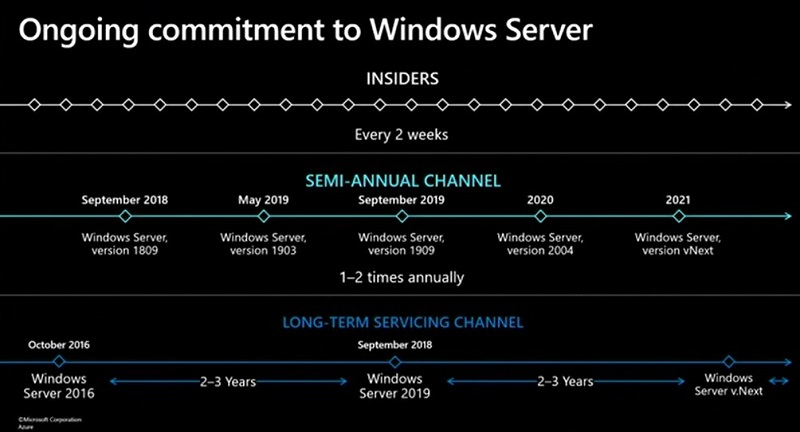

Новостей из мира ОС было немного, если не считать выходов регулярных релизов, но две из них важны. Во-первых, Microsoft, несмотря на ставку на облако, ещё раз подтвердила, что не собирается забрасывать Windows Server и что у неё есть планы минимум на три крупных релиза вперёд, первый из которых выйдет уже в 2021 году. Во-вторых, Red Hat отказалась от развития CentOS в привычном виде и собирается сделать из неё, по сути, вечную бета-версию RHEL.

Объяснения компании, почему она пошла на такой шаг, сообщество не очень убедили, а предложения альтернатив появились почти сразу после анонса: основатель CentOS представил проект Rocky Linux, CloudLinux анонсировала Lenix, а Oracle снова всем напомнила, что её форк на базе RHEL бесплатен. Из других возможных кандидатов на замену CentOS можно вспомнить ещё Springdale Linux и ClearOS. От новой CentOS Stream Red Hat вряд ли откажется, но всё ещё может пересмотреть политику лицензирования RHEL.

Из других значительных событий отметим важные релизы ядра Linux 5.8 и 5.10 — первый стал крупнейшим по количеству изменений, а второй, тоже довольно большой, принёс поддержку свежего «железа», которое массово появится на рынке в этом году. Вместе с тем было принято решение о продлении поддержки нескольких старых LTS-релизов ядра. Из мелочей: вышел унифицированный для Linux и FreeBSD релиз OpenZFS 2.0.0, готовится полноценная поддержка NTFS в ядре, а Wireguard довольно быстро влился в основные ветки ядер Linux, FreeBSD, OpenBSD, NetBSD и Android, что открывает ему возможность стать де-факто стандартом для многих VPN. Увы, полностью залечить «старые раны» от Spectre и других подобных уязвимостей не вышло.

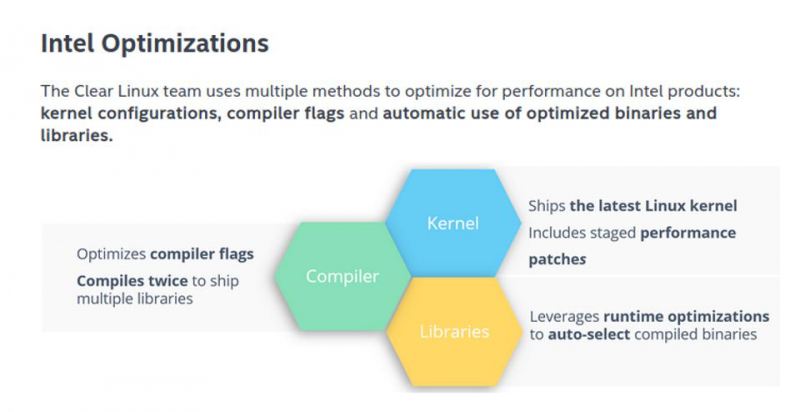

Релизы GCC 11 и LLVM 12 получили очень полезную возможность учёта различий в наборах инструкций x86-64 для более эффективной оптимизации. И в RHEL 9 планируют повысить минимальные требования до уровня x86-64-v2. Это компромисс между желанием улучшить быстродействие и желанием сохранить совместимость с широким кругом аппаратных платформ. То есть остаться по возможности универсальной ОС в отличие, например, от Intel Clear Linux, который продолжает лидировать по быстродействию.

Сделки и события

Осенью случилось крупнейшее в истории IPO софтверной компании — Snowflake была оценена в $33,6 млрд, а сейчас её капитализация выросла до $85 млрд. Тут интересна не только сумма, но и специализация: компания предлагает data warehouse в облаке. Другое рекордное IPO не состоялось — Kioxia рассчитывала получить около $19 млрд, но перенесла размещение. Возможно, оно состоится в этом году. Как и IPO SUSE, для которой оно потенциально может стать путём к обретению независимости.

Среди M&A-сделок ключевывми, конечно, являются приобретение NVIDIA компании Arm за $40 млрд и поглощение AMD крупного разработчика FPGA Xilinx, активы которого оцениваются в $35 млрд. Первая сделка обратила на себя пристальное внимание регулирующих органов Великобритании и Китая, но NVIDIA уверена в их одобрении и обещает развивать Arm. На третье место, пожалуй, можно поместить приобретение Marvell за $10 млрд разработчика сетевых решений Inphi, которое, как полагают, отражает смену приоритетов и является причиной отказа от развития ThunderX. В России пока что крупнейшей сделкой является выкуп «ИКС Холдинг» холдингом USM за $2,17 млрд.

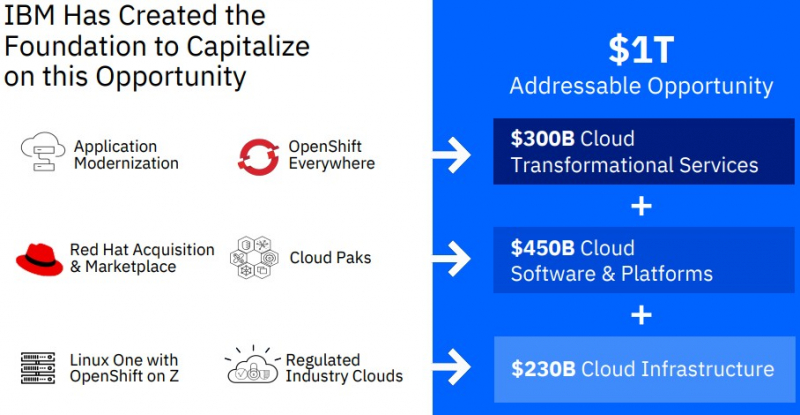

Но компании не только сливались, но и разделялись. Главное событие такого рода — вывод из состава IBM практически всего подразделения Global Technology Services, которое оказывает различного рода услуги, связанные с инфраструктурой заказчиков. А IBM и Red Hat сосредоточатся на создании гибридного облака стоимостью в $1 трлн. Такая реструктуризация, как и ожидалось, приведёт к сокращению штат. А в этом году нас может ждать ещё более значительное событие — выделение VMware в отдельную компанию.

Заключение

Безопасность и устойчивость, автоматизация и ИИ, 5G и распределённые системы — эти темы, напрямую связанные с цифровой трансформацией, будут актуальны и в 2021 году. Увы, главной из них станет именно безопасность, причём как виртуальная, так и физическая. Трансформация приведёт к большей зависимости от IT-сектора, который в ответ попытается стать более дружелюбным. Заказчику будет всё менее важно, на каком конкретно «железе» и ПО базируется услуга. И это отличный шанс для новых игроков потеснить былых гигантов. Но трансформация будет таить в себе всё более нарастающую комплексность — и вот она-то и преподнесёт нам главные сюрпризы в будущем.

Чтобы ничего не пропустить в новом году, подпишитесь на нас в Twitter, Telegram, LinkedIn, Google News или Zen.