Лента новостей

|

15.08.2023 [16:20], Владимир Мироненко

ITGLOBAL.COM возобновил предоставление услуги Exchange CloudПоставщик ИТ-услуг, продуктов и сервисов ITGLOBAL.COM объявил о возобновлении работы облачного сервиса корпоративной почты на базе Microsoft Exchange в рамках услуги Exchange Cloud. ITGLOBAL.COM отмечает, что Microsoft уже более десяти лет предлагает сервисы Office 365, включающие и корпоративную почту, которые для многих оказались выгоднее, чем предложения локальных провайдеров. В результате последние со временем отказались от предоставления таких услуг. Однако уже более года Microsoft планормерно сворачивает свою деятельность в России и Беларуси. «Для всех клиентов, которые хотят продолжать пользоваться Microsoft Exchange, мы реанимировали свою услугу Exchange как сервис, которая построена на базе ПО Microsoft и высокодоступной инфраструктуры без единой точки отказа. На сегодня это единственный легальный способ использовать продукты Microsoft, имея все актуальные версии, обновления и поддержку от наших специалистов», — сообщил ITGLOBAL.COM.

Источник изображения: Microsoft Провайдер предоставляет аренду почтовых ящиков по модели SaaS. По словам директора по развитию сервисов ITGLOBAL.COM, сервисом Exchange Cloud активно пользуются компании, ранее пользовавшиеся Office 365, что позволяет сохранить привычный формат и инструменты работы.

15.08.2023 [14:12], Сергей Карасёв

Стартап Modular ищет финансирование, чтобы бросить вызов NVIDIA на рынке ИИМолодая компания Modular, по сообщению ресурса The Information, обсуждает возможность получения финансирования с рядом потенциальных инвесторов, включая General Catalyst. Ожидается, что в случае проведения раунда поддержки Series A рыночная стоимость стартапа составит приблизительно $600 млн. Modular ищет средства, чтобы бросить вызов NVIDIA на рынке ИИ. Дело в том, что стартап разрабатывает специализированное ПО, которое, по её заявлениям, позволяет компаниям, создающим модели ИИ, отказаться от дорогостоящих ускорителей NVIDIA в пользу более доступных и менее дефицитных аппаратных решений, в том числе от AMD, Intel или Google.

Источник изображения: pixabay.com Софт Modular работает путём унификации доступа к популярным ИИ-фреймворкам, таким как PyTorch и TensorFlow, с использованием модульных компонуемых элементов. Проще говоря, разработчики могут использовать разнообразное (в том числе кастомное) оборудование для обучения ИИ-моделей, а затем развёртывать их на любом сервере или периферийном устройстве. В 2022 году соучредитель и генеральный директор Modular Крис Латтнер (Chris Lattner) заявил, что стартап нацелен на оптимизацию жизненного цикла разработки ИИ благодаря автоматизации и стандартизации процессов разработчиков. Латтнер был соавтором языка программирования Swift во время работы в Apple. Другим соучредителем стратапа является Тим Дэвис (Tim Davis), который ранее руководил разработками в области машинного обучения, компиляторов и других компонентов в Google Cloud. По этой причине, считают эксперты, Modular вызывает интерес со стороны ряда крупных потенциальных инвесторов. Нужно отметить, что появление стартапов вроде Modular происходит на фоне того, как многие участники ИИ-рынка ищут альтернативы решениям NVIDIA, поскольку ситуация обостряется из-за дефицита ускорителей H100/A100.Например, MosaicML объявила, что смогла перенести обучение ИИ с NVIDIA A100 на AMD Instinct MI250 без модификации кода и свободно переключаться между ускорителями во время тренировки модели. Это стало возможно благодаря сотрудничеству AMD и PyTorch. К PyTorch Foundation присоединилась и Intel.

15.08.2023 [12:27], Сергей Карасёв

Спрос на традиционные серверы сокращается из-за развития ИИ-рынкаПродажи традиционных серверов в глобальном масштабе сокращаются, о чём сообщает ресурс MarketWatch, ссылаясь на аналитика Susquehanna Мехди Хоссейни (Mehdi Hosseini). Основная причина падения спроса заключается в том, что гиперскейлеры и операторы ЦОД переключают внимание на системы, оптимизированные для ИИ. Отмечается, что в III квартале 2023 года мировые отгрузки стандартных CPU-серверов могут оказаться «разочаровывающими». Поставки таких систем могут сократиться на 20 % в годовом исчислении, в то время как продажи ИИ-решений вырастут на 23 %.

Источник изображения: Microsoft В целом, отгрузки серверов в III четверти текущего года окажутся на 3 % больше по сравнению с предыдущим кварталом. Это намного меньше прежнего прогноза, составлявшего 10 %. Свежие данные указывают на существенное замедление темпов развития мировой отрасли дата-центров, о чём говорят и другие исследования. В июле председатель правления TSMC Марк Лю (Mark Liu) заявил, что из-за растущего спроса на системы ИИ снижаются продажи традиционных процессоров для серверов. По оценкам, генеративный ИИ будет главной технологической тенденцией на следующие три года, при этом 75 % директоров IT-компаний либо тестируют соответствующие технологии, либо уже внедряют подобные проекты.

14.08.2023 [23:48], Руслан Авдеев

«Яндекс» приобрёл у «Билайна» 70 тыс. SIM-карт для своих самокатов, часть из них будет работать в роуминге в КазахстанеКомпания «Яндекс» развивает кикшеринговый сервис в Казахстане. Как сообщают «Ведомости», сетевое подключение самокатов обеспечат SIM-карты «Билайна». Правда, использовать их будут в режиме роуминга. Не исключено, что «Яндексу и вовсе придётся перейти на SIM-карты местных операторов. По данным источников издания, пока флот самокатов компании в Казахстане относительно невелик и составляет около 5 тыс. единиц. Издание отмечает, что обслуживание одной SIM обходится в 40 руб./мес., но даже в роуминге с учётом небольшого объёма M2M-трафика стоимость будет ненамного больше. По данным «Билайна», поставки карт для работы самокатов «Яндекса» в Алма-Ате начались ещё в марте. Более того, часть SIM, как сообщается, доставлена в Китай, где производят самокаты. Всего «Билайном», по данным источников СМИ, с начала года было поставлено 50 тыс. SIM-карт для самокатов «Яндекса», а в прошлом и позапрошлом году порядка 20 тыс. карт совокупно.

Источник изображения: "Яндекс" В августе власти Казахстана потребовали локализации данных местных пользователей. Хотя у «Яндекса» имеются серверные мощности в стране, весьма вероятно, что роуминг и передачу информации за рубеж сочтут неприемлемой, поэтому «Яндексу» всё равно придётся сотрудничать с местными операторами. Предполагается, что стоимость обслуживания российских карт в роуминге и казахстанских альтернатив будет сопоставимой. Местный оператор Beeline представляет собой самостоятельную структуру, поэтому российским SIM «Билайна» всё равно придётся работать в роуминге. Как сообщают «Ведомости», в России насчитывается порядка 200 тыс. кикшеринговых электросамокатов. Для большей стабильности обслуживания некоторые сервисы используют SIM-карты двух операторов одновременно.

14.08.2023 [23:02], Алексей Степин

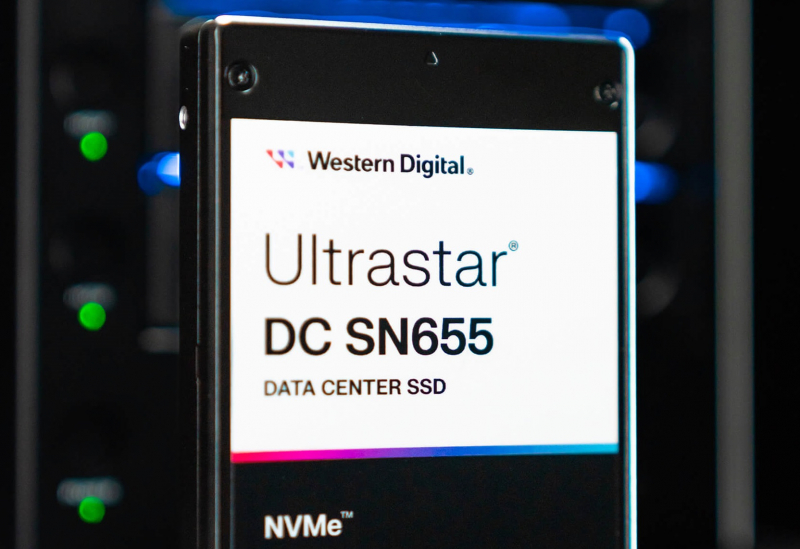

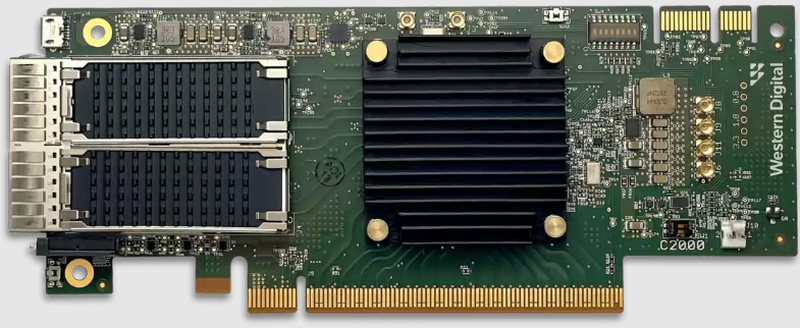

Western Digital обновила JBOF-платформу OpenFlex Data24 и представила NVMe SSD серии UltraStar DC SN655Western Digital обновила платформу OpenFlex. Новая версия OpenFlex Data24 3200 представляет собой решение класса NVMe-oF JBOF на базе хост-адаптеров серии RapidFlex C2000, использующих фирменные ASIC A2000. Адаптеры имеют интерфейс PCIe 4.0 x16 и два 100GbE-порта, поддерживают NVMe/TCP и RoCE v1/v2 и отличаются низким уровнем задержки. Более того, они могут выступать как в роли целевого (target) устройства, так и в качестве инициатора. Дисковое шасси имеет форм-фактор 2U и поддерживает установку до 24 накопителей NVMe в форм-факторе U.2/U.3. Оно также имеет шесть слотов PCI Express x16 для установки адаптеров WD RapidFlex C2000. При этом имеется отдельный чип BMC и выделенный 1GbE-порт для удалённого мониторинга и управления. Благодаря шести слотам расширения доступно подключение до шести хост-систем без применения дополнительного коммутатора. .

Для обновлённого хранилища WD подготовила и новые двухпортовые SSD (PCIe 4.0, NVMe 1.4b), представив модель Ultrastar DC SN655 в форм-факторе U.3 (15 мм), которая пришла на смену SN650. В основе новых NVMe-накопителей лежит 112-слойная TLC-память WD/Kioxia BiCS6. Максимальный объём составляет 15,38 Тбайт, а уровень износостойкости равен 1 DWPD. Поддерживается защита SE/ISE/TCG Ruby. Накопители рассчитаны на работу при температуре от 0 до +70 °C. Энергопотребление не превышает 20 Вт. Скорость последовательного чтения составляет 6,8 Гбайт/с, а скорость записи зависит от объёма и варьируется в пределах 2–3,7 Гбайт/с. Максимальная производительность на случайных операциях достигает 1,1 млн IOPS при чтении и 125 тыс. IOPS при записи (модель 15,38 Тбайт), а уровень задержки не превышает 100 и 15 мс соответственно. SSD оптимизированы для нагрузок с большим неструктурированным потоком данных. Гарантийный период — пять лет. Показатель MTBF составляет 2,5 млн часов.

14.08.2023 [22:25], Руслан Авдеев

ИИ для телекома: SK Telecom вложила $100 млн в стартап Anthropic, чтобы получить кастомную большую языковую модель для своего бизнесаЮжнокорейский телеком-оператор SK Telecom инвестировал $100 млн в стартап Anthropic, основанный бывшими топ-менеджерами OpenAI и занимающийся генеративным ИИ. Как сообщает DataCenter Dynamics, сделка предусматривает не только инвестиции, но и совместную работу над большими языковыми моделями (LLM), специально оптимизированными для телекоммуникационных компаний. На первом этапе будет создан специальный вариант более общей модели Claude. Новый вариант научится понимать корейский, японский, английский, немецкий, испанский и арабский языки. Курировать работу будет один из основателей стартапа и его главный научный сотрудник Джаред Каплан (Jared Kaplan). Готовая модель поступит в распоряжение группы Global Telco AI Alliance, основанной в прошлом месяце SK Telecom, Deutsche Telekom, e& и Singtel. LLM будет применяться для обслуживания клиентов телеком-сервисов, а также для маркетинга, продаж и других целей. По словам Anthropic, SK Telecom намерена использовать ИИ для «преображения» телекоммуникационной отрасли. Стартап намерен объединить свои навыки в сфере ИИ с опытом SK Telecom в телекоммуникационном бизнесе. При этом последняя уже работает над LLM — в феврале появилась информация о том, что южнокорейская компания удвоила мощность ИИ-суперкомпьютера Titan, ответственного за работу корейского варианта GPT-3 — модели Aidat (A dot).

Источник изображения: Anthropic С самого начала своего существования Anthropic была хорошо воспринята техногигантами. Среди её инвесторов уже числится Google, вложившая в стартап $300 млн, а всего компания привлекла более $1,5 млрд, причём в числе инвесторов, получивших долю в компании, оказалось и другое подразделение SK Group — SK Telecom Ventures.

14.08.2023 [21:37], Сергей Карасёв

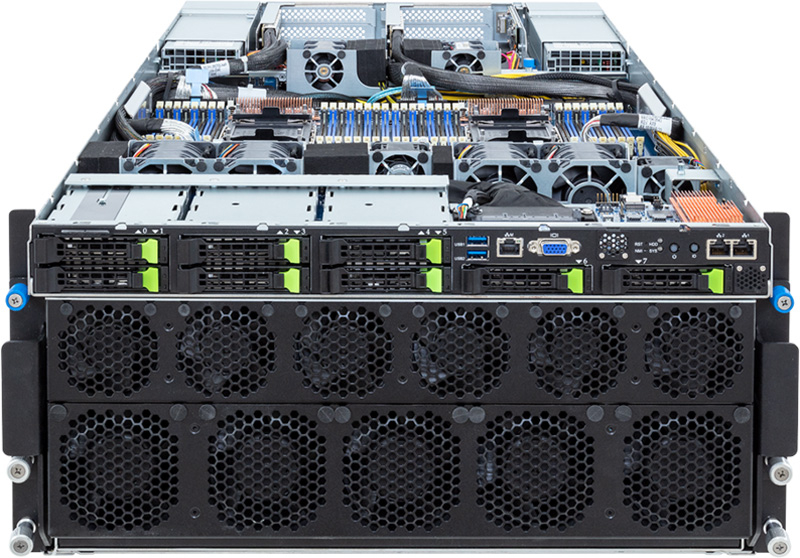

С СЖО и без: Giga Computing (Gigabyte) выпустила новые серверы на базе Xeon Sapphire Rapids и NVIDIA HGX H100Компания Giga Computing (Gigabyte), серверное подразделение Gigabyte, анонсировала стоечные серверы G363-SR0 и G593-SD2, выполненные в форм-факторе 3U и 5U соответственно. В основу положены процессоры Intel Xeon Sapphire Rapids и платформа NVIDIA HGX H100. Обе новинки допускают установку двух процессоров в исполнении LGA 4677 (Socket E) с показателем TDP до 350 Вт. Диапазон рабочих температур — от 0 до +35 °C. Модель G363-SR0 оснащена системой прямого жидкостного охлаждения (DLC). Доступны 16 слотов для модулей оперативной памяти DDR5-4800 ёмкостью до 256 Гбайт каждый. Могут быть подключены восемь SFF-накопителей NVMe/SATA/SAS с возможностью горячей замены. Поддерживаются массивы SATA RAID 0/1/10/5. В оснащение входят по два сетевых порта 1GbE и 10GbE, выделенный порт управления 1GbE, два порта USB 3.2 Gen1 и интерфейс Mini-DP. За возможности расширения отвечают шесть слотов PCIe 5.0 x16 (два спереди, четыре сзади), коннекторы OCP 3.0 и М.2 (PCIe 4.0 x4). Задействованы четыре ускорителя NVIDIA H100 (SXM5). Установлены три блока питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium.

Источник изображений: Giga Computing Сервер G593-SD2, ориентированный на задачи ИИ и НРС, располагает 32 слотами для модулей DDR5-4800 и восемью ускорителями NVIDIA H100 (SXM5). Спереди есть восемь отсеков для SFF-накопителей NVMe/SATA/SAS. Данная модель использует воздушное охлаждение и шесть блоков питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Предусмотрены 12 слотов PCIe 5.0 x16, два сетевых порта 10GbE, выделенный порт управления 1GbE, два порта USB 3.2 Gen1 и интерфейс D-Sub.

14.08.2023 [17:37], Алексей Степин

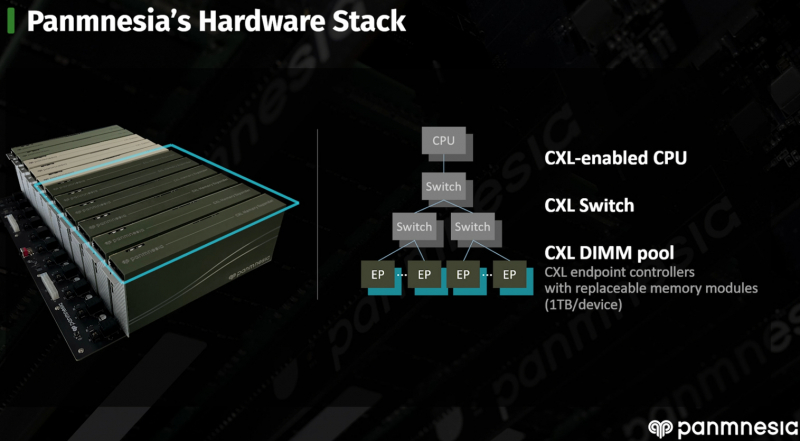

CXL-пул Panmnesia втрое быстрее RDMA-систем и может предложить 6 Тбайт RAMНа конференции Flash Memory Summit южнокорейская компания Panmnesia продемонстрировала свою версию CXL-пула DRAM объёмом 6 Тбайт на базе программно-аппаратного стека собственной разработки. Новинка продемонстрировала более чем троекратное превосходство над системой, построенной на базе технологии RDMA, в нагрузках, связанной с работой рекомендательной ИИ-системы Meta✴. Panmnesia разработана в сотрудничестве с Корейским инститом передовых технологий (KAIST). О более раннем варианте разработок KAIST в этой области мы рассказывали в 2022 году. Коммерческий вариант комплекса поддерживает CXL 3.0 и состоит из CXL-процессора, коммутатора и модулей расширения памяти. Все модули выполнены в форм-факторе, чрезвычайно напоминающем FHFL-карты. Модули устанавливаются в универсальное шасси, при этом их можно произвольно комбинировать. Демо-платформа содержала два процессорных модуля, три модуля коммутации и шесть 1-Тбайт модулей памяти. Модули памяти построены на базе обыкновенных DIMM-планок и поддерживают их замену и расширение. Реализован не только режима CXL.mem, но и CXL.cache и CXL.io. При этом компания предлагает не только готовые IP-решения, но и их кастомизацию под конкретного заказчика, что поможет оптимизировать цикл создания продукта и снизить общую стоимость разработки и валидации. Фирменное ПО базируется на Linux и содержит необходимые драйверы, а также специализированную виртуальную машину, с помощью которой пространство памяти представляется в виде безпроцессорного NUMA-узла. Поверх этих компонентов функционирует пользовательская часть, отвечающая за эффективное размещение и предвыборку (prefetching) данных. По ряду параметров Panmnesia можно назвать лидером в области CXL-решений. В частности, по объёму DRAM она уже обгоняет совместное решение Samsung, MemVerge, H3 и XConn, а использование DIMM-модулей только придаёт ей гибкости. Развитая программная часть, как утверждается, упрощает и удешевляет интеграцию в существующую инфраструктуру ЦОД. Спектр применения, как и у всех систем CXL-пулинга, крайне широкий и включает в себя не только ИИ-сценарии, но и любые задачи, требующие большого объёма оперативной памяти.

14.08.2023 [16:39], Сергей Карасёв

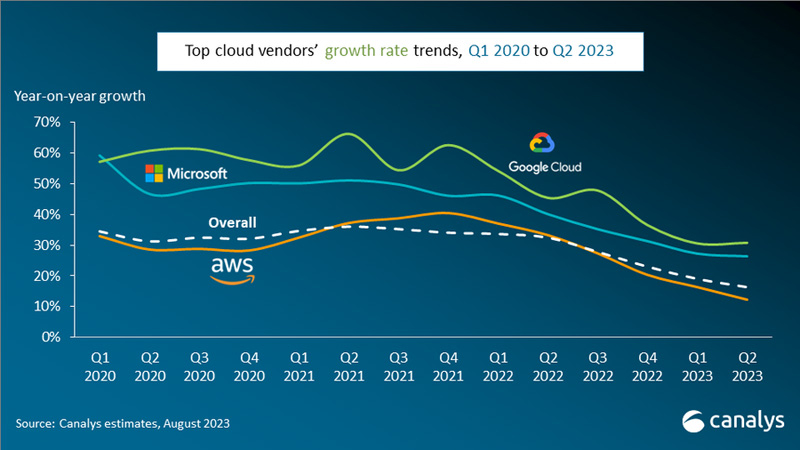

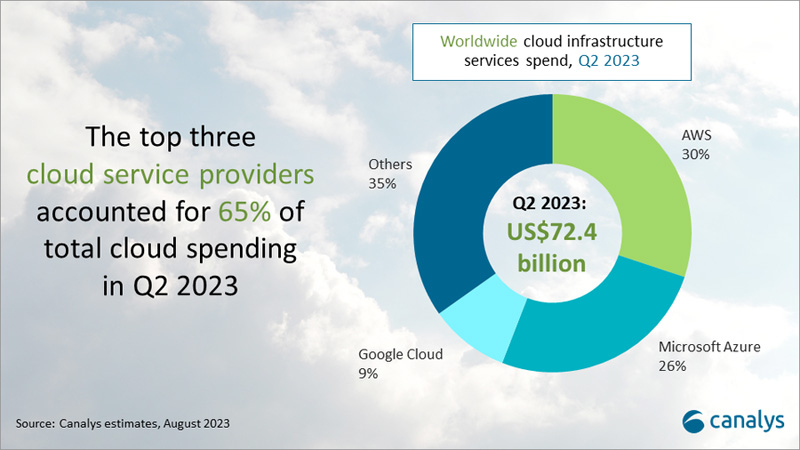

Квартальный объём мирового рынка облачных инфраструктур превысил $70 млрд, но темпы роста сокращаютсяКомпания Canalys опубликовала результаты исследования мирового рынка облачных инфраструктур во II квартале 2023 года. Объём отрасли достиг $72,4 млрд, что на 16 % больше прошлогоднего результата. В I четверти 2023-го темпы роста были выше — 19 %, а годом ранее и вовсе превышали 30 %. Аналитики отмечают, что сохраняющаяся макроэкономическая неопределённость вынуждает клиентов по-прежнему сосредоточивать усилия на оптимизации использования облака для снижения затрат. Вместе с тем основным драйвером инвестиций в облачные технологии остаётся ИИ.

Источник изображений: Canalys Во II квартале 2023 года три ведущих поставщика услуг — AWS, Microsoft Azure и Google Cloud — в совокупности увеличили выручку на 20 % в годовом исчислении по сравнению с 22 % в II квартале. Их суммарная доля составила 65 % от общих расходов. При этом рост бизнеса AWS и Microsoft замедлился, в то время как темпы развития Google Cloud остались стабильными по сравнению с предыдущим кварталом и составили 31 %. Платформа AWS продолжает лидировать на рынке услуг облачной инфраструктуры: во II квартале 2023 года на её долю приходилось 30 % общих расходов, а рост в годовом исчислении оказался на уровне 12 %. Amazon инвестировала $100 млн в новую программу обучения работе с генеративным ИИ, которая, как ожидается, поможет предприятиям ускорить разработку соответствующих сервисов.  Доля Microsoft Azure составила 26 % рынка, рост выручки по сравнению с прошлым годом — 26 %. Увеличение количества заказов на облачные услуги зафиксировано на уровне 19 % — до $224 млрд. Корпорация привлекла к своей службе Azure OpenAI ряд крупных клиентов, включая Ikea, Volvo Group и Zurich Insurance. Облако Google Cloud выросло на 31 % в годовом исчислении, показав лучший результат среди трёх ведущих гиперскейлеров. Доля компании составила около 9 %. Подход к увеличению периода амортизации серверов и сетевого оборудования помог контролировать эксплуатационные расходы и повысил прибыльность Google Cloud.

14.08.2023 [16:18], Сергей Карасёв

Темпы роста выручки облачного подразделения Alibaba замедлилисьКитайский гигант Alibaba Group Holding отрапортовал о работе во II четверти 2023 финансового года, которая была закрыта 30 июня. Общая выручка достигла ¥234,16 млрд (примерно $32,29 млрд), что соответствует росту на 14 % по сравнению с тем же периодом 2022 года. Чистая прибыль корпорации составила ¥33,0 млрд, или $4,55млрд. Рост по отношению ко II кварталу 2022-го зафиксирован на отметке 63 %. Прибыль в пересчёте н одну ценную бумагу равна ¥1,66, или около $0,23. Подразделение облачных сервисов Cloud Intelligence Group показало квартальную выручку в размере ¥25,12 млрд ($3,47 млрд), что только на 4 % больше прошлогоднего результата. Это говорит о снижении темпов развития соответствующего направления, что объясняется в том числе макроэкономическими факторами.

Источник изображения: Alibaba Вместе с тем скорректированный показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) в облачной группе взлетел в годовом исчислении на 106 % — до ¥387 млн, или $53 млн. Связано это с ослаблением ограничений, введённых в ответ на пандемию COVID-19, а также со снижением расходов корпоративных заказчиков на фоне кризиса. Говорится, что Cloud Intelligence Group продолжает развивать направление генеративного ИИ. В частности, в апреле нынешнего года была запущена платформа Tongyi Qianwen — чат-бот наподобие ChatGPT американской OpenAI. Кроме того, обновлена аудиосистема Tingwu с добавлением возможности анализа совещаний на основе ИИ. Весной нынешнего года совет директоров Alibaba Group Holding одобрил полное выделение облачного подразделения Cloud Intelligence Group в самостоятельную публичную компанию. Её акции будут торговаться на бирже. В преддверии процедуры IPO корпорация значительно снизила цены на облачные услуги, что также могло повлиять на квартальные результаты. |

|