Лента новостей

|

11.05.2024 [14:00], Сергей Карасёв

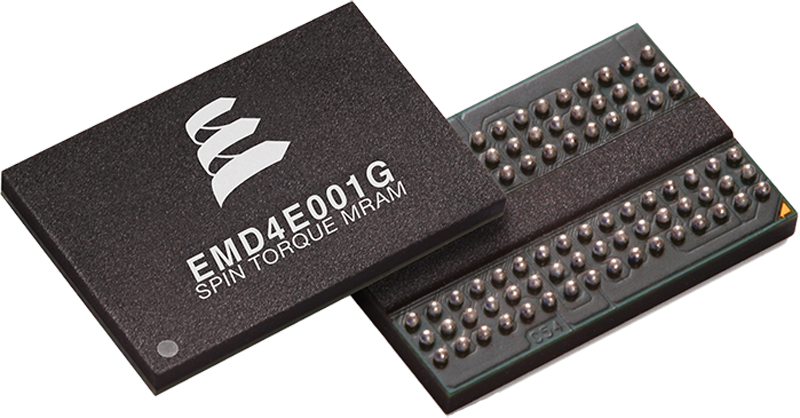

IBM оснастит накопители FCM четвёртого поколения памятью Everspin STT-MRAMКомпания Everspin Technologies сообщила о том, что её чипы магниторезистивной памяти с произвольным доступом (MRAM) войдут в состав вычислительных накопителей IBM FlashCore Modules (FCM) четвёртого поколения. Это обеспечит дополнительный уровень защиты данных при отключении питания. Речь идёт о применении изделий Everspin Persyst EMD4E001G ёмкостью 1 Гбит. Эти высокопроизводительные энергонезависимые чипы выполнены по технологии STT-MRAM (запись данных с помощью переноса спинового момента).

Источник изображения: Everspin Изделия Everspin используют интерфейс DDR4. Заявленная скорость передачи информации в режимах чтения и записи достигает 2,7 Гбайт/с. В случае внезапного сбоя питания критически важные данные могут быть быстро перенесены в память STT-MRAM, что обеспечит их сохранность. Что касается FCM4, то это проприетарные накопители IBM, выполненные на 176-слойных чипах TLC NAND. Вместимость составляет 4,8, 9,6, 19,2 или 38,4 Тбайт. Реализована технология защиты от вредоносного ПО, работающая на уровне прошивки. Накопители анализируют I/O-операции с помощью ИИ-алгоритмов, оперативно выявляя проникновение программ-вымогателей и других зловредов. Согласно прогнозам Technavio, показатель CAGR (среднегодовой темп роста в сложных процентах) на мировом рынке MRAM составит 37,39 % до 2026 года. Таким образом, прирост продаж в денежном выражении с 2021-го по 2026 год достигнет $1,43 млрд.

11.05.2024 [13:52], Сергей Карасёв

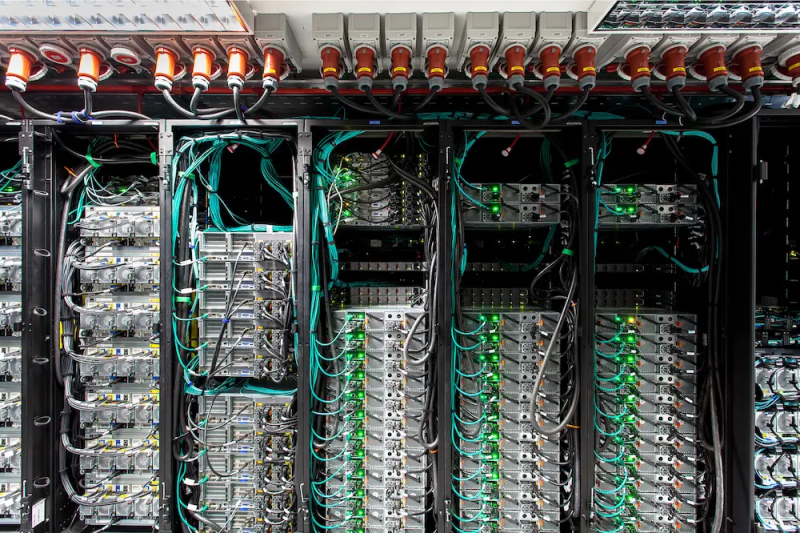

CoreWeave вложит £1 млрд в ИИ ЦОД в ВеликобританииКомпания CoreWeave, специализирующаяся на предоставлении облачных услуг для решения ИИ-задач, по сообщению Datacenter Dynamics, намерена активно развивать бизнес в Великобритании. В ближайшее время в соответствующие проекты планируется инвестировать £1 млрд (приблизительно $1,25 млрд). Отмечается, что CoreWeave уже открыла представительство в Лондоне, которое станет европейской штаб-квартирой компании. В 2024 году CoreWeave намерена запустить в Великобритании два дата-центра с последующим развитием инфраструктуры в 2025-м. Подробности об этих ЦОД пока не раскрываются. Майк Интратор (Mike Intrator), соучредитель и генеральный директор CoreWeave, заявил, что укрепление присутствия в Великобритании является важной вехой на пути дальнейшего развития компании. CoreWeave рассчитывает разворачивать облачные сервисы на местном рынке, предоставляя клиентам вычислительные ресурсы для внедрения приложений ИИ.

Источник изображения: CoreWeave Стартап CoreWeave, основанный в 2017 году, изначально занимался майнингом криптовалют. Затем компания переориентировалась на вычисления общего назначения и хостинг проектов генеративного ИИ. Недавно CoreWeave привлекла финансирование в размере $1,1 млрд, получив оценку в $19 млрд. CoreWeave заявляет, что её сервисы с ускорителями NVIDIA позволяют клиентам выполнять задачи более эффективно и с повышенной производительностью, нежели традиционные публичные облака. На сегодняшний день CoreWave предоставляет услуги из трёх ЦОД-регионов. Это площадки US East в Уихокене (Нью-Джерси), US West в Лас-Вегасе (Невада) и US Central в Чикаго (Иллинойс). К концу 2024 года компания рассчитывает управлять в общей сложности 28 дата-центрами. В частности, CoreWeave намерена потратить не менее $1,6 млрд на ЦОД в городе Плано (Техас).

11.05.2024 [13:46], Сергей Карасёв

Южнокорейский разработчик ИИ-чипов Deepx привлек более $80 млнЮжнокорейский стартап Deepx, занимающийся разработкой специализированных чипов для задач ИИ, сообщил о проведении раунда финансирования Series C, в ходе которого на развитие получено $80,5 млн. В инвестиционной программе принимают участие SkyLake Equity Partners, BNW Investments, AJU IB и TimeFolio Asset Management. Deepx была основана в 2018 году бывшим инженером Apple и Cisco Локвоном Кимом (Lokwon Kim). В настоящее время в Deepx работает около 65 человек. Компания подала примерно 260 патентных заявок в США, Китае и Южной Корее на различные разработки, связанные с ИИ. Полученные средства Deepx намерена направить на ускорение разработки и коммерциализации своих продуктов. Отмечается, что стартап ведёт переговоры более чем со 100 потенциальными клиентами и стратегическими партнёрами.

Источник изображения: Deepx Deepx проектирует ИИ-процессоры для разных сфер применения. Это, в частности, изделия DX-V1 и DX-V3 для бытовой электроники, DX-M1 для промышленных роботов и периферийных вычислений, а также DX-H1 для серверов. Производительность этих чипов на ИИ-операциях варьируется от 5 до 400 TOPS. Архитектура решений Deepx предусматривает сокращение интенсивности обмена данными с памятью DRAM, что позволяет повысить общую эффективность вычислений. Помимо аппаратных компонентов, Deepx предоставляет программную платформу DXNN, которая позволяет автоматически компилировать модели ИИ в формат, поддерживаемый чипами компании. Причём компилятор производит оптимизацию (квантование) моделей для улучшения производительности.

11.05.2024 [13:40], Сергей Карасёв

FujiFilm повысит цены на ленточные картриджи LTO UltriumКорпорация FujiFilm, по сообщению ресурса StorageNewsletter, с 1 июля нынешнего года повысит цены на ленточные картриджи семейства LTO Ultrium. Изменение связано прежде всего с удорожанием материалов, которые применяются при производстве такой продукции. Говорится, что стоимость картриджей FujiFilm LTO Ultrium 9 поднимется на 15 %. Эти изделия способны хранить 18 Тбайт данных, тогда как вместимость со сжатием достигает 45 Тбайт. В устройствах применятся лента на основе феррита бария (BaFe), покрытие формируется с использованием фирменной технологии NANOCUBIC. Рост цен также затронет картриджи FujiFilm предыдущих поколений — LTO Ultrium 8 и LTO Ultrium 7, которые подорожают сразу на 40 %. Изделия стандарта LTO-8 имеют «чистую» ёмкость 12 Тбайт и могут хранить до 30 Тбайт данных в сжатом виде. В случае LTO-7 показатели составляют соответственно 6 и 15 Тбайт.

Источник изображения: FujiFilm Исследования говорят о том, что при хранении «холодных» данных ленточные накопители оказываются дешевле и намного экологичнее традиционных HDD. Кроме того, при переходе на LTO возможно снижение объёмов электронных отходов. Если HDD эксплуатируются в среднем 5 лет, то срок службы ленточных накопителей вдвое больше — 10 лет. В соответствии с текущими планами, каждое последующее поколение LTO предусматривает удвоение ёмкости. С появлением LTO-10 вместимость картриджа вырастет до 36 Тбайт, а объём хранимых в сжатом виде данных — до 90 Тбайт. Картриджи 14-го поколения обеспечат объём до 576 Тбайт и 1,44 Пбайт соответственно.

11.05.2024 [00:11], Сергей Карасёв

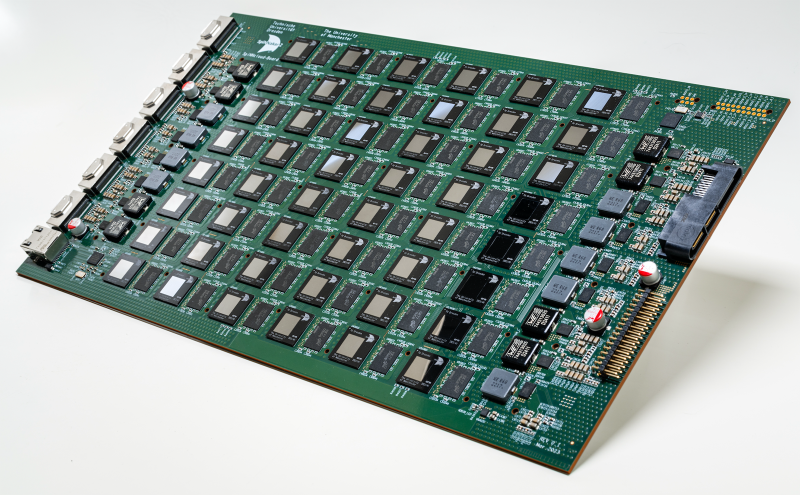

SpiNNcloud представила первый коммерческий «нейроморфный суперкомпьютер» SpiNNaker2 на базе ArmКомпания SpiNNcloud Systems анонсировала «нейроморфный суперкомпьютер» — гибридную высокопроизводительную вычислительную ИИ-систему, основанную, по словам компании, на принципах работы человеческого мозга. Утверждается, что это первое коммерчески доступное решение данного типа. Изделие базируется на архитектуре, разработанной Стивом Фербером (Steve Furber), одним из создателей оригинального процессора Arm. Идея заключается в применении большого количества маломощных чипов для более эффективной обработки ИИ-задач и других рабочих нагрузок. SpiNNaker2 представляет собой специализированную серверную плату с 48 чипами, каждый из которых насчитывает 152 ядра Arm. Таким образом, общее количество ядер составляет 7296. В состав чипов также входят различные дополнительные узлы, включая распределённые GPU-подобные блоки для ускорения обработки нейроморфных, гибридных и обычных моделей ИИ. В одну стойку могут монтироваться до 90 плат SpiNNaker2. Масштабирование осуществляется путём объединения таких стоек в кластер. В результате, как утверждается, возможно эмулирование в реальном времени как минимум 10 млрд взаимосвязанных нейронов. На операциях машинного обучения производительность может достигать 0,3 Эопс (1018 операций в секунду). Для сравнения — исследовательский нейроморфный компьютер Intel Hala Point поддерживает до 1,15 млрд нейронов и производительность до 30 Попс. От традиционных ИИ-платформ на базе GPU новое решение отличается универсальностью, говорит компания. Благодаря использованию многочисленных асинхронных блоков с низким энергопотреблением достигается более эффективное управление рабочими нагрузками. Со II половины 2024 года изделия SpiNNaker2 будут доступны в составе облачной платформы. В I половине 2025-го планируется организовать поставки самостоятельных систем. В число первых заказчиков SpiNNaker2 вошли Национальные лаборатории Сандия (Sandia National Laboratories), Технический университет Мюнхена (TUM) и Гёттингенский университет (Universität Göttingen).

10.05.2024 [23:47], Сергей Карасёв

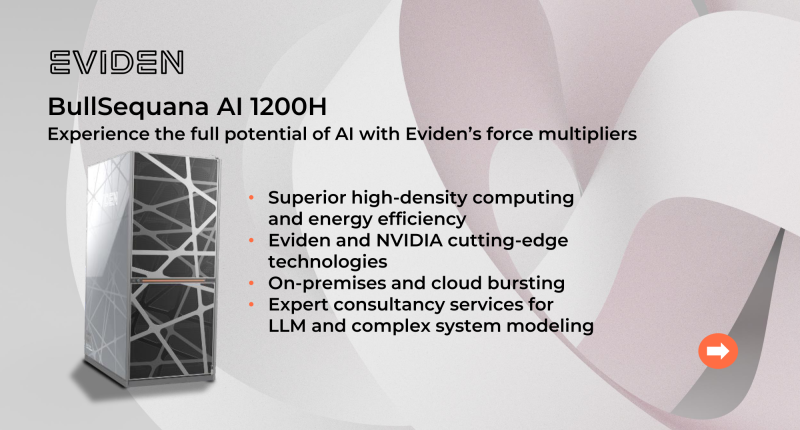

Eviden представила семейство ИИ-серверов BullSequana AIКомпания Eviden (дочерняя структура Atos) анонсировала серверы серии BullSequana AI, предназначенные для решения ИИ-задач. В зависимости от модификации и уровня производительности устройства подходят для различных сценариев использования — от НРС-платформ до периферийных вычислений. Наиболее производительными серверами семейства являются решения BullSequana AI 1200H. Они могут применяться в составе облачных и гибридных инфраструктур, а также в дата-центрах заказчиков. По сути, это суперкомпьютер корпоративного уровня, специально разработанный для ресурсоёмких задач, таких как точная настройка ИИ-систем или обучение больших языковых моделей (LLM). Конфигурация BullSequana AI 1200H включает суперчипы NVIDIA Grace Hopper, а также интерконнект NVIDIA Quantum-2 InfiniBand. Задействовано программное обеспечение Eviden Jarvice XE, Eviden Smart Energy Management Suite, Eviden Smart Management Center и NVIDIA AI Enterprise. Серверы BullSequana AI 1200H, насчитывающие в общей сложности 1456 ускорителей NVIDIA H100, выбраны для модернизации французского суперкомпьютера Jean Zay. Производительность этого НРС-комплекса увеличится более чем в три раза — с 36,85 до 125,9 Пфлопс. Кроме того, в новое семейство серверов вошли производительные устройства BullSequana AI 800, системы BullSequana AI 600 с воздушным и гибридным охлаждением, модели BullSequana AI 200 для частных и гибридных облачных сред, а также BullSequana AI 100 для периферийных вычислений. В целом, как отмечается, каждая модель BullSequana AI предлагает различные уровни производительности, масштабируемости и гибкости. Таким образом, заказчики могут подобрать наиболее подходящий для себя вариант в зависимости от конкретного варианта использования, бюджета и размера бизнеса.

10.05.2024 [21:34], Сергей Карасёв

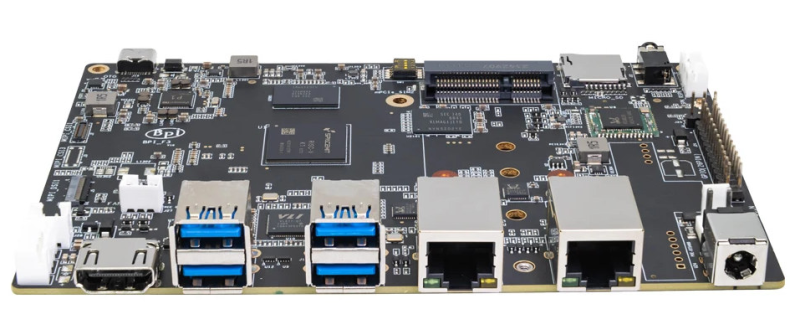

Восьмиядерный RISC-V с NPU: одноплатный компьютер Banana Pi BPI-F3 получил чип SpacemiT K1Banana Pi, по сообщению ресурса CNX Software, начала поставки одноплатного компьютера BPI-F3, особенностью которой является использование процессора SpacemiT K1 на открытой архитектуре RISC-V. Изделие подходит для работы с приложениями ИИ. Новинка была анонсирована в феврале этого года. Чип SpacemiT K1 объединяет восемь 64-бит RISC-V ядер, неназванный графический блок с поддержкой OpenCL 3.0, OpenGL ES3.2 и Vulkan 1.2, а также нейропроцессорный модуль (NPU) с производительностью до 2 TOPS. Говорится о возможности кодирования/декодирования материалов H.265, H.264, VP9, VP8.

Источник изображения: Banana Pi Объём оперативной памяти LPDDR4 может составлять 2 или 4 Гбайт, вместимость флеш-модуля eMMC — 8 или 16 Гбайт. Есть слот для карты microSD и коннектор M.2 Key-M для SSD с интерфейсом PCIe 2.1 x1 или SATA. Опционально могут быть добавлены флеш-чипы SPI NAND на 32 Мбайт и SPI NOR на 4 Мбайт. В оснащение входят два порта 1GbE (RJ-45) на контроллере Realtek RTL8211F с опциональной поддержкой PoE (через плату RT5400), а также адаптеры Wi-Fi 5 (2,4/5 ГГц) и Bluetooth 4.2 на базе Realtek RTL8852BS. Дополнительно предлагается модем 4G в виде модуля mPCIe (плюс слот для SIM-карты). Доступны четыре порта USB 3.0 Type-A, разъём USB 2.0 Type-C и коннектор HDMI 1.4 (до 1080p60). Поддерживаются интерфейсы MIPI DSI (4 линии) и 2 × MIPI-CSI (4 линии). Кроме того, упомянуты 26-контактная колодка GPIO, инфракрасный порт и разъём для подсоединения вентилятора. Питание (12 В / 3 A) подаётся через DC-гнездо. Габариты составляют 148 × 100 мм, вес — около 200 г. Цена начинается примерно с $63.

10.05.2024 [21:19], Владимир Мироненко

Bloomberg: Apple начала оснащать свои ЦОД серверами с чипами M2 Ultra для поддержки ИИ-функций iOSНа предстоящей конференции для разработчиков WWDC 2024, которая пройдёт в июне, Apple, как ожидается, представит новую версию iOS 18 с множеством функций генеративного ИИ. Некоторые из них будут выполняться локально, но часть будет использовать ИИ-модели, развёрнутые в ЦОД Apple. Как сообщает Bloomberg со ссылкой на информированные источники, компания в рамках программы Apple Chips in Data Centers (ACDC) начала обновлять инфраструктуру, оснащая свои ЦОД серверами с чипами собственной разработки M2 Ultra для обеспечения более эффективной работы ИИ-моделей. По словам источников, за последние три года компания инвестировала сотни миллионов долларов в новую облачную инициативу.

Источник изображения: Apple Чип M2 Ultra включает вычислительный модуль Neural Engine для запуска ИИ-моделей. В ближайшем будущем в ЦОД будут также устанавливаться серверы с чипами M4, представленными на прошлой неделе. Ранее на этой неделе The Wall Street Journal сообщал, что Apple в рамках ACDC разрабатывает собственные серверные ИИ-ускорители для инференса. Пока Apple планирует использовать для новых облачных сервисов собственные ЦОД, но в конечном итоге перенесёт часть нагрузок на «сторонние объекты». На это намекнул финансовый директор Лука Маэстри (Luca Maestri). «У нас есть собственные мощности ЦОД, а затем мы используем мощности третьих сторон, — сказал он после того, как его попросили рассказать об ИИ-инфраструктуре. — Эта модель исторически хорошо работала для нас, и мы планируем продолжать в том же духе и в дальнейшем».

10.05.2024 [20:44], Руслан Авдеев

Саудовская DataVolt начала строительство экоустойчивого ЦОД в УзбекистанеСаудовская компания DataVolt начала строительство дебютного дата-центра Tashkent IT Park Data Center в Ташкенте, передаёт Datacenter Dynamics. Спецификации нового объекта оператором пока не раскрывались, но Министерство цифровых технологий Узбекистана сообщило, что речь идёт о проекте ёмкостью 10 МВт и стоимостью $150 млн. В DataVolt заявили, что новый ЦОД представляет собой модульное решение с возможностью масштабирования, что позволит организовать выполнение самых разных задач, а производительность может составить от сотен до тысяч Тфлопс. Церемония закладки объекта состоялась в присутствии президента Узбекистана и саудовского принца, в числе прочего занимающего пост министра энергетики. Это лишь первый проект DataVolt в Узбекистане, но речь уже идёт об инновационном решении в области экоустойчивости — он предусматривает использование солнечной и ветряной энергии, запасать которую предполагается в энергохранилищах. Дополнительно предусмотрено питание от водорода и иных видах «зелёного» топлива для круглосуточного обеспечения экобезопасной энергией. Такой подход позволит обеспечить экономически эффективную базу для внедрения ИИ-вычислений в Узбекистане — проект станет локомотивам развития передовой IT-индустрии. Основанная в прошлом году DataVolt является дочерней структурой Vision Invest, саудовской инвестиционно-строительной компании, занимающейся объектами критической инфраструктуры. Значительная часть руководства DataVolt, включая генерального директора, ранее работала в ACWA Power, занимавшейся созданием электростанций и опреснителей — эта компания тоже принадлежит Vision Invest. Ранее DataVolt подписала с властями Узбекистана инвестиционное соглашение, согласно которому в стране будут возведены ЦОД ещё на 500 МВт. Т.н. «Новый Ташкент» разместит у себя кампус ёмкостью 250 МВт на участке в 25 га. Ещё один объект ёмкостью 40 МВт появится в Бухаре, в перспективе его мощность будет доведена до 250 МВт. В прошлом году DataVolt анонсировала партнёрство с индийской AquaTech Systems, предусматривающее создание водно-эффективных ЦОД, а также со Sterling and Wilson. Кроме того, DataVolt раскрыла планы по строительству кампуса ЦОД в Бангладеш. А в самой Саудовской Аравии компания намерена инвестировать $5 млрд в строительство дата-центров.

10.05.2024 [13:53], Владимир Мироненко

Lenovo установит в Италии 1,2-Пфлопс суперкомпьютер Cassandra на базе Intel Xeon Max для климатических исследованийКомпания Lenovo сообщила о возобновлении сотрудничества с Европейско-Средиземноморским центром по изменению климата (CMCC), базирующимся в Лечче (Италия), и подписании контракта на установку в этом году новой мощной системы высокопроизводительных вычислений (HPC) Cassandra, предназначенной для исследования изменения климата с помощью повышенных вычислительных возможностей и оптимизации использования энергии. Cassandra включает 180 узлов SD650 V3 с двумя процессорами Intel Xeon Max 9480 (Sapphire Rapids с HBM) на узел и имеет пиковую FP64-производительность 1,2 Пфлопс. Благодаря использованию технологии жидкостного охлаждения Lenovo Neptune Direct Water-Cooling, способной отводить до 98 % тепла, Cassandra потребляет на 15 % ниже электроэнергии, чем аналогичные решения с воздушным охлаждением. Благодаря повышенной эффективности СЖО температура процессоров не достигает критических значений, что позволяет избежать снижения максимальной частоты ядер процессоров, говорит Lenovo. Установкой Cassandra в суперкомпьютерном центре CMCC (SCC) будет заниматься Ricca IT, сертифицированный партнёр Lenovo. В суперкомпьютерном центре CMCC уже имеется HPC-система от Lenovo под названием Juno, установленная в 2022 году, с FP64-производительностью около 1,13 Пфлопс и построенная на базе процессоров Intel и ускорителей NVIDIA. Cassandra будет использоваться для климатического моделирования системы Земли, океана, работы как глобальных, так и региональных систем сезонного прогнозирования, а также запуска приложения по исследованию изменения климата на основе ИИ. CMCC также планирует интегрировать во II полугодии в суперкомпьютер два ИИ-узла с восемью ускорителями NVIDIA H100 в каждом. |

|